文章目录

- RabbitMQ

- 异步通讯

- 技术对比

- 安装RabbitMQ

- 下载镜像

- 安装MQ

- RabbitMQ消息模型

- 入门案例

- publisher实现

- consumer实现

- 总结

- SpringAMQP

- Basic Queue 简单队列模型

- 消息发送

- 消息接收

- WorkQueue

- 消息发送

- 消息接收

- 测试

- 总结

- 发布/订阅

- Fanout

- 声明队列和交换机

- 消息发送

- 消息接收

- Direct

- 基于注解声明队列和交换机

- 消息发送

- Topic

- 说明

- 消息发送

- 消息接收

- 消息转换器

- 默认转换器

- 配置JSON转换器

- 消息可靠性

- 生产者消息确认

- 消息持久化

- 交换机持久化

- 队列持久化

- 消息持久化

- 消费者消息确认

- 消费失败重试机制

- 本地重试

- 失败策略

- 死信交换机

- 定义

- 利用死信交换机接收死信

- TTL

- 延迟队列

- 安装DelayExchange插件

- DelayExchange原理

- 使用DelayExchange

- 声明DelayExchange交换机

- 惰性队列

- 消息堆积问题

- 惰性队列

- 基于命令行设置lazy-queue

- 基于@Bean声明lazy-queue

- 基于@RabbitListener声明LazyQueue

- MQ集群

- 集群的分类

- 普通集群

- 部署

- 获取Cookie

- 准备集群配置

- 启动集群

- 镜像集群

- 部署

- exactly模式

- all模式

- nodes模式

- 仲裁队列

- 添加仲裁队列

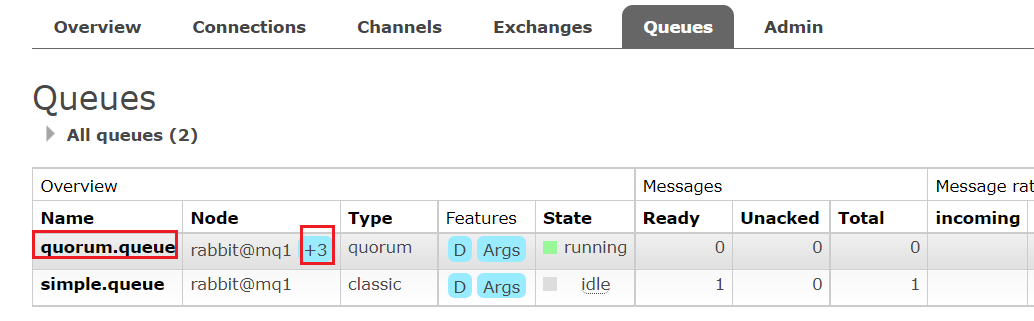

- 控制台添加

- SpringAMQP创建

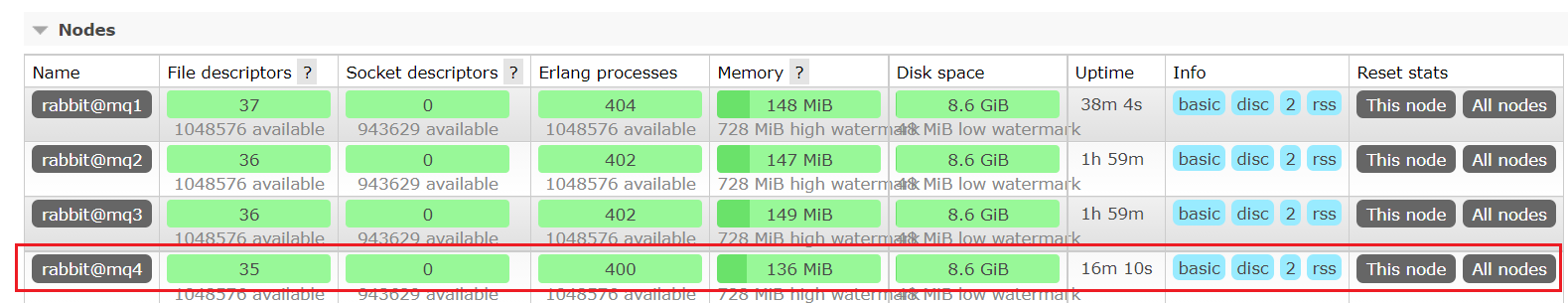

- 集群扩容

- 增加仲裁队列副本

RabbitMQ

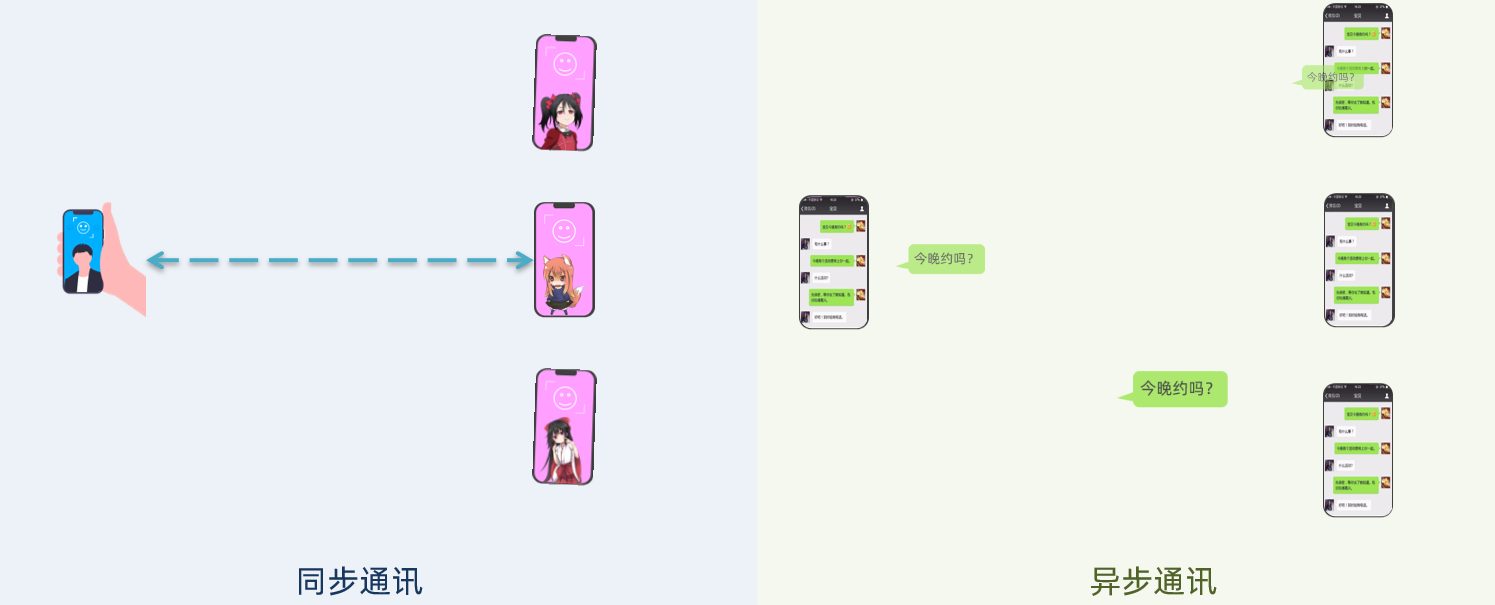

微服务间通讯有同步和异步两种方式:

同步通讯:就像打电话,需要实时响应。

异步通讯:就像发邮件,不需要马上回复。

两种方式各有优劣,打电话可以立即得到响应,但是一个人却不能跟多个人同时通话。而发送邮件可以同时与多个人收发邮件,但是往往响应会有延迟。

同步调用的优点:

- 时效性较强,可以立即得到结果

同步调用的问题:

耦合度高:每次加入新的需求,都要修改原来的代码。性能和吞吐能力下降:调用者需要等待服务提供者响应,如果调用链过长则响应时间等于每次调用的时间之和。有额外的资源消耗:调用链中的每个服务在等待响应过程中,不能释放请求占用的资源,高并发场景下会极度浪费系统资源。有级联失败问题:如果服务提供者出现问题,所有调用方都会跟着出问题,如同多米诺骨牌一样,迅速导致整个微服务群故障。

异步通讯

异步调用则可以避免上述问题:

以购买商品为例,用户支付后需要调用订单服务完成订单状态修改,调用物流服务,从仓库分配响应的库存并准备发货。

在事件模式中,支付服务是事件发布者(publisher),在支付完成后只需要发布一个支付成功的事件(event),事件中带上订单id。

订单服务和物流服务是事件订阅者(Consumer),订阅支付成功的事件,监听到事件后完成自己业务即可。

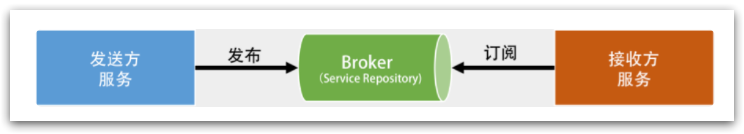

为了解除事件发布者与订阅者之间的耦合,两者并不是直接通信,而是有一个中间人(Broker)。发布者发布事件到Broker,不关心谁来订阅事件。订阅者从Broker订阅事件,不关心谁发来的消息。

Broker 是一个类似于数据总线一样的东西,所有的服务要接收数据和发送数据都发到这个总线上,这个总线就像协议一样,让服务间的通讯变得标准和可控。

异步通讯的优点:

-

吞吐量提升:无需等待订阅者处理完成,响应更快速

-

故障隔离:服务没有直接调用,不存在级联失败问题

-

调用间没有阻塞,不会造成无效的资源占用

-

耦合度极低,每个服务都可以灵活插拔,可替换

-

流量削峰:不管发布事件的流量波动多大,都由Broker接收,订阅者可以按照自己的速度去处理事件

缺点:

- 架构复杂了,业务没有明显的流程线,不好管理

- 需要依赖于Broker的可靠、安全、性能。

技术对比

现在开源软件或云平台上 Broker 的软件是非常成熟的,比较常见的一种就是MQ技术。

MQ,中文是消息队列(MessageQueue),字面来看就是存放消息的队列。也就是事件驱动架构中的Broker。

比较常见的MQ实现:

- ActiveMQ

- RabbitMQ

- RocketMQ

- Kafka

几种常见MQ的对比:

| RabbitMQ | ActiveMQ | RocketMQ | Kafka | |

|---|---|---|---|---|

| 公司/社 区 | Rabbit | Apache | 阿里 | Apache |

| 开发语言 | Erlang | Java | Java | Scala&Java |

| 协议支持 | AMQP,XMPP,SMTP,STOMP | OpenWire,STOMP,REST,XMPP,AMQP | 自定义协议 | 自定义协议 |

| 可用性 | 高 | 一般 | 高 | 高 |

| 单机吞吐量 | 一般 | 差 | 高 | 非常高 |

| 消息延迟 | 微秒级 | 毫秒级 | 毫秒级 | 毫秒以内 |

| 消息可靠性 | 高 | 一般 | 高 | 一般 |

如果追求可用性,可以选择Kafka、 RocketMQ 、RabbitMQ

如果追求可靠性,可以选择RabbitMQ、RocketMQ

如果追求吞吐能力,选择RocketMQ、Kafka

追求消息低延迟,选择RabbitMQ、Kafka

为什么选择RabbitMQ而不是其它的MQ?

kafka是以吞吐量高而闻名,不过其数据稳定性一般,而且无法保证消息有序性。RabbitMQ基于面向并发的语言Erlang开发,吞吐量不如Kafka,但消息可靠性较好,并且消息延迟极低,集群搭建比较方便。支持多种协议,并且有各种语言的客户端,比较灵活。Spring对RabbitMQ的支持也比较好,使用起来比较方便。

安装RabbitMQ

在Centos7虚拟机中使用Docker来安装。

下载镜像

在线拉取镜像

docker pull rabbitmq:3-management

安装MQ

执行下面的命令来运行MQ容器:

docker run \

-e RABBITMQ_DEFAULT_USER=admin \

-e RABBITMQ_DEFAULT_PASS=123456 \

--name mq \

--hostname mq1 \

-p 15672:15672 \

-p 5672:5672 \

-d \

rabbitmq:3-management

RabbitMQ的基本结构:

RabbitMQ中的一些角色:

- publisher:生产者

- consumer:消费者

- exchange:交换机,负责消息路由

- queue:队列,存储消息

- Virtual Host:虚拟主机,隔离不同租户的exchange、queue、消息的隔离

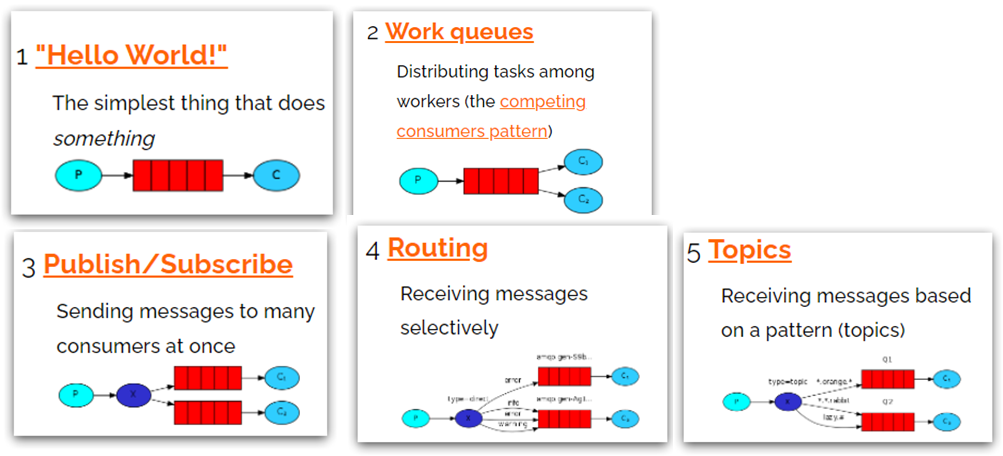

RabbitMQ消息模型

MQ的官方文档中给出了5个MQ的Demo示例,对应了几种不同的用法:

-

基本消息队列(BasicQueue)

-

工作消息队列(WorkQueue)

发布订阅(Publish、Subscribe),又根据交换机类型不同分为三种:

-

Fanout Exchange:广播

-

Direct Exchange:路由

-

Topic Exchange:主题

入门案例

简单队列模式的模型图:

官方的HelloWorld是基于最基础的消息队列模型来实现的,只包括三个角色:

- publisher:消息发布者,将消息发送到队列queue

- queue:消息队列,负责接受并缓存消息

- consumer:订阅队列,处理队列中的消息

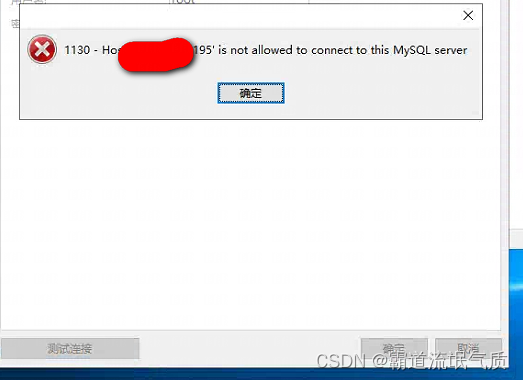

publisher实现

实现思路:

- 建立连接

- 创建Channel

- 声明队列

- 发送消息

- 关闭连接和channel

代码实现:

public class PublisherTest {

@Test

public void testSendMessage() throws IOException, TimeoutException {

// 1.建立连接

ConnectionFactory factory = new ConnectionFactory();

// 1.1.设置连接参数,分别是:主机名、端口号、vhost、用户名、密码

factory.setHost("192.168.xxx.xxx");

factory.setPort(5672);

factory.setVirtualHost("/");

factory.setUsername("admin");

factory.setPassword("123456");

// 1.2.建立连接

Connection connection = factory.newConnection();

// 2.创建通道Channel

Channel channel = connection.createChannel();

// 3.创建队列

String queueName = "simple.queue";

channel.queueDeclare(queueName, false, false, false, null);

// 4.发送消息

String message = "hello, rabbitmq!";

channel.basicPublish("", queueName, null, message.getBytes());

System.out.println("发送消息成功:【" + message + "】");

// 5.关闭通道和连接

channel.close();

connection.close();

}

}

consumer实现

实现思路:

- 建立连接

- 创建Channel

- 声明队列

- 订阅消息

代码实现:

public class ConsumerTest {

public static void main(String[] args) throws IOException, TimeoutException {

// 1.建立连接

ConnectionFactory factory = new ConnectionFactory();

// 1.1.设置连接参数,分别是:主机名、端口号、vhost、用户名、密码

factory.setHost("192.168.xxx.xxx");

factory.setPort(5672);

factory.setVirtualHost("/");

factory.setUsername("admin");

factory.setPassword("123456");

// 1.2.建立连接

Connection connection = factory.newConnection();

// 2.创建通道Channel

Channel channel = connection.createChannel();

// 3.创建队列

String queueName = "simple.queue";

channel.queueDeclare(queueName, false, false, false, null);

// 4.订阅消息

channel.basicConsume(queueName, true, new DefaultConsumer(channel){

@Override

public void handleDelivery(String consumerTag, Envelope envelope,

AMQP.BasicProperties properties, byte[] body) throws IOException {

// 5.处理消息

String message = new String(body);

System.out.println("接收到消息:【" + message + "】");

}

});

System.out.println("等待接收消息。。。。");

}

}

总结

基本消息队列的消息发送流程:

-

建立connection

-

创建channel

-

利用channel声明队列

-

利用channel向队列发送消息

基本消息队列的消息接收流程:

-

建立connection

-

创建channel

-

利用channel声明队列

-

定义consumer的消费行为handleDelivery()

-

利用channel将消费者与队列绑定

SpringAMQP

SpringAMQP是基于RabbitMQ封装的一套模板,并且还利用SpringBoot对其实现了自动装配,使用起来非常方便。

SpringAmqp的官方地址:https://spring.io/projects/spring-amqp

SpringAMQP提供了三个功能:

- 自动声明队列、交换机及其绑定关系

- 基于注解的监听器模式,异步接收消息

- 封装了RabbitTemplate工具,用于发送消息

Basic Queue 简单队列模型

在父工程mq-demo中引入依赖

<!--AMQP依赖,包含RabbitMQ-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-amqp</artifactId>

</dependency>

消息发送

首先配置MQ地址,在publisher服务的application.yml中添加配置:

spring:

rabbitmq:

host: 192.168.xxx.xxx # 主机名

port: 5672 # 端口

virtual-host: / # 虚拟主机

username: admin # 用户名

password: 123456 # 密码

然后在publisher服务中编写测试类SpringAmqpTest,并利用RabbitTemplate实现消息发送:

@RunWith(SpringRunner.class)

@SpringBootTest

public class SpringAmqpTest {

@Autowired

private RabbitTemplate rabbitTemplate;

@Test

public void testSimpleQueue() {

// 队列名称

String queueName = "simple.queue";

// 消息

String message = "hello, spring amqp!";

// 发送消息

rabbitTemplate.convertAndSend(queueName, message);

}

}

消息接收

首先配置MQ地址,在consumer服务的application.yml中添加配置:

spring:

rabbitmq:

host: 192.168.xxx.xxx # 主机名

port: 5672 # 端口

virtual-host: / # 虚拟主机

username: admin # 用户名

password: 123456 # 密码

然后在consumer服务的listener包中新建一个类SpringRabbitListener,代码如下:

@Component

public class SpringRabbitListener {

@RabbitListener(queues = "simple.queue")

public void listenSimpleQueueMessage(String msg) throws InterruptedException {

System.out.println("spring 消费者接收到消息:【" + msg + "】");

}

}

启动consumer服务,然后在publisher服务中运行测试代码,发送MQ消息。

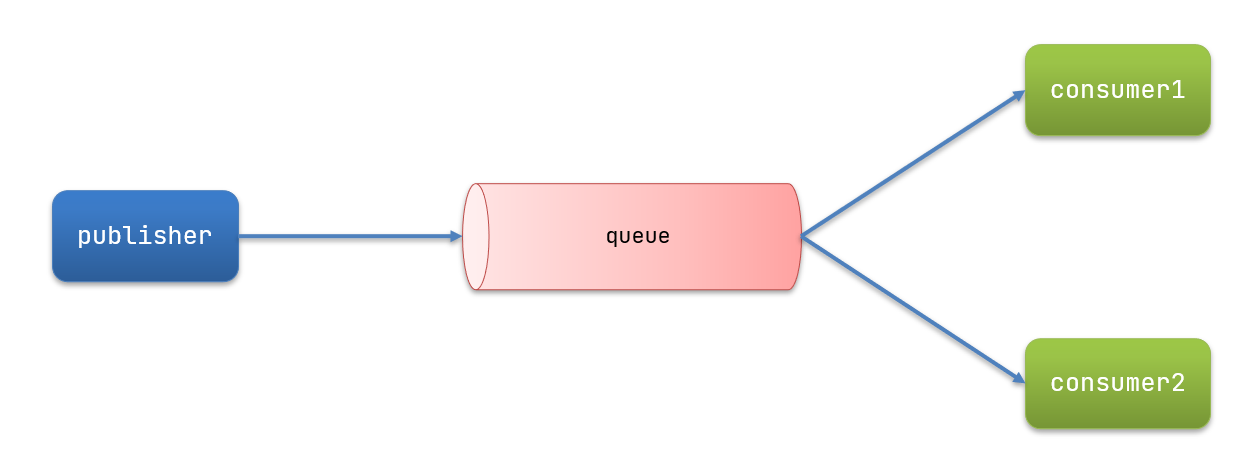

WorkQueue

Work queues,也被称为(Task queues),任务模型。简单来说就是让多个消费者绑定到一个队列,共同消费队列中的消息。

当消息处理比较耗时的时候,可能生产消息的速度会远远大于消息的消费速度。长此以往,消息就会堆积越来越多,无法及时处理。

此时就可以使用work 模型,多个消费者共同处理消息处理,效率就能大大提高了。

消息发送

利用循环发送,来模拟大量消息堆积现象。

在publisher服务中的SpringAmqpTest类中添加一个测试方法:

/**

* workQueue

* 向队列中不停发送消息,模拟消息堆积。

*/

@Test

public void testWorkQueue() throws InterruptedException {

// 队列名称

String queueName = "simple.queue";

// 消息

String message = "hello, message_";

for (int i = 0; i < 50; i++) {

// 发送消息

rabbitTemplate.convertAndSend(queueName, message + i);

Thread.sleep(20);

}

}

消息接收

要模拟多个消费者绑定同一个队列,我们在consumer服务的SpringRabbitListener中添加2个新的方法:

@RabbitListener(queues = "simple.queue")

public void listenWorkQueue1(String msg) throws InterruptedException {

System.out.println("消费者1接收到消息:【" + msg + "】" + LocalTime.now());

Thread.sleep(20);

}

@RabbitListener(queues = "simple.queue")

public void listenWorkQueue2(String msg) throws InterruptedException {

System.err.println("消费者2........接收到消息:【" + msg + "】" + LocalTime.now());

Thread.sleep(200);

}

注意到这个消费者sleep了1000秒,模拟任务耗时。

测试

启动ConsumerApplication后,在执行publisher服务中刚刚编写的发送测试方法testWorkQueue。

可以看到消费者1很快完成了自己的25条消息。消费者2却在缓慢的处理自己的25条消息。

也就是说消息是平均分配给每个消费者,并没有考虑到消费者的处理能力。这样显然是有问题的。

在spring中有一个简单的配置,可以解决这个问题。我们修改consumer服务的application.yml文件,添加配置:

spring:

rabbitmq:

listener:

simple:

prefetch: 1 # 每次只能获取一条消息,处理完成才能获取下一个消息

总结

Work模型的使用过程:

- 多个消费者绑定到一个队列,同一条消息只会被一个消费者处理

- 通过设置prefetch来控制消费者预取的消息数量

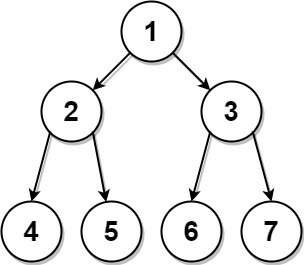

发布/订阅

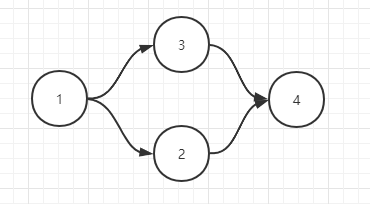

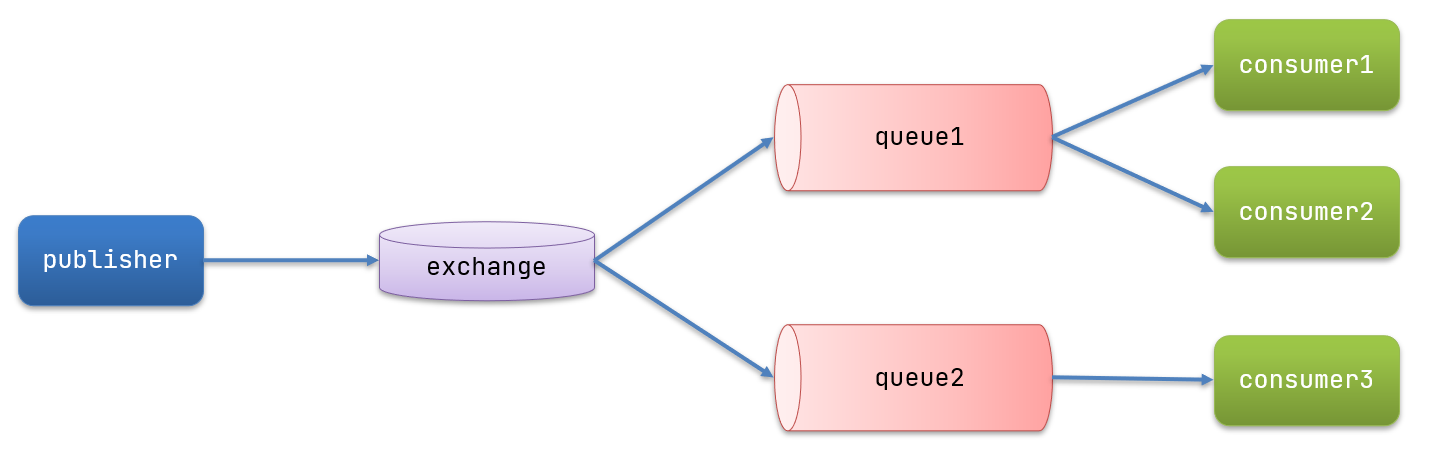

发布订阅的模型如图:

可以看到,在订阅模型中,多了一个exchange角色,而且过程略有变化:

- Publisher:生产者,也就是要发送消息的程序,但是不再发送到队列中,而是发给X(交换机)

- Exchange:交换机,图中的X。一方面,接收生产者发送的消息。另一方面,知道如何处理消息,例如递交给某个特别队列、递交给所有队列、或是将消息丢弃。到底如何操作,取决于Exchange的类型。Exchange有以下3种类型:

- Fanout:广播,将消息交给所有绑定到交换机的队列

- Direct:定向,把消息交给符合指定routing key 的队列

- Topic:通配符,把消息交给符合routing pattern(路由模式) 的队列

- Consumer:消费者,与以前一样,订阅队列,没有变化

- Queue:消息队列也与以前一样,接收消息、缓存消息。

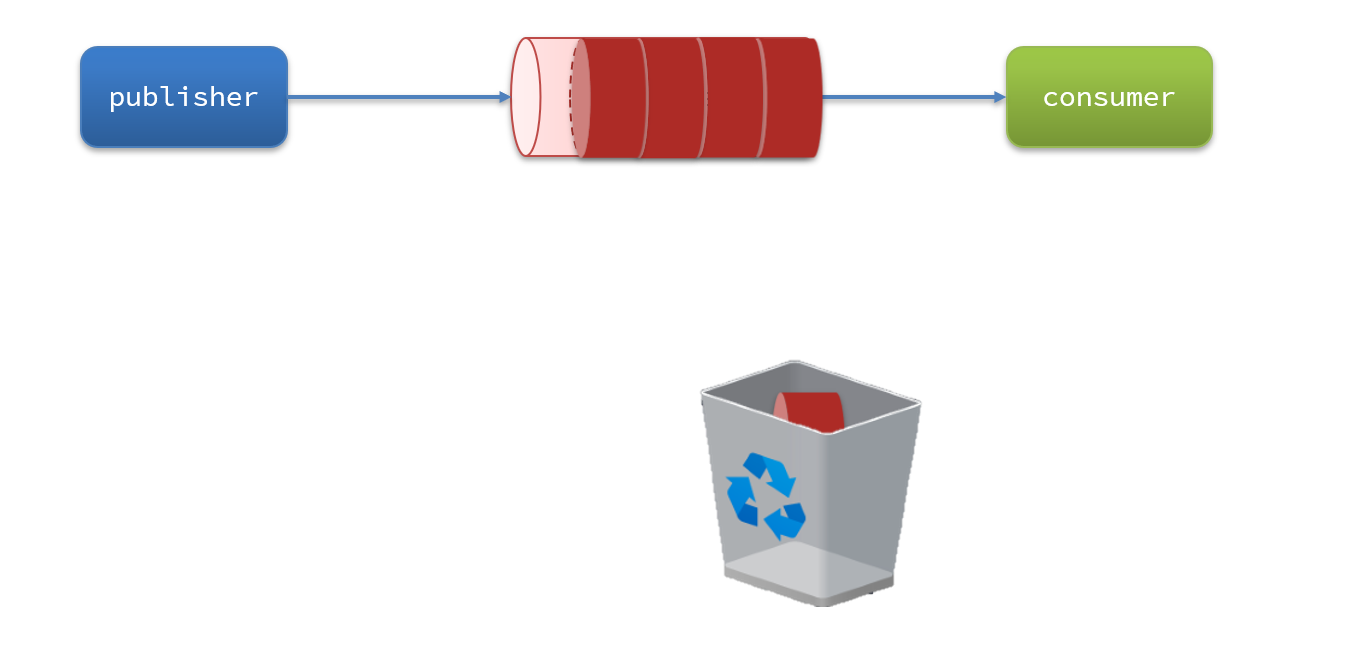

Exchange(交换机)只负责转发消息,不具备存储消息的能力,因此如果没有任何队列与Exchange绑定,或者没有符合路由规则的队列,那么消息会丢失!

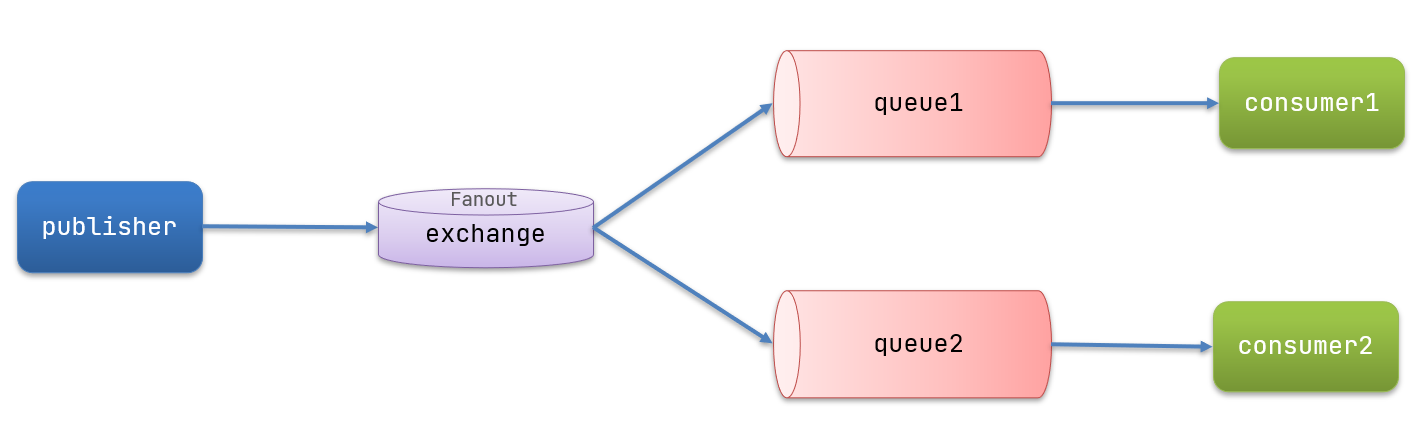

Fanout

Fanout,英文翻译是扇出,在MQ中译为广播更合适。

在广播模式下,消息发送流程是这样的:

-

可以有多个队列

-

每个队列都要绑定到Exchange(交换机)

-

生产者发送的消息,只能发送到交换机,交换机来决定要发给哪个队列,生产者无法决定

-

交换机把消息发送给绑定过的所有队列

-

订阅队列的消费者都能拿到消息

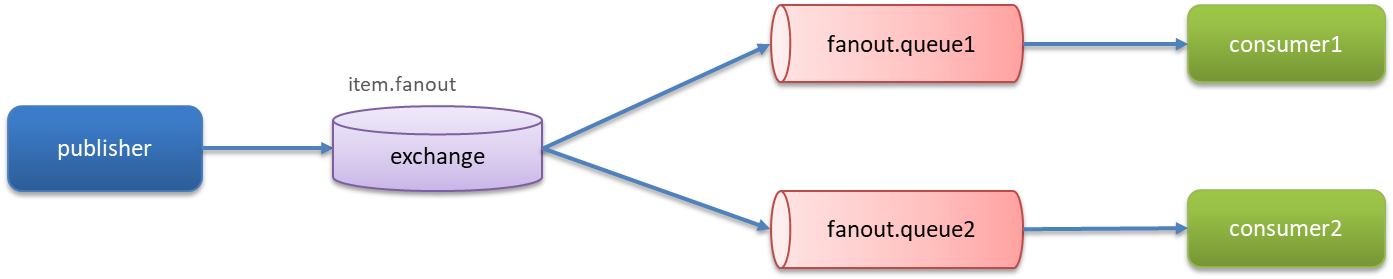

案例测试:

- 创建一个交换机 itcast.fanout,类型是Fanout

- 创建两个队列fanout.queue1和fanout.queue2,绑定到交换机itcast.fanout

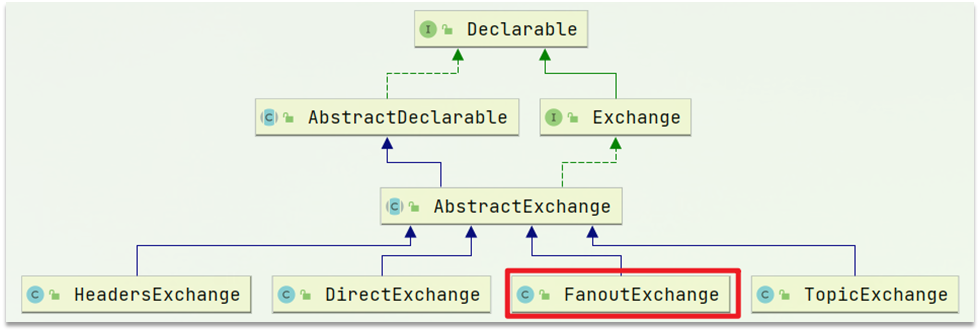

声明队列和交换机

Spring提供了一个接口Exchange,来表示所有不同类型的交换机:

在consumer中创建一个类,声明队列和交换机:

@Configuration

public class FanoutConfig {

/**

* 声明交换机

* @return Fanout类型交换机

*/

@Bean

public FanoutExchange fanoutExchange(){

return new FanoutExchange("itcast.fanout");

}

/**

* 第1个队列

*/

@Bean

public Queue fanoutQueue1(){

return new Queue("fanout.queue1");

}

/**

* 绑定队列和交换机

*/

@Bean

public Binding bindingQueue1(Queue fanoutQueue1, FanoutExchange fanoutExchange){

return BindingBuilder.bind(fanoutQueue1).to(fanoutExchange);

}

/**

* 第2个队列

*/

@Bean

public Queue fanoutQueue2(){

return new Queue("fanout.queue2");

}

/**

* 绑定队列和交换机

*/

@Bean

public Binding bindingQueue2(Queue fanoutQueue2, FanoutExchange fanoutExchange){

return BindingBuilder.bind(fanoutQueue2).to(fanoutExchange);

}

}

消息发送

在publisher服务的SpringAmqpTest类中添加测试方法:

@Test

public void testFanoutExchange() {

// 队列名称

String exchangeName = "itcast.fanout";

// 消息

String message = "hello, everyone!";

rabbitTemplate.convertAndSend(exchangeName, "", message);

}

消息接收

在consumer服务的SpringRabbitListener中添加两个方法,作为消费者:

@RabbitListener(queues = "fanout.queue1")

public void listenFanoutQueue1(String msg) {

System.out.println("消费者1接收到Fanout消息:【" + msg + "】");

}

@RabbitListener(queues = "fanout.queue2")

public void listenFanoutQueue2(String msg) {

System.out.println("消费者2接收到Fanout消息:【" + msg + "】");

}

小结

交换机的作用是什么?

- 接收publisher发送的消息。

- 将消息按照规则路由到与之绑定的队列。

- 不能缓存消息,路由失败,消息丢失。

- FanoutExchange的会将消息路由到每个绑定的队列。

声明队列、交换机、绑定关系的Bean是什么?

- Queue

- FanoutExchange

- Binding

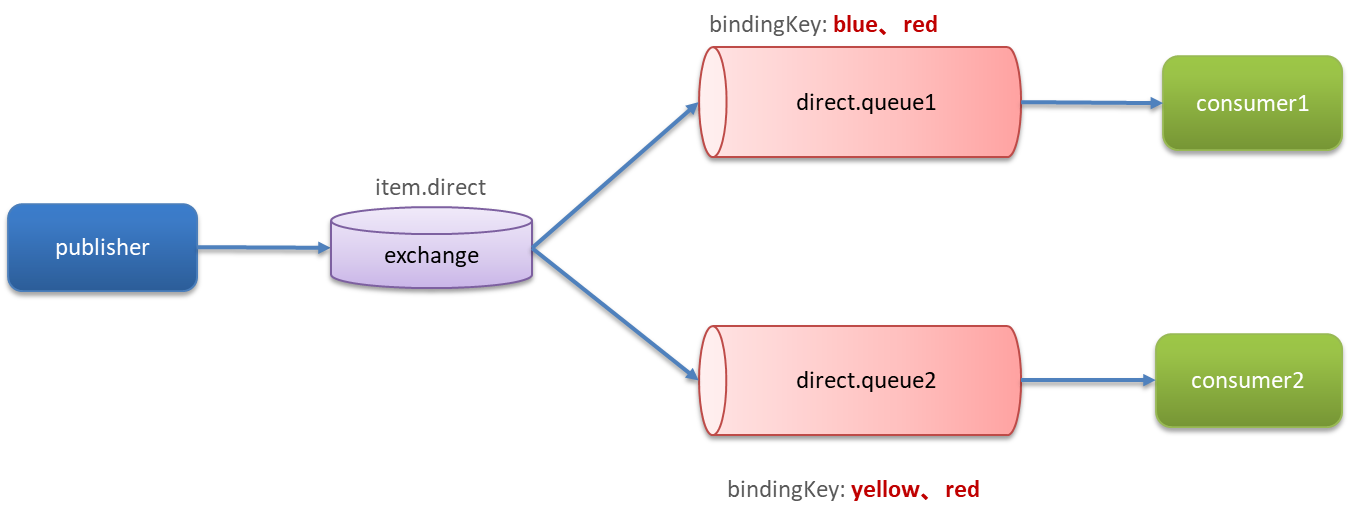

Direct

在Fanout模式中,一条消息,会被所有订阅的队列都消费。但是,在某些场景下,我们希望不同的消息被不同的队列消费。这时就要用到Direct类型的Exchange。

在Direct模型下:

- 队列与交换机的绑定,不能是任意绑定了,而是要指定一个

RoutingKey(路由key) - 消息的发送方在 向 Exchange发送消息时,也必须指定消息的

RoutingKey。 - Exchange不再把消息交给每一个绑定的队列,而是根据消息的

Routing Key进行判断,只有队列的Routingkey与消息的Routing key完全一致,才会接收到消息

案例需求如下:

-

利用@RabbitListener声明Exchange、Queue、RoutingKey

-

在consumer服务中,编写两个消费者方法,分别监听direct.queue1和direct.queue2

-

在publisher中编写测试方法,向itcast. direct发送消息。

基于注解声明队列和交换机

基于@Bean的方式声明队列和交换机比较麻烦,Spring还提供了基于注解方式来声明。

在consumer的SpringRabbitListener中添加两个消费者,同时基于注解来声明队列和交换机:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "direct.queue1"),

exchange = @Exchange(name = "itcast.direct", type = ExchangeTypes.DIRECT),

key = {"red", "blue"}

))

public void listenDirectQueue1(String msg){

System.out.println("消费者接收到direct.queue1的消息:【" + msg + "】");

}

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "direct.queue2"),

exchange = @Exchange(name = "itcast.direct", type = ExchangeTypes.DIRECT),

key = {"red", "yellow"}

))

public void listenDirectQueue2(String msg){

System.out.println("消费者接收到direct.queue2的消息:【" + msg + "】");

}

消息发送

在publisher服务的SpringAmqpTest类中添加测试方法:

@Test

public void testSendDirectExchange() {

// 交换机名称

String exchangeName = "itcast.direct";

// 消息

String message = "红色警报!日本乱排核废水,导致海洋生物变异,惊现哥斯拉!";

// 发送消息

rabbitTemplate.convertAndSend(exchangeName, "red", message);

}

总结

描述下Direct交换机与Fanout交换机的差异?

- Fanout交换机将消息路由给每一个与之绑定的队列。

- Direct交换机根据RoutingKey判断路由给哪个队列。

- 如果多个队列具有相同的RoutingKey,则与Fanout功能类似。

基于@RabbitListener注解声明队列和交换机有哪些常见注解?

- @Queue

- @Exchange

Topic

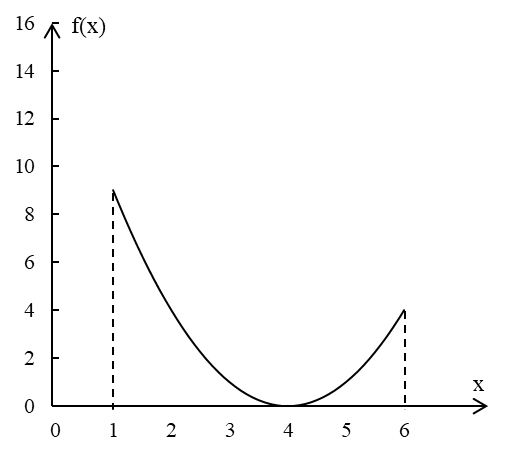

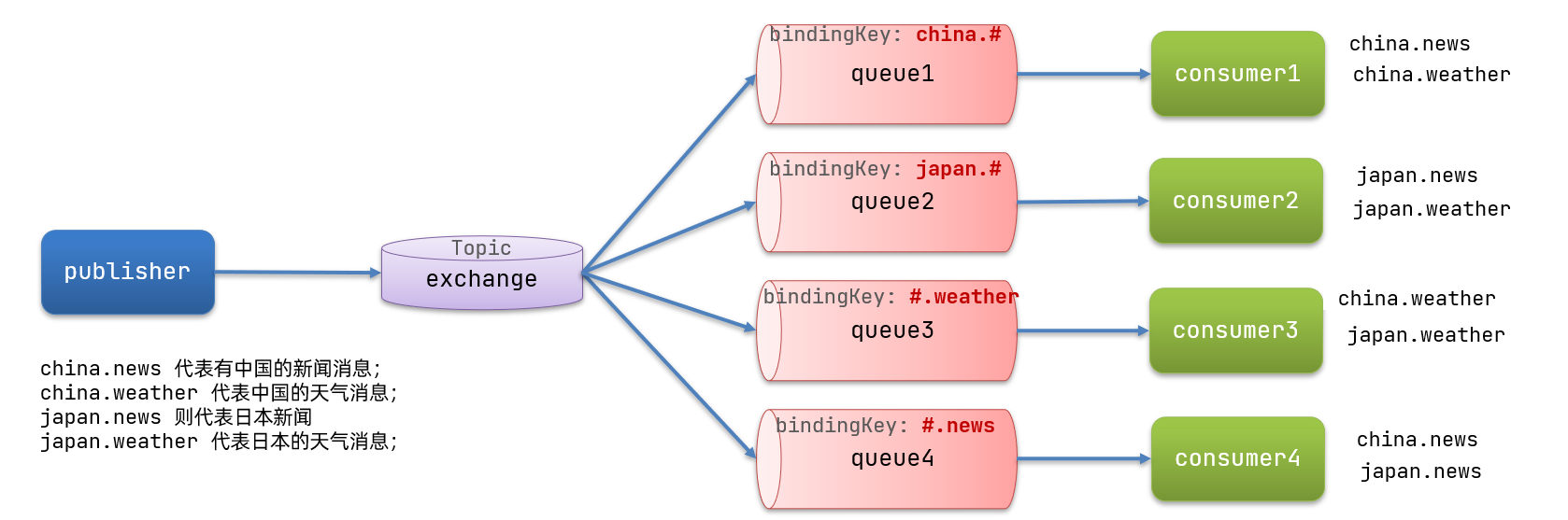

说明

Topic类型的Exchange与Direct相比,都是可以根据RoutingKey把消息路由到不同的队列。只不过Topic类型Exchange可以让队列在绑定Routing key 的时候使用通配符!

Routingkey 一般都是有一个或多个单词组成,多个单词之间以”.”分割,例如: item.insert

通配符规则:

#:匹配一个或多个词

*:匹配不多不少恰好1个词

举例:

item.#:能够匹配item.spu.insert 或者 item.spu

item.*:只能匹配item.spu

图示

解释:

- Queue1:绑定的是

china.#,因此凡是以china.开头的routing key都会被匹配到。包括china.news和china.weather - Queue2:绑定的是

#.news,因此凡是以.news结尾的routing key都会被匹配。包括china.news和japan.news

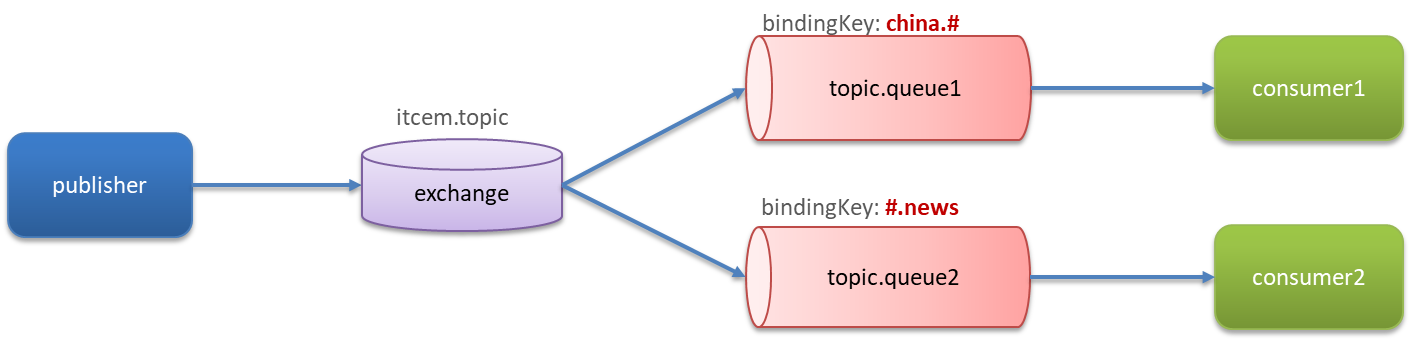

实现思路如下:

-

并利用@RabbitListener声明Exchange、Queue、RoutingKey

-

在consumer服务中,编写两个消费者方法,分别监听topic.queue1和topic.queue2

-

在publisher中编写测试方法,向item. topic发送消息。

消息发送

在publisher服务的SpringAmqpTest类中添加测试方法:

/**

* topicExchange

*/

@Test

public void testSendTopicExchange() {

// 交换机名称

String exchangeName = "itcast.topic";

// 消息

String message = "喜报!孙悟空大战哥斯拉,胜!";

// 发送消息

rabbitTemplate.convertAndSend(exchangeName, "china.news", message);

}

消息接收

在consumer服务的SpringRabbitListener中添加方法:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "topic.queue1"),

exchange = @Exchange(name = "itcast.topic", type = ExchangeTypes.TOPIC),

key = "china.#"

))

public void listenTopicQueue1(String msg){

System.out.println("消费者接收到topic.queue1的消息:【" + msg + "】");

}

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "topic.queue2"),

exchange = @Exchange(name = "itcast.topic", type = ExchangeTypes.TOPIC),

key = "#.news"

))

public void listenTopicQueue2(String msg){

System.out.println("消费者接收到topic.queue2的消息:【" + msg + "】");

}

总结

描述下Direct交换机与Topic交换机的差异?

- Topic交换机接收的消息RoutingKey必须是多个单词,以

**.**分割 - Topic交换机与队列绑定时的bindingKey可以指定通配符

#:代表0个或多个词*:代表1个词

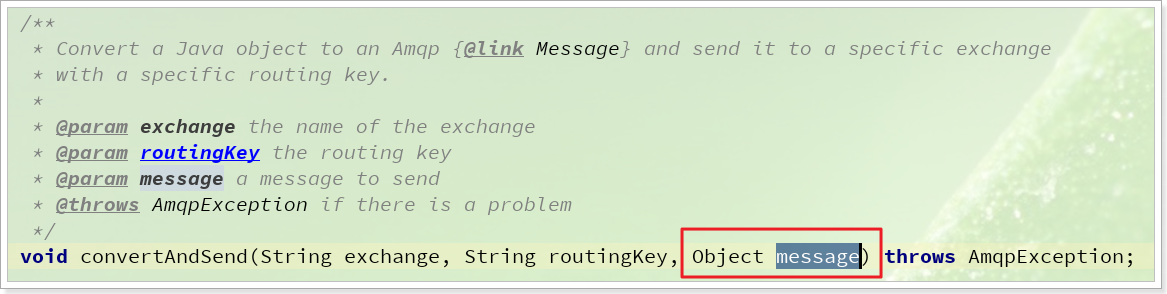

消息转换器

Spring会把发送的消息序列化为字节发送给MQ,接收消息的时候,还会把字节反序列化为Java对象。

只不过,默认情况下Spring采用的序列化方式是JDK序列化。众所周知,JDK序列化存在下列问题:

- 数据体积过大

- 有安全漏洞

- 可读性差

默认转换器

修改消息发送的代码,发送一个Map对象:

@Test

public void testSendMap() throws InterruptedException {

// 准备消息

Map<String,Object> msg = new HashMap<>();

msg.put("name", "Jack");

msg.put("age", 21);

// 发送消息

rabbitTemplate.convertAndSend("simple.queue","", msg);

}

停止consumer服务

发送消息后查看控制台:

配置JSON转换器

显然,JDK序列化方式并不合适。可以使用JSON方式来做序列化和反序列化,使得消息体的体积更小、可读性更高。

在publisher和consumer两个服务中都引入依赖:

<dependency>

<groupId>com.fasterxml.jackson.dataformat</groupId>

<artifactId>jackson-dataformat-xml</artifactId>

<version>2.9.10</version>

</dependency>

配置消息转换器。

在启动类中添加一个Bean即可:

@Bean

public MessageConverter jsonMessageConverter(){

return new Jackson2JsonMessageConverter();

}

消息队列在使用过程中,面临着很多实际问题需要思考:

消息可靠性

消息从发送,到消费者接收,会经理多个过程:

其中的每一步都可能导致消息丢失,常见的丢失原因包括:

- 发送时丢失:

- 生产者发送的消息未送达exchange

- 消息到达exchange后未到达queue

- MQ宕机,queue将消息丢失

- consumer接收到消息后未消费就宕机

针对这些问题,RabbitMQ分别给出了解决方案:

- 生产者确认机制

- mq持久化

- 消费者确认机制

- 失败重试机制

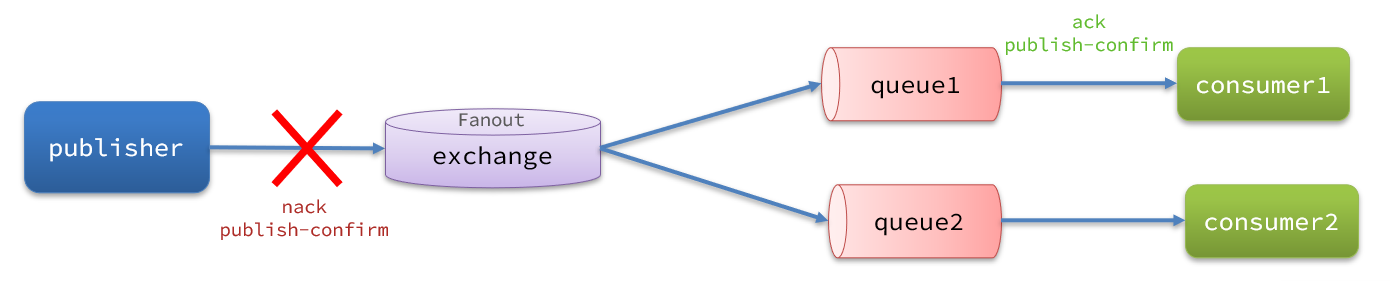

生产者消息确认

RabbitMQ提供了publisher confirm机制来避免消息发送到MQ过程中丢失。这种机制必须给每个消息指定一个唯一ID。消息发送到MQ以后,会返回一个结果给发送者,表示消息是否处理成功。

返回结果有两种方式:

- publisher-confirm,发送者确认

- 消息成功投递到交换机,返回ack

- 消息未投递到交换机,返回nack

- publisher-return,发送者回执

- 消息投递到交换机了,但是没有路由到队列。返回ACK,及路由失败原因。

注意:确认机制发送消息时,需要给每个消息设置一个全局唯一id,以区分不同消息,避免ack冲突。

修改配置

首先,修改生产者服务中的application.yml文件,添加下面的内容:

spring:

rabbitmq:

publisher-confirm-type: correlated

publisher-returns: true

template:

mandatory: true

publish-confirm-type:开启publisher-confirm,这里支持两种类型:simple:同步等待confirm结果,直到超时correlated:异步回调,定义ConfirmCallback,MQ返回结果时会回调这个ConfirmCallback

publish-returns:开启publish-return功能,同样是基于callback机制,不过是定义ReturnCallbacktemplate.mandatory:定义消息路由失败时的策略。true,则调用ReturnCallback;false:则直接丢弃消息

定义Return回调

每个RabbitTemplate只能配置一个ReturnCallback,因此需要在项目加载时配置。

在生产者服务中添加一个Config配置类

@Configuration

public class CommonConfig implements ApplicationContextAware {

@Override

public void setApplicationContext(ApplicationContext applicationContext) throws BeansException {

// 获取RabbitTemplate

RabbitTemplate rabbitTemplate = applicationContext.getBean(RabbitTemplate.class);

// 设置ReturnCallback

rabbitTemplate.setReturnCallback((message, replyCode, replyText, exchange, routingKey) -> {

// 投递失败,记录日志

log.info("消息发送失败,应答码{},原因{},交换机{},路由键{},消息{}",

replyCode, replyText, exchange, routingKey, message.toString());

// 如果有业务需要,可以重发消息

});

}

}

定义ConfirmCallback

ConfirmCallback可以在发送消息时指定,因为每个业务处理confirm成功或失败的逻辑不一定相同。

在生产者服务的测试类中,定义一个单元测试方法

public void testSendMessage2SimpleQueue() throws InterruptedException {

// 1.消息体

String message = "hello, spring amqp!";

// 2.全局唯一的消息ID,需要封装到CorrelationData中

CorrelationData correlationData = new CorrelationData(UUID.randomUUID().toString());

// 3.添加callback

correlationData.getFuture().addCallback(

result -> {

if(result.isAck()){

// 3.1.ack,消息成功

log.debug("消息发送成功, ID:{}", correlationData.getId());

}else{

// 3.2.nack,消息失败

log.error("消息发送失败, ID:{}, 原因{}",correlationData.getId(), result.getReason());

}

},

ex -> log.error("消息发送异常, ID:{}, 原因{}",correlationData.getId(),ex.getMessage())

);

// 4.发送消息

rabbitTemplate.convertAndSend("task.direct", "task", message, correlationData);

// 休眠一会儿,等待ack回执

Thread.sleep(2000);

}

消息持久化

生产者确认可以确保消息投递到RabbitMQ的队列中,但是消息发送到RabbitMQ以后,如果突然宕机,也可能导致消息丢失。

要想确保消息在RabbitMQ中安全保存,必须开启消息持久化机制。

- 交换机持久化

- 队列持久化

- 消息持久化

必须保证上述三点都持久化,才是真正的消息持久化。

交换机持久化

RabbitMQ中交换机默认是非持久化的,mq重启后就丢失。

SpringAMQP中可以通过代码指定交换机持久化:

@Bean

public DirectExchange simpleExchange(){

// 三个参数:交换机名称、是否持久化、当没有queue与其绑定时是否自动删除

return new DirectExchange("simple.direct", true, false);

}

默认情况下,由SpringAMQP声明的交换机都是持久化的。

可以在RabbitMQ控制台看到持久化的交换机都会带上D的标示:

队列持久化

RabbitMQ中队列默认是非持久化的,mq重启后就丢失。

SpringAMQP中可以通过代码指定交换机持久化:

@Bean

public Queue simpleQueue(){

// 使用QueueBuilder构建队列,durable就是持久化的

return QueueBuilder.durable("simple.queue").build();

}

默认情况下,由SpringAMQP声明的队列都是持久化的。

可以在RabbitMQ控制台看到持久化的队列都会带上D的标示:

消息持久化

利用SpringAMQP发送消息时,可以设置消息的属性(MessageProperties),指定delivery-mode:

- 1:非持久化

- 2:持久化

用java代码指定

@Test

public void testDurableMessage(){

// 创建消息

Message message = MessageBuilder

.withBody("hello,TTL Queue".getBytes(StandardCharsets.UTF_8))

.setDeliveryMode(MessageDeliveryMode.PERSISTENT)

.build();

// 消息ID,需要封装到CorrelationData中

CorrelationData correlationData = new CorrelationData(UUID.randomUUID().toString());

// 发送消息

rabbitTemplate.convertAndSend("simple.queue",message,correlationData);

// 记录日志

log.debug("发送消息成功!");

}

默认情况下,SpringAMQP发出的任何消息都是持久化的,不用特意指定。

消费者消息确认

RabbitMQ是阅后即焚机制,即RabbitMQ确认消息被消费者消费后会立刻删除此消息。

而RabbitMQ是通过消费者回执来确认消费者是否成功处理消息的:消费者获取消息后,应该向RabbitMQ发送ACK回执,表明自己已经处理消息。

如果RabbitMQ投递消息给消费者,消费者获取消息后,并返回ACK给RabbitMQ,RabbitMQ删除消息之后,此时消费者宕机,接收到的消息还未来得及处理。这样,消息就丢失了,因此消费者返回ACK的时机相当重要。

而SpringAMQP则允许配置三种确认模式:

•manual:手动ack,需要在业务代码结束后,调用api发送ack(根据业务情况,自行判断什么时候该返回ack)。

•auto:自动ack,由spring监测listener代码是否出现异常,没有异常则返回ack;抛出异常则返回nack(类似事务机制,出现异常时返回nack,消息回滚到mq;没有异常,返回ack)。

•none:关闭ack,MQ假定消费者获取消息后会成功处理,因此消息投递后立即被删除(消息投递是不可靠的,可能丢失)。

配置确认模式

修改消费者服务的application.yml文件,添加下面内容:

spring:

rabbitmq:

listener:

simple:

acknowledge-mode: auto # 自动ACK

修改consumer服务的SpringRabbitListener类中的方法,模拟一个消息处理异常:

@RabbitListener(queues = "simple.queue")

public void listenSimpleQueue(String msg) {

log.info("消费者接收到simple.queue的消息:【{}】", msg);

// 模拟异常

System.out.println(1 / 0);

log.debug("消息处理完成!");

}

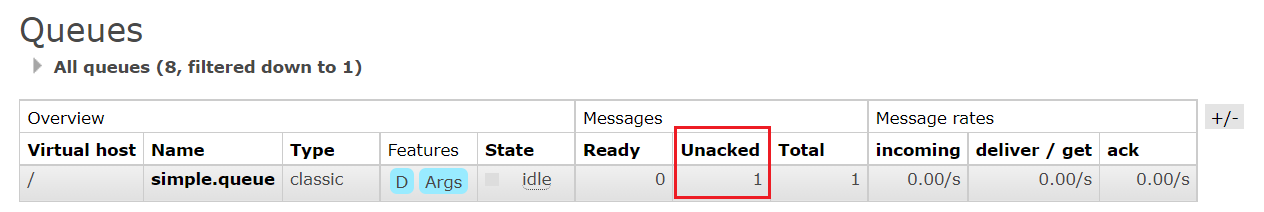

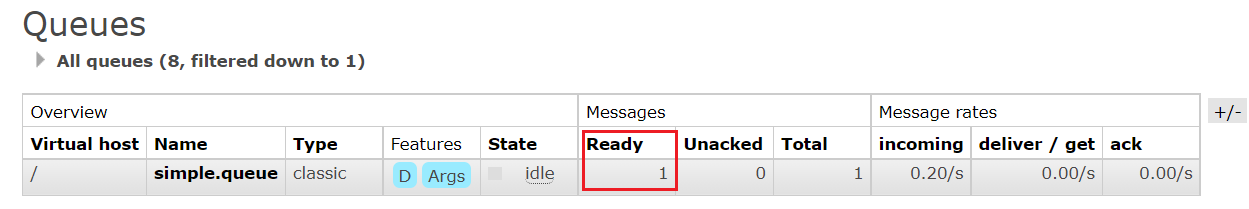

在异常位置打断点,再次发送消息,程序卡在断点时,可以发现此时消息状态为unack(未确定状态)

抛出异常后,因为Spring会自动返回nack,所以消息恢复至Ready状态,并且没有被RabbitMQ删除:

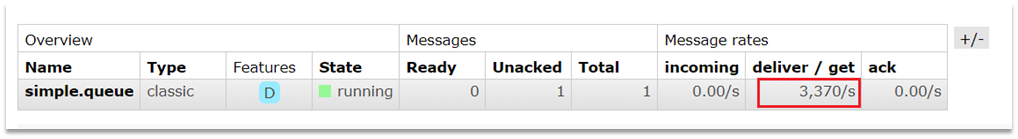

消费失败重试机制

当消费者出现异常后,消息会不断requeue(重入队)到队列,再重新发送给消费者,然后再次异常,再次requeue,无限循环,导致mq的消息处理飙升,带来不必要的压力

此时有两种解决办法:1、本地重试。2、失败策略。

本地重试

可以利用Spring的retry机制,在消费者出现异常时利用本地重试,而不是无限制的requeue到mq队列。

修改消费者服务的application.yml文件,添加内容:

spring:

rabbitmq:

listener:

simple:

retry:

enabled: true # 开启消费者失败重试

initial-interval: 1000 # 初识的失败等待时长为1秒

multiplier: 1 # 失败的等待时长倍数,下次等待时长 = multiplier * last-interval

max-attempts: 3 # 最大重试次数

stateless: true # true无状态;false有状态。如果业务中包含事务,这里改为false

重启消费者服务,重复之前的测试。可以发现:

- 在重试3次后,SpringAMQP会抛出异常AmqpRejectAndDontRequeueException,说明触发本地重试。

- 查看RabbitMQ控制台,发现消息被删除了,说明最后SpringAMQP返回的是ack,mq将消息删除了。

由此可见当开启本地重试时,消息处理过程中抛出异常,不会requeue到队列,而是在消费者本地重试。重试达到最大次数后,Spring会返回ack,消息会被丢弃。

失败策略

在之前的测试中,达到最大重试次数后,消息会被丢弃,这是由Spring内部机制决定的。

在开启重试模式后,重试次数耗尽,如果消息依然失败,则需要有MessageRecovery接口来处理,它包含三种不同的实现:

- RejectAndDontRequeueRecoverer:重试耗尽后,直接reject,丢弃消息。默认就是这种方式

- ImmediateRequeueMessageRecoverer:重试耗尽后,返回nack,消息重新入队

- RepublishMessageRecoverer:重试耗尽后,将失败消息投递到一个指定的,专门存放异常消息的队列,后续由人工集中处理。

配置失败策略

- 在消费者服务中定义处理失败消息的交换机和队列

@Bean

public DirectExchange errorMessageExchange(){

return new DirectExchange("error.direct");

}

@Bean

public Queue errorQueue(){

return new Queue("error.queue", true);

}

@Bean

public Binding errorBinding(){

return BindingBuilder.bind(errorQueue()).to(errorMessageExchange()).with("error");

}

- 定义一个RepublishMessageRecoverer,关联队列和交换机

@Bean

public MessageRecoverer republishMessageRecoverer(RabbitTemplate rabbitTemplate){

return new RepublishMessageRecoverer(rabbitTemplate, "error.direct", "error");

}

完整代码

@Configuration

public class ErrorMessageConfig {

@Bean

public DirectExchange errorMessageExchange(){

return new DirectExchange("error.direct");

}

@Bean

public Queue errorQueue(){

return new Queue("error.queue", true);

}

@Bean

public Binding errorBinding(){

return BindingBuilder.bind(errorQueue()).to(errorMessageExchange()).with("error");

}

@Bean

public MessageRecoverer republishMessageRecoverer(RabbitTemplate rabbitTemplate){

return new RepublishMessageRecoverer(rabbitTemplate, "error.direct", "error");

}

}

由此可以得出,确保RabbitMQ消息的可靠性的措施有:

- 开启生产者确认机制,确保生产者的消息能到达队列。

- 开启持久化功能,确保消息未消费前在队列中不会丢失。

- 开启消费者确认机制为auto,由spring确定消息处理成功之后完成ACK。

- 开启消费者失败重试机制,并设置MessageRecoverer,多次重试失败后将消息投递到异常交换机,交由人工处理。

死信交换机

定义

当一个队列中的消息满足下列情况之一时,可以成为死信(dead letter):

- 消费者使用basic.reject或 basic.nack声明消费失败,并且消息的requeue参数设置为false

- 消息是一个过期消息,超时无人消费

- 要投递的队列消息满了,无法投递

如果这个包含死信的队列配置了dead-letter-exchange属性,指定了一个交换机,那么队列中的死信就会投递到这个交换机中,而这个交换机称为死信交换机(Dead Letter Exchange,简称DLX)。

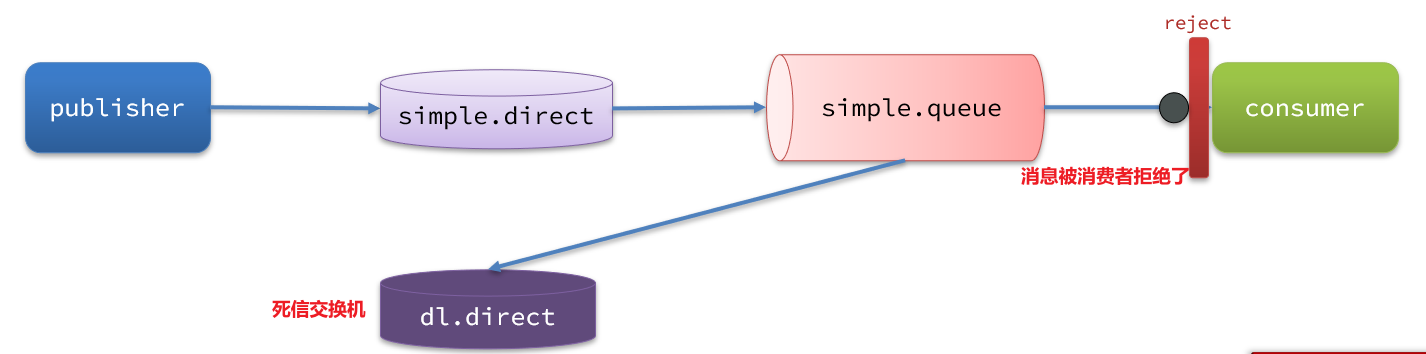

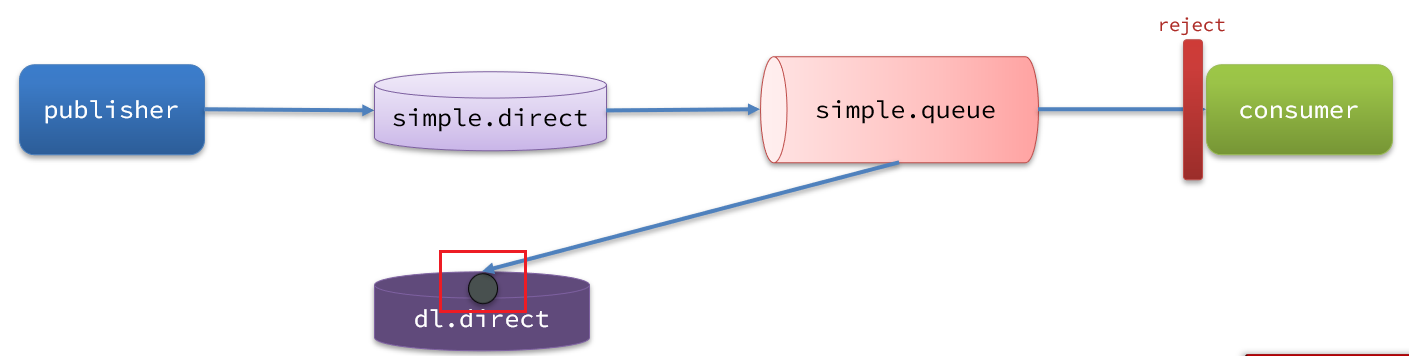

一个消息被消费者拒绝了,变成了死信:

因为simple.queue绑定了死信交换机 dl.direct,因此死信会投递给这个交换机:

如果这个死信交换机也绑定了一个队列,则消息最终会进入这个存放死信的队列:

另外,队列将死信投递给死信交换机时,必须知道两个信息:

- 死信交换机名称

- 死信交换机与死信队列绑定的RoutingKey

这样才能确保投递的消息能到达死信交换机,并且正确的路由到死信队列。

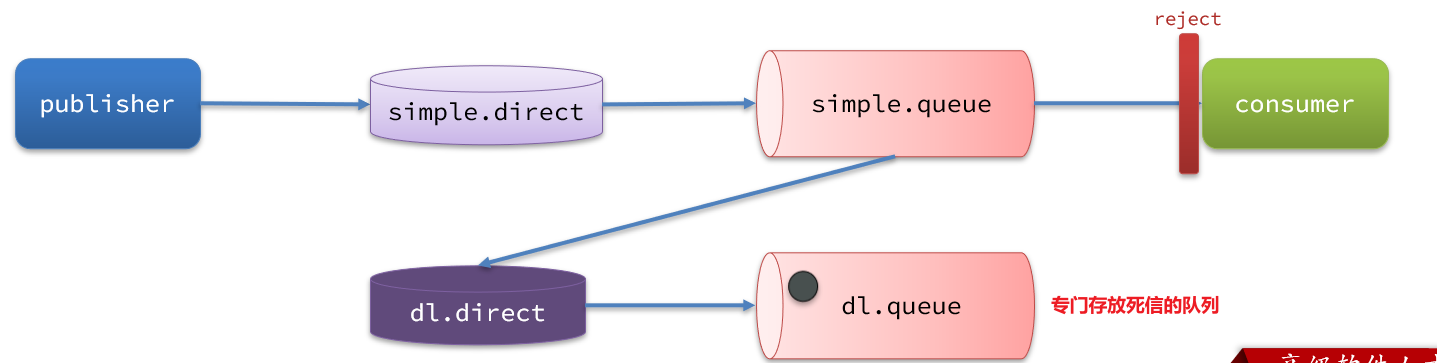

利用死信交换机接收死信

在失败重试策略中,默认的RejectAndDontRequeueRecoverer会在本地重试次数耗尽后,发送reject给RabbitMQ,消息变成死信,被丢弃。

可以给simple.queue添加一个死信交换机,给死信交换机绑定一个队列。这样消息变成死信后也不会丢弃,而是最终投递到死信交换机,路由到与死信交换机绑定的队列。

在消费者服务中,定义一组死信交换机、死信队列

// 声明普通的 simple.queue队列,并且为其指定死信交换机:dl.direct

@Bean

public Queue simpleQueue2(){

return QueueBuilder.durable("simple.queue") // 指定队列名称,并持久化

.deadLetterExchange("dl.direct") // 指定死信交换机

.build();

}

// 声明死信交换机 dl.direct

@Bean

public DirectExchange dlExchange(){

return new DirectExchange("dl.direct", true, false);

}

// 声明存储死信的队列 dl.queue

@Bean

public Queue dlQueue(){

return new Queue("dl.queue", true);

}

// 将死信队列 与 死信交换机绑定

@Bean

public Binding dlBinding(){

return BindingBuilder.bind(dlQueue()).to(dlExchange()).with("simple");

}

使用场景:

- 队列绑定了死信交换机,死信会投递到死信交换机。

- 利用死信交换机收集所有消费者处理失败的消息(死信),交由人工处理,进一步提高消息队列的可靠性。

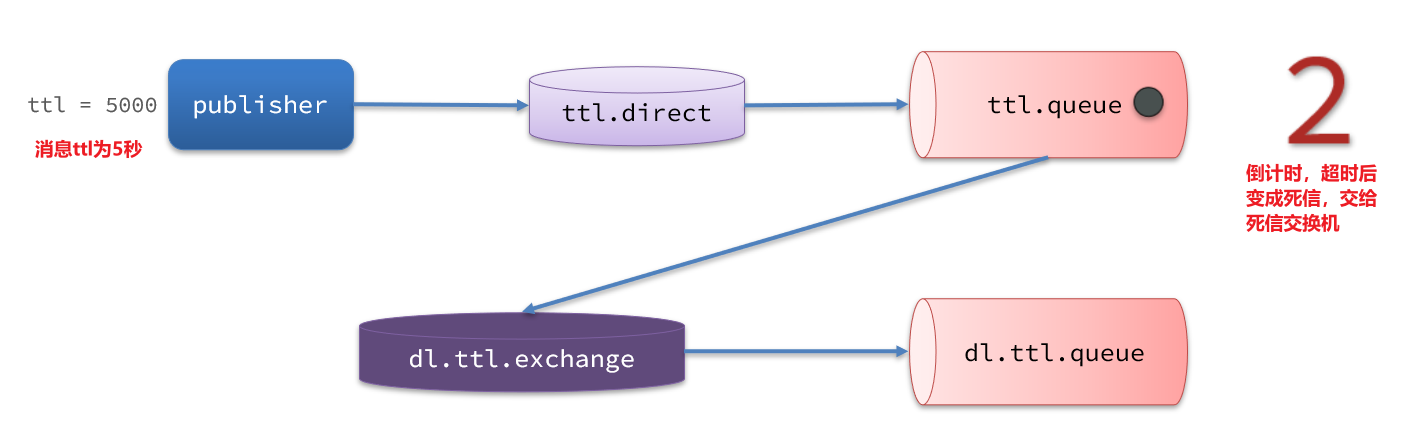

TTL

一个队列中的消息如果超时未消费,则会变为死信,超时分为两种情况:

- 消息所在的队列设置了超时时间

- 消息本身设置了超时时间

声明队列时指定TTL

在消费者服务的SpringRabbitListener中,定义一个新的消费者,并且声明死信交换机、死信队列:

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "dl.ttl.queue", durable = "true"),

exchange = @Exchange(name = "dl.ttl.direct"),

key = "ttl"

))

public void listenDlQueue(String msg){

log.info("接收到 dl.ttl.queue的延迟消息:{}", msg);

}

要给队列设置超时时间,需要在声明队列时配置x-message-ttl属性:

@Bean

public Queue ttlQueue(){

return QueueBuilder.durable("ttl.queue") // 指定队列名称,并持久化

.ttl(10000) // 设置队列的超时时间,10秒

.deadLetterExchange("dl.ttl.direct") // 指定死信交换机

.build();

}

注意,这个队列设定了死信交换机为dl.ttl.direct

声明交换机,将TTL与交换机绑定:

@Bean

public DirectExchange ttlExchange(){

return new DirectExchange("ttl.direct");

}

@Bean

public Binding ttlBinding(){

return BindingBuilder.bind(ttlQueue()).to(ttlExchange()).with("ttl");

}

发送消息,但是不要指定TTL:

@Test

public void testTTLQueue() {

// 创建消息

String message = "hello, ttl queue";

// 消息ID,需要封装到CorrelationData中

CorrelationData correlationData = new CorrelationData(UUID.randomUUID().toString());

// 发送消息

rabbitTemplate.convertAndSend("ttl.direct", "ttl", message, correlationData);

// 记录日志

log.debug("发送消息成功");

}

发送消息时指定TTL

在发送消息时,也可以指定TTL:

@Test

public void testTTLMsg() {

// 创建消息

Message message = MessageBuilder

.withBody("hello, ttl message".getBytes(StandardCharsets.UTF_8))

.setExpiration("10000")

.build();

// 消息ID,需要封装到CorrelationData中

CorrelationData correlationData = new CorrelationData(UUID.randomUUID().toString());

// 发送消息

rabbitTemplate.convertAndSend("ttl.direct", "ttl", message, correlationData);

log.debug("发送消息成功");

}

延迟队列

利用TTL结合死信交换机,我们实现了消息发出后,消费者延迟收到消息的效果。这种消息模式就称为延迟队列(Delay Queue)模式。

延迟队列的使用场景包括:

- 用户下单,如果用户在15 分钟内未支付,则自动取消

- 预约工作会议,10分钟后自动通知所有参会人员

因为延迟队列的需求非常多,所以RabbitMQ的官方也推出了一个插件,原生支持延迟队列效果。

这个插件就是DelayExchange插件。

参考RabbitMQ的插件列表页面:https://www.rabbitmq.com/community-plugins.html

使用方式可以参考官网地址:https://blog.rabbitmq.com/posts/2015/04/scheduling-messages-with-rabbitmq

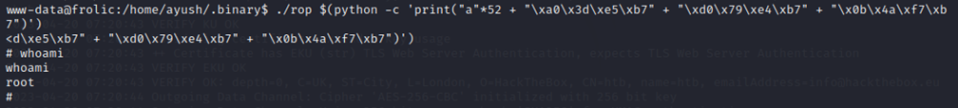

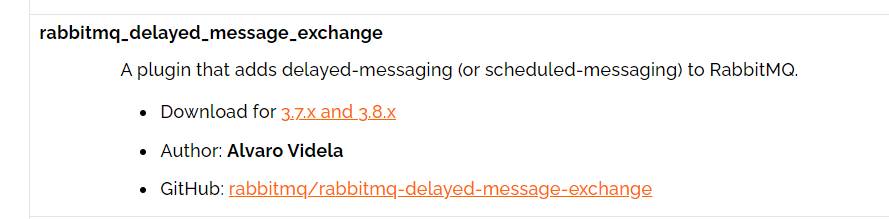

安装DelayExchange插件

可以去对应的GitHub页面下载3.8.9版本的插件,地址为https://github.com/rabbitmq/rabbitmq-delayed-message-exchange/releases/tag/3.8.9

这个对应RabbitMQ的3.8.5以上版本。

上传插件

因为是基于Docker安装,所以需要先查看RabbitMQ的插件目录对应的数据卷。但是前面安装MQ时并未挂载数据卷,所以这里重新创建一个MQ容器。

先移除之前创建的容器

docker rm -f mq

创建MQ容器

docker run \

-e RABBITMQ_DEFAULT_USER=itcast \

-e RABBITMQ_DEFAULT_PASS=123321 \

-v mq-plugins:/plugins \

--name mq \

--hostname mq1 \

-p 15672:15672 \

-p 5672:5672 \

-d \

rabbitmq:3.8-management

使用下面命令查看数据卷

docker volume inspect mq-plugins

可以得知挂载的位置在/var/lib/docker/volumes/mq-plugins/_data

将下载好的插件上传至该目录即可。

安装插件

安装需要进入MQ容器内部执行安装,执行以下命令

docker exec -it mq bash

进入容器内部后,执行下面命令开启插件:

rabbitmq-plugins enable rabbitmq_delayed_message_exchange

安装成功结果如下:

DelayExchange原理

DelayExchange需要将一个交换机声明为delayed类型。当有消息发送到delayExchange时,流程如下:

-

接收消息

-

判断消息是否具备x-delay属性

-

如果有x-delay属性,说明是延迟消息,持久化到硬盘,读取x-delay值,作为延迟时间

-

返回routing not found结果给消息发送者

-

x-delay时间到期后,重新投递消息到指定队列

使用DelayExchange

插件的使用也非常简单:声明一个交换机,交换机的类型可以是任意类型,只需要设定delayed属性为true即可,然后声明队列与其绑定即可。

声明DelayExchange交换机

基于注解方式(推荐)

@RabbitListener(bindings = @QueueBinding(

value = @Queue(name = "dl.queue", durable = "true"),

exchange = @Exchange(name = "dl.direct"),

key = "dl" ))public void listenDlQueue(String msg){

log.info("接收到 dl.queue的延迟消息:{}", msg);

}

基于@Bean方式

@Bean

public DirectExchange ttlExchange(){

return new DirectExchange("ttl.direct");

}

@Bean

public Queue ttlQueue(){

return QueueBuilder.durable("ttl.queue") // 指定队列名称,并持久化

.ttl(10000) // 设置队列的超时时间,10秒

.deadLetterExchange("dl.direct") // 指定死信交换机

.deadLetterRoutingKey("dl") // 指定死信RoutingKey

.build();

}

@Bean

public Binding simpleBinding(){

return BindingBuilder.bind(ttlQueue()).to(ttlExchange()).with("ttl");

}

发送消息时,一定要携带x-delay属性,并指定延迟的时间。

@Test

public void testTTLMsg() {

// 创建消息

Message message = MessageBuilder

.withBody("hello, ttl message".getBytes(StandardCharsets.UTF_8))

.setExpiration("5000")

.build();

// 消息ID,需要封装到CorrelationData中

CorrelationData correlationData = new CorrelationData(UUID.randomUUID().toString());

// 发送消息

rabbitTemplate.convertAndSend("ttl.direct", "ttl", message, correlationData);

}

惰性队列

消息堆积问题

当生产者发送消息的速度超过了消费者处理消息的速度,就会导致队列中的消息堆积,直到队列存储消息达到上限。之后发送的消息就会成为死信,可能会被丢弃,这就是消息堆积问题。

解决消息堆积有两种思路:

- 增加更多消费者,提高消费速度。也就是我们之前说的work queue模式

- 扩大队列容积,提高堆积上限

惰性队列

从RabbitMQ的3.6.0版本开始,就增加了Lazy Queues的概念,也就是惰性队列。惰性队列的特征如下:

- 接收到消息后直接存入磁盘而非内存

- 消费者要消费消息时才会从磁盘中读取并加载到内存

- 支持数百万条的消息存储

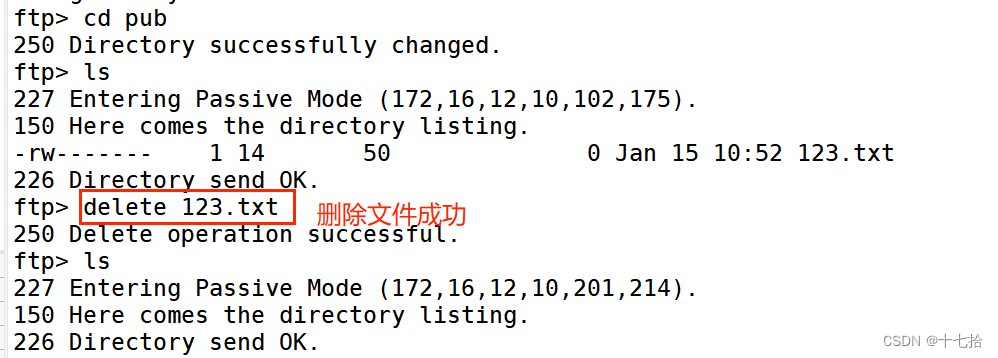

基于命令行设置lazy-queue

要设置一个队列为惰性队列,只需要在声明队列时,指定x-queue-mode属性为lazy即可。可以通过命令行将一个运行中的队列修改为惰性队列:

rabbitmqctl set_policy Lazy "^lazy-queue$" '{"queue-mode":"lazy"}' --apply-to queues

rabbitmqctl:RabbitMQ的命令行工具set_policy:添加一个策略Lazy:策略名称,可以自定义"^lazy-queue$":用正则表达式匹配队列的名字'{"queue-mode":"lazy"}':设置队列模式为lazy模式--apply-to queues:策略的作用对象,是所有的队列

基于@Bean声明lazy-queue

@Bean

public Queue lazyQueue(){

return QueueBuilder

.durable("lazy.queue")

.lazy() // 开启x-queue-mode为lazy

.build();

}

基于@RabbitListener声明LazyQueue

@RabbitListener(queuesToDeclare = @Queue(

name = "lazy.queue",

durable = "true",

arguments = @Argument(name = "x-queue-mode",value = "lazy")

))

public void listenLazyQueue(String message){

log.info("接收到 lazy.queue 的消息:{}",message);

}

惰性队列的优点:

- 基于磁盘存储,消息上限高

- 没有间歇性的page-out,性能比较稳定

惰性队列的缺点:

- 基于磁盘存储,消息时效性会降低

- 性能受限于磁盘的IO

MQ集群

集群的分类

RabbitMQ的是基于Erlang语言编写,而Erlang又是一个面向并发的语言,天然支持集群模式。RabbitMQ的集群有两种模式:

-

普通集群:是一种分布式集群,将队列分散到集群的各个节点,从而提高整个集群的并发能力。

-

镜像集群:是一种主从集群,普通集群的基础上,添加了主从备份功能,提高集群的数据可用性。

镜像集群虽然支持主从,但主从同步并不是强一致的,某些情况下可能有数据丢失的风险。因此在RabbitMQ的3.8版本以后,推出了新的功能:

- 仲裁队列来代替镜像集群,底层采用Raft协议确保主从的数据一致性。

普通集群

普通集群,或者叫标准集群(classic cluster),具备下列特征:

- 会在集群的各个节点间共享部分数据,包括:交换机、队列元信息。不包含队列中的消息。

- 当访问集群某节点时,如果队列不在该节点,会从数据所在节点传递到当前节点并返回

- 队列所在节点宕机,队列中的消息就会丢失

结构如下

部署

计划部署三节点的mq集群:

| 主机名 | 控制台端口 | amqp通信端口 |

|---|---|---|

| mq1 | 8081 —> 15672 | 8071 —> 5672 |

| mq2 | 8082 —> 15672 | 8072 —> 5672 |

| mq3 | 8083 —> 15672 | 8073 —> 5672 |

集群中的节点标示默认都是:rabbit@[hostname],因此以上三个节点的名称分别为:

- rabbit@mq1

- rabbit@mq2

- rabbit@mq3

获取Cookie

RabbitMQ底层依赖于Erlang,而Erlang虚拟机就是一个面向分布式的语言,默认就支持集群模式。集群模式中的每个RabbitMQ 节点使用 cookie 来确定它们是否被允许相互通信。

要使两个节点能够通信,它们必须具有相同的共享秘密,称为Erlang cookie。cookie 只是一串最多 255 个字符的字母数字字符。

每个集群节点必须具有相同的 cookie。实例之间也需要它来相互通信。

先在之前启动的mq容器中获取一个cookie值,作为集群的cookie。执行下面的命令

docker exec -it mq cat /var/lib/rabbitmq/.erlang.cookie

记录保存获取到的Cookie值,以备后用。

接下来,停止并删除当前的mq容器,重新搭建集群。

docker rm -f mq

准备集群配置

在/tmp目录新建一个配置文件 rabbitmq.conf:

cd /tmp

# 创建文件

touch rabbitmq.conf

文件内容如下:

loopback_users.guest = false

listeners.tcp.default = 5672

cluster_formation.peer_discovery_backend = rabbit_peer_discovery_classic_config

cluster_formation.classic_config.nodes.1 = rabbit@mq1

cluster_formation.classic_config.nodes.2 = rabbit@mq2

cluster_formation.classic_config.nodes.3 = rabbit@mq3

再创建一个文件,记录cookie

cd /tmp

# 创建cookie文件

touch .erlang.cookie

# 写入cookie

echo "FXZMCVGLBIXZCDEMMVZQ" > .erlang.cookie

# 修改cookie文件的权限

chmod 600 .erlang.cookie

准备三个目录,mq1、mq2、mq3:

cd /tmp

# 创建目录

mkdir mq1 mq2 mq3

然后拷贝rabbitmq.conf、cookie文件到mq1、mq2、mq3:

# 进入/tmp

cd /tmp

# 拷贝

cp rabbitmq.conf mq1

cp rabbitmq.conf mq2

cp rabbitmq.conf mq3

cp .erlang.cookie mq1

cp .erlang.cookie mq2

cp .erlang.cookie mq3

启动集群

创建网络

docker network create mq-net

运行命令

# 运行mq1

docker run -d --net mq-net \

-v ${PWD}/mq1/rabbitmq.conf:/etc/rabbitmq/rabbitmq.conf \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=admin \

-e RABBITMQ_DEFAULT_PASS=123456 \

--name mq1 \

--hostname mq1 \

-p 8071:5672 \

-p 8081:15672 \

rabbitmq:3.8-management

# 运行mq2

docker run -d --net mq-net \

-v ${PWD}/mq2/rabbitmq.conf:/etc/rabbitmq/rabbitmq.conf \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=admin \

-e RABBITMQ_DEFAULT_PASS=123456 \

--name mq2 \

--hostname mq2 \

-p 8072:5672 \

-p 8082:15672 \

rabbitmq:3.8-management

# 运行mq3

docker run -d --net mq-net \

-v ${PWD}/mq3/rabbitmq.conf:/etc/rabbitmq/rabbitmq.conf \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=admin \

-e RABBITMQ_DEFAULT_PASS=123456 \

--name mq3 \

--hostname mq3 \

-p 8073:5672 \

-p 8083:15672 \

rabbitmq:3.8-management

到此,一个普通的集群就部署完毕。

镜像集群

在刚刚的案例中,一旦创建队列的主机宕机,队列就会不可用。不具备高可用能力。如果要解决这个问题,必须使用官方提供的镜像集群方案。

官方文档地址:https://www.rabbitmq.com/ha.html

镜像集群:本质是主从模式,具备下面的特征。

- 交换机、队列、队列中的消息会在各个mq的镜像节点之间同步备份。

- 创建队列的节点被称为该队列的主节点,备份到的其它节点叫做该队列的镜像节点。

- 一个队列的主节点可能是另一个队列的镜像节点

- 所有操作都是主节点完成,然后同步给镜像节点

- 主宕机后,镜像节点会替代成新的主(如果在主从同步完成前,主就已经宕机,可能出现数据丢失)

- 不具备负载均衡功能,因为所有操作都会有主节点完成(但是不同队列,其主节点可以不同,可以利用这个提高吞吐量)

结构如下

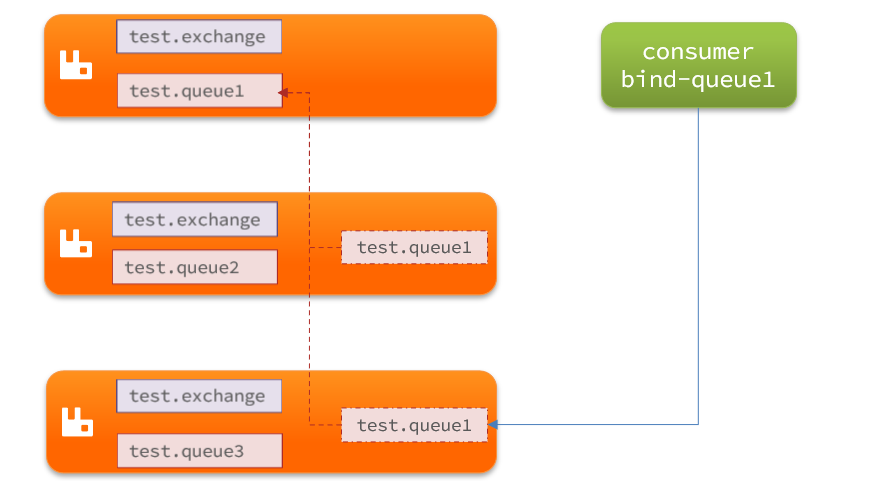

默认情况下,队列只保存在创建该队列的节点上。而镜像模式下,创建队列的节点被称为该队列的主节点,队列还会拷贝到集群中的其它节点,也叫做该队列的镜像节点。

但是,不同队列可以在集群中的任意节点上创建,因此不同队列的主节点可以不同。甚至,一个队列的主节点可能是另一个队列的镜像节点。

用户发送给队列的一切请求,例如发送消息、消息回执默认都会在主节点完成,如果是从节点接收到请求,也会路由到主节点去完成。镜像节点仅仅起到备份数据作用。

当主节点接收到消费者的ACK时,所有镜像都会删除节点中的数据。

部署

镜像模式的配置有3种模式:

| hamode | haparams | 效果 |

|---|---|---|

| 准确模式exactly | 队列的副本量count | 集群中队列副本(主服务器和镜像服务器之和)的数量。count如果为1意味着单个副本:即队列主节点。count值为2表示2个副本:1个队列主和1个队列镜像。换句话说:count = 镜像数量 + 1。如果群集中的节点数少于count,则该队列将镜像到所有节点。如果有集群总数大于count+1,并且包含镜像的节点出现故障,则将在另一个节点上创建一个新的镜像。 |

| all | (none) | 队列在群集中的所有节点之间进行镜像。队列将镜像到任何新加入的节点。镜像到所有节点将对所有群集节点施加额外的压力,包括网络I / O,磁盘I / O和磁盘空间使用情况。推荐使用exactly,设置副本数为(N / 2 +1)。 |

| nodes | node names | 指定队列创建到哪些节点,如果指定的节点全部不存在,则会出现异常。如果指定的节点在集群中存在,但是暂时不可用,会创建节点到当前客户端连接到的节点。 |

exactly模式

进入任意容器

docker exec -it mq1 bash

执行命令

rabbitmqctl set_policy ha-two "^two\." '{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}'

rabbitmqctl set_policy:固定写法ha-two:策略名称,自定义"^two\.":匹配队列的正则表达式,符合命名规则的队列才生效,这里是任何以two.开头的队列名称'{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}': 策略内容"ha-mode":"exactly":策略模式,此处是exactly模式,指定副本数量"ha-params":2:策略参数,这里是2,就是副本数量为2,1主1镜像。"ha-sync-mode":"automatic":同步策略,默认是manual,即新加入的镜像节点不会同步旧的消息。如果设置为automatic,则新加入的镜像节点会把主节点中所有消息都同步,会带来额外的网络开销。

all模式

进入任意容器

docker exec -it mq2 bash

执行命令

rabbitmqctl set_policy ha-all "^all\." '{"ha-mode":"all"}'

ha-all:策略名称,自定义"^all\.":匹配所有以all.开头的队列名'{"ha-mode":"all"}':策略内容"ha-mode":"all":策略模式,此处是all模式,即所有节点都会称为镜像节点

nodes模式

进入容器

docker exec -it mq3 bash

执行命令

rabbitmqctl set_policy ha-nodes "^nodes\." '{"ha-mode":"nodes","ha-params":["rabbit@nodeA", "rabbit@nodeB"]}'

- rabbitmqctl set_policy`:固定写法

ha-nodes:策略名称,自定义"^nodes\.":匹配队列的正则表达式,符合命名规则的队列才生效,这里是任何以nodes.开头的队列名称'{"ha-mode":"nodes","ha-params":["rabbit@nodeA", "rabbit@nodeB"]}': 策略内容"ha-mode":"nodes":策略模式,此处是nodes模式"ha-params":["rabbit@mq1", "rabbit@mq2"]:策略参数,这里指定副本所在节点名称

仲裁队列

从RabbitMQ 3.8版本开始,引入了新的仲裁队列,他具备与镜像队里类似的功能,但使用更加方便。

添加仲裁队列

控制台添加

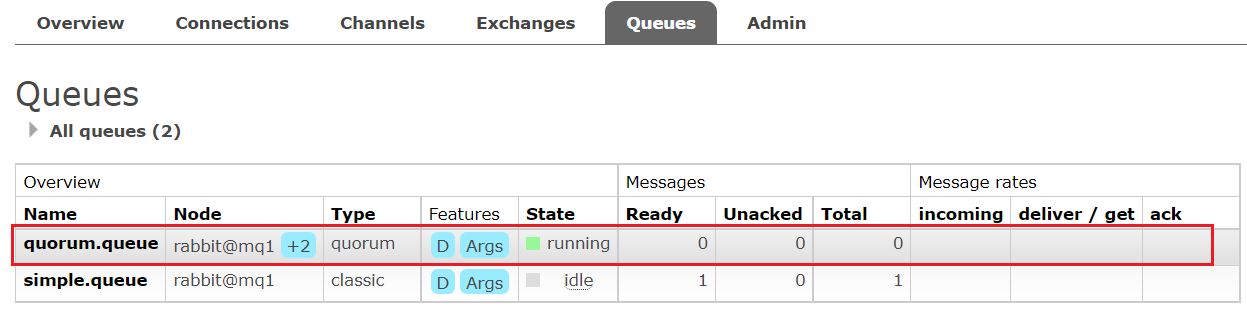

在任意控制台添加一个队列,一定要选择队列类型为Quorum类型。

在任意控制台查看队列:

可以看到,仲裁队列的 + 2 字样。代表这个队列有2个镜像节点。

因为仲裁队列默认的镜像数为5。如果你的集群有7个节点,那么镜像数肯定是5;而我们集群只有3个节点,因此镜像数量就是3。

SpringAMQP创建

@Configuration

public class QuorumConfig{

@Bean

public Queue quorumQueue() {

return QueueBuilder

.durable("quorum.queue") // 持久化

.quorum() // 仲裁队列

.build();

}

}

SpringAMQP连接集群,只需要在yaml中配置即可

spring:

rabbitmq:

addresses: 192.168.150.105:8071, 192.168.150.105:8072, 192.168.150.105:8073

username: admin

password: 123456

virtual-host: /

集群扩容

启动一个新的MQ容器

docker run -d --net mq-net \

-v ${PWD}/.erlang.cookie:/var/lib/rabbitmq/.erlang.cookie \

-e RABBITMQ_DEFAULT_USER=itcast \

-e RABBITMQ_DEFAULT_PASS=123321 \

--name mq4 \

--hostname mq5 \

-p 8074:15672 \

-p 8084:15672 \

rabbitmq:3.8-management

进入容器控制台

docker exec -it mq4 bash

停止mq进程

rabbitmqctl stop_app

重置RabbitMQ中的数据:

rabbitmqctl reset

加入mq1

rabbitmqctl join_cluster rabbit@mq1

再次启动mq进程

rabbitmqctl start_app

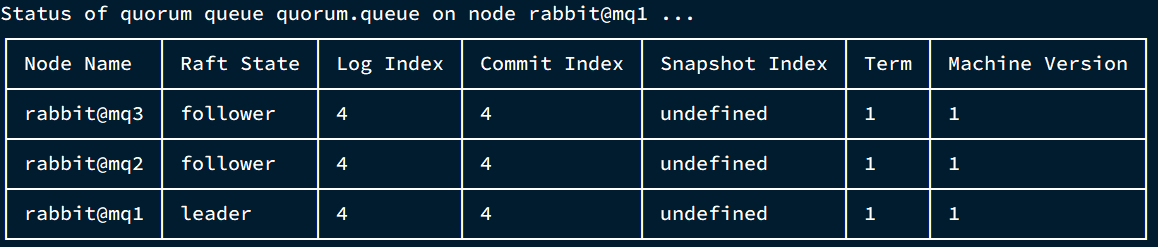

增加仲裁队列副本

先查看下quorum.queue这个队列目前的副本情况,进入mq1容器:

docker exec -it mq1 bash

执行命令:

rabbitmq-queues quorum_status "quorum.queue"

现在让mq4也加入进来

rabbitmq-queues add_member "quorum.queue" "rabbit@mq4"

再次查看副本情况

rabbitmq-queues quorum_status "quorum.queue"

查看控制台,发现quorum.queue的镜像数量也从原来的 +2 变成了 +3