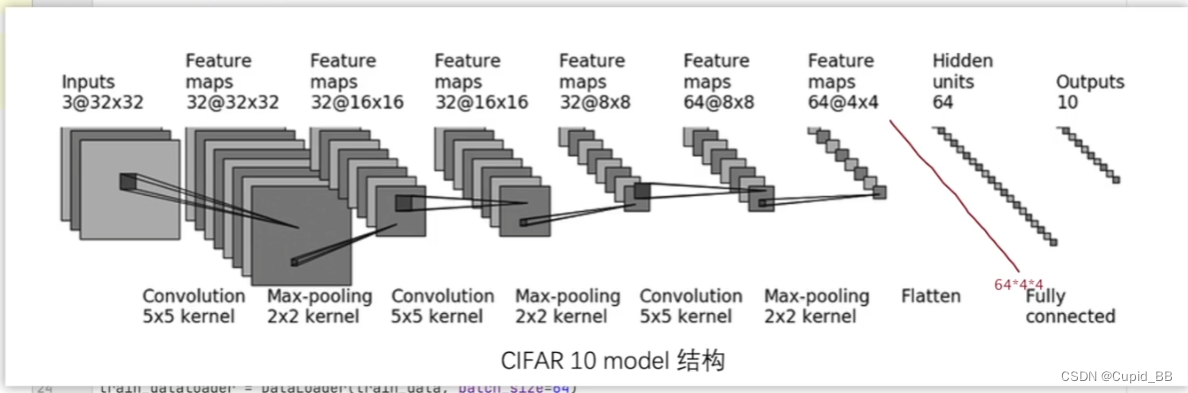

搭建神经网络

model

import torch

from torch import nn

#搭建神经网络

class Tudui(nn.Module):

def __init__(self):

super(Tudui, self).__init__()

self.model = nn.Sequential(

nn.Conv2d(3, 32, 5, 1, 2),

nn.MaxPool2d(2),

nn.Conv2d(32, 32, 5, 1, 2),

nn.MaxPool2d(2),

nn.Conv2d(32, 64, 5, 1, 2),

nn.MaxPool2d(2),

nn.Flatten(),

nn.Linear(64 * 4 * 4, 64),

nn.Linear(64, 10)

)

def forward(self, x):

x = self.model(x)

return x

if __name__ == '__main__':

tudui = Tudui()

input = torch.ones((64, 3, 32, 32))

output = tudui(input)

print(output.size()) # torch.Size([64, 10])

train

import torchvision

from model import *

from torch.utils.data import DataLoader

#准备数据集

train_data = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=torchvision.transforms.ToTensor())

test_data = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=torchvision.transforms.ToTensor())

train_data_size = len(train_data)

test_data_size = len(test_data)

print("训练数据集的长度为:{}".format(train_data_size)) # 50000

print("测试数据集的长度为:{}".format(test_data_size)) # 10000

#利用Dataloader来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

#创建网络模型

tudui = Tudui()

#损失函数

loss_fn = nn.CrossEntropyLoss()

#优化器

learning_rate = 1e-2

optimizer = torch.optim.SGD(tudui.parameters(), lr=learning_rate)

#设置训练网络的一些参数

#记录训练的次数

total_train_step = 0

#记录测试的次数

total_test_step = 0

#训练的轮数

epochs = 10

for epoch in range(epochs):

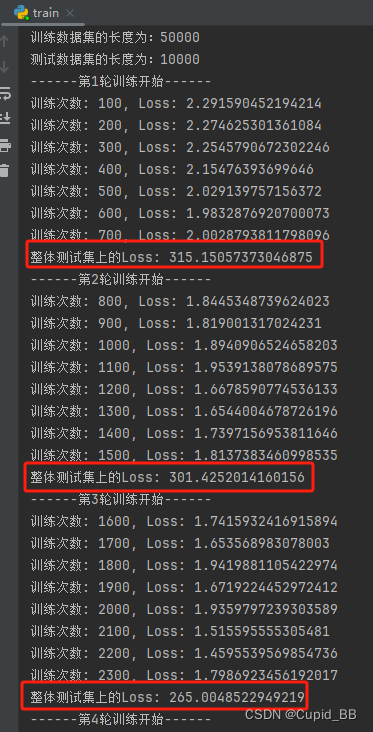

print("------第{}轮训练开始------".format(epoch+1))

#训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets)

#优化器优化模型

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_train_step += 1

if total_train_step % 100 == 0:

print("训练次数: {}, Loss: {}".format(total_train_step, loss)) # loss.item()

#测试步骤开始

total_test_loss = 0

with torch.no_grad():

for data in test_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets)

total_test_loss += loss

print("整体测试集上的Loss: {}".format(total_test_loss))

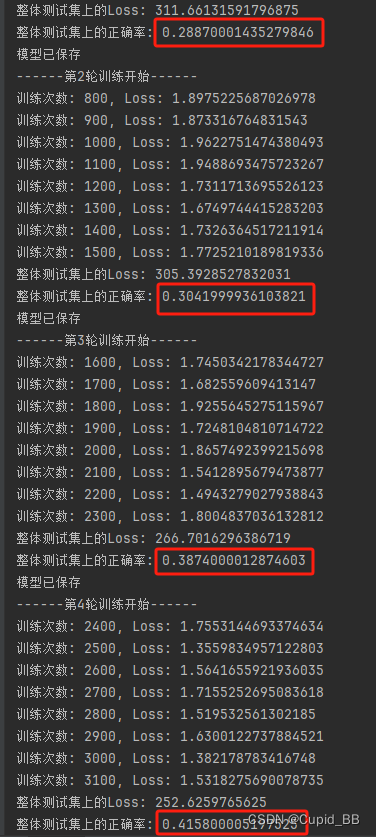

确实每轮有所提升

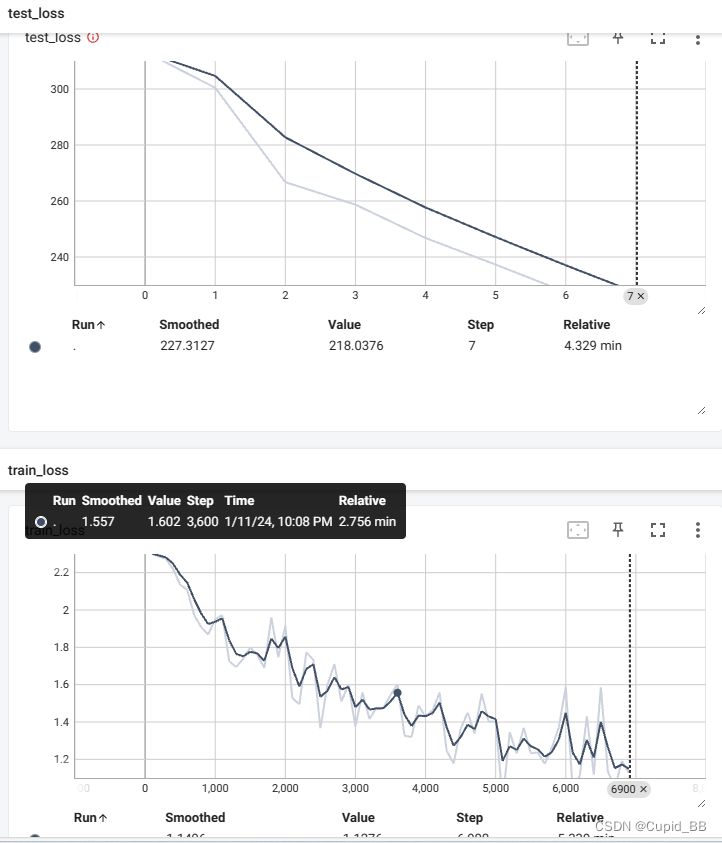

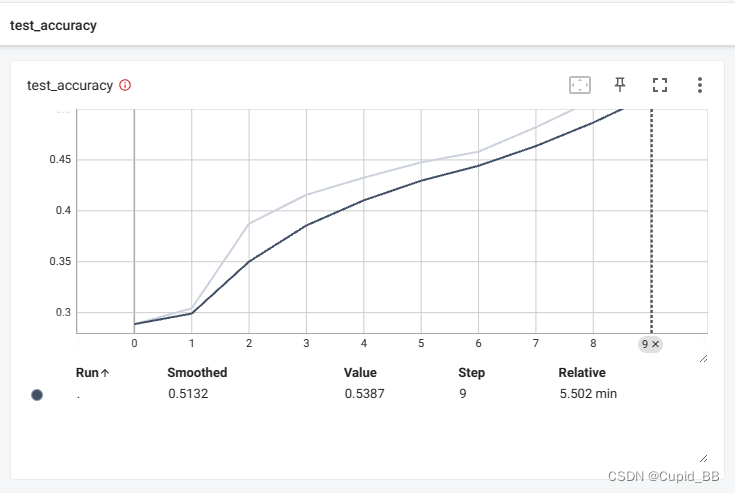

添加tensorboard

writer = SummaryWriter(log_dir='./logs_train')

writer.add_scalar('train_loss', loss, total_train_step)

writer.add_scalar('test_loss', total_test_loss, total_test_step)

total_test_step += 1

writer.close()

test_loss train_loss

保存模型

torch.save(tudui, "tudui_{}.pth".format(epoch+1))

print('模型已保存')

整体代码

import torch

import torchvision

from torch.utils.tensorboard import SummaryWriter

from model import *

from torch.utils.data import DataLoader

#准备数据集

train_data = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=torchvision.transforms.ToTensor())

test_data = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=torchvision.transforms.ToTensor())

train_data_size = len(train_data)

test_data_size = len(test_data)

print("训练数据集的长度为:{}".format(train_data_size)) # 50000

print("测试数据集的长度为:{}".format(test_data_size)) # 10000

#利用Dataloader来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

#创建网络模型

tudui = Tudui()

#损失函数

loss_fn = nn.CrossEntropyLoss()

#优化器

learning_rate = 1e-2

optimizer = torch.optim.SGD(tudui.parameters(), lr=learning_rate)

#设置训练网络的一些参数

#记录训练的次数

total_train_step = 0

#记录测试的次数

total_test_step = 0

#训练的轮数

epochs = 10

#添加tensorboard

writer = SummaryWriter(log_dir='./logs_train')

for epoch in range(epochs):

print("------第{}轮训练开始------".format(epoch+1))

#训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets)

#优化器优化模型

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_train_step += 1

if total_train_step % 100 == 0:

print("训练次数: {}, Loss: {}".format(total_train_step, loss)) # loss.item()

writer.add_scalar('train_loss', loss, total_train_step)

#测试步骤开始

total_test_loss = 0

with torch.no_grad():

for data in test_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets)

total_test_loss += loss

print("整体测试集上的Loss: {}".format(total_test_loss))

writer.add_scalar('test_loss', total_test_loss, total_test_step)

total_test_step += 1

torch.save(tudui, "tudui_{}.pth".format(epoch+1))

print('模型已保存')

writer.close()

预测

import torch

outputs = torch.tensor([[0.1, 0.2],

[0.3, 0.4]])

print(outputs.argmax(dim=1)) # 取最大值的位置;1横着看, 0竖着看

预测的正确率

import torch

outputs = torch.tensor([[0.1, 0.2],

[0.3, 0.4]])

print(outputs.argmax(dim=1)) # 取最大值的位置;1横着看, 0竖着看

preds = outputs.argmax(1)

targets = torch.tensor([0, 1])

print((preds == targets).sum()) # 对应位置相等的个数

对源代码的进行修改(增正确取率)

主要加了这一句,看分类的正确率

total_accuracy += (outputs.argmax(1) == targets).sum()

完整

import torch

import torchvision

from torch.utils.tensorboard import SummaryWriter

from model import *

from torch.utils.data import DataLoader

#准备数据集

train_data = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=torchvision.transforms.ToTensor())

test_data = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=torchvision.transforms.ToTensor())

train_data_size = len(train_data)

test_data_size = len(test_data)

print("训练数据集的长度为:{}".format(train_data_size)) # 50000

print("测试数据集的长度为:{}".format(test_data_size)) # 10000

#利用Dataloader来加载数据集

train_dataloader = DataLoader(train_data, batch_size=64)

test_dataloader = DataLoader(test_data, batch_size=64)

#创建网络模型

tudui = Tudui()

#损失函数

loss_fn = nn.CrossEntropyLoss()

#优化器

learning_rate = 1e-2

optimizer = torch.optim.SGD(tudui.parameters(), lr=learning_rate)

#设置训练网络的一些参数

#记录训练的次数

total_train_step = 0

#记录测试的次数

total_test_step = 0

#训练的轮数

epochs = 10

#添加tensorboard

writer = SummaryWriter(log_dir='./logs_train')

for epoch in range(epochs):

print("------第{}轮训练开始------".format(epoch+1))

#训练步骤开始

for data in train_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets)

#优化器优化模型

optimizer.zero_grad()

loss.backward()

optimizer.step()

total_train_step += 1

if total_train_step % 100 == 0:

print("训练次数: {}, Loss: {}".format(total_train_step, loss)) # loss.item()

writer.add_scalar('train_loss', loss, total_train_step)

#测试步骤开始

total_test_loss = 0

total_accuracy = 0

with torch.no_grad():

for data in test_dataloader:

imgs, targets = data

outputs = tudui(imgs)

loss = loss_fn(outputs, targets)

total_test_loss += loss

total_accuracy += (outputs.argmax(1) == targets).sum()

print("整体测试集上的Loss: {}".format(total_test_loss))

print("整体测试集上的正确率: {}".format(total_accuracy/test_data_size))

writer.add_scalar('test_loss', total_test_loss, total_test_step)

writer.add_scalar('test_accuracy', total_accuracy/test_data_size, total_test_step)

total_test_step += 1

torch.save(tudui, "tudui_{}.pth".format(epoch+1))

print('模型已保存')

writer.close()

正确率是有提升的

(三)细节

tudui.train()

tudui.eval()

并不是这样才能开始,仅对部分层有用,比如Dropout