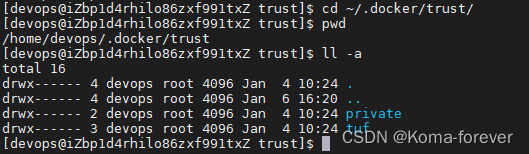

1.先查看磁盘空间

df -h

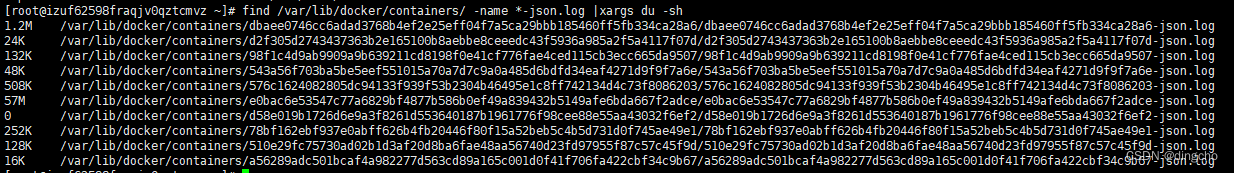

2.找到容器的containerId-json.log文件,并清理

find /var/lib/docker/containers/ -name *-json.log |xargs du -sh

3、可以根据需求清理对应日志也可以清理数据大的日志

$ cat /dev/null > /var/lib/docker/containers/dbaee0746cc6adad3768b4ef2e25eff04f7a5ca29bbb185460ff5fb334ca28a6/dbaee0746cc6adad3768b4ef2e25eff04f7a5ca29bbb185460ff5fb334ca28a6-json.log当然我们也可以尝试脚本化清理:

如果docker容器正在运行,那么使用rm -rf方式删除日志后,通过df -h会发现磁盘空间并没有释放。原因是在Linux或者Unix系统中,通过rm -rf或者文件管理器删除文件,将会从文件系统的目录结构上解除链接(unlink)。如果文件是被打开的(有一个进程正在使用),那么进程将仍然可以读取该文件,磁盘空间也一直被占用。正确姿势是cat /dev/null > *-json.log,当然你也可以通过rm -rf删除后重启docker。接下来,提供一个日志清理脚本clean_docker_log.sh,内容如下:

#!/bin/sh

echo "======== start clean docker containers logs ========"

logs=$(find /var/lib/docker/containers/ -name *-json.log)

for log in $logs

do

echo "clean logs : $log"

cat /dev/null > $log

done

echo "======== end clean docker containers logs ========"# chmod +x clean_docker_log.sh

# ./clean_docker_log.sh但是,这样清理之后,随着时间的推移,容器日志会像杂草一样,

我们可以设置一个容器服务的日志大小上限,从根本上解决问题,需要限制容器服务的日志大小上限。这个通过配置容器docker-compose的max-size选项来实现

nginx:

image: nginx:1.12.1

restart: always

logging:

driver: “json-file”

options:

max-size: “5g”重启nginx容器之后,其日志文件的大小就被限制在5GB,再也不用担心了。

全局设置

新建/etc/docker/daemon.json,若有就不用新建了。添加log-dirver和log-opts参数,样例如下:

# vim /etc/docker/daemon.json

{

"registry-mirrors": ["http://f613ce8f.m.daocloud.io"],

"log-driver":"json-file",

"log-opts": {"max-size":"500m", "max-file":"3"}

}max-size=500m,意味着一个容器日志大小上限是500M,

max-file=3,意味着一个容器有三个日志,分别是id+.json、id+1.json、id+2.json。

// 重启docker守护进程

# systemctl daemon-reload

# systemctl restart docker

注意:设置的日志大小,只对新建的容器有效。