实验条件:

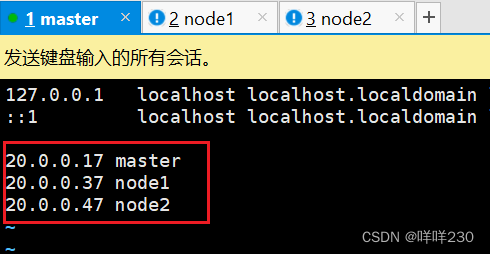

| master | 20.0.0.17 | 2核4G | docker、kubelet、kubeadm、kubectl、fannel |

| node1 | 20.0.0.37 | 2核4G | docker、kubelet、kubeadm、kubectl、fannel |

| node2 | 20.0.0.47 | 2核4G | docker、kubelet、kubeadm、kubectl、fannel |

| slave:harbor 仓库节点 | 20.0.0.27 | 2核4G | docker、docker-compose、harbor |

实验步骤:

一、部署ETCD

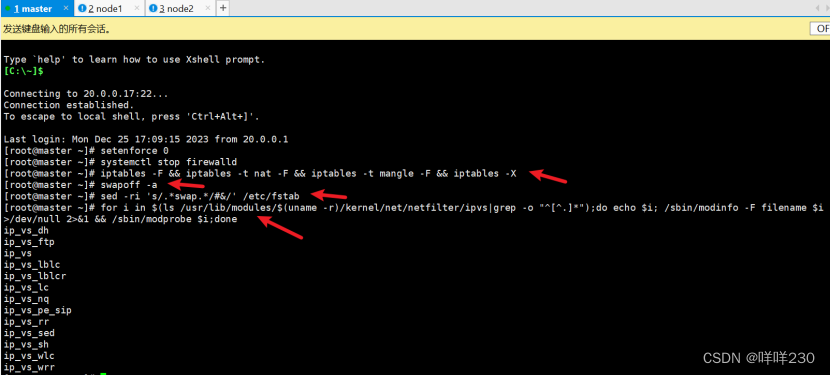

【master、node1、node2】

1、清空所有策略、关闭swap交换分区

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

加载 ip_vs 模块

for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

2、主机映射

vim /etc/hosts

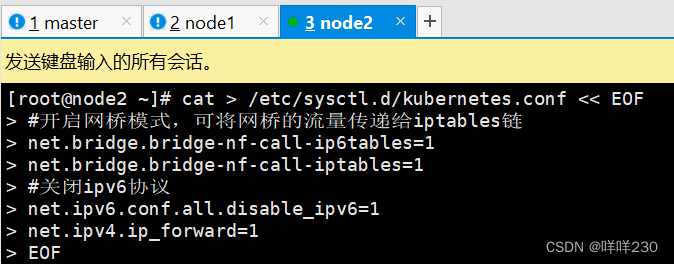

3、优化内核参数

cat > /etc/sysctl.d/kubernetes.conf << EOF

#开启网桥模式,可将网桥的流量传递给iptables链

net.bridge.bridge-nf-call-ip6tables=1

net.bridge.bridge-nf-call-iptables=1

#关闭ipv6协议

net.ipv6.conf.all.disable_ipv6=1

net.ipv4.ip_forward=1

EOF

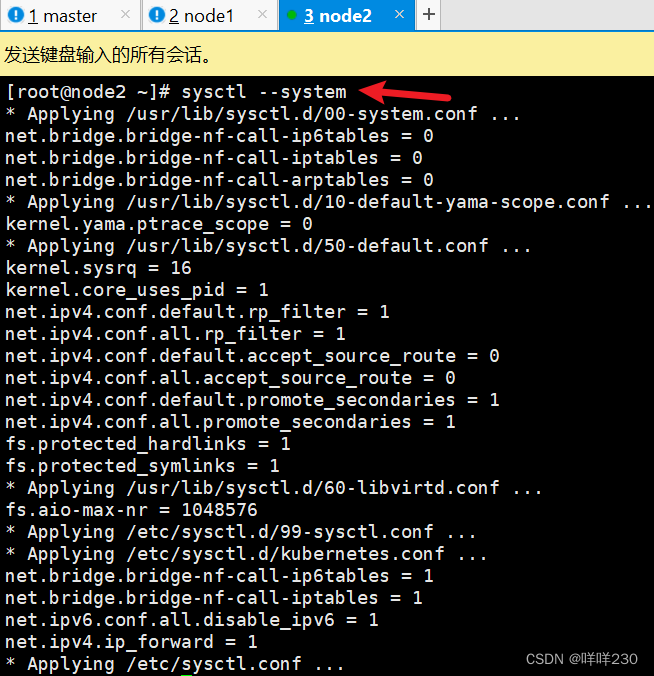

生效参数

sysctl --system

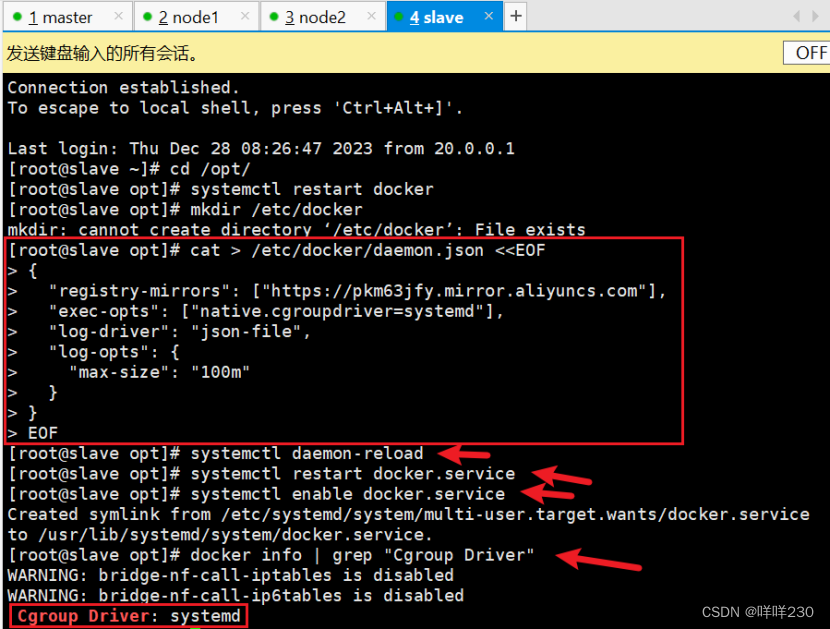

4、所有节点安装docker

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.io

mkdir /etc/docker

cat > /etc/docker/daemon.json <<EOF

{

"registry-mirrors": ["https://pkm63jfy.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

}

}

EOF

systemctl daemon-reload

systemctl restart docker.service

systemctl enable docker.service

docker info | grep "Cgroup Driver"

默认使用systemd的资源控制方式(kubeadm一定要使用这种方式)

5、安装kubeadm,kubelet和kubectl

【master、node1、node2】

(1)定义kubernetes源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

yum install -y kubelet-1.20.15 kubeadm-1.20.15 kubectl-1.20.15

(2)开机自启kubelet

systemctl enable kubelet.service

#K8S通过kubeadm安装出来以后都是以Pod方式存在,即底层是以容器方式运行,所以kubelet必须设置开机自启

(3)查看初始化需要的镜像

kubeadm config images list --kubernetes-version 1.20.15

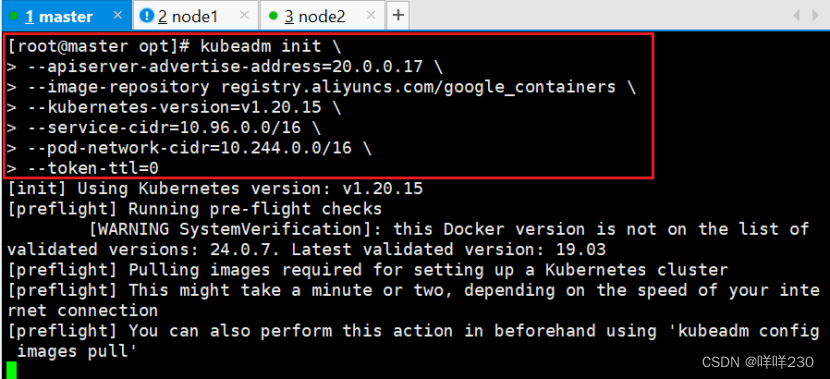

6、启动kubectl

(1)初始化kubeadm

【master】

kubeadm init \

--apiserver-advertise-address=20.0.0.17 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version=v1.20.15 \

--service-cidr=10.96.0.0/16 \

--pod-network-cidr=10.244.0.0/16 \

--token-ttl=0

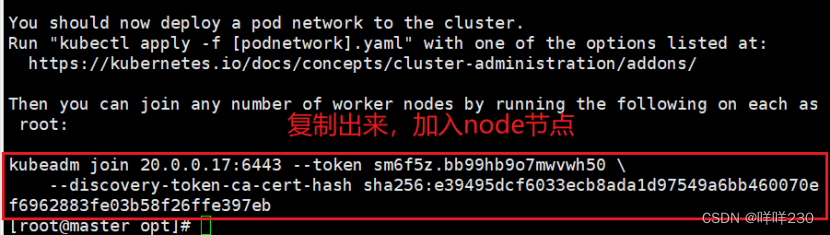

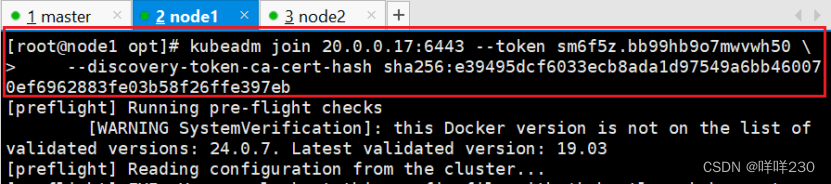

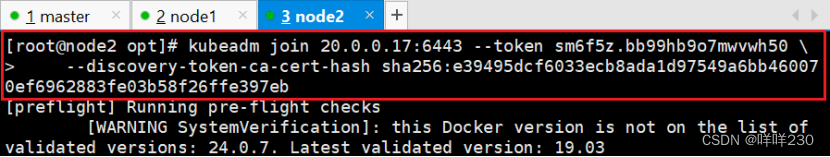

kubeadm join 20.0.0.17:6443 --token sm6f5z.bb99hb9o7mwvwh50 \

--discovery-token-ca-cert-hash sha256:e39495dcf6033ecb8ada1d97549a6bb460070ef6962883fe03b58f26ffe397eb

| --apiserver-advertise-address=192.168.233.91 | 声明master节点的apiserver的监听地址 |

| --image-repository registry.aliyuncs.com/google_containers | 声明拉取镜像的仓库 |

| --kubernetes-version=v1.20.15 | k8s集群的版本 |

| --service-cidr=10.96.0.0/16 | 所有service对外代理地址都是10.96.0.0/16网段 |

| --pod-network-cidr=10.244.0.0/16 | 所有pod节点的IP地址网段 |

| --token-ttl=0 | 默认token的有效期是0(0表示永不过期,不设置默认是24小时) |

(2)在node节点加入集群

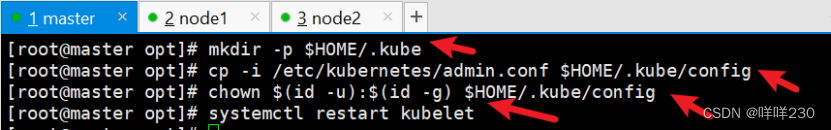

(3)设定kubectl

kubectl需经由API server认证及授权后方能执行相应的管理操作,

kubeadm 部署的集群为其生成了一个具有管理员权限的认证配置文件 /etc/kubernetes/admin.conf,

它可由 kubectl 通过默认的 “$HOME/.kube/config” 的路径进行加载。

mkdir -p $HOME/.kube

cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

chown $(id -u):$(id -g) $HOME/.kube/config

systemctl restart kubelet

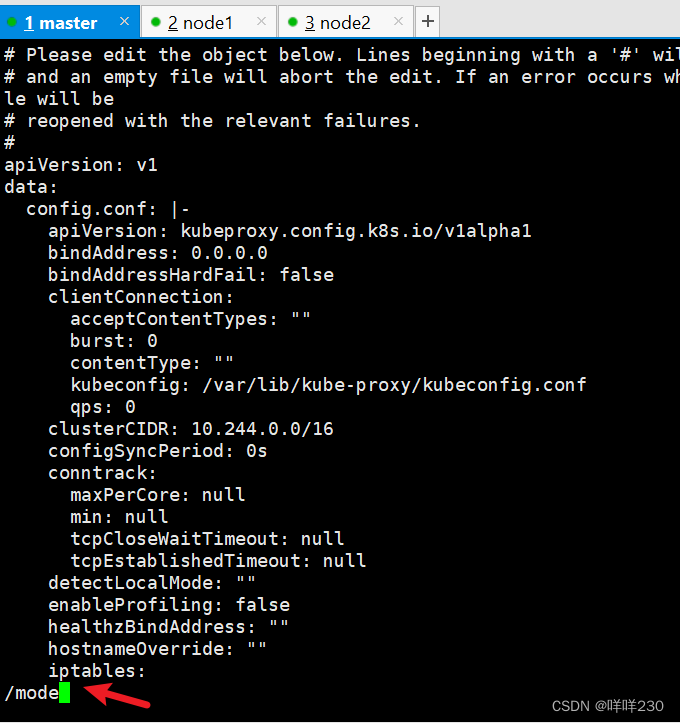

初始化后需要修改 kube-proxy 的 configmap,开启 ipvs

kubectl edit cm kube-proxy -n=kube-system

修改mode: ipvs

![]()

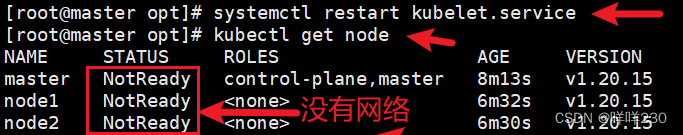

kubectl get cs

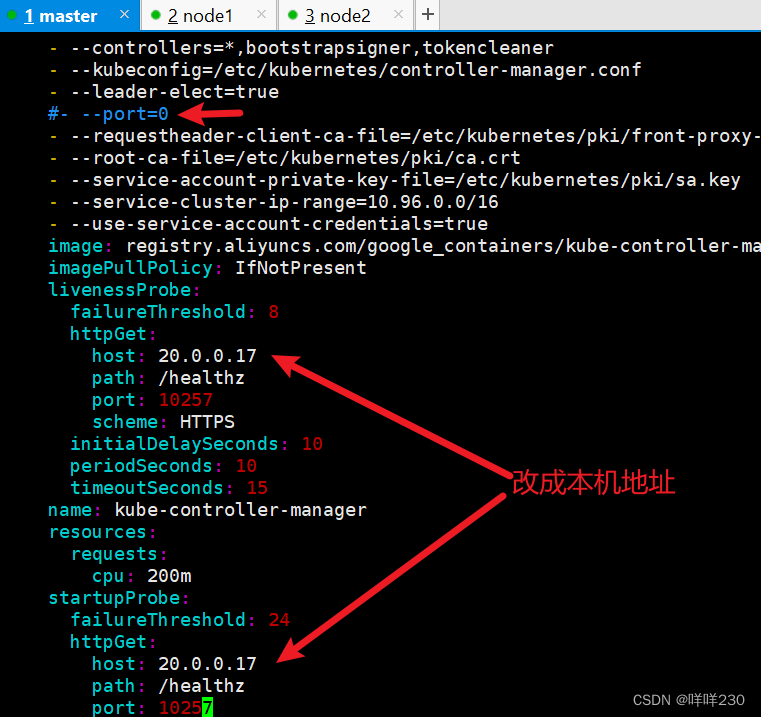

发现集群不健康,更改以下两个文件,修改监听地址

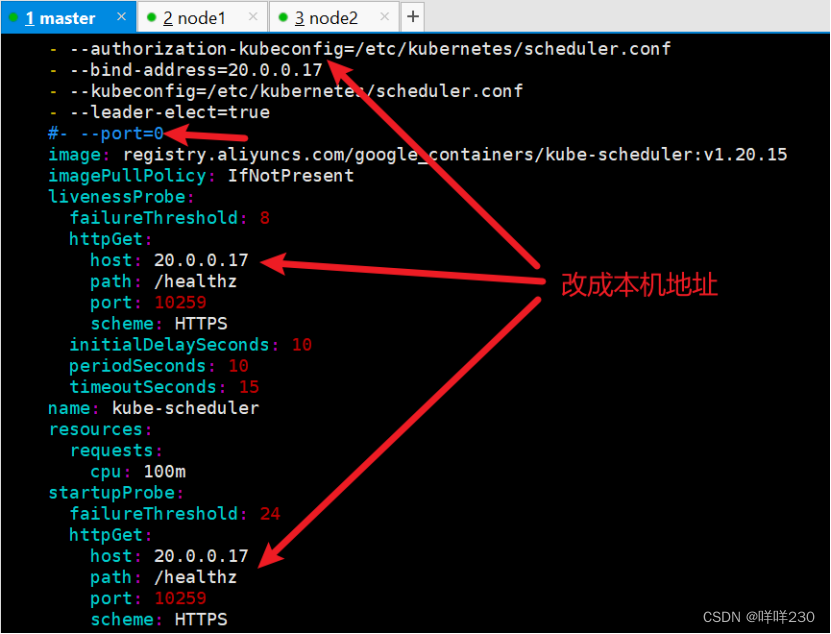

vim /etc/kubernetes/manifests/kube-scheduler.yaml

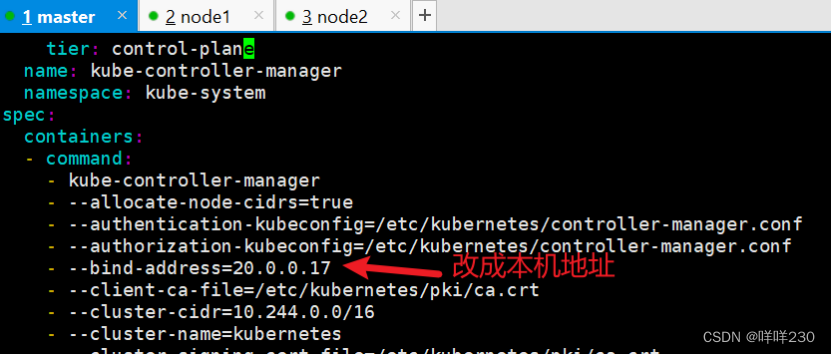

vim /etc/kubernetes/manifests/kube-controller-manager.yaml

# 修改如下内容

把--bind-address=127.0.0.1变成--bind-address=192.168.233.91 #修改成k8s的控制节点master01的ip

把httpGet:字段下的hosts由127.0.0.1变成192.168.233.91(有两处)

#- --port=0 # 搜索port=0,把这一行注释掉

systemctl restart kubelet

![]()

![]()

此时etcd是单节点,要么部署一台,要么部署三台

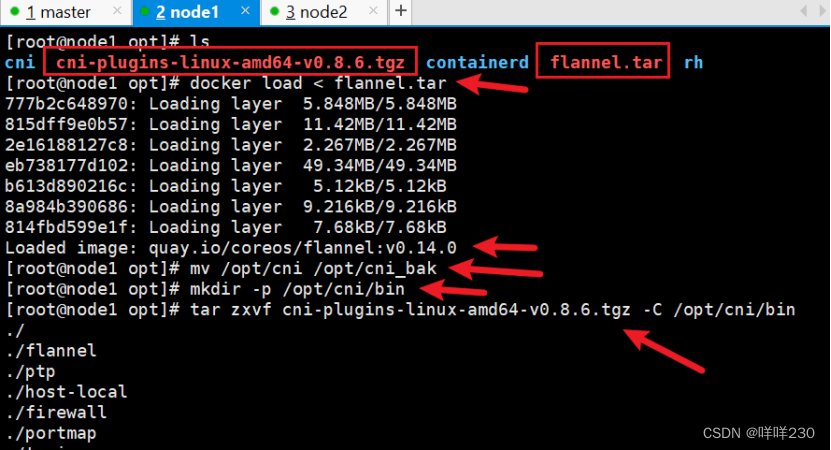

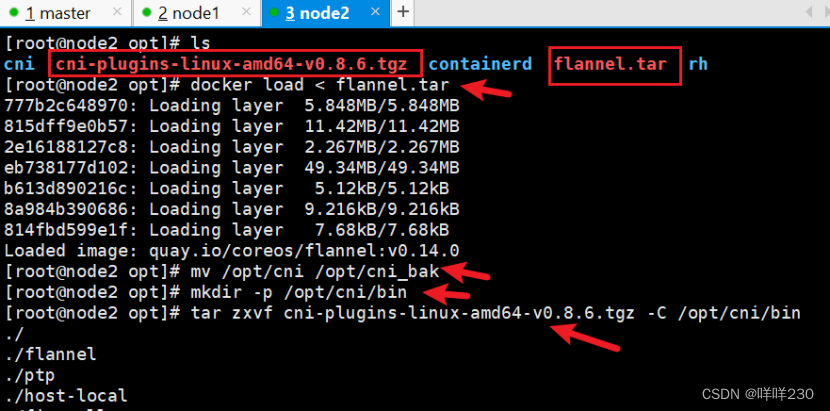

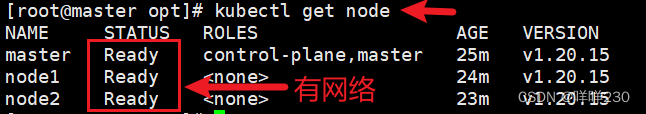

二、部署网络(flannel)

1、所有节点上传 flannel 镜像 flannel.tar 和网络插件 cni-plugins-linux-amd64-v0.8.6.tgz 到 /opt 目录,

master节点上传 kube-flannel.yml 文件

cd /opt

docker load < flannel.tar

mv /opt/cni /opt/cni_bak

mkdir -p /opt/cni/bin

tar zxvf cni-plugins-linux-amd64-v0.8.6.tgz -C /opt/cni/bin

【master】

kubectl apply -f kube-flannel.yml

【node1】

【node2】

注:删除node节点

kubectl delete node 节点名称

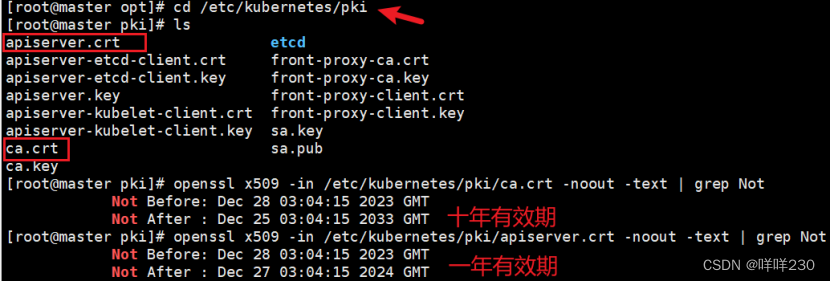

三、部署证书有效期

证书有效期的问题,kubeadm默认只有1年

1、查看证书有效期

openssl x509 -in /etc/kubernetes/pki/ca.crt -noout -text | grep Not

openssl x509 -in /etc/kubernetes/pki/apiserver.crt -noout -text | grep Not

2、修改证书有效期

./update-kubeadm-cert.sh all

执行脚本即可

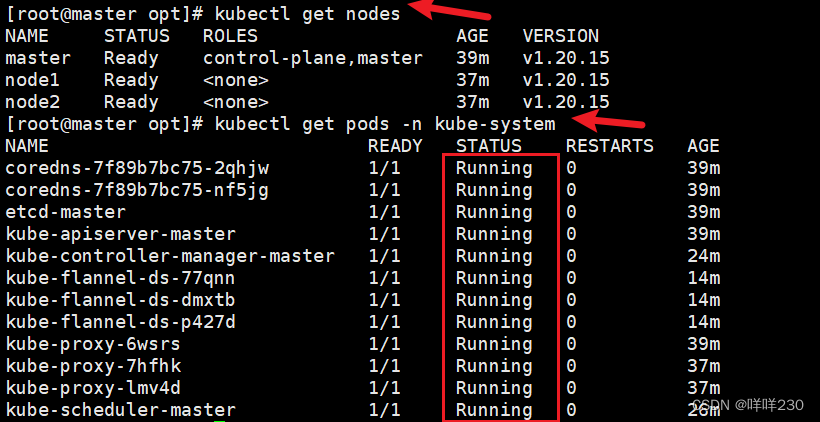

3、在master节点查看节点状态

kubectl get nodes

kubectl get pods -n kube-system

4、添加自动补齐

vim /etc/profile

source <(kubectl completion bash)

source /etc/profile

![]()

![]()

k8s搭建完成(此时master既是主,又是node节点)

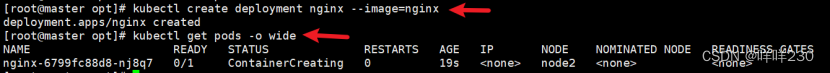

5、测试

(1)创建pod 资源

kubectl create deployment nginx --image=nginx

kubectl get pods -o wide

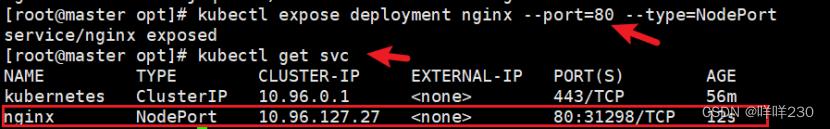

(2)暴露端口提供服务

kubectl expose deployment nginx --port=80 --type=NodePort

kubectl get svc

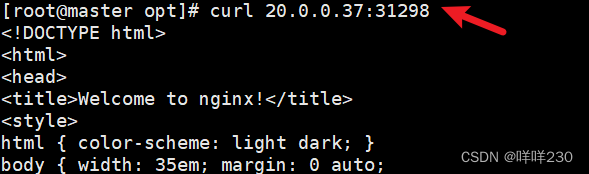

(3)测试访问

curl http://20.0.0.37:31298

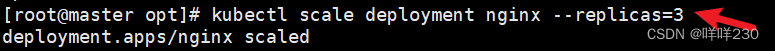

(4)缩容副本

kubectl scale deployment nginx --replicas=3

kubectl get pods -o wide

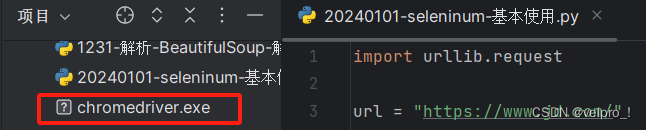

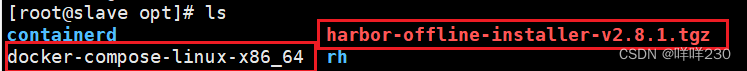

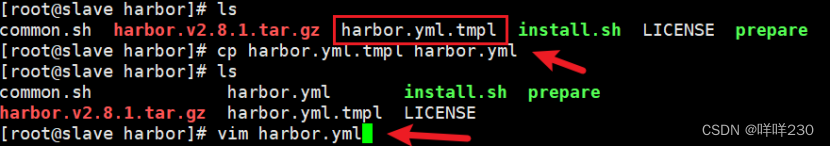

四、部署harbor仓库

1、上传 harbor-offline-installer-v2.8.1.tgz 和 docker-compose 文件到 /opt 目录

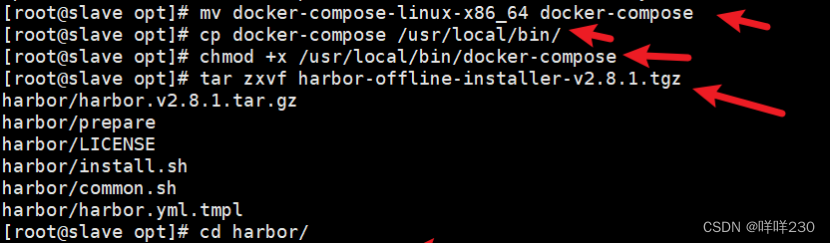

cd /opt

mv docker-compose-linux-x86_64 docker-compose

cp docker-compose /usr/local/bin/

chmod +x /usr/local/bin/docker-compose

tar zxvf harbor-offline-installer-v2.8.1.tgz

cd harbor/

cp harbor.yml.tmpl harbor.yml

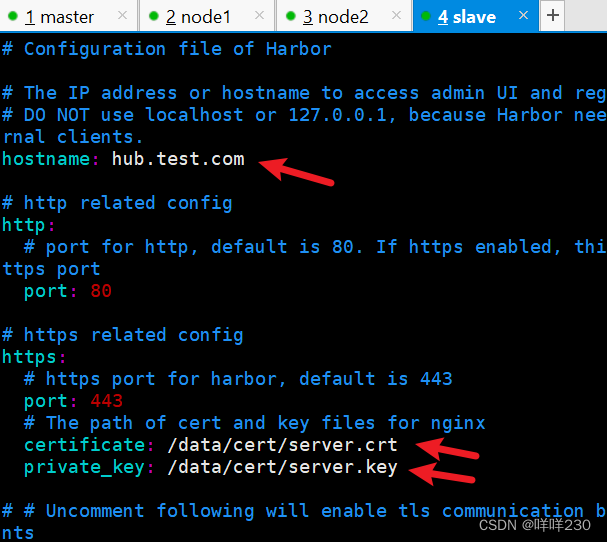

vim harbor.yml

hostname = hub.test.com

https:

# https port for harbor, default is 443

port: 443

# The path of cert and key files for nginx

certificate: /data/cert/server.crt

private_key: /data/cert/server.key

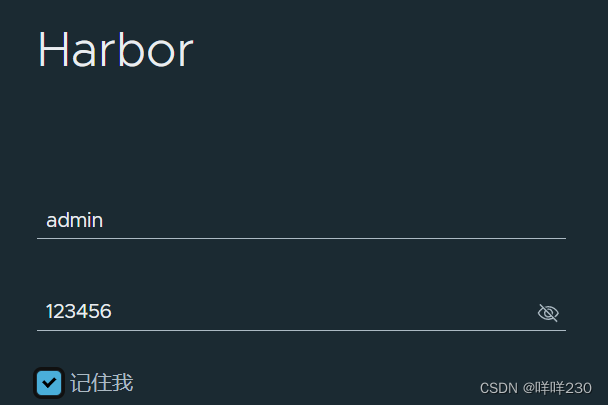

harbor_admin_password = 123456

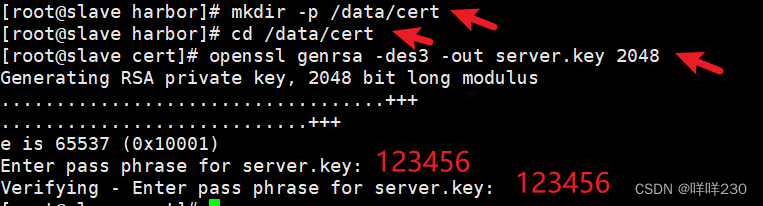

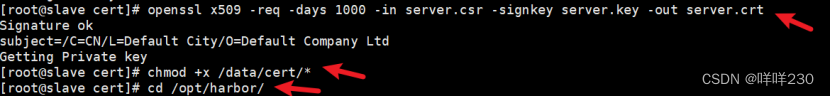

2、生成证书

mkdir -p /data/cert

cd /data/cert

(1)生成私钥

openssl genrsa -des3 -out server.key 2048

输入两遍密码:123456

(2)生成证书签名请求文件

openssl req -new -key server.key -out server.csr

输入私钥密码:123456

输入国家名:CN

输入省名:BJ

输入市名:BJ

输入组织名:TEST

输入机构名:TEST

输入域名:hub.kgc.com

输入管理员邮箱:admin@test.com

其它全部直接回车

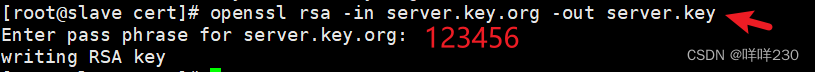

(3)备份私钥

cp server.key server.key.org

(4)清除私钥密码

openssl rsa -in server.key.org -out server.key

输入私钥密码:123456

(5)签名证书

openssl x509 -req -days 1000 -in server.csr -signkey server.key -out server.crt

chmod +x /data/cert/*

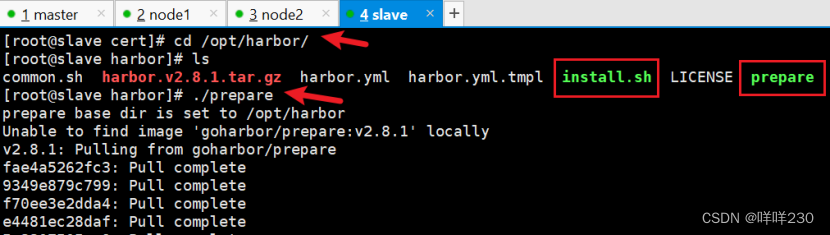

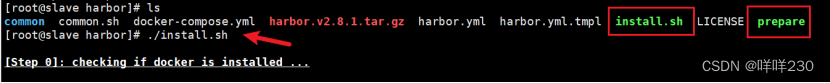

cd /opt/harbor/

./prepare

./install.sh

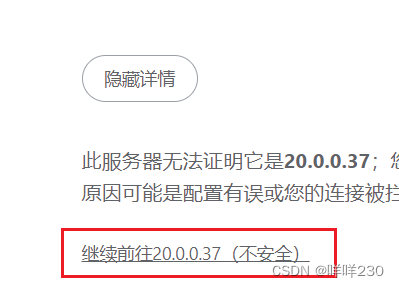

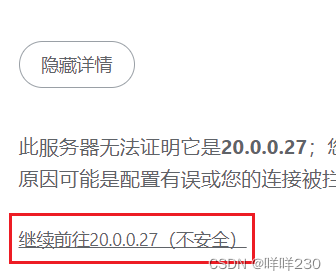

(6)浏览器访问:https://20.0.0.27(harbor镜像仓库地址)

添加例外 -> 确认安全例外

用户名:admin

密码:123456

harbor仓库搭建完成

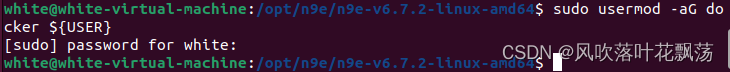

五、node节点https免密登录harbor仓库上传镜像

(1)node1登录仓库上传镜像

【node1】

mkdir -p /etc/docker/certs.d/hub.test.com/

![]()

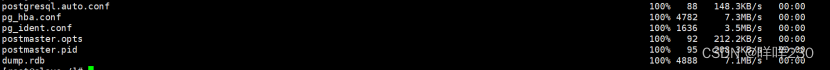

【harbor仓库】

在harbor节点把密钥验证目录整个转给node节点:

scp -r data/ root@20.0.0.37:/

【node1】

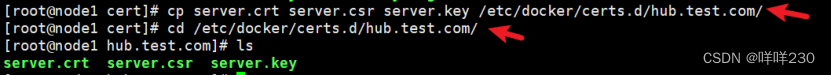

把刚才的生成的密钥文件放入:

cd /data/cert/

ls

cp server.crt server.csr server.key /etc/docker/certs.d/hub.test.com/

cd /etc/docker/certs.d/hub.test.com/

vim /etc/hosts

20.0.0.27 hub.test.com

![]()

vim /lib/systemd/system/docker.service

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --insecure-registry=hub.test.com

![]()

systemctl daemon-reload

systemctl restart docker

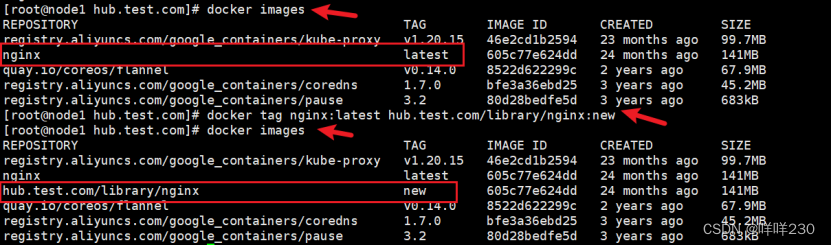

![]()

docker login -u admin -p 123456 https://hub.test.com

docker tag nginx:latest hub.test.com/library/nginx:new

docker push hub.test.com/library/nginx:new

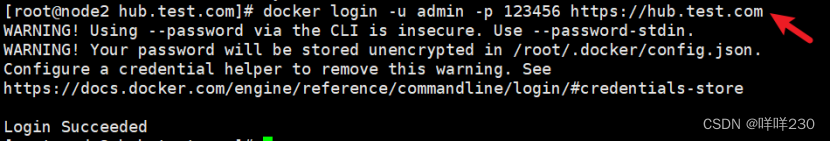

(2)node2登录仓库上传镜像

【node2】

mkdir -p /etc/docker/certs.d/hub.test.com/

![]()

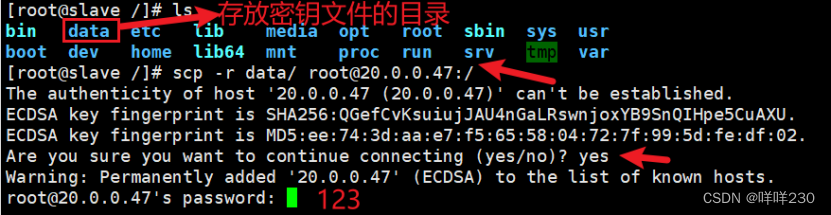

【harbor仓库】

在harbor节点把密钥验证目录整个转给node节点:

scp -r data/ root@20.0.0.47:/

【node2】

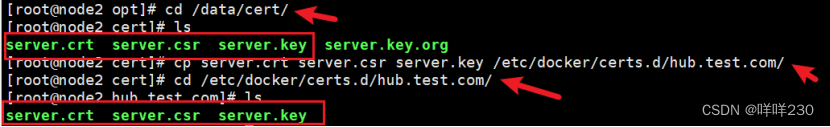

把刚才的生成的密钥文件放入:

cd /data/cert/

ls

cp server.crt server.csr server.key /etc/docker/certs.d/hub.test.com/

cd /etc/docker/certs.d/hub.test.com/

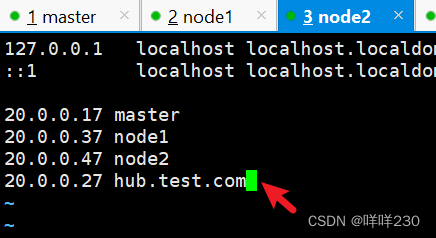

vim /etc/hosts

20.0.0.27 hub.test.com

![]()

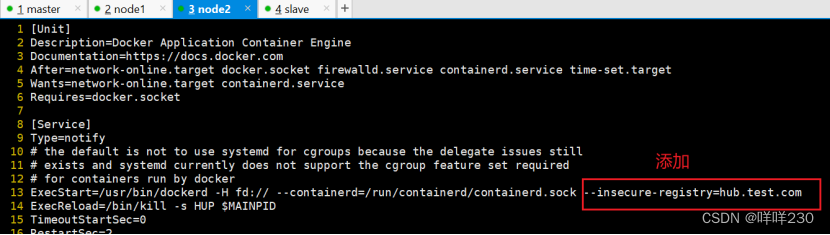

vim /lib/systemd/system/docker.service

ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock --insecure-registry=hub.test.com

![]()

systemctl daemon-reload

systemctl restart docker

![]()

docker login -u admin -p 123456 https://hub.test.com

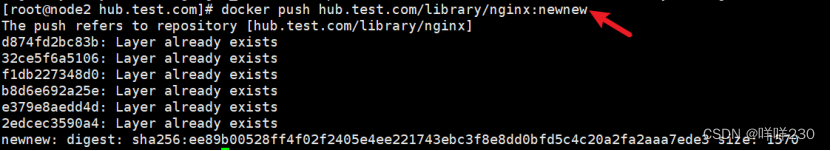

docker tag nginx:latest hub.test.com/library/nginx:newnew

docker push hub.test.com/library/nginx:newnew

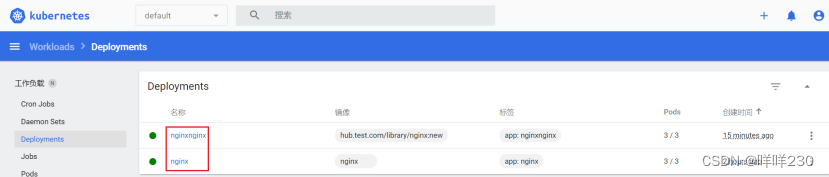

(3)测试。从harbor仓库拉取镜像

①创建pod

kubectl create deployment nginxnginx --image=hub.test.com/library/nginx:new --replicas=3

②查看pod

kubectl get pods

结论:从仓库中拉取镜像成功

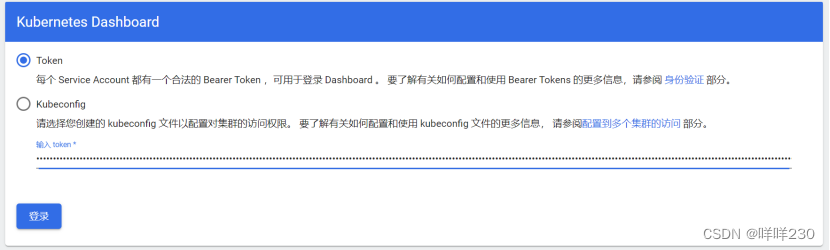

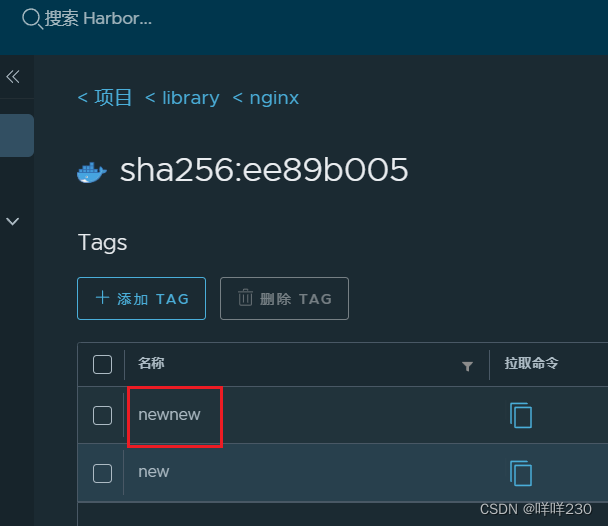

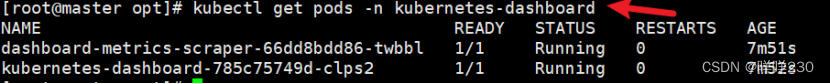

六、部署dashboard可视化界面

1、上传recommended.yaml脚本到master节点

![]()

运行脚本 kubectl apply -f recommended.yaml

2、创建用户

kubectl create serviceaccount dashboard-admin -n kube-system

![]()

3、绑定用户

kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

![]()

4、获取token值

kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')

kubectl get pods -n kubernetes-dashboard

浏览器访问https://20.0.0.37:30001/