文本特征抽取TfidVectorizer

前几种方法的缺点:有很多词虽然没意义,但是出现次数很多,会影响结果,有失偏颇------------关键词

TfidVecorizer--------Tf-IDF

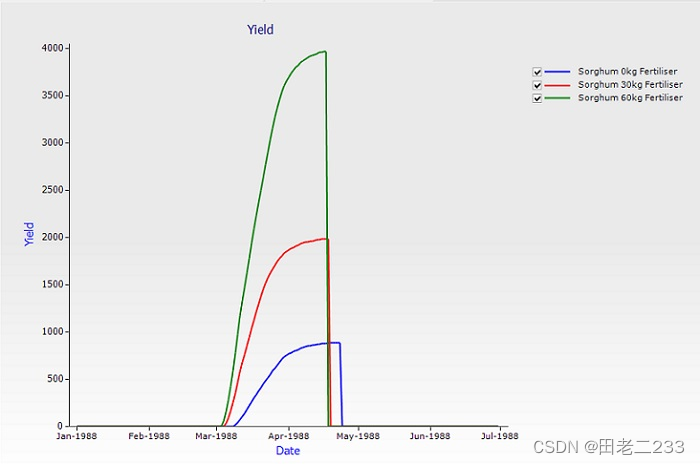

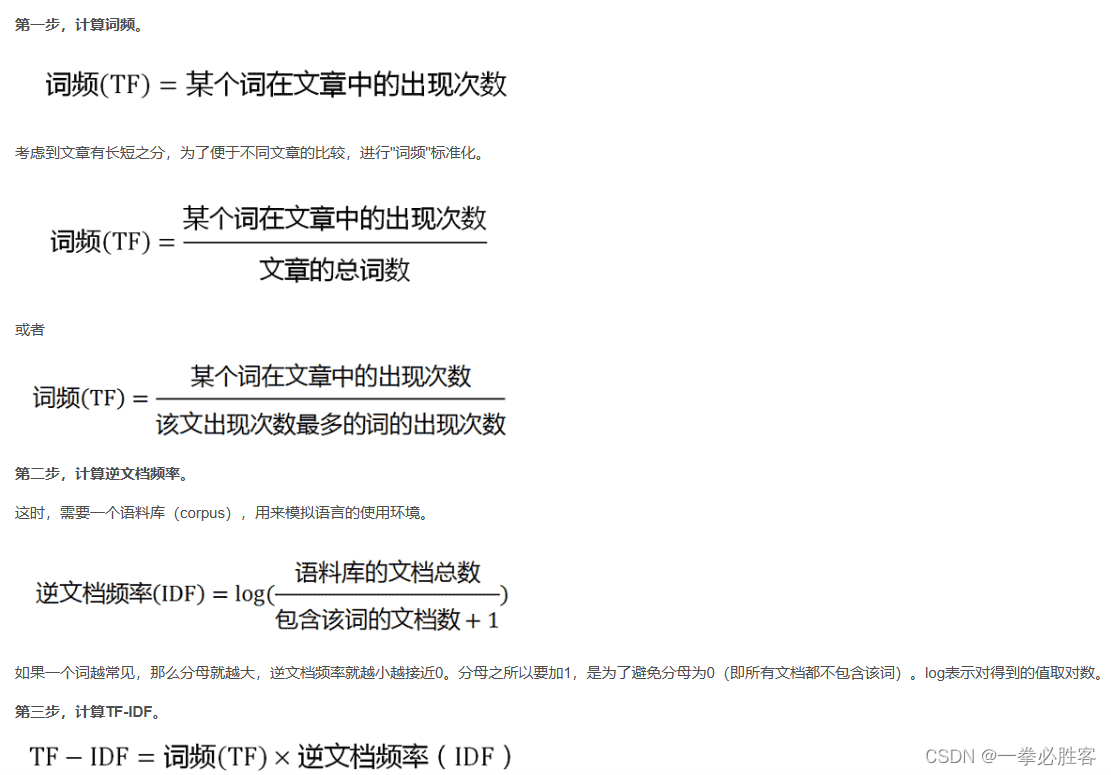

思想:一个词在一篇文章中出现概率高,但是在其他文章很少出现------------认为这个很适合来分类

TF-IDF------重要程度

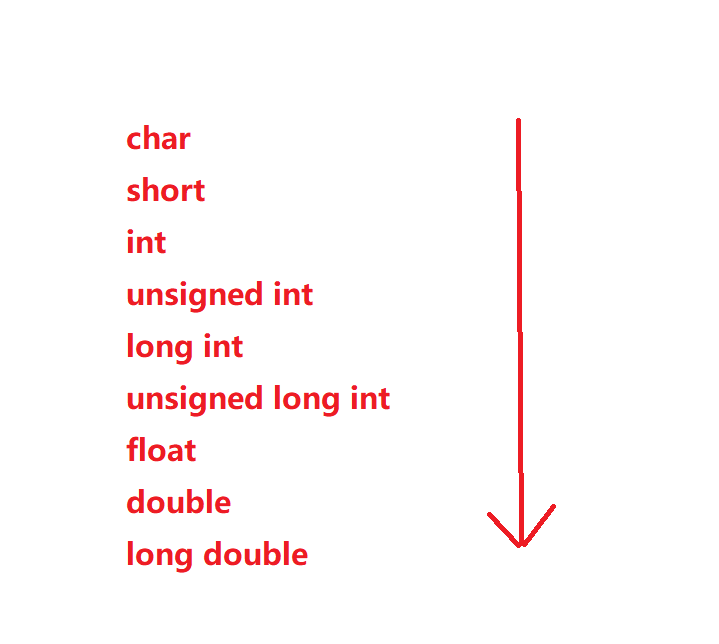

TF------------term frequency---------------------词频

IDF------------inverse document frequency----------逆向文档频率

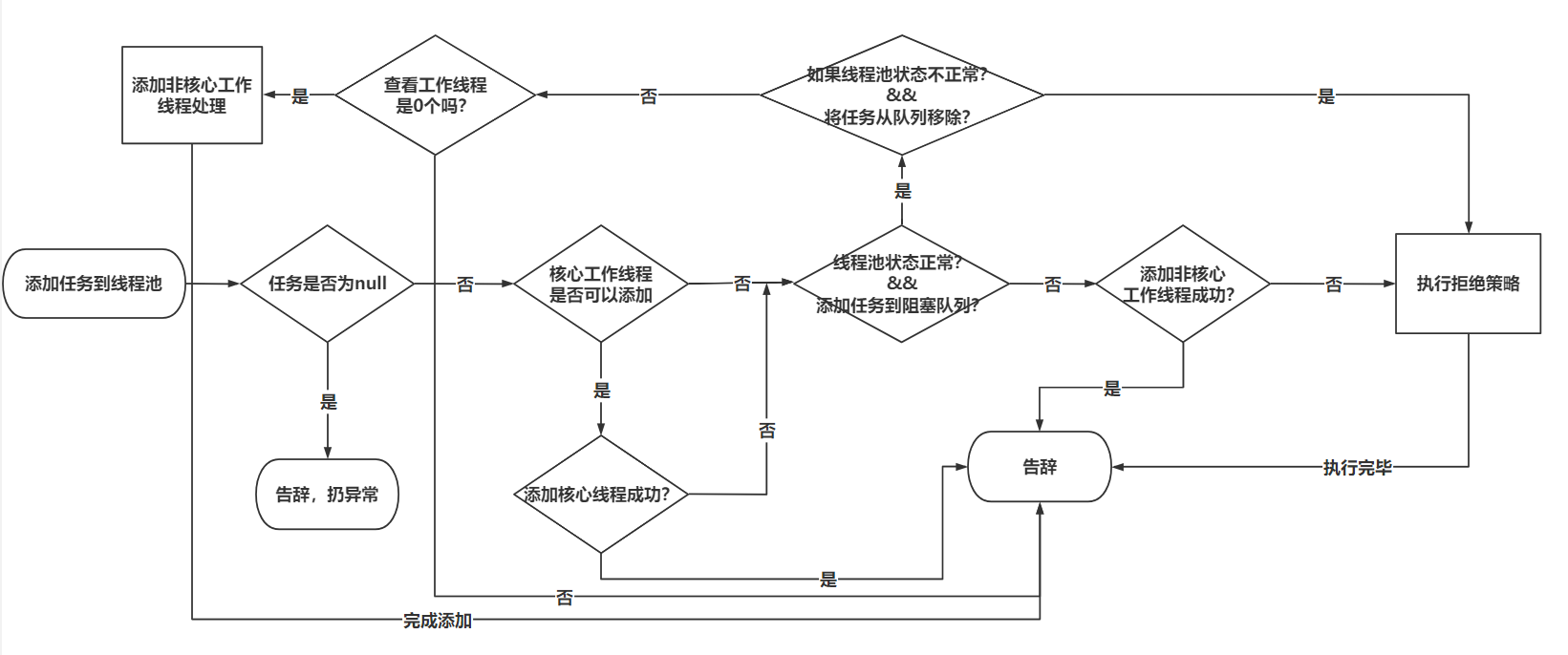

from sklearn.feature_extraction.text import TfidfVectorizer

tfidf_vec = TfidfVectorizer()

# stop words自定义停用词表,为列表List类型

# token_pattern过滤规则,正则表达式,如r"(?u)bw+b

# max_df=0.5,代表一个单词在 50% 的文档中都出现过了,那么它只携带了非常少的信息,因此就不作为分词统计

documents = [

'this is the bayes document',

'this is the second second document',

'and the third one',

'is this the document'

]

tfidf_matrix = tfidf_vec.fit_transform(documents)

# 拟合模型,并返回文本矩阵 表示了每个单词在每个文档中的 TF-IDF 值

print('输出每个单词在每个文档中的 TF-IDF 值,向量里的顺序是按照词语的 id 顺序来的:', '\n', tfidf_matrix.toarray())

print('不重复的词:', tfidf_vec.get_feature_names())

print('输出每个单词对应的 id 值:', tfidf_vec.vocabulary_)

print('返回idf值:', tfidf_vec.idf_)

print('返回停用词表:', tfidf_vec.stop_words_)

🌸I could be bounded in a nutshell and count myself a king of infinite space.

特别鸣谢:木芯工作室 、Ivan from Russia

![移动Web【字体图标、平面转换[位移,旋转,转换原点,多重转换]、渐变】](https://img-blog.csdnimg.cn/254076a8730141c08912fc2b69c5b6c2.png)