Centos7的安装与模板机的制作

1.安装环境准备

1.VMware Workstation

2.centos7镜像

本文用的VMware版本为16.2.1 build-18811642

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Wnk6lrBy-1672466488954)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221215104047259.png)]](https://img-blog.csdnimg.cn/d37ef540e2154824a0ea739538bf1849.png)

2.开始安装

话不多说,直接上图

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aA9tNtum-1672466488955)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221215104320544.png)]](https://img-blog.csdnimg.cn/10044607968440cfaca771d466b88623.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-GG3oCYgk-1672466488956)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216171631474.png)]](https://img-blog.csdnimg.cn/7fe70a7cf0754b1bb49d6246ec1a3914.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-FEmXry0S-1672466488957)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216171702193.png)]](https://img-blog.csdnimg.cn/c3968af918fd4641a1b13bc42b27cb71.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Ivz0GaYr-1672466488957)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216172305380.png)]](https://img-blog.csdnimg.cn/152428dc5fa9449a921f2aa7a3b47724.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gWGYQTqb-1672466488957)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216173310543.png)]](https://img-blog.csdnimg.cn/ac2f7a8016404531a14ff982b8071ec8.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-hXC2Uo7M-1672466488958)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216173352996.png)]](https://img-blog.csdnimg.cn/cc05e09533d6441796396219f90bcba2.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qcp0yoKM-1672466488958)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216173417358.png)]](https://img-blog.csdnimg.cn/dd390f892ddc456897e37b280dc7d194.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-0FiJsGKQ-1672466488958)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174133661.png)]](https://img-blog.csdnimg.cn/06d93cc94a5c4a55be185ff86d72e74f.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-02losHFV-1672466488959)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174242359.png)]](https://img-blog.csdnimg.cn/17df19c2038e4ae4a8d08399a8ee29bb.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-9XXzdpBa-1672466488960)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174305336.png)]](https://img-blog.csdnimg.cn/d5f73b8c5105438b8fd306508f95e23d.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-iO9w4qxc-1672466488960)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174343496.png)]](https://img-blog.csdnimg.cn/200981ef11444aecad1cb08e93314f22.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-tEOhA94L-1672466488961)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174445327.png)]](https://img-blog.csdnimg.cn/0ed3bd6ad8fe42f4b77db07a3c0d0f8f.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-bWW9Hocf-1672466488961)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174512227.png)]](https://img-blog.csdnimg.cn/07c02453e2c947e8a74c186a64d9f3db.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-FDwY9lFo-1672466488962)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174602453.png)]](https://img-blog.csdnimg.cn/4107c4352b264a5aaa53a61510f0ac32.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Z7ovUxGs-1672466488963)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174631660.png)]](https://img-blog.csdnimg.cn/06b7cddcf2bf4798abf7718269dc417f.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-n3G12ZJH-1672466488963)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174651955.png)]](https://img-blog.csdnimg.cn/31bd73eb906c4d718cfbe304ea6f0155.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-lPzEvujb-1672466488964)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216174732973.png)]](https://img-blog.csdnimg.cn/69cf3ccc30274c85adb9239e430ab080.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pYvRDgb3-1672466488965)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180133439.png)]](https://img-blog.csdnimg.cn/e6a638aec957484781cff5d0a382c2ff.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qZSJJFBd-1672466488965)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180221147.png)]](https://img-blog.csdnimg.cn/e2c7131f43e845dfb6a66d0be5786dc0.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-LnuSxBjM-1672466488966)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180647061.png)]](https://img-blog.csdnimg.cn/a0830ddec4bd4b0dbd3c563ccdb8007f.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-296TStue-1672466488966)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180723926.png)]](https://img-blog.csdnimg.cn/57823aeb6715406494b9eb997ab83700.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Df7bdZKA-1672466488967)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180753465.png)]](https://img-blog.csdnimg.cn/44b5a090854641a5b6bff4499005b32c.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-4ASnxahw-1672466488967)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180808909.png)]](https://img-blog.csdnimg.cn/757f91ff7cd94d91856ae2fa2265db47.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-57VcFE9T-1672466488968)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216180901923.png)]](https://img-blog.csdnimg.cn/3521f8a6e27d473080206acbcc1dd0b0.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-MbwIZ8kc-1672466488968)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216184502694.png)]](https://img-blog.csdnimg.cn/7bdef9f927c24a11b11c76f3234f2272.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UeluQYrv-1672466488969)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216185031862.png)]](https://img-blog.csdnimg.cn/3d14538c719640d5b1b2d924b04a536d.png)

3.模板机制作

1.查看防火墙的运行状态

firewall-cmd --state

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-KbvQ25Pt-1672466488969)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216190626975.png)]](https://img-blog.csdnimg.cn/406789277b3f4675965d6030a965b7a2.png)

防火墙目前正在启动中

2.关闭防火墙

(1)临时关闭

systemctl stop firewalld.service

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qtxMOiXb-1672466488970)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216192617373.png)]](https://img-blog.csdnimg.cn/de8293782d5941d1968421713dfda3d9.png)

(2)永久关闭

systemctl disable firewalld.service

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-FzM9EYN5-1672466488970)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216192820332.png)]](https://img-blog.csdnimg.cn/b86f02d52cda417b8f6aee57b722e48f.png)

仅仅关闭此防火墙是不够的,还要关闭内核防火墙

查看内核防火墙的状态

getenforce

临时关闭内核防火墙

setenforce 0

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-0dWPwqXx-1672466488971)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216193052668.png)]](https://img-blog.csdnimg.cn/e6ab40fb5f2448949feac0cd04ede491.png)

永久关闭的方式

vi /etc/selinux/config

将SELINUX=enforcing中的enforcing修改为disabled

如下图所示

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-kPbRACYF-1672466488972)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216193407491.png)]](https://img-blog.csdnimg.cn/36b8d85cecba405cb167fbfb480888f1.png)

此时两套防火墙均关闭,重启一下虚拟机。

reboot -h now

3.配置静态ip

切换目录到网络配置目录

cd /etc/sysconfig/network-scripts

查看一下都有什么文件

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1fN4xc7T-1672466488973)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216194223779.png)]](https://img-blog.csdnimg.cn/9d2ceb055d834d20a31bb6b6ba81236c.png)

配置静态ip需要点击编辑->虚拟网络编辑器

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-G54z3U9w-1672466488974)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216194635434.png)]](https://img-blog.csdnimg.cn/f1564e427ce5455da026595150b96c69.png)

打开可以查看可以分配的起始ip地址与结束的ip地址

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-97gDaXNu-1672466488974)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216194730305.png)]](https://img-blog.csdnimg.cn/486f8bf255d2479eb81efa82b08caa45.png)

分配ip的时候要在这个范围之内

vi ifcfg-ens33

将文件内容改为以下内容

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aJMwDMIX-1672466488975)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216195226680.png)]](https://img-blog.csdnimg.cn/344c18eabb6f457d86ca8d6bc29247a4.png)

ip地址根据自己的ip来选择,网关也是根据自己的情况来写

保存退出后重启网卡文件

service network restart

查看是否为我们配置的ip地址

ip addr

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-iKmTiqn7-1672466488975)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216195530276.png)]](https://img-blog.csdnimg.cn/6459a0f3d1ef4eabb57891e571836f1f.png)

配置成功,下面检查一下是否可以连接外网

curl www.baidu.com

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-EziZeQZS-1672466488976)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221216195648190.png)]](https://img-blog.csdnimg.cn/e2b9999b4ebe44b3a3abea4187db3228.png)

出现此处画面说明配置成功,模板机也制作完成

4.用模板机制作主节点

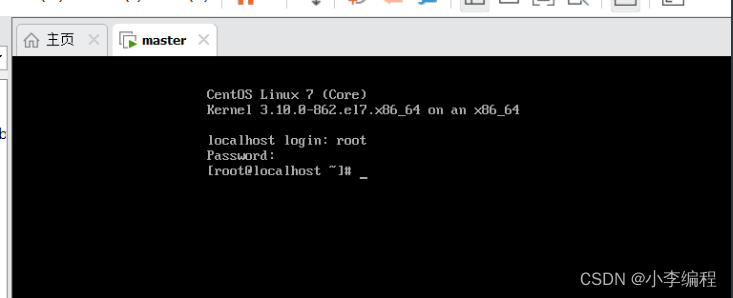

1.远程登录虚拟机

本文使用SecureCRT来连接虚拟机

使用方式直接看图

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-H4vlOR44-1672466488976)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217113416847.png)]](https://img-blog.csdnimg.cn/fc53d3265b574b53a92e0131f9146754.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-u4K06FDA-1672466488977)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217113432731.png)]](https://img-blog.csdnimg.cn/5316894d260e457db6c46c7ff867579b.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-fbygJZIb-1672466488977)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217114952028.png)]](https://img-blog.csdnimg.cn/5df5c100d69d410c9e8f0bc1cbb003bc.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5ndFbHCM-1672466488978)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217113546980.png)]](https://img-blog.csdnimg.cn/5aa5d3fc321e4d37886512043edc2782.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IsGfRDUf-1672466488978)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217113621177.png)]](https://img-blog.csdnimg.cn/946e5053ab754a84bb403ac0f79c5249.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-NVyBwp0e-1672466488979)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217113657269.png)]](https://img-blog.csdnimg.cn/e12f37a3c3474d91bdc03c4e6839118b.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Jl2iZmNv-1672466488979)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217113710113.png)]](https://img-blog.csdnimg.cn/8b53acb7ecb64f5bbe87d32584d0a13a.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-J3OlOqG0-1672466488980)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217115110174.png)]](https://img-blog.csdnimg.cn/d2544066c94948da9ce5d2a1d8bf2a89.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-cLvhnfpT-1672466488980)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217115159647.png)]](https://img-blog.csdnimg.cn/f954861342fa423f9704d9ea539d4d09.png)

2.上传文件

可以使用上传工具上传文件,由于安装的是最小化安装,并没有这个工具,可以先安装一下

yum -y install lrzsz

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-dxqv8SFx-1672466488981)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217115824789.png)]](https://img-blog.csdnimg.cn/fb7eeedf76624cf3831a09933fccc35a.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5TZRjHqG-1672466488981)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217120006452.png)]](https://img-blog.csdnimg.cn/efc7c178367f4dc09b942662eb4486d1.png)

安装完毕

上传命令

rz

然后敲回车,此时会打开文件目录

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-wf0ZEevM-1672466488982)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217120229318.png)]](https://img-blog.csdnimg.cn/a3be8c645d2544f8af4c4f6243e2944e.png)

选择要上传的文件,点击打开,等候上传成功即可

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-PMPZiYE7-1672466488982)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217120618825.png)]](https://img-blog.csdnimg.cn/5297535149a544bea18278beb419fc06.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gi9yqp9q-1672466488983)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217120645444.png)]](https://img-blog.csdnimg.cn/f48f12b827094264b777105d7543518e.png)

可以看到已经上传过来了

3.安装jdk

首先切换到文件所存放的位置

cd /usr/local/src

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-2eiiEUB5-1672466488983)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217130225197.png)]](https://img-blog.csdnimg.cn/c6e1ba767338416e9e99864bb352863f.png)

执行解压缩命令

tar -zxvf jdk-8u172-linux-x64.tar.gz

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-tGwqwQNs-1672466488984)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217130401335.png)]](https://img-blog.csdnimg.cn/af1eacd8eeb54705900cfe0f7769d312.png)

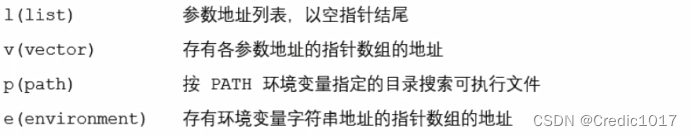

配置环境变量

1./root/.bashrc

2./etc/profile

两个位置的都可以,第一个是全局变量,当机器开机启动后配置就会生效,第二个是当用户登录之后生效

选择第一种配置方式

当前jdk的位置

/usr/local/src/jdk1.8.0_172

vi /root/.bashrc

加入以下内容

export JAVA_HOME=/usr/local/src/jdk1.8.0_172

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-OmBHUwRO-1672466488984)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217132134955.png)]](https://img-blog.csdnimg.cn/0acbc455c4004c488ff07557c49d1d20.png)

刷新一下环境变量

source /root/.bashrc

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-DySTiyeb-1672466488984)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217132255412.png)]](https://img-blog.csdnimg.cn/16be485e60334e6ea4b7ac1f4ee30c28.png)

jdk到此安装结束

4.安装hadoop

上传hadoop的压缩包

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-BTOLI0aF-1672466488985)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217130625806.png)]](https://img-blog.csdnimg.cn/c252080475e1495e87b2fc6c26ce2ef4.png)

解压缩hadoop

tar -zxvf hadoop-2.6.1.tar.gz

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5pQH4DLF-1672466488985)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217130829294.png)]](https://img-blog.csdnimg.cn/adce9393019745ee958f403164b69630.png)

删除一些文件,替换为以下几个文件

rm -rf hdfs-site.xml core-site.xml slaves yarn-site.xml

接下来上传以下文件

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-P1FBzdhq-1672466488986)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217133916870.png)]](https://img-blog.csdnimg.cn/5a22874bbffb4825ad251807b7a4d860.png)

链接:https://pan.baidu.com/s/1tbyLjrWXSNpRn5GoxdjFSg?pwd=8tqw

提取码:8tqw

–来自百度网盘超级会员V5的分享

5.vim的安装

yum -y install vim

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Fm0TmVZf-1672466488986)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217134639028.png)]](https://img-blog.csdnimg.cn/841d077779384edf9609efb238ae1a36.png)

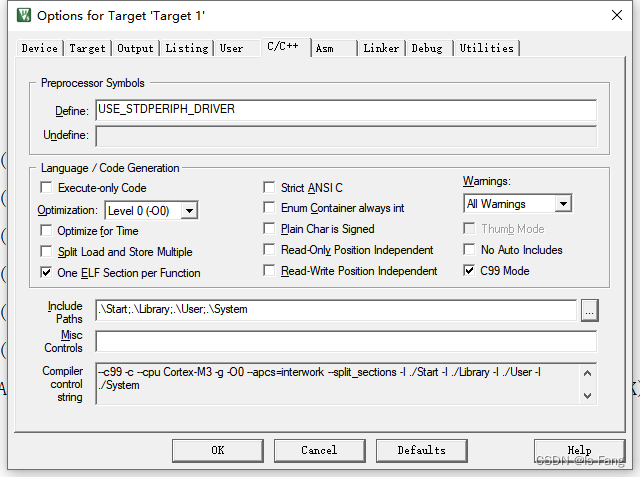

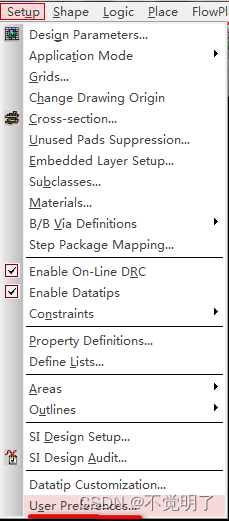

6.配置其他的环境

vim hadoop-env.sh

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pCQ36wrK-1672466488986)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217134859566.png)]](https://img-blog.csdnimg.cn/624a6589177d44f2820b38c166bef0de.png)

替换成路径

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jtoD84RI-1672466488987)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217135001955.png)]](https://img-blog.csdnimg.cn/3e9e90129f3141fb9395bd9581d34e3e.png)

vim yarn-env.sh

export JAVA_HOME=/usr/local/src/jdk1.8.0_172

将该语句加入到文件中

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1Vtzhl9g-1672466488987)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217135311151.png)]](https://img-blog.csdnimg.cn/2d2ef38e7e3347fabb2bacd8de14a4c4.png)

创建一些文件夹

cd /usr/local/src/hadoop-2.6.1

mkdir -p dfs/data

mkdir -p dfs/name

mkdir tmp

vim /root/.bashrc

添加以下内容

# set hadoop environment

export HADOOP_HOME=/usr/local/src/hadoop-2.6.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-4T0iQ2od-1672466488987)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217135946431.png)]](https://img-blog.csdnimg.cn/67ef8699b85c455db5e7d70b4fb6a370.png)

刷新一下

source /root/.bashrc

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-CQMJPdKX-1672466488988)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217140141932.png)]](https://img-blog.csdnimg.cn/550bde896b074e3e94b334660a8de290.png)

环境配置完毕

4.克隆虚拟机

1.首先先把虚拟机关机

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-neDWNbmz-1672466488988)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217140841982.png)]](https://img-blog.csdnimg.cn/5fe6bd1418c647009d6dd631ea9a74c5.png)

点击虚拟机—>管理–>克隆

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jR9XV0ZR-1672466488988)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217140947280.png)]](https://img-blog.csdnimg.cn/f59bc3c297c44e9aaf3deb0526ed0665.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-keu3y1sn-1672466488989)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217141000169.png)]](https://img-blog.csdnimg.cn/9f897d6d02c64ccba49df9ac422a0785.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5qH5gGwU-1672466488989)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217141018515.png)]](https://img-blog.csdnimg.cn/6bb09ebd185a4c91b31ae31667b8858a.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-HUn96min-1672466488989)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217141117649.png)]](https://img-blog.csdnimg.cn/b072598d705d4ecdb5b6ade8254a117f.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-zbN2FY9S-1672466488989)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217141145511.png)]](https://img-blog.csdnimg.cn/4f0f742c49a24148864aabb918862168.png)

用同样的方式克隆出slave2

2.接下来打开虚拟机修改ip地址

cd /etc/sysconfig/network-scripts

vim ifcfg-ens33

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XcbeGUHF-1672466488990)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217141800985.png)]](https://img-blog.csdnimg.cn/a07f9a9147bc4d9bad241e1da9b2f20a.png)

只改ip地址即可,修改完成后重新启动网络服务

/etc/init.d/network restart

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-w3agN30K-1672466488990)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217142058493.png)]](https://img-blog.csdnimg.cn/2fd45f96ed084a498baf59a00fd71272.png)

出现此场景说明是正常的,用同样的方式去修改slave2

5.修改hostname

1.修改hostname:

格式:hostnamectl set-hostname 机器名称

命令:hostnamectl set-hostname master

hostnamectl set-hostname master

hostnamectl set-hostname slave1

hostnamectl set-hostname slave2

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-t5CcFXfo-1672466488990)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217143727034.png)]](https://img-blog.csdnimg.cn/59a2e4d3a37b400d9f64c8b1f6a54024.png)

分别在对应节点执行三条命令

2.下面做一下ip映射关系

vim /etc/hosts

192.168.109.130 master

192.168.109.131 slave1

192.168.109.132 slave2

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-LxN9QhLY-1672466488991)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217144129214.png)]](https://img-blog.csdnimg.cn/d54404c6aacf4632a47314dcac5d4c21.png)

加入要配置的映射关系

3.远程将修改的文件拷贝给两台slave

scp -r /etc/hosts root@slave1:/etc/

scp -r /etc/hosts root@slave2:/etc/

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-vdd8j9wk-1672466488991)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217144753630.png)]](https://img-blog.csdnimg.cn/11e56928c95b46b9ad33d6fd80b94ebd.png)

重启三台虚拟机

6.建立互信关系

1.master节点上

ssh-keygen -t rsa -P ''

输入完成后执行,然后按回车

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-X4KZw8qr-1672466488991)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217145525061.png)]](https://img-blog.csdnimg.cn/c11a102c3dd44775b7bf3369142e5c51.png)

另外两个节点也执行一下

2.进入以下目录

cd /root/.ssh/

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-wnCs0C2s-1672466488992)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217145827546.png)]](https://img-blog.csdnimg.cn/b594ab8970a24d38bc087771dd280db5.png)

3.接下来执行下方的命令

ssh slave1 cat /root/.ssh/id_rsa.pub >>authorized_keys

ssh slave2 cat /root/.ssh/id_rsa.pub >>authorized_keys

cat id_rsa.pub >>authorized_keys

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-LjpG6cO2-1672466488992)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217150145641.png)]](https://img-blog.csdnimg.cn/37033378a63b46e9b3475618008e8bd2.png)

4.将该文件分发给另外两个机器

scp -r authorized_keys slave1:`pwd`

scp -r authorized_keys slave2:`pwd`

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SsrW0uuv-1672466488992)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217150938545.png)]](https://img-blog.csdnimg.cn/1e79abfa81db4dddbf971e83755f3ac4.png)

5.验证一下是否互信成功

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-mbufb5Fk-1672466488992)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217151451099.png)]](https://img-blog.csdnimg.cn/e954ab28805848f7a01a73e9f2c06671.png)

登录时不需要输入密码,成功

7.hadoop集群搭建

1.格式化hadoop集群

1)在哪个节点格式化,哪个节点就是主节点

在master节点格式化

hadoop namenode -format

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-5RRkr3ng-1672466488993)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217151824140.png)]](https://img-blog.csdnimg.cn/753452bafcb248469d59c58ddd093b8d.png)

2)启动集群

cd $HADOOP_HOME

sbin/start-all.sh

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-B6LacBb5-1672466488993)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217152037922.png)]](https://img-blog.csdnimg.cn/c855df563b484e9bb409b740ad2fbdb0.png)

3)检查集群是否正常

检查进程是否正常

master(主节点)节点

[root@master hadoop-2.6.1]# jps

1907 Jps

1653 ResourceManager

1354 NameNode

1519 SecondaryNameNode

slave1(子节点)

[root@slave1 ~]# jps

1232 DataNode

1417 Jps

1322 NodeManager

slave2(子节点)

[root@slave2 ~]# jps

1478 NodeManager

1575 Jps

1388 DataNode

master(主节点)上执行命令

hadoop dfsadmin -report

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-vv9alovg-1672466488993)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217152839220.png)]](https://img-blog.csdnimg.cn/e13abb8bad054886992b602972c93285.png)

出现这样的情况说明是正常的,下面进一步验证。

hadoop fs -put README.txt /

将此文件上传至hdfs上,接下来查看一下

hadoop fs -ls /

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-OXdW0nSS-1672466488994)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217153209249.png)]](https://img-blog.csdnimg.cn/be5bbcde12564e1286623360fcb77792.png)

4)关闭集群

sbin/stop-all.sh

执行完之后分别在三台机器上执行jps命令

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-z2nXfBqx-1672466488994)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217153957368.png)]](https://img-blog.csdnimg.cn/9bc3a8b93e7a4d06a6802ee6f4bfb667.png)

hadoop集群搭建完成

2.web界面浏览

为了可以在网页浏览,需要在主节点启动历史任务

cd /usr/local/src/hadoop-2.6.1/sbin

./mr-jobhistory-daemon.sh start historyserver

jps

此时jps之后

[root@master sbin]# jps

3537 JobHistoryServer

3683 NameNode

4279 Jps

3996 ResourceManager

3854 SecondaryNameNode

JobHistoryServer进程会记录执行任务的日志

在浏览器输入ip地址加上8088端口即可查看hadoop的GUI界面

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-USHnpoju-1672466488994)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217155546008.png)]](https://img-blog.csdnimg.cn/fafa529ede8c4ac7b543fadfb2073a8c.png)

下面修改本机hosts文件

位置为:C:\Windows\System32\drivers\etc

修改hosts文件

添加内容:

虚拟机各个节点的ip地址和hostname

中间空格分开

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-dkkillZi-1672466488994)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217160124955.png)]](https://img-blog.csdnimg.cn/76b6610640b04049bf4e818971e3e216.png)

这样就可以用hostname来访问了

8.mysql的安装

1.检查是否安装了数据库

rpm -qa | grep mysql

rpm -qa | grep mariadb

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-cFeuOdbi-1672466488995)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217160851899.png)]](https://img-blog.csdnimg.cn/615c4b7eaa4143cb9348e2ac344537a2.png)

此时说明已经有mariadb,要先把它卸载掉

2.卸载

yum -y remove mariadb-libs-5.5.56-2.el7.x86_64

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-fijxOD27-1672466488995)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217161454149.png)]](https://img-blog.csdnimg.cn/3820e32c3dd943a4b04339549fb1a2c1.png)

卸载完毕

3.安装wget

yum -y install wget

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-NoGZoYoH-1672466488996)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217161613164.png)]](https://img-blog.csdnimg.cn/a9ae2ca982c74d7e985b6976d283e5b4.png)

4.下载 mysql57-community-release-el7-9.noarch.rpm 的yum源:

wget http://mirrors.ustc.edu.cn/mysql-repo/mysql57-community-release-el7-9.noarch.rpm

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-OZSDoicu-1672466488996)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217162106396.png)]](https://img-blog.csdnimg.cn/a1bb44f43de84b2f85a8bc2ee1b7dba6.png)

5.安装rpm文件:

rpm -ivh mysql57-community-release-el7-9.noarch.rpm

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-UKGBSfSr-1672466488997)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221217162211136.png)]](https://img-blog.csdnimg.cn/e2ff230cb5894b38905b939bc55804db.png)

6.yum安装mysql-community-server

yum -y install mysql-community-server --nogpgcheck

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-gASqjPpo-1672466488997)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218090144216.png)]](https://img-blog.csdnimg.cn/2723a4caf67a428093c0f34dc26cc671.png)

7.关闭强密码验证

vim /etc/my.cnf

#增加以下内容

plugin-load=validate_password.so

validate-password=OFF

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-1e2bQ3yZ-1672466488998)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218090417537.png)]](https://img-blog.csdnimg.cn/70332d6592f14a848476dcb3b806f503.png)

8.启动mysql服务

service mysqld start

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-sFeOTmme-1672466488998)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218090658440.png)]](https://img-blog.csdnimg.cn/7db0bf6f90e0424c94c5b9e320d5d184.png)

9.获取临时生成的密码

grep "password" /var/log/mysqld.log

10.登录mysql

mysql -u root -p

将密码输入,回车

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pBUGgSPn-1672466488998)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218090953051.png)]](https://img-blog.csdnimg.cn/4bd328ef5c114b42a0535c2667dd3282.png)

11.更改密码

SET PASSWORD = PASSWORD('123456');

ALTER USER 'root'@'localhost' PASSWORD EXPIRE NEVER;

flush privileges;

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-apFnjR8h-1672466488999)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218091202302.png)]](https://img-blog.csdnimg.cn/32d9795b129b4fa095f44c9f489460b1.png)

12查询用户表:

mysql> use mysql

mysql> select User,authentication_string,Host from user;

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-TfiYOk24-1672466488999)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218091336188.png)]](https://img-blog.csdnimg.cn/8ef14659bcc642f6bb54139a77345e93.png)

13.设置任意IP访问:

mysql> grant all privileges on *.* to root@"%" identified by "123456";

mysql> grant all privileges on *.* to root@"master" identified by "123456";

mysql> flush privileges;

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-OQealtGY-1672466489000)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218091505738.png)]](https://img-blog.csdnimg.cn/8612246f860b4fb49737af96bed35e18.png)

退出mysql:exit 设置开机启动mysql服务:systemctl enable mysqld

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-npGNKWSj-1672466489000)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218091535647.png)]](https://img-blog.csdnimg.cn/f1c06c1ab81a40129ac66dca3f75165d.png)

14.重新登录mysql

mysql -u root -p

输入密码123456

use mysql

select User,authentication_string,Host from user;

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-Y88LUHPi-1672466489000)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218091925139.png)]](https://img-blog.csdnimg.cn/a523266496554bf491df6eb01e4fd856.png)

可以看到下边多了两行,此时设置完毕

9.Hive的安装

1.下载软件包

wget https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-1.2.2/apache-hive-1.2.2-bin.tar.gz

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-nTkJFOgE-1672466489001)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218102716793.png)]](https://img-blog.csdnimg.cn/d9f92dc6afb042f48a54511a95be8e02.png)

下边加入后边的参数

wget https://mirrors.tuna.tsinghua.edu.cn/apache/hive/hive-1.2.2/apache-hive-1.2.2-bin.tar.gz --no-check-certificate

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-g3S4KPt8-1672466489001)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218102805887.png)]](https://img-blog.csdnimg.cn/0643d795a6694c0ca2c041bf78838869.png)

2.解压

tar -zxvf apache-hive-1.2.2-bin.tar.gz

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-JyhwbC8U-1672466489002)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218102854819.png)]](https://img-blog.csdnimg.cn/77b7ba51e0b842279f1fd41426cbb124.png)

移动目录

mv apache-hive-1.2.2-bin /usr/local/src/

切换目录

cd /usr/local/src/apache-hive-1.2.2-bin/conf

3.修改配置文件

修改hive运行环境配置文件:hive-env.sh

mv hive-env.sh.template hive-env.sh

vim hive-env.sh

添加如下内容

export JAVA_HOME=/usr/local/src/jdk1.8.0_172

export HADOOP_HOME=/usr/local/src/hadoop-2.6.1

export HIVE_HOME=/usr/local/src/apache-hive-1.2.2-bin

export HIVE_CONF_DIR=/usr/local/src/apache-hive-1.2.2-bin/conf

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-qNkGgBsA-1672466489002)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218103440696.png)]](https://img-blog.csdnimg.cn/e4edbf93891141ceb8961c302823f884.png)

创建hive-site.xml文件

touch hive-site.xml

vim hive-site.xml

添加如下内容

<?xml version="1.0" encoding="UTF-8" standalone="no"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://master:3306/hive?createDatabaseIfNotExist=true&useSSL=false</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>hdfs://master:9000/hive/warehouse</value>

</property>

<property>

<name>hive.exec.scratchdir</name>

<value>hdfs://master:9000/hive/tmp</value>

</property>

<property>

<name>hive.querylog.location</name>

<value>/usr/hive/log</value>

<description>设置hive job日志存储位置</description>

</property>

<property>

<name>hive.cli.print.header</name>

<value>true</value>

<description>设置列名</description>

</property>

<property>

<name>hive.resultset.use.unique.column.names</name>

<value>false</value>

<description>增加列名可读性</description>

</property>

<!-- flume to hive test-->

<property>

<name>hive.support.concurrency</name>

<value>true</value>

<description>是否支持并发,默认是false</description>

</property>

<!--

<property>

<name>hive.txn.manager</name>

<value>org.apache.hadoop.hive.ql.lockmgr.DbTxnManager</value>

<description>打开一部分事务支持协同配置</description>

</property>

-->

<property>

<name>hive.compactor.initiator.on</name>

<value>true</value>

<description>运行启动程序和清除线程,用于打开所需参数的完整列表事务</description>

</property>

<property>

<name>hive.compactor.worker.threads</name>

<value>1</value>

<description>增加工作线程的数量将减少花费的时间</description>

</property>

<property>

<name>hive.enforce.bucketing</name>

<value>true</value>

<description>是否启用bucketing,写入table数据</description>

</property>

<property>

<name>hive.exec.dynamic.partition.mode</name>

<value>nonstrict</value>

<description>设置动态分区模式为非严格模式</description>

</property>

</configuration>

4.添加环境变量

master节点

vim ~/.bashrc

export HIVE_HOME=/usr/local/src/apache-hive-1.2.2-bin

export PATH=$PATH:${HIVE_HOME}/bin

刷新一下环境变量,让配置生效:

source ~/.bashrc

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-PfdfF0N3-1672466489002)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218110949532.png)]](https://img-blog.csdnimg.cn/46ef7280e764424d827a2efb1c18935e.png)

5.安装mysql的连接工具

wget https://cdn.mysql.com/archives/mysql-connector-java-5.1/mysql-connector-java-5.1.45.tar.gz

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-3qY4Wm7f-1672466489003)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218111112801.png)]](https://img-blog.csdnimg.cn/feb4f54e3a6a4bb5aff814eea5f4fa4c.png)

解压

tar -zxvf mysql-connector-java-5.1.45.tar.gz

cd mysql-connector-java-5.1.45

cp mysql-connector-java-5.1.45-bin.jar $HIVE_HOME/lib/

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-g9nB3WG8-1672466489003)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218111418895.png)]](https://img-blog.csdnimg.cn/b1933a3fc20b470180160b424e7f7ae7.png)

查看是否复制过来

cd $HIVE_HOME

ls lib/mysql-connector-java-5.1.45-bin.jar

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-3BBQmJXt-1672466489004)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218111514374.png)]](https://img-blog.csdnimg.cn/5e2540b04e0b44489b0f8fa11879642a.png)

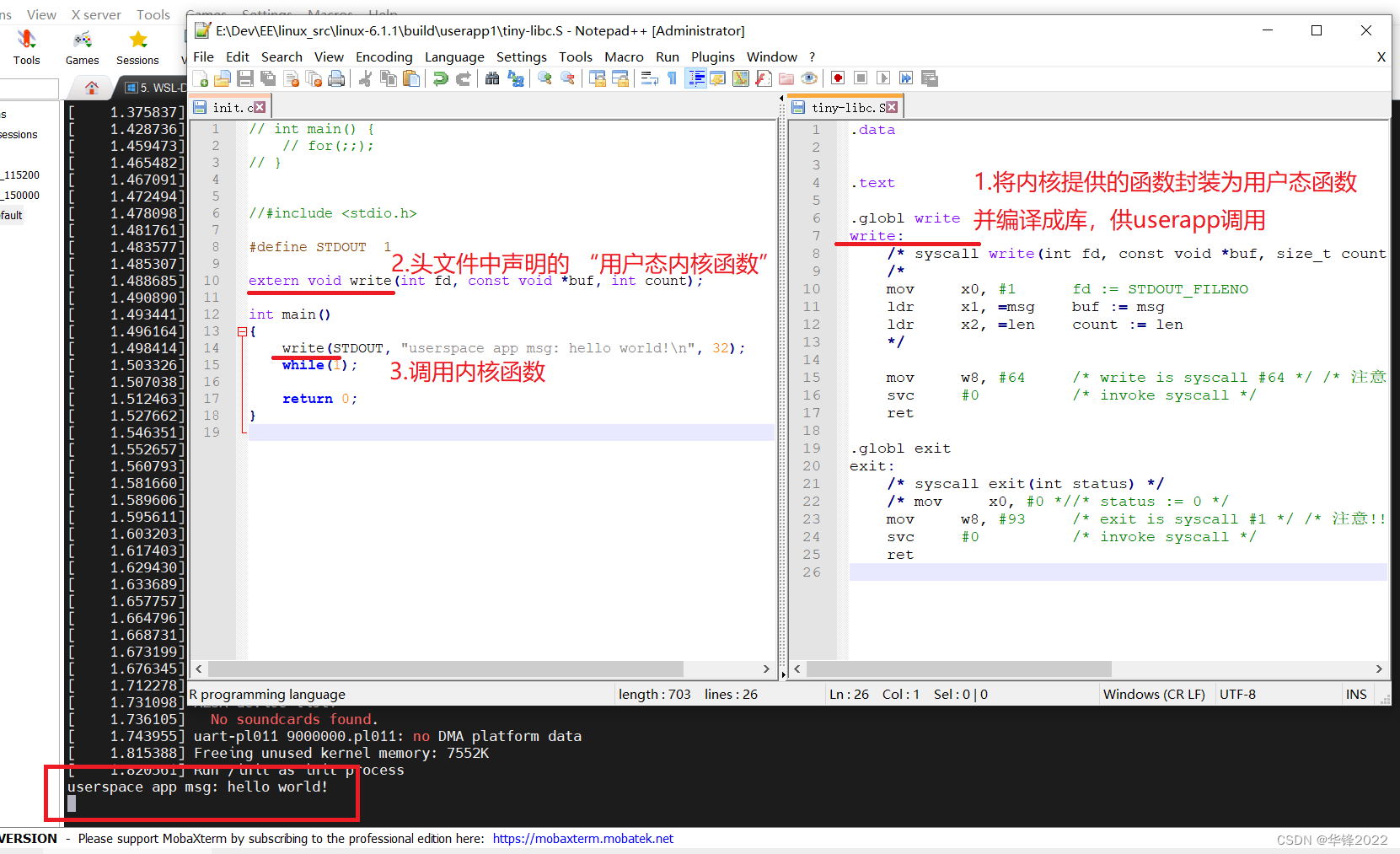

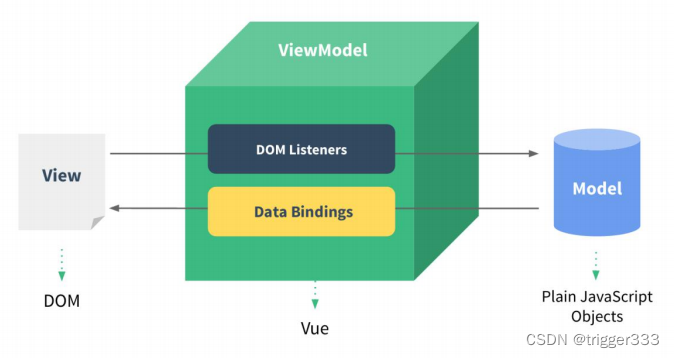

6.启动hive

# 启动hive之前先启动hadoop

hive 是依赖hadoop中的hdfs作为存储,依赖mysql管理元数据

hadoop集群启动之后,需要等待一会,等待hadoop退出安全模式,

退出之后才可以启动hive

1.启动hadoop

cd /usr/local/src/hadoop-2.6.1

sbin/start-all.sh

2.检查

hadoop dfsadmin -report

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-U0jHnClK-1672466489004)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218112444064.png)]](https://img-blog.csdnimg.cn/2aa746c98e0948df93e68f3eef3378d0.png)

3.进入hive目录

cd /usr/local/src

ls -ll

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-b36lNdLe-1672466489004)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218112822837.png)]](https://img-blog.csdnimg.cn/cc4329b1a12742abb2a22faa72e5d5fb.png)

修改用户和用户组,改为root

先关闭hadoop

cd hadoop-2.6.1

sbin/stop-all.sh

cd /usr/local/src

修改用户和用户组

ll

chown -R root:root hadoop-2.6.1 jdk1.8.0_172

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-A2wPstiT-1672466489005)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218113359815.png)]](https://img-blog.csdnimg.cn/14d04d0715084555b5ed486cd4b3d1a1.png)

两个slave节点也改一下

接下来重新启动hadoop

cd /usr/local/src/hadoop-2.6.1

sbin/start-all.sh

再次检查是否在安全模式

hadoop dfsadmin -report

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-XJyb7aVT-1672466489005)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218113801263.png)]](https://img-blog.csdnimg.cn/a1f791f85b3347cc8a4496bed73e6dbc.png)

可以看到并没有处于安全模式

4.启动hive

cd /usr/local/src/apache-hive-1.2.2-bin/bin

./hive

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-OMYF0PYu-1672466489006)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218114233312.png)]](https://img-blog.csdnimg.cn/87113584ff364a6cbab49f30de6b9efd.png)

执行过程中出现了错误,下面来修改

首先删除hadoop中的旧版本的jline-0.9.94.jar

所在目录

$HADOOP_HOME/share/hadoop/yarn/lib/jline-0.9.94.jar

删除操作

rm $HADOOP_HOME/share/hadoop/yarn/lib/jline-0.9.94.jar

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-jPr0uMoP-1672466489006)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218115101812.png)]](https://img-blog.csdnimg.cn/c7eb5386a17d4b8d9d62cb7dfb9010a6.png)

复制hive中的jline-2.12.jar到hadoop中

cd /usr/local/src/apache-hive-1.2.2-bin

cp lib/jline-2.12.jar $HADOOP_HOME/share/hadoop/yarn/lib/

然后启动hive

cd conf/

hive

show databases;

此时发现hive执行的比较慢,我们下面修改一下,提升hive执行速度

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aaa1ZKA1-1672466489007)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218115910917.png)]](https://img-blog.csdnimg.cn/8c0e6fafe2df4790aef54483f88f293e.png)

cd /usr/local/src/apache-hive-1.2.2-bin/conf

vim hive-site.xml

将下边内容注释掉

<!-- flume to hive test>

<property>

<name>hive.support.concurrency</name>

<value>true</value>

<description>是否支持并发,默认是false</description>

</property>

<property>

<name>hive.txn.manager</name>

<value>org.apache.hadoop.hive.ql.lockmgr.DbTxnManager</value>

<description>打开一部分事务支持协同配置</description>

</property>

<property>

<name>hive.compactor.initiator.on</name>

<value>true</value>

<description>运行启动程序和清除线程,用于打开所需参数的完整列表事务</description>

</property>

<property>

<name>hive.compactor.worker.threads</name>

<value>1</value>

<description>增加工作线程的数量将减少花费的时间</description>

</property>

<property>

<name>hive.enforce.bucketing</name>

<value>true</value>

<description>是否启用bucketing,写入table数据</description>

</property>

<property>

<name>hive.exec.dynamic.partition.mode</name>

<value>nonstrict</value>

<description>设置动态分区模式为非严格模式</description>

</property>

-->

此时执行hive的时候就变快了

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-6Vt7ovmW-1672466489007)(C:\Users\DELL\AppData\Roaming\Typora\typora-user-images\image-20221218120807188.png)]](https://img-blog.csdnimg.cn/9f95581797274683bd8ebf8135249d96.png)

![如何稍微优雅滴完成博文访问计数[SpringBoot+redis+分布式锁]](https://img-blog.csdnimg.cn/f276c02cf9ea48fa98b73f891080e2f0.png)

](https://img-blog.csdnimg.cn/img_convert/3dc62dc06b9e9b0e1395345306629f1d.jpeg)