文章目录

- 前言:

- 一面:

- 01、Java基础知识答疑,简单概述一下?

- 02、倒排索引了解吗?使用Java语言怎么实现倒排?

- 03、详细讲解一下redis里面的哈希表,常用的Redis哈希表命名有哪些,举例说明其使用?

- 04、happen-before的规则了解吗?说一下happen-before的一些例子。

- 05、详细讲解一下工作中常使用的关键字:volatile修饰符,synchronize锁。

- 06、简单描述一下几种常见的Java单例模式实现以及使用场景?

- 07、请问你了解过进程与线程的区别吗,多进程和多线程的区别是什么?

- 08、简单描述一下HashMap的实现原理,为什么用红黑树,红黑树的特点什么?

- 09、快速排序的时间和空间复杂度,最好最坏的情况各是什么,以及优化方案?用Java语言简单写一个快速排序方法?

- 10、TCP的拥塞控制是什么,说一下其具体实现过程?UDP有拥塞控制吗?如何解决?

- 11、讲一下你了解过的垃圾回收算法和回收器机制,什么时候执行STOP THE WORLD?

- 12、工作中有了解Go语言吗,Go语言有什么优势?

- 13、项目相关的问题:项目中负责哪些模块?说一下工作中最有心得的技术领域?遇到问题的解决思路和方法?

- 二面:

- 01、简单描述一下你对Kylin项目架构的了解。

- 02、分布式一致性协议有哪些?讲解一下Paxos和ZAB协议?

- 03、分布式系统的CAP理论是什么,为什么要做分区容错性?

- 04、大表Join小表如何优化,如何避免数据倾斜?

- 05、讲一下你对最大堆和最小堆的了解以及其时间复杂度?

- 06、介绍一下HDFS的读取、写入,容错处理机制?

- 07、讲解一下MapReduce的过程?

- 08、描述一下你对MR shuffle,Spark shuffle的了解?

- 09、namenode HA,脑裂,Yarn的调度机制了解吗,简单说一下是实现原理?

- 10、Hive的内部表和外部表区别、数仓建模模型、数仓分层、雪花模型和星型模型?

- 11、了解ClickHouse吗?它与Kylin的区别?

- 三面:

- 01、用伪代码实现一个简单的LRU算法?

- 02、链表倒数第K个数。(讲思路)

- 03、一堆螺丝和螺母用最短时间匹配。(Java代码实现)

- 04、求每天浏览页面的新用户。(Hive QL实现)

- 05、求抖音小视频每日点击量最高的10个。(Hash + 最小堆)

前言:

偶然间看到一篇字节跳动的面试题,看了一下题目,由简到难,一步一步增加面试者题目,自己根据多年的Java知识积累,尝试着进行一场虚拟的字节跳动的面试流程。我是好好的补充了一下脑洞,用劲九虎二牛之力,才勉强回答一二,有不同想法的各位同仁,欢迎评论区留言,探讨一二,多多受益。一面:

01、Java基础知识答疑,简单概述一下?

Java基础知识包括但不限于以下内容:

1. 数据类型和变量:Java有基本数据类型(如整数、浮点数、字符、布尔值)和引用数据类型(如类、接口、数组),可以声明和使用变量来存储数据。

举例:声明整数类型变量:

int num = 10;

2. 控制流程:Java提供条件语句(如if-else、switch)和循环语句(如for循环、while循环)来控制程序的执行流程。

举例:使用if-else语句判断某个数是奇数还是偶数:

int num = 5;

if (num % 2 == 0) {

System.out.println("偶数");

} else {

System.out.println("奇数");

}

3. 方法和函数:Java中可以定义方法来组织和重用代码,方法可以接收参数并返回结果。

举例:定义一个方法来计算两个整数的和:

public int sum(int a, int b) {

return a + b;

}

4. 面向对象编程:Java是一门面向对象的编程语言,通过类和对象来组织和封装数据和行为。

举例:定义一个简单的类来表示学生:

public class Student {

private String name;

private int age;

public Student(String name, int age) {

this.name = name;

this.age = age;

}

public void study() {

System.out.println(name + "正在学习");

}

}

5. 异常处理:Java提供异常处理机制来处理程序运行过程中的异常情况,可以捕获和处理异常,保证程序的稳定性。

举例:使用try-catch语句捕获并处理除零异常:

int a = 10;

int b = 0;

try {

int result = a / b;

System.out.println(result);

} catch (ArithmeticException e) {

System.out.println("除零异常:" + e.getMessage());

}

这些只是Java基础知识的一部分,Java还有很多其他的概念和特性,需要进一步学习和掌握。

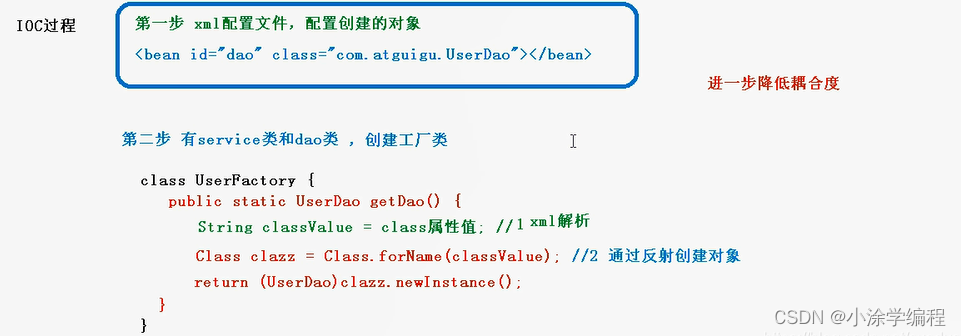

02、倒排索引了解吗?使用Java语言怎么实现倒排?

倒排索引(Inverted Index)是一种常用的文本检索技术,用于快速查找包含特定词语的文档。以下是一个简单的倒排索引实现的示例:

1. 首先,需要建立一个包含文档信息的数据结构,例如使用HashMap来存储词语和对应的文档列表。

import java.util.*;

public class InvertedIndex {

private Map<String, List<String>> index;

public InvertedIndex() {

index = new HashMap<>();

}

public void addDocument(String documentId, String content) {

String[] words = content.split("\\s+"); // 使用空格分隔文档内容为单词

for (String word : words) {

if (!index.containsKey(word)) {

index.put(word, new ArrayList<>());

}

index.get(word).add(documentId);

}

}

public List<String> search(String keyword) {

return index.getOrDefault(keyword, new ArrayList<>());

}

public static void main(String[] args) {

InvertedIndex invertedIndex = new InvertedIndex();

invertedIndex.addDocument("doc1", "This is a sample document");

invertedIndex.addDocument("doc2", "Another document for testing");

List<String> result = invertedIndex.search("document");

System.out.println("Documents containing 'document': " + result);

}

}

在上述示例中,我们首先创建了一个 index 对象,用于存储词语和对应的文档列表。然后,通过 addDocument 方法将文档内容添加到索引中,将文档ID和内容作为参数传入。在添加文档时,我们将内容按照空格进行分词,然后将每个词语与文档ID关联起来。最后,通过 search 方法可以根据关键词查找包含该关键词的文档ID列表。

在上述示例中,我们添加了两个文档,并通过关键词"document"进行搜索,输出了包含该关键词的文档ID列表。你可以根据实际需求进行扩展和优化,例如支持多词组合搜索、处理停用词等。

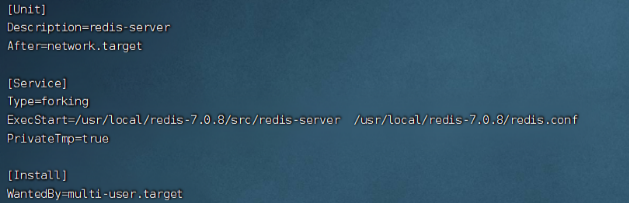

03、详细讲解一下redis里面的哈希表,常用的Redis哈希表命名有哪些,举例说明其使用?

Redis中的哈希表(Hash)是一种数据结构,用于存储键值对的集合。哈希表是一个无序的键值对集合,其中每个键都是唯一的,并且与一个值相关联。

在Redis中,哈希表的键是一个字符串,值可以是字符串、整数或浮点数等数据类型。哈希表的实现采用了类似散列表的方式,通过哈希函数将键映射到一个索引位置上,以实现快速的读写操作。

以下是一些常用的Redis哈希表命令:

1. HSET:设置哈希表中指定字段的值。

HSET key field value

2. HGET:获取哈希表中指定字段的值。

HGET key field

3. HMSET:同时设置哈希表中多个字段的值。

HMSET key field1 value1 field2 value2 ...

4. HMGET:同时获取哈希表中多个字段的值。

HMGET key field1 field2 ...

5. HDEL:删除哈希表中一个或多个字段。

HDEL key field1 field2 ...

6. HKEYS:获取哈希表中所有字段的键。

HKEYS key

7. HVALS:获取哈希表中所有字段的值。

HVALS key

8. HGETALL:获取哈希表中所有字段的键值对。

HGETALL key

哈希表在Redis中的应用非常广泛,常用于存储对象、缓存数据、计数器等场景。通过哈希表,可以高效地存储和检索大量的键值对数据。

04、happen-before的规则了解吗?说一下happen-before的一些例子。

happen-before是Java并发编程中的一个重要概念,用于描述操作之间的时间顺序关系。happen-before规则是一组规则,用于指定在多线程环境下,操作之间的顺序关系,以保证程序的正确性。

以下是happen-before规则的一些例子:

1. 程序顺序规则:如果操作A出现在操作B之前,那么操作A就happen-before操作B。

2. 锁规则:如果一个解锁操作出现在对同一个锁的加锁操作之前,那么解锁操作就happen-before加锁操作。

3. volatile变量规则:如果一个volatile变量的写操作出现在对同一个变量的读操作之前,那么写操作就happen-before读操作。

4. 线程启动规则:如果线程A启动线程B,那么A线程的操作happen-before线程B中的任意操作。

5. 线程终止规则:如果线程A的所有操作都happen-before线程B的终止操作,那么线程A的操作就happen-before线程B的终止操作。

6. 线程中断规则:如果线程A调用线程B的interrupt()方法,那么线程A的操作happen-before线程B检查到中断事件的操作。

7. 对象终结规则:如果对象的构造函数结束happen-before它的finalize()方法的开始,那么对象的构造函数中的操作happen-before它的finalize()方法中的操作。

happen-before规则是Java并发编程中的一个非常重要的概念,可以帮助我们理解多线程程序中操作之间的顺序关系,以及如何避免并发问题。

05、详细讲解一下工作中常使用的关键字:volatile修饰符,synchronize锁。

volatile修饰符和synchronized关键字是Java并发编程中用于实现线程安全的两个关键字。

1. volatile修饰符:

-

volatile修饰符用于修饰变量,确保变量的可见性和禁止指令重排序。

-

当一个变量被volatile修饰时,对该变量的写操作会立即刷新到主内存,对该变量的读操作会从主内存中获取最新值。

-

volatile修饰符适用于多个线程同时访问一个变量的场景,但不适用于复合操作的原子性保证。

-

例如,使用volatile修饰一个标志位,可以使多个线程之间正确地感知到该标志位的变化。

2. synchronized关键字:

-

synchronized关键字用于实现线程的互斥访问,确保共享资源在同一时间只能被一个线程访问。

-

synchronized可以修饰代码块或方法,也可以修饰静态方法或类。

-

当线程进入synchronized代码块或方法时,会自动获取对象的锁,其他线程需要等待锁的释放才能进入。

-

synchronized关键字保证了临界区的原子性和可见性,但可能会引起线程的阻塞和上下文切换开销。

-

例如,使用synchronized关键字可以确保多个线程对共享资源的访问互斥,避免并发问题。

需要注意的是,volatile修饰符和synchronized关键字都是用于实现线程安全的机制,但适用的场景和实现方式不同。选择合适的机制取决于具体的需求和线程安全的要求。

volatile修饰符和synchronized关键字的示例说明如下:

1. volatile修饰符的示例:

public class VolatileExample {

private volatile boolean flag = false;

public void setFlag() {

flag = true;

}

public void printFlag() {

while (!flag) {

// 空循环等待flag变为true

}

System.out.println("Flag is true");

}

public static void main(String[] args) {

VolatileExample example = new VolatileExample();

new Thread(() -> {

example.setFlag();

}).start();

new Thread(() -> {

example.printFlag();

}).start();

}

}

在上述示例中,flag变量被volatile修饰。其中,一个线程通过setFlag方法将flag设置为true,另一个线程通过printFlag方法检查flag是否为true。由于flag的可见性,当flag变为true时,printFlag方法会结束循环并打印出"Flag is true"。

2. synchronized关键字的示例:

public class SynchronizedExample {

private int count = 0;

public synchronized void increment() {

count++;

}

public int getCount() {

return count;

}

public static void main(String[] args) {

SynchronizedExample example = new SynchronizedExample();

for (int i = 0; i < 5; i++) {

new Thread(() -> {

for (int j = 0; j < 1000; j++) {

example.increment();

}

}).start();

}

try {

Thread.sleep(2000); // 等待所有线程执行完毕

} catch (InterruptedException e) {

e.printStackTrace();

}

System.out.println("Count: " + example.getCount());

}

}

在上述示例中,多个线程通过increment方法对count进行累加操作。由于increment方法被synchronized修饰,每次只能有一个线程进入该方法,确保了对count的操作是互斥的。最后,通过getCount方法获取累加后的count值,并打印出来。

通过使用volatile修饰符和synchronized关键字,可以实现线程安全的操作和共享资源的同步访问。

06、简单描述一下几种常见的Java单例模式实现以及使用场景?

Java单例模式是一种设计模式,用于确保一个类只有一个实例,并提供全局访问点。

以下是几种常见的Java单例模式实现方式:

1. 懒汉式(Lazy Initialization):

public class Singleton {

private static Singleton instance;

private Singleton() {}

public static synchronized Singleton getInstance() {

if (instance == null) {

instance = new Singleton();

}

return instance;

}

}

在懒汉式中,只有在第一次调用 getInstance() 方法时才会创建实例。通过 synchronized 关键字确保线程安全,但会导致性能下降。

2. 双重检查锁(Double-Checked Locking):

public class Singleton {

private static volatile Singleton instance;

private Singleton() {}

public static Singleton getInstance() {

if (instance == null) {

synchronized (Singleton.class) {

if (instance == null) {

instance = new Singleton();

}

}

}

return instance;

}

}

双重检查锁在懒汉式的基础上进行了改进,通过两次判断 instance 是否为 null 来减少锁的使用,提高性能。 volatile 关键字确保多线程环境下的可见性。

3. 饿汉式(Eager Initialization):

public class Singleton {

private static final Singleton instance = new Singleton();

private Singleton() {}

public static Singleton getInstance() {

return instance;

}

}

在饿汉式中,实例在类加载时就被创建,因此不存在线程安全问题。但可能会浪费内存,因为实例在整个程序生命周期中都存在。

4. 静态内部类(Static Inner Class):

public class Singleton {

private Singleton() {}

private static class SingletonHolder {

private static final Singleton instance = new Singleton();

}

public static Singleton getInstance() {

return SingletonHolder.instance;

}

}

静态内部类的方式利用了类加载机制和静态变量的特性,实现了懒加载和线程安全。

以上是几种常见的Java单例模式实现方式,选择适合自己需求的方式来实现单例模式。

07、请问你了解过进程与线程的区别吗,多进程和多线程的区别是什么?

进程和线程是操作系统中用于实现并发执行的两个基本概念。

1. 进程(Process):

-

进程是程序的一次执行过程,是操作系统进行资源分配和调度的基本单位。

-

每个进程都有独立的内存空间,包含程序代码、数据和执行状态等。

-

进程之间相互独立,拥有各自的地址空间,通信需要通过进程间通信(IPC)机制。

-

进程切换开销较大,需要保存和恢复整个进程的上下文。

2. 线程(Thread):

-

线程是进程中的一个执行单元,是CPU调度和执行的基本单位。

-

同一进程中的线程共享相同的内存空间,包括代码、数据和文件等。

-

线程之间可以直接读写共享数据,通信更加方便快捷。

-

线程切换开销较小,只需要保存和恢复线程的上下文。

多进程和多线程的区别如下:

1. 资源占用:多进程需要独立的内存空间和系统资源,占用较多资源;而多线程共享同一进程的资源,占用较少资源。

2. 通信方式:多进程之间通信需要通过进程间通信(IPC)机制,如管道、信号量、共享内存等;而多线程之间可以直接读写共享数据进行通信。

3. 切换开销:多进程切换的开销较大,需要保存和恢复整个进程的上下文;而多线程切换的开销较小,只需要保存和恢复线程的上下文。

4. 编程复杂性:多进程编程相对复杂,需要处理进程间通信和同步问题;而多线程编程相对简单,线程共享内存,编程更加方便。

5. 安全性:多进程之间相互独立,一个进程崩溃不会影响其他进程;而多线程共享内存,一个线程的错误可能导致整个进程崩溃。

综上所述,多进程适合于需要独立运行和相互隔离的任务,多线程适合于需要共享数据和协同工作的任务。选择合适的并发模型取决于具体的应用场景和需求。

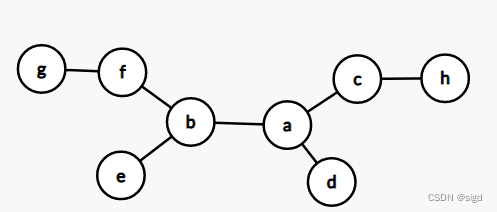

08、简单描述一下HashMap的实现原理,为什么用红黑树,红黑树的特点什么?

HashMap是Java中的一种常用的数据结构,用于存储键值对。它基于哈希表实现,通过哈希函数将键映射到对应的存储位置上,以实现快速的插入、查找和删除操作。

在HashMap中,哈希冲突是指不同的键经过哈希函数计算后得到相同的哈希值,导致它们被映射到同一个存储位置上。为了解决哈希冲突,HashMap采用了链地址法(拉链法)和红黑树结合的方式。

当链表中的元素数量超过一定阈值时,HashMap会将链表转换为红黑树。这是因为红黑树在插入、删除和查找等操作上具有更好的性能,尤其是在大量元素的情况下。

红黑树是一种自平衡的二叉搜索树,具有以下特点:

- 节点是红色或黑色。

- 根节点是黑色。

- 叶子节点(空节点)是黑色。

- 如果一个节点是红色的,则它的子节点必须是黑色的。

- 从根节点到叶子节点的每条路径上,黑色节点的数量相同。

红黑树通过保持这些特性,确保了树的高度相对较低,从而提供了快速的插入、删除和查找操作。在HashMap中,红黑树用于解决链表过长的问题,提高了HashMap的性能和效率。

总结起来,HashMap采用哈希表和红黑树的结合,通过哈希函数和链地址法解决哈希冲突,当链表过长时转换为红黑树,以提供快速的键值对操作。

09、快速排序的时间和空间复杂度,最好最坏的情况各是什么,以及优化方案?用Java语言简单写一个快速排序方法?

快速排序(Quicksort)是一种常用的排序算法,其时间复杂度和空间复杂度如下:

-

时间复杂度:

-

最好情况下,当每次划分都能将数组均匀分割时,快速排序的时间复杂度为O(nlogn)。

-

最坏情况下,当每次划分都只能将数组分割为一个元素和剩余的元素时,快速排序的时间复杂度为O(n^2)。

-

平均情况下,快速排序的时间复杂度为O(nlogn)。

-

-

空间复杂度:

-

快速排序的空间复杂度主要取决于递归调用的栈空间,最好和平均情况下的空间复杂度为O(logn)。

-

最坏情况下,当递归调用栈达到最大深度时,空间复杂度为O(n)。

-

快速排序的优化方案包括:

1. 随机选择基准元素:在每次划分时,随机选择一个元素作为基准元素,可以避免最坏情况的发生,减少时间复杂度为O(n^2)的概率。

2. 三数取中法:在选择基准元素时,不是简单地选择第一个或最后一个元素,而是选择数组中的中间元素,可以降低最坏情况的概率。

3. 插入排序优化:当待排序的子数组大小较小时,可以使用插入排序来替代快速排序,减少递归调用的次数。

4. 尾递归优化:对于划分后的较小子数组,可以使用尾递归来避免递归调用栈的过深,减少空间复杂度。

这些优化方案可以提高快速排序的性能和效率,减少最坏情况的发生,但也需要根据具体情况进行评估和选择。

下面是一个Java实现快速排序算法的例子,其中包括高效和低效两种实现方式。

高效实现:

import java.util.Arrays;

public class QuickSort {

public static void main(String[] args) {

int[] arr = {10, 7, 8, 9, 1, 5};

System.out.println("原始数组: " + Arrays.toString(arr));

quickSort(arr, 0, arr.length - 1);

System.out.println("排序后的数组: " + Arrays.toString(arr));

}

public static void quickSort(int[] arr, int low, int high) {

if (low < high) {

int pivotIndex = partition(arr, low, high);

quickSort(arr, low, pivotIndex - 1);

quickSort(arr, pivotIndex + 1, high);

}

}

public static int partition(int[] arr, int low, int high) {

int pivot = arr[high];

int i = low - 1;

for (int j = low; j < high; j++) {

if (arr[j] < pivot) {

i++;

swap(arr, i, j);

}

}

swap(arr, i + 1, high);

return i + 1;

}

public static void swap(int[] arr, int i, int j) {

int temp = arr[i];

arr[i] = arr[j];

arr[j] = temp;

}

}

低效实现:

import java.util.Arrays;

public class QuickSort {

public static void main(String[] args) {

int[] arr = {10, 7, 8, 9, 1, 5};

System.out.println("原始数组: " + Arrays.toString(arr));

quickSort(arr);

System.out.println("排序后的数组: " + Arrays.toString(arr));

}

public static void quickSort(int[] arr) {

if (arr == null || arr.length == 0) {

return;

}

int length = arr.length;

quickSortHelper(arr, 0, length - 1);

}

public static void quickSortHelper(int[] arr, int low, int high) {

if (low < high) {

int pivotIndex = partition(arr, low, high);

quickSortHelper(arr, low, pivotIndex - 1);

quickSortHelper(arr, pivotIndex + 1, high);

}

}

public static int partition(int[] arr, int low, int high) {

int pivot = arr[low];

int i = low + 1;

int j = high;

while (i <= j) {

while (i <= j && arr[i] <= pivot) {

i++;

}

while (i <= j && arr[j] > pivot) {

j--;

}

if (i < j) {

swap(arr, i, j);

}

}

swap(arr, low, j);

return j;

}

public static void swap(int[] arr, int i, int j) {

int temp = arr[i];

arr[i] = arr[j];

arr[j] = temp;

}

}

这是快速排序算法的两种实现方式,高效实现使用了递归和分区的方式,而低效实现则使用了循环和双指针的方式。两种实现方式的核心思想都是通过选择一个基准元素,将数组分为两部分,一部分小于基准元素,一部分大于基准元素,然后对两部分分别进行递归或循环处理,直到排序完成。

10、TCP的拥塞控制是什么,说一下其具体实现过程?UDP有拥塞控制吗?如何解决?

TCP(传输控制协议)的拥塞控制是为了在网络拥塞的情况下,避免过多的数据流量导致网络性能下降或崩溃。拥塞控制的具体过程如下:

1. 慢启动(Slow Start):初始时,TCP发送方以较小的拥塞窗口大小发送数据,然后每次收到确认时,拥塞窗口大小会加倍,以逐渐增加发送速率。

2. 拥塞避免(Congestion Avoidance):在慢启动阶段之后,当拥塞窗口大小达到一个阈值时,TCP发送方会进入拥塞避免阶段。此时,拥塞窗口的增长速率变慢,每次收到一个确认时,拥塞窗口大小只增加一个分组。

3. 快速重传(Fast Retransmit):当TCP发送方连续收到3个重复的确认时,它会认为网络中发生了拥塞,并立即重传丢失的数据包,而不必等待超时。

4. 快速恢复(Fast Recovery):在进行快速重传后,TCP发送方将拥塞窗口大小减半,并进入快速恢复阶段。在快速恢复阶段,每次收到一个确认时,拥塞窗口大小增加一个分组,并且以拥塞避免的方式继续增长。

UDP(用户数据报协议)没有内置的拥塞控制机制。UDP是一种无连接的协议,不提供可靠性和拥塞控制。UDP的设计目标是尽可能快地传输数据,适用于实时性要求高、对数据丢失不敏感的应用场景。

如果在使用UDP时需要进行拥塞控制,可以通过应用层进行自定义实现。一些常见的方法包括:

1. 基于时间的拥塞控制:通过设置发送速率的上限,限制发送方的数据发送速度,以避免网络拥塞。

2. 基于反馈的拥塞控制:在接收方收到数据时,通过反馈信息告知发送方当前网络状况,发送方根据反馈信息调整发送速率。

3. 基于丢包率的拥塞控制:通过监测丢包率,当丢包率超过某个阈值时,减小发送速率以避免拥塞。

需要注意的是,UDP的拥塞控制是应用层的实现,因此在使用UDP时,开发人员需要自行实现适合自己应用场景的拥塞控制策略。

11、讲一下你了解过的垃圾回收算法和回收器机制,什么时候执行STOP THE WORLD?

垃圾回收算法和回收器是用于管理和释放不再使用的内存资源的技术。下面是一些常见的垃圾回收算法和回收器,以及执行"STOP THE WORLD"的情况:

1. 垃圾回收算法:

-

标记-清除算法(Mark and Sweep):通过标记不再使用的对象,然后清除这些对象所占用的内存空间。

-

复制算法(Copying):将内存分为两个区域,每次只使用其中一个区域,当一个区域满时,将存活的对象复制到另一个区域,然后清除当前区域中的所有对象。

-

标记-整理算法(Mark and Compact):通过标记不再使用的对象,然后将存活的对象向一端移动,然后清除边界之外的内存空间。

2. 垃圾回收器:

-

Serial收集器:使用单线程进行垃圾回收,适用于小型应用程序。

-

Parallel收集器:使用多线程进行垃圾回收,适用于多核处理器的应用程序。

-

CMS收集器(Concurrent Mark Sweep):使用并发标记和清除算法,减少垃圾回收时的停顿时间。

-

G1收集器(Garbage First):将堆内存划分为多个区域,通过并发标记和整理算法,优化垃圾回收性能和停顿时间。

3. STOP THE WORLD:

"STOP THE WORLD"是指在进行垃圾回收时,应用程序的执行被暂停。在某些情况下,垃圾回收器需要暂停应用程序来执行一些必要的操作,例如标记存活对象、清除未标记的对象等。这些停顿时间可能会对应用程序的性能和响应时间产生影响。

一般情况下,垃圾回收器会尽量减少"STOP THE WORLD"的时间,并通过并发标记和清除等技术来实现并发执行。但在某些情况下,如进行全局标记、整理等操作时,垃圾回收器可能需要停止应用程序的执行,以确保垃圾回收的正确性和一致性。这些停顿时间的长短取决于垃圾回收算法和回收器的实现,以及应用程序的特性和负载情况。

12、工作中有了解Go语言吗,Go语言有什么优势?

是的,我了解Go语言。Go语言是一种由Google开发的开源编程语言,具有以下优势:

1. 简洁易学:Go语言的语法简洁清晰,易于学习和使用,减少了开发人员的学习曲线。

2. 并发编程:Go语言原生支持并发编程,通过轻量级的Goroutine和通道(Channel)机制,简化了并发编程的复杂性,使得编写高效的并发程序更加容易。

3. 高性能:Go语言通过垃圾回收、编译器优化等技术,提供了出色的性能表现,适用于构建高性能的应用程序。

4. 内存管理:Go语言的垃圾回收机制(Garbage Collection)可以自动管理内存,减轻了开发人员的负担,避免了手动内存管理带来的错误。

5. 静态类型和类型推导:Go语言是静态类型的语言,可以在编译时捕获类型错误,提高了代码的可靠性。同时,Go语言也支持类型推导,可以简化代码书写,提高开发效率。

6. 跨平台:Go语言的编译器支持多种平台,可以方便地在不同的操作系统上进行开发和部署。

7. 强大的标准库:Go语言拥有丰富的标准库,涵盖了网络编程、文件操作、加密解密、并发编程等众多领域,开发人员可以直接使用这些标准库来构建应用程序,提高开发效率。

总的来说,Go语言以其简洁、高效、并发友好的特性,适用于构建高性能、可靠性强的应用程序,尤其在网络编程、分布式系统和云计算等领域广受欢迎。

13、项目相关的问题:项目中负责哪些模块?说一下工作中最有心得的技术领域?遇到问题的解决思路和方法?

二面:

01、简单描述一下你对Kylin项目架构的了解。

Kylin是一个开源的大数据分析引擎,用于快速查询和分析大规模数据集。其项目架构主要包括以下几个核心组件:

1. 元数据存储(Metadata Storage):用于存储Kylin的元数据信息,包括数据模型、Cube定义、查询语义等。目前支持HBase和MySQL作为元数据存储。

2. Cube构建引擎(Cube Build Engine):负责将原始数据构建成多维Cube,以提供快速的OLAP查询能力。构建引擎会根据Cube定义和数据模型,对原始数据进行切片、聚合和压缩等处理,生成Cube数据文件。

3. 查询引擎(Query Engine):用于执行OLAP查询,提供快速的查询响应和结果返回。查询引擎会根据查询语义和Cube定义,利用预计算的Cube数据和查询优化技术,快速计算并返回结果。

4. 元数据管理(Metadata Management):提供了管理Kylin元数据的接口和工具,包括数据模型设计、Cube定义、数据源配置等。

5. 安全认证和权限管理(Security and Authorization):提供了用户认证和权限管理的功能,以保护敏感数据和控制访问权限。

6. 调度和监控(Scheduling and Monitoring):提供了任务调度和监控的功能,包括Cube构建任务的调度、查询任务的监控等。

Kylin的架构设计旨在实现高性能和可扩展性,通过预计算和多维存储的方式,提供快速的OLAP查询能力。同时,Kylin还提供了丰富的API和工具,方便用户进行数据模型设计、Cube构建和查询操作。

02、分布式一致性协议有哪些?讲解一下Paxos和ZAB协议?

Paxos和ZAB(ZooKeeper Atomic Broadcast)协议都是一种分布式一致性协议,用于在分布式系统中实现数据一致性和容错性。它们的主要目标是确保在面对网络故障和节点故障时,系统仍能保持一致性。

1. Paxos协议:

-

Paxos是由Leslie Lamport提出的一种分布式一致性算法,用于解决分布式系统中的一致性问题。

-

Paxos的核心是通过提议(Proposal)和接受(Accept)的阶段,来达成多个节点之间的一致性。

-

Paxos算法分为三个角色:提议者(Proposer)、接受者(Acceptor)和学习者(Learner)。

-

提议者通过提出提案(Proposal)来尝试达成一致,接受者则根据提案的编号和值来决定是否接受该提案。

-

Paxos协议通过多个轮次的提议和接受,最终达成一致性。

2. ZAB协议:

-

ZAB协议是Apache ZooKeeper中使用的一种原子广播协议,用于实现分布式一致性和容错性。

-

ZAB协议的目标是确保ZooKeeper集群中的所有服务器具有相同的事务日志和数据状态。

-

ZAB协议主要包括两个阶段:崩溃恢复阶段和消息广播阶段。

-

在崩溃恢复阶段,ZAB协议通过选举一个Leader来恢复集群中的一致性,Leader负责处理客户端的读写请求。

-

在消息广播阶段,Leader将客户端的写请求广播给其他服务器,并等待大多数服务器的确认,以保证一致性。

Paxos和ZAB协议都是解决分布式系统中一致性问题的重要算法。它们在实现细节和应用场景上有所不同,但都提供了可靠的一致性保证。

03、分布式系统的CAP理论是什么,为什么要做分区容错性?

CAP理论是分布式系统设计中的一个重要理论,指出在一个分布式系统中,一致性(Consistency)、可用性(Availability)和分区容错性(Partition Tolerance)这三个目标无法同时满足,最多只能同时满足其中两个。

具体来说:

1. 一致性(Consistency):指的是在分布式系统中的所有节点看到的数据是一致的。即当一个节点更新了数据后,其他节点能够立即看到最新的数据。

2. 可用性(Availability):指的是分布式系统在面对网络故障或节点故障时,仍然能够继续提供服务,不会出现长时间的不可用情况。

3. 分区容错性(Partition Tolerance):指的是分布式系统在面对网络分区(即节点之间无法相互通信)时,仍然能够保持数据一致性和可用性。

CAP理论认为,在分布式系统中,由于网络的不可靠性和分区的存在,无法同时满足一致性、可用性和分区容错性这三个目标。因此,在设计分布式系统时,需要根据实际需求和场景,权衡和选择满足的目标。

对于大多数分布式系统来说,分区容错性是必须满足的,因为网络分区是无法避免的。而在一致性和可用性之间的选择,则取决于具体的应用需求。一致性优先的系统会更强调数据的一致性,可能会在可用性上有所牺牲;可用性优先的系统则更强调系统的可用性,可能会在一致性上有所放松。

分区容错性的意义在于保证了分布式系统的稳定性和可靠性。通过分区容忍,即使在面临网络故障或节点故障时,系统仍然能够继续运行,并保持数据的一致性。这为构建高可用、高性能的分布式系统提供了基础。

04、大表Join小表如何优化,如何避免数据倾斜?

在处理大表和小表的Join操作时,数据倾斜是一个常见的挑战。数据倾斜指的是在Join操作中,某些键值对的分布不均匀,导致部分节点负载过重,影响性能。

以下是一些处理数据倾斜的优化技巧:

1. 预处理和数据分析:在进行Join操作之前,对大表和小表的数据进行预处理和分析,了解数据的分布情况和倾斜程度。可以通过统计信息、采样等方式进行数据分析,以便更好地优化Join操作。

2. 数据倾斜检测:通过监控和分析Join操作的执行情况,及时检测数据倾斜的发生。可以通过观察任务的执行时间、数据分布情况等指标来判断是否存在数据倾斜。

3. 倾斜键处理:

-

均匀分布:对于倾斜的键,可以通过一些策略将其数据均匀分布到不同的节点上,例如对键进行哈希操作,将相同哈希值的键分配到不同的节点。

-

数据重分布:将倾斜的键值对从负载过重的节点上移动到其他节点上,以实现负载均衡。可以使用数据迁移、分片等技术来实现数据重分布。

4. 聚合操作:如果倾斜的键值对只是用于聚合操作(如求和、计数等),可以将倾斜键的聚合操作提前执行,并将结果缓存起来,避免重复计算。

5. 调整Join算法:根据具体情况,选择合适的Join算法。例如,使用Broadcast Join可以将小表复制到所有节点上,减少数据传输量和节点间的数据倾斜。

6. 增加并行度:增加并行度可以将任务分散到更多的节点上执行,减少单个节点的负载,以应对数据倾斜。

7. 动态调整资源:根据实际情况,动态调整节点的资源分配,例如增加节点的内存、CPU等资源,以适应数据倾斜带来的负载变化。

以上是一些常见的处理数据倾斜的优化技巧,具体的选择和实施策略需要根据具体的场景和数据特点来决定。

05、讲一下你对最大堆和最小堆的了解以及其时间复杂度?

最大堆(Max Heap)和最小堆(Min Heap)都是二叉堆(Binary Heap)的一种特殊形式,是一种常用的数据结构,用于维护一组元素,并支持高效的插入、删除和获取最值操作。

最大堆:

- 最大堆是一种满足以下条件的二叉树结构:对于堆中的任意节点i,节点i的值大于等于其子节点的值。

- 最大堆的根节点是堆中的最大值。

- 最大堆常用于实现优先队列,可以快速获取到当前堆中的最大值。

最小堆:

- 最小堆是一种满足以下条件的二叉树结构:对于堆中的任意节点i,节点i的值小于等于其子节点的值。

- 最小堆的根节点是堆中的最小值。

- 最小堆常用于实现优先队列,可以快速获取到当前堆中的最小值。

最大堆和最小堆的操作:

- 插入操作:将新元素插入到堆的末尾,然后通过上浮操作(向上调整)将其调整到合适的位置,以满足堆的性质。

- 删除操作:通常是删除根节点,将堆的最后一个元素移动到根节点,然后通过下沉操作(向下调整)将其调整到合适的位置,以满足堆的性质。

- 获取最值操作:最大堆可以快速获取最大值,最小堆可以快速获取最小值,只需访问堆的根节点即可。

最大堆和最小堆的时间复杂度:

- 插入操作的时间复杂度为O(log n),其中n是堆中元素的个数。

- 删除操作的时间复杂度为O(log n)。

- 获取最值操作的时间复杂度为O(1)。

最大堆和最小堆在算法和数据结构中有广泛的应用,例如排序算法(如堆排序)、图算法(如Dijkstra最短路径算法)等。

06、介绍一下HDFS的读取、写入,容错处理机制?

下面简要介绍一下HDFS(Hadoop分布式文件系统)的读取、写入和容错处理的原理。

HDFS的读取和写入:

-

读取:HDFS将大文件切分为多个数据块(默认大小为128MB),并将这些数据块分布在不同的数据节点上。当客户端需要读取文件时,它会向NameNode发送读取请求,NameNode返回包含数据块位置的元数据信息。然后客户端直接与数据节点通信,从数据节点读取相应的数据块,并将它们组合为完整的文件。

-

写入:当客户端要写入文件时,它会向NameNode发送写入请求,并将文件切分为数据块。然后客户端与数据节点通信,将数据块写入到对应的数据节点上。数据节点将数据块写入本地磁盘,并向NameNode发送写入完成的确认消息。最后,NameNode更新元数据信息,标记文件写入完成。

HDFS的容错处理:

-

数据冗余:HDFS通过数据冗余来实现容错。每个数据块都会有多个副本存储在不同的数据节点上,通常默认为3个副本。这样,即使某个数据节点发生故障,仍然可以从其他副本中获取数据。

-

心跳机制:HDFS使用心跳机制来监控数据节点的健康状态。数据节点会定期向NameNode发送心跳信号,告知自己的状态。如果NameNode在一定时间内没有收到某个数据节点的心跳信号,就会认为该节点发生故障,并将其上的数据块复制到其他健康的节点上。

-

自动恢复:当数据节点发生故障时,HDFS会自动将该节点上的数据块复制到其他副本所在的节点上,以保证数据的完整性和可用性。

-

NameNode的高可用:HDFS中的NameNode是整个文件系统的关键节点,负责管理文件系统的元数据。为了提高NameNode的可用性,HDFS引入了主备模式(Active-Standby)的架构。在主备模式下,有一个主NameNode和一个备NameNode,备NameNode会与主NameNode保持同步,并在主NameNode发生故障时接管其职责。

这是HDFS的基本读取、写入和容错处理的原理。具体的源代码实现可以在Apache Hadoop项目的代码库中找到。

07、讲解一下MapReduce的过程?

MapReduce是一种用于处理大规模数据集的编程模型和处理框架。下面是MapReduce的过程,包括第一版和第二版(YARN):

第一版MapReduce的过程:

1. 输入切分(Input Split):将输入数据切分为多个小的输入片段,每个输入片段都会被一个Map任务处理。

2. 映射(Map):每个Map任务读取一个输入片段,并将其转换为键值对的形式。然后,对每个键值对应用用户自定义的Map函数,生成中间键值对(Intermediate Key-Value Pairs)。

3. 分区(Partitioning):将中间键值对根据键的哈希值分发到不同的Reduce任务上。分区决定了哪些中间键值对会被发送到哪个Reduce任务进行处理。

4. 排序(Sorting):在每个Reduce任务接收到中间键值对之前,对中间键值对进行排序,以便相同键的值能够被归并在一起。

5. 归并(Shuffling):将排序后的中间键值对发送给对应的Reduce任务,以便进行进一步的处理。

6. 缩减(Reduce):每个Reduce任务接收到归并后的中间键值对,并对相同键的值应用用户自定义的Reduce函数,生成最终的输出键值对。

7. 输出(Output):将最终的输出键值对写入到输出文件或存储系统中。

第二版MapReduce(基于YARN)的过程:

第二版的MapReduce与第一版类似,但在资源管理和任务调度方面进行了改进。它使用YARN(Yet Another Resource Negotiator)作为资源管理器,具有更好的可伸缩性和资源利用率。

1. 客户端提交作业(Job Submission):客户端向YARN资源管理器提交MapReduce作业。

2. 资源分配(Resource Allocation):YARN资源管理器为作业分配所需的计算资源,包括Map任务和Reduce任务所需的计算资源。

3. 任务调度(Task Scheduling):YARN资源管理器将Map任务和Reduce任务分配给可用的计算节点,并在节点上启动任务。

4. 任务执行(Task Execution):计算节点上的任务执行器(Task Executor)执行Map任务和Reduce任务,并将结果写入临时文件。

5. 归并(Shuffling):中间结果通过网络传输到Reduce任务所在的节点,并进行归并操作。

6. 缩减(Reduce):Reduce任务对归并后的中间结果应用用户自定义的Reduce函数,生成最终的输出键值对。

7. 输出(Output):将最终的输出键值对写入到输出文件或存储系统中。

这是MapReduce的基本过程,第一版和第二版的主要区别在于资源管理和任务调度的方式。

08、描述一下你对MR shuffle,Spark shuffle的了解?

MR Shuffle(MapReduce Shuffle)和Spark Shuffle是两种不同的数据重分区和数据传输过程,用于支持分布式计算框架中的数据处理和计算操作。

1. MR Shuffle(MapReduce Shuffle):

-

在MapReduce中,Shuffle是指将Map阶段的输出结果按照键进行重新分区,并将相同键的值传递给Reduce阶段进行进一步的处理。

-

MR Shuffle包括三个主要步骤:分区(Partitioning)、排序(Sorting)和归并(Merging)。

-

分区:将Map任务的输出结果根据键的哈希值分发到不同的Reduce任务上。

-

排序:在每个Reduce任务接收到中间键值对之前,对中间键值对进行排序,以便相同键的值能够被归并在一起。

-

归并:将排序后的中间键值对发送给对应的Reduce任务,以便进行进一步的处理。

2. Spark Shuffle:

-

在Spark中,Shuffle是指将数据重新分区并传输到不同的节点上,以支持Spark的转换和操作。

-

Spark Shuffle的具体实现方式取决于使用的操作(如groupByKey、reduceByKey、join等)和数据分区策略。

-

Spark Shuffle的过程包括三个主要步骤:Map阶段、Shuffle阶段和Reduce阶段。

-

Map阶段:执行转换操作,生成键值对。

-

Shuffle阶段:将生成的键值对重新分区,并将相同键的值传输到同一个节点上。

-

Reduce阶段:对相同键的值进行聚合、合并或其他操作,生成最终的结果。

-

Spark Shuffle相对于MR Shuffle的优势在于:

- Spark Shuffle支持更多的转换操作和高级API,提供更灵活的数据处理能力。

- Spark Shuffle采用了更高效的内存和磁盘存储结构,以提高性能和效率。

- Spark Shuffle支持更细粒度的数据分区和动态调整,以适应不同的数据和计算场景。

总的来说,MR Shuffle和Spark Shuffle都是用于分布式计算框架中的数据重分区和数据传输过程,用于支持大规模数据处理和计算操作。它们的具体实现方式和性能特点有所不同,根据具体的应用需求和场景选择合适的框架和Shuffle策略。

09、namenode HA,脑裂,Yarn的调度机制了解吗,简单说一下是实现原理?

NameNode HA(高可用)、脑裂(Split-Brain)、YARN的调度机制。

1. NameNode HA(高可用):

-

在Hadoop分布式文件系统(HDFS)中,NameNode是主节点,负责管理文件系统的命名空间和元数据。

-

NameNode HA旨在提供对NameNode的高可用性,以防止单点故障导致的系统不可用。

-

NameNode HA通过将两个或多个NameNode节点配置为活动-备用模式,实现主备切换和故障恢复。

2. 脑裂(Split-Brain):

-

脑裂是指在分布式系统中,由于网络故障或通信问题导致节点之间失去联系,从而导致系统分裂成多个独立的子系统。

-

脑裂可能导致数据不一致和冲突,破坏系统的一致性和可靠性。

-

为了避免脑裂,分布式系统通常会采用心跳机制、选举算法和分布式锁等技术来确保节点之间的通信和协调。

3. YARN的调度机制:

-

YARN(Yet Another Resource Negotiator)是Hadoop的资源管理系统,用于分配和管理集群中的计算资源。

-

YARN的调度机制负责将集群中的资源分配给不同的应用程序和任务。

-

YARN的调度器包括容量调度器(Capacity Scheduler)和公平调度器(Fair Scheduler),它们根据不同的调度策略和配置,将资源分配给应用程序和任务。

-

容量调度器根据预先配置的资源容量比例进行资源分配,而公平调度器则尽量保持各个应用程序之间的资源公平共享。

以上是对NameNode HA、脑裂和YARN调度机制的简要介绍。如需更详细的信息,请提供更具体的问题或指明需要深入了解的方面。

10、Hive的内部表和外部表区别、数仓建模模型、数仓分层、雪花模型和星型模型?

Hive的内部表和外部表区别、数仓建模模型、数仓分层、雪花模型和星型模型。

1. Hive的内部表和外部表区别:

-

内部表(Internal Table)是Hive默认创建的表,其数据存储在Hive管理的文件系统中(如HDFS),Hive对其进行数据的管理和维护。

-

外部表(External Table)是指Hive中的表,其数据存储在外部文件系统中,Hive只对其进行元数据的管理,不对数据进行维护。外部表可以与已有的数据进行关联,也可以将数据导入到外部表中。

2. 数仓建模模型:

数仓建模模型是一种用于构建数据仓库的设计模式,常见的模型有维度建模和规范化建模。

-

维度建模(Dimensional Modeling):以事实表和维度表为核心,通过星型模型或雪花模型来组织数据,适用于OLAP(联机分析处理)场景,具有较好的查询性能和易理解性。

-

规范化建模(Normalized Modeling):将数据按照规范化的方式存储,通过多个关联表来表示数据之间的关系,适用于OLTP(联机事务处理)场景,具有较好的数据一致性和更新性能。

3. 数仓分层:

数仓分层是将数据仓库按照不同的层次进行划分和管理,常见的分层包括原始数据层、清洗转换层、集市层和报表层。

-

原始数据层:存储原始的、未经处理的数据。

-

清洗转换层:对原始数据进行清洗、转换和整合,生成可用于分析的数据。

-

集市层:对清洗转换后的数据进行进一步整合和加工,构建面向特定业务需求的数据集市。

-

报表层:为用户提供直接查询和报表展示的数据。

4. 雪花模型和星型模型:

-

雪花模型(Snowflake Schema)是一种维度建模模式,将维度表进一步规范化,通过创建更多的表和关联来表示维度之间的层次关系,以减少数据冗余。

-

星型模型(Star Schema)是一种维度建模模式,将事实表与多个维度表通过主键-外键关联,形成一个星型结构,简化了数据的查询和分析。

以上是对Hive的内部表和外部表区别、数仓建模模型、数仓分层、雪花模型和星型模型的简要介绍。如需更详细的信息,请提供更具体的问题或指明需要深入了解的方面。

11、了解ClickHouse吗?它与Kylin的区别?

是的,我了解ClickHouse。ClickHouse是一个开源的列式数据库管理系统,专为快速分析和处理大规模数据而设计。它具有以下特点:

1. 高性能:ClickHouse通过采用列式存储和向量化查询等技术,可以在大规模数据集上实现快速的查询和分析,具有出色的性能。

2. 可扩展性:ClickHouse支持水平扩展,可以通过添加更多的节点来处理更大规模的数据和查询负载。

3. 实时查询:ClickHouse支持实时查询,可以在数据不断写入的同时进行查询操作,适用于需要快速响应的实时分析场景。

4. SQL兼容性:ClickHouse支持标准的SQL查询语言,使得用户可以使用熟悉的SQL语法进行数据查询和分析。

与Kylin相比,ClickHouse的一些区别如下:

1. 存储模型:Kylin是基于Cube和OLAP的多维存储模型,而ClickHouse是基于列式存储的关系型数据库。

2. 架构设计:Kylin使用Hadoop生态系统(如HDFS、HBase)作为底层存储和计算平台,而ClickHouse是一个独立的列式数据库管理系统。

3. 数据建模:Kylin使用多维建模和Cube定义来进行数据建模和聚合,而ClickHouse使用标准的关系型数据建模。

4. 生态系统:Kylin在Hadoop生态系统中具有更多的集成和支持,可以与Hive、Spark等组件无缝集成。而ClickHouse则更专注于高性能的列式存储和分析。

选择使用ClickHouse还是Kylin取决于具体的需求和应用场景。如果需要实时查询和高性能的列式存储,ClickHouse是一个不错的选择。而如果需要多维建模和OLAP分析,以及与Hadoop生态系统的深度集成,Kylin可能更适合。

三面:

01、用伪代码实现一个简单的LRU算法?

当然,下面是一个简单的LRU(最近最少使用)算法的伪代码实现:

class LRUCache:

def __init__(self, capacity):

self.capacity = capacity

self.cache = {} # 用于存储缓存数据

self.order = [] # 用于记录数据访问顺序

def get(self, key):

if key in self.cache:

self.order.remove(key) # 将访问的数据从原有位置移除

self.order.append(key) # 将访问的数据添加到末尾,表示最近使用

return self.cache[key]

else:

return -1

def put(self, key, value):

if key in self.cache:

self.order.remove(key) # 如果数据已存在,先将其移除

elif len(self.cache) >= self.capacity:

# 如果缓存已满,移除最久未使用的数据(即列表头部的数据)

oldest_key = self.order.pop(0)

del self.cache[oldest_key]

self.cache[key] = value

self.order.append(key) # 将新数据添加到末尾,表示最近使用

上述代码中,LRUCache类实现了LRU缓存的基本功能。缓存容量由capacity参数指定,cache字典用于存储缓存数据,order列表用于记录数据的访问顺序。get方法用于获取缓存数据,如果数据存在则将其移动到列表末尾表示最近使用;put方法用于插入缓存数据,如果缓存已满则移除最久未使用的数据,并将新数据添加到列表末尾。

请注意,以上代码仅为简单的伪代码实现,具体的实际应用中可能需要根据不同语言和环境进行适当调整。

02、链表倒数第K个数。(讲思路)

链表倒数第K个数的问题可以使用双指针来解决。下面是解决该问题的思路:

-

定义两个指针,一个快指针和一个慢指针,并将它们都指向链表的头节点。

-

快指针先向前移动K个位置,使得快指针与慢指针之间相隔K个节点。

-

接下来,同时移动快指针和慢指针,直到快指针到达链表的末尾。这样,慢指针所指向的节点就是倒数第K个节点。

-

返回慢指针所指向的节点的值即可。

这种方法的关键在于通过快慢指针的相对移动来确定倒数第K个节点的位置。快指针先移动K个位置,然后快慢指针同时移动,当快指针到达链表末尾时,慢指针所指向的节点就是倒数第K个节点。

需要注意的是,在实际实现中,需要考虑链表为空或者链表长度小于K的情况,并进行相应的处理。另外,如果要返回倒数第K个节点的值,可以在慢指针移动时记录每个节点的值,最后返回慢指针所指向的节点的值。

03、一堆螺丝和螺母用最短时间匹配。(Java代码实现)

下面是用Java实现一堆螺丝和螺母匹配的代码:

import java.util.Arrays;

public class ScrewAndNutMatching {

public static void matchScrewsAndNuts(int[] screws, int[] nuts) {

if (screws == null || nuts == null || screws.length != nuts.length) {

return;

}

quickSort(screws, nuts, 0, screws.length - 1);

}

private static void quickSort(int[] screws, int[] nuts, int low, int high) {

if (low < high) {

int pivotIndex = partition(screws, nuts, low, high);

quickSort(screws, nuts, low, pivotIndex - 1);

quickSort(screws, nuts, pivotIndex + 1, high);

}

}

private static int partition(int[] screws, int[] nuts, int low, int high) {

int pivot = screws[high];

int i = low - 1;

for (int j = low; j < high; j++) {

if (screws[j] < pivot) {

i++;

swap(screws, i, j);

} else if (screws[j] == pivot) {

swap(screws, j, high);

j--;

}

}

swap(screws, i + 1, high);

int pivotIndex = i + 1;

i = low - 1;

for (int j = low; j < high; j++) {

if (nuts[j] < pivot) {

i++;

swap(nuts, i, j);

} else if (nuts[j] == pivot) {

swap(nuts, j, high);

j--;

}

}

swap(nuts, i + 1, high);

return pivotIndex;

}

private static void swap(int[] arr, int i, int j) {

int temp = arr[i];

arr[i] = arr[j];

arr[j] = temp;

}

public static void main(String[] args) {

int[] screws = {4, 1, 5, 2, 3};

int[] nuts = {1, 3, 2, 4, 5};

matchScrewsAndNuts(screws, nuts);

System.out.println("Matched screws and nuts:");

System.out.println(Arrays.toString(screws));

System.out.println(Arrays.toString(nuts));

}

}

上述代码使用快速排序的思想,将螺丝和螺母分别进行排序,以实现匹配。在排序过程中,根据螺丝和螺母的大小关系进行元素交换,最终完成匹配。在main方法中,我们给出了一个示例,并输出了匹配结果。请注意,示例中的螺丝和螺母数组长度相同,且数组元素不重复。

04、求每天浏览页面的新用户。(Hive QL实现)

要求每天浏览页面的新用户,可以使用Hive QL实现以下查询:

SELECT date, COUNT(DISTINCT user_id) AS new_users

FROM pageviews

WHERE date >= '2022-01-01' AND date <= '2022-01-31'

GROUP BY date;

上述查询假设有一个名为 pageviews 的表,包含 date 和 user_id 两个字段,记录了用户的页面浏览情况。查询结果将按日期分组,并计算每天浏览页面的新用户数量。

请根据实际情况修改查询中的表名、字段名以及日期范围。

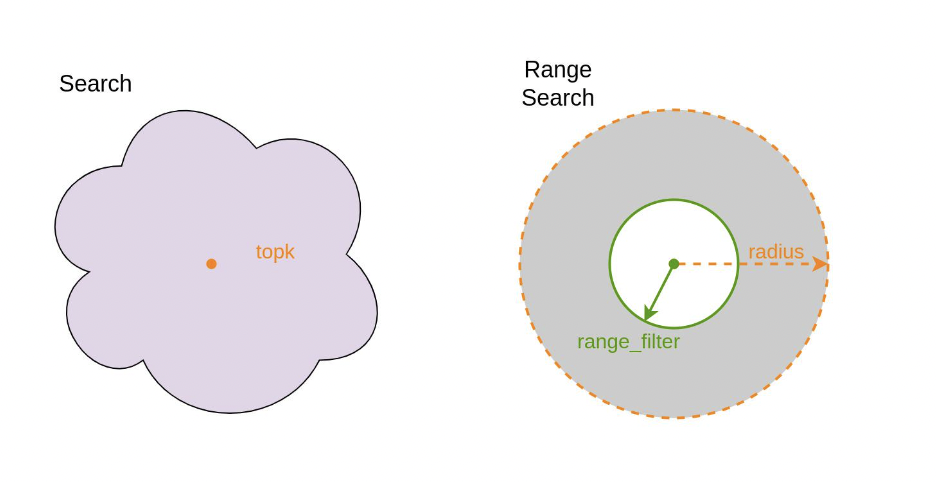

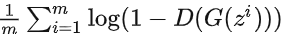

05、求抖音小视频每日点击量最高的10个。(Hash + 最小堆)

要求求解抖音小视频每日点击量最高的10个,可以使用Hash和最小堆的数据结构来实现。

具体步骤如下:

-

使用Hash表统计每个小视频的每日点击量,将视频ID作为键,点击量作为值,更新Hash表中的点击量。

-

使用最小堆来维护当前点击量最高的10个小视频。最小堆中的元素按点击量大小进行排序,堆顶元素是当前点击量最小的视频。

-

遍历Hash表中的每个小视频,将点击量与最小堆的堆顶元素进行比较:

- 如果点击量大于堆顶元素,则将堆顶元素替换为当前小视频,并进行最小堆的调整,保持堆的性质。

- 如果点击量小于等于堆顶元素,则继续遍历下一个小视频。

-

遍历完所有小视频后,最小堆中的10个元素即为每日点击量最高的10个小视频。

需要注意的是,为了实现每日的统计,需要在每日结束时进行数据清零和重新统计。

这种基于Hash和最小堆的算法可以高效地找到每日点击量最高的10个小视频,时间复杂度为O(nlogk),其中n为小视频的数量,k为最小堆的大小(这里为10)。