目录

- 第5章 Kafka监控(Kafka Eagle)

- 5.2 修改kafka启动命令

- 5.2 上传压缩包

- 5.3 解压到本地

- 5.4 进入刚才解压的目录

- 5.5 将kafka-eagle-web-1.3.7-bin.tar.gz解压至/opt/module

- 5.6 修改名称

- 5.7 给启动文件执行权限

- 5.8 修改配置文件

- 5.9 添加环境变量

- 5.10 启动

- 5.11 登录页面查看监控数据

- 第6章 Kafka面试题

- 6.1 面试问题

第5章 Kafka监控(Kafka Eagle)

5.2 修改kafka启动命令

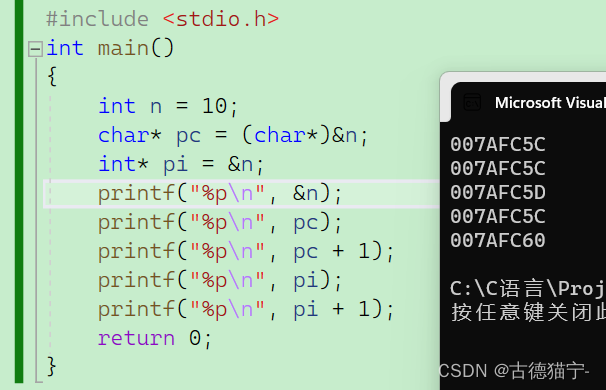

修改kafka-server-start.sh命令中

if [ "x$KAFKA_HEAP_OPTS" = "x" ]; then

export KAFKA_HEAP_OPTS="-Xmx1G -Xms1G"

fi

为

if [ "x$KAFKA_HEAP_OPTS" = "x" ]; then

export KAFKA_HEAP_OPTS="-server -Xms2G -Xmx2G -XX:PermSize=128m -XX:+UseG1GC -XX:MaxGCPauseMillis=200 -XX:ParallelGCThreads=8 -XX:ConcGCThreads=5 -XX:InitiatingHeapOccupancyPercent=70"

export JMX_PORT="9999"

#export KAFKA_HEAP_OPTS="-Xmx1G -Xms1G"

fi

注意:修改之后在启动Kafka之前要分发之其他节点

5.2 上传压缩包

上传压缩包kafka-eagle-bin-1.3.7.tar.gz到集群/opt/software目录

5.3 解压到本地

[atguigu@hadoop102 software]$ tar -zxvf kafka-eagle-bin-1.3.7.tar.gz

5.4 进入刚才解压的目录

[atguigu@hadoop102 kafka-eagle-bin-1.3.7]$ ll

总用量 82932

-rw-rw-r--. 1 atguigu atguigu 84920710 8月 13 23:00 kafka-eagle-web-1.3.7-bin.tar.gz

5.5 将kafka-eagle-web-1.3.7-bin.tar.gz解压至/opt/module

[atguigu@hadoop102 kafka-eagle-bin-1.3.7]$ tar -zxvf kafka-eagle-web-1.3.7-bin.tar.gz -C /opt/module/

5.6 修改名称

[atguigu@hadoop102 module]$ mv kafka-eagle-web-1.3.7/ eagle

5.7 给启动文件执行权限

[atguigu@hadoop102 eagle]$ cd bin/

[atguigu@hadoop102 bin]$ ll

总用量 12

-rw-r--r--. 1 atguigu atguigu 1848 8月 22 2017 ke.bat

-rw-r--r--. 1 atguigu atguigu 7190 7月 30 20:12 ke.sh

[atguigu@hadoop102 bin]$ chmod 777 ke.sh

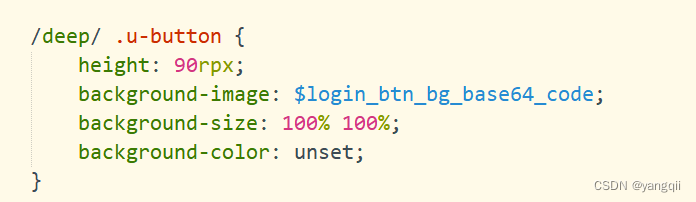

5.8 修改配置文件

######################################

# multi zookeeper&kafka cluster list

######################################

kafka.eagle.zk.cluster.alias=cluster1

cluster1.zk.list=hadoop102:2181,hadoop103:2181,hadoop104:2181

######################################

# kafka offset storage

######################################

cluster1.kafka.eagle.offset.storage=kafka

######################################

# enable kafka metrics

######################################

kafka.eagle.metrics.charts=true

kafka.eagle.sql.fix.error=false

######################################

# kafka jdbc driver address

######################################

kafka.eagle.driver=com.mysql.jdbc.Driver

kafka.eagle.url=jdbc:mysql://hadoop102:3306/ke?useUnicode=true&characterEncoding=UTF-8&zeroDateTimeBehavior=convertToNull

kafka.eagle.username=root

5.9 添加环境变量

export KE_HOME=/opt/module/eagle

export PATH=$PATH:$KE_HOME/bin

注意:source /etc/profile

5.10 启动

[atguigu@hadoop102 eagle]$ bin/ke.sh start

... ...

... ...

*******************************************************************

* Kafka Eagle Service has started success.

* Welcome, Now you can visit 'http://192.168.9.102:8048/ke'

* Account:admin ,Password:123456

*******************************************************************

* <Usage> ke.sh [start|status|stop|restart|stats] </Usage>

* <Usage> https://www.kafka-eagle.org/ </Usage>

*******************************************************************

[atguigu@hadoop102 eagle]$

注意:启动之前需要先启动ZK以及KAFKA

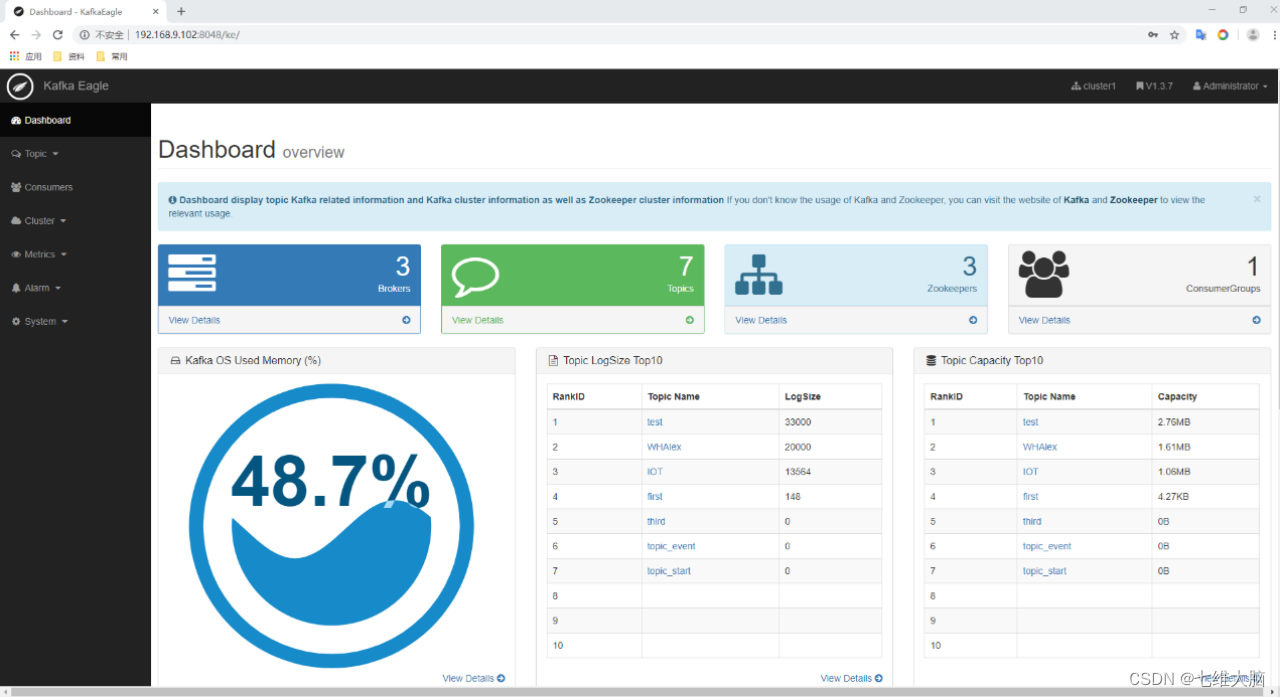

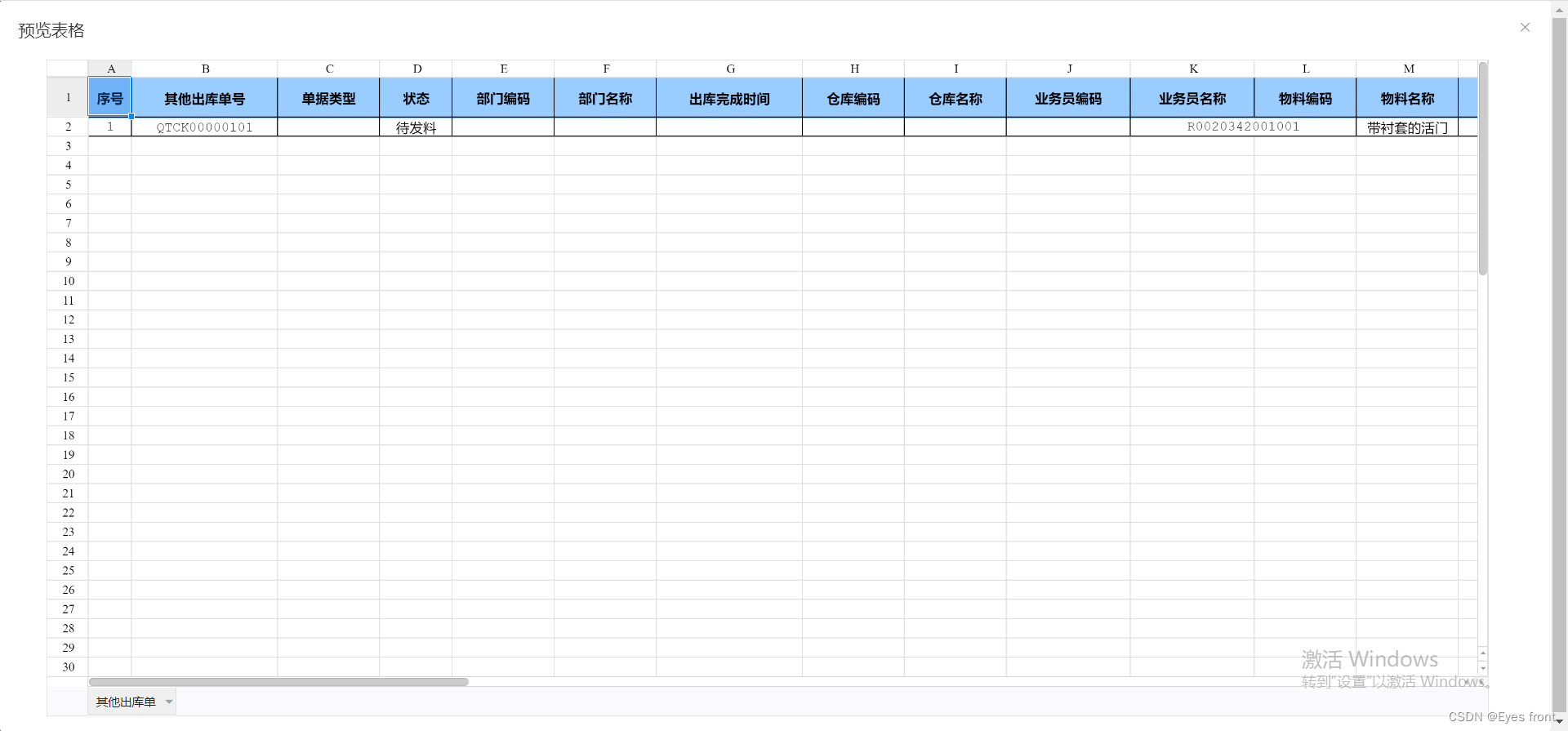

5.11 登录页面查看监控数据

http://192.168.9.102:8048/ke

第6章 Kafka面试题

6.1 面试问题

-

Kafka中的ISR、AR又代表什么?

ISR:与leader保持同步的follower集合

AR:分区的所有副本 -

Kafka中的HW、LEO等分别代表什么?

LEO:没个副本的最后条消息的offset

HW:一个分区中所有副本最小的offset -

Kafka中是怎么体现消息顺序性的?

每个分区内,每条消息都有一个offset,故只能保证分区内有序。

-

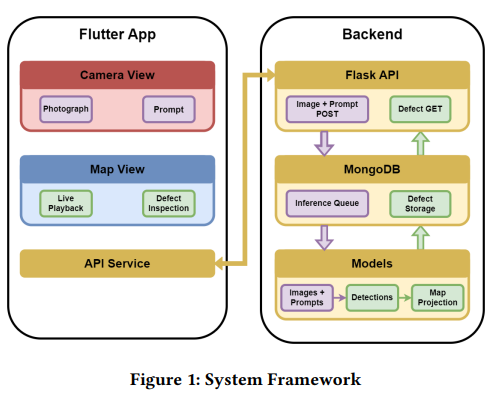

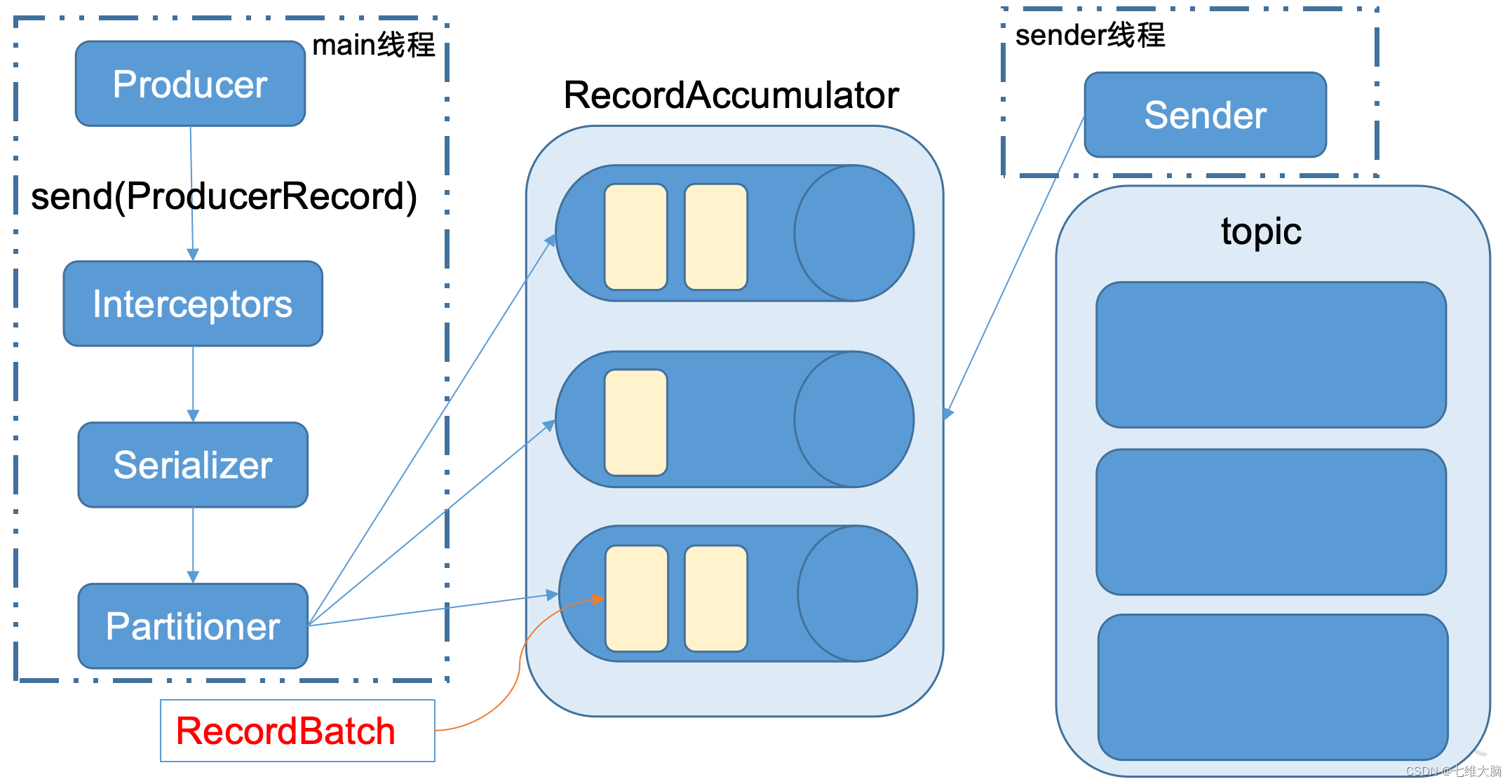

Kafka中的分区器、序列化器、拦截器是否了解?它们之间的处理顺序是什么?

拦截器 -> 序列化器 -> 分区器

-

Kafka生产者客户端的整体结构是什么样子的?使用了几个线程来处理?分别是什么?

KafkaProducer 发送消息流程

-

“消费组中的消费者个数如果超过topic的分区,那么就会有消费者消费不到数据”这句话是否正确?

正确 -

消费者提交消费位移时提交的是当前消费到的最新消息的offset还是offset+1?

offset+1 -

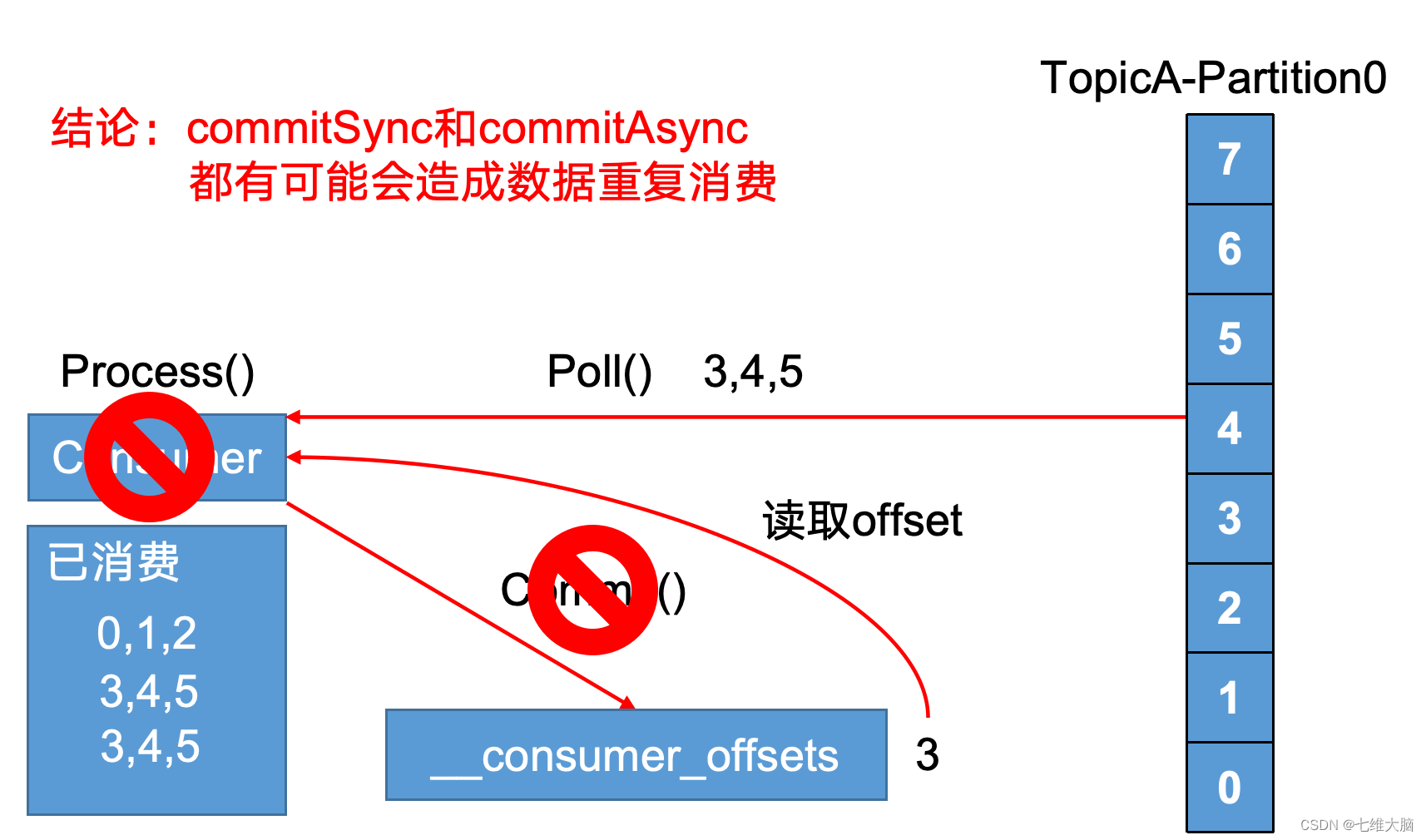

有哪些情形会造成重复消费?

-

那些情景会造成消息漏消费?

先提交offset,后消费,有可能造成数据的重复 -

当你使用kafka-topics.sh创建(删除)了一个topic之后,Kafka背后会执行什么逻辑?

- 会在zookeeper中的/brokers/topics节点下创建一个新的topic节点,如:/brokers/topics/first

- 触发Controller的监听程序

- kafka Controller 负责topic的创建工作,并更新metadata cache

-

topic的分区数可不可以增加?如果可以怎么增加?如果不可以,那又是为什么?

可以增加

bin/kafka-topics.sh --zookeeper localhost:2181/kafka --alter --topic topic-config --partitions 3 -

topic的分区数可不可以减少?如果可以怎么减少?如果不可以,那又是为什么?

不可以减少,被删除的分区数据难以处理。 -

Kafka有内部的topic吗?如果有是什么?有什么所用?

__consumer_offsets,保存消费者offset -

Kafka分区分配的概念?

一个topic多个分区,一个消费者组多个消费者,故需要将分区分配个消费者(roundrobin、range) -

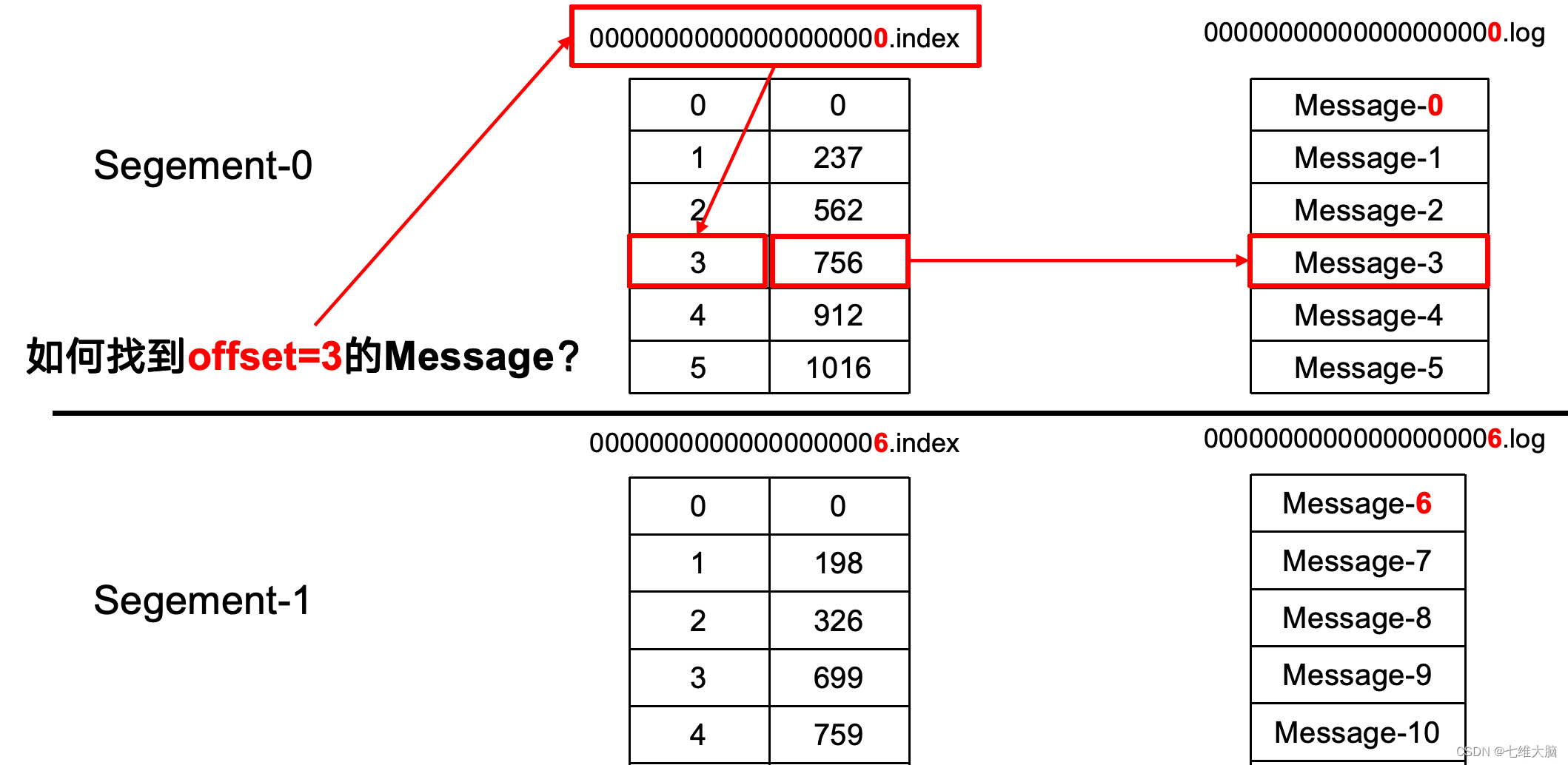

简述Kafka的日志目录结构?

每个分区对应一个文件夹,文件夹的命名为topic-0,topic-1,内部为.log和.index文件 -

如果我指定了一个offset,Kafka Controller怎么查找到对应的消息?

-

聊一聊Kafka Controller的作用?

负责管理集群broker的上下线,所有topic的分区副本分配和leader选举等工作。 -

Kafka中有那些地方需要选举?这些地方的选举策略又有哪些?

partition leader(ISR),controller(先到先得) -

失效副本是指什么?有那些应对措施?

不能及时与leader同步,暂时踢出ISR,等其追上leader之后再重新加入 -

Kafka的那些设计让它有如此高的性能?

分区,顺序写磁盘,0-copy

![23111710[含文档+PPT+源码等]计算机毕业设计基于SpringBoot的体育馆场地预约赛事管理系统的设计](https://img-blog.csdnimg.cn/img_convert/59ad26cfb649e5ecc63a232905d9b585.png)