文章目录

- 前言、华为云Stack交付综述

- 华为云Stack标准组网

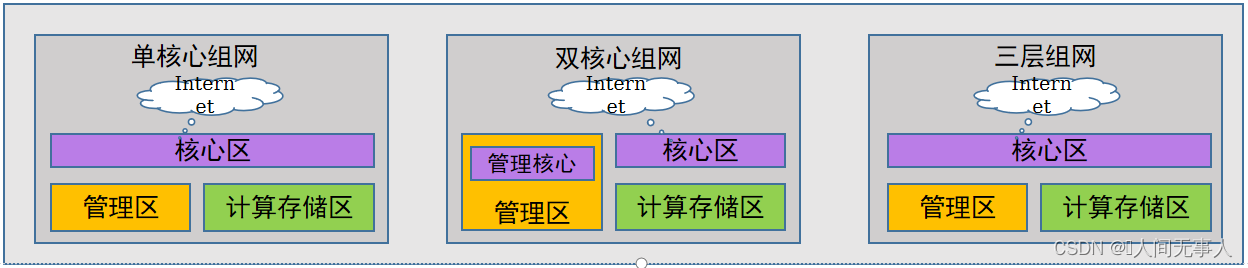

- 标准组网架构

- HCS标准组网架构

- 单核心VS双核心组网

- 二层组网VS三层组网

- 单核心和双核心组网

- 单核心组网设计和配置

- 单核心组网 - 计算节点2网口

- 单核心组网 - 计算节点4网口

- 单核心组网 - 计算节点6网口

- 单核心架构 - 多Region组网

- 双核心组网设计和配置

- 双核心组网 - 计算节点6网口

- 双核心组网 - 6网口多物理出口分区

- 双核心架构 - 多Region组网

- 三层组网

- 三层组网设计和配置

- 三层组网配置

- 三层组网 - 计算节点2网口

- 三层组网 - 计算节点4网口

- 三层组网 - 计算节点6网口

- 灾备组网和云联邦

- 灾备组网 - CSHA和管理面跨AZ高可用(单核心)

- 灾备组网 - CSHA和管理面跨AZ高可用(双核心)

- CSHA+CSDR和管理面两地三中心场景拓扑图(单核心)

- CSHA+CSDR和管理面两地三中心场景拓扑图(双核心)

- 云联邦组网说明

- 云联邦云间网络选项建议

- 云联邦标准组网 - 仅Internet连接

- 云联邦标准组网 - 仅专线连接

- 华为云Stack标准化配置、缩略语

前言、华为云Stack交付综述

看这篇文章

【hcie-cloud】【3】华为云Stack规划设计之华为云Stack交付综述【上】

华为云Stack标准组网

标准组网架构

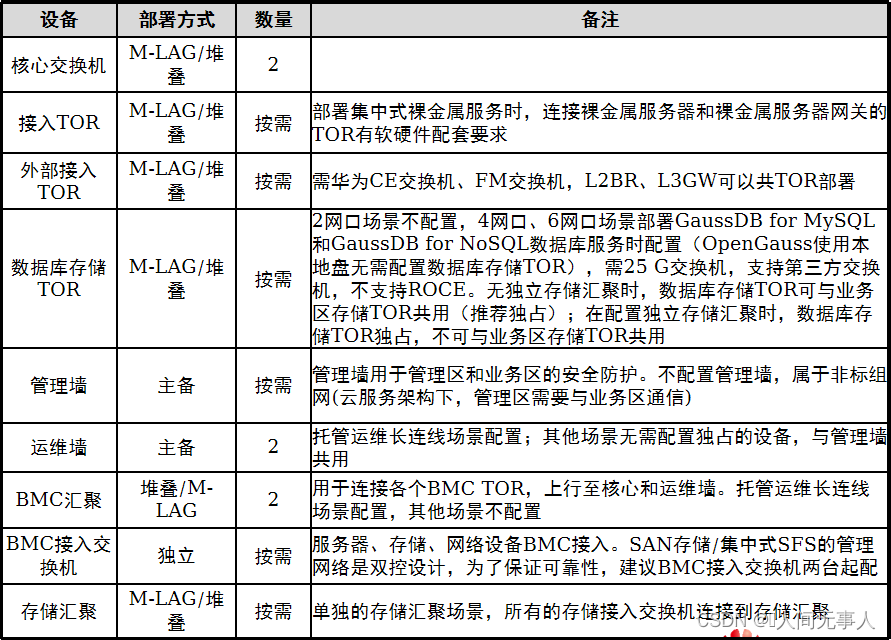

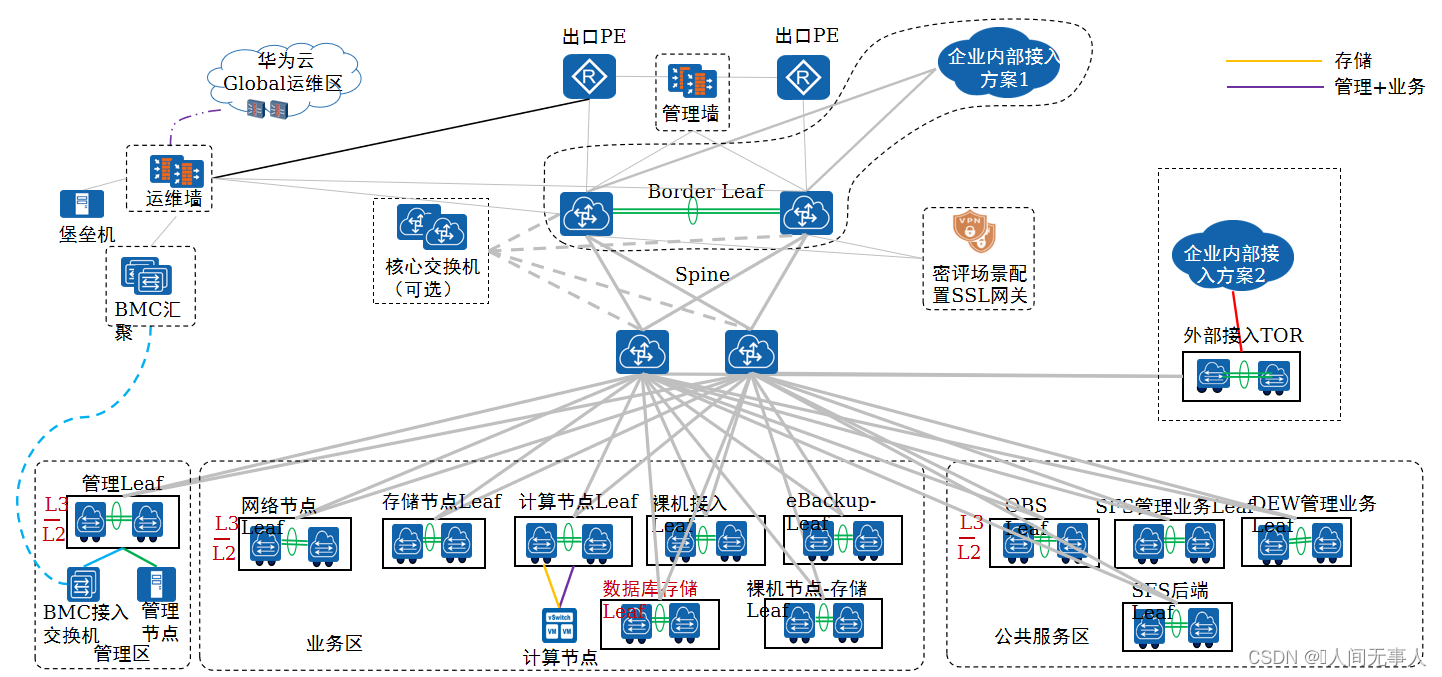

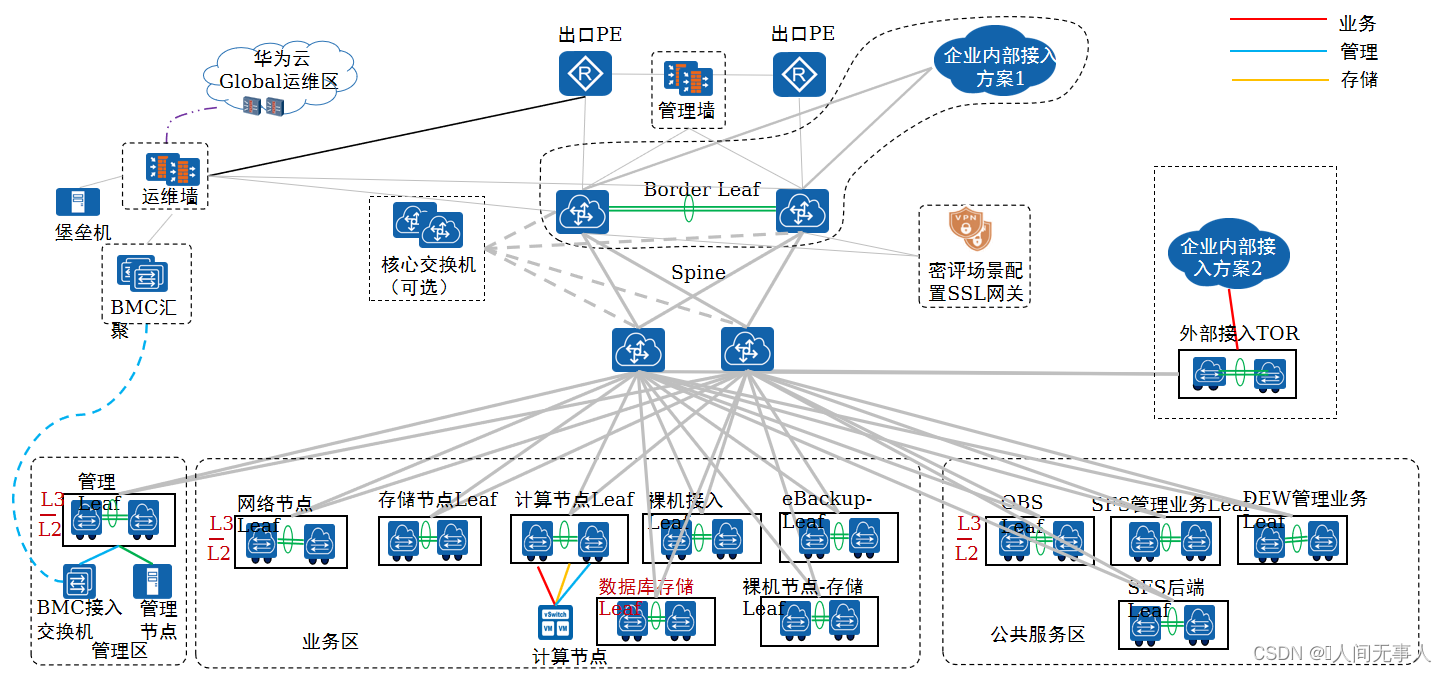

HCS标准组网架构

- 单核心组网

- 单核心组网场景下,计算节点支持2网口、4网口或者6网口

- 双核心组网

- 双核心组网场景下,计算节点支持6网口

- 三层组网

- 三层组网为单核心架构,计算节点在2网口时,不支持高阶服务,计算节点在4网口和6网口时,支持高阶服务

-

说明:

- TYPE-I方案交换机、路由器、管理墙支持第三方设备;集中式裸机网关/L2BR/L3GW需华为CE系列交换机或FM交换机,SFS后端TOR仅支持部分华为CE交换机、FM交换机或第三方厂商设备,设备选型原则请查阅《华为云Stack8.1.1配置手册》。分布式裸机网关对接入交换机的光模块兼容性适配请参考《华为云Stack配置手册》。

-

OBS TOR支持第三方交换机,MRS存算分离场景需为25G交换机,第三方交换机兼容性要求如下:

- 支持第三方交换机;

- 支持VLAN,eth-trunk端口聚合;

- 支持VRF配置,用于配置不同业务平面的隔离;

- 支持ECMP等价路由,并且支持NQA或者类似的技术,配合ECMP做路由状态监测;ECMP下一跳规格需支持到32个下一跳;

- 支持Qos,可按照VLAN,DSCP,端口等做流量整形,报文优先级排序;

- 支持动态LACP,指定LACP模式下Eth-Trunk接口接收报文的超时时间是3秒;

- OBS TOR性能要求:必须满足转发时延<4us且buffer>=20MB,支持10G组网和25G组网。MRS存算分离业务时推荐25G交换机并满足转发时延<2us且buffer>=32MB要求;若第三方交换机的时延<2us且buffer>=32MB不满足或采用10G组网,则MRS存算分离业务时OBS的性能(时延和带宽)弱于25GE组网。

-

单核心场景的两对接入交换机为管理区TOR和业务区TOR。支持管理区TOR和业务区TOR合部署,此时仅需一对接入TOR,但此组网时扩容受限,会造成管理节点扩容时跨TOR部署导致在管理节点间二层流量跨TOR转发,此组网部署时没有明显区分管理区、业务区的物理分区,易导致客户运维复杂增加运维成本。管理区TOR和业务区TOR合部署时,计算节点规格小于100台。

-

以上选型仅为部分推荐使用的设备型号,如需更多设备选型,请查阅华为云Stack硬件兼容性列表;

-

本章节内所有组网图为示意图,管理和计算配置FusionStorage存储为例,具体连线规则(如接口带宽、接口数量等),参见集成设计指导书网络分区设计。

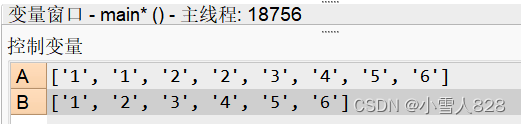

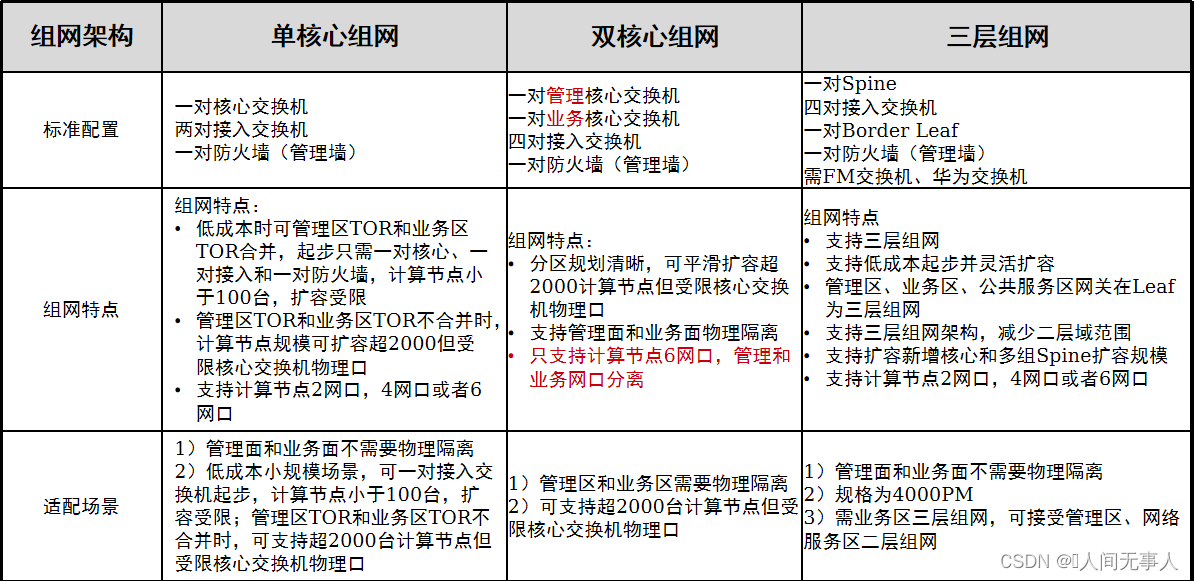

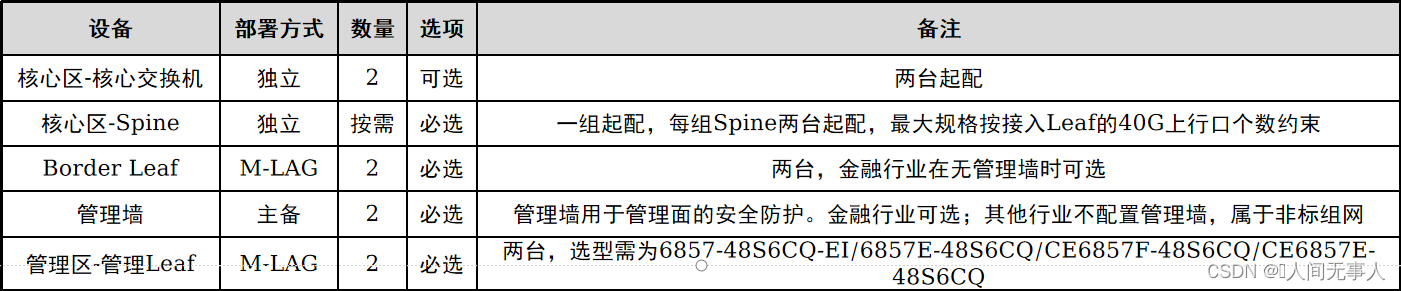

单核心VS双核心组网

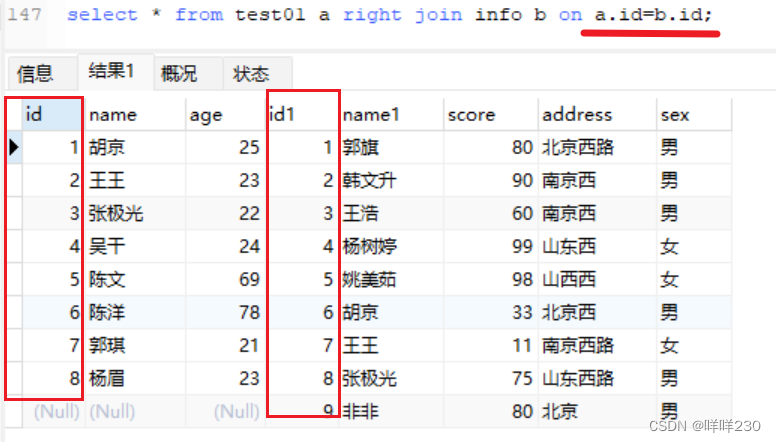

如下图

二层组网VS三层组网

- 三层组网:支持单Region多出口,支持CSDR,不支持Region内的灾备(管理面高可用、CSHA)。2网口不支持高阶服务,4网口、6网口支持高阶服务。

- 核心交换机是作为后续扩容时,多个spine接在同一对核心上

单核心和双核心组网

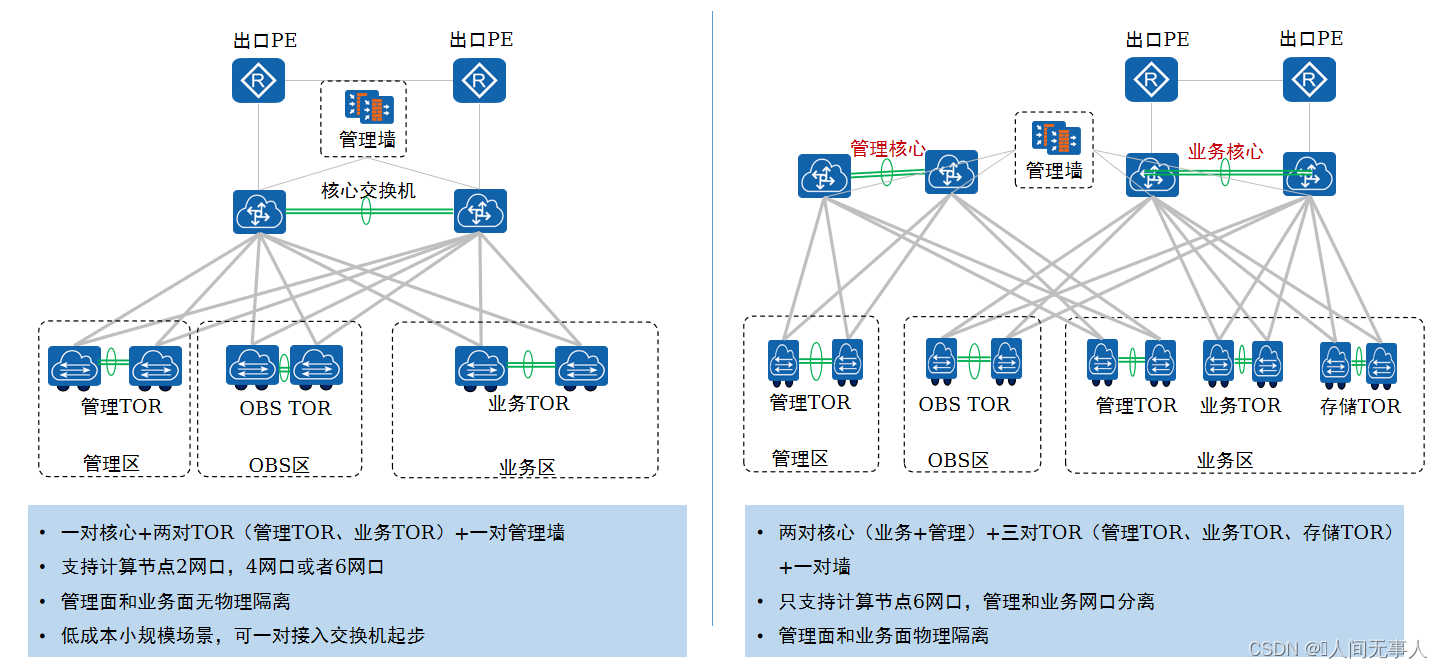

单核心组网设计和配置

- 设计规格:

- 规模可超2000PM但受限核心交换机物理口

- 方案优点:

- 简化网络架构,提升成本竞争力,标准配置需一对核心、两对TOR、一对防火墙(管理墙)

支持计算节点2网口,4网口或者6网口(同一Region内网口的选择需保持一致)

- 简化网络架构,提升成本竞争力,标准配置需一对核心、两对TOR、一对防火墙(管理墙)

- FM交换机、CE系列交换机网络产品线约束仅能M-LAG组网交付。

- 第三方交换机选型要求参见《华为云Stack配置手册》-工程组网章节。

- 核心交换机(CloudEngine 8850-64CQ-EI)64个口,管理业务同核心,最多接32个TOR,每个TOR48口,32*48=1536台服务器

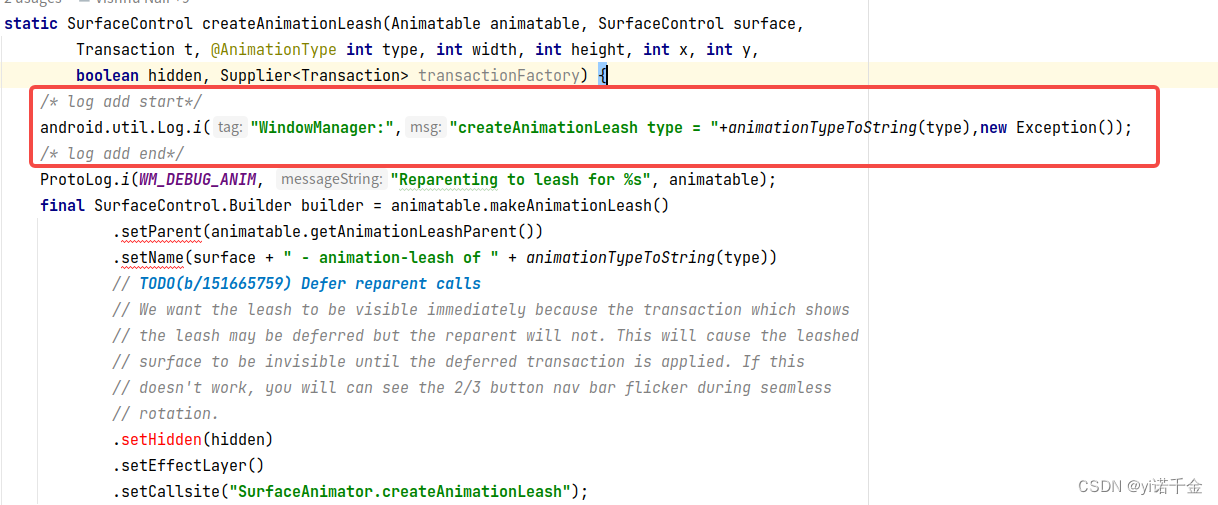

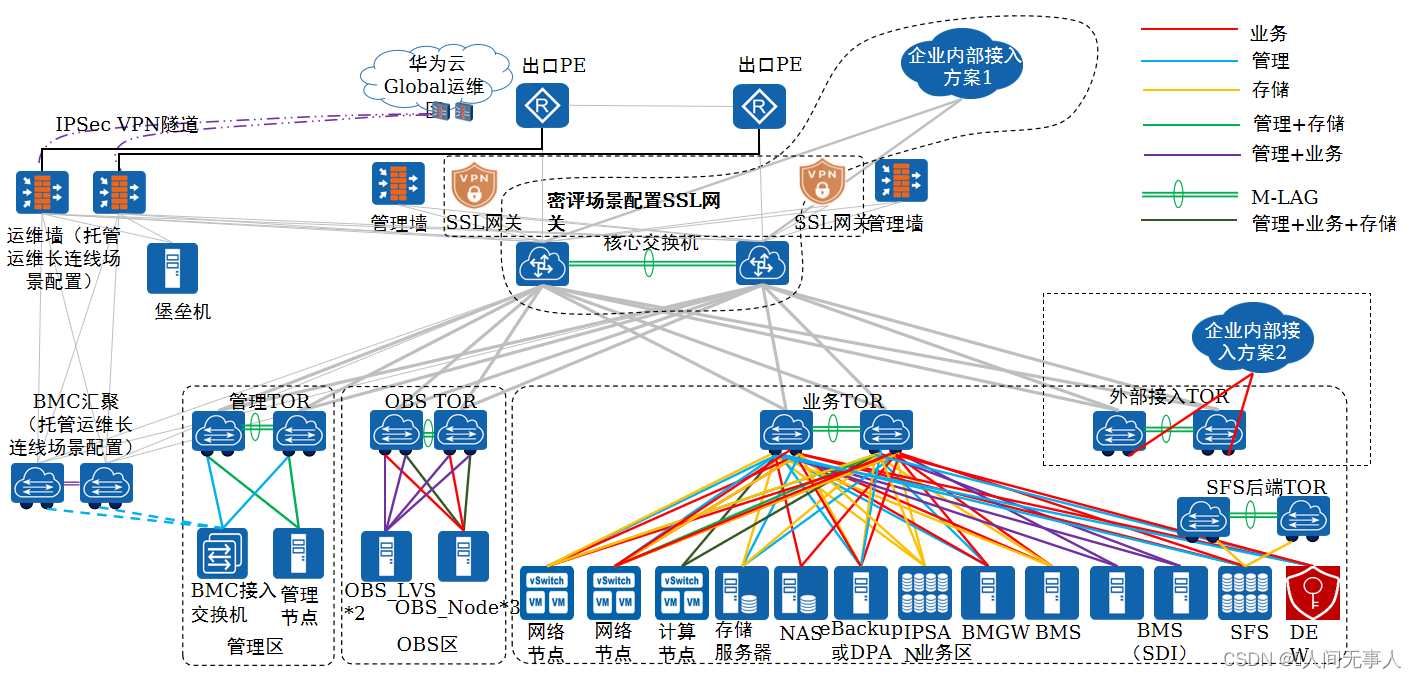

单核心组网 - 计算节点2网口

-

组网整体说明:

- 1)单核心组网规模可超2000PM但受限核心交换机物理口;单对TOR要求不超过88个端口;业务TOR下接入网络节点和计算节点,通过外部接入TOR支持企业内部网络二层接入云内(L2BR)、硬件L3GW专线,外部接入TOR与其他TOR不支持合布。

- 2)基础IaaS管理平面的网关在核心。

- 3)核心交换机可以使用CE8850-64CQ或者CE12800。交换机ARP规格主要依赖于计算节点规格,100PM场景下ARP规格需支持2K,2000PM场景下ARP需支持20K规格,2000PM场景下ARP需支持30K规格。

- 4)管理墙可以使用第三方的防火墙,旁挂核心交换机。

- 5)企业内部三层接入:软件方案只支持企业内部接入方案1,交换机支持异构,在核心交换机配置静态路由下行回程到网络节点;上行到企业内部接入网的路由可配置为静态路由,也可在核心交换机与企业内部接入交换机配置动态路由。硬件L3GW方案支持采用企业内部接入方案2,方案2中的外部接入TOR需为华为CE系列交换机、FM交换机。

- 6)外部接入TOR支持L2BR和L3GW,需为华为CE系列交换机、FM交换机,支持L2BR和L3GW共TOR部署(企业内部接入方案2),但不与其他TOR共用,外部接入TOR设备类型请查阅兼容性网站。L2BR接入方式:支持刀片服务器直接L2BR接入到外部接入TOR,但刀片服务器需配置交换板,直通板场景需配置客户TOR接入到外部接入TOR;不支持非刀片服务器直接L2BR接入到外部接入TOR,需配置客户TOR接入到外部接入TOR。

- 7)基础型云专线只支持采用核心接入方式(企业内部接入方案1),增强型云专线只支持采用外部接入TOR方式(企业内部接入方案2)。支持组播需配置外部接入TOR,FM系列仅支持6857-48S6CQ-EI、6865-48S8CQ-SI;CE系列仅支持CE6857F-48S6CQ、CE6865E-48S8CQ、CE6857、CE6865;三层组播在外部网络中由客户物理设备提供,由客户组播设备与外部接入TOR互联。

- 8)分布式SFS节点分1个管理口(GE),两个前端业务口和两个后端存储口,分别接入到前端TOR和后端TOR,前端TOR可与业务区TOR复用,后端TOR需华为交换机由SFS独占(请查看SFS兼容性列表)。管理口接入到业务区管理TOR,前端业务口接入到业务区业务TOR,后端存储口接入到SFS独立配置的后端TOR;业务区管理TOR和业务TOR共部署时,管理口和前端业务口接入到业务区管理/业务TOR。管理TOR为光口交换机时需配置光转电模块接入SFS管理口。集中式SFS节点2个管理口(为GE口,即为BMC口)和8个业务口(支持不同节点业务口三层互通)。管理口连接BMC交换机,与SAN存储组网相同,BMC交换机需2台堆叠组网。二层组网场景,业务口连接计算节点业务TOR;三层组网场景,业务口连接计算节点Leaf(计算节点业务leaf)。

- 9)DEW部署在业务区,管理2网口和业务2网口,连接到业务区的管理TOR和业务TOR。

- 10)定期连线时在Global Region管理墙手动配置IPSec VPN隧道与公有云的VPN服务实例建立互通连接,并通过Global Region连接到其他各个Region。因此管理墙需满足与华为云进行VPN对接能力,见华为云VPN与第三方设备对接要求:https://support.huaweicloud.com/intl/zh-cn/vpn_faq/vpn_faq_0053.html。人机通道通过每个Region内的堡垒机(部署在管理节点的VM)与公有云VPN互通,通过堡垒机代理与Region内的基础IaaS管理网络(External_OM、DMZ_Service、BMC) 互通。

-

托管运维长连线场景:

- 1)运维墙和BMC汇聚仅在托管运维长连线场景配置,每个Region配置原则相同。独立Global区无需配置BMC汇聚,仅需一台BMC TOR,运维墙与BMC TOR互联。其他场景,支持运维墙与管理墙合并,此时无需BMC汇聚,与原有定期连线场景组网相同。

- 2)托管运维长连线场景配置BMC汇聚时,二层组网BMC汇聚与管理核心互联,三层组网BMC汇聚与管理Leaf互联。BMC平面网关在BMC汇聚,BMC接入交换机与BMC汇聚互联无需与管理TOR互联,BMC汇聚与运维墙直连。独立Global区在托管运维长连线场景无需配置BMC汇聚,仅一组BMC交换机,BMC平面网关在BMC TOR,运维墙与BMC交换机直连,BMC交换机与管理TOR直连。

- 3)二层组网场景运维墙与管理核心交换机互联,三层组网场景运维墙与Border Leaf互联,独立Global区场景运维墙与管理TOR互联。

- 4)长连线场景与定期连线场景兼容性能力一致,支持第三方交换机。

- 5)Global 运维墙到Region区运维墙之间通道通过IPSec VPN互通。

- 6)运维墙与PE互联通过Internet地址VPN隧道与远程运维中心TSC互通。

- 7)多物理出口分区组网场景,运维墙和BMC汇聚仅部署在同一个出口分区,部署在EIP的出口区,如政务场景部署在互联网分区。

- 8)大数据物理机集群不支持模式一,混合云+大数据物理机集群场景以及独立Global区+大数据物理机集群场景长连线组网与定期连线组网相同。

-

管理区:

- 1)主推:FusionStorage融合部署,兼容:IPSAN、FCSAN,管理存储采用SAN存储场景,管理节点需要配置独立存储网口:2*10GE网卡(IP SAN场景)或HBA卡(FC SAN场景,需配置FC交换机)。

- 2)管理TOR建议独立部署;管理TOR可以与业务TOR合部署,计算节点规格小于100台。

- 3)Openstack管理平面(External_OM)在如下几种场景需要跟BMC带外管理平面互通,组网中BMC接入交换机必须连接到管理接入或者打通BMC带外管理平面与Openstack管理平面。

- eSight运维场景:eSight通过External_OM平面跟带外管理互通实现设备的管理和运维。

- 裸金属服务场景:Openstack通过External_OM平面跟裸金属服务器的带外管理平面互通实现裸金属服务器的管理。

- 卷管理场景:Openstack通过External_OM平面跟OceanStor存储的带外管理平面互通实现卷创建删除等操作。

- SFS管理场景:SFS管理组件通过External_OM平面跟OceanStor 9000带外管理互通实现设备的管理和运维。

-

OBS区:

- 1)OBS TOR仅OBS独占,不与其他节点复用,支持第三方交换机,支持Bond4组网。支持MRS存算分离时(高阶服务,需为4网口、6网口)需25G组网,交换机需满足转发时延<2us且buffer>=32MB要求;其他场景支持10G组网,交换机需满足转发时延<4us且buffer>=20MB。融合部署时一组TOR起步;分离部署时LVS和Service OBS node节点接入OBS接入TOR,其他OBS node节点接入OBS存储TOR,二层组网场景OBS接入TOR和OBS存储TOR可合并,推荐OBS接入TOR和OBS存储TOR各自独占。OBS TOR不与其他TOR共用。OBS Node节点跨网卡Bond,其中2个网口为管理+业务+存储(管理面访问OBS),2个网口为业务(计算节点和Internet访问OBS)。OBS融合部署时,OBS node节点所有服务器都是两种类型网口4根连线分为2个bond;分离部署时部署Service的OBS node节点为两种类型网口4根连线分为2个bond,其他类型OBS node节点服务器仅需管理业务类型口2根连线1个管理bond无需业务类型网口。OBS LVS节点连线方式不区分融合部署和分离部署。

- 2)OBS TOR性能要求:必须满足转发时延<4us且buffer>=20MB,支持10G组网和25G组网。MRS存算分离业务时推荐25G交换机并满足转发时延<2us且buffer>=32MB要求;若交换机的时延<2us且buffer>=32MB不满足或采用10G组网,则MRS存算分离业务时OBS的性能(时延和带宽)弱于25GE组网。

- 3)OBS TOR在10G组网时标配为CE6881/CE6857,25G组网时标配为CE6863/CE6865。部署MRS存算分离业务时推荐25G组网,OBS TOR使用CE6863/CE6865;在已有OBS业务采用10G组网时新增MRS存算分离也支持,性能弱于25GE组网。10G组网时,每组交换机上行口为2440G;25G组网时,每组交换机上行口为24100G。

单核心组网 - 计算节点4网口

-

单核心组网中仅4网口和6网口场景支持高阶服务,2网口不支持高阶服务(原因在于基于系统容器的数据库服务不支持2网口组网)

-

服务VPC的高级服务在业务区VPC内部署管理VM,通过基础型云专线(Public VRF)实现管理区External_OM与服务VPC互通以及DMZ区与服务VPC ELB互通;服务VPC VM通过External_Relay_Network与DMZ区互通;

-

业务区:

- 1)业务TOR一对起配,网络节点在X86和鲲鹏场景下统一都为6网口(管理+业务+存储)部署方案;支持计算节点2网口(管理业务存储)、4网口(管理业务+存储)、6网口(管理+业务+存储)部署方案,不支持计算节点网口混合部署,即除网络节点外,计算节点的网口形态在单Region内需一致;CX5网卡场景,在2网口、4网口、6网口场景都支持用户态和内核态。

- 2)网络节点配置6个网口,2个管理,2个存储,2个业务(用户态OVS);计算节点仅部署计算VM。网络节点为独立主机组,计算节点为独立主机组,类型相同两者支持共AZ(即单AZ内同时存在网络节点主机组和计算节点主机组);网络节点与计算节点可共TOR部署(不能与外部接入TOR共部署),也可独立TOR部署。网络节点与计算VM是一套存储资源池。

- 3)如果有裸金属服务业务,支持分布式裸机和集中式裸机网关两种能力,支持分布式裸机网关与集中式裸机网关方式共存。集中式裸机和分布式裸机支持多个AZ,分布式裸机可以与集中式裸机共AZ。

分布式裸金属网关方案支持第三方交换机,第三方交换机需遵循1822网卡与第三方对接的要求(见配置手册第三方交换机选型原则),仅支持本地盘或FCSAN,不支持FusionStorage和IPSAN。2网口和4网口场景,分布式裸机支持10GE、25GE组网;6网口场景,分布式裸机支持管理口、业务口都10GE,支持管理口、业务口都25GE。双核心、多出口场景下与集中式裸机网关相同,需管理节点连接到业务TOR实现裸机Provision的网络互通。多出口场景下分布式裸机网关与集中式裸机网关相同,仅能部署在一个出口下。分布式裸机SDI卡通过串口服务器串口连接进行运维,一台串口服务器可管理30块SDI卡,串口服务器通过带外管理接入BMC网络。远程技术支持模式场景,通过串口服务器BMC IP地址+端口登录到不同SDI卡。

集中式裸机网关方案中裸金属服务器和裸金属网关连接的TOR主推华为CE6881交换机;存储面采用FusionSorage时不支持SD100智能网卡,需采用iSCSI方式挂载。集中式裸机网关方案中BMGW单服务器业务口为6个物理口,BMS单服务器的业务口推荐2个网口可支持多个网口(见配置手册“裸金属节点配置”)。 - 4)业务区存储主推FusionStorage分离部署,支持2网口(管理存储合布)和4网口(管理+存储)方案,同时兼容FusionStorage融合部署、FusionCube融合部署、IPSAN。SAN存储场景,计算节点需配置独立的存储网口: 2*10GE(IP SAN场景)

- 5)存储TOR可以与业务TOR共TOR部署,但不能与外部接入TOR共TOR部署。

- 6)仅6网口时支持SAP HANA,SAP HANA节点管理和业务分离,业务网卡类型要求部署用户态OVS,存储仅支持FC SAN存储,如果部署SAP HANA服务,需配置FC交换机,可与业务区存储FC交换机共用;鲲鹏场景不支持SAP HANA。

- 7)应用备份服务独占DPA节点,无需NAS。DPA节点只支持10G,不支持25G。DPA分布式版为管理口、业务口、存储口;DPA单机版无存储口,仅管理口、业务口。一个Region支持部署多个DPA集群,单个DPA集群最大6个节点,起配3个管理节点。每个集群的3个管理节点的管理平面需在同一个二层域,其他节点管理口支持三层;集群内所有节点的业务口、存储口支持三层。

- 8)SSL网关仅在密评场景部署,仅在Global部署,其他场景无需部署。部署SSL网关时,单核心组网场景与核心交换机互连、双核心组网场景与管理核心互连、三层组网场景与Border Leaf互连。SSL网关2个10GE光口为管理口、2个10GE光口为业务口接入管理核心交换机。

单核心组网 - 计算节点6网口

- 每台网络节点业务口配置用户态OVS,支持鲲鹏和X86;计算节点仅部署计算VM,计算节点业务口6网口场景为用户态OVS,2/4网口场景为内核态OVS。网络节点与计算节点类型相同支持同AZ,接入的业务TOR可共TOR部署(不能与外部接入TOR共部署),也可独立TOR部署。网络节点与计算VM是一套存储资源池。

- SAP HANA受限销售

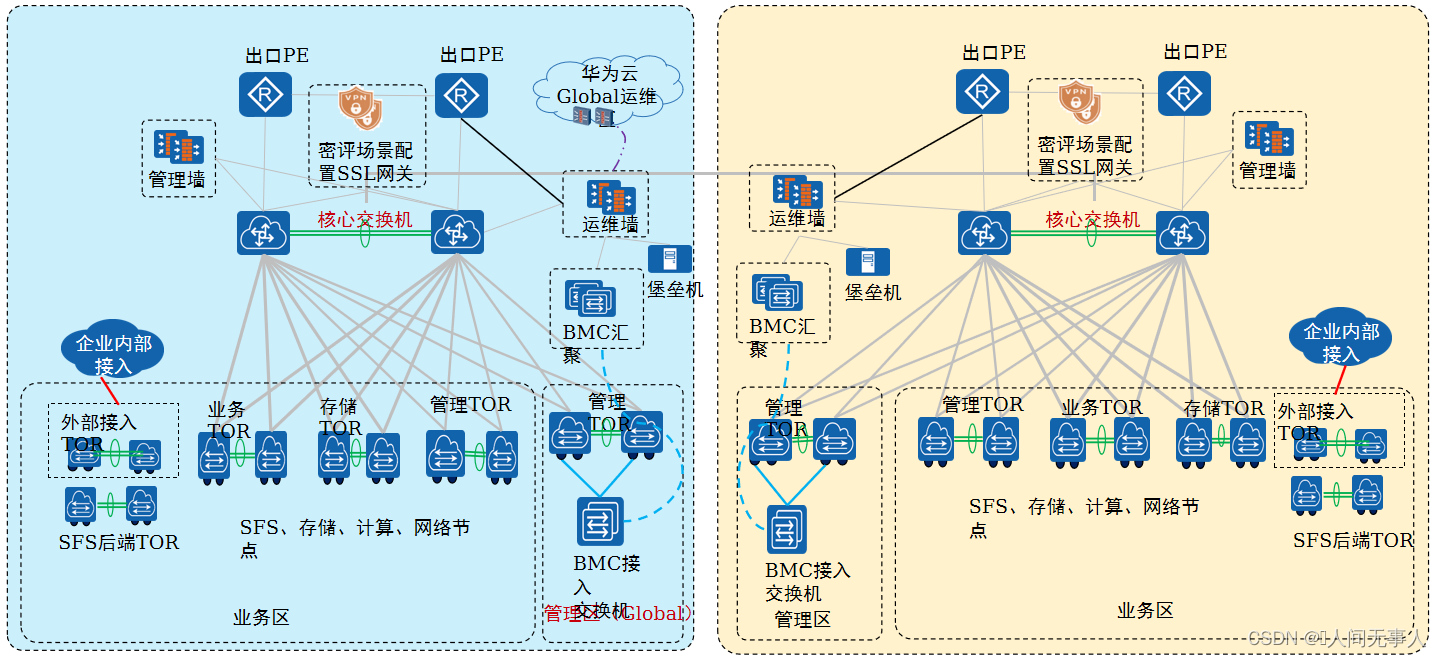

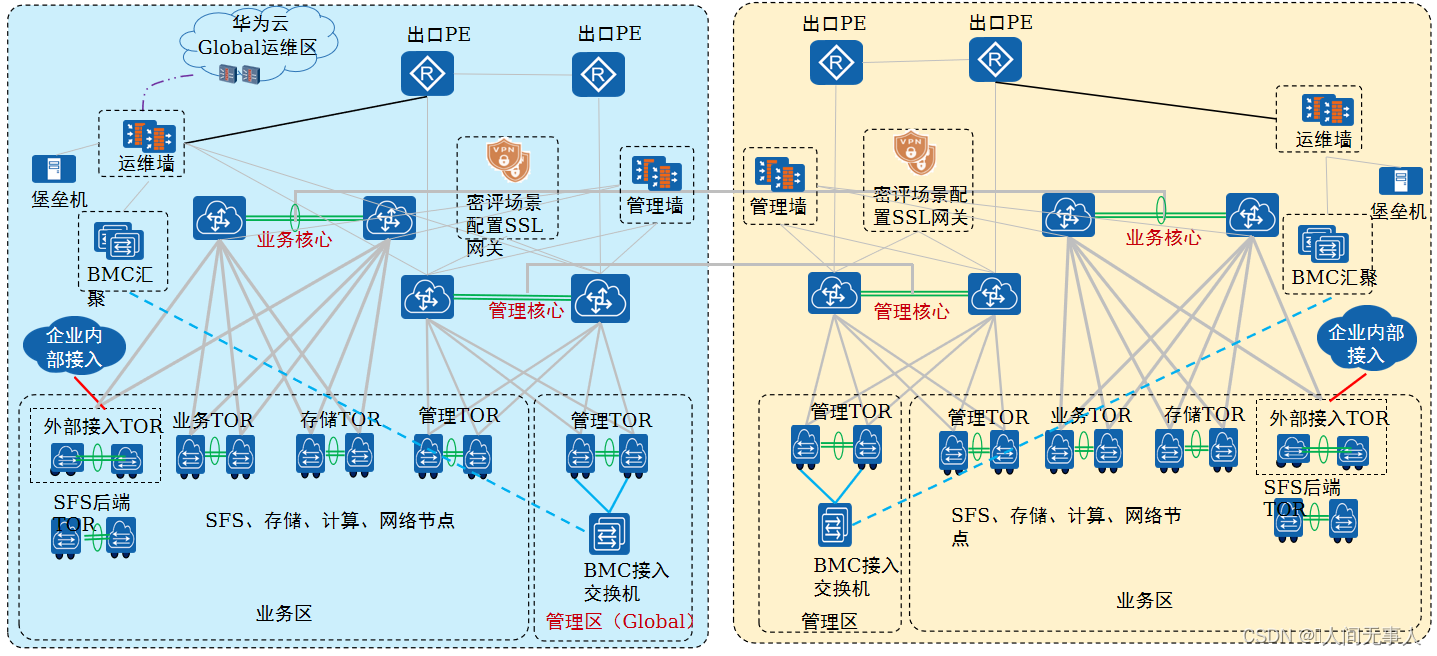

单核心架构 - 多Region组网

- 多Region组网说明:

- 1)两个Region分别都是单核心组网。

- 2)首Region和其他Region的核心交换机之间需要三层可达。因为ManageOne和Console部署在Global区,需要同时管理两个Region,两个Region的管理面需要打通。Region区的管理网络(External_OM、DMZ_Service、OBS_OM)需要与Global区的External_OM、DMZ_service和OBS_OM平面互通。支持云连接服务(可选)时,Region区的vRouter集群VTEP IP(Loopback地址)需要与Global区的vRouter集群VTEP IP(Loopback地址)互通。

Globla Public与Region Public,Global DMZ与Region DMZ默认不需要过防火墙配置安全策略。Global Publuc/DMZ与Region Public/DMZ互访,Global与Region存在跨安全区的访问,通过Global的防火墙上实现跨域访问,只需要在Global所在管理墙配置安全策略。 - 3)如果双Region的方案叠加管理面跨Region容灾或CSDR,则主备Region需部署ManageOne主备容灾;CSDR要求生产和容灾Region的存储复制面需要打通,因此业务核心之间需要连线。

- 4)两个业务核心之间是否需要其他业务流量互通(除了CSDR场景下的存储复制互通),比如EIP,IPSec-VPN或者路由直通等互通,按照具体项目要求实现。

- 5)CSDR场景,存储复制网络的网关配置在业务核心的InterConnection VRF,两个Region的存储复制流量互通不需要过防火墙。两个Region的InterConnetion VRF的网络互通不需要过防火墙。存储节点存储复制口仅在CSDR场景需要。

- 6)首Region和从Region间的Public VRF和Public VRF、DMZ VRF和DMZ VRF、OMAccess VRF和OMAccess VRF之间互通的流量过防火墙统一到核心交换机的Internet VRF,通过核心交换机首Region和从Region间的Internet VRF之间互联的三层口互通;在每个Region的管理墙上配置安全策略,实现集中到Internet VRF的Region间互通。Region间Public VRF和DMZ VRF跨VRF互通的流量需要在Global Region的管理墙上配置安全策略,实现跨VRF的互通。

- 7)多region组网支持高阶服务,CSDR服务与高阶服务无关。

- 注:多Region组网下的管理平面互通需求:

Region区的管理网络(External_OM、DMZ_Service、OBS_OM)需要与Global区的External_OM、DMZ_service和OBS_OM平面互通。支持云连接服务(可选)时,Region区的vRouter集群VTEP IP(Loopback地址)需要与Global区的vRouter集群VTEP IP(Loopback地址)互通。

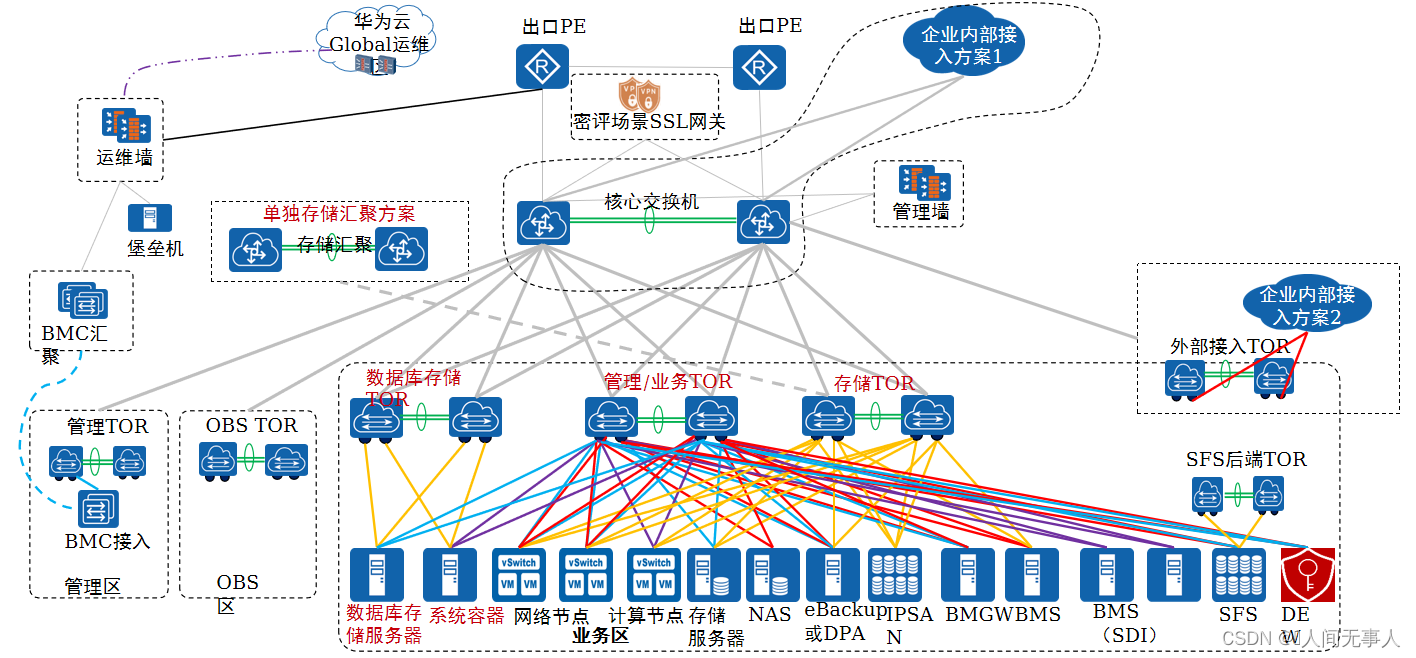

双核心组网设计和配置

- 设计规格:

- 规模可超2000PM但受限核心交换机物理口

- 方案优点:

- 管理网和业务网物理隔离

- 标准配置为4对TOR(一对管理区TOR,一对业务区管理TOR,一对业务区业务TOR,一对业务区存储TOR)

- FM交换机、CE系列交换机网络产品线约束仅能M-LAG组网交付。

- 第三方交换机选型要求参见《华为云Stack配置手册》-工程组网章节。

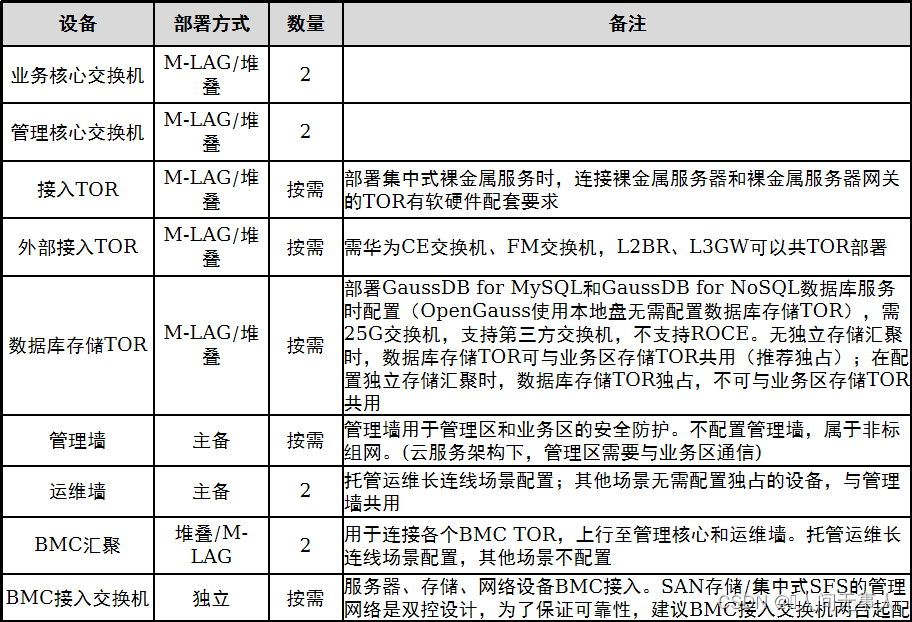

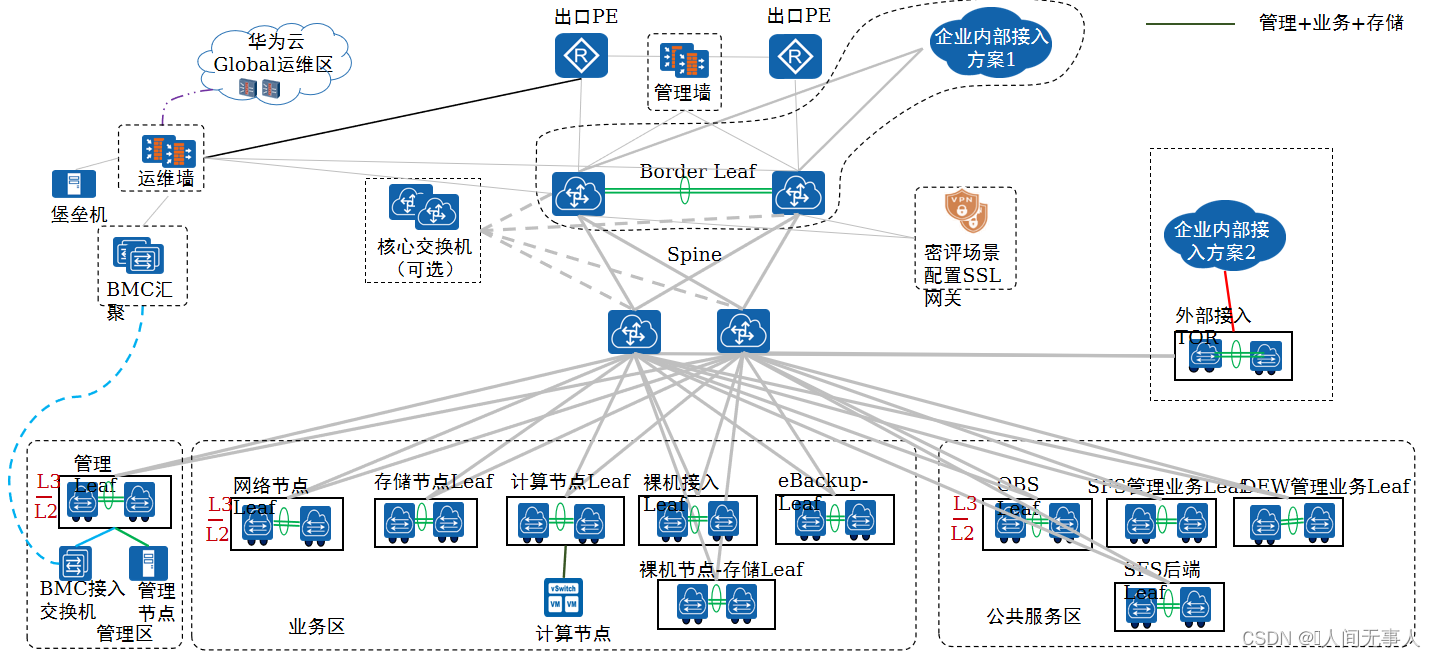

双核心组网 - 计算节点6网口

- 整体组网说明:

- 1)双核心组网规模可超2000PM但受限核心交换机物理口,接入交换机分别是管理区的管理TOR,业务区的管理TOR、业务TOR,存储TOR和外部接入TOR(单对TOR要求不超过88个端口);业务TOR下接入网络节点和计算节点,外部接入TOR下接入第三方服务器L2BR接入、硬件L3GW专线,业务TOR与外部接入TOR不支持合布。

- 2)分布式SFS节点分1个管理口(GE),两个前端业务口和两个后端存储口,分别接入到前端TOR和后端TOR,前端TOR可与业务区TOR复用,后端TOR需华为交换机由SFS独占(请查看SFS兼容性列表)。管理口接入到业务区管理TOR,前端业务口接入到业务区业务TOR,后端存储口接入到SFS独立配置的后端TOR。管理TOR为光口交换机时需配置光转电模块接入SFS管理口。

- 3)集中式SFS节点2个管理口(为GE口,即为BMC口)和8个业务口(支持不同节点业务口三层互通)。管理口连接BMC交换机,与SAN存储组网相同,BMC交换机需2台堆叠组网。二层组网场景,业务口连接计算节点业务TOR;三层组网场景,业务口连接计算节点Leaf(计算节点业务leaf)。

- 管理区:如果双核心组网场景且部署裸金属服务,管理节点需要配置独立2*10GE网卡连接到裸金属服务器的业务区接入TOR上(图中红色虚线所示)提供Provision网络。

- 业务区:

- 1)业务TOR 3对起配,1对业务区的管理TOR,1对业务TOR,1对存储TOR。业务区管理TOR上连管理核心,业务区业务TOR和存储TOR上连业务核心。

- 2)每台网络节点业务口配置用户态OVS,支持鲲鹏和X86;计算节点仅部署计算VM,计算节点业务口6网口场景为用户态OVS,2/4网口场景为内核态OVS。网络节点与计算节点类型相同支持共AZ,接入的业务TOR可共TOR部署(不能与外部接入TOR共部署),也可独立TOR部署。网络节点与计算VM是一套存储资源池。

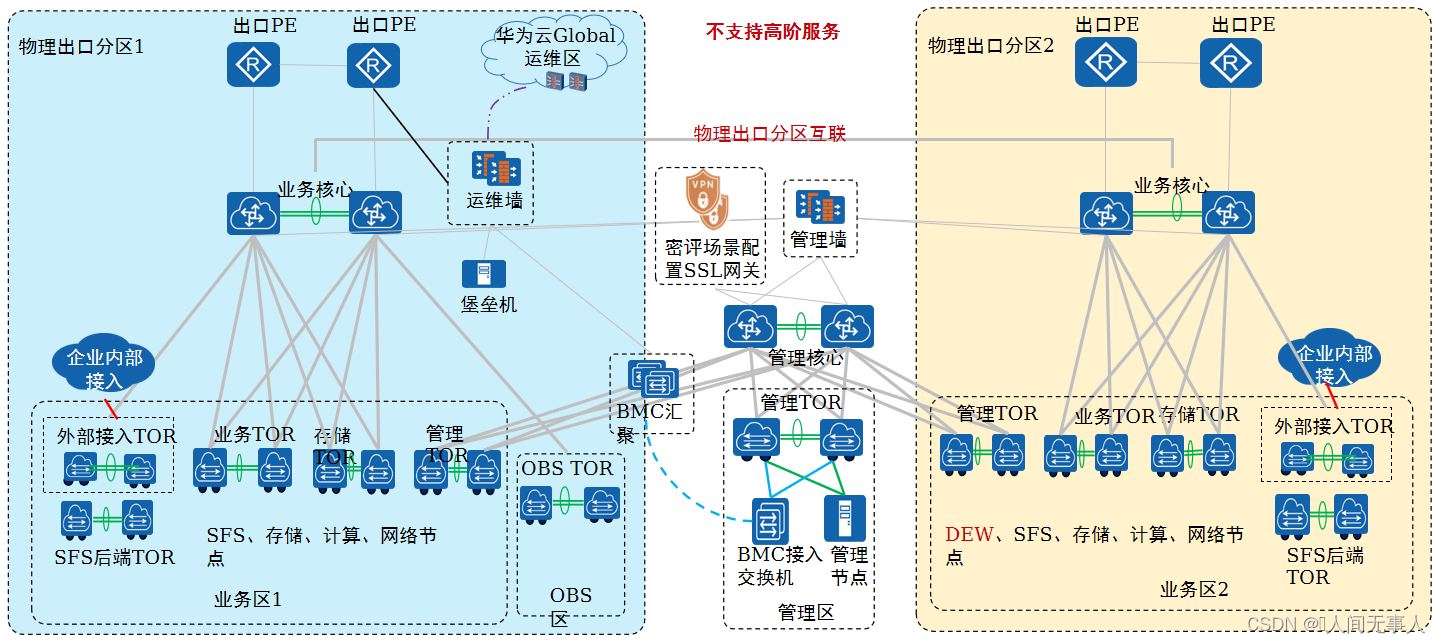

双核心组网 - 6网口多物理出口分区

-

不支持单Region多物理出口隔离场景,隔离场景需采用多个Region进行部署,不提供一个Region的方式交付。

-

不同物理出口分区间通过核心互联,互联带宽需满足物理出口分区间的互访带宽需求。不同物理出口分区核心间互联时,建议在互联设备上划分独立VRF与各物理出口分区核心互联配置路由,保证流量互通的隔离,各物理出口分区核心与客户现有互联设备配置BGP进行路由发布(发布LoopBack、Tunnel_Bearing、OBS_Business_Tenant、DEW_Service平面路由)。

-

仅双核心6网口组网,提供多物理出口分区能力,该组网下不同物理出口分区间不隔离,不支持高阶服务。

-

裸金属服务只支持部署在一个物理出口分区,管理节点需配置独立业务口并连接到裸金属服务器节点所在业务接入交换机。

-

OBS部署在其中一个物理出口分区,不支持多个物理出口分区都部署,仅支持部署一套OBS集群。因此其他物理出口分区的计算节点访问OBS时,需跨物理分区业务核心进行互通。多个物理出口分区都需访问OBS时则存在跨物理出口分区访问OBS的大流量,因此物理出口分区间的互通通道需保证带宽满足业务需求。

-

DEW部署在其中一个物理出口分区的业务区,其他物理出口分区需跨物理分区业务核心进行互通。因此若仅一个物理出口分区需DEW服务,推荐DEW服务部署在该物理出口分区;若多个物理出口分区需DEW服务,则物理出口分区核心需提供高带宽能力。

-

SFS可在每个物理出口分区部署,即物理出口分区1部署一套SFS,物理出口分区2部署另一套SFS。

Region内时延需满足小于2毫秒 -

托管运维长连线场景:

- 1)运维墙和BMC汇聚仅在托管运维长连线场景配置,每个Region配置原则相同。独立Global区无需配置BMC汇聚,仅需一台BMC TOR,运维墙与BMC TOR互联。其他场景,支持运维墙与管理墙合并,此时无需BMC汇聚,与原有定期连线场景组网相同。

- 2)托管运维长连线场景配置BMC汇聚时,二层组网BMC汇聚与管理核心互联,三层组网BMC汇聚与管理Leaf互联。BMC平面网关在BMC汇聚,BMC接入交换机与BMC汇聚互联无需与管理TOR互联,BMC汇聚与运维墙直连。独立Global区在托管运维长连线场景无需配置BMC汇聚,仅一组BMC交换机,BMC平面网关在BMC TOR,运维墙与BMC交换机直连,BMC交换机与管理TOR直连。

- 3)二层组网场景运维墙与管理核心交换机互联,三层组网场景运维墙与Border Leaf互联,独立Global区场景运维墙与管理TOR互联。

- 4)长连线场景与定期连线场景兼容性能力一致,支持第三方交换机。

- 5)Global 运维墙到Region区运维墙之间通道通过IPSec VPN互通。

- 6)多物理出口分区组网场景,运维墙和BMC汇聚仅部署在同一个出口分区,部署在EIP的出口区,如政务场景部署在互联网分区。

- 7)大数据物理机集群不支持模式一,混合云+大数据物理机集群场景以及独立Global区+大数据物理机集群场景长连线组网与定期连线组网相同。

双核心架构 - 多Region组网

- 多Region组网说明:

- 1)两个Region分别都是双核心组网。

- 2)首Region和其他Region的管理核心交换机之间需要三层可达。因为ManageOne和Console部署在Global区,需要同时管理两个Region,两个Region的管理面需要打通。Region区的管理网络(External_OM、DMZ_Service,OBS_OM)需要与Global区的External_OM、DMZ_service和OBS_OM平面互通。支持云连接服务(可选)时,Region区的vRouter集群VTEP IP(Loopback地址)需要与Global区的vRouter集群VTEP IP(Loopback地址)互通。

Globla Public与Region Public,Global DMZ与Region DMZ默认不需要过防火墙配置安全策略。Global Public/DMZ与Region Public/DMZ互访,Global与Region存在跨安全区的访问,通过Global的防火墙上实现跨域访问,只需要在Global所在管理墙配置安全策略。 - 3)如果双Region的方案叠加管理面跨Region容灾或CSDR,则主备Region需部署ManageOne主备容灾;CSDR要求生产和容灾Region的存储复制面需要打通,因此业务核心之间需要连线。

- 4)两个业务核心之间是否需要其他业务流量互通(除了CSDR场景下的存储复制互通),比如EIP,IPSec-VPN或者路由直通等互通,按照具体项目要求实现。

- 5)CSDR场景,存储复制网络的网关配置在业务核心的InterConnection VRF,两个Region的存储复制流量互通不需要过防火墙。两个Region的InterConnetion VRF的网络互通不需要过防火墙。存储节点存储复制口仅在CSDR场景需要。

- 6)首Region和从Region间的Public VRF和Public VRF、DMZ VRF和DMZ VRF、OMAccess VRF和OMAccess VRF之间互通的流量过防火墙统一到核心交换机的Internet VRF,通过核心交换机首Region和从Region间的Internet VRF之间互联的三层口互通;在每个Region的管理墙上配置安全策略,实现集中到Internet VRF的Region间互通。Region间Public VRF和DMZ VRF跨VRF互通的流量需要在Global Region的管理墙上配置安全策略,实现跨VRF的互通。

- 7)多region组网支持高阶服务,CSDR服务与高阶服务无关。

- 注:多Region组网下的管理平面互通需求:

Region区的管理网络(External_OM、DMZ_Service、OBS_OM)需要与Global区的External_OM、DMZ_service和OBS_OM平面互通。支持云连接服务(可选)时,Region区的vRouter集群VTEP IP(Loopback地址)需要与Global区的vRouter集群VTEP IP(Loopback地址)互通。

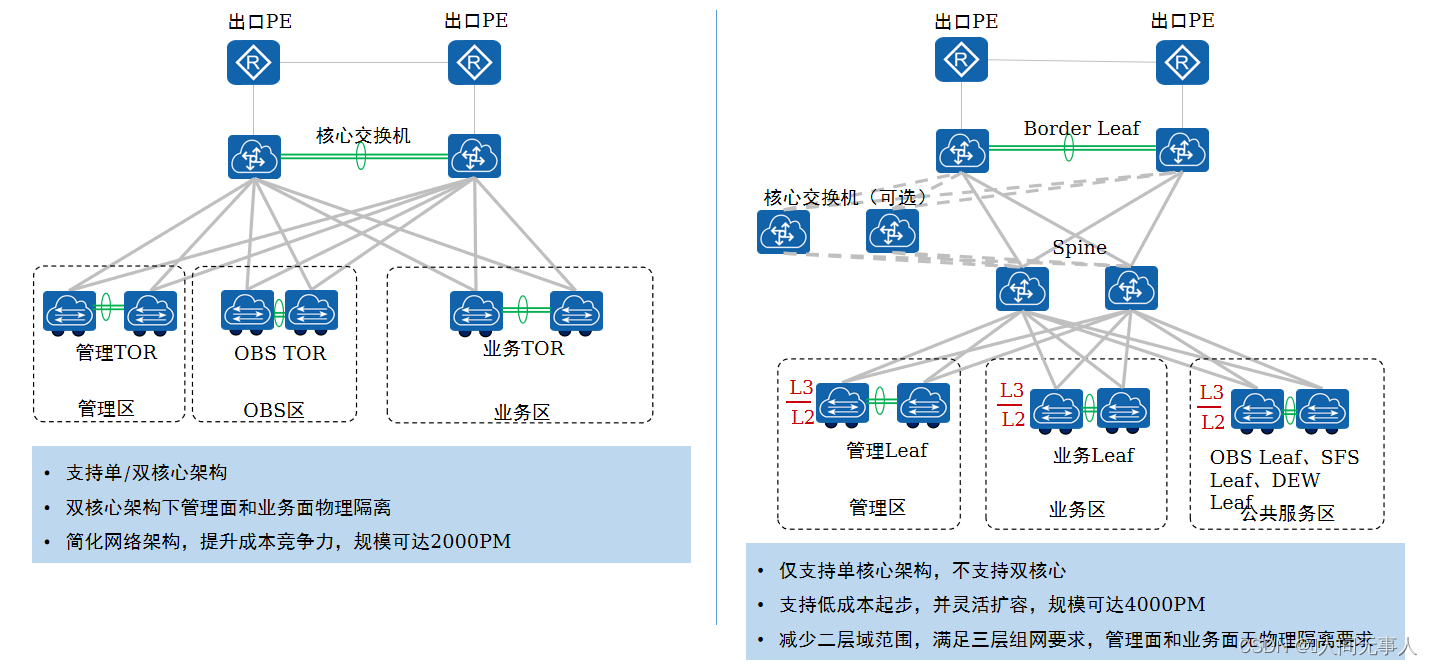

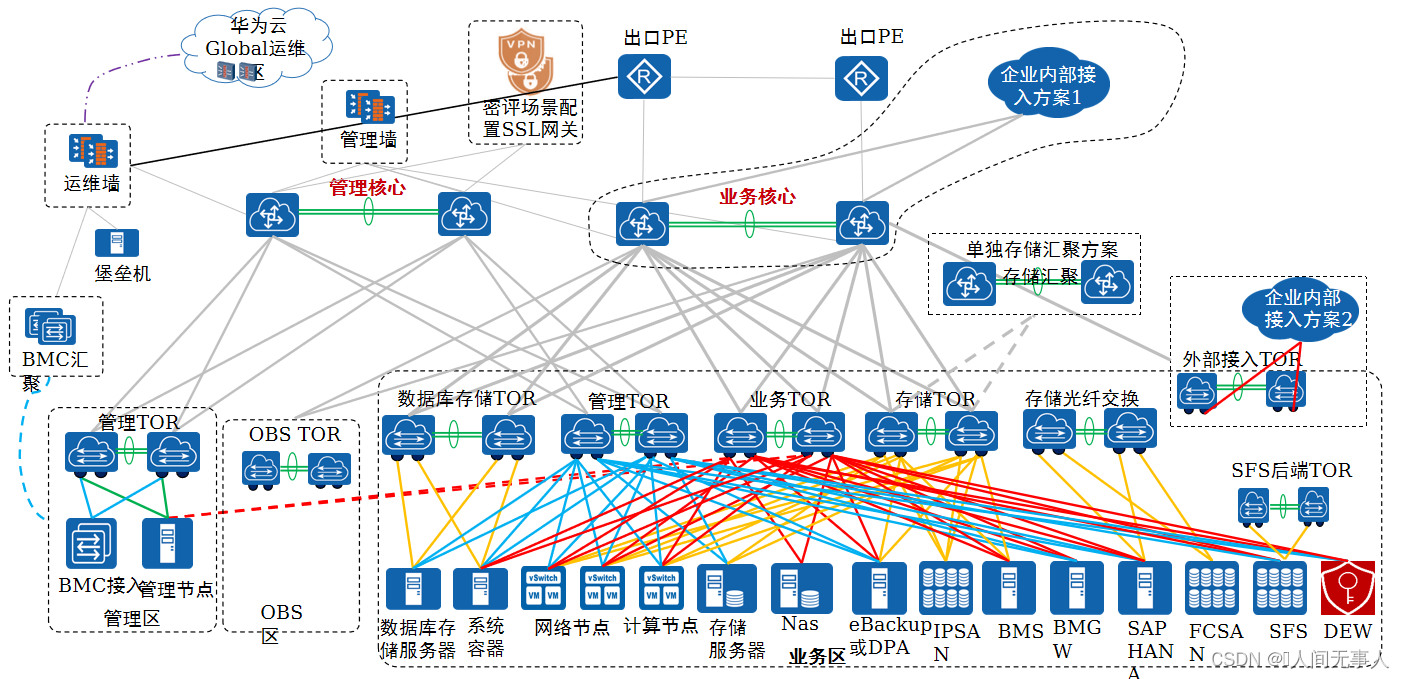

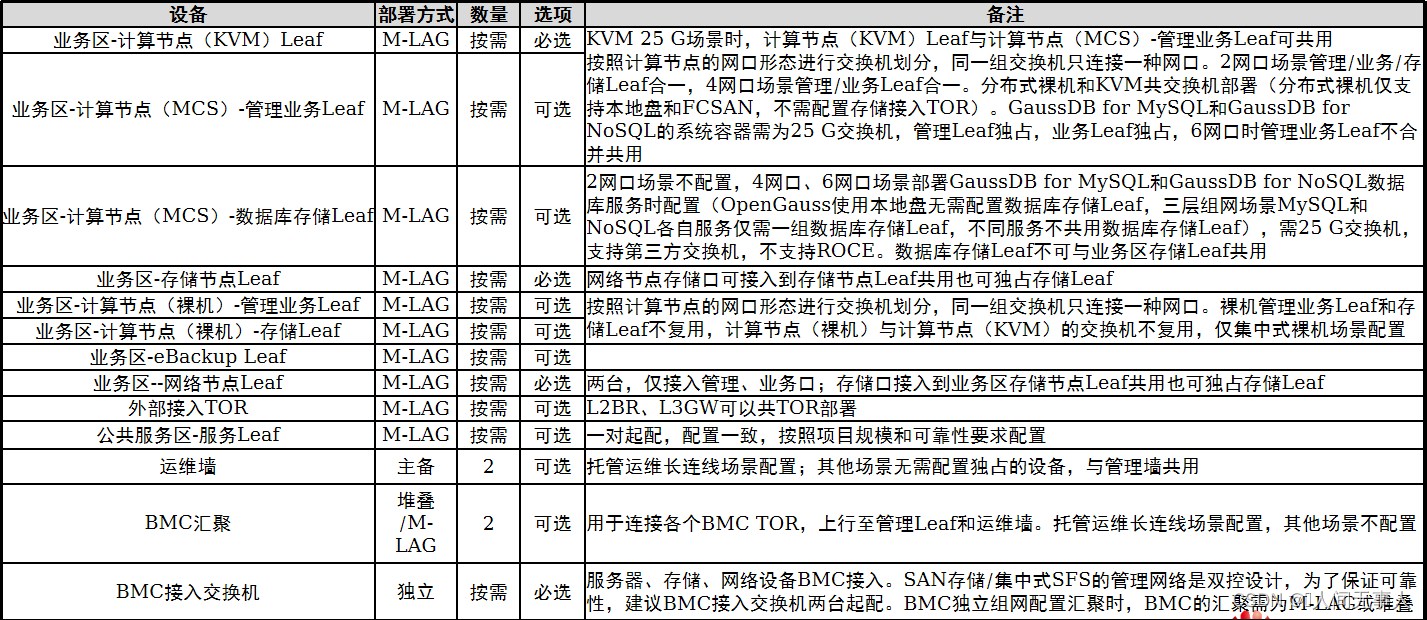

三层组网

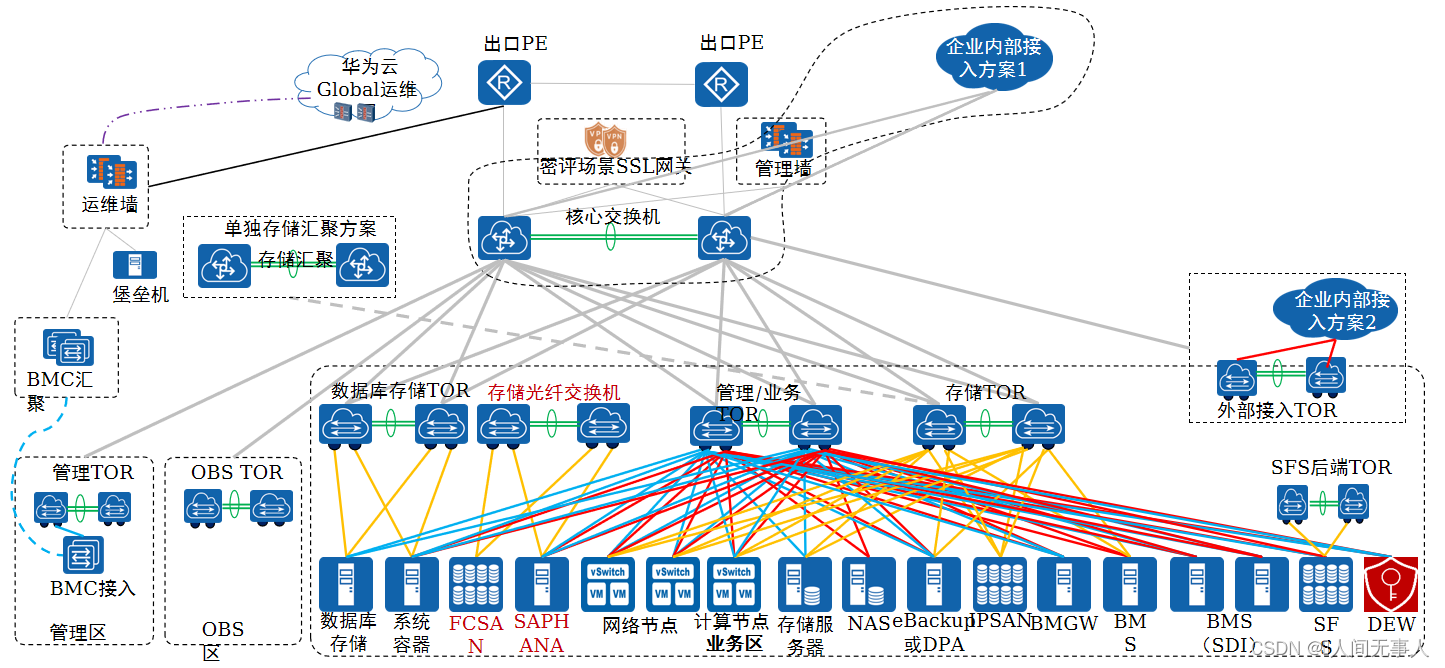

三层组网设计和配置

- 设计规格:

- 2K 4W ECS+2K BMS(<=4000PM),可达4000PM,具备超过4000PM扩容架构但版本能力不能超4000PM【2K 4W 指2千计算节点,4万虚拟机】

- 方案优点:

- 三层组网,减少二层域范围,满足三层组网

- 支持低成本起步,并灵活扩容

- 管理平面和业务平面无物理隔离要求

三层组网配置

- 设备选型推荐:三层组网仅适配华为交换机和FM品牌交换机

- MCS全称Machine Container Service,中文叫做系统容器,是一种以容器技术为基础的轻量级主机虚拟化技术。系统容器提供与虚拟机一致的行为,在HCS场景下MCS主要是数据库相关服务使用

三层组网 - 计算节点2网口

-

组网整体说明:

- 1)三层组网规格可达4000PM,支持2K4W ECS + 2K BMS,具备超过4000PM扩容架构,支持规模与管理Leaf选型相关:6857-48S6CQ-EI/6857E-48S6CQ/CE6857F-48S6CQ/CE6857E-48S6CQ/CE6857-48S6CQ-EI/6865-48S8CQ-SI/6865E-48S8CQ/CE6865E-48S8CQ/CE6865-48S8CQ-EI支持2W虚拟机即2000PM以内,CE6881-48S6CQ/CE6863E-48S8CQ-EI/CE6863-48S6CQ支持到4W虚拟机即可达4000PM。

- 2)仅支持单核心架构,不支持双核心,不支持单Region多物理出口分区,支持CSDR,不支持Region内的灾备(管理面高可用、CSHA)。

- 3)2网口不支持高阶服务(原因在于基于系统容器的数据库服务不支持2网口组网),4网口、6网口支持高阶服务。

- 4)需FM交换机、华为交换机,需购买网络产品线服务进行交付;管理墙支持第三方。

- 5)划分管理区、业务区(网络集群节点/KVM/裸机)、公共服务区。

- 6)核心区包含核心交换机和Spine;Region内仅一组核心(独立部署),核心可选;可多组Spine(独立部署)。初始部署可无核心仅一组Spine,Spine与Border Leaf互联。管理区、业务区、公共服务区网关在Leaf(External_Relay_Network和Provision的网关在管理Leaf)。

- 7)三层组网时,托管运维长连线场景BMC网关在BMC接入交换机,BMC汇聚配置路由到BMC接入交换机;其他运维场景BMC网关在BMC接入交换机,管理Leaf配置路由到BMC接入交换机。BMC为独立组网,无需每个区有各自独立的BMC交换机。

- 8)仅支持M-LAG,不支持堆叠组网(BMC除外)。

- 9)部分交换机需配置VxLAN Licence:管理Leaf为External_Relay_Network的网关,每个计算节点(KVM&MCS)业务Leaf、计算节点(裸机)业务Leaf与管理Leaf建立VxLAN隧道,因此管理Leaf、计算节点(KVM&MCS)业务Leaf、计算节点(裸机)业务Leaf需配置VxLAN Licence;裸机PXE的Provision网络需从管理Leaf到业务区裸机业务Leaf建立VxLAN隧道,因此管理Leaf和业务区计算节点(裸机)业务Leaf需配置VxLAN Licence。集中式裸机场景在裸机接入TOR需预配置裸机高速平面的VxLAN隧道。

- 10)两台Border Leaf,M-LAG组网,仅支持一组Border Leaf,不与其他交换机共用。10G场景Border Leaf配置2个10G Peer-Link,2个10G逃生互联物理口;25G场景配置2个25G Peer-Link,2个25G逃生互联物理口。

- 11)金融行业场景,管理墙和Border Leaf可选,可选方式仅如下两种配置:无管理墙但配置Broder Leaf,或者可同时无管理墙和Border Leaf(非密评场景,密评场景需配置Border Leaf旁挂密评设备)。无Border Leaf时,Spine/核心与客户PE互联。在Spine/核心单组内设备数量扩容时,需新增PE互联口以及使用软专线时的客户内网接入设备互联口。无管理墙时,需保证:

- 客户保证访问云平台管理面的安全防护,即客户已建设安全等保防护可保证云外访问云平台管理面的安全性

- 无需云内管理面的建设满足等保要求

- 无需在云内建立托管运维长连线或定期连线的远程运维VPN接入

- 无需云内提供管理面访问的NAT64

- 无需云内提供云外访问云内管理面的NAT,即客户地址与云内管理地址不重叠,无需NAT可互访

- 后续无需改造为配置管理边界防火墙

-

核心区

- Spine:一组起配,每组Spine两台起配,每台Spine独立部署,中间不需要连线。支持多组Spine,需配置核心交换机。

- 核心交换机:可选,两台设备起步,Region内仅一组核心交换机。每台核心交换机独立部署,中间不需要连线。核心交换机选型建议与Spine同型号或高于Spine。新建部署时,若未配置核心交换机,Border Leaf接入在第一组Spine;若配置核心交换机,Border Leaf建议接入在核心交换机。

- 核心交换机以及每组Spine,最大规格按接入Leaf(Border Leaf、外部接入TOR、Spine下接入的各个区的Leaf)的40G上行口个数约束(比如Leaf是6857-48S6CQ-EI/6857E-48S6CQ/CE6857F-48S6CQ/CE6857E-48S6CQ/CE6881/CE6857/CE6863E-48S8CQ-EI/CE6863则核心交换机/Spine最大4台,Leaf是6865-48S8CQ-SI/6865E-48S8CQ/CE6865E-48S8CQ/CE6865则核心交换机/Spine最大6台)。当核心交换机不接入Border Leaf和外部接入TOR时,核心交换机个数无规格约束。

-

管理区

- 管理节点,仅为一对Leaf,网关在管理Leaf,Region内仅一个管理区。

-

业务区

- 1)支持计算节点2网口、4网口、6网口方案,部署的节点包括计算节点、存储节点、裸金属服务器节点和BMGW节点(集中式裸金属)、分布式裸金属服务器节点、ebackup节点等。

- 2)2网口场景,管理/业务/存储交换机合一,计算节点Leaf交换机1对起步;4网口场景,计算节点管理/业务Leaf、计算节点存储Leaf单独配置,也可以共用Leaf;6网口场景,管理、业务、存储各自配置独立Leaf,也可以共用Leaf。推荐共用Leaf,因此计算节点接入一组Leaf起步。

- 3)除了External_Relay_Network、Provision的网关在管理Leaf,业务区使用的网络平面的网关在业务区Leaf交换机。

- 4)计算节点(KVM/分布式裸金属)Leaf与计算节点(集中式裸金属)的管理业务Leaf、存储Leaf不共用;分布式裸机与KVM接入方式相同(分布式裸机仅支持本地盘和FCSAN,不需配置存储Leaf),可以共Leaf。集中式裸机每个集群独占Leaf,不同集中式裸机集群不共用Leaf避免无法扩展单集群内裸机规格。

- 5)集中式裸金属场景裸金属服务器采用Fusionstroage存储时,裸机存储口的存储平面网关在各自接入的裸机存储Leaf。裸机存储Leaf与裸机管理业务Leaf不复用。单个裸机集群(2:30配比:2个BMGW和30个BMS)独占一组裸机管理业务Leaf保证裸机集群可扩容到2:30;支持多个裸机集群共用一组裸机管理业务Leaf,但此时无法满足单个裸机集群扩容。

- 6)集中式裸机场景在裸机Leaf需预配置裸机高速平面的VxLAN隧道。

- 7)存储节点管理口、存储口接入到存储节点Leaf,共用一组Leaf。

- 8)网络节点:

- 企业内部三层接入:基础型云专线(软专线)只支持采用Border Leaf接入方式(企业内部接入方案1),在Border Leaf配置静态路由下行回程到网络节点(暂不支持网络节点与Border Leaf动态路由);上行到企业内部接入网的路由可配置为静态路由,也可在Border Leaf与企业内部接入交换机配置动态路由。增强型云专线(硬件L3GW)方案只支持采用外部接入TOR方式(企业内部接入方案2),外部接入TOR接入到核心。

- 外部接入TOR支持L2BR和L3GW,需为华为CE系列交换机、FM交换机,支持L2BR和L3GW共TOR部署(企业内部接入方案2),但不与其他TOR共用,外部接入TOR设备类型请查阅兼容性网站。L2BR接入方式:支持刀片服务器直接L2BR接入到外部接入TOR,但刀片服务器需配置交换板,直通板场景需配置客户TOR接入到外部接入TOR;不支持非刀片服务器直接L2BR接入到外部接入TOR,需配置客户TOR接入到外部接入TOR。

- 网络服务区网关在网络节点Leaf,到Spine的收敛比需满足1:2配比。网络节点可共用业务区存储,也可独立部署存储资源池。

- 网络节点Leaf独占接入网络节点管理口、业务口,每组网络节点集群独占一组网络节点Leaf;网络节点存储口可接入到存储节点Leaf共用也可独占存储Leaf。多个网络集群是多出口逻辑模型,高阶服务不支持多出口,因此不支持多个网络集群场景。

- 网络节点Leaf独立AS号,业务区其他Leaf同一个AS号。

- 网络节点不发放计算VM。

- 9)业务区Leaf共用原则:

- 计算节点和分布式裸机共用Leaf,其中的管理、业务、存储Leaf可合并(LLD子网规划掩码无需/26,避免地址占用过多)。

- 集中式裸机的管理业务Leaf、存储Leaf不共用。

- 存储节点的管理Leaf、存储Leaf可共用(LLD子网规划掩码无需/26,避免地址占用过多)。

- 计算节点的Leaf、集中式裸机节点的Leaf、存储节点的Leaf、eBackup-Leaf各自独占使用,不同类型之间不共用Leaf。仅网络节点存储口连接的存储Leaf可以与存储节点接入的存储节点Leaf可共用,网络节点也可独占存储Leaf,推荐共用。

- 10)管理墙仅管理面南北防护,当管理墙为华为防火墙时可与EdgeFW硬件墙共用。

- 11)DPA节点与eBackup节点可共用一组eBackup Leaf,也可各自独占eBackup Leaf,推荐共用。

- 12)应用备份服务独占DPA节点,无需NAS。DPA节点只支持10G,不支持25G。DPA分布式版为管理口、业务口、存储口;DPA单机版无存储口,仅管理口、业务口。一个Region支持部署多个DPA集群,单个DPA集群最大6个节点,起配3个管理节点。每个集群的3个管理节点的管理平面需在同一个二层域,其他节点管理口支持三层;集群内所有节点的业务口、存储口支持三层。DPA集群的3个管理节点需在一组Leaf,其他节点可以在不同Leaf。

- 13)SSL网关仅在密评场景部署,仅在Global部署,其他场景无需部署。部署SSL网关时,单核心组网场景与核心交换机互连、双核心组网场景与管理核心互连、三层组网场景与Border Leaf互连。SSL网关2个10GE光口为管理口、2个10GE光口为业务口接入Border Leaf。

-

公共服务区

- 1)部署OBS、SFS、DEW服务,网关在Leaf。

- 2)分布式SFS节点为一个管理口(GE口),SFS管理Leaf为光口交换机时需配置光转电模块接入SFS管理口。SFS管理Leaf独立部署单台部署,SFS管理Leaf可与SFS业务Leaf共用。SFS后端Leaf需华为交换机,请查看SFS兼容性列表。SFS管理Leaf、SFS业务Leaf和SFS后端Leaf仅SFS服务使用,不与其他服务共用。

- 3)集中式SFS节点2个管理口(为GE口,即为BMC口)和8个业务口(支持不同节点业务口三层互通)。管理口连接BMC交换机,与SAN存储组网相同,BMC交换机需2台堆叠组网。二层组网场景,业务口连接计算节点业务TOR;三层组网场景,业务口连接计算节点Leaf(计算节点业务leaf)。

- 4)OBS分离部署场景在三层组网中OBS接入Leaf和OBS存储Leaf各自独占不合并,且不与其他TOR共用。

三层组网 - 计算节点4网口

- 2网口不支持高阶服务(原因在于基于系统容器的数据库服务不支持2网口组网),4网口、6网口支持高阶服务。

- 4网口、6网口场景部署GaussDB for MySQL和GaussDB for NoSQL数据库服务时配置数据库存储TOR,各个数据库服务共用数据库存储TOR,需25G 交换机,支持第三方交换机,不支持ROCE。推荐数据库存储TOR独占,支持数据库存储TOR与业务区存储TOR共用。数据库存储TOR与核心交换机互联,满足数据库服务备份到OBS的业务流互通。接入25G根据收敛比核心要求配置100G,核心交换机上要配置100GE单板或配置40GE单板满足收敛比不小于1:5。在4网口、6网口X86和鲲鹏场景都是配置2块4口1822网卡,存储独占1块1822网卡,管理业务共用一块1822网卡,不支持跨网卡bond。

- OBS TOR仅OBS独占,不与其他节点复用,支持第三方交换机,支持Bond4组网。支持MRS存算分离时需25G组网,交换机需满足转发时延<2us且buffer>=32MB要求;其他场景支持10G组网,交换机需满足转发时延<4us且buffer>=20MB。OBS Node节点跨网卡Bond,其中2个网口为管理+业务(管理面访问OBS),2个网口为业务(计算节点和Internet访问OBS)。融合部署时,OBS node节点所有服务器都是两种类型网口4根连线分为2个bond;分离部署时部署Service的OBS node节点为两种类型网口4根连线分为2个bond,其他类型OBS node节点服务器仅需管理业务类型口2根连线1个管理bond无需业务类型网口。OBS LVS节点连线方式不区分融合部署和分离部署。10G组网时,每组交换机上行口为2440G;25G组网时,每组交换机上行口为24100G。

- MRS存算分离计算节点不支持内核态OVS,因此X86场景CX4/CX5/1822网卡可4网口、6网口,其他网卡需为6网口组网;鲲鹏场景在1822网卡时支持4网口和6网口,在第三方网卡时需为6网口。MRS存算分离计算节点业务口接入的业务TOR需满足1:3收敛比,10G场景每组Leaf上行口为2440G,25G场景每组Leaf上行口为24100G。

- 数据库服务采用集中式裸机部署时,仅支持25G。

三层组网 - 计算节点6网口

灾备组网和云联邦

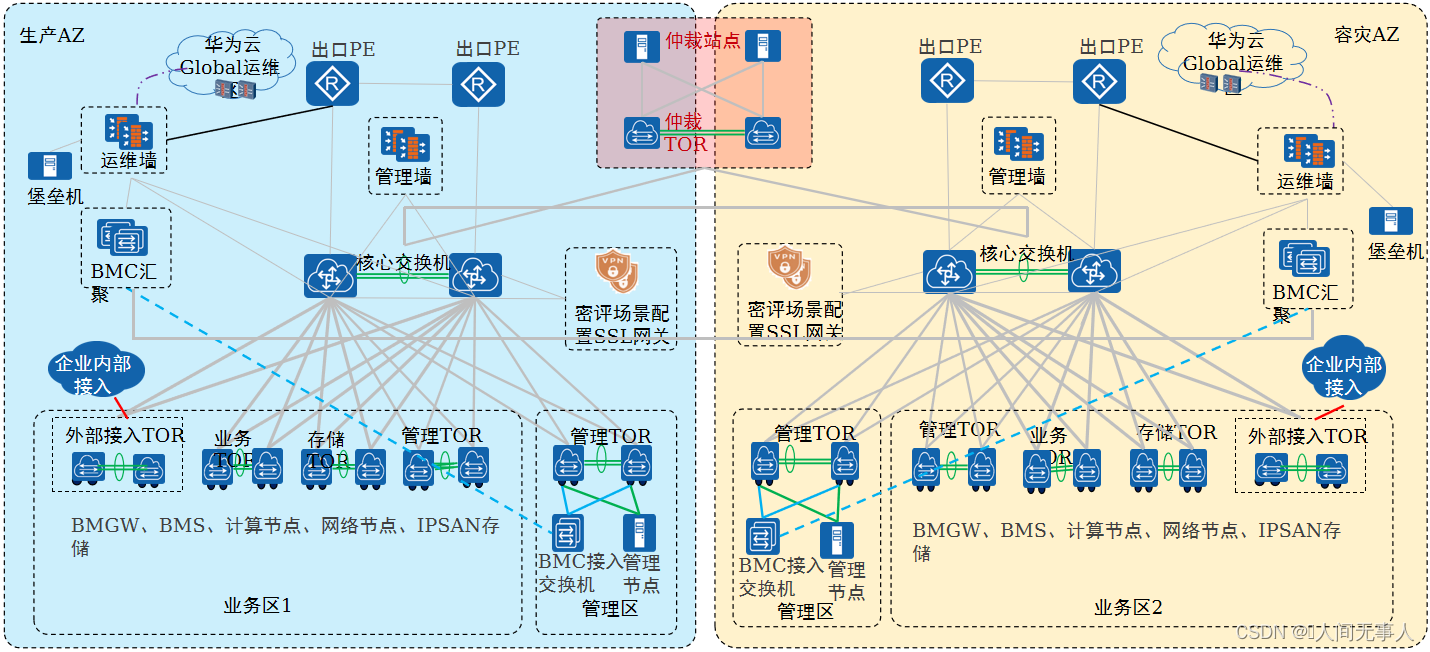

灾备组网 - CSHA和管理面跨AZ高可用(单核心)

- 管理面跨AZ高可用设计说明

- 1)管理面跨AZ高可用场景下,对应的是一套OpenStack,拉远部署在两个站点,每个站点需要各自的管理节点,管理平面二层拉远。

- 2)核心交换机之间推荐采用直连,用于管理面二层互通、业务区一个VPC内的VM跨两个站点。

- 3)管理接入交换机仅作为二层接入,核心交换机作为管理网的三层网关,配置VRRP。在核心交换机上配置了三层网关的网络平面均需要配置VRRP,包含External_OM、DMZ_Service、Management_Storage_Data、External_Relay_Network、Internal_Base、Tunnel_Bearing、Internet等。

- 4)Type I场景,单核心组网支持计算节点的2网口、4网口和6网口部署。在多出口场景下,每个物理出口需要配置各自的网络节点(每套网络节点2节点起配),每个出口的网络节点业务没有关系,是两套独立的网络集群,网络服务相关的网络平面每个出口都需要单独规划,且保证网络不冲突;在主备出口场景下,只部署一套网络集群,一套网络集群拉远部署在两个站点。

- 5)第三方仲裁站点,建议通过专线直连到两个站点的核心交换机。第三方仲裁站点到生产站点、第三方仲裁站点到灾备站点之间,需要分别发布云平台仲裁服务节点的主机路由。云服务、ManageOne、FusionSphere OpenStack都需要访问第三方仲裁站点。

- 6)企业内部接入中仅L3GW支持主备网关的CSHA能力,L2BR不支持主备网关能力。

- CSHA设计说明

- 1)核心交换机之间推荐采用直连,用于存储双活复制。

- 2)两个站点的存储双活/远程复制网口连接到存储接入交换机,存储接入交换机上行到核心交换机,经过核心交换机二层通信。

- 3)存储设备的仲裁网络平面网口,连接到管理接入交换机。生产存储、容灾存储的仲裁网络平面的网关,各自配置在生产站点、容灾站点的核心交换机。

- 4)第三方仲裁站点,建议通过专线直连到两个站点的核心。存储设备需要访问第三方仲裁站点。

- 5)CSHA依赖管理面跨AZ高可用,故CSHA场景同样需要遵循管理面跨AZ高可用设计说明。

- 管理面容灾场景下,可以部署高阶服务,但高阶服务不具备管理面容灾能力;管理面容灾跨AZ场景下支持部署部分高阶服务(具体见配置手册容灾场景说明)。

- 其他请参考单核心组网

- 支持部分高阶服务管理面高可用。

- 支持密评场景,但两地三中心场景不支持密评。

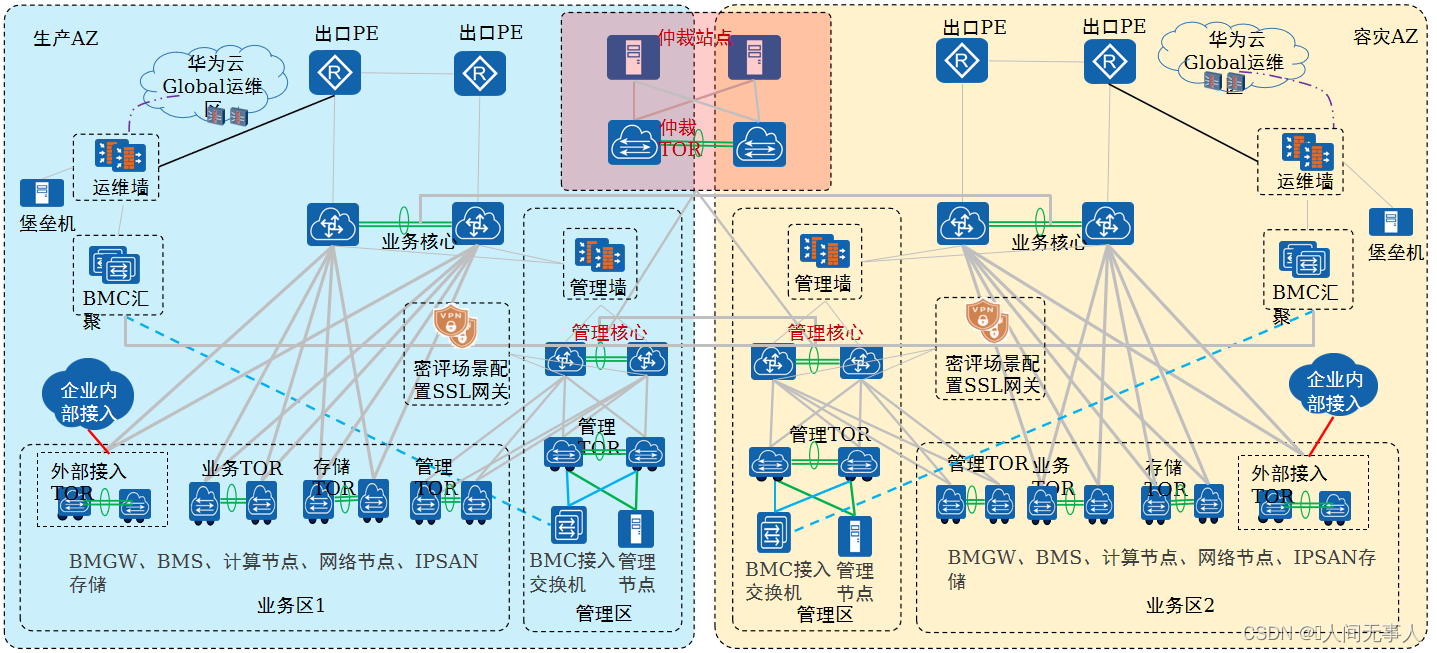

灾备组网 - CSHA和管理面跨AZ高可用(双核心)

- 管理面跨AZ高可用设计说明

- 1)管理面高可用场景下,对应的是一套OpenStack,拉远部署在两个站点,每个站点需要部署各自的管理节点,管理平面二层拉远。

- 2)管理核心交换机之间推荐采用直连,用于管理面二层互通。业务核心交换机之间推荐采用直连,用于业务区一个VPC内的VM跨两个站点。

- 3)管理接入交换机仅作为二层接入,管理核心交换机作为管理网的三层网关,配置VRRP。在管理核心交换机上配置了三层网关的网络平面均需要配置VRRP

- 4)Type I场景,双核心组网使用6网口部署,6网口组网简单,分区清晰,两个站点的业务核心交换机都通过管理墙与管理核心交换机连接,部署比较简单。在多出口场景下,每个物理出口需要配置各自的网络节点(每套网络节点2节点起配),每个出口的网络节点业务上没有关系,是两套独立的网络服务节点,网络服务相关的网络平面需要单独规划,不能冲突;在主备出口场景下,只部署一套网络集群,一套网络集群拉远部署在两个站点。

- 5)第三方仲裁站点,建议通过专线直连到两个站点的管理核心交换机。第三方仲裁站点到生产站点、第三方仲裁站点到灾备站点之间,需要分别发布云平台仲裁服务节点的主机路由。云服务、ManageOne、FusionSphere OpenStack都需要访问第三方仲裁站点。

- 6)企业内部接入中仅L3GW支持主备网关的CSHA能力,L2BR不支持主备网关能力。

- 7)如果部署了裸金属服务,裸金属服务只支持部署在一个出口下,且裸金属服务所在出口的管理节点需配置独立业务口,并连接到业务接入交换机。

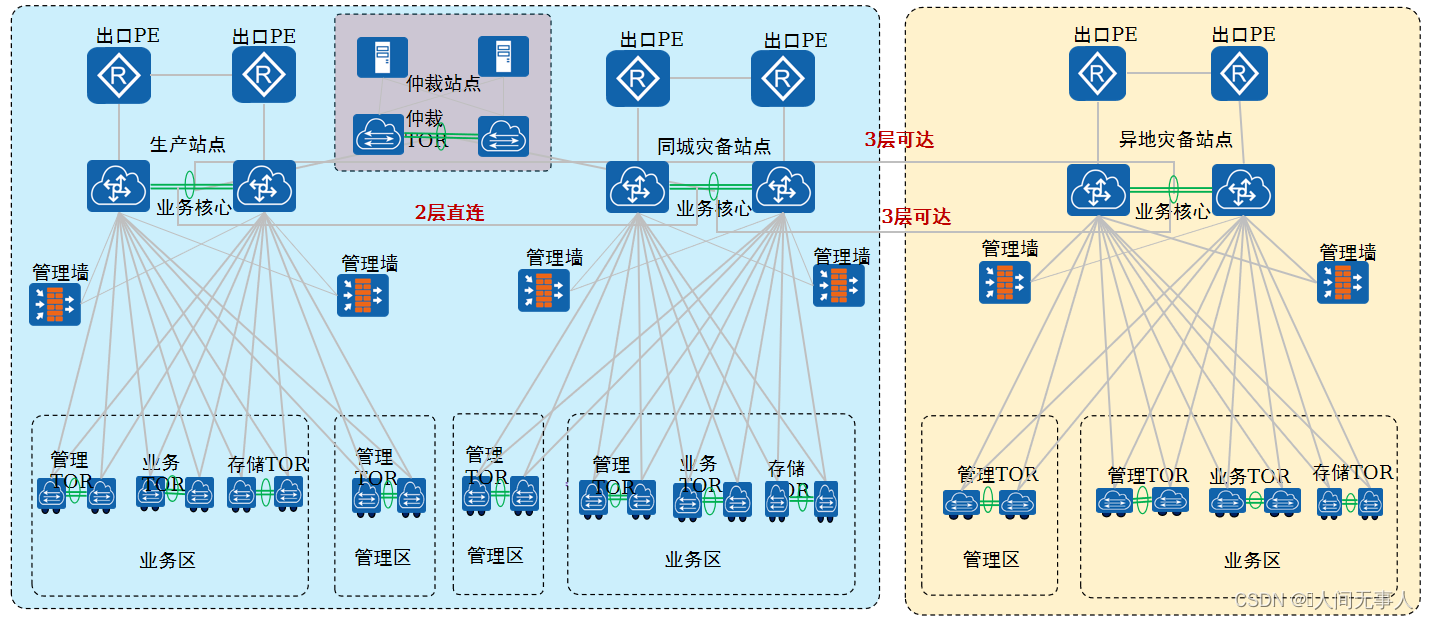

CSHA+CSDR和管理面两地三中心场景拓扑图(单核心)

- 两地三中心场景只能部署IaaS服务,该场景严格受控,暂不支持托管运维长连线场景。

- 1)生产站点与同城灾备站点之间为CSHA和管理面高可用,请参考CSHA和管理面跨AZ高可用组网说明。

- 2)管理面跨Region容灾,需要Region区的管理网络与主备Global区的External_OM和DMZ_Service平面互通。Region间通过配置静态路由实现管理网路互通,其中异地灾备站点到生产站点路由优先级高,异地灾备站点到同城灾备站点路由优先级低。

- 3)CSDR业务面容灾,生产Region和容灾Region的存储复制平面,存储复制平面三层互通即可。生产站点与同城灾备站点间、生产站点与异地灾备站点间需要分别配置存储复制平面三层互通。

- 4)首Region不能部署高阶服务,其他Region可部署高阶服务但高阶服务不具备管理面容灾能力。

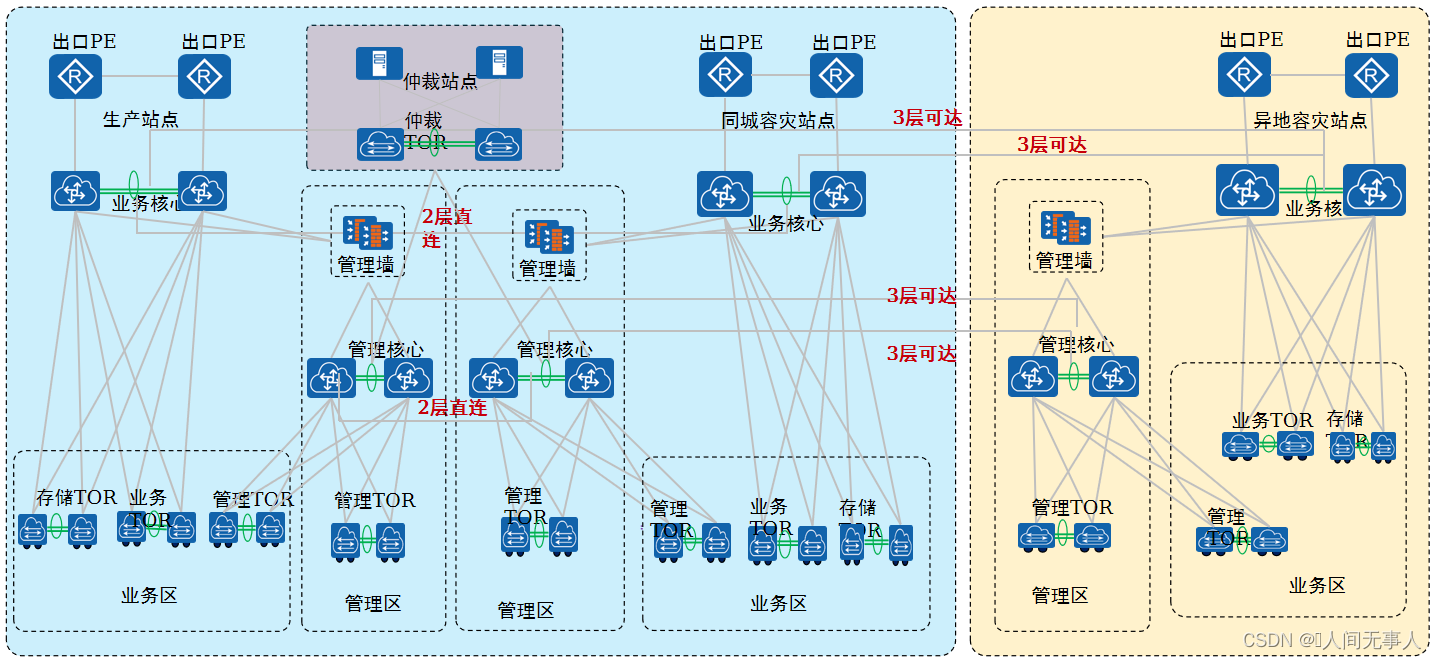

CSHA+CSDR和管理面两地三中心场景拓扑图(双核心)

- 两地三中心场景只能部署IaaS服务,该场景严格受控,暂不支持托管运维长连线场景。

- 1)生产站点与同城灾备站点之间为CSHA和管理面高可用,请参考CSHA和管理面跨AZ高可用组网说明。

- 2)管理面跨Region容灾,需要Region区的管理网络与主备Global区的Cloud_OM和DMZ_Service平面互通。Region间通过配置静态路由实现管理网路互通,其中异地灾备站点到生产站点路由优先级高,异地灾备站点到同城灾备站点路由优先级低。

- 3)CSDR业务面容灾,生产Region和容灾Region的存储复制平面,存储复制平面三层互通即可。生产站点与同城灾备站点间、生产站点与异地灾备站点间需要分别配置存储复制平面三层互通。

- 4)首Region不能部署高阶服务,其他Region可部署高阶服务但高阶服务不具备管理面容灾能力。

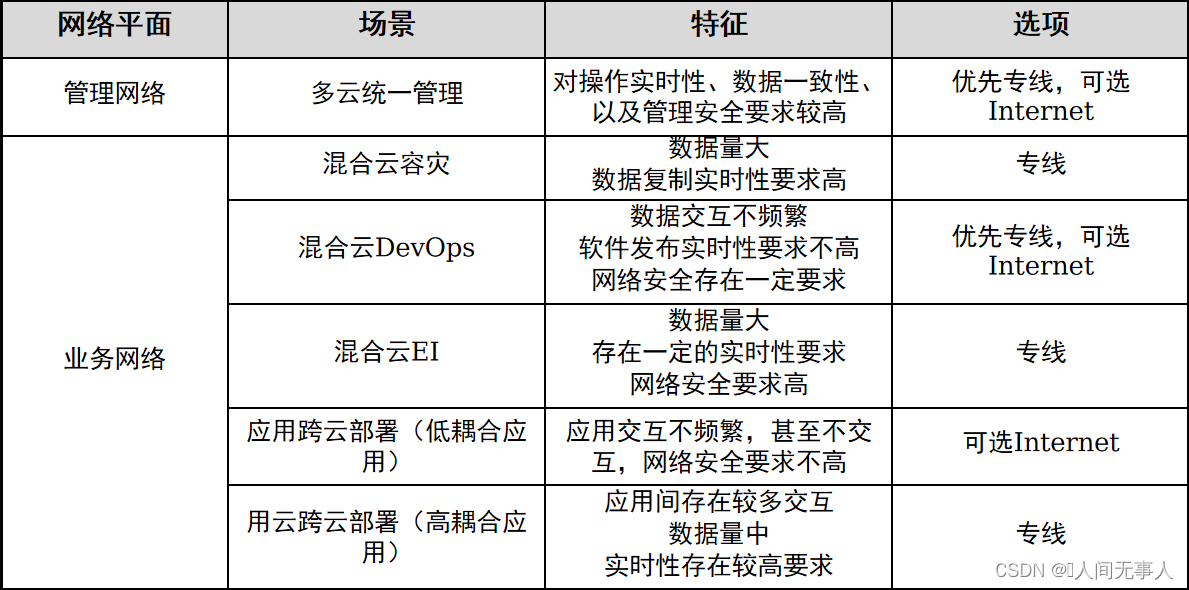

云联邦组网说明

- 云联邦组网主要针对私有云、公有云云间网络,云联邦云间网络包括管理网络和业务网络两个平面。

- 管理平面主要承载云间管理数据,包括认证鉴权、业务管理、运维管理等

- 业务平面主要承载业务交互数据,例如灾备场景的数据同步、业务软件间的接口调用等

- 云联邦云间网络主要有专线和Internet两种建设方式,选型的原则主要考虑4个方面:

- 网络平面

- 管理平面因为其对操作实时性、数据一致性、以及管理安全的要求,通常建议采用专线建设,如果对实时体验及安全要求不严格,也可以采用Internet

- 业务平面则根据业务数据的特征选择,比如灾备场景,同步数据量大,实时性直接决定RPO,因此建议采用专线,而松耦合的应用交互等则可以采用Internet

- 网络平面

- 网络安全

- 根据云间网络的安全要求选择。安全要求高则建议采用专线,并可以配合VPN,否则可以采用Internet并辅助VPN或者Https等

- 网络质量

- 根据云间传递数据的量、时效性对网络质量的要求,如带宽、时延、可靠性等进行选择。网络质量要求高的选择专线,否则可采用Internet

- 网络成本

- 专线相对于Internet意味着更高成本,在预算许可的情况下,尽量选择专线方式以提供更好的业务保障和体验

云联邦云间网络选项建议

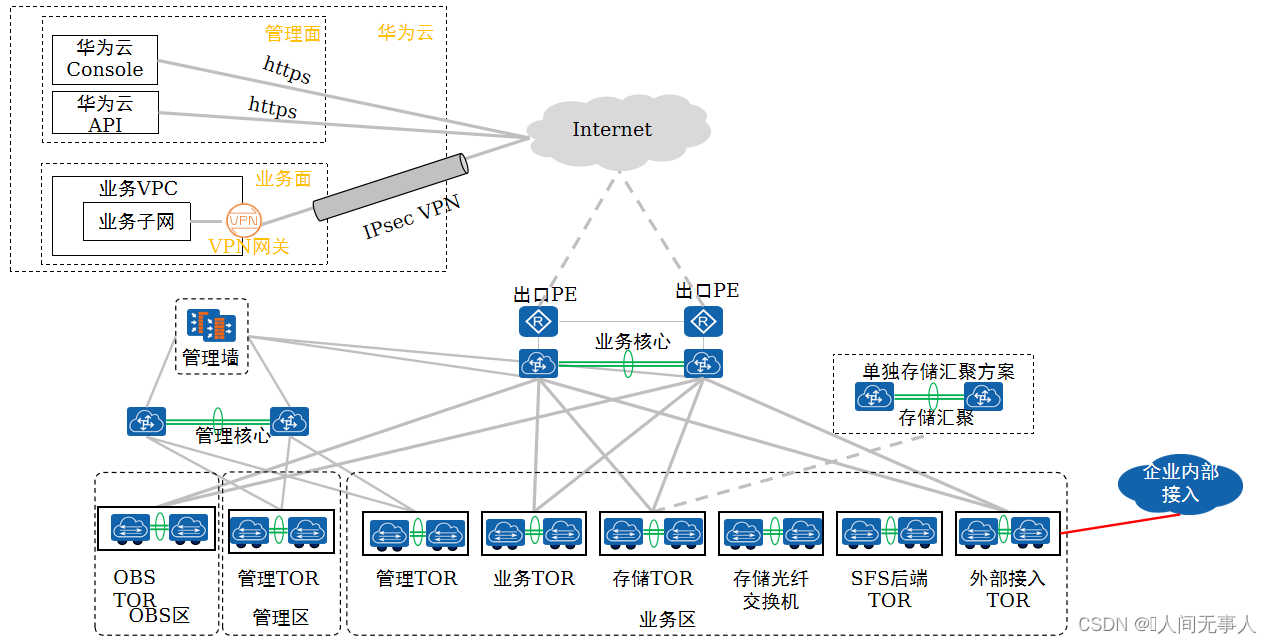

云联邦标准组网 - 仅Internet连接

- 云联邦Internet组网整体说明:

- 数据面 – 私有云侧,TypeI使用HCS 8.0新引入的软网元VPN系统作为VPN网关,TypeII使用业务防火墙作为VPN网关;公有云侧使用业务VPC关联的VPN网关;在私有云VPN网关和公有云VPN网关之间配置双向的IPsec VPN

- 管理面 – 通过https直连华为云的公网服务端点即可

- 问题:目前尚无客户提出对通过Internet直连华为云管理面提出安全顾虑,若客户对此提出安全顾虑,可考虑使用创建一个管理面VPC和VPN网关外加VPCEP连接华为云管理面的私有地址,在向用户推荐此方案前需要验证

云联邦标准组网 - 仅专线连接

- 云联邦专线组网整体说明:

- 物理线路连接 – TypeI从外部接入TOR或业务核心交换机引裸光纤到运营商或华为云的入网点, TypeII从路由直通网络引裸光纤到运营商或华为云的入网点

- 入网点到华为云接入点之间的网络由运营商提供,运营商线路是否使用物理专线或MPLS逻辑专线对云联邦组网方案不造成影响。专线接入目前仅支持配置三层转发,技术上可通过L2BR配置跨云大二层,但尚未确认云联邦场景需求也未进行实际验证。

- 业务面 – 在公有云侧为管理面VPC创建虚拟网关,创建虚拟接口通过指定私有云侧远端网关配置静态路由或者使能BGP动态路由,并通过虚拟接口打通华为云接入点到VPC虚拟网关之间的连接,管理面VPC和业务面VPC通过VPC对等连接互通。私有云侧根据物理连线的位置在外部接入TOR或业务核心交换机上通过指定公有云侧远端网关配置静态路由或使能BGP动态路由。注意:另外一种可选配置是在公有云侧配置两个虚拟接口分别连接管理面和业务面VPC与华为云接入点,但是在这种方案配置复杂、依赖多,需要运营商配置vlan透传,不建议使用。

- 管理面 – 云联邦管理面和业务面共用专线,需要在私有云侧管理墙配置SNAT允许云联邦管理流量通过管理核心到业务核心,让云管理平台相关节点(ManageOne-Service01、ManageOne-Service02、ManageOne-Service03、ManageOne-Service04)能够访问华为云API Gateway,同时云联邦管理面和业务面在专线上可通过VLAN进行隔离。公有云侧使用VPC终端节点(Endpoint)功能连接华为云Console和API,注意目前公有云侧VPCEP仅支持API服务的连接,还不支持Console的连接,需要与公有云部门协作推进,详情可参考国寿云联邦项目材料。公有云侧VPCEP所在的VPC通过VPC对等连接与业务VPC实现互通。

华为云Stack标准化配置、缩略语

看这篇文章

【hcie-cloud】【5】华为云Stack规划设计之华为云Stack标准化配置、缩略语【下】