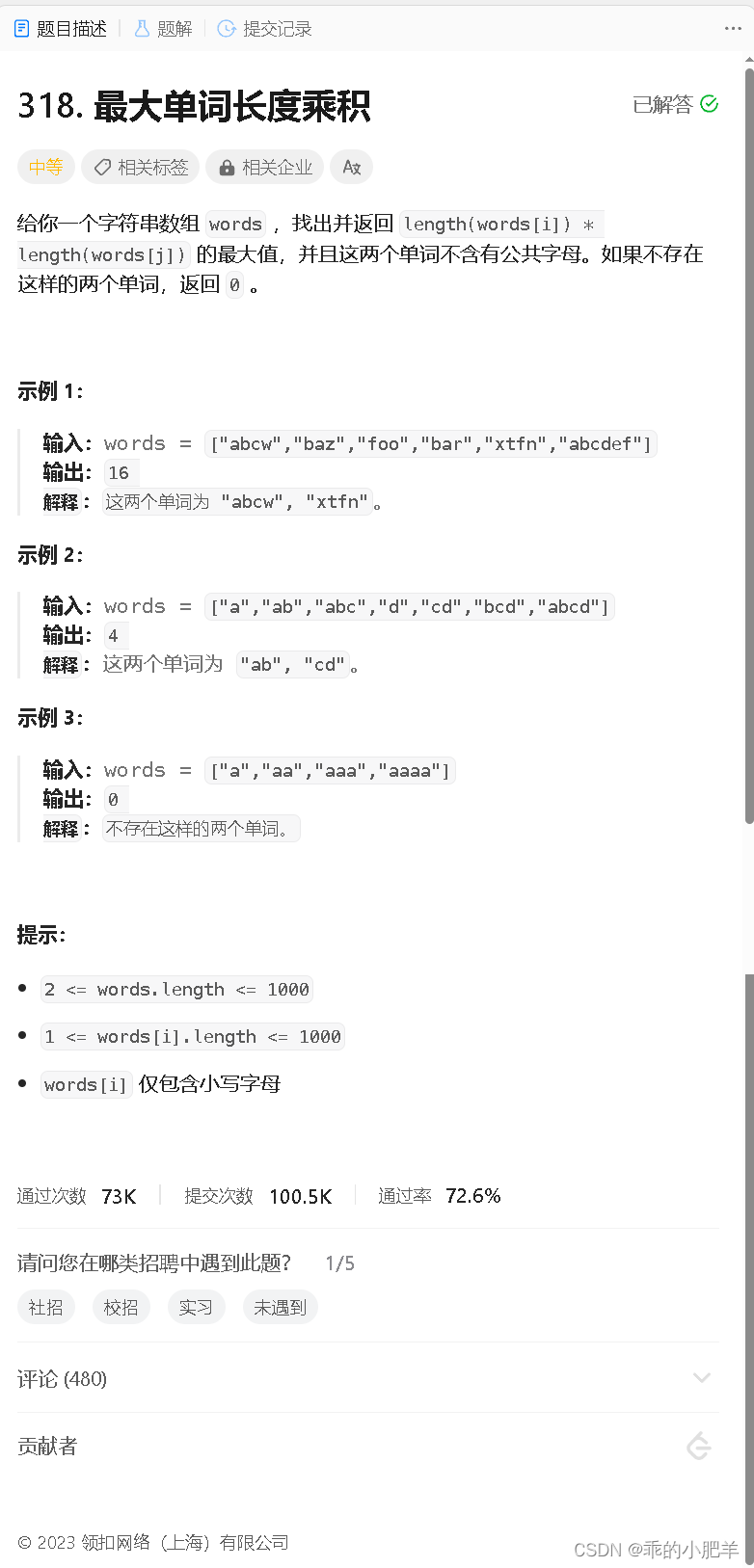

为何LSTM缓解梯度消失问题

为什么LSTM会减缓梯度消失? - 知乎

LSTM引入长短期记忆,cell state和hidden state,解决梯度消失关键是对长期记忆cell state的保留和更新

LSTM解决梯度消失的本质是在Cell state 的更新中引入输入门和遗忘门

![]()

通过输入门,控制何时保留新的候选cell state,保留多少

通过遗忘门,控制何时遗忘上一个cell state,遗忘多少

门控sigmoid的输出值为0~1之间,其导数值范围0~0.25

使得的值不会趋于0和无穷大

NN通过学习改变门控值,改变梯度传递,缓解梯度消失问题

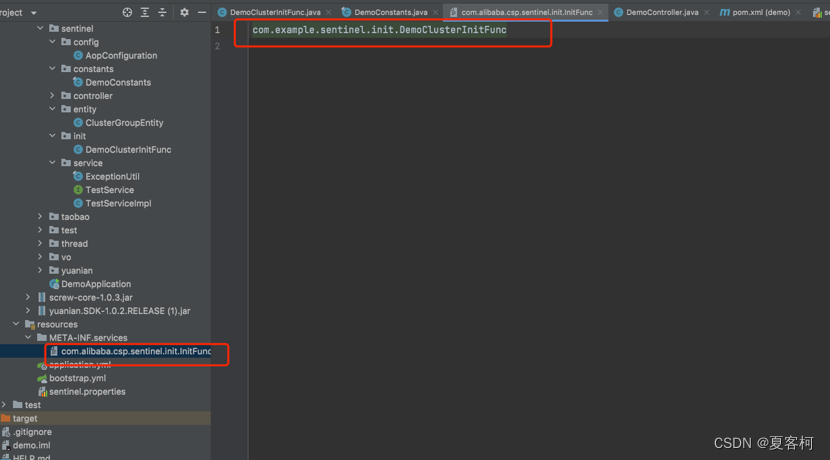

Smerity.com: Explaining and illustrating orthogonal initialization for recurrent neural networks

解释和说明正交初始化的循环神经网络

正交初始化缓解梯度消失和爆炸问题