©PaperWeekly 原创 · 作者 | 夏炎

学校 | 浙江大学

研究方向 | 多模态

论文标题:

Achieving Cross Modal Generalization with Multimodal Unified Representation

模型&代码地址:

https://github.com/haihuangcode/CMG

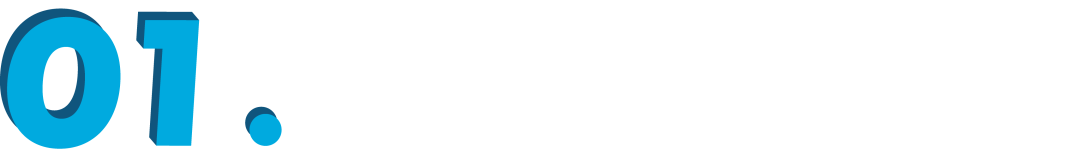

在本文中,我们提出了跨模态泛化任务,旨在将模型从已知模态中学到的知识,迁移到未知模态上,而实现的关键在于通过对大量成对数据的预训练实现多模态统一表达。之前的方法在多模态统一表达领域取得了不错的进展,但是这些方法都是在粗粒度层面进行对齐,或者基于不同模态的信息能够一一对应的前提下。然而在实际情况中,成对的模态很难完全实现完全一致的信息对齐。

因此,我们提出了对偶跨模态信息解偶和多模态 EMA,让不同模态互相作为对方模态的监督信号,将来自不同模态且具有相同语义的信息映射到一起,在细粒度层面上实现多模态输入序列的统一表达。我们在音视频、音频文本,以及甚至在音频-视频-文本三个模态上都进行了统一表达,并在下游实现了各种任务的跨模态泛化,例如跨模态事件分类、定位,跨模态检索,基于查询的视频分割,以及跨数据集的泛化任务。

介绍

随着多模态信息的爆炸性增长,如何处理这些繁杂的信息成为一个急需解决的问题。多模态学习逐渐成为深度学习中一个重要的组成部分,在图像/视频/音视频问答,query-based 图像/视频分割,多模态检索等领域取得了重要的进步。然而,对不同模态的标注难度是不一样的,并且很多标注场景中只能获取少数几个模态,缺乏其他模态,在迁移应用中难免会有很多局限。

然而,成对的无标注的多模态数据往往是容易获得且大量的(例如互联网上存在的大量图像 - caption 对,视频中往往包含了与之对应的音频等)。因此在本文中,我们提出了跨模态泛化,研究如何从这些成对无标注的多模态数据中学到一致性,当下游任务中只有一个模态有标注时,能实现在其他模态中实现的 zero-shot 的性能。

近年来,研究者们开始研究如何在模型中将各种各样的多模态信息映射到统一的语义空间中,这些工作分为隐式映射和显式映射两种。在隐式层面上,一些方法使用一个 modal-agnostic 的 Encoder 来表征不同的模态,然而这些隐式的表达只能在隐空间上将不同的模态靠近,难以解决跨模态泛化任务。

在显式层面上,一些工作开始研究如何用一个统一的 codebook 或者 prototype 来映射不同的模态,但是这些工作只能将模态向量压缩成一个单个向量后再进行映射,或者基于不同模态的信息是完全对齐的假设。然而在更普遍的场景中,不同模态的信息并不是完全对齐的,直接使用之前的方法会导致不属于同一语义的多模态信息被错误的映射到一起。因此,我们这篇文章的重点在于研究如何实现细粒度层面上的多模态序列统一表达。

在这篇工作中,我们将该问题分解为两个要解决的难点:一,如何将不同模态中具有相同语义的信息提取出来,同时避免 modality-specific 信息的干扰;二,如何将这些具有相同语义的不同模态用统一的 codebook 表征。

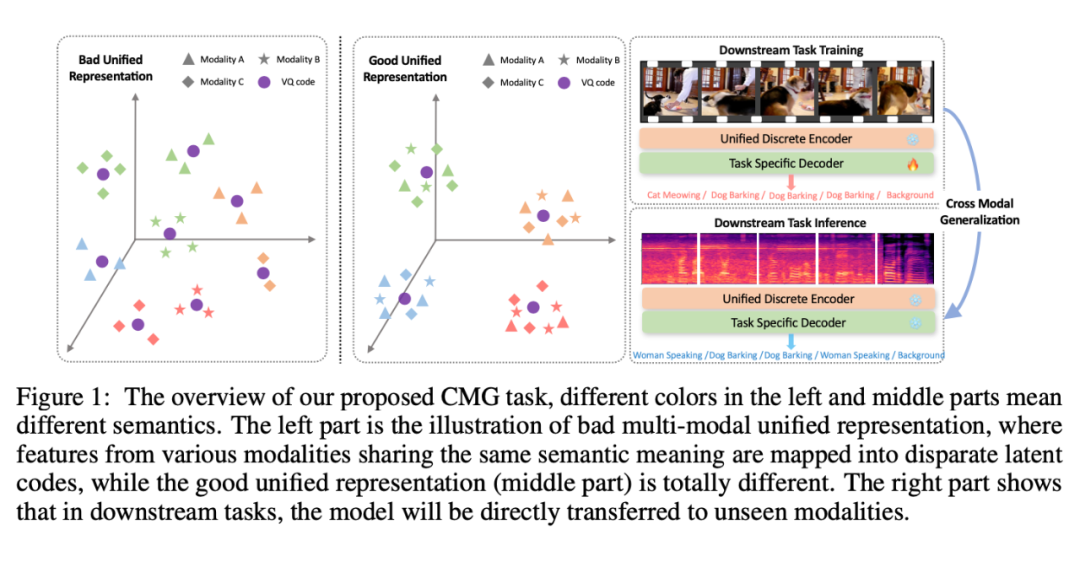

之前的大部分工作都忽略了第一点,在这篇文章中我们证明其对于实现跨模态泛化是非常重要的。我们首先提出了对偶的跨模态解耦,将一个新提出的跨模态 CPC 与互信息最小化(CLUB)相结合。具体来说,我们使用 CLUB 来优化互信息上界,将不同模态中语义相关的信息(表达主要内容或事件的信息)与模态独立的信息(与语义不相关的其他信息,例如视觉中的光照、视角;音频中的音色、音高等)解耦开。

然而,在没有其他指导信息的情况下,模型很难学到哪些是有用的语义信息。受到多模态信息往往具有互相补充指导的启发,我们提出了新颖的跨模态 CPC,可以根据当前模态的已知序列信息,去预测对方模态中的未来信息,实现不同模态之间细粒度的互信息最大化,逐渐提取语义信息并互相靠近。同时,我们还提出了多模态 EMA,利用 teacher-student 机制,让不同模态相互指导,在离散空间中互相靠近,并最终将具有相同语义的不同模态变量收敛到一起。

方法

2.1 基础方法

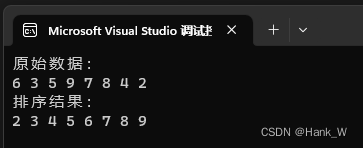

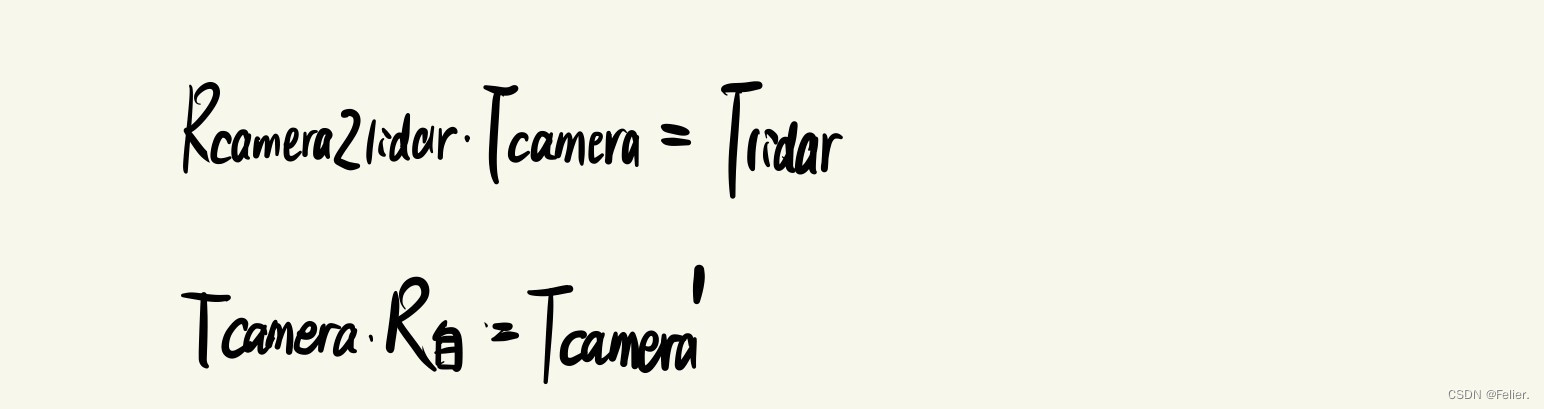

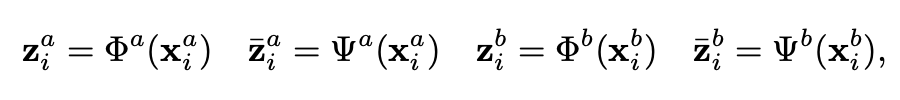

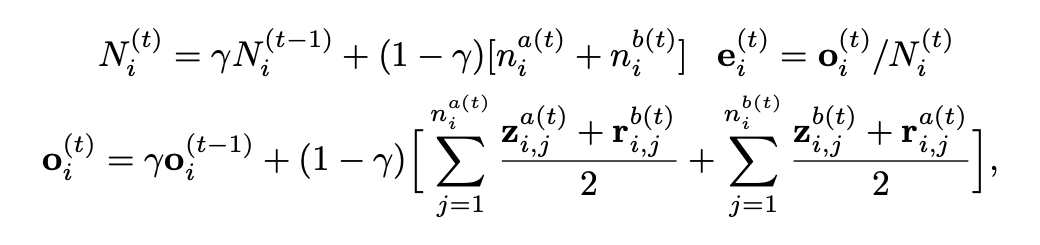

给定两个成对的模态(),我们分别利用两个语义 Encoder( 和 )去提取模态无关特征 ,并利用两个 modal-specific Encoder( 和 )去从两个模态中提取剩余的特征,具体公式为:

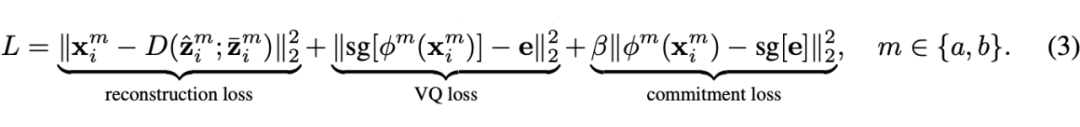

我们对语义特征使用 VQ-VAE 在细粒度层面上对模态信息进行离散化,使用了同一个 codebook,然后我们将离散化后的向量与模态无关向量合并后,重构回原来的特征:

在本文中,我们使用指数平均移动(EMA)来代替 VQ loss,重构 loss 则保证了压缩后的离散变量仍旧具有不同模态的语义信息。但是,在没有监督的情况下,因为 domain gap 导致不同模态的语义特征会收敛到 codebook 中的不同区域,难以实现下游的各种跨模态泛化任务。因此,我们分别提出了以下几个模块来缓解这个问题。

2.2 对偶跨模态信息解耦(DCID)

我们从两个角度来实现我们的 DCID 模块:首先是在每个模态内部将 modal-agnostic semantic features 与 modal-specific features 的互信息最小化(CLUB),其次是对不同模态中 modal-agnostic semantic features 的互信息最大化(Cross-CPC)。

基于CLUB的互信息最小化

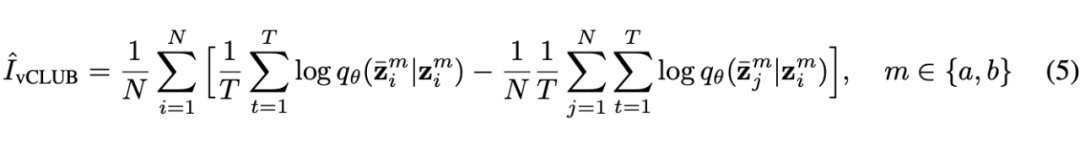

相比于 InfoNCE 和 MINE 等优化互信息下界的方法,CLUB 能够很好的优化互信息的上确界,在信息解偶等领域更有优势。给定语义特征 和 modal-specific 特征 ,我们将原始的 CLUB 改造成时序版本,公式如下:

预训练时,近似网络和主网络交替优化。最后,我们可以减少每种模态中语义信息和模态特定信息之间的相关性。然而,仅仅使用 CLUB 最小化互信息对模型识别相关语义仍旧是不够的。鉴于配对的多模态信息可以提供相互指导并充当彼此的监督信号,我们设计了一个新颖的 Cross-CPC 方法来缓解这个问题。

Cross-CPC

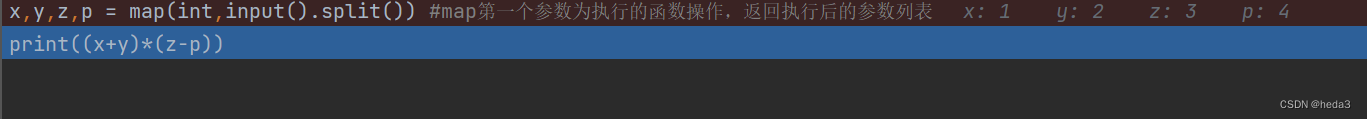

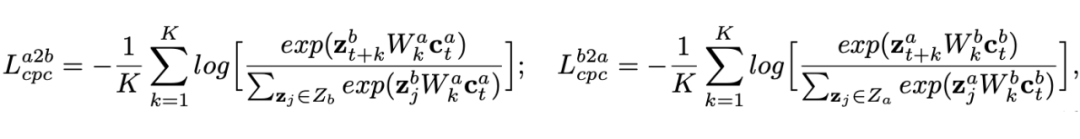

对比学习预测(CPC)被广泛的用于序列特征的自监督训练中,可以通过强大的自回归模型预测序列中未来的 token 与当前 token 的相关性来提取高维特征,之前的工作仅考虑在将 CPC 应用在单模态训练中,然而对于人类来说,我们可以根据当前模态中的已知序列去预测另一个模态中可能发生的情况,因此,我们提出了跨模态 CPC,可以通过这种细粒度的跨模态对比预测将不同模态中相关的语义信息互相提取出来:

3.3 Multi-modal Exponential Moving Average

当不同模态的语义信息被充分解偶出来后,如何能让来自不同模态的具有相同语义的特征映射到同一个离散 code 中,对于实现下游的跨模态泛化任务至关重要。之前的方法难以解决这种 unconstrained 细粒度的跨模态对齐,因此我们提出了一个多模态 EMA 方法,能够让不同模态在离散化过程中,互相作为 teacher-student 迭代更新,最终收敛到一起。

首先我们使用 Cross-Attention 将对方模态中相关的信息,引入到当前模态中,以模态A为例:,其中 是 query, 是 key 和 value。向量 包含从 中得出的语义信息,与 有强烈的相关性,同时也保留了模式 B 的内在属性。因此,它可以在 EMA 过程中作为一个中介,促进模态A与模态 B 的对齐。

给定一个 codebook 中的离散变量 ,我们可以获取 个模态 A 中跟其相关的 semantic vectors 以及 个模态 B 中跟其相关的 semantic vectors ,MM-EMA 的公式如下所示:

最终的预训练阶段 Total loss 为:

实验

当预训练结束后,我们获得了一个多模态通用的 codebook,以及能将这些模态映射到该离散空间的对应模态的编码器,在下游任务中,我们利用预训练得到的编码器和 codebook,只对一种模态进行训练,然后让将训练得到的模型零样本的迁移到其他未知模态中进行测试。

3.1 测试任务

跨模态事件分类:在 AVE 中,每个视频都包含一个在音频和视觉信息中都存在的主要事件。因此,我们可以使用单一模式(例如,视频)来训练一个事件分类器,并直接评估该分类器在另一种模式(例如,音频)上的性能。

跨模态事件定位:在 AVVP 中,部分数据被标注了音频和视觉模式的细粒度事件标签。类似于 AVE,我们可以在一个模式上进行事件定位,然后直接将模型转移到另一个模式进行测试。

跨模态视频分类:在 AVS 中,每一份 AVS 数据包含一段音频,发出声音的物体的视频片段,与物体相对应的文本标签,以及人工标记的 mask。我们将每个文本标签扩展为一句描述性的句子。我们使用一种模式(例如,音频)来训练基于查询的视频分割,并直接在另一种模式(例如,文本)中测试分割能力。

跨模态检索:我们选择检索任务来证明我们的方法也可以应用于视觉-文本的泛化。我们使用音频作为一个媒介来衡量我们的模型在这两种模态之间的泛化能力,并做了一个任意模态到音频的检索任务。具体来说,在第一阶段,我们使用 VGGSound24K 数据集进行视觉-文本统一表示学习,然后在第二阶段,在下游训练期间,我们让模型学习文本(视频)-音频检索,最后在推理期间,我们直接测试模型在视频(文本)-音频检索上的泛化能力。

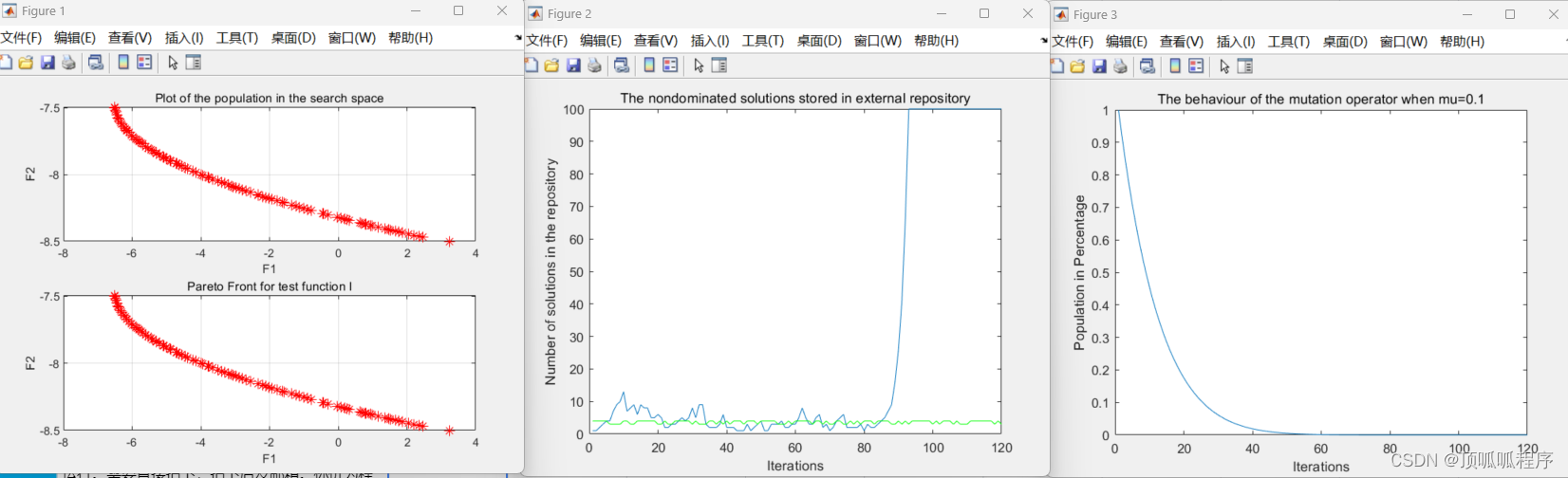

3.2 实验结果

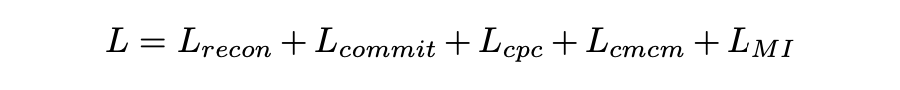

在 AVE 和 AVVP 中的跨模态泛化能力:Baseline 的结果说明了如果不加任何限制的话,模型很难在预训练中学到不同模态的对齐关系,导致在下游的实验效果跟不用预训练相比差不多。同时,实验结果也显示,单纯的使用这些方法在这种无限制的细粒度音视频对齐中,会有很大的局限,而当加上我们提出的 DCID 后,这些模型在下游任务上的表现有了一个很大的提升。

这进一步说明了我们提出的 DCID 可以有效的将不同模态的语义信息解偶出来,帮助预训练过程中的多模态对齐。同时,与之前最先进的方法 CMCM 相比,我们的方法也可以大幅领先,并且当预训练数据较少时,我们的方法优势越大。

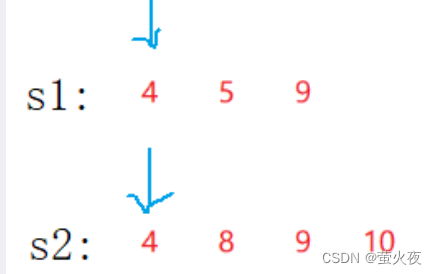

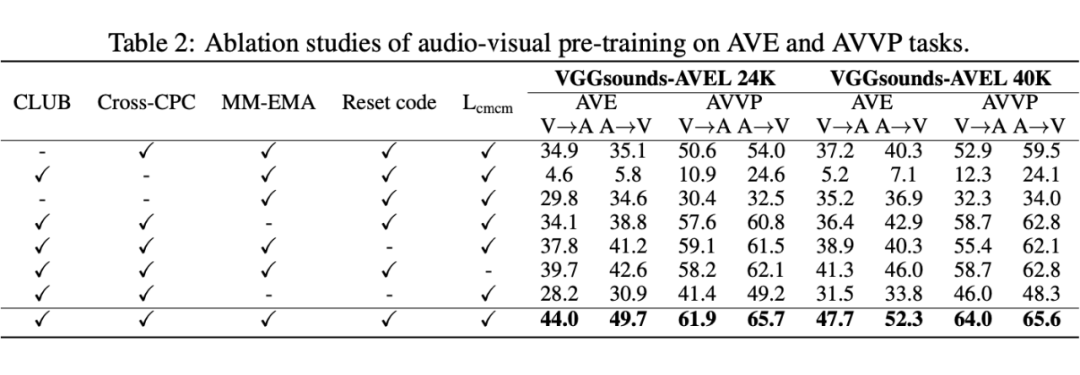

对我们所提出一些关键模块的消融实验:首先我们以音视频的统一表达为例,测试了当移除模型的主要部件之后,模型在下游的 AVE 和 AVVP 任务上的表现情况,结果如表 2 所示。我们可以看到,当移除了这些部件之后模型的性能都有下降。在 DCID 模块中,去除 Cross-CPC 的影响要远远大于去除 CLUB 的影响,这说明如果没有 Cross-CPC 提供细粒度的跨模态对齐约束的情况下,单纯使用 CLUB 很难从原模态特征中提取出有效的语义信息。

当移除 MM-EMA 之后,模型性能也下降较多,证明了 MM-EMA 可以有效的利用 Cross-Attention,将不同模态的相关信息逐步映射到一起,帮助实现统一表达。而去除 reset code 的实验结果表明该模块可以有效去除 MM-EMA 导致的 code 多余,缓解 VQ-VAE 中的 codebook collapse 问题。最后,当移除 L_cmcm 后模型性能也会有小幅下降,说明了该模块的有效性,可以帮助我们的模型实现统一表达。

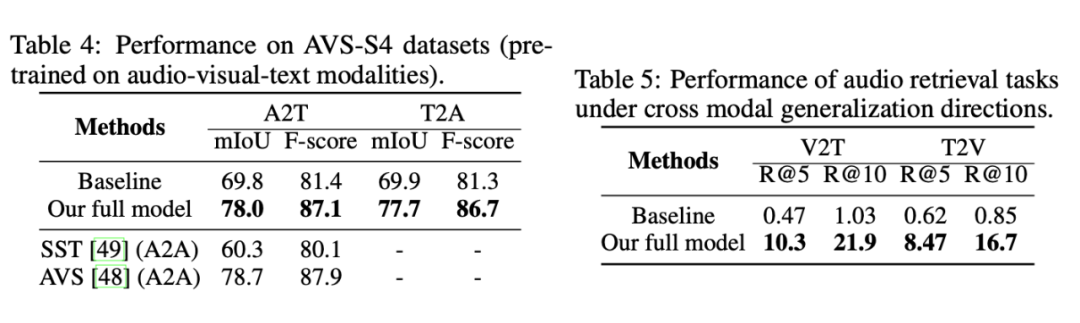

在跨模态视频分割以及跨模态检索中的实验结果:

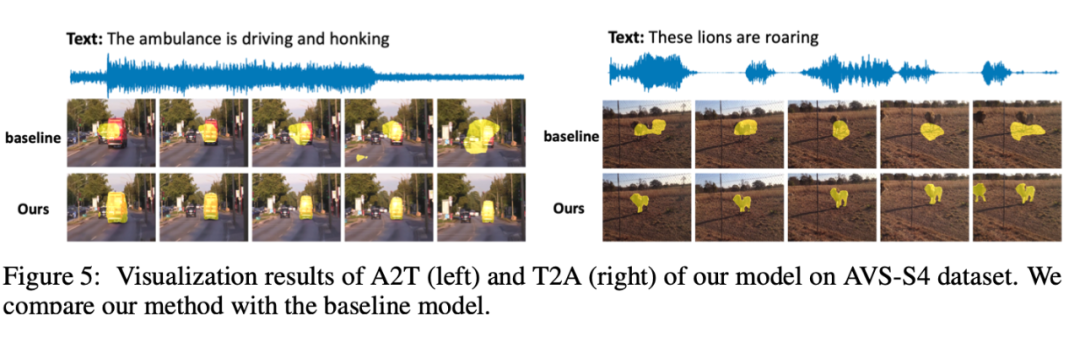

跨模态分割的可视化结果:

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·