不涉及太多原理

VGG在2014年由牛津大学著名研究组VGG (Visual Geometry Group) 提出,斩获该年ImageNet竞赛中

Localization Task (定位任务) 第一名 和 Classification Task (分类任务) 第二名。

网络亮点:

1.通过堆叠多个3x3的卷积核来替代大尺度卷积核(减少所需参数)

通过堆叠两个3x3的卷积核替代5x5的卷积核,堆叠三个3x3的卷积核替代7x7的卷积核。

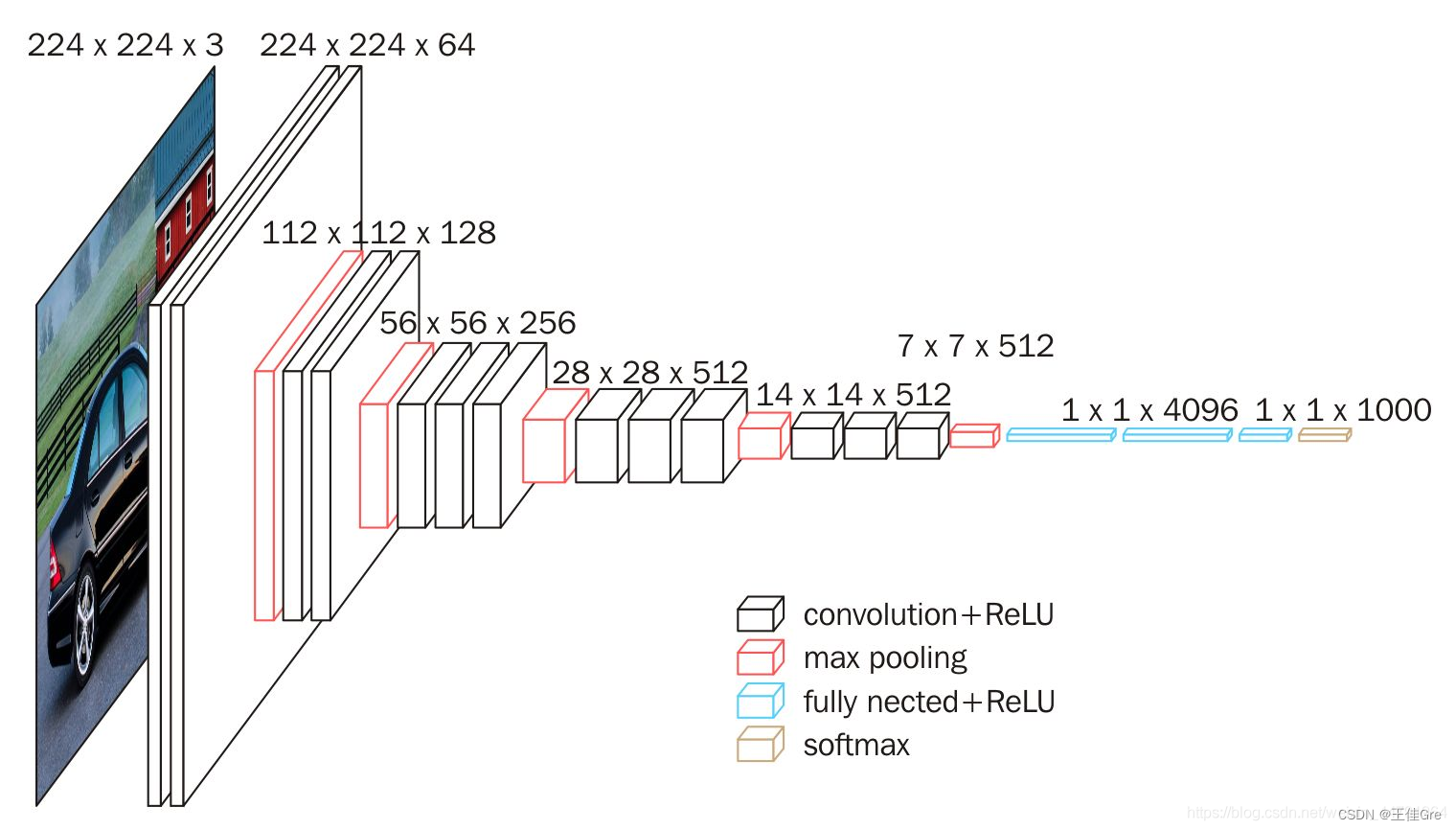

网络结构:

VGG16由三种不同的层组成,分别是卷积层、最大池化层、全连接层。

VGG16的具体执行方式如下:

1、一张原始图片被resize到(224,224,3)。

2、conv1:进行两次[3,3]卷积网络,输出的特征层为64,输出为(224,224,64),再进行2X2最大池化,输出net为(112,112,64)。

3、conv2:进行两次[3,3]卷积网络,输出的特征层为128,输出net为(112,112,128),再进行2X2最大池化,输出net为(56,56,128)。

4、conv3:进行三次[3,3]卷积网络,输出的特征层为256,输出net为(56,56,256),再进行2X2最大池化,输出net为(28,28,256)。

5、conv4:进行三次[3,3]卷积网络,输出的特征层为512,输出net为(28,28,512),再进行2X2最大池化,输出net为(14,14,512)。

6、conv5:进行三次[3,3]卷积网络,输出的特征层为512,输出net为(14,14,512),再进行2X2最大池化,输出net为(7,7,512)。

7、对结果进行平铺。

8、进行两次神经元为4096的全连接层。

8、全连接到1000维上,用于进行分类。

代码

Model

#model.py

import torch.nn as nn

import torch

class VGG(nn.Module):

def __init__(self, features, num_classes=1000, init_weights=False):

super(VGG, self).__init__()

self.features = features

self.classifier = nn.Sequential(

nn.Dropout(p=0.5),

nn.Linear(512*7*7, 4096),

nn.ReLU(True),

nn.Dropout(p=0.5),

nn.Linear(4096, 4096),

nn.ReLU(True),

nn.Linear(4096, num_classes)

)

if init_weights:

self._initialize_weights()

def forward(self, x):

# N x 3 x 224 x 224

x = self.features(x)

# N x 512 x 7 x 7

x = torch.flatten(x, start_dim=1)

# N x 512*7*7

x = self.classifier(x)

return x

def _initialize_weights(self):

for m in self.modules():

if isinstance(m, nn.Conv2d):

# nn.init.kaiming_normal_(m.weight, mode='fan_out', nonlinearity='relu')

nn.init.xavier_uniform_(m.weight)

if m.bias is not None:

nn.init.constant_(m.bias, 0)

elif isinstance(m, nn.Linear):

nn.init.xavier_uniform_(m.weight)

# nn.init.normal_(m.weight, 0, 0.01)

nn.init.constant_(m.bias, 0)

def make_features(cfg: list):

layers = []

in_channels = 3

for v in cfg:

if v == "M":

layers += [nn.MaxPool2d(kernel_size=2, stride=2)]

else:

conv2d = nn.Conv2d(in_channels, v, kernel_size=3, padding=1)

layers += [conv2d, nn.ReLU(True)]

in_channels = v

return nn.Sequential(*layers)

cfgs = {

'vgg11': [64, 'M', 128, 'M', 256, 256, 'M', 512, 512, 'M', 512, 512, 'M'],

'vgg13': [64, 64, 'M', 128, 128, 'M', 256, 256, 'M', 512, 512, 'M', 512, 512, 'M'],

'vgg16': [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 'M', 512, 512, 512, 'M', 512, 512, 512, 'M'],

'vgg19': [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 256, 'M', 512, 512, 512, 512, 'M', 512, 512, 512, 512, 'M'],

}

def vgg(model_name="vgg16", **kwargs):

try:

cfg = cfgs[model_name]

except:

print("Warning: model number {} not in cfgs dict!".format(model_name))

exit(-1)

model = VGG(make_features(cfg), **kwargs)

return model

train:

import torch.nn as nn

from torchvision import transforms, datasets

import json

import os

import torch.optim as optim

from model import vgg

import torch

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

print(device)

data_transform = {

"train": transforms.Compose([transforms.RandomResizedCrop(224),

transforms.RandomHorizontalFlip(),

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))]),

"val": transforms.Compose([transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])}

data_root = os.path.abspath(os.path.join(os.getcwd(), "../..")) # get data root path

image_path = data_root + "/NET/data_set/flower_data/" # flower data set path

train_dataset = datasets.ImageFolder(root=image_path+"train",

transform=data_transform["train"])

train_num = len(train_dataset)

# {'daisy':0, 'dandelion':1, 'roses':2, 'sunflower':3, 'tulips':4}

flower_list = train_dataset.class_to_idx

cla_dict = dict((val, key) for key, val in flower_list.items())

# write dict into json file

json_str = json.dumps(cla_dict, indent=4)

with open('class_indices.json', 'w') as json_file:

json_file.write(json_str)

batch_size = 9

train_loader = torch.utils.data.DataLoader(train_dataset,

batch_size=batch_size, shuffle=True,

num_workers=0)

validate_dataset = datasets.ImageFolder(root=image_path + "val",

transform=data_transform["val"])

val_num = len(validate_dataset)

validate_loader = torch.utils.data.DataLoader(validate_dataset,

batch_size=batch_size, shuffle=False,

num_workers=0)

# test_data_iter = iter(validate_loader)

# test_image, test_label = test_data_iter.next()

model_name = "vgg16"

net = vgg(model_name=model_name, num_classes=6, init_weights=True)

net.to(device)

loss_function = nn.CrossEntropyLoss()

optimizer = optim.Adam(net.parameters(), lr=0.0001)

best_acc = 0.0

save_path = './{}Net.pth'.format(model_name)

for epoch in range(30):

# train

net.train()

running_loss = 0.0

for step, data in enumerate(train_loader, start=0):

images, labels = data

optimizer.zero_grad()

outputs = net(images.to(device))

loss = loss_function(outputs, labels.to(device))

loss.backward()

optimizer.step()

# print statistics

running_loss += loss.item()

# print train process

rate = (step + 1) / len(train_loader)

a = "*" * int(rate * 50)

b = "." * int((1 - rate) * 50)

print("\rtrain loss: {:^3.0f}%[{}->{}]{:.3f}".format(int(rate * 100), a, b, loss), end="")

print()

# validate

net.eval()

acc = 0.0 # accumulate accurate number / epoch

with torch.no_grad():

for val_data in validate_loader:

val_images, val_labels = val_data

optimizer.zero_grad()

outputs = net(val_images.to(device))

predict_y = torch.max(outputs, dim=1)[1]

acc += (predict_y == val_labels.to(device)).sum().item()

val_accurate = acc / val_num

if val_accurate > best_acc:

best_acc = val_accurate

torch.save(net.state_dict(), save_path)

print('[epoch %d] train_loss: %.3f test_accuracy: %.3f' %

(epoch + 1, running_loss / step, val_accurate))

print('Finished Training')

# 以下是上述训练循环的主要步骤,分成几个关键点列出算法流程:

# 关键点 1: 模型和训练参数的初始化

# 1.初始化模型名称 model_name 和类别数 num_classes。

# 2.创建 VGG16 模型,设置模型为 model_name,并选择是否使用预训练权重。

# 3.将模型移动到 GPU(如果可用)。

# 4.定义损失函数为交叉熵损失。

# 5.定义优化器为 Adam,并设置学习率。

# 关键点 2: 训练循环

# 6.初始化变量 best_acc 用于记录最佳验证准确率,以及 save_path 用于保存最佳模型的权重。

# 7.开始循环训练模型,共进行 30 个训练周期。

# 关键点 3: 训练数据加载和迭代

# 8.将模型设置为训练模式,启用 dropout 和批规范化等训练特定的操作。

# 9.初始化变量 running_loss 用于跟踪当前训练周期的总损失。

# 10.使用训练数据加载器 train_loader 迭代训练数据批次。

# 11.对每个批次执行以下步骤:

# 12.将输入数据 images 和标签 labels 移动到 GPU(如果可用)。

# 13.清零优化器的梯度。

# 14.通过模型前向传播计算输出。

# 15.计算损失(交叉熵损失)。

# 16.反向传播梯度,并使用优化器来更新模型的权重。

# 17.跟踪并累加当前批次的损失值。

# 关键点 4: 训练进度显示

# 18.在训练过程中,通过打印信息来显示训练进度,包括当前批次的训练进度和损失。

# 关键点 5: 验证模型

# 19.将模型设置为评估模式,禁用 dropout 和批规范化等训练特定的操作。

# 20.初始化变量 acc 用于累积验证集的准确数目。

# 21.使用验证数据加载器 validate_loader 迭代验证数据批次。

# 22.对每个验证批次执行以下步骤:

# 23.将输入数据 val_images 和标签 val_labels 移动到 GPU(如果可用)。

# 24.清零优化器的梯度。

# 25.通过模型前向传播计算输出。

# 26.预测每个样本的类别。

# 27.计算当前批次中模型正确分类的样本数量并累积到 acc 中。

# 关键点 6: 保存最佳模型

# 28.如果当前验证准确率 val_accurate 高于之前的最佳准确率 best_acc,则更新 best_acc。

# 29.保存模型的权重到文件 save_path,以便在之后使用最佳模型。

# 关键点 7: 输出训练结果

# 30.在每个训练周期结束后,输出当前训练周期的训练损失和验证集准确率。

# 31.继续下一个训练周期,直到完成 30 个周期。

# 关键点 8: 训练结束

# 32.在所有训练周期完成后,输出 "Finished Training" 表示训练已完成。

# 这个算法流程用于训练一个深度学习模型,具体是一个VGG16模型,用于图像分类任务。该流程迭代多个训练周期,通过计算损失和验证集准确率来监视模型的性能,并保存最佳模型的权重。

val

import torch

from model import vgg

from PIL import Image

from torchvision import transforms

import matplotlib.pyplot as plt

import json

data_transform = transforms.Compose(

[transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])

# load image

img = Image.open("")

plt.imshow(img)

# [N, C, H, W]

img = data_transform(img)

# expand batch dimension

img = torch.unsqueeze(img, dim=0)

# read class_indict

try:

json_file = open('./class_indices.json', 'r')

class_indict = json.load(json_file)

except Exception as e:

print(e)

exit(-1)

# create model

model = vgg(model_name="vgg16", num_classes=6)

# load model weights

model_weight_path = "./vgg16Net.pth"

model.load_state_dict(torch.load(model_weight_path))

model.eval()

with torch.no_grad():

# predict class

output = torch.squeeze(model(img))

predict = torch.softmax(output, dim=0)

predict_cla = torch.argmax(predict).numpy()

print(class_indict[str(predict_cla)],predict[predict_cla].numpy())

plt.show()