AI视野·今日CS.NLP 自然语言处理论文速览

Mon, 16 Oct 2023

Totally 53 papers

👉上期速览✈更多精彩请移步主页

Daily Computation and Language Papers

| PromptRE: Weakly-Supervised Document-Level Relation Extraction via Prompting-Based Data Programming Authors Chufan Gao, Xulin Fan, Jimeng Sun, Xuan Wang 关系提取旨在将两个实体之间的关系分类为预先定义的类别。虽然以前的研究主要集中在句子级关系提取,但最近的研究已将范围扩展到文档级关系提取。传统的关系抽取方法严重依赖人工标注的训练数据,耗时耗力。为了减轻手动注释的需要,最近开发了用于句子级关系提取的弱监督方法,而在文档级关系提取方面做了有限的工作。由于无关系实例数量不平衡以及直接探测用于文档关系提取的预训练大型语言模型的失败,弱监督文档级关系提取面临着重大挑战。为了应对这些挑战,我们提出了 PromptRE,一种新颖的弱监督文档级关系提取方法,它将基于提示的技术与数据编程相结合。此外,PromptRE 将标签分布和实体类型作为先验知识结合起来,以提高性能。通过利用提示和数据编程的优势,PromptRE 提高了关系分类的性能,并有效地处理了无关系问题。 |

| Table-GPT: Table-tuned GPT for Diverse Table Tasks Authors Peng Li, Yeye He, Dror Yashar, Weiwei Cui, Song Ge, Haidong Zhang, Danielle Rifinski Fainman, Dongmei Zhang, Surajit Chaudhuri GPT 3.5 和 ChatGPT 等语言模型展示了遵循不同人类指令并执行各种任务的卓越能力。然而,当使用一系列基本表格理解任务探索语言模型时,我们观察到当今的语言模型在许多表格相关任务中仍然不是最优的,可能是因为它们主要是在 emph 一维自然语言文本上进行预训练的,而关系表 |

| Political claim identification and categorization in a multilingual setting: First experiments Authors Urs Zaberer, Sebastian Pad , Gabriella Lapesa 政治主张的识别和分类是分析政治报纸报道的重要一步,然而,用于这项任务的资源却很少。本文探讨了政治主张分析的跨语言投影的不同策略。我们在德国数据集 DebateNet2.0 上进行实验,涵盖 2015 年难民危机引发的政策辩论。 |

| Precedent-Enhanced Legal Judgment Prediction with LLM and Domain-Model Collaboration Authors Yiquan Wu, Siying Zhou, Yifei Liu, Weiming Lu, Xiaozhong Liu, Yating Zhang, Changlong Sun, Fei Wu, Kun Kuang 法律判决预测LJP已成为法律人工智能中越来越重要的任务,即根据案件事实描述来预测案件的判决。判例是指先前发生的具有类似事实的法律案件,是各国法律体系中后续案件判断的依据。因此,值得探讨 LJP 中先例的利用。深度学习的最新进展使得多种技术可用于解决 LJP 任务。这些可以分为两类:大型语言模型 LLM 和特定领域模型。法学硕士能够解释和生成复杂的自然语言,而领域模型可以有效地学习任务特定信息。在本文中,我们提出了先例增强的 LJP 框架 PLJP,该系统在先例的背景下利用了 LLM 和领域模型的优势。具体来说,领域模型旨在提供候选标签并有效地找到适当的先例,而大型模型将通过上下文先例理解来做出最终预测。对现实世界数据集的实验证明了我们的 PLJP 的有效性。 |

| BanglaNLP at BLP-2023 Task 2: Benchmarking different Transformer Models for Sentiment Analysis of Bangla Social Media Posts Authors Saumajit Saha, Albert Nanda 孟加拉语是全球第七大使用最广泛的语言,其母语人数达到惊人的 2.34 亿,主要来自印度和孟加拉国。这种形态丰富的语言拥有丰富的文学传统,涵盖多种方言和语言特定的挑战。尽管孟加拉语语言丰富且历史悠久,但它在自然语言处理 NLP 和语音社区中仍然被归类为低资源语言。本文介绍了我们提交给 BLP 研讨会的任务 2 孟加拉社交媒体帖子的情绪分析。我们尝试使用各种基于 Transformer 的架构来解决此任务。我们的定量结果表明,迁移学习确实有助于在这种低资源语言场景中更好地学习模型。当我们进一步微调已经在 Twitter 数据上进行情感分析任务微调的模型时,这一点变得很明显,并且微调后的模型在所有其他模型中表现最好。我们还进行了详细的错误分析,其中我们发现了一些需要重新检查真实标签的情况。 |

| Automated Claim Matching with Large Language Models: Empowering Fact-Checkers in the Fight Against Misinformation Authors Eun Cheol Choi, Emilio Ferrara 在当今的数字时代,错误信息的迅速传播对公众福祉和社会信任构成威胁。随着网上错误信息的激增,事实核查人员的手动验证变得越来越具有挑战性。我们引入了 FACT GPT 事实检查增强与声明匹配任务导向的生成预训练 Transformer,这是一个旨在使用大型语言模型 LLM 自动化事实检查的声明匹配阶段的框架。该框架识别出新的社交媒体内容,这些内容要么支持要么反驳先前被事实核查人员揭穿的主张。我们的方法采用 GPT 4 生成由模拟社交媒体帖子组成的标记数据集。该数据集可作为微调更专业的法学硕士的训练场。我们在与公共卫生相关的社交媒体内容的广泛数据集上评估了 FACT GPT。结果表明,我们经过微调的法学硕士在权利要求匹配任务中的性能可与大型预训练法学硕士相媲美,与人工注释紧密结合。 |

| "Kelly is a Warm Person, Joseph is a Role Model": Gender Biases in LLM-Generated Reference Letters Authors Yixin Wan, George Pu, Jiao Sun, Aparna Garimella, Kai Wei Chang, Nanyun Peng 随着生成语言模型的进步,用户已经开始利用大型语言模型法学硕士来协助编写各种类型的内容,包括推荐信等专业文档。尽管它们很方便,但这些应用程序带来了前所未有的公平问题。由于生成的推荐信可能会被用户直接用于专业或学术场景,因此有可能造成直接的社会危害,例如降低女性申请者的成功率。因此,迫在眉睫且有必要全面研究此类现实世界用例中的公平问题和相关危害,以便将来缓解和监控。在本文中,我们批判性地研究了法学硕士生成的推荐信中的性别偏见。受社会科学发现的启发,我们设计了评估方法,通过语言风格的二维偏差和词汇内容的偏差来体现法学硕士生成的信件中的性别偏差。此外,我们通过单独分析模型幻觉内容中的偏差放大来研究偏差传播的程度,我们将其定义为模型生成文档的幻觉偏差。通过对 ChatGPT、Alpaca、Vicuna 和 StableLM 等 4 个热门法学硕士进行基准评估,我们的研究揭示了法学硕士生成的推荐信中存在显着的性别偏见。 |

| Explore-Instruct: Enhancing Domain-Specific Instruction Coverage through Active Exploration Authors Fanqi Wan, Xinting Huang, Tao Yang, Xiaojun Quan, Wei Bi, Shuming Shi 通过增强多样性可以大幅优化指令调整,从而使模型能够处理更广泛的任务。然而,用于此类调整的现有数据通常表现出对各个领域的覆盖不足,限制了这些领域内细致入微的理解和交互的范围。为了解决这一缺陷,我们提出了 Explore Instruct,这是一种通过大型语言模型 LLM 进行主动探索来增强数据覆盖范围的新方法,可用于特定领域的指令调整。 Explore Instruct 基于代表性的领域用例,通过实施搜索算法来探索多种变化或可能性,以获得多样化且以领域为中心的指令调优数据。我们以数据为中心的分析验证了所提出的方法在提高特定领域指令覆盖范围方面的有效性。此外,我们的模型的性能在多个基线上显示出相当大的进步,包括那些利用领域特定数据增强的基线。我们的研究结果为提高教学覆盖率提供了一个有希望的机会,特别是在特定领域的上下文中,从而推动适应性语言模型的开发。 |

| Developing a Natural Language Understanding Model to Characterize Cable News Bias Authors Seth P. Benson, Iain J. Cruickshank 社会科学和计算科学都对媒体偏见进行了广泛的研究。然而,当前的工作仍然在很大程度上依赖于人类输入和主观评估来标记偏差。对于有线新闻研究来说尤其如此。为了解决这些问题,我们开发了一种无监督机器学习方法来表征有线新闻节目的偏见,而无需任何人工输入。该方法依赖于对通过命名实体识别提到的主题以及如何通过立场分析讨论这些主题进行分析,以便将具有相似偏见的程序聚集在一起。将我们的方法应用于 2020 年有线新闻记录,我们发现节目簇随着时间的推移是一致的,并且大致对应于节目的有线新闻网络。 |

| BibRank: Automatic Keyphrase Extraction Platform Using~Metadata Authors Abdelrhman Eldallal, Eduard Barbu 自动关键短语提取涉及识别文档中的基本短语。这些关键词在文档分类、聚类、推荐、索引、搜索、摘要和文本简化等各种任务中至关重要。本文介绍了一个集成关键短语数据集并促进关键短语提取算法评估的平台。该平台包括 BibRank,这是一种自动关键短语提取算法,该算法利用通过解析 BibTeX 格式的书目数据获得的丰富数据集。 BibRank 将创新的加权技术与位置、统计和单词共现信息相结合,从文档中提取关键短语。 |

| PuoBERTa: Training and evaluation of a curated language model for Setswana Authors Vukosi Marivate, Moseli Mots Oehli, Valencia Wagner, Richard Lastrucci, Isheanesu Dzingirai 自然语言处理 NLP 在英语等资源丰富的语言方面取得了重大进展,但在茨瓦纳语等资源匮乏的语言方面却落后了。本文通过提出 PuoBERTa 来解决这一差距,这是一种专门为 Setswana 训练的定制掩码语言模型。我们将介绍如何收集、整理和准备不同的单语文本,以便为 PuoBERTa 的训练生成高质量的语料库。基于之前为 Setswana 创建单语言资源的努力,我们在多个 NLP 任务中评估了 PuoBERTa,包括词性 POS 标记、命名实体识别 NER 和新闻分类。此外,我们还引入了新的 Setswana 新闻分类数据集,并使用 PuoBERTa 提供了初始基准。 |

| A Frustratingly Easy Plug-and-Play Detection-and-Reasoning Module for Chinese Spelling Check Authors Haojing Huang, Jingheng Ye, Qingyu Zhou, Yinghui Li, Yangning Li, Feng Zhou, Hai Tao Zheng 近年来,通过设计特定于任务的预训练方法或引入辅助任务,中文拼写检查CSC得到了很大的改进,这些任务大多以端到端的方式解决该任务。在本文中,我们建议将 CSC 工作流程分解为检测、推理和搜索子任务,以便更直接、更有效地利用有关中文的丰富外部知识。具体来说,我们设计了一个即插即用的检测和推理模块,该模块与现有的 SOTA 非自回归 CSC 模型兼容,以进一步提高其性能。我们发现为一种模型训练的检测和推理模块也可以使其他模型受益。我们还研究了任务分解提供的主要可解释性。 |

| GLoRE: Evaluating Logical Reasoning of Large Language Models Authors Hanmeng liu, Zhiyang Teng, Ruoxi Ning, Jian Liu, Qiji Zhou, Yue Zhang 最近,大型语言模型 LLM,包括 GPT 4 等著名模型和新兴的社区模型,已经展示了显着的通用语言理解能力。然而,很少有人尝试评估这些法学硕士的逻辑推理能力,而逻辑推理能力是自然语言理解的一个重要方面。为了鼓励在这一领域进行进一步研究,我们引入了 GLoRE,这是一个精心组装的通用逻辑推理评估基准,由涵盖三种不同类型任务的 12 个数据集组成。我们的实验结果表明,与人类和监督微调的性能相比,开放LLM模型的逻辑推理能力需要进一步改进ChatGPT,GPT 4显示出强大的逻辑推理能力,GPT 4大幅超越ChatGPT。我们提出了一种自一致性探测方法来提高 ChatGPT 的准确性,并提出了一种微调方法来提高开放式 LLM 的性能。 |

| Qilin-Med: Multi-stage Knowledge Injection Advanced Medical Large Language Model Authors Qichen Ye, Junling Liu, Dading Chong, Peilin Zhou, Yining Hua, Andrew Liu 将大型语言模型法学硕士融入医疗保健领域具有潜力,但也面临挑战。直接对医学等领域的法学硕士进行预培训需要大量资源,有时甚至是不可行的。仅仅依赖有监督的微调 SFT 可能会导致过度自信的预测,并且可能无法挖掘特定领域的见解。为了解决这些挑战,我们提出了一种结合特定领域持续预训练 DCPT、SFT 和直接偏好优化 DPO 的多阶段训练方法。我们研究的一个显着贡献是引入了 3Gb 中医 ChiMed 数据集,包括医学问答、纯文本、知识图和对话,分为三个训练阶段。通过我们的管道 Qilin Med 培训的医学法学硕士表现出显着的绩效提升。在CPT和SFT阶段,它在CMExam上取得了38.4和40.0的准确率,超过了百川7B的33.5。在DPO阶段,在华佗26M测试集上,其BLEU 1得分为16.66,ROUGE1得分为27.44,优于SFT的12.69和24.21。 |

| Dialect Transfer for Swiss German Speech Translation Authors Claudio Paonessa, Yanick Schraner, Jan Deriu, Manuela H rlimann, Manfred Vogel, Mark Cieliebak 本文研究了构建瑞士德语语音翻译系统的挑战,特别关注方言多样性的影响以及瑞士德语和标准德语之间的差异。瑞士德语是一种没有正式书写系统的口语,由许多不同的方言组成,是一种资源匮乏的语言,只有大约 500 万使用者。该研究以两个关键研究问题为指导:瑞士德语语音翻译模型训练过程中方言的包含和排除如何影响特定方言的性能,以及瑞士德语和标准德语之间的差异如何影响瑞士德语语音翻译模型的性能。 |

| KCTS: Knowledge-Constrained Tree Search Decoding with Token-Level Hallucination Detection Authors Sehyun Choi, Tianqing Fang, Zhaowei Wang, Yangqiu Song 大型语言模型法学硕士展示了卓越的人类水平自然语言生成能力。然而,它们有可能产生错误信息,通常称为幻觉问题,对其部署构成重大风险。解决此问题的常见方法是检索相关知识并使用其输入中的知识对法学硕士进行微调。不幸的是,这种方法会产生很高的训练成本,并且可能会导致多任务模型发生灾难性遗忘。为了克服这些限制,我们提出了一种称为 KCTS 知识约束树搜索 的知识约束解码方法,该方法使用知识分类器得分和 MCTS 蒙特卡洛树搜索 指导冻结的 LM 在每个解码步骤生成与参考知识对齐的文本。为了使序列级知识分类器适应令牌级指导,我们还提出了一种新颖的令牌级幻觉检测方法,称为 RIPA 奖励拐点近似。 |

| MM-BigBench: Evaluating Multimodal Models on Multimodal Content Comprehension Tasks Authors Xiaocui Yang, Wenfang Wu, Shi Feng, Ming Wang, Daling Wang, Yang Li, Qi Sun, Yifei Zhang, Xiaoming Fu, Soujanya Poria 多模态大型语言模型 MLLM 的流行引发了最近致力于评估这些模型的研究工作的激增。然而,现有的MLLM评估研究主要集中在单模态视觉内容的理解和推理上,忽视了多模态视觉语言内容理解领域的性能评估。除了多模态推理之外,与多模态内容理解相关的任务还需要对多模态上下文有深刻的理解,通过多模态交互来获得最终答案。在本文中,我们介绍了一个名为 MM BigBench 的综合评估框架,它包含多种指标,可以对各种模型和指令在各种不同的多模态内容理解任务中的性能进行广泛的评估。因此,我们的工作补充了 MLLM 在多模态理解任务中的表现研究,实现了对 MLLM 更全面、更全面的评估。首先,我们使用最佳性能指标来确定每个模型在不同数据集上的性能上限。随后,平均相对增益指标对各种模型和指令的整体性能进行评估,而稳定性指标则衡量其敏感性。此外,以往的研究主要集中于独立评估模型或仅评估指令,忽略了模型与指令之间的适应性。我们提出适应性指标来量化模型和指令之间的适应性。我们的论文在涵盖 6 个任务的 14 个多模态数据集上评估了总共 20 个语言模型、14 个 MLLM,每个任务有 10 条指令,并得出了新颖的见解。 |

| Dont Add, dont Miss: Effective Content Preserving Generation from Pre-Selected Text Spans Authors Aviv Slobodkin, Avi Caciularu, Eran Hirsch, Ido Dagan 最近引入的受控文本缩减 CTR 任务将典型摘要样式任务中的文本生成步骤隔离开来。 |

| ChatKBQA: A Generate-then-Retrieve Framework for Knowledge Base Question Answering with Fine-tuned Large Language Models Authors Haoran Luo, Haihong E, Zichen Tang, Shiyao Peng, Yikai Guo, Wentai Zhang, Chenghao Ma, Guanting Dong, Meina Song, Wei Lin 知识库问答 KBQA 旨在通过大规模知识库 KB 导出自然语言问题的答案,通常分为知识检索和语义解析两个研究部分。然而,仍然存在三个核心挑战,包括知识检索效率低下、检索错误对语义解析产生不利影响以及先前 KBQA 方法的复杂性。在大型语言模型 LLM 时代,我们引入了 ChatKBQA,这是一种新颖的生成然后检索 KBQA 框架,它建立在微调开源 LLM 的基础上,例如 Llama 2、ChatGLM2 和 Baichuan2。 ChatKBQA 建议首先使用微调的 LLM 生成逻辑形式,然后通过无监督检索方法检索和替换实体和关系,从而更直接地改进生成和检索。实验结果表明,ChatKBQA 在标准 KBQA 数据集、WebQSP 和 ComplexWebQuestions CWQ 上实现了新的最先进性能。这项工作还提供了一种新的范式,将法学硕士与知识图谱知识图谱相结合,以实现可解释和知识所需的问答。 |

| Towards Example-Based NMT with Multi-Levenshtein Transformers Authors Maxime Bouthors, Josep Crego, Fran ois Yvon 检索增强机器翻译 RAMT 正在引起越来越多的关注。这是因为 RAMT 不仅改进了翻译指标,而且还假设实现某种形式的域适应。 |

| xDial-Eval: A Multilingual Open-Domain Dialogue Evaluation Benchmark Authors Chen Zhang, Luis Fernando D Haro, Chengguang Tang, Ke Shi, Guohua Tang, Haizhou Li 开放域对话评估的参考免费学习指标的最新进展是由预训练语言模型的进步以及具有高质量人工注释的对话数据的可用性推动的。然而,目前的研究主要集中在英语对话上,这些指标对其他语言的推广尚未得到充分检验。这很大程度上是由于缺乏多语言对话评估基准。为了解决这个问题,我们引入了基于开源英语对话评估数据集构建的 xDial Eval。 xDial Eval 包括 12 个回合级别和 6 个对话级别的英语数据集,分别包含 14930 个带注释的回合和 8691 个带注释的对话。英语对话数据通过商业机器翻译系统扩展到其他九种语言。在 xDial Eval 上,我们对之前基于 BERT 的指标和最近出现的大型语言模型进行了全面分析。最后,我们建立了强大的自我监督和多语言基线。就所有数据集和语言的平均 Pearson 相关性而言,最佳基线优于 OpenAI 的 ChatGPT,在回合和对话级别分别绝对提高了 6.5 和 4.6,尽管参数要少得多。 |

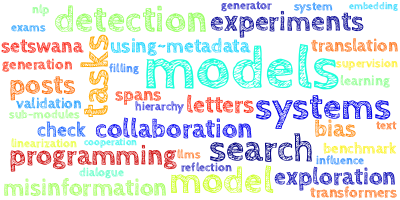

| Textual Analysis of ICALEPCS and IPAC Conference Proceedings: Revealing Research Trends, Topics, and Collaborations for Future Insights and Advanced Search Authors Antonin Sulc, Annika Eichler, Tim Wilksen 在本文中,我们对过去的 ICALEPCS 和 IPAC 会议记录进行了文本分析,以深入了解该领域的研究趋势和讨论的主题。我们使用自然语言处理技术从过去会议记录的摘要和论文中提取有意义的信息。我们提取主题以可视化和识别趋势,分析其演变以确定新兴研究方向,并仅根据其内容和网络分析来突出有趣的出版物。此外,我们将提供先进的搜索工具,以更好地搜索现有论文,以防止重复并更容易找到参考结果。 |

| CAMELL: Confidence-based Acquisition Model for Efficient Self-supervised Active Learning with Label Validation Authors Carel van Niekerk, Christian Geishauser, Michael Heck, Shutong Feng, Hsien chin Lin, Nurul Lubis, Benjamin Ruppik, Renato Vukovic, Milica Ga i 监督神经方法因其依赖于大型、精心注释的数据集而受到阻碍,这对于顺序任务来说尤其麻烦。随着从基于专家的标签向众包标签的转变,注释的质量往往会恶化。为了应对这些挑战,我们提出了基于 CAMELL 置信度的采集模型,用于带标签验证的高效自监督主动学习,这是一个针对顺序多输出问题量身定制的基于池的主动学习框架。 CAMELL 拥有三个核心功能:1 它需要专家注释者仅标记所选序列的一小部分;2 它有助于对序列的其余部分进行自我监督;3 它采用标签验证机制来防止错误标签污染数据集并造成损害。模型性能。我们在顺序任务上评估 CAMELL,特别强调对话信念跟踪,这是一项受到有限和嘈杂数据集约束困扰的任务。我们的实验表明,CAMELL 在效率方面优于基线。 |

| Multi-level Adaptive Contrastive Learning for Knowledge Internalization in Dialogue Generation Authors Chenxu Yang, Zheng Lin, Lanrui Wang, Chong Tian, Liang Pang, Jiangnan Li, Yanan Cao, Weiping Wang 基于知识的对话生成旨在通过纳入外部知识来补充上下文来减轻文本退化问题。然而,该模型通常无法以类似人类的方式将这些信息内化为响应。相反,它只是将所提供的知识片段插入通用响应中。结果,生成的响应往往是乏味的、不连贯的,并且缺乏交互性,这意味着退化问题仍未得到解决。在这项工作中,我们首先发现这种复制风格退化主要是由于弱似然目标,这使得模型仅通过在基于重叠的表面模式匹配中复制知识片段来欺骗目标。为了克服这一挑战,我们提出了一个多级自适应对比学习 MACL 框架,该框架动态地对负面示例进行采样,然后在令牌级别和序列级别上惩罚退化行为。 |

| Towards Informative Few-Shot Prompt with Maximum Information Gain for In-Context Learning Authors Hongfu Liu, Ye Wang 大型语言模型法学硕士拥有通过利用与新下游任务相关的一些演示作为条件来参与上下文学习 ICL 的能力。然而,这种特定的学习范式由于所选示例的输入分布、顺序和提示格式等因素引起的巨大差异而存在高度不稳定性。在这项工作中,我们证明即使所有这些因素保持不变,示例的随机选择仍然会导致高方差。因此,我们的目标是通过量化观察给定候选示例后在预测中获得的信息增益 IG 来探索数据示例的信息能力。然后我们建议对 IG 最大的样本进行采样。此外,我们还发现模板偏差的存在,这可能导致在抽样过程中对 IG 进行不公平的评估。为了减轻这种偏差,我们引入了采样前校准策略。 |

| Human-in-the-loop Machine Translation with Large Language Model Authors Xinyi Yang, Runzhe Zhan, Derek F. Wong, Junchao Wu, Lidia S. Chao 大语言模型法学硕士因其上下文学习机制和涌现能力而受到广泛关注。研究界已经进行了多项试点研究,将法学硕士应用于机器翻译任务,并从不同的角度评估其表现。然而,以往的研究主要集中在LLM本身,并没有探索LLM推理过程中的人为干预。 LLM的特点,例如情境学习和即时工程,密切反映了人类在语言任务中的认知能力,为人类在循环生成中提供了直观的解决方案。在这项研究中,我们提出了一个人在循环管道,指导法学硕士通过修订指令生成定制的输出。该管道首先提示法学硕士生成翻译草稿,然后利用自动检索或人工反馈作为监督信号,通过上下文学习来增强法学硕士的翻译。该管道中生成的人机交互也存储在外部数据库中,以扩展上下文检索数据库,使我们能够在离线环境中利用人类监督。我们使用 GPT 3.5 Turbo API 在五个特定领域的德语英语翻译基准上评估所提出的管道。结果证明了与直接翻译相比,管道在领域翻译定制和提高翻译性能方面的有效性。此外,我们还从以下几个角度讨论结果: 1 不同上下文检索方法的有效性 2 低资源场景下检索数据库的构建 3 观察到的领域差异 4 语言统计的定量分析和 5 翻译案例的定性分析。 |

| SeqXGPT: Sentence-Level AI-Generated Text Detection Authors Pengyu Wang, Linyang Li, Ke Ren, Botian Jiang, Dong Zhang, Xipeng Qiu 广泛应用的大型语言模型法学硕士可以生成类似人类的内容,引发了人们对法学硕士滥用的担忧。因此,构建强大的人工智能生成文本 AIGT 检测器非常重要。目前的工作仅考虑文档级 AIGT 检测,因此,在本文中,我们首先通过合成包含经过 LLM 修饰的文档的数据集来引入句子级检测挑战,即文档包含人类编写的句子和由人修改的句子。法学硕士。然后,我们提出了 textbf Seq uence textbf X Check textbf GPT ,这是一种利用白盒 LLM 的对数概率列表作为句子级 AIGT 检测的特征的新颖方法。这些特征的组成就像语音处理中的文本波一样,无法由法学硕士研究。因此,我们构建基于卷积和自注意力网络的SeqXGPT。我们在句子和文档级别的检测挑战中对其进行了测试。 |

| Exploration with Principles for Diverse AI Supervision Authors Hao Liu, Matei Zaharia, Pieter Abbeel 使用下一个代币预测来训练大型变压器已经带来了人工智能领域的突破性进步。虽然这种生成式人工智能方法已经产生了令人印象深刻的结果,但它严重依赖人类监督。即使像 ChatGPT 这样最先进的人工智能模型也依赖于通过人类演示进行微调,需要大量的人类输入和领域专业知识。这种对人类监督的强烈依赖对人工智能创新的进步构成了重大障碍。为了解决这一限制,我们提出了一种称为探索性 AI EAI 的新范式,旨在自主生成高质量的训练数据。 EAI 从无监督强化学习 RL 预训练中汲取灵感,实现了自然语言空间内的探索。我们通过利用大型语言模型来评估生成内容的新颖性来实现这一目标。我们的方法采用两个关键组成部分,一个是根据探索原则生成新颖内容的参与者,另一个是评估生成的内容并提供批评来指导参与者的评论家。 |

| PerturbScore: Connecting Discrete and Continuous Perturbations in NLP Authors Linyang Li, Ke Ren, Yunfan Shao, Pengyu Wang, Xipeng Qiu 随着神经网络在自然语言处理中应用的快速发展,模型的鲁棒性问题越来越受到关注。与计算机视觉不同,文本的离散性质使得探索 NLP 的鲁棒性更具挑战性。因此,在本文中,我们的目标是将离散扰动与连续扰动联系起来,因此我们可以使用这种连接作为桥梁来帮助理解 NLP 模型中的离散扰动。具体来说,我们首先探讨如何连接和测量离散扰动和连续扰动之间的相关性。然后我们设计一个回归任务作为 PerturbScore 来自动学习相关性。通过实验结果,我们发现我们可以在离散扰动和连续扰动之间建立联系,并使用所提出的 PerturbScore 来学习这种相关性,超越了以前用于离散扰动测量的方法。 |

| InstructTODS: Large Language Models for End-to-End Task-Oriented Dialogue Systems Authors Willy Chung, Samuel Cahyawijaya, Bryan Wilie, Holy Lovenia, Pascale Fung 大型语言模型 LLM 已用于自然语言处理 NLP 中的各种任务,但对于面向任务的对话系统 TODS 仍在探索中,尤其是端到端 TODS。我们推出了 InstructTODS,这是一种新颖的现成框架,适用于零镜头端到端任务导向的对话系统,无需微调即可适应不同的领域。通过利用 LLM,InstructTODS 生成代理信念状态,将用户意图无缝转换为动态查询,以便与任何知识库进行高效交互。我们广泛的实验表明,InstructTODS 在指导对话成功完成方面达到了与完全微调的 TODS 相当的性能,无需先验知识或任务特定数据。此外,对端到端 TODS 的严格人类评估表明,InstructTODS 产生的对话响应在有用性、信息性和人性方面明显优于黄金响应和最先进的 TODS。此外,我们对 TODS 子任务对话状态跟踪、意图分类和响应生成的综合评估进一步支持了 TODS 中法学硕士的有效性。 |

| Retrieval-Generation Alignment for End-to-End Task-Oriented Dialogue System Authors Weizhou Shen, Yingqi Gao, Canbin Huang, Fanqi Wan, Xiaojun Quan, Wei Bi 开发一个高效的检索器来从大规模知识库 KB 中检索知识对于面向任务的对话系统有效处理本地化和专业化任务至关重要。然而,广泛使用的生成模型(例如 T5 和 ChatGPT)在生成响应时常常难以区分检索到的知识库记录之间的细微差异,从而导致生成的响应质量不佳。在本文中,我们提出应用最大边际似然通过利用响应生成的信号进行监督来训练感知检索器。此外,我们的方法不仅仅考虑检索到的实体,还结合了各种元知识来指导生成器,从而提高了知识的利用率。我们使用 T5 和 ChatGPT 作为骨干模型在三个面向任务的对话数据集上评估我们的方法。结果表明,当与元知识相结合时,响应生成器可以有效地利用检索器的高质量知识记录并提高生成响应的质量。 |

| Guiding AMR Parsing with Reverse Graph Linearization Authors Bofei Gao, Liang Chen, Peiyi Wang, Zhifang Sui, Baobao Chang 抽象含义表示 AMR 解析的目的是从给定的句子中提取抽象语义图。序列到序列方法将语义图线性化为节点和边的序列并直接生成线性化图,取得了良好的性能。然而,我们观察到这些方法在解码过程中会受到结构损失累积的影响,导致稍后解码的节点和边的 F1 分数比早期解码的节点和边要低得多。为了解决这个问题,我们提出了一种新颖的逆图线性化 RGL 增强框架。 RGL 定义了 AMR 图的默认顺序和反向线性化顺序,其中默认顺序后面部分的大多数结构出现在反向顺序的前面部分,反之亦然。 RGL 通过两遍自蒸馏机制将反向线性化合并到原始 AMR 解析器中,该机制在生成默认线性化时指导模型。我们的分析表明,我们提出的方法显着缓解了结构损失累积的问题,在 AMR 2.0 和 AMR 3.0 数据集上分别比之前最好的 AMR 解析模型高出 0.8 和 0.5 Smatch 分数。 |

| Large Language Models as Source Planner for Personalized Knowledge-grounded Dialogue Authors Hongru Wang, Minda Hu, Yang Deng, Rui Wang, Fei Mi, Weichao Wang, Yasheng Wang, Wai Chung Kwan, Irwin King, Kam Fai Wong 开放域对话系统通常需要不同的知识源来生成更多信息和证据的响应。然而,现有的基于知识的对话系统要么关注单一知识源,要么忽视多个知识源之间的依赖关系,这可能导致产生不一致甚至自相矛盾的响应。为了整合多个知识源和它们之间的依赖关系,我们提出了 SAFARI,这是一个新颖的框架,它利用大型语言模型法学硕士在监督和无监督环境下规划、理解和整合的卓越能力。具体来说,SAFARI 将知识基础解耦为多个来源和响应生成,这允许轻松扩展到各种知识源,包括不使用任何来源的可能性。为了研究这个问题,我们构建了一个基于个性化知识的对话数据集textittextbfKnowledgetextbfBehindtextbfPersonatextbfKBP,这是第一个考虑角色和隐性知识之间依赖关系的数据集。 |

| A Comparative Analysis of Task-Agnostic Distillation Methods for Compressing Transformer Language Models Authors Takuma Udagawa, Aashka Trivedi, Michele Merler, Bishwaranjan Bhattacharjee 大型语言模型已成为现代 NLP 的重要组成部分,在各种任务中实现了最先进的性能。然而,由于其昂贵的推理成本,它们对于现实世界的部署通常效率低下。知识蒸馏是一种很有前途的技术,可以提高效率,同时保留大部分有效性。在本文中,我们重现、比较和分析了 Transformer 语言模型任务无关通用蒸馏的几种代表性方法。我们的研究目标包括输出分布OD传输、具有各种层映射策略的隐藏状态HS传输以及基于MiniLMv2的多头注意力MHA传输。通过广泛的实验,我们研究了每种方法在单语英语和多语言环境中对各种学生架构的有效性。总的来说,我们表明基于 MiniLMv2 的 MHA 转移通常是蒸馏的最佳选择,并解释了其成功背后的潜在原因。此外,我们表明 HS 传输仍然是一个有竞争力的基线,特别是在复杂的层映射策略下,而 OD 传输始终落后于其他方法。 |

| End-to-end Story Plot Generator Authors Hanlin Zhu, Andrew Cohen, Danqing Wang, Kevin Yang, Xiaomeng Yang, Jiantao Jiao, Yuandong Tian 故事情节虽然简短,但却包含了可能包含数万字的完整故事的大部分基本信息。我们研究故事情节自动生成的问题,其中包括故事前提、人物描述、情节轮廓等。为了生成单个引人入胜的情节,现有的情节生成器(例如 DOC Yang 等人,2022a)需要数百到数千次调用LLM,例如故事情节规划阶段的 OpenAI API,成本高昂且至少需要几分钟。此外,该方法的硬连线性质使得管道不可微分,阻碍了绘图生成器的快速专业化和个性化。在本文中,我们提出了三种模型:texttt OpenPlot、texttt E2EPlot 和 texttt RLPlot 来应对这些挑战。 texttt OpenPlot 通过仔细的提示设计,用 LLaMA2 Touvron et al., 2023 调用取代了昂贵的 OpenAI API 调用,从而以廉价的方式生成高质量的故事情节训练数据集。然后,我们使用 texttt OpenPlot 生成的大约 13000 个故事情节,通过监督微调 SFT 来训练端到端故事情节生成器 texttt E2EPlot 。 texttt E2EPlot 生成的故事情节与 texttt OpenPlot 的质量相当,并且平均只需 30 秒就可以快 10 倍 1k 标记。 |

| Mitigating Bias for Question Answering Models by Tracking Bias Influence Authors Mingyu Derek Ma, Jiun Yu Kao, Arpit Gupta, Yu Hsiang Lin, Wenbo Zhao, Tagyoung Chung, Wei Wang, Kai Wei Chang, Nanyun Peng 各种 NLP 任务的模型已被证明表现出刻板印象,而问答 QA 模型中的偏差尤其有害,因为输出答案可能会被最终用户直接使用。已经有数据集可以评估 QA 模型中的偏差,而 QA 模型的偏差缓解技术仍在探索中。在这项工作中,我们提出了 BMBI,一种减轻多项选择 QA 模型偏差的方法。基于这样的直觉:如果模型从有偏差的示例中学习,模型将倾向于更加有偏差,因此我们通过观察查询实例对另一个实例的影响来测量查询实例的偏差级别。如果受影响的实例更加偏向,我们就得出查询实例是有偏向的。然后,我们使用检测到的偏差水平作为优化目标,在原始 QA 任务之外形成多任务学习设置。我们进一步引入了一种新的偏差评估指标,以全面且敏感的方式量化偏差。我们表明,我们的方法可以应用于跨多个偏差类别的多个 QA 公式。 |

| "Im not Racist but...": Discovering Bias in the Internal Knowledge of Large Language Models Authors Abel Salinas, Louis Penafiel, Robert McCormack, Fred Morstatter 大型语言模型法学硕士因其在不断扩展的自然语言处理任务中的出色表现而受到广泛关注。然而,这些模型已被证明存在固有的社会偏见或刻板印象,这可能会对它们在许多下游应用中的性能产生不利影响。在本文中,我们介绍了一种新颖的、纯粹基于提示的方法来揭示任意法学硕士中隐藏的刻板印象。我们的方法动态生成内部刻板印象的知识表示,从而能够识别法学硕士内部知识中编码的偏见。 |

| Calibrating Likelihoods towards Consistency in Summarization Models Authors Polina Zablotskaia, Misha Khalman, Rishabh Joshi, Livio Baldini Soares, Shoshana Jakobovits, Joshua Maynez, Shashi Narayan 尽管抽象文本摘要最近取得了进展,但当前的摘要模型仍然存在生成与事实不一致的摘要的问题,从而降低了它们在现实世界应用中的实用性。我们认为,这种行为的主要原因是,用最大似然目标训练的摘要模型为给定上下文的合理序列分配了高概率,但它们通常不能根据序列的一致性准确地对序列进行排名。在这项工作中,我们通过校准模型生成序列的可能性来解决这个问题,以更好地与自然语言推理 NLI 模型测量的一致性指标保持一致。人类评估研究和自动指标表明,校准后的模型可以生成更一致、更高质量的摘要。 |

| Circuit Component Reuse Across Tasks in Transformer Language Models Authors Jack Merullo, Carsten Eickhoff, Ellie Pavlick 最近在机械可解释性方面的工作表明,可以通过电路分析成功地对语言模型中的行为进行逆向工程。然而,一个常见的批评是每个电路都是特定于任务的,因此这种分析无法有助于在更高层次上理解模型。在这项工作中,我们提供的证据表明,关于特定头部的低级发现和关于通用算法的高级发现确实可以跨任务推广。具体来说,我们研究了 Wang 等人发现的电路。 2022 年用于间接对象识别 IOI 任务,1. 表明它可以在更大的 GPT2 模型上重现,2. 它主要被重用来解决看似不同的任务彩色对象 Ippolito Callison Burch,2023 年。我们提供的证据表明,这两项任务的底层流程在功能上非常相似,并且在循环注意力头中包含大约 78 个重叠。我们进一步提出了一个概念验证干预实验,其中我们调整中间层的四个注意力头,以修复彩色对象电路并使其表现得像 IOI 电路。在此过程中,我们将“彩色对象”任务的准确度从 49.6 提高到 93.7,并解释了大多数错误来源。干预以 IOI 回路中相互作用预测的特定方式影响下游注意头,表明这种子回路行为对于不同的任务输入是不变的。 |

| A Zero-Shot Language Agent for Computer Control with Structured Reflection Authors Tao Li, Gang Li, Zhiwei Deng, Bryan Wang, Yang Li 大型语言模型法学硕士已经显示出在实时计算机环境中规划和执行高级目标的能力不断增强,例如:迷你沃B。为了执行任务,最近的工作通常需要一个模型通过监督学习或少数多次提示来从任务的跟踪示例中学习。如果没有这些跟踪示例,代理如何自主学习并提高其对计算机的控制仍然是一个挑战,这限制了代理执行新任务的能力。我们使用不需要给定专家跟踪的零样本代理来解决这个问题。我们的代理计划在部分观察的环境中执行可执行的操作,并通过自我反思和结构化思维管理来识别错误并从中学习,从而迭代地推进任务。在 MiniWoB 的简单任务中,我们表明我们的零样本代理通常优于最近的 SoTA,具有更有效的推理。 |

| Toward Joint Language Modeling for Speech Units and Text Authors Ju Chieh Chou, Chung Ming Chien, Wei Ning Hsu, Karen Livescu, Arun Babu, Alexis Conneau, Alexei Baevski, Michael Auli 语音和文本是人类语言的两种主要形式。多年来,研究界一直致力于将语音映射到文本,反之亦然。然而,在语言建模领域,很少有人对它们进行联合建模。鉴于此,我们探索语音单元和文本的联合语言建模。具体来说,我们比较不同的语音标记器将连续语音信号转换为离散单元,并使用不同的方法构建混合语音文本数据。我们引入自动指标来评估联合 LM 混合语音和文本的效果。我们还对具有不同模态语音或文本的下游口语理解 SLU 任务的 LM 进行微调,并测试其性能以评估模型对共享表示的学习。 |

| Can GPT models be Financial Analysts? An Evaluation of ChatGPT and GPT-4 on mock CFA Exams Authors Ethan Callanan, Amarachi Mbakwe, Antony Papadimitriou, Yulong Pei, Mathieu Sibue, Xiaodan Zhu, Zhiqiang Ma, Xiaomo Liu, Sameena Shah 大型语言模型法学硕士在各种自然语言处理 NLP 任务中表现出了卓越的性能,通常可以匹配甚至击败最先进的任务特定模型。本研究旨在评估法学硕士的财务推理能力。我们利用特许金融分析师CFA项目的模拟试题,综合考虑Zero Shot ZS、Chain of Thought CoT和Few Shot FS场景,对ChatGPT和GPT 4在金融分析方面进行全面评估。我们对模型的性能和局限性进行了深入分析,并估计它们是否有机会通过 CFA 考试。最后,我们概述了增强法学硕士在金融领域适用性的潜在策略和改进的见解。 |

| LoftQ: LoRA-Fine-Tuning-Aware Quantization for Large Language Models Authors Yixiao Li, Yifan Yu, Chen Liang, Pengcheng He, Nikos Karampatziakis, Weizhu Chen, Tuo Zhao 量化是服务大型语言模型法学硕士不可或缺的技术,最近已在 LoRA 微调中找到了应用。在这项工作中,我们重点关注在预训练模型上同时应用量化和 LoRA 微调的场景。在这种情况下,通常会观察到完全微调和量化加 LoRA 微调方法之间下游任务的性能存在持续差距。为此,我们提出了 LoftQ LoRA Fine Tuningware Quantization ,这是一种新颖的量化框架,可同时量化 LLM 并为 LoRA 微调找到适当的低秩初始化。这种初始化减轻了量化模型和全精度模型之间的差异,并显着提高了下游任务的泛化能力。我们在自然语言理解、问答、总结和自然语言生成任务上评估我们的方法。实验表明,我们的方法非常有效,并且优于现有的量化方法,特别是在具有挑战性的 2 位和 2 4 位混合精度体系中。 |

| User Inference Attacks on Large Language Models Authors Nikhil Kandpal, Krishna Pillutla, Alina Oprea, Peter Kairouz, Christopher A. Choquette Choo, Zheng Xu 微调是针对专门任务和应用程序定制大型语言模型 LLM 的常见且有效的方法。在本文中,我们研究了 LLM 对用户数据进行微调的隐私影响。为此,我们定义了一个现实的威胁模型,称为用户推断,其中攻击者推断用户的数据是否被用于微调。我们针对此威胁模型实施攻击,只需要来自用户的一小部分样本,这些样本可能与用于训练和黑盒访问微调 LLM 的样本不同。我们发现 LLM 很容易受到各种微调数据集的用户推理攻击,有时攻击成功率接近完美。此外,我们调查了哪些属性使用户容易受到用户推理的影响,发现异常用户(即数据分布与其他用户和贡献大量数据的用户有足够不同的用户)最容易受到攻击。最后,我们探索了几种减轻隐私攻击的启发式方法。我们发现训练算法中的干预措施(例如批量或每个示例梯度裁剪和早期停止)无法阻止用户推理。 |

| Hypernymy Understanding Evaluation of Text-to-Image Models via WordNet Hierarchy Authors Anton Baryshnikov, Max Ryabinin 由于质量的快速提高和大量的实际应用,文本到图像的合成最近引起了广泛的关注。然而,文本到图像模型的语言理解能力仍然知之甚少,这使得很难推理给定模型能够很好理解的提示表述。在这项工作中,我们测量了流行文本到图像模型的能力,以理解文本上位词或单词之间的关系。我们基于 WordNet 语义层次结构和在 ImageNet 上预训练的现有图像分类器设计了两个自动指标。这些指标既可以对文本与图像模型的语言能力进行广泛的定量比较,又可以提供一种发现细粒度的定性差异的方法,例如模型未知的单词,因此模型很难绘制。 |

| AgentCF: Collaborative Learning with Autonomous Language Agents for Recommender Systems Authors Junjie Zhang, Yupeng Hou, Ruobing Xie, Wenqi Sun, Julian McAuley, Wayne Xin Zhao, Leyu Lin, Ji Rong Wen 最近,由于其卓越的决策能力,出现了采用法学硕士驱动的代理作为可信的人类代理的现象。然而,现有的研究主要集中在模拟人类对话。人类非语言行为,例如推荐系统中的项目点击,虽然隐式地表现出用户偏好并且可以增强用户的建模,但尚未得到深入探索。 |

| The Consensus Game: Language Model Generation via Equilibrium Search Authors Athul Paul Jacob, Yikang Shen, Gabriele Farina, Jacob Andreas 当应用于问答和其他文本生成任务时,语言模型 LM 可以通过从其输出分布中采样答案来生成查询,或者通过使用它们对一组候选输出进行评分或排序来进行区分查询。这些程序有时会产生截然不同的预测。我们如何协调相互不兼容的评分程序以获得一致的 LM 预测我们引入了一种新的、无需训练的博弈论程序来进行语言模型解码。我们的方法将语言模型解码视为一种正则化的不完美信息序列信号游戏,我们将其称为共识游戏,其中生成器寻求使用自然语言句子向判别器传达抽象正确性参数。我们开发了计算程序来寻找该游戏的近似均衡,从而产生了我们称为均衡排名的解码算法。应用于大量任务(包括阅读理解、常识推理、数学问题解决和对话)时,平衡排序在多个基准测试中始终如一地(有时甚至是大幅)提高了现有 LM 解码程序的性能,我们观察到将平衡排序应用于 LLaMA 7B 的性能优于 LLaMA 7B更大的 LLaMA 65B 和 PaLM 540B 型号。 |

| HierarchicalContrast: A Coarse-to-Fine Contrastive Learning Framework for Cross-Domain Zero-Shot Slot Filling Authors Junwen Zhang, Yin Zhang 在面向任务的对话场景中,跨域零镜头槽填充在利用源域知识在无法获得注释数据的未知目标域中学习具有高泛化能力的模型方面发挥着至关重要的作用。然而,现有最先进的零射击槽填充方法在目标领域的泛化能力有限,它们仅在已见槽上表现出有效的知识转移,而在未见槽上表现不佳。为了缓解这个问题,我们提出了一种新颖的分层对比学习框架 HiCL,用于零样本槽填充。具体来说,我们提出了一种基于高斯分布式嵌入的粗粒度到细粒度的对比学习,通过优化令牌间和令牌内分布距离来学习话语令牌之间的广义深层语义关系。这鼓励 HiCL 泛化到训练阶段未见过的槽类型。此外,我们提出了一种新的迭代标签集语义推理方法,以无偏且单独地评估未见槽类型的性能,这些槽类型与其对应项(即之前的零样本槽填充评估方法中见过的槽类型)纠缠在一起。 |

| CodeChain: Towards Modular Code Generation Through Chain of Self-revisions with Representative Sub-modules Authors Hung Le, Hailin Chen, Amrita Saha, Akash Gokul, Doyen Sahoo, Shafiq Joty 大型语言模型法学硕士已经非常擅长解决更简单的编程任务,例如 HumanEval 或 MBPP 基准测试中的任务。然而,对于这些模型来说,解决更复杂和更具竞争力的编程任务仍然相当具有挑战性,这可能是因为它们倾向于将解决方案生成为整体代码块,而不是将其分解为逻辑子任务和子模块。另一方面,经验丰富的程序员本能地编写带有抽象的模块化代码来解决复杂的任务,通常重用以前开发的模块。为了解决这一差距,我们提出了 CodeChain,这是一种新颖的推理框架,它通过一系列自我修订来引发模块化代码生成,每个代码都由先前迭代中生成的一些代表性子模块引导。具体来说,CodeChain首先通过思路提示指导LLM生成模块化代码。然后,它通过迭代两个步骤来应用一系列自我修订:1提取和聚类生成的子模块,并选择集群代表作为更通用和可重用的实现,2用这些选定的模块实现增强原始思维提示链,指示法学硕士重新生成新的模块化解决方案。我们发现,通过自然地鼓励 LLM 重用之前开发和验证的子模块,CodeChain 可以显着提高生成解决方案的模块化性和正确性,在 APPS 上实现 35 的相对 pass 1 改进,在 CodeContests 上实现 76 的相对 pass 1 改进。它被证明对 OpenAI LLM 以及 WizardCoder 等开源 LLM 都有效。 |

| Making Multimodal Generation Easier: When Diffusion Models Meet LLMs Authors Xiangyu Zhao, Bo Liu, Qijiong Liu, Guangyuan Shi, Xiao Ming Wu 我们推出 EasyGen,这是一种高效模型,旨在通过利用扩散模型和大型语言模型法学硕士的功能来增强多模式理解和生成。现有的多模态模型主要依赖于 CLIP 或 ImageBind 等编码器,并且需要大量的训练数据来弥合模态之间的差距,而 EasyGen 与主要依赖于 CLIP 或 ImageBind 等编码器的现有多模态模型不同,EasyGen 建立在名为 BiDiffuser 的双向条件扩散模型之上,该模型可促进模态之间更有效的交互。 EasyGen 通过简单的投影层集成 BiDiffuser 和 LLM 来处理图像到文本的生成。与大多数仅限于生成文本响应的现有多模态模型不同,EasyGen 还可以通过利用 LLM 创建文本描述来促进文本到图像的生成,BiDiffuser 可以解释文本描述以生成适当的视觉响应。大量的定量和定性实验证明了 EasyGen 的有效性,其训练可以在实验室环境中轻松实现。 |

| Relation-aware Ensemble Learning for Knowledge Graph Embedding Authors Ling Yue, Yongqi Zhang, Quanming Yao, Yong Li, Xian Wu, Ziheng Zhang, Zhenxi Lin, Yefeng Zheng 知识图谱 KG 嵌入是自然语言处理中的一项基本任务,人们提出了各种方法来以独特的方式探索语义模式。在本文中,我们建议通过以关系感知的方式利用现有方法来学习集成。然而,使用关系感知集成探索这些语义会比一般集成方法产生更大的搜索空间。为了解决这个问题,我们提出了一种除法搜索组合算法 RelEns DSC,该算法独立搜索关系明智的集成权重。该算法与一般集成方法具有相同的计算成本,但具有更好的性能。基准数据集上的实验结果证明了所提出的方法在有效搜索关系感知集成权重和实现最先进的嵌入性能方面的有效性。 |

| Welfare Diplomacy: Benchmarking Language Model Cooperation Authors Gabriel Mukobi, Hannah Erlebach, Niklas Lauffer, Lewis Hammond, Alan Chan, Jesse Clifton 人工智能系统不断增长的能力和日益广泛的部署需要强大的基准来衡量其合作能力。不幸的是,大多数多代理基准要么是零和要么是纯粹合作,为此类测量提供了有限的机会。我们引入了零和棋盘游戏外交的一般和变体,称为“福利外交”,其中玩家必须平衡对军事征服和国内福利的投资。我们认为,福利外交有助于对合作能力进行更清晰的评估和更有力的培训激励。我们的贡献是 1 提出福利外交规则并通过开源外交引擎实施它们 2 使用零样本提示语言模型构建基线代理 3 进行实验,我们发现使用最先进模型的基线可以获得高社会福利但可利用。我们的工作旨在通过帮助研究人员开发和评估多智能体人工智能系统来促进社会安全。 |

| CompA: Addressing the Gap in Compositional Reasoning in Audio-Language Models Authors Sreyan Ghosh, Ashish Seth, Sonal Kumar, Utkarsh Tyagi, Chandra Kiran Evuru, S. Ramaneswaran, S. Sakshi, Oriol Nieto, Ramani Duraiswami, Dinesh Manocha 音频的一个基本特征是它的组合性质。使用对比方法训练的音频语言模型 ALM,例如学习音频和语言模态之间共享表示的 CLAP,提高了许多下游应用的性能,包括零样本音频分类、音频检索等。然而,这些模型有效地执行组合推理在很大程度上仍未被探索,需要进行额外的研究。在本文中,我们提出了 CompA,这是两个专家注释基准的集合,其中包含大多数现实世界的音频样本,用于评估 ALM 中的组合推理。我们提出的 CompA 顺序评估 ALM 对音频中声学事件的顺序或发生的理解程度,CompA 属性评估声学事件的属性绑定。任一基准测试的实例都包含两个音频字幕对,其中两个音频具有相同的声学事件,但成分不同。 ALM 根据正确音频与正确字幕的匹配程度进行评估。使用这个基准,我们首先表明当前的 ALM 的性能仅比随机机会好一点,因此在组合推理方面遇到了困难。接下来,我们提出 CompA CLAP,其中我们使用一种新颖的学习方法对 CLAP 进行微调,以提高其组合推理能力。为了训练 CompA CLAP,我们首先提出对具有构图感知硬底片的对比训练进行改进,从而实现更有针对性的训练。接下来,我们提出了一种新颖的模块化对比损失,可以帮助模型学习细粒度的作曲理解,并克服公开可用的作曲音频的严重稀缺性。 |

| Chinese Abs From Machine Translation |

Papers from arxiv.org

更多精彩请移步主页

pic from pexels.com