当然!下面是一个用C++语言实现的基本网络爬虫的详细代码示例:

#include <iostream>

#include <string>

#include <curl/curl.h>

size_t writeCallback(void* contents, size_t size, size_t nmemb, std::string* output) {

size_t totalSize = size * nmemb;

output->append((char*)contents, totalSize);

return totalSize;

}

int main() {

CURL* curl;

CURLcode res;

std::string htmlData;

// 初始化 libcurl

curl_global_init(CURL_GLOBAL_DEFAULT);

// 创建一个 CURL 实例

curl = curl_easy_init();

if (curl) {

// 设置要抓取的网页地址

curl_easy_setopt(curl, CURLOPT_URL, "https://www.example.com");

// 设置回调函数,用于处理获取到的响应数据

curl_easy_setopt(curl, CURLOPT_WRITEFUNCTION, writeCallback);

curl_easy_setopt(curl, CURLOPT_WRITEDATA, &htmlData);

// 执行 HTTP 请求

res = curl_easy_perform(curl);

if (res != CURLE_OK) {

std::cerr << "curl_easy_perform() failed: " << curl_easy_strerror(res) << std::endl;

}

// 输出获取到的网页内容

std::cout << htmlData << std::endl;

// 清理 CURL 实例

curl_easy_cleanup(curl);

} else {

std::cerr << "curl_easy_init() failed." << std::endl;

return 1;

}

// 清理 libcurl

curl_global_cleanup();

return 0;

}

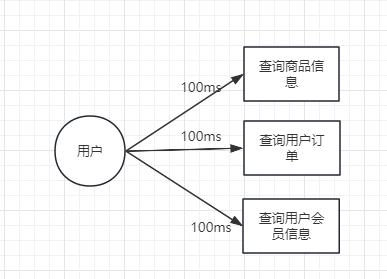

以上代码使用了 libcurl 库,它是一个用于发送 HTTP 请求和处理响应的常用开源库。在代码中,我们首先通过 curl_global_init() 函数初始化 libcurl,然后创建一个 CURL 实例,并设置要抓取的网页地址。接着,我们设置了一个回调函数 writeCallback() 来处理获取到的响应数据,并使用 curl_easy_perform() 函数执行 HTTP 请求。最后,我们打印获取到的网页内容,并清理 CURL 实例和 libcurl。

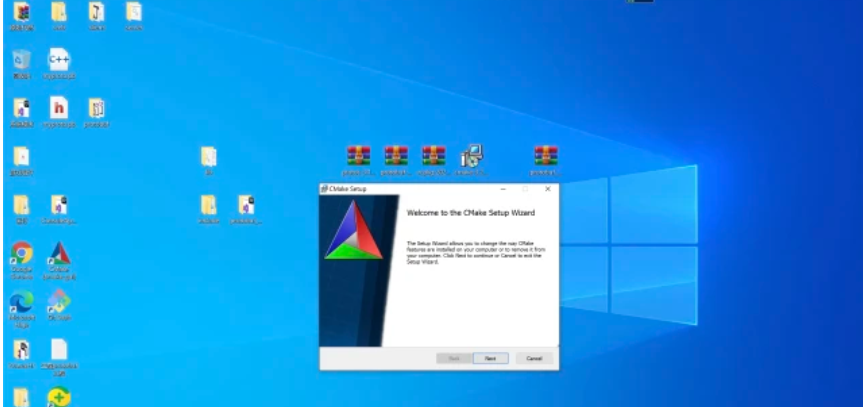

请注意,在运行此代码之前,您需要先安装 libcurl 库,并在编译时链接该库。具体安装和配置步骤可能因操作系统和编译环境而有所不同。

网络爬虫是一个复杂而涉及众多技术的领域,以上代码只是一个基础示例,您可以根据自己的需求进行更多定制和扩展。同时,请遵守合法合规的爬虫行为,并遵循相关网站的爬虫规则和政策。