Effective Pan-Sharpening With Transformer and Invertible Neural Network

(基于Transformer和可逆神经网络的有效泛锐化)

可逆神经网络1

可逆神经网络2

在遥感成像系统中,全色锐化是从高分辨率全色图像及其对应的低分辨率多光谱图像获得高分辨率多光谱图像的重要技术。由于卷积神经网络(CNNs)具有强大的学习能力,基于卷积神经网络的方法在这一领域占据了主导地位。然而,由于卷积算子的限制,常常不能精确地获得长程空间特征,从而限制了整体性能。为此,本文提出了一种新颖有效的方法,利用自定义的Transformer结构和信息无损可逆神经模块进行长程相关性建模和有效的特征融合。具体地,定制变换器将全色(PAN)和多光谱(MS)特征公式化为queries和keys,以鼓励跨两个模态的联合特征学习,而所设计的可逆神经模块使得能够进行有效的特征融合,以生成预期的全色锐化结果。据我们所知,这是首次尝试将Transformer和可逆神经网络引入全色锐化领域。

介绍

随着卫星传感器的快速发展,卫星图像已经被广泛应用于军事系统、环境监测和测绘服务等领域。然而,由于成像设备的技术和物理限制,卫星通常装备多光谱(MS)和全色(PAN)传感器以同时测量互补图像,MS图像具有低空间分辨率和高光谱分辨率,PAN图像具有低光谱分辨率和高空间分辨率。为了获得同时具有高光谱和高空间分辨率的遥感影像,融合低分辨率MS影像和高空间分辨率PAN影像以突破技术限制的全色锐化技术受到了影像处理界和遥感界的广泛关注。

在过去的几十年里,人们提出了许多全色锐化算法,并取得了很好的效果。传统的算法包括组件替换、多分辨率分析和基于模型的方法。然而,所有这些方法通常都是基于手工特征,重建MS图像中缺失信息的能力有限。最近,为了克服上述缺点,研究人员集中于利用卷积神经网络(CNNs)的强大特征表示能力来构造大量基于CNNs的全色锐化方法,其大幅度优于先前的最先进方法。

然而,现有的基于CNN的方法仍然受到一些限制:

1)由于卷积算子的局部相邻接收特性的性质,它们缺乏长距离相关性的建模。以及2)它们在特征提取和融合中是无效的。两者都导致可能对示例性全色锐化图像有用的一些基本特征的损失。

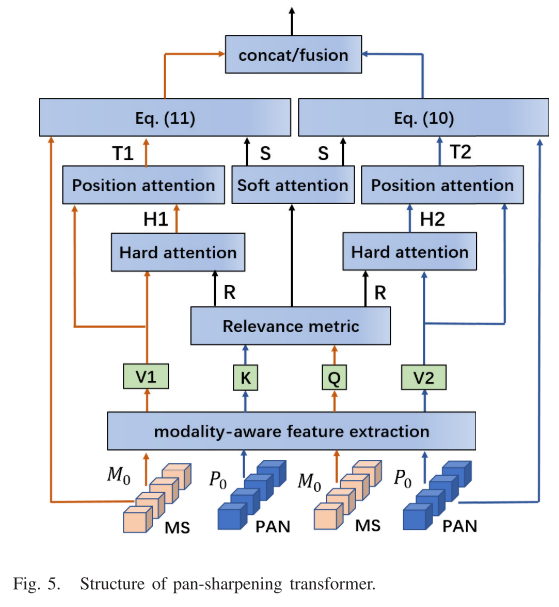

Long-Range Dependency Modeling

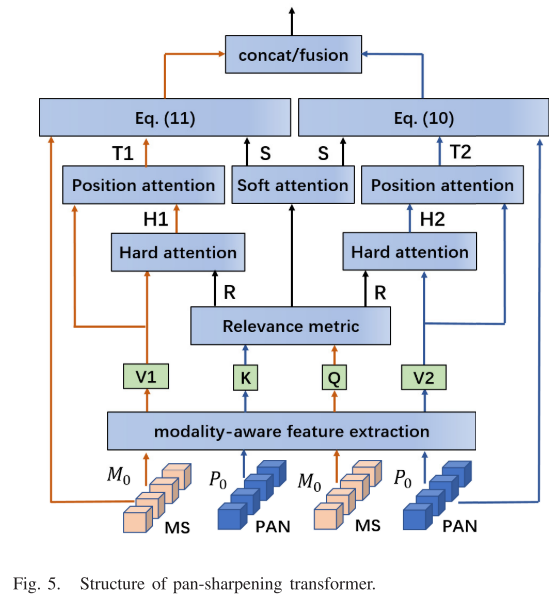

Transformer体系结构是第一个提出的,并且在自然语言处理(NLP)领域取得了显著的性能。与卷积算子的局部接收特性不同,变换器结构通过采用不同有序输入特征部分之间的多头全局注意机制,天生擅长捕捉长距离依赖关系。之后,在成功的推动下,许多研究人员开始将变压器结构引入计算机视觉。开创性的工作是用于图像识别任务的视觉 transformer(visual transformer (ViT)),与最先进的基于CNN的方法相比,该方法获得了优异的结果。从那时起,基于变换的方法已经出现,成功地工作在其他计算机视觉问题中,例如对象检测、图像分割和图像恢复。但是,在泛锐化任务中并未对其进行探索。此外,现有的transformer架构被设计成在单个图像中找到自相似性。全色锐化的目的是寻找MS图像和PAN图像这两种形态图像之间的交互信息。为了实现这一点,我们重新开发了一个定制的全色锐化transformer架构。具体而言,所提出的transformer将PAN和MS特征公式化为queries和keys,以鼓励跨两个模态的联合特征学习,用于搜索长程特征,如图5所示。

Effective Feature Extraction and Fusion

全色锐化任务的目标是融合来自MS图像和PAN图像的互补信息以生成高空间分辨率MS图像。众所周知,如何有效地提取和融合互补信息对于全色锐化性能至关重要。具体而言,现有的全色锐化方法大多直接将MS和PAN图像在图像空间中拼接,然后送入单流共享卷积编码器进行特征提取和融合。其余的方法采用双流独立卷积编码器以提供来自MS和PAN图像的模态特定特征图,然后将所获得的特征图级联以在特征空间中融合。

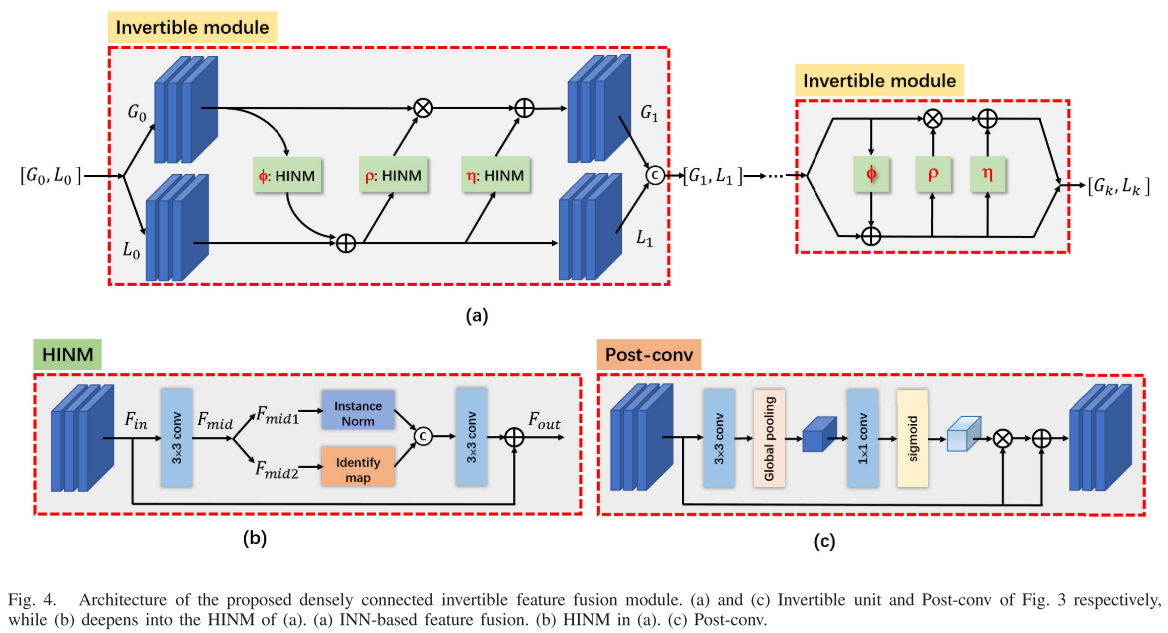

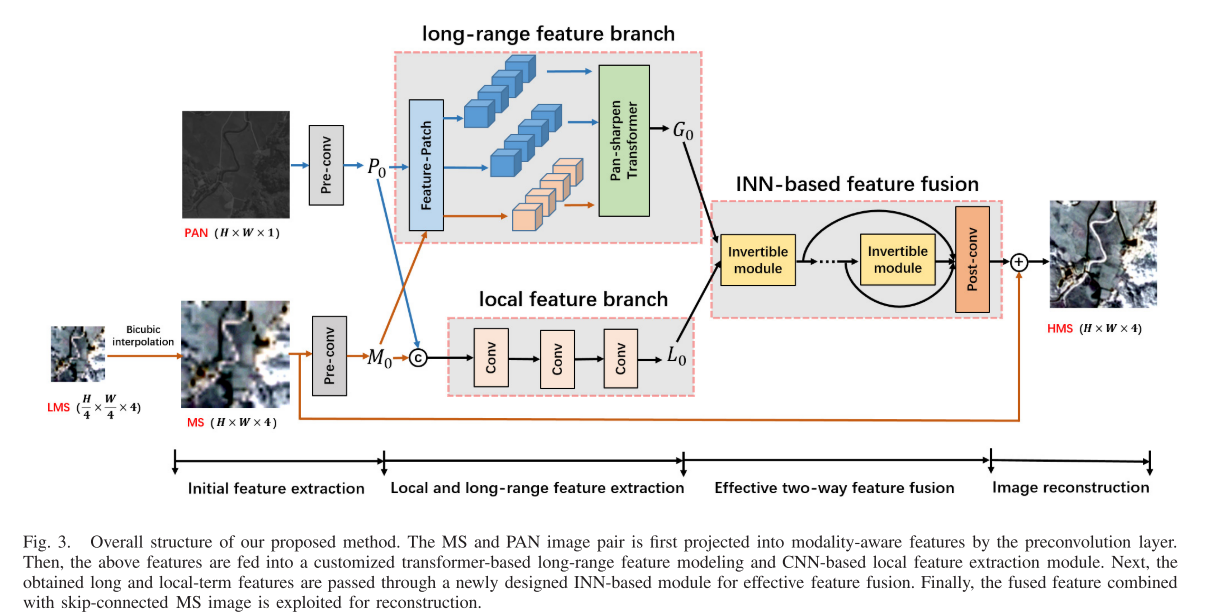

然而,上述方法并没有充分研究特征提取和融合的潜力。为此,我们设计了两种方案:1)局部和远程特征提取模块,以及2)密接可逆神经网络融合模块。具体而言,前者包括两个分支:局部卷积分支和长程Transformer分支。两种算法都以MS图像和PAN图像为输入,进行局部和长程特征提取。由于可逆神经结构的自然信息无损能力,不同于现有的采用纯卷积层来实现融合的方法,我们设计了一种新的密集连接可逆神经网络来实现有效的特征融合。具体实施方式可参见图4。

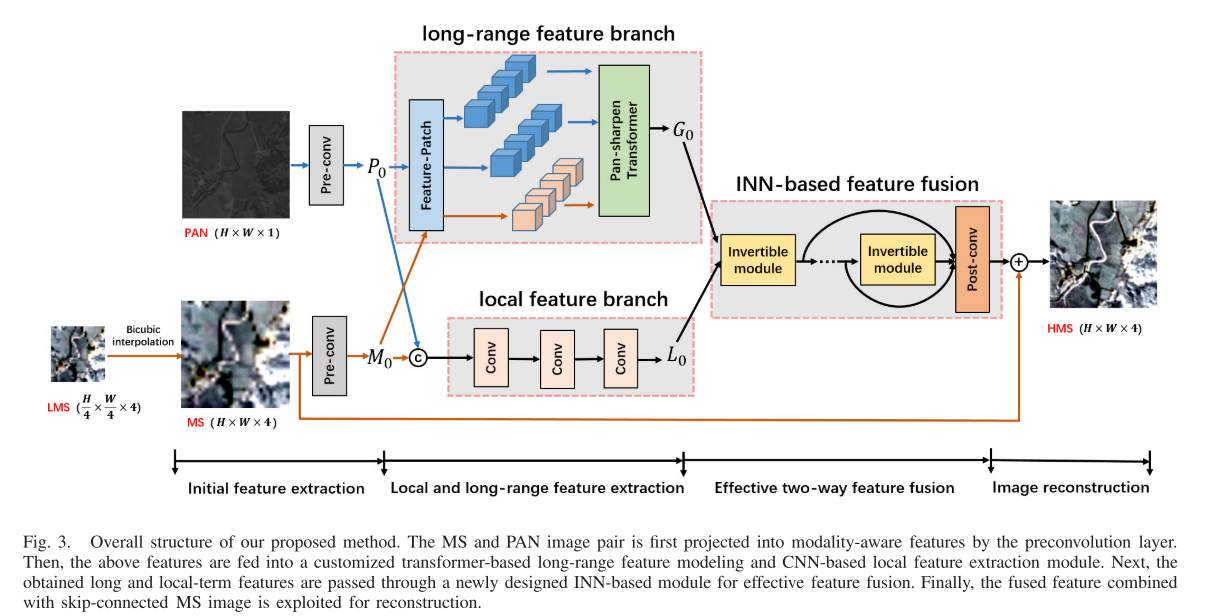

总之,本文结合Transformer结构的长程相关性建模和信息无损可逆神经网络的优点,提出了一种新的有效的全色锐化方法。据我们所知,这是首次尝试将变换器和可逆神经网络引入全色锐化领域。如图3所示,我们的方法包括三个步骤:1)通过卷积和变换进行局部和远程特征提取;2)通过密集连接可逆神经模块进行有效的局部和远程特征融合;和3)高分辨率MS图像重建。

贡献

1)结合Transformer结构的长程相关性建模和可逆神经网络有效的特征融合能力,提出了一种新的全色锐化方法。据我们所知,这是首次尝试将变换器和可逆神经网络引入全色锐化领域。

2)我们设计了一个自定义的Transformer结构用于全色锐化和一个新的密集连接的可逆神经模块。消融实验也证明了Transformer和可逆神经特征融合模块的有效性。

3)在不同类型卫星数据集上的大量实验表明,该方法在视觉和定量上都优于现有算法,且参数和运行次数较少。

相关工作

Pan-Sharpening

近年来出现了大量的全色锐化方法,这些方法可以分为两类,传统的全色锐化方法和基于深度学习的全色锐化方法。

经典的全色锐化方法主要包括分量替换、多分辨率分析和基于模型的算法。在压缩感知方法中,通常的思想是假设空间和光谱信息可以分别分解,并进一步将它们与全色模态相结合以恢复期望的全色锐化图像。具体而言,强度饱和、Brovey变换、主成分分析和Gram-Schmidt(GS)方法是主要代表。IHS融合使用IHS变换,Brovey方法使用乘法注入方案,而GS方法利用GS正交化过程。当光谱和空间信息没有得到适当的分解时,分量替换方法的结果会产生许多伪像。基于多分辨率分析的方法首先将MS和PAN图像变换为多尺度状态,然后将它们注入到预上采样的MS图像中以提供融合结果。典型算法归因于拉普拉斯金字塔和小波变换、曲波和非下采样轮廓波变换。多分辨率分析方法的性能很大程度上依赖于多尺度变换技术。基于模型的方法通过最小化损失函数将全色锐化任务公式化为优化问题,包括稀疏表示全色锐化方法、非局部、贝叶斯正则化和全变分算子。然而,这种不充分的表示限制了传统方法的性能。

近年来,受深度神经网络在各种计算机视觉任务中取得的成功的启发,研究人员开发了许多基于深度学习的全色锐化算法,其性能得到了很大的提高。最早的工作是PNN ,它只使用三个卷积单元进行映射。Yang等人采用残差机制将PNN重新开发为目标自适应框架。随后,研究人员采用多尺度和多深度卷积分支来提取更丰富的特征。Cai和Huang将全色锐化任务视为全色引导的超分辨率,并设计了渐进式全色锐化神经网络。Xu等人通过深度展开技术开发了基于模型的深度全色锐化方法。虽然上述方法取得了较好的效果,但仍存在频谱失真和空间纹理增强不足的问题。为此,本文提出了一个新的框架来解决上述问题。

Invertible Neural Network

可逆神经网络因其信息的无损失性而引起了广泛的关注并取得了很大的进展。对于这一开创性工作,可以参考NICE提出的增加耦合层的建议。然后,realnvp通过添加强倍增来修改附加耦合层,并以交替模式组合耦合层,使得输入可以在相同的机会改变。Kingma和Dhariwal提出了actnorm层,并推广了信道混洗操作。此外,ffjord、i-revnet和i-resnet进一步改进了用于密度估计的耦合层,以实现更好的生成结果。由于INN具有很强的特征表示能力,研究人员将其用于各种推理任务,如图像着色、图像重缩放和视频超分辨率。但在全色锐化领域还没有探索,我们利用INN的有效信息融合来满足全色锐化的特点,将全色图像和MS图像融合得到HR-MS图像。

Transformer

Transformer模型架构最早由Vaswani等人提出,多年来已被证明在NLP文献中极其重要。与递归神经网络和神经网络相比,基于变换器的模型的成功可以归因于它能够更好地捕获遥感信息。基于他们的成功,dosovitskiy提出了一个视觉转换器(vision converter (VIT))用于图像分类。这引起了开发基于Transformer的方法来解决视觉问题的极大兴趣,例如对象检测和分割。因此,在这项工作中,我们还使用了一个基于变换器的架构,通过使模型能够编码跨模态图像的长距离依赖性来获得改进的全色锐化性能。据我们所知,这是首次尝试将变压器引入全色锐化领域。

方法

Overall Network Architecture

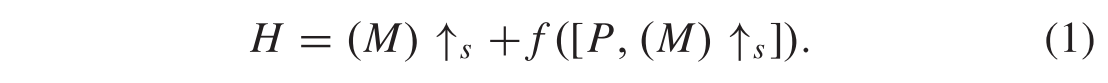

整体结构如图3所示。它以MS图像和PAN图像作为输入,并将高分辨率(HR)PAN图像的纹理细节与来自低分辨率(LR)MS图像的光谱信息相结合以生成HR-MS图像。具体地说,给定PAN图像P ∈

R

1

×

H

×

W

R^{1×H×W}

R1×H×W和MS图像M ∈

R

C

×

(

H

/

4

)

×

(

W

/

4

)

R^{C×(H/4)×(W/4)}

RC×(H/4)×(W/4),该方法首先使用两个独立的3 × 3卷积层将4次上采样的MS和PAN图像投影到具有模态特征P0和M0的特征空间中。接下来,特征图P0和M0通过双流局部和长距离特征提取模块。局部分支由几个卷积层组成,并提供局部范围特征图,而变换分支利用多头关注来生成来自P0和M0的展平特征面片之间的长程特征。所获得的局部特征和长程特征被标记为L0和G0。接着,将这两个特征进一步传播到密集连接的可逆特征融合神经模块,以实现有效的融合。具体地说,这两种特征相互作用以增强它们的表示。然后,将增强表示变换为与上采样MS图像相同的大小和通道。最后,我们通过跳跃连接将上采样MS图像添加到变换表示中来构造HR-MS图像。全色锐化过程可以描述为

注意,我们的网络f(·)的直接输出是残余高频细节,这是现有方法中用于简化学习的常用技术。

Local and Long-Range Feature Extraction

如图3所示,我们设计的特征提取模块由两个分支组成:通过卷积层的局部范围特征分支和通过Transformer结构的长范围特征分支。为了保持MS图像和PAN图像的初始特征,将上采样后的MS图像MΛ∈

R

C

×

H

×

W

R^{C×H×W}

RC×H×W和PAN图像P ∈

R

1

×

H

×

W

R^{1×H×W}

R1×H×W分别送入两个独立的3 × 3卷积层,得到M0∈

R

8

×

H

×

W

R^{8×H×W}

R8×H×W和P0 ∈

R

8

×

H

×

W

R^{8×H×W}

R8×H×W的浅层特征。然后,通过信道维度级联M0和P0被传递到上述两个分支。

具体地,局部特征分支由3×3卷积层实现,并且接收全分辨率特征图M0和P0以提取局部范围特征L0。在长程特征分支中,使用新设计的Transformer来产生长程相关性。正如所认识到的,标准Transformer被设计成捕获单个图像的所有标记之间的长程自相似依赖性。由于全色锐化需要整合两种图像(MS图像和PAN图像)之间的互补信息的性质,直接将标准Transformer架构应用于全色锐化任务是不合适的。我们的变压器结构如图5所示。Transformer将划分的MS和PAN特征面片

M

1

M^1

M1,…,

M

n

M^n

Mn和

P

1

P^1

P1,…,

P

n

P^n

Pn,具有16 × 16像素大小,作为来自浅全分辨率特征M0和P0的输入。

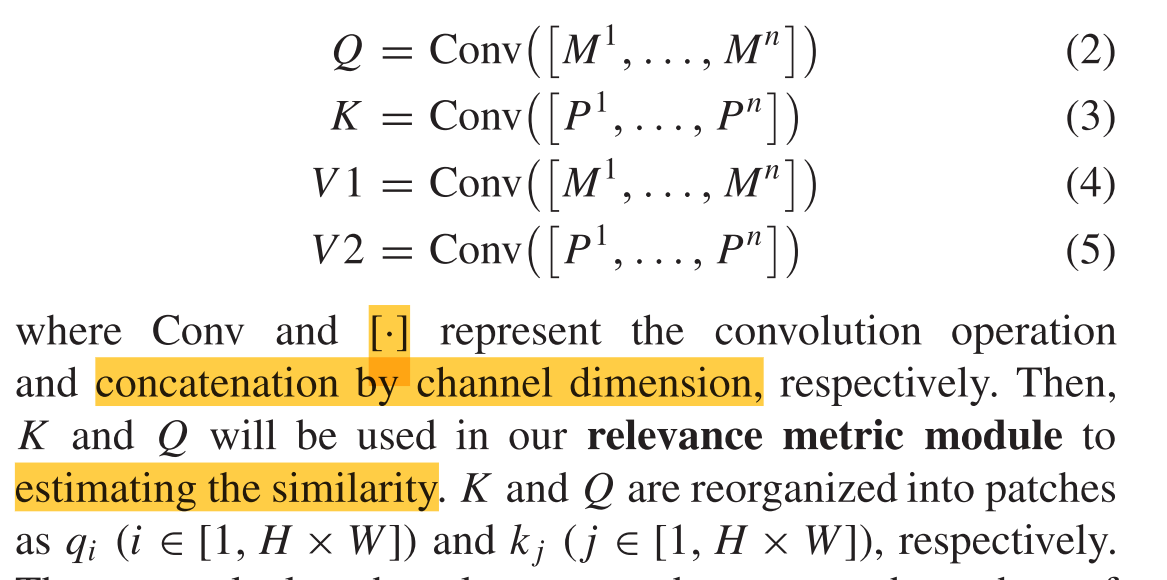

首先,我们使用几个卷积层来投影MS和PAN特征面片

M

1

M^1

M1,…,

M

n

M^n

Mn和

P

1

P^1

P1,…,

P

n

P^n

Pn与16 × 16像素大小的纹理特征,Q (query),K (key)和 V (value)是一个多芯Transformer内部的三个必要组件。与标准变压器不同,我们将V(value)扩展为两个分量V1和V2,即

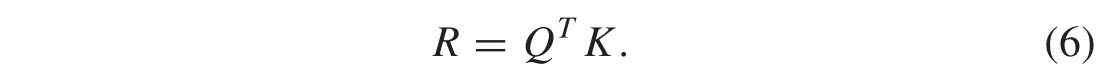

然后,我们通过如下规则计算Q的每个片qi与K中的kj之间的相关性ri,j:ri,j =((qi/||qi||),(kj/|| kj||))。整个相关性度量矩阵表示为:

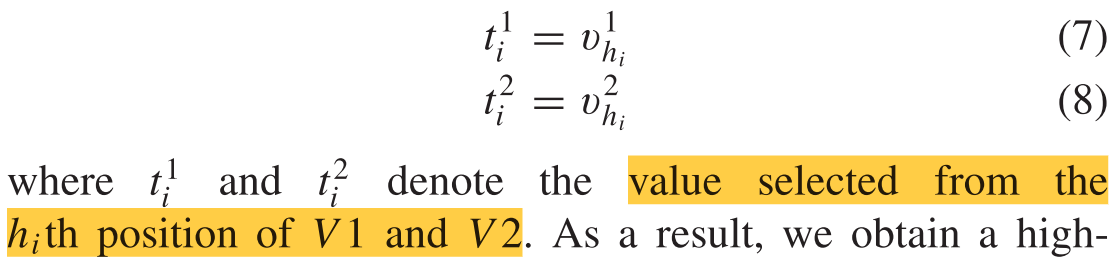

然后,我们进一步使用关联矩阵R来生成硬注意图和软注意图。与传统的注意操作对每个查询qi采用加权V的求和算子不同,本文设计了两个核心注意模块:硬注意模块和软注意模块,将图像纹理特征V注入到HR-MS图像中。具体而言,我们首先计算硬注意映射H,其中我们从相关性ri,j获得第i个元素hi(i ∈[1,H × W]):hj= argmax(ri,j)。然后,通过参考硬注意图,对展开的面片V1和V2实施索引选择操作

结果表明,通过位置索引关注,我们得到了PAN特征和MS特征的高分辨率特征表示T1和T2。此外,我们计算软注意图为

结果表明,通过位置索引关注,我们得到了PAN特征和MS特征的高分辨率特征表示T1和T2。此外,我们计算软注意图为

其中softmax是数学中的softmax函数。最后,将软注意图和硬注意图与PAN特征相结合,得到增强的长程特征G0

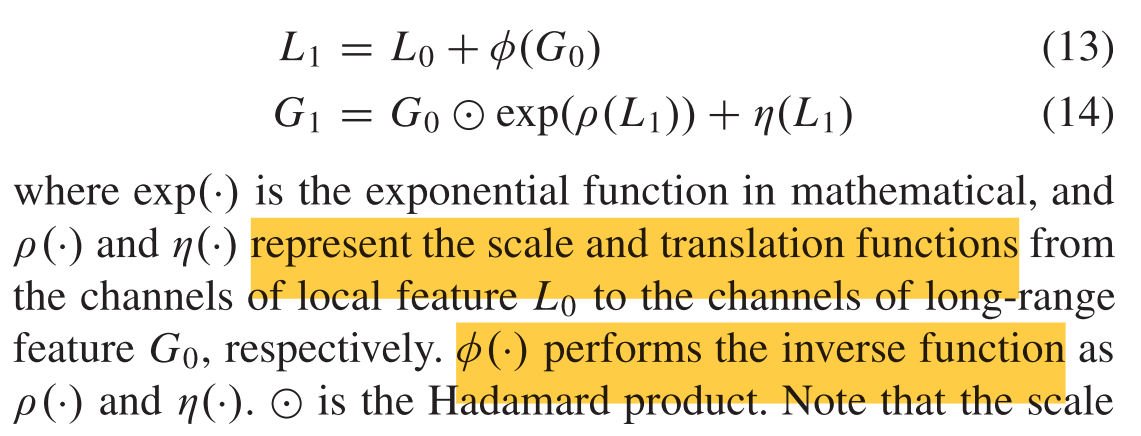

Invertible Neural Module for Feature Fusion

与纯卷积层不同,可逆网络在变换过程中是信息无损的。对于可逆模型,输入需要分成两部分。在我们的工作中,可逆模块的输入自然地包括两部分,局部和长程特征L0和G0,这与输入的分离完全匹配。为了利用可逆网络保持提取的特征,我们设计了一个由一堆可逆基本单元组成的稠密连接的可逆特征融合神经模块。如图4(a)所示,我们在这项工作中遵循的每个基本单元都是仿射耦合层。

为了增加网络的表示能力,提出了两种方案:1)将每个可逆单元的直接序列特征通过跳跃连接传播到最后一个可逆单元,然后进行级联以增强其表示; 2)设计了两个可逆单元之间的有效变换操作。具体地说,我们对长程分支使用加性变换,而对局域分支使用增强的仿射变换。以第一仿射耦合层为例,给定局部和远程特征L0和G~0`,输出将被计算为

注意,尺度函数和平移函数不一定可逆,因此,我们通过神经网络来实现它们。通过这样做,其他k−1个可逆块接收前一个块的输出并生成结果。所有输出L0/G 0,…利用残差通道关注块将每个可逆单元的Lk/Gk级联生成高频细节,然后与输入的低空间MS图像相加,跳接得到HR-MS图像。

其中,RCAB 和[·]表示通过信道维度的残余信道关注度和级联。k是我们堆叠的可逆神经单元的数目,并且设置为3以减少计算成本。

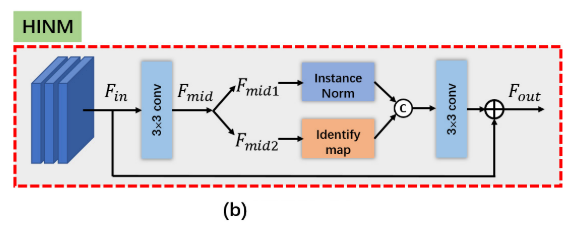

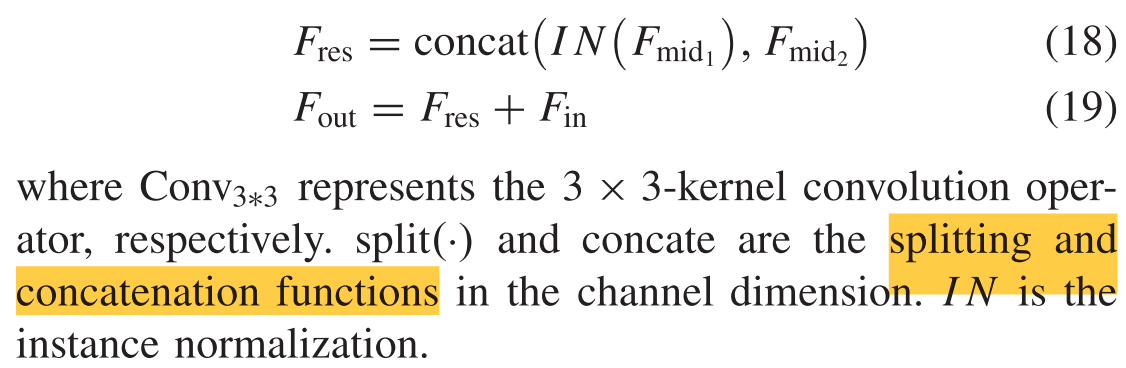

此外,为了增强与两部分特征的交互,我们使用两个级联的半实例归一化(half instance normalization (HIN))块来实现变换操作ρ(·)、η(·)和φ(·)。如图4(b)所示,

HIN模块首先使用3 × 3卷积将输入特征Fin ∈

R

C

i

n

×

H

×

W

R^{C~in~×H×W}

RC in ×H×W投影到中间特征Fmid ∈

R

16

×

H

×

W

R^{16×H×W}

R16×H×W。然后将特征Fmid1/Fmid2 ∈

R

8

×

H

×

W

R^{8×H×W}

R8×H×W分为两部分,第一部分Fmid1 通过实例归一化(IN)进行归一化,然后与Fmid2通过信道维数进行连接。HIN块在Fmid1上采用IN,并通过Fmid2保持上下文信息。级联运算后,将得到的特征Fres送入一层3×3卷积算子和两个leaky ReLU激活函数。最后,HIN块通过将Fres与跳过连接的特征Fin相加来输出增强的特征Fout,如

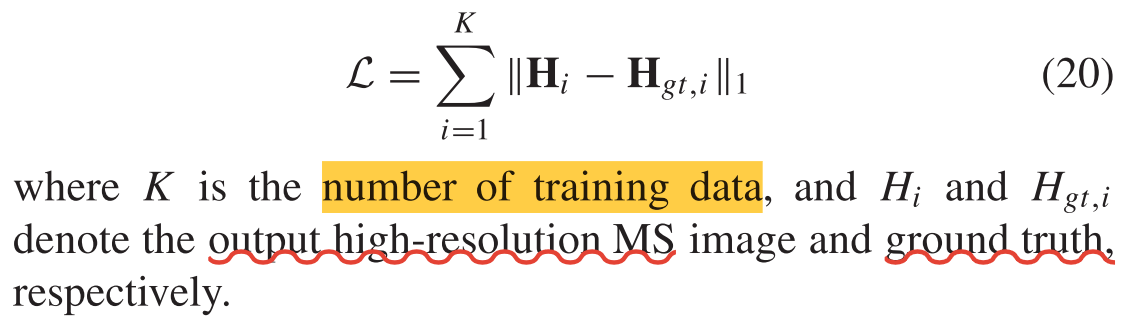

Network Loss Function

我们采用平均绝对误差(L1损失)来优化我们提出的方法