目录

Redis 主从复制

主从复制的作用

主从复制流程

搭建Redis 主从复制

实验环境

所有主机安装redis

修改 Redis 配置文件(Master节点操作)

修改 Redis 配置文件(Slave节点操作)

验证主从效果

Redis 哨兵模式

哨兵模式的作用

哨兵结构

故障转移机制

主节点的选举

搭建Redis 哨兵模式

修改 Redis 哨兵模式的配置文件(所有节点操作)

启动哨兵模式

查看哨兵信息

故障模拟

Redis 群集模式

集群的作用

Redis集群的数据分片

Redis集群的主从复制模型

搭建Redis 群集模式

开启群集功能

启动redis节点

启动集群

测试群集

Redis 主从复制

主从复制,是指将一台Redis服务器的数据,复制到其他的Redis服务器。前者称为主节点(Master),后者称为从节点(Slave);数据的复制是单向的,只能由主节点到从节点。

默认情况下,每台Redis服务器都是主节点;且一个主节点可以有多个从节点(或没有从节点),但一个从节点只能有一个主节点。

主从复制的作用

●数据冗余:主从复制实现了数据的热备份,是持久化之外的一种数据冗余方式。

●故障恢复:当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复;实际上是一种服务的冗余。

●负载均衡:在主从复制的基础上,配合读写分离,可以由主节点提供写服务,由从节点提供读服务(即写Redis数据时应用连接主节点,读Redis数据时应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个从节点分担读负载,可以大大提高Redis服务器的并发量。

●高可用基石:除了上述作用以外,主从复制还是哨兵和集群能够实施的基础,因此说主从复制是Redis高可用的基础。

主从复制流程

(1)若启动一个Slave机器进程,则它会向Master机器发送一个“sync command”命令,请求同步连接。

(2)无论是第一次连接还是重新连接,Master机器都会启动一个后台进程,将数据快照保存到数据文件中(执行rdb操作),同时Master还会记录修改数据的所有命令并缓存在数据文件中。

(3)后台进程完成缓存操作之后,Master机器就会向Slave机器发送数据文件,Slave端机器将数据文件保存到硬盘上,然后将其加载到内存中,接着Master机器就会将修改数据的所有操作一并发送给Slave端机器。若Slave出现故障导致宕机,则恢复正常后会自动重新连接。

(4)Master机器收到Slave端机器的连接后,将其完整的数据文件发送给Slave端机器,如果Master同时收到多个Slave发来的同步请求,则Master会在后台启动一个进程以保存数据文件,然后将其发送给所有的Slave端机器,确保所有的Slave端机器都正常

搭建Redis 主从复制

实验环境

master:192.168.142.20

slave1:192.168.142.40

slave2:192.168.142.50

所有主机安装redis

//环境准备

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

#修改内核参数

vim /etc/sysctl.conf

vm.overcommit_memory = 1

net.core.somaxconn = 2048

sysctl -p//安装redis

yum install -y gcc gcc-c++ make

tar zxvf /opt/redis-7.0.9.tar.gz -C /opt/

cd /opt/redis-7.0.9

make

make PREFIX=/usr/local/redis install

#由于Redis源码包中直接提供了 Makefile 文件,所以在解压完软件包后,不用先执行 ./configure 进行配置,可直接执行 make 与 make install 命令进行安装。

#创建redis工作目录

mkdir /usr/local/redis/{conf,log,data}

cp /opt/redis-7.0.9/redis.conf /usr/local/redis/conf/

useradd -M -s /sbin/nologin redis

chown -R redis.redis /usr/local/redis/

#环境变量

vim /etc/profile

PATH=$PATH:/usr/local/redis/bin #增加一行

source /etc/profile//定义systemd服务管理脚本

vim /usr/lib/systemd/system/redis-server.service

[Unit]

Description=Redis Server

After=network.target

[Service]

User=redis

Group=redis

Type=forking

TimeoutSec=0

PIDFile=/usr/local/redis/log/redis_6379.pid

ExecStart=/usr/local/redis/bin/redis-server /usr/local/redis/conf/redis.conf

ExecReload=/bin/kill -s HUP $MAINPID

ExecStop=/bin/kill -s QUIT $MAINPID

PrivateTmp=true

[Install]

WantedBy=multi-user.target修改 Redis 配置文件(Master节点操作)

vim /usr/local/redis/conf/redis.conf

bind 0.0.0.0 #87行,修改监听地址为0.0.0.0

protected-mode no #111行,将本机访问保护模式设置no

port 6379 #138行,Redis默认的监听6379端口

daemonize yes #309行,设置为守护进程,后台启动

pidfile /usr/local/redis/log/redis_6379.pid #341行,指定 PID 文件

logfile "/usr/local/redis/log/redis_6379.log" #354行,指定日志文件

dir /usr/local/redis/data #504行,指定持久化文件所在目录

#requirepass abc123 #1037行,可选,设置redis密码

appendonly yes #1380行,开启AOF

systemctl restart redis-server.service修改 Redis 配置文件(Slave节点操作)

vim /usr/local/redis/conf/redis.conf

bind 0.0.0.0 #87行,修改监听地址为0.0.0.0

protected-mode no #111行,将本机访问保护模式设置no

port 6379 #138行,Redis默认的监听6379端口

daemonize yes #309行,设置为守护进程,后台启动

pidfile /usr/local/redis/log/redis_6379.pid #341行,指定 PID 文件

logfile "/usr/local/redis/log/redis_6379.log" #354行,指定日志文件

dir /usr/local/redis/data #504行,指定持久化文件所在目录

#requirepass abc123 #1037行,可选,设置redis密码

appendonly yes #1380行,开启AOF

replicaof 192.168.142.20 6379 #528行,指定要同步的Master节点IP和端口

#masterauth abc123 #535行,可选,指定Master节点的密码,仅在Master节点设置了requirepass

systemctl restart redis-server.service

验证主从效果

在Master节点上看日志:

tail -f /usr/local/redis/log/redis_6379.log

Replica 192.168.80.11:6379 asks for synchronization

Replica 192.168.80.12:6379 asks for synchronization

Synchronization with replica 192.168.80.11:6379 succeeded

Synchronization with replica 192.168.80.12:6379 succeeded

在Master节点上验证从节点:

redis-cli info replication

# Replication

role:master

connected_slaves:2

slave0:ip=192.168.80.11,port=6379,state=online,offset=1246,lag=0

slave1:ip=192.168.80.12,port=6379,state=online,offset=1246,lag=1Redis 哨兵模式

主从切换技术的方法是:当服务器宕机后,需要手动一台从机切换为主机,这需要人工干预,不仅费时费力而且还会造成一段时间内服务不可用。为了解决主从复制的缺点,就有了哨兵机制。

哨兵的核心功能:在主从复制的基础上,哨兵引入了主节点的自动故障转移。

哨兵模式的作用

●监控:哨兵会不断地检查主节点和从节点是否运作正常。

●自动故障转移:当主节点不能正常工作时,哨兵会开始自动故障转移操作,它会将失效主节点的其中一个从节点升级为新的主节点,并让其它从节点改为复制新的主节点。

●通知(提醒):哨兵可以将故障转移的结果发送给客户端。

哨兵结构

哨兵结构由两部分组成,哨兵节点和数据节点:

●哨兵节点:哨兵系统由一个或多个哨兵节点组成,哨兵节点是特殊的redis节点,不存储数据。

●数据节点:主节点和从节点都是数据节点。

故障转移机制

1.由哨兵节点定期监控发现主节点是否出现了故障

每个哨兵节点每隔1秒会向主节点、从节点及其它哨兵节点发送一次ping命令做一次心跳检测。如果主节点在一定时间范围内不回复或者是回复一个错误消息,那么这个哨兵就会认为这个主节点主观下线了(单方面的)。当超过半数哨兵节点认为该主节点主观下线了,这样就客观下线了。

2.当主节点出现故障,此时哨兵节点会通过Raft算法(选举算法)实现选举机制共同选举出一个哨兵节点为leader,来负责处理主节点的故障转移和通知。所以整个运行哨兵的集群的数量不得少于3个节点。

3.由leader哨兵节点执行故障转移,过程如下:

●将某一个从节点升级为新的主节点,让其它从节点指向新的主节点;

●若原主节点恢复也变成从节点,并指向新的主节点;

●通知客户端主节点已经更换。

需要特别注意的是,客观下线是主节点才有的概念;如果从节点和哨兵节点发生故障,被哨兵主观下线后,不会再有后续的客观下线和故障转移操作。

主节点的选举

1.过滤掉不健康的(已下线的),没有回复哨兵 ping 响应的从节点。

2.选择配置文件中从节点优先级配置最高的。(replica-priority,默认值为100)

3.选择复制偏移量最大,也就是复制最完整的从节点。

哨兵的启动依赖于主从模式,所以须把主从模式安装好的情况下再去做哨兵模式

搭建Redis 哨兵模式

Master节点:192.168.142.20

Slave1节点:192.168.142.50

Slave2节点:192.168.142.60

systemctl stop firewalld

setenforce 0修改 Redis 哨兵模式的配置文件(所有节点操作)

cp /opt/redis-7.0.9/sentinel.conf /usr/local/redis/conf/

chown redis.redis /usr/local/redis/conf/sentinel.conf

vim /usr/local/redis/conf/sentinel.conf

protected-mode no #6行,关闭保护模式

port 26379 #10行,Redis哨兵默认的监听端口

daemonize yes #15行,指定sentinel为后台启动

pidfile /usr/local/redis/log/redis-sentinel.pid #20行,指定 PID 文件

logfile "/usr/local/redis/log/sentinel.log" #25行,指定日志存放路径

dir /usr/local/redis/data #54行,指定数据库存放路径

sentinel monitor mymaster 192.168.80.10 6379 2 #73行,修改 指定该哨兵节点监控192.168.80.10:6379这个主节点,该主节点的名称是mymaster,最后的2的含义与主节点的故障判定有关:至少需要2个哨兵节点同意,才能判定主节点故障并进行故障转移

#sentinel auth-pass mymaster abc123 #76行,可选,指定Master节点的密码,仅在Master节点设置了requirepass

sentinel down-after-milliseconds mymaster 3000 #114行,判定服务器down掉的时间周期,默认30000毫秒(30秒)

sentinel failover-timeout mymaster 180000 #214行,同一个sentinel对同一个master两次failover之间的间隔时间(180秒)启动哨兵模式

先启master,再启slave

cd /usr/local/redis/conf/

redis-sentinel sentinel.conf &查看哨兵信息

redis-cli -p 26379 info Sentinel

# Sentinel

sentinel_masters:1

sentinel_tilt:0

sentinel_running_scripts:0

sentinel_scripts_queue_length:0

sentinel_simulate_failure_flags:0

master0:name=mymaster,status=ok,address=192.168.80.10:6379,slaves=2,sentinels=3故障模拟

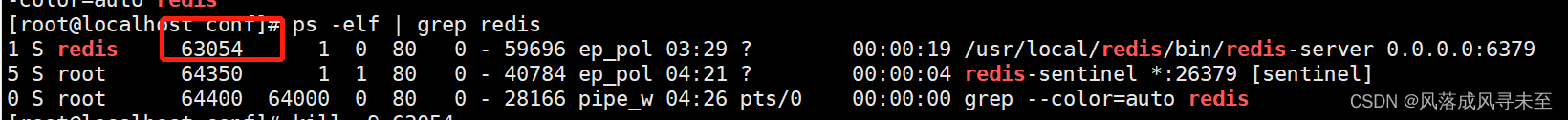

查看redis-server进程号

杀死 Master 节点上redis-server的进程号

kill -9 63054验证结果

redis-cli -p 26379 INFO SentinelRedis 群集模式

集群,即Redis Cluster,是Redis 3.0开始引入的分布式存储方案。

集群由多组节点(Node)组成,Redis的数据分布在这些节点中。集群中的节点分为主节点和从节点:只有主节点负责读写请求和集群信息的维护;从节点只进行主节点数据和状态信息的复制。

集群的作用

(1)数据分区:数据分区(或称数据分片)是集群最核心的功能。

集群将数据分散到多个节点,一方面突破了Redis单机内存大小的限制,存储容量大大增加;另一方面每个主节点都可以对外提供读服务和写服务,大大提高了集群的响应能力。

Redis单机内存大小受限问题,在介绍持久化和主从复制时都有提及;例如,如果单机内存太大,bgsave和bgrewriteaof的fork操作可能导致主进程阻塞,主从环境下主机切换时可能导致从节点长时间无法提供服务,全量复制阶段主节点的复制缓冲区可能溢出。

(2)高可用:集群支持主从复制和主节点的自动故障转移(与哨兵类似);当任一节点发生故障时,集群仍然可以对外提供服务。

Redis集群的数据分片

Redis集群引入了哈希槽的概念

Redis集群有16384个哈希槽(编号0-16383)

集群的每组节点负责一部分哈希槽

每个Key通过CRC16校验后对16384取余来决定放置哪个哈希槽,通过这个值,去找到对应的插槽所对应的节点,然后直接自动跳转到这个对应的节点上进行存取操作

#以3个节点组成的集群为例:

节点A包含0到5460号哈希槽

节点B包含5461到10922号哈希槽

节点C包含10923到16383号哈希槽

Redis集群的主从复制模型

集群中具有A、B、C三个节点,如果节点B失败了,整个集群就会因缺少5461-10922这个范围的槽而不可以用。

为每个节点添加一个从节点A1、B1、C1整个集群便有三个Master节点和三个slave节点组成,在节点B失败后,集群选举B1位为的主节点继续服务。当B和B1都失败后,集群将不可用。

搭建Redis 群集模式

redis的集群一般需要6个节点,3主3从。方便起见,这里所有节点在同一台服务器上模拟:

以端口号进行区分:3个主节点端口号:6001/6002/6003,对应的从节点端口号:6004/6005/6006

cd /usr/local/redis/

mkdir -p redis-cluster/redis600{1..6}

for i in {1..6}

do

cp /opt/redis-7.0.9/redis.conf /usr/local/redis/redis-cluster/redis600$i

cp /opt/redis-7.0.9/src/redis-cli /opt/redis-7.0.9/src/redis-server /usr/local/redis/redis-cluster/redis600$i

done开启群集功能

#其他5个文件夹的配置文件以此类推修改,注意6个端口都要不一样。

cd /usr/local/redis/redis-cluster/redis6001

vim redis.conf

#bind 127.0.0.1 #87行,注释掉bind项,默认监听所有网卡

protected-mode no #111行,关闭保护模式

port 6001 #138行,修改redis监听端口

daemonize yes #309行,设置为守护进程,后台启动

pidfile /usr/local/redis/log/redis_6001.pid #341行,指定 PID 文件

logfile "/usr/local/redis/log/redis_6001.log" #354行,指定日志文件

dir ./ #504行,指定持久化文件所在目录

appendonly yes #1379行,开启AOF

cluster-enabled yes #1576行,取消注释,开启群集功能

cluster-config-file nodes-6001.conf #1584行,取消注释,群集名称文件设置

cluster-node-timeout 15000 #1590行,取消注释群集超时时间设置另外的5个节点服务器,他们的配置是一样的,注意修改端口号,PID文件,日志文件,群集名称文件

启动redis节点

分别进入那六个文件夹,执行命令:redis-server redis.conf ,来启动redis节点

cd /usr/local/redis/redis-cluster/redis6001

redis-server redis.conf

for d in {1..6}

do

cd /usr/local/redis/redis-cluster/redis600$d

./redis-server redis.conf

done

ps -ef | grep redis启动集群

redis-cli --cluster create 127.0.0.1:6001 127.0.0.1:6002 127.0.0.1:6003 127.0.0.1:6004 127.0.0.1:6005 127.0.0.1:6006 --cluster-replicas 1

#六个实例分为三组,每组一主一从,前面的做主节点,后面的做从节点。下面交互的时候 需要输入 yes 才可以创建。

--replicas 1 表示每个主节点有1个从节点。测试群集

redis-cli -p 6001 -c #加-c参数,节点之间就可以互相跳转

127.0.0.1:6001> cluster slots #查看节点的哈希槽编号范围

1) 1) (integer) 5461

2) (integer) 10922 #哈希槽编号范围

3) 1) "127.0.0.1"

2) (integer) 6003 #主节点IP和端口号

3) "fdca661922216dd69a63a7c9d3c4540cd6baef44"

4) 1) "127.0.0.1"

2) (integer) 6004 #从节点IP和端口号

3) "a2c0c32aff0f38980accd2b63d6d952812e44740"

2) 1) (integer) 0

2) (integer) 5460

3) 1) "127.0.0.1"

2) (integer) 6001

3) "0e5873747a2e26bdc935bc76c2bafb19d0a54b11"

4) 1) "127.0.0.1"

2) (integer) 6006

3) "8842ef5584a85005e135fd0ee59e5a0d67b0cf8e"

3) 1) (integer) 10923

2) (integer) 16383

3) 1) "127.0.0.1"

2) (integer) 6002

3) "816ddaa3d1469540b2ffbcaaf9aa867646846b30"

4) 1) "127.0.0.1"

2) (integer) 6005

3) "f847077bfe6722466e96178ae8cbb09dc8b4d5eb"127.0.0.1:6001> set name zhangsan

-> Redirected to slot [5798] located at 127.0.0.1:6003

OK

127.0.0.1:6001> cluster keyslot name #查看name键的槽编号

redis-cli -p 6004 -c

127.0.0.1:6004> keys * #对应的slave节点也有这条数据,但是别的节点没有

1) "name"

redis-cli -p 6001 -c cluster nodes

![2023年中国医疗传感器行业现状分析:市场国有化率低[图]](https://img-blog.csdnimg.cn/img_convert/39ef84436d0174bb4f8eb966c3952a6c.png)