文章目录

- 1 概率论部分 (1-4)

- 概率空间

- 随机变量

- 概率分布

- 随机变量的函数仍然是随机变量

- 条件期望

- 2 随机过程 (5-7)

- 随机过程

- Martingale

- 停时

- 马尔科夫链

- 3 参数估计 (8-10)

- 参数估计问题

- 充分统计量

- 贝叶斯估计

- 非随机估计

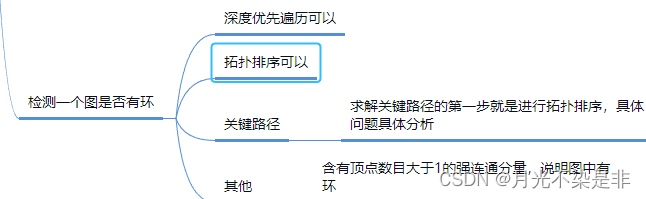

部分思维导图如下,私信发送html完整版

1 概率论部分 (1-4)

概率空间

-

概率空间的三要素:( Ω , F , P ) \Omega,\mathcal{F},P) Ω,F,P) ⇒ \Rightarrow ⇒ (样本,事件,概率测度)

-

样本:实验的实际结果

-

事件:样本空间的一个子集,可以理解为使用一个谓词对样本的归类/判别

-

σ \sigma σ域

-

要求定义的事件空间是一个 σ \sigma σ域,应该满足的条件:

- ∅ ∈ F \emptyset\in \mathcal{F} ∅∈F

- if A ∈ F A\in\mathcal{F} A∈F, then A c ∈ F A^c\in\mathcal{F} Ac∈F

- F \mathcal{F} F 中元素的个数一定偶数

- if A 1 , A 2 , . . . ∈ F A_1,A_2,...\in \mathcal{F} A1,A2,...∈F, then ∪ i = 1 ∞ A i ∈ F \cup_{i=1}^\infty A_i \in \mathcal{F} ∪i=1∞Ai∈F

-

σ \sigma σ域体现了对样本辨别的精度: 原子(atom)事件的精度

-

最小 σ \sigma σ 域

- { ∅ , Ω } \{\emptyset, \Omega\} {∅,Ω}.

-

-

-

概率测度:将事件映射到概率的函数 P : F → [ 0 , 1 ] P:\mathcal{F}\rightarrow [0,1] P:F→[0,1],满足以下性质:

- P ( ∅ ) = 0 , P ( Ω ) = 1 P(\emptyset)=0, P(\Omega)=1 P(∅)=0,P(Ω)=1.

- P ( ∪ i = 1 ∞ A i ) = ∑ i = 1 ∞ P ( A i ) P(\cup_{i=1}^{\infty}A_i)=\sum_{i=1}^\infty P(A_i) P(∪i=1∞Ai)=∑i=1∞P(Ai).

随机变量

-

定义: X : Ω → R X:\Omega\rightarrow \mathbb{R} X:Ω→R 对实验结果的观测函数

-

F \mathcal{F} F-Measurable: 任何一个 B ∈ B ( R ) B\in \mathcal{B}(\mathbb{R}) B∈B(R)都能找到一个事件 X − 1 ( B ) X^{-1}(B) X−1(B)与之对应 ⇒ \Rightarrow ⇒ 随机变量的设置应是在事件空间可辨别的

- Borel σ \sigma σ-field B ( R ) \mathcal{B}(\mathbb{R}) B(R): 包含所有左开右闭的子集的唯一最小 σ \sigma σ域

-

概率测度: 将随机变量的范围(Borel set)映射为概率的函数 P X : B ( ( R ) ) → [ 0 , 1 ] P_X: \mathcal{B}(\mathbb(R)) \rightarrow [0,1] PX:B((R))→[0,1].

- P X ( B ) : = P ( X − 1 ( B ) ) P_X(B):=P(X^{-1}(B)) PX(B):=P(X−1(B))

-

根据随机变量定义的事件空间( σ \sigma σ-field): σ ( X ) = { X − 1 ( B ) : B ∈ B ( R ) } \sigma(X) = \{X^{-1}(B): B\in\mathcal{B}(\mathbb{R})\} σ(X)={X−1(B):B∈B(R)}.

- 随机变量的设置取决于事件空间的分辨能力

-

独立性

-

随机变量的独立性: 随机变量的取值不相互影响 { X ∈ A } \{X\in A\} {X∈A} 与 { Y ∈ B } \{Y\in B\} {Y∈B} 相互独立

-

事件空间的独立性:两个sigma域讨论的不是同一个东西,任意两个事件提供的信息不重合 A ∈ G A\in \mathcal{G} A∈G 和 B ∈ H B\in\mathcal{H} B∈H 相互独立

-

随机变量的独立本质上是对应的事件空间的独立

-

-

无关性

-

两个随机变量是否线性相关

-

评价指标

-

协方差covariance:

- c o v ( X , Y ) = E ( ( X − E ( X ) ) ( Y − E ( Y ) ) ) = E ( X Y ) − E ( X ) E ( Y ) = 0 cov(X,Y)=E((X-E(X))(Y-E(Y)))=E(XY)-E(X)E(Y)=0 cov(X,Y)=E((X−E(X))(Y−E(Y)))=E(XY)−E(X)E(Y)=0.

-

相关系数 correlation

- ρ ( X , Y ) = E [ ( E ( X − E ( X ) ) v a r ( X ) ) ( E ( Y − E ( Y ) ) v a r ( Y ) ) ] = c o v ( X , Y ) v a r ( X ) v a r ( Y ) = 0 \rho(X,Y)=E\left[\left(\frac{E(X-E(X))}{\sqrt{var(X)}}\right)\left(\frac{E(Y-E(Y))}{\sqrt{var(Y)}}\right)\right]=\frac{cov(X,Y)}{\sqrt{var(X) var(Y)}}=0 ρ(X,Y)=E[(var(X)E(X−E(X)))(var(Y)E(Y−E(Y)))]=var(X)var(Y)cov(X,Y)=0.

-

-

概率分布

-

CDF 累计分布函数 F X : R → [ 0 , 1 ] F_X:\mathbb{R}\rightarrow [0,1] FX:R→[0,1].

-

∀ x ∈ R : F X ( x ) = P ( X ≤ x ) = P X ( ( − ∞ , x ) ) \forall x\in \mathbb{R}: F_X(x)=P(X\leq x) = P_X((-\infty,x)) ∀x∈R:FX(x)=P(X≤x)=PX((−∞,x)).

-

F X F_X FX的3条性质

- 左0右1

- 单调递增

- 右连续 (连续随机变量的CDF左右连续)

-

-

概率质量/密度函数

-

离散 PMF: p X ( x ) = P ( X = x ) p_X(x) = P(X=x) pX(x)=P(X=x)

-

连续 PDF: f X ( x ) f_X(x) fX(x)的特性

- 积分为1,处处非负 ∫ R f X ( x ) d x = 1 \int_{\mathbb{R}}f_X(x)dx=1 ∫RfX(x)dx=1.

- 特定一点概率为0, 可数集合概率为0

-

-

联合概率分布

-

联合CDF

- F X Y ( x , y ) = P ( X ≤ x , Y ≤ y ) F_{XY}(x,y)=P(X\leq x, Y\leq y) FXY(x,y)=P(X≤x,Y≤y).

- X,Y独立的充要条件

- F X Y ( x , y ) = F X ( x ) F Y ( y ) F_{XY}(x,y)=F_X(x)F_Y(y) FXY(x,y)=FX(x)FY(y).

- 独立同分布(i.i.d.)

- P X i = P X j ∀ i , j P_{X_i}=P_{X_j} \forall i,j PXi=PXj∀i,j.

-

联合PMF

- p X Y ( x , y ) = P ( X = x , Y = y ) p_{XY}(x,y) = P(X=x,Y=y) pXY(x,y)=P(X=x,Y=y)

-

联合PDF

- 连续随机变量独立的充要条件

- f X Y ( x , y ) = f X ( x ) f Y ( y ) f_{XY}(x,y)=f_X(x)f_Y(y) fXY(x,y)=fX(x)fY(y).

- 连续随机变量独立的充要条件

-

随机变量的函数仍然是随机变量

- 期望 E ( X ) E(X) E(X)

- 方差 v a r ( X ) = E ( ( X − E ( X ) ) 2 ) = E ( X 2 ) − E 2 ( X ) var(X)=E((X-E(X))^2)=E(X^2)-E^2(X) var(X)=E((X−E(X))2)=E(X2)−E2(X).

- k k k阶矩 E ( X k ) E(X^k) E(Xk)

- k k k阶中心矩 E ( ( X − E ( X ) ) k ) E((X-E(X))^k) E((X−E(X))k)

条件期望

-

条件概率 由 P ( B ∣ A ) = P ( A ∩ B ) P ( A ) P(B|A)=\frac{P(A \cap B)}{P(A)} P(B∣A)=P(A)P(A∩B).

-

贝叶斯公式

- P ( A i ∣ B ) = P ( B ∣ A i ) P ( A i ) ∑ i = 1 n P ( B ∣ A i ) P ( A i ) P(A_i|B)=\frac{P(B|A_i)P(A_i)}{\sum\limits_{i=1}^n P(B|A_i)P(A_i)} P(Ai∣B)=i=1∑nP(B∣Ai)P(Ai)P(B∣Ai)P(Ai).

-

条件PMF: p Y ∣ X ( y i ∣ x i ) : = p X Y ( x i , y i ) p X x i p_{Y|X}(y_i|x_i):=\frac{p_{XY}(x_i,y_i)}{p_X{x_i}} pY∣X(yi∣xi):=pXxipXY(xi,yi) .

-

条件PDF: f Y ∣ X ( y ∣ x ) : = f X Y ( x , y ) f X ( x ) f_{Y|X}(y|x):=\frac{f_{XY}(x,y)}{f_X(x)} fY∣X(y∣x):=fX(x)fXY(x,y).

-

-

随机变量的条件期望

-

E ( Y ∣ X = x i ) = ∑ y j ∈ D Y y i p Y ∣ X ( y i ∣ x 1 ) E(Y|X=x_i) = \sum\limits_{y_j\in D_Y} y_i p_{Y|X}(y_i|x_1) E(Y∣X=xi)=yj∈DY∑yipY∣X(yi∣x1) 是一个具体的值

-

E ( Y ∣ X ) E(Y|X) E(Y∣X) 是一个与X取值相关的随机变量

-

特性

-

σ ( X ) \sigma(X) σ(X)-measurable: 可以将Y理解为对X值的观测,Y不可能比X看得更仔细

-

∫ { X = x i } E ( Y ∣ X ) d P = ∫ { X = x i } Y d P \int_{\{X=x_i\}}E(Y|X)dP = \int_{\{X=x_i\}}YdP ∫{X=xi}E(Y∣X)dP=∫{X=xi}YdP.

-

-

全期望公式: E ( Y ) = E ( E ( Y ∣ X ) ) E(Y)=E(E(Y|X)) E(Y)=E(E(Y∣X))

- ( X − E ( X ∣ Y ) ) (X-E(X|Y)) (X−E(X∣Y)) 和任意 Y Y Y 的函数 g ( Y ) g(Y) g(Y) 正交

-

-

σ \sigma σ 域的条件期望

-

线性

- E ( a X + b Y ∣ G ) = a E ( X ∣ G ) + b E ( Y ∣ G ) E(aX + bY | \mathcal{G}) = aE(X | \mathcal{G}) + bE(Y | \mathcal{G}) E(aX+bY∣G)=aE(X∣G)+bE(Y∣G)

-

独立性

- 如果 X X X 与 G \mathcal{G} G 无关,则 E ( X ∣ G ) = E ( X ) E(X | \mathcal{G})=E(X) E(X∣G)=E(X)

-

过滤性

- 如果 H ∈ G \mathcal{H}\in\mathcal{G} H∈G ( G \mathcal{G} G 更精细),则 E ( E ( X ∣ G ) ∣ H ) = E ( X ∣ H ) E(E(X | \mathcal{G}) | \mathcal{H}) = E(X | \mathcal{H}) E(E(X∣G)∣H)=E(X∣H)

-

已知变量可提

- 只要 G \mathcal{G} G 给定, E ( X ∣ G ) = X E(X|\mathcal{G})=X E(X∣G)=X

- 只要 G \mathcal{G} G 给定, E ( X Y ∣ G ) = X E ( Y ∣ G ) E(XY|\mathcal{G})=XE(Y|\mathcal{G}) E(XY∣G)=XE(Y∣G)

-

2 随机过程 (5-7)

随机过程

-

定义

- 随机变量的时间序列

-

Filtration

-

已知信息随时间变化的过程

-

σ \sigma σ域的描述精度随时间逐渐变精细 F 1 ⊆ F 2 ⊆ … F \mathcal{F}_1\subseteq\mathcal{F}_2\subseteq\dots\mathcal{F} F1⊆F2⊆…F.

-

-

{ F n } \{F_n\} {Fn}-adapted process

- 任何 X n X_n Xn都 F n \mathcal{F}_n Fn可测

Martingale

-

定义: 满足以下条件的随机过程 { X n } \{X_n\} {Xn}称之为鞅

- { F n } \{F_n\} {Fn}-adapted

- 期望有界 E ( ∣ X n ∣ ) < ∞ E(|X_n|)<\infty E(∣Xn∣)<∞.

- 期望不变 E ( X n ∣ F n − 1 ) = X n − 1 E(X_n|\mathcal{F}_{n-1})=X_{n-1} E(Xn∣Fn−1)=Xn−1 .

-

Martingale Transform

- 使用随机过程 { C n } \{C_n\} {Cn}对Martingale { X n } \{X_n\} {Xn}进行加权

- 权值的随机过程是一个gambling strategy

- Previsible Random Process: 能用 F n − 1 \mathcal{F}_{n-1} Fn−1的信息决定 n n n时刻的押注 C n C_n Cn

- CANNOT BEAT THE SYSTEM: { ( C ⋅ X ) n } \{(C\cdot X)_n\} {(C⋅X)n}仍然是一个Martingale

-

性质

- E ( X n ) = E ( X 0 ) E(X_n) = E(X_0) E(Xn)=E(X0).

停时

-

定义: 在某种策略下停止时间的取值,是一个随机概率,事件 { τ = n } \{\tau=n\} {τ=n}能在 F n \mathcal{F}_n Fn下进行分辨

- ∀ n = 1 , 2 , ⋯ : { τ = n } ∈ F n \forall n = 1,2,\dots :\{\tau=n\} \in \mathcal{F}_n ∀n=1,2,⋯:{τ=n}∈Fn.

-

Stopped process: 被停时截断的随机过程 X n τ X^\tau_n Xnτ.

-

基础停时定理: 被停时 τ \tau τ 截断的Martingale X n τ X^\tau_n Xnτ 仍是Martingale

-

Doob选择停时定理 <停时随机变量期望的传递性>

-

Super-Martingale的传递性:如果随机过程 X n X_n Xn是一个super-martingale,则截断过程 X n τ X_n^\tau Xnτ也是super-Martingale, 满足 E ( X τ ) ≤ E ( X 1 ) E(X_\tau)\leq E(X_1) E(Xτ)≤E(X1)

-

Martingale的传递性: 如果随机过程 X n X_n Xn是一个Martingale,且以下满足以下条件之一,则截断过程也是Martingale

- τ \tau τ有界

- X X X 有界

- E ( τ ) E(\tau) E(τ)有界且 ∣ X n ( Ω ) − X n − 1 ( Ω ) ∣ |X_n(\Omega)-X_{n-1}(\Omega)| ∣Xn(Ω)−Xn−1(Ω)∣有界

-

-

鞅的应用

- 构造Martingale { S n } \{S_n\} {Sn}并运用 E ( S τ ) = E ( S 1 ) E(S_\tau)=E(S_1) E(Sτ)=E(S1).

马尔科夫链

-

MC

-

状态: S = { 0 , 1 , 2 , . . . } S=\{0,1,2,...\} S={0,1,2,...}

-

暂态: 不能再有限时间内无穷次回到状态 i i i

- k → ∞ , P ( T i k < ∞ ∣ X 0 = i ) → 0 k\rightarrow \infty, P(T^k_i<\infty|X_0=i)\rightarrow 0 k→∞,P(Tik<∞∣X0=i)→0.

-

常返态: 能在有限时间内 k k k次回到状态 i i i

- ∀ k ≥ 1 , P ( T i k < ∞ ∣ X 0 = i ) = 1 \forall k\geq 1, P(T^k_i<\infty|X_0=i)=1 ∀k≥1,P(Tik<∞∣X0=i)=1.

-

-

转移矩阵

-

单步转移

- Markov性: P ( X n + 1 = i ∣ X 0 , … , X n ) = P ( X n + 1 = i ∣ X n ) P(X_{n+1}=i|X_0,\dots,X_n)=P(X_{n+1}=i|X_n) P(Xn+1=i∣X0,…,Xn)=P(Xn+1=i∣Xn).

- time-homogeneous: P ( X n + 1 = j ∣ X n = i ) = P ( X m + 1 = j ∣ X m = i ) P(X_{n+1}=j|X_n=i)=P(X_{m+1}=j|X_m=i) P(Xn+1=j∣Xn=i)=P(Xm+1=j∣Xm=i).

- P = [ P i j ] i , j ∈ S \mathbb{P}=[P_{ij}]_{i,j\in S} P=[Pij]i,j∈S, P i j = P ( X n + 1 = j ∣ X n = i ) P_{ij} = P(X_{n+1}=j|X_n=i) Pij=P(Xn+1=j∣Xn=i).

-

多步转移

-

P i j ( n ) = P ( X n + m = j ∣ X m = i ) P^{(n)}_{ij} = P(X_{n+m}=j|X_m=i) Pij(n)=P(Xn+m=j∣Xm=i).

-

Chapman-Kolmogorov等式: m+n步转移概率与中间状态无关

- P i j m + n = ∑ k ∈ S P i k ( m ) P k j ( n ) P^{m+n}_{ij}=\sum\limits_{k\in S} P_{ik}^{(m)}P_{kj}^{(n)} Pijm+n=k∈S∑Pik(m)Pkj(n).

-

-

irreducible

- ∃ n , P i j ( n ) > 0 , ∀ i , j \exist n, P^{(n)}_{ij}>0, \forall i,j ∃n,Pij(n)>0,∀i,j

-

-

-

分布的演化

-

状态概率分布向量

- π ( n ) = ( π 0 ( n ) , π 1 ( n ) , … ) \pi^{(n)}=(\pi^{(n)}_0,\pi^{(n)}_1,\dots) π(n)=(π0(n),π1(n),…), 其中 π i ( n ) \pi_i^{(n)} πi(n)是 n n n时刻状态为 i i i的概率.

-

稳态分布

-

π = π P \pi=\pi\mathbb{P} π=πP 的解

- 状态输入与输出达到了平衡

- 方程的解并非一定唯一

- 如果MC为reducible, 则稳态将与初始状态有关

- 方程的解也并非一定存在

-

特殊形式:极限分布

- ∀ i , j ∈ S : π j = lim n → ∞ P i j ( n ) \forall i,j \in S: \pi_j = \lim\limits_{n\rightarrow\infty}P^{(n)}_{ij} ∀i,j∈S:πj=n→∞limPij(n). 从任意状态 i i i无限时间后落在转态 j j j的概率

- 与初始状态无关的状态分布:无限步转移矩阵的每一行都是一样的

- 存在则唯一

-

-

Limit Behavior

-

Assumptions

-

I: irreducible 状态间相互连通

-

A: aperiodic 每个状态的返回时间无周期性

-

R: 所有状态都是常返状态

-

S: 稳态分布存在

-

-

Convergence Theorem

-

I+A+S $\Rightarrow \quad n\rightarrow \infty, P^{(n)}_{ij}\rightarrow \pi_j $.

-

I+S $\Rightarrow \quad n\rightarrow \infty, \frac{1}{n} \sum\limits_{k=1}{n}P{(k)}_{ij}\rightarrow \pi_j $.

-

-

Asymptotic Frequency

- I+R ⇒ n → ∞ , N n ( i ) n → 1 E ( T i ∣ X 0 = i ) \Rightarrow \quad n\rightarrow \infty, \frac{N_n(i)}{n}\rightarrow \frac{1}{E(T_i|X_0=i)} ⇒n→∞,nNn(i)→E(Ti∣X0=i)1.

-

Expected Return Time

- I+S ⇒ n → ∞ , π i = 1 E ( T i ∣ X 0 = i ) \Rightarrow \quad n\rightarrow \infty, \pi_i = \frac{1}{E(T_i|X_0=i)} ⇒n→∞,πi=E(Ti∣X0=i)1.

-

-

3 参数估计 (8-10)

参数估计问题

-

组成

- 观测 X = ( X 1 , … , X n ) ∈ X X=(X_1,\dots,X_n) \in \mathcal{X} X=(X1,…,Xn)∈X.

- 参数向量 θ = ( θ 1 , … , θ p ) ∈ Θ \theta=(\theta_1,\dots,\theta_p)\in \Theta θ=(θ1,…,θp)∈Θ

- 概率测度模型 P θ : B ( R n ) → [ 0 , 1 ] P_\theta: \mathcal{B}(\mathbb{R}^n)\rightarrow [0,1] Pθ:B(Rn)→[0,1].

-

估计方法

-

贝叶斯估计

- 在已知先验知识的情况下,用观测数据修正先验知识,根据后验来优化代价

-

非随机估计

- 无先验知识的情况下,

-

充分统计量

-

定义

-

在已知充分统计量的情况下,概率分布函数能够用充分统计量完全表达,而与参数 θ \theta θ无关

-

P θ ( X 1 ≤ x 1 , … , X n ≤ x n ∣ T ( X ) = t ) = G ( x , t ) P_{\theta}(X_1\leq x_1,\dots,X_n\leq x_n|T(X)=t)=G(x,t) Pθ(X1≤x1,…,Xn≤xn∣T(X)=t)=G(x,t).

-

-

Neyman-Fisher分解

- 如果 T = T ( X ) T=T(X) T=T(X) 是充分统计量,则概率密度函数 f X ( x ∣ θ ) f_X(x|\theta) fX(x∣θ)能够分解为只与观测有关的 h ( x ) h(x) h(x)和只与参数和统计量有关的 g ( T ( x ) , θ ) g(T(x),\theta) g(T(x),θ).

贝叶斯估计

-

先验信息

- f ( θ ) f(\theta) f(θ): 虽然不知道 θ \theta θ的值,但知道 θ \theta θ取值的分布

-

后验信息

-

得到观测信息后,根据贝叶斯规则对 θ \theta θ的分布进行进一步修正

-

f ( θ ∣ x ) = f ( x , θ ) f ( x ) = f ( x ∣ θ ) f ( x ) f ( x ) f(\theta|x)=\frac{f(x,\theta)}{f(x)}=\frac{f(x|\theta)f(x)}{f(x)} f(θ∣x)=f(x)f(x,θ)=f(x)f(x∣θ)f(x)

-

-

估计代价 cost ( θ ^ ( x ) , θ ) \text{cost}(\hat{\theta}(x),\theta) cost(θ^(x),θ)

-

最优贝叶斯估计器

- θ ^ = arg min θ ^ ∈ Θ E ( cost ( θ ^ , θ ) ) \hat{\theta} = \argmin\limits_{\hat{\theta}\in\Theta} E(\text{cost}(\hat{\theta},\theta)) θ^=θ^∈ΘargminE(cost(θ^,θ)) 代价期望最小

- 估计器的形式取决于 cost \text{cost} cost的选择

-

-

条件期望估计器 (CME)

-

优化目标

- 平方误差 cost ( θ ^ , θ ) = ∣ θ ^ − θ ∣ 2 \text{cost}(\hat{\theta},\theta)=|\hat{\theta}-\theta|^2 cost(θ^,θ)=∣θ^−θ∣2.

- 均方误差 M S E ( θ ^ ) = E ( ∣ θ ^ − θ ∣ 2 ) MSE(\hat{\theta})=E(|\hat{\theta}-\theta|^2) MSE(θ^)=E(∣θ^−θ∣2)

-

估计器: 平均值

- θ ^ C M E = E ( θ ∣ X ) \hat{\theta}_{CME} = E(\theta|X) θ^CME=E(θ∣X)

-

-

条件中值估计器 (CmE)

-

优化目标

- 绝对误差 cost ( θ ^ , θ ) = ∣ θ ^ − θ ∣ \text{cost}(\hat{\theta},\theta)=|\hat{\theta}-\theta| cost(θ^,θ)=∣θ^−θ∣.

- 平均绝对误差 M A E ( θ ^ ) = E ( ∣ θ ^ − θ ∣ ) MAE(\hat{\theta})=E(|\hat{\theta}-\theta|) MAE(θ^)=E(∣θ^−θ∣).

-

估计器: 中位数

- θ ^ C m E = median θ ∈ Θ f ( θ ∣ X ) \hat{\theta}_{CmE}=\text{median}_{\theta\in\Theta} f(\theta|X) θ^CmE=medianθ∈Θf(θ∣X)

-

-

最大后验估计器 (MAP)

-

优化目标

- 归一化误差 cost ( θ ^ , θ ) = I ( ∣ θ ^ − θ ∣ > ϵ ) \text{cost}(\hat{\theta},\theta)=I(|\hat{\theta}-\theta|>\epsilon) cost(θ^,θ)=I(∣θ^−θ∣>ϵ).

- ϵ \epsilon ϵ-误差概率 P e ( θ ^ ) = P ( ∣ θ ^ − θ ∣ > ϵ ) P_e(\hat{\theta})=P(|\hat{\theta}-\theta|>\epsilon) Pe(θ^)=P(∣θ^−θ∣>ϵ)

-

估计器: 众数

- θ ^ M A P = arg max θ ∈ Θ { f ( θ ∣ X ) } \hat{\theta}_{MAP}=\argmax \limits_{\theta\in\Theta}\{ f(\theta|X)\} θ^MAP=θ∈Θargmax{f(θ∣X)}

-

非随机估计

-

MOM 矩估计

-

用统计量来估计真值

- g k ( θ ) = m k ( θ ) = E θ [ X i k ] g_k(\theta) = m_k(\theta)=E_\theta\left[X^k_i\right] gk(θ)=mk(θ)=Eθ[Xik]

- m ^ k = 1 n ∑ i = 1 n X i k \hat m_k=\frac{1}{n}\sum\limits_{i=1}^n X_i^k m^k=n1i=1∑nXik

-

-

ML 最大似然估计

-

使观测到的可能性最大->最大化似然函数 L ( θ ) = ln f ( x ; θ ) L(\theta)=\ln f(x;\theta) L(θ)=lnf(x;θ)

-

θ ^ M L = arg max θ f ( X ; θ ) = arg max θ L ( θ ) \hat\theta_{ML}=\argmax\limits_{\theta} f(X;\theta)=\argmax\limits_\theta L(\theta) θ^ML=θargmaxf(X;θ)=θargmaxL(θ)

-

-

估计的评价指标

-

偏差

- b θ ( θ ^ ) = E θ [ θ ^ ] − θ \text{b}_\theta(\hat{\theta})=E_\theta[\hat{\theta}]-\theta bθ(θ^)=Eθ[θ^]−θ

-

方差

- var θ ( θ ^ ) = E θ [ ( θ ^ − E θ ( θ ^ ) ) 2 ] = E θ ( θ ^ 2 ) − E θ 2 ( θ ^ ) \text{var}_\theta(\hat{\theta})=E_\theta[(\hat{\theta}-E_\theta(\hat{\theta}))^2]=E_\theta(\hat\theta^2)-E_\theta^2(\hat\theta) varθ(θ^)=Eθ[(θ^−Eθ(θ^))2]=Eθ(θ^2)−Eθ2(θ^)

-

UMVU (Uniform Minimum Variance Unbiased estimator)

-

偏差为0,方差最小

-

有效估计器: 当且仅当估计模型为如下的指数函数时CRB才能达到

-

∂ ∂ θ ln f ( X ; θ ) = k θ ( θ ^ − θ ) \frac{\partial}{\partial\theta}\ln f(X;\theta)=k_\theta(\hat\theta-\theta) ∂θ∂lnf(X;θ)=kθ(θ^−θ)

-

exponential family: PDF的指数和次数都能拆成只与观测有关和只与参数有关的两部分

- f ( x ; θ ) = a ( θ ) b ( x ) e c ( θ ) T ( x ) f(x;\theta)=a(\theta)b(x)e^{c(\theta)T(x)} f(x;θ)=a(θ)b(x)ec(θ)T(x)

-

-

-

Fisher Information

-

F ( θ ) = E θ [ ( ∂ ∂ θ ln f ( X ; θ ) ) 2 ] = E θ [ − ∂ 2 ∂ θ 2 ln f ( X ; θ ) ] F(\theta) = E_\theta \left[ \left(\frac{\partial}{\partial\theta}\ln f(X;\theta)\right)^2\right] =E_\theta \left[ -\frac{\partial^2}{\partial\theta^2}\ln f(X;\theta)\right] F(θ)=Eθ[(∂θ∂lnf(X;θ))2]=Eθ[−∂θ2∂2lnf(X;θ)]

-

Cramer-Rao Lower Bound

- 无偏估计器方差的下界为 1 F ( θ ) \frac{1}{F(\theta)} F(θ)1

-

-