本文章主要参考第32届国际人工智能联合会议(IJCAI)上由清华大学人工智能研究院知识工程研究中心(KEG)、北京智谱华章科技有限公司、开放群岛开源社区联合编写的《2023联邦学习全球研究与应用趋势报告》,对重点内容进行总结提炼,并介绍部分学习资料,旨在帮助对联邦学习感兴趣的学习者更快了解其研究现状及未来可能的发展趋势。

参考链接:《2023联邦学习全球研究与应用趋势报告》

目录

1. 引言

2. 联邦学习技术研究与应用现状

2.1 科研论文成果现状

2.2 高被引论文分析

2.2.1 高被引论文介绍

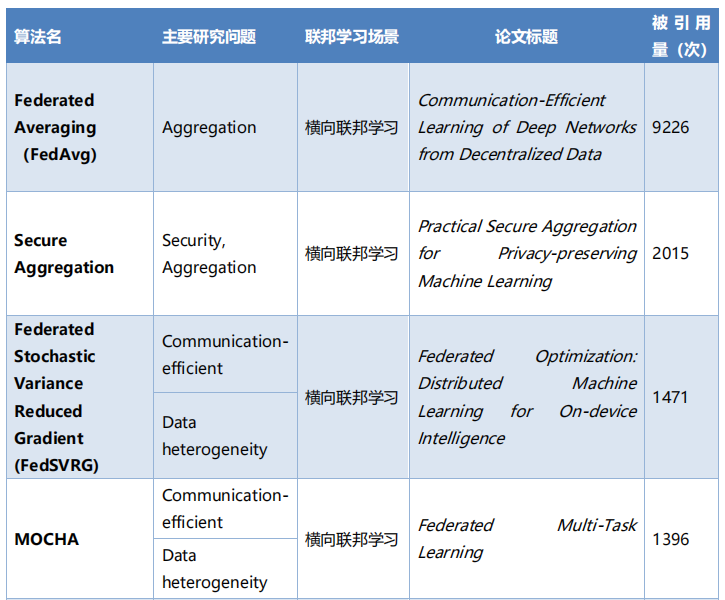

2.2.2 联邦学习十大算法

2.2.3 高被引论文TOP10解读

2.3 联邦学习的特刊、书籍和综述

2.3.1 特刊

2.3.2 书籍

2.3.3 综述

2.4 联邦学习代表性学者

2.4.1 联邦学习算法与理论

2.4.2 联邦学习应用方面(边缘计算与区块链等)

3. 联邦学习发展趋势

3.1 总体趋势

3.2 联邦学习与大模型技术的融合趋势

1. 引言

人工智能未来能否可持续发展面临三大困境:数据困境、法律挑战以及算力困境。针对以上困境,“狭义”联邦机器学习的概念于 2016 年由谷歌研究人员首先提出,随后成为解决数据孤岛问题、满足隐私保护和数据安全的一个可行性解决方案 。联邦学习的特征是数据不出本地、各个参与者的身份和地位平等,它能够实现多个参与方在保护数据隐私、满足合法合规要求的前提下进行机器学习,协同地进行模型训练与结果预测,并且建模效果和将整个数据集放在一处建模的效果相同或相差不大(在各个数据的用户对齐(user alignment)或特征对齐(feature alignment)的条件下),从而实现企业间的数据融合建模,解决数据孤岛问题。“广义”联邦学习的概念由香港科技大学杨强教授所领导的微众银行 AI 团队在 2018 年提出,该团队将联邦学习扩展为机构和个人间的 B2C 模式和不同机构间 B2B 分布式联合建模架构,包括按样本、按特征分割以及异构多方建模,同时可以建立去中心协调器的 Peer-to-Peer 架构形式,其设计目标是在保障大数据交换时的信息安全、保护终端数据和个人数据隐私、保证合法合规的前提下,在多参与方或多计算结点之间开展高效率、安全、可靠的机器学习和模型使用。联邦学习同时包括鼓励多方持续参与合作生态的激励机制,建立正向激励的数据价值交易市场机制。

如上所述,根据孤岛数据的分布特点(用户与用户特征的重叠情况),联邦学习可以分为横向联邦学习、纵向联邦学习与联邦迁移学习。

2. 联邦学习技术研究与应用现状

2.1 科研论文成果现状

图1 联邦学习研究论文趋势(2016-2022年)

基于AMiner系统的论文热词分析,近年来联邦学习的研究热点涵盖应用、系统和模型设计、安全隐私三个领域。在应用研究领域,包括物联网、边缘计算、医疗保健、车辆交互、无线通信、5G、数据库以及推荐。在系统和模型设计方面,主要关注聚合、优化、异构、鲁棒性、通信效率、公平性、激励机制和资源效率。在安全隐私方面,研究主题涉及区块链、差分隐私、安全多方计算、隐私泄露、同态加密、恶意攻击、网络安全以及容错。

2.2 高被引论文分析

2.2.1 高被引论文介绍

美国联邦学习被引用量最高的论文是谷歌公司研究科学家 H.Brendan Mcmahan 作为一作发表的论文 Communication-efficient learning of deep networks from decentralized data,该论文于 2016 年发表于 ArXiv e-prints (2016): arXiv-1602,并在 2017 年收录于 AISTATS (International Conference on Artificial Intelligence and Statistics)。中国联邦学习总体论文引用量居于第二,其中被引用最高的论文是香港科技大学计算机科学与工程学系教授杨强为第一作者与微众银行 AI 部门、北京航空航天大学计算机学院的研究人员联合发表的 Federated Machine Learning: Concept and Applications。这两篇都是联邦学习领域经典且基础的论文,感兴趣的可以了解学习。

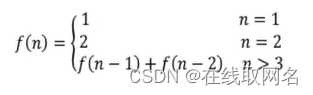

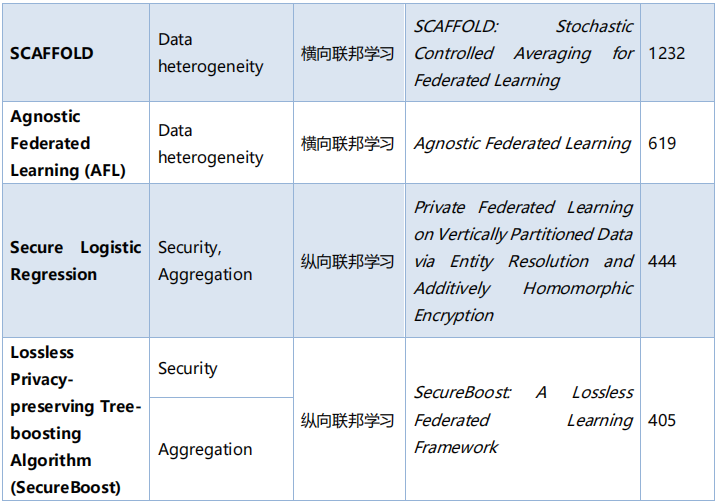

2.2.2 联邦学习十大算法

2.2.3 高被引论文TOP10解读

- 论文标题:Communication-Efficient Learning of Deep Networks from Decentralized Data

作者:H. Brendan McMahan, Eide Moore r, Daniel Ramage, Seth Hampson;Blaise Agüera y Arcas

发表期刊:International Conference on Artificial Intelligence and Statistics (AISTATS), 2017

论文地址:https://www.aminer.cn/pub/599c7cc1601a182cd27d4688/

摘要:现代移动设备可以访问大量适合学习模型的数据,这反过来又可以大大改善设备上的用户体验。例如,语言模型可以改进语音识别和文本输入,图像模型可以自动选择好的照片。然而,这些丰富的数据通常是隐私敏感的、数量庞大的,或者两者兼而有之,这可能会妨碍使用传统方法登录到数据中心并在那里进行训练。由此,学者们提出一种替代方案,将训练数据分布在移动设备上,并通过聚合本地计算的更新来学习共享模型,并将这种分布式方法称为联邦学习。本文提出了一种基于迭代模型平均的深度网络联邦学习的实用方法,并进行了广泛的实证评估,考虑五种不同的模型架构和四个数据集。实验表明,该方法对不平衡和非 IID 数据分布具有鲁棒性,这是该设置的一个定义特征。通信成本是主要限制因素,与同步随机梯度下降相比,该方法显示所需的通信轮次减少 10-100 倍。

- 论文标题:Federated Machine Learning: Concept and Applications

作者:Qiang Yang, Yang Liu, Tianjian Chen, Yongxin Tong

发表期刊:ACM Transactions on Intelligent Systems and Technology,Article No.:12pp 1–19,2019

论文地址:https://www.aminer.cn/pub/5c9f688c6558b90bfa34dcb4

摘要: 今天的人工智能仍然面临两大挑战。一是在大多数行业中,数据以孤岛的形式存在;另一个是加强数据隐私和安全。本文为这些挑战提出了一个可能的解决方案:安全联邦学习。除了谷歌在 2016 年首次提出的联邦学习框架之外,本文还引入了一个全面的安全联邦学习框架,其中包括横向联邦学习、纵向联邦学习和联邦迁移学习。本文提供了联邦学习框架的定义、体系结构和应用程序,并提供了关于这个主题的现有工作全面调查。此外,还提出了在组织间建立基于联邦机制的数据网络,作为在不损害用户隐私的前提下实现知识共享的有效解决方案。

- 论文标题 : Federated Learning: Strategies for Improving Communication Efficiency

作者: Jakub Konecný, H. Brendan McMahan, Felix X. Yu, Peter Richtárik, Ananda Theertha Suresh, Dave Bacon

发表期刊:arXiv: Machine Learning (cs.LG),2018

论文地址:https://www.aminer.cn/pub/58437725ac44360f1082f72b/

摘要: 联邦学习是一种机器学习设置,其目标是训练高质量的集中式模型,同时训练数据仍然分布在具有不可靠且相对较慢的网络连接的大量客户端上。本文考虑针对此设定的学习算法,在每一轮中,每个客户端根据其本地数据独立计算当前模型的更新,并将此更新传达给中央服务器,在那里客户端更新被聚合以计算新的全局模型。此设定中的典型客户端是手机,通信效率是最重要的。本文提出了两种降低上行链路通信成本的方法:一个是结构化更新,直接从使用较少数量变量参数化的受限空间中学习更新,例如低秩或随机掩码;另一个是草图更新,学习完整的模型更新,然后在将其发送到服务器之前使用量化、随机旋转和子采样的组合对其进行压缩。在卷积网络和循环网络上的实验表明,本文所提出的方法可以将通信成本降低两个数量级。

- 论文标题:Advances and Open Problems in Federated Learning

作者:Peter Kairouz, H. Brendan McMahan, Brendan Avent, Aurelien Bellet, Mehdi Bennis, Arjun Nitin Bhagoji, Keith Bonawitz, Zachary Charles, et al. 58 authors

发表期刊: Foundations and Trends® in Machine Learning, no. 1 ,2021

论文地址: https://www.aminer.cn/pub/5df20fc53a55acbe6bfcc74f/

摘要:联邦学习是一种机器学习设定,许多客户端(例如移动设备或整个组织)在中央服务器 (例如服务提供商)的编排下协同训练一个模型,同时保持训练数据的分散。联邦学习体现 了集中数据收集和最小化的原则,可以减轻许多由传统的、集中的机器学习和数据科学方法造成的系统性隐私风险和成本。本文讨论了最近的联邦学习研究进展,并提出了广泛的开放式问题和挑战。

- 论文标题:Federated Learning: Challenges, Methods, and Future Directions

作者:Tian Li, Anit Kumar Sahu, Ameet Talwalkar, Virginia Smith

发表期刊:IEEE Signal Processing Magazine, no. 3 ,pp: 50-60,2020

论文地址:https://www.aminer.cn/pub/5d5e6b9a3a55acfce79a16af/

摘要:联邦学习涉及在远程设备或孤岛数据中心(如移动电话或医院)上训练统计模型,同时保持数据本地化。在异构和潜在的大规模网络中进行训练会带来新的挑战,需要从根本上背离大规模机器学习、分布式优化和隐私保护数据分析的标准方法。本文讨论了联邦学习的独特特征和挑战,提出了横向联邦学习、纵向联邦学习、联邦迁移学习的范式。提供了当前方法的广泛概述,并概述了与广泛的研究社区相关的几个未来工作方向。

- 论文标题: Towards Federated Learning at Scale: System Design

作者:Keith Bonawitz, Hubert Eichner, Wolfgang Grieskamp, Dzmitry Huba, Alex Ingerman, Vladimir Ivanov, Chloé Kiddon, Jakub Konecný, Stefano Mazzocchi, H. Brendan McMahan, Timon Van Overveldt, David Petrou, Daniel Ramage, Jason Roselander

发表期刊: Proceedings of Machine Learning and Systems Volume: 1, pp: 374-388,2019

论文地址:https://www.aminer.cn/pub/5cede10bda562983788eae06/

摘要: 联邦学习是一种分布式机器学习方法,可以在大量分散数据的语料库上进行模型训练。本文基于 TensorFlow 为移动设备领域的联邦学习构建了一个可扩展的生产系统,描述了由此产生的高级设计,勾勒出一些挑战及其解决方案,并涉及未解决的问题和未来的方向。

- 论文标题:Practical Secure Aggregation for Privacy-Preserving Machine Learning

作者: Keith Bonawitz, Vladimir Ivanov, Ben Kreuter, Antonio Marcedone, H. Brendan McMahan, Sarvar Patel, Daniel Ramage, Aaron Segal, Karn Seth

发表期刊: Computer and Communications Security pp: 1175-1191,2017

论文地址: https://www.aminer.cn/pub/5a260c2817c44a4ba8a23355/

摘要: 本论文设计了一种新颖、通信高效、故障稳健的协议,用于高维数据的安全聚合。该协议允许服务器以安全的方式(即无需了解每个用户的个人贡献)计算来自移动设备的大型用户持有数据向量的总和,并且可以用于(例如,在联邦学习设定中)聚合用户提供的深度神经网络模型更新。本文在诚实但好奇且活跃的对手设置中证明了该协议的安全性,并表明使任意选择的用户子集随时退出,也能保持安全性。本文评估了该协议的效率,并通过复杂性分析和具体实现表明,即使在大型数据集和客户端池上,其运行时和通信开销仍然很低。对于 16 位输入值,本文的协议以明文形式发送数据,为 210 个用户和 220 维向量提供 1.73 倍的通信扩展,并为 214 个用户和 224 维向量提供 1.98 倍扩展。

- 论文标题: Federated Learning with Non-IID Data

作者: Yue Zhao, Meng Li, Liangzhen Lai, Naveen Suda, Damon Civin, Vikas Chandra

发表期刊: arXiv:1806.00582 [cs.LG], 2018

摘要:该项工作重点关注当本地数据非独立同分布(Non-IID)时联邦学习的统计挑战。首先展示,对于为高度偏斜的 Non-IID 数据训练的神经网络,联合学习的准确性显著降低,高达 55%,其中每个客户端设备仅在一类数据上训练。进一步表明,这种精度下降可以用权重偏差来解释,权重偏差可以用每个设备上类别分布和种群分布之间的地球移动器距离(EMD)来量化。作为一种解决方案,该文提出了一种策略,通过创建在所有边缘设备之间全局共享的一小部分数据来改进 Non-IID 数据的训练。实验表明,对于只有 5%的全球共享数据的 CIFAR-10 数据集,准确率可以提高 30%。

- 论文标题:Federated Optimization: Distributed Machine Learning for On-Device Intelligence

作者:Jakub Konecný, H. Brendan McMahan, Daniel Ramage, Peter Richtárik

发表期刊: arXiv preprint arXiv:1610.02527 (2016).

论文地址:https://www.aminer.cn/pub/58437725ac44360f1082ff8b/

摘要: 本文为机器学习中的分布式优化引入一个新的、相关性越来越强的设置,其定义优化的数据不均匀地分布在大量节点上。其目标是培养一个高质量的称为联邦优化的集中模型。在这种情况下,通信效率是最重要的,而最小化通信轮数是主要目标。当将培训数据保存在 usersu0027 移动设备本地,而不是将其记录到数据中心进行培训时,就出现了一个激励的示例。在联合优化中,这些设备被用作计算节点,对本地数据执行计算,以更新全局模型。假设在网络中有非常多的设备——与给定服务的用户数量一样多,每个用户只拥有一小部分可用数据的。特别是,本文预计本地可用的数据点数量要比设备数量少得多。此外,由于不同的用户使用不同的模式生成数据,可以合理地假设没有任何设备具有总体分布的代表性样本。本文证明了现有的算法不适合这种设定,并提出了一种新的算法,它显示了稀疏凸问题,出现了令人鼓舞的实验结果。这项工作还为联邦优化方面的未来研究奠定了基础。

- 论文标题:Federated Multi-Task Learning

作者: Virginia Smith, Chao-Kai Chiang, Maziar Sanjabi, Ameet Talwalkar

发表期刊: Advances in Neural Information Processing Systems 30 (NIPS), 2017

论文地址:https://www.aminer.cn/pub/599c797f601a182cd264476f/

摘要: 联邦学习在通过分布式设备网络训练机器学习模型方面带来了新的统计和系统挑战。在这项实验中,本文展示了自然适合处理这种设置统计挑战的多任务学习,并提出了一种新颖的系统感知优化方法 MOCHA,它对实际系统问题具有鲁棒性。本文的方法和理论首次考虑了分布式多任务学习的高通信成本、滞后性和容错性问题。与联合设置中的替代方法相比,所得到的方法实现了显著加速,正如作者通过模拟真实世界联合数据集所证明的那样。

2.3 联邦学习的特刊、书籍和综述

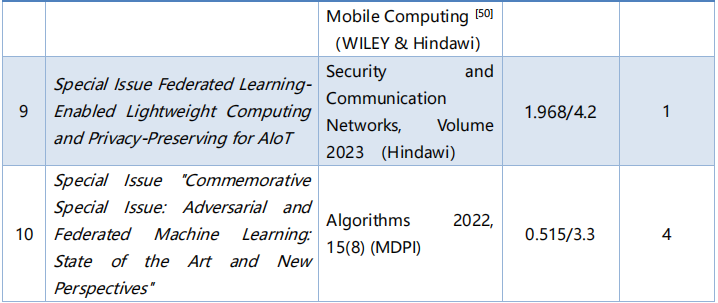

2.3.1 特刊

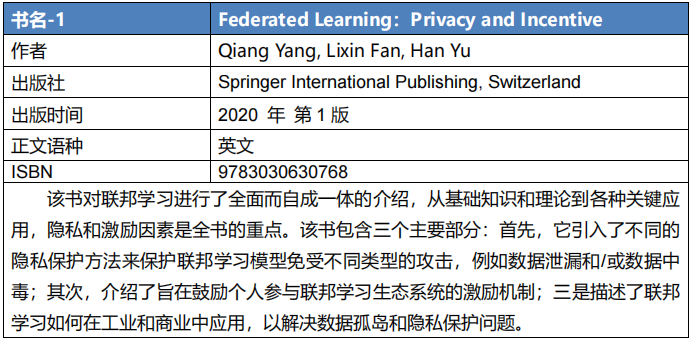

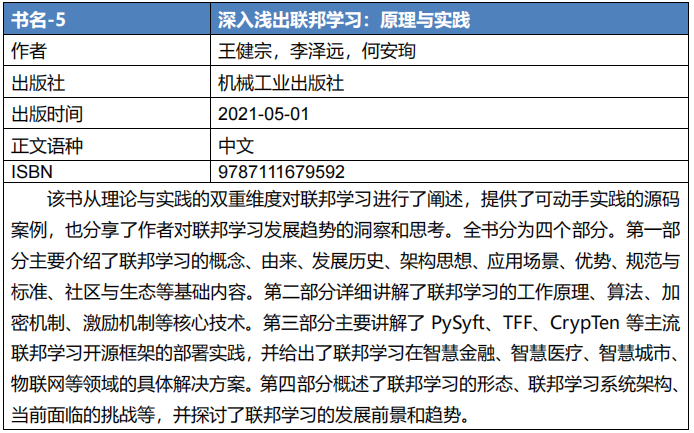

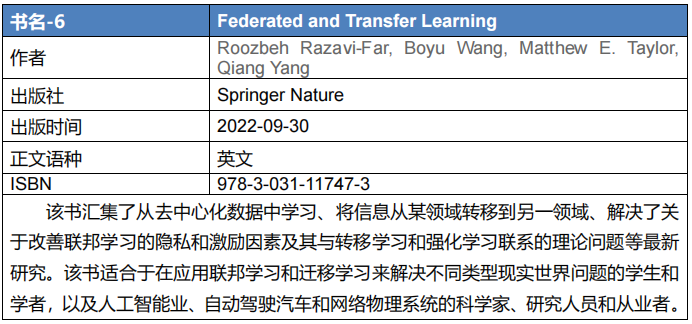

2.3.2 书籍

![]()

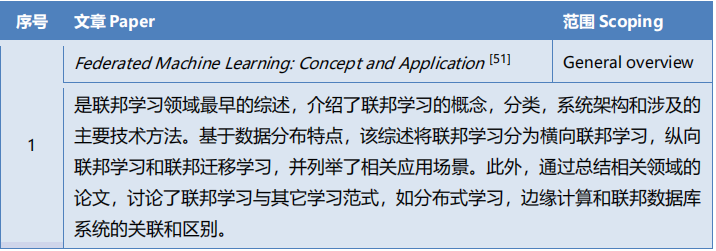

2.3.3 综述

![]()

2.4 联邦学习代表性学者

AMiner学术搜索服务平台联邦学习方向:https://www.aminer.cn/topic/600e890992c7f9be21d74695

网址https://www.aminer.cn/获取联邦学习领域学者资料。

2.4.1 联邦学习算法与理论

- Qiang Yang (杨强)

香港科技大学 教授; 微众银行 首席人工智能官

研究兴趣:人工智能、迁移学习、联邦学习、机器学习、数据挖掘

- Dawn song (宋晓东)

加州大学伯克利分校电气工程与计算机科学系 教授

研究兴趣:深度学习、区块链和去中心化系统、计算机安全、隐私和应用密码学,使用程序分析、算法设计和机器学习来确保安全和隐私。

- Bingsheng He

新加坡国立大学 副教授

研究兴趣:并行和分布式系统、云计算、高性能计算、数据库系统、大数据系统、GPGPU

- Salman Avestimehr

南加州大学 教授; FedML 首席执行官兼联合创始人

研究兴趣:信息论、机器学习、分布式计算、安全/隐私学习/计算、联邦学习

- Peter Richtarik

阿卜杜拉国王科技大学 教授

研究兴趣:优化、机器学习、联邦学习、深度学习

- Wojciech Samek

德国柏林理工学院电子工程与计算机系 教授

研究兴趣:机器学习、可解释性深度学习、联邦学习

- H. Brendan Mcmahan

谷歌公司 研究科学家

研究兴趣:机器学习、联邦学习、分布式优化、差异隐私、深度学习

- Ameet Talwalkar

美国卡耐基梅隆大学 助理教授

研究兴趣:机器学习,重点关注与自动化、公平性、可解释和联邦学习相关主题

- Yongxin Tong (童咏昕)

北京航空航天大学计算机科学与工程学院 教授

研究兴趣:联邦学习、数据联邦、时空大数据分析、众包数据库、隐私保护数据分析

- Bo Li(李博)

美国伊利诺伊大学厄巴纳-香槟分校 助理教授

研究兴趣:对抗性机器学习、安全、 隐私、大数据

- Reza Shokri

新加坡国立大学 教授

研究兴趣:计算机安全和隐私、机器学习

2.4.2 联邦学习应用方面(边缘计算与区块链等)

- Dusit Tao Niyato

新加坡南洋理工大学计算机科学与工程学院、物理与数学学院 教授

研究兴趣:可持续性、边缘智能、去中心化机器学习、激励机制设计

- Song Guo

香港理工大学计算机系 教授

研究兴趣:边缘智能、联邦学习、AI赋能的物联网、边缘计算与区块链、分布式系统

- Jun Zhang

香港科技大学 副教授

研究兴趣:移动边缘计算、边缘人工智能、无线通信、联邦学习

- Zehui Xiong

新加坡科技设计大学 助理教授

研究兴趣:网络系统的优化和智能、区块链与数据管理的安全和隐私保护、边缘人工智能系统的联邦机器学习、智能物联网的群体智能和边缘学习、无线通信的资源管理、元宇宙

3. 联邦学习发展趋势

3.1 总体趋势

根据AMiner数据库查找联帮学习相关论文,生成大数据智能的发展趋势河流图,得出目前联帮学习较热门主题包括Training(训练)、Privacy(隐私)、Servers (服务器端)、Internet of Things(物联网)、Blockchain(区块链)、Deep Learning(深度学习)、Security(安全)、Differential Privacy(差分隐私)、Edge Computing(边缘计算)、Homomorphic Encryption(同态加密)。