3.4.3 3层神经网络Python实现

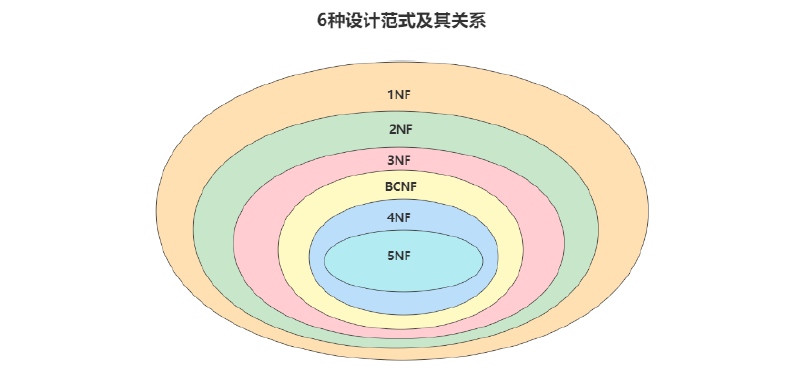

实现的是这个网络

**init_network()**函数会进行权重和偏置的初始化,并将它们保存在字典变量network中。这个字典变量network中保存了每一层所需的参数(权重和偏置)。

**forward()**函数中则封装了将输入信号转换为输出信号的处理过程。

另外,这里出现了forward (前向)一词,它表示的是从输入到输出方向的传递处理。后面在进行神经网络的训练时,我们将介绍后向(backward,从输出到输入方向)的处理。

#阶跃函数

import numpy as np

import matplotlib.pylab as plt

def step_function(x):#阶跃函数

y=x>0

y=y.astype(np.int64)#True转换成1,False转换成0

return y

def sigmoid(x):#sigmoid激活函数

return 1/(1+np.exp(-x))

def ReLU(x):

return np.maximum(0,x)

def identity_function(x):#恒等函数,原样输出

return x

'''

x=np.arange(-5.0,5.0,0.1)

y=step_function(x)

y2=sigmoid(x)

plt.plot(x,y2)

plt.ylim(-0.1,1.1)

plt.show()

'''

def init_network(): #权重偏置初始化,并建立字典

network={}

network['W1']=np.array([[0.1,0.3,0.5],[0.2,0.4,0.6]])

network['b1']=np.array([0.1,0.2,0.3])

network['W2'] = np.array([[0.1, 0.4], [0.2, 0.5], [0.3, 0.6]])

network['b2'] = np.array([0.1, 0.2])

network['W3'] = np.array([[0.1, 0.3], [0.2, 0.4]])

network['b3'] = np.array([0.1, 0.2])

return network

def forward(network,x):#向前传播

W1,W2,W3=network['W1'],network['W2'],network['W3']

b1,b2,b3=network['b1'],network['b2'],network['b3']

a1=np.dot(x,W1)+b1 #矩阵点乘

z1=sigmoid(a1)

a2=np.dot(z1,W2)+b2

z2=sigmoid(a2)

a3=np.dot(z2,W3)+b3

y=identity_function(a3)

return y

network=init_network()

x=np.array([1.0,0.5])# X=【1*2】矩阵 W1=【2*3】矩阵=>Z1=【1*3】 W2=【3*2】=>Z2=【1*2】

y=forward(network,x)

print(y)