问题描述

最近遇到这样一个问题:logstash想要动态更新数据库内容,常用的方法是在conf文件里设置。这里我选择用timestamp记录

# 数据追踪

# 追踪的字段

tracking_column => "update_time"

tracking_column_type => "timestamp" # "numeric" or "timestamp"

use_column_value => true

# 上次追踪的元数据存放位置

last_run_metadata_path => "/usr/share/logstash/config/lastrun/logstash_jdbc_last_run"

# sql

statement => "SELECT * FROM News_2 where update_time > :sql_last_value"

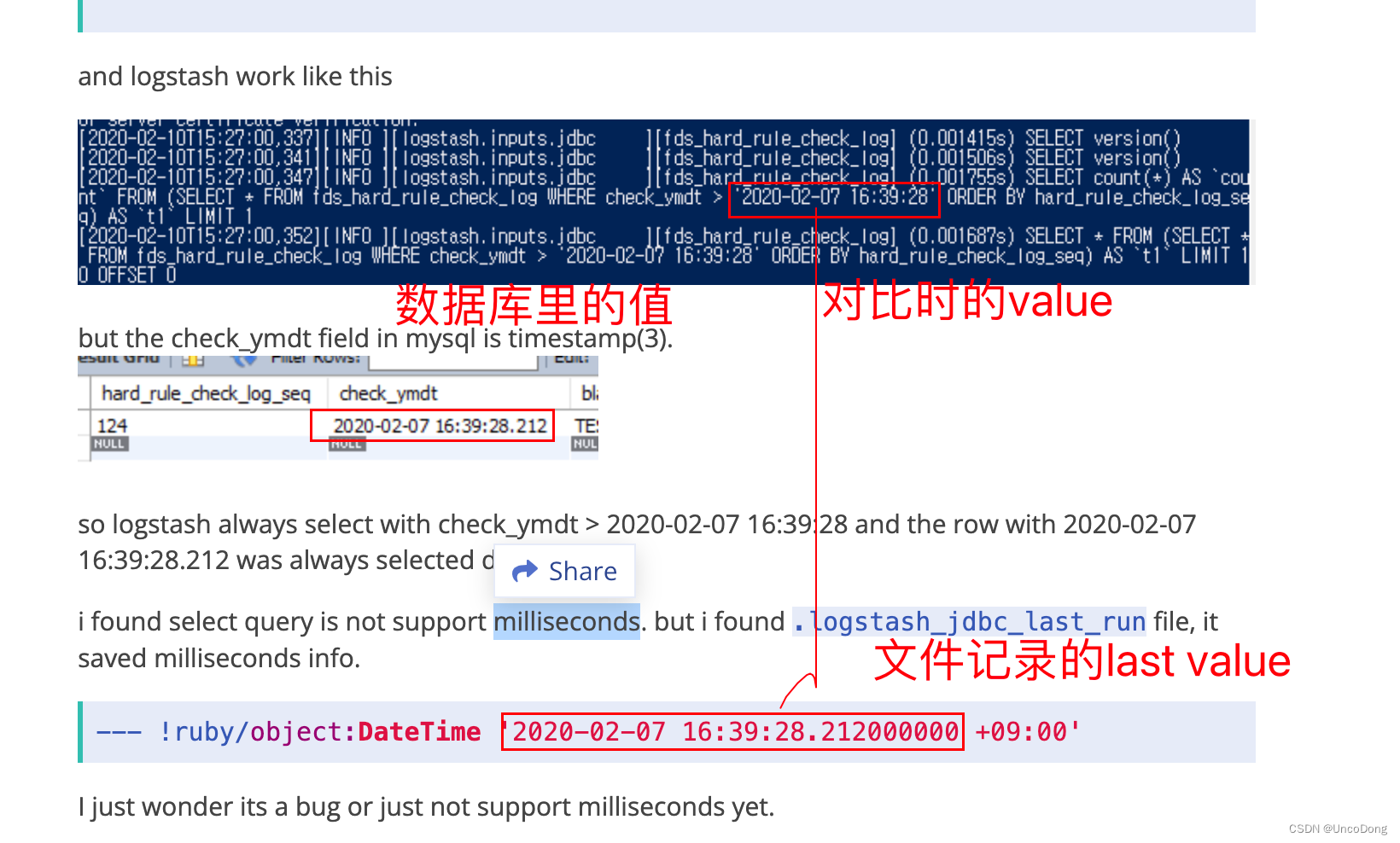

但遇到的一个奇怪问题是:明明last_run_metadata_path记录的时间格式是精确到毫秒的,但是读取后对比的时候,毫秒级别直接被砍,只能对比秒级。

借用这位老哥的logstash论坛提问,他的遭遇和我一模一样:sql_last_value with timestamp type support milliseconds?

这样就会导致,某些数据只在毫秒级别有差异,而对比的时候如果只能精确到秒级,则这些数据会被重复选取,甚至当每次更新数据量小的时候,last_run_metadata_path都不会被更新。

原因

- https://github.com/logstash-plugins/logstash-input-jdbc/issues/140

- https://github.com/logstash-plugins/logstash-input-jdbc/pull/260

借助csdn的chatgpt的回答(他竟然真的给出了比较靠谱的回答,我哭死)

logstash的tracking_column_type参数被设置为timestamp时,它只能精确到秒,无法精确到毫秒。这是因为默认情况下,logstash使用的是DateTime类型来存储时间戳,而DateTime类型的精度只能到秒。如果你需要精确到毫秒的时间戳,你可以考虑使用一个更高精度的数据类型,例如BigInt或Double。然后,在你的logstash配置文件中将tracking_column_type参数设置为相应的数据类型。这样,logstash就能够正确地读取和比较精确到毫秒的时间戳了。

解决方案

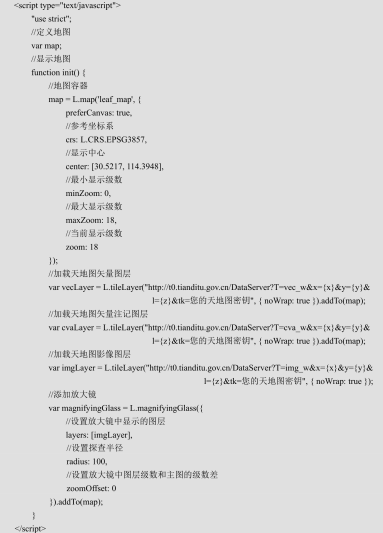

不用timestamp类型,直接用numeric类型,并且记录数字格式的时间戳,例如

# 数据追踪

# 追踪的字段

tracking_column => "update_time_int"

tracking_column_type => "numeric" # "numeric" or "timestamp"

use_column_value => true

# 上次追踪的元数据存放位置

last_run_metadata_path => "/usr/share/logstash/config/lastrun/logstash_jdbc_last_run"

# sql

statement => "

select *, cast(updated_time_int as SIGNED) as updated_time_int

from (

SELECT *,

REPLACE(unix_timestamp(updated_time),'.','') as updated_time_int

FROM News_2 ) as temp

where updated_time_int > :sql_last_value"

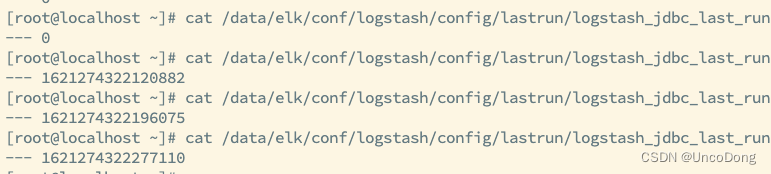

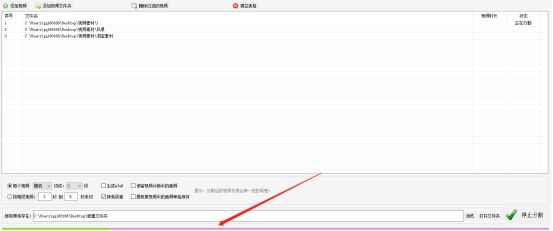

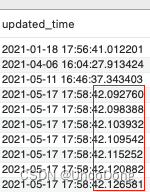

可以看到正确的往前推进了