文章目录

- 一,案例分析

- (一)数据去重介绍

- (二)案例需求

- 二,案例实施

- (一)准备数据文件

- (1)启动hadoop服务

- (2)在虚拟机上创建文本文件

- (3)上传文件到HDFS指定目录

- (二)Map阶段实现

- (1)创建Maven项目:Deduplicate

- (2)添加相关依赖

- (3)创建日志属性文件

- (4)创建去重映射器类:DeduplicateMapper

- (三)Reduce阶段实现

- (1)创建去重归并器类:DeduplicateReducer

- (四)Driver程序主类实现

- (1)创建去重驱动器类:DeduplicateDriver

- (五)运行去重驱动器类,查看结果

- (1)运行DeduplicateDriver类

- (2)下载并查看文件

一,案例分析

(一)数据去重介绍

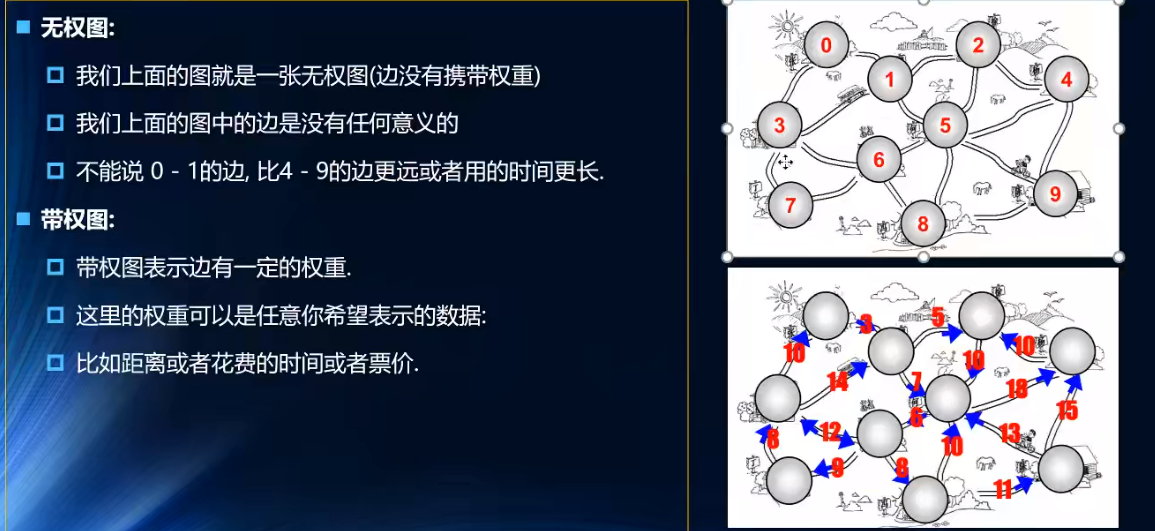

数据去重主要是为了掌握利用并行化思想来对数据进行有意义的筛选,数据去重指去除重复数据的操作。在大数据开发中,统计大数据集上的多种数据指标,这些复杂的任务数据都会涉及数据去重。

(二)案例需求

文件file1.txt本身包含重复数据,并且与file2.txt同样出现重复数据,现要求使用Hadoop大数据相关技术对以上两个文件进行去重操作,并最终将结果汇总到一个文件中。

编写MapReduce程序,在Map阶段采用Hadoop默认作业输入方式后,将key设置为需要去重的数据,而输出的value可以任意设置为空。

在Reduce阶段,不需要考虑每一个key有多少个value,可以直接将输入的key复制为输出的key,而输出的value可以任意设置为空,这样就会使用MapReduce默认机制对key(也就是文件中的每行内容)自动去重。

二,案例实施

(一)准备数据文件

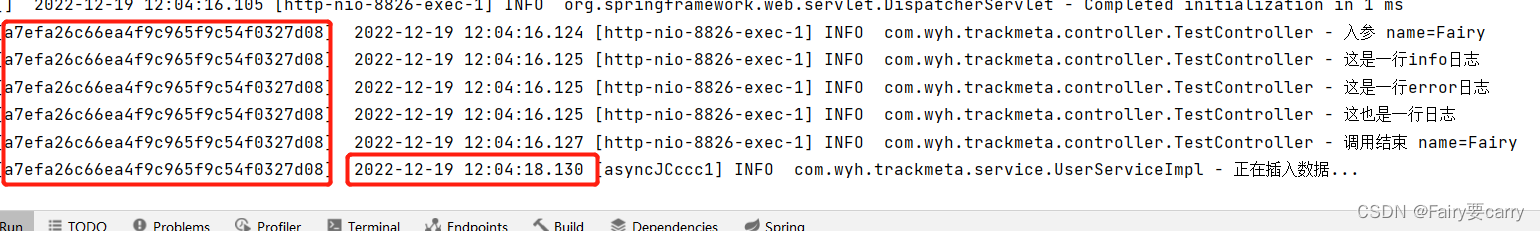

(1)启动hadoop服务

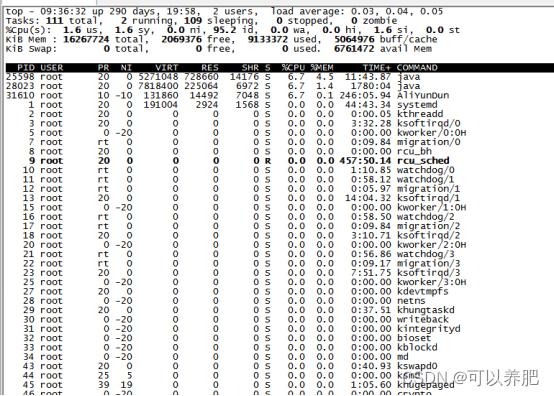

启动hadoop服务,输入命令:start-all.sh

(2)在虚拟机上创建文本文件

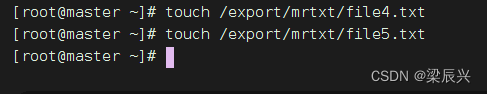

1.在/opt/mrtxt目录下创建两个文本文件 - file4.txt、file5.txt

2.输入命令:vi /export/mrtxt/file4.txt,向file4添加如下内容:

2022-12-1 a

2022-12-2 b

2022-12-3 c

2022-12-4 d

2022-12-5 a

2022-12-6 b

2022-12-7 c

2022-12-3 c

3.输入命令:vi /export/mrtxt/file5.txt,向file5添加如下内容:

2022-12-1 b

2022-12-2 a

2022-12-3 b

2022-12-4 d

2022-12-5 a

2022-12-6 c

2022-12-7 d

2022-12-3 c

(3)上传文件到HDFS指定目录

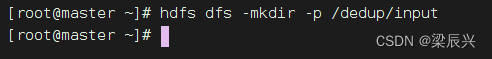

1.创建/dedup/input目录,执行命令:hdfs dfs -mkdir -p /dedup/input

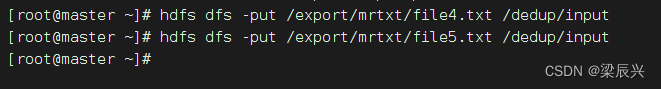

2.将两个文本文件 file4.txt与file5.txt,上传到HDFS的/dedup/input目录

(二)Map阶段实现

使用IntelliJ开发工具创建Maven项目Deduplicate,并且新创建net.army.mr包,在该路径下编写自定义Mapper类DeduplicateMapper,主要用于读取数据集文件将TextInputFormat默认组件解析的类似<0,2022-11-1 a >键值对修改为<2022-11-1 a,null>。

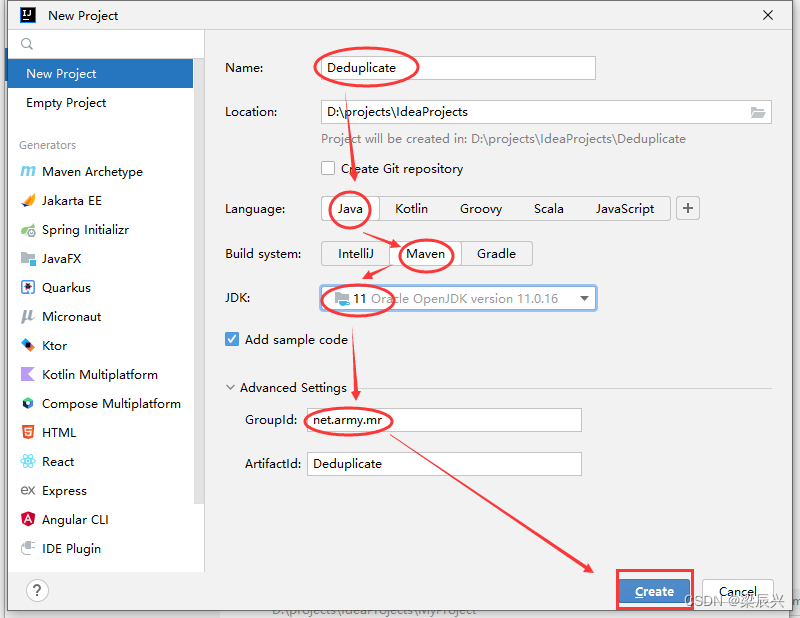

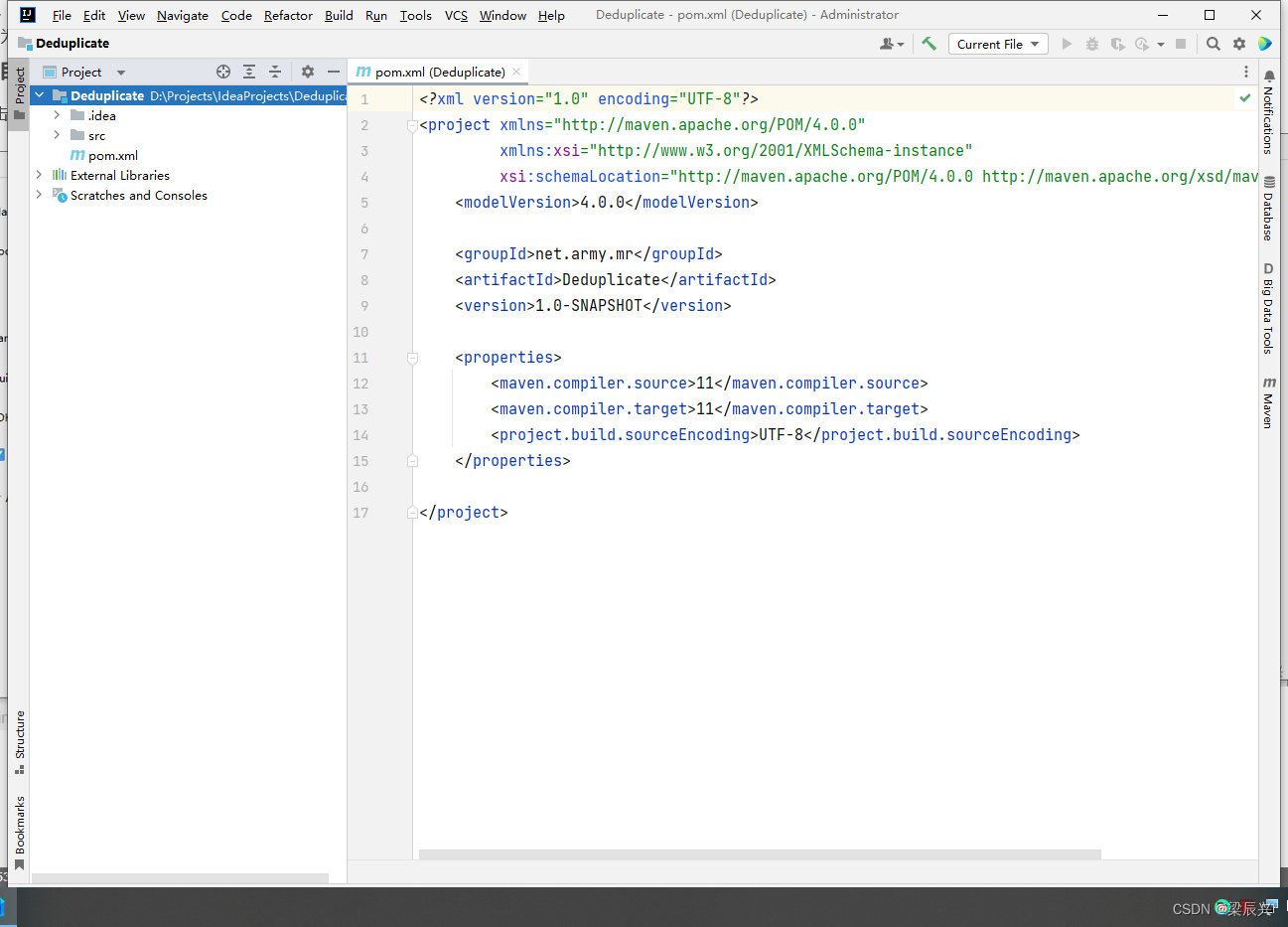

(1)创建Maven项目:Deduplicate

1.配置好如下图所示,然后单击【Create】按钮

2.成功创建界面

2.成功创建界面

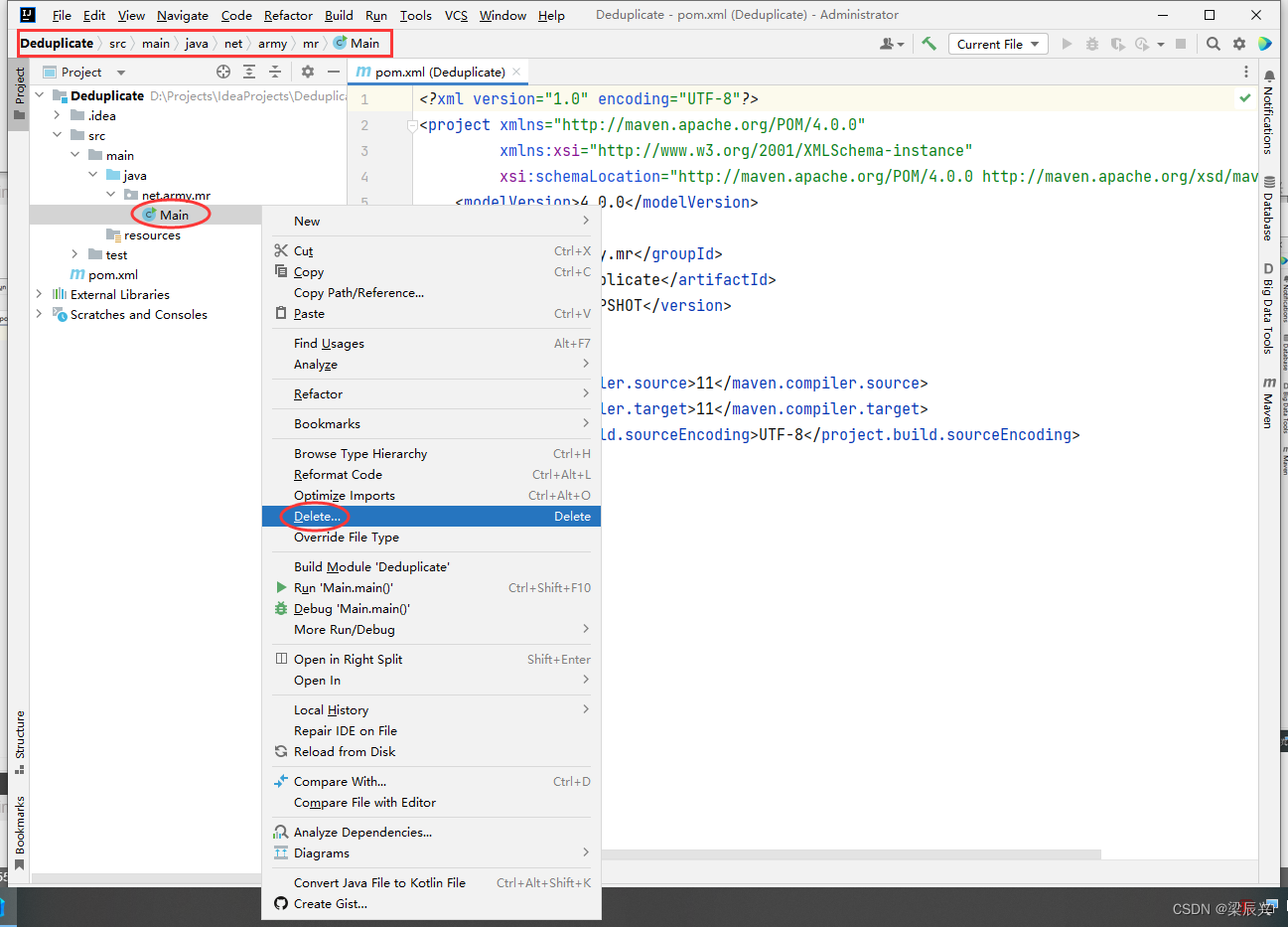

3.删除Main类,右击【Main】类,单击【Delete】

3.删除Main类,右击【Main】类,单击【Delete】

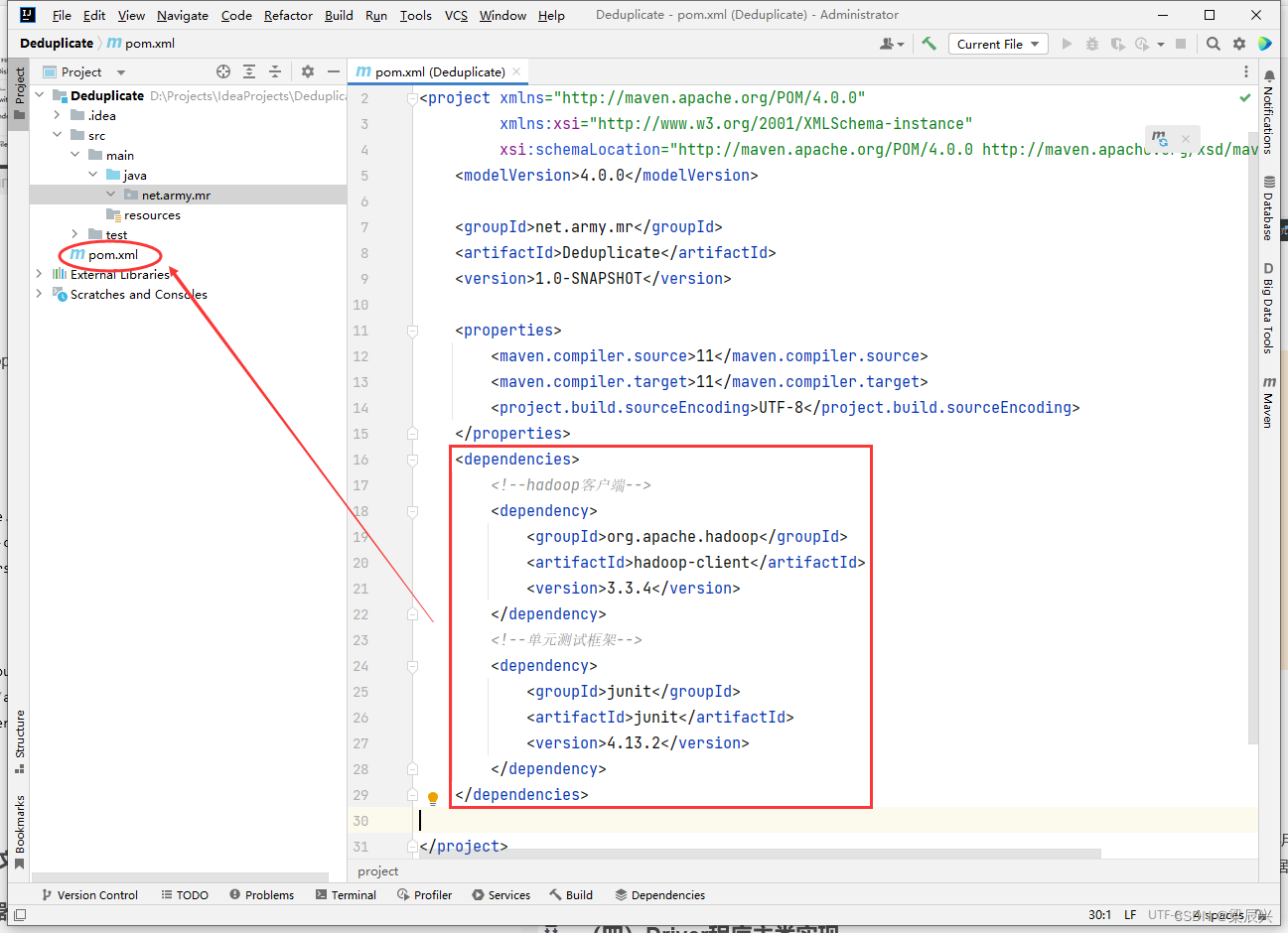

(2)添加相关依赖

1.在pom.xml文件里添加hadoop和junit依赖,添加内容如下:

<dependencies>

<!--hadoop客户端-->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

<!--单元测试框架-->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13.2</version>

</dependency>

</dependencies>

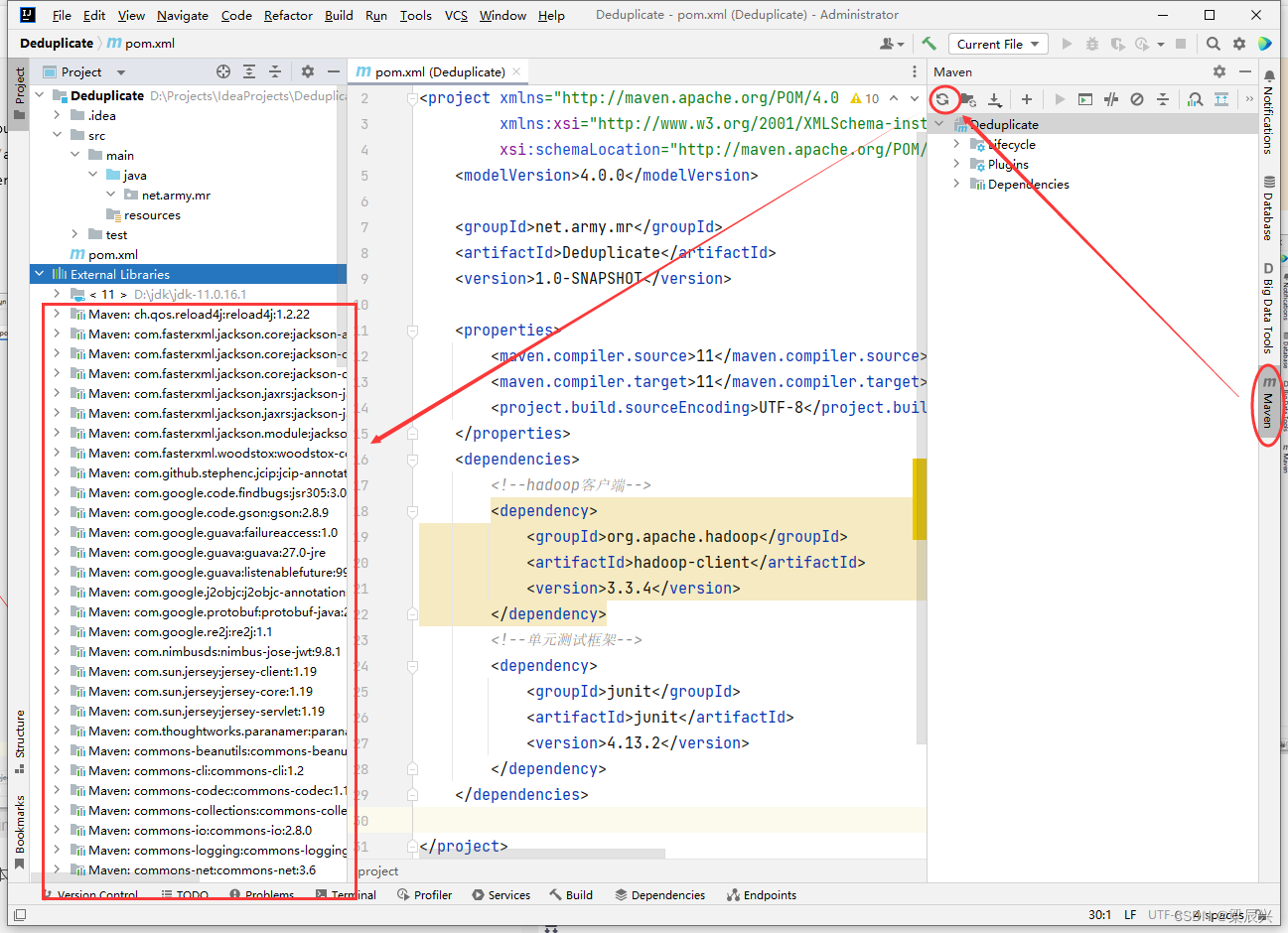

2.刷新maven,将依赖下载到本地仓库

2.刷新maven,将依赖下载到本地仓库

(3)创建日志属性文件

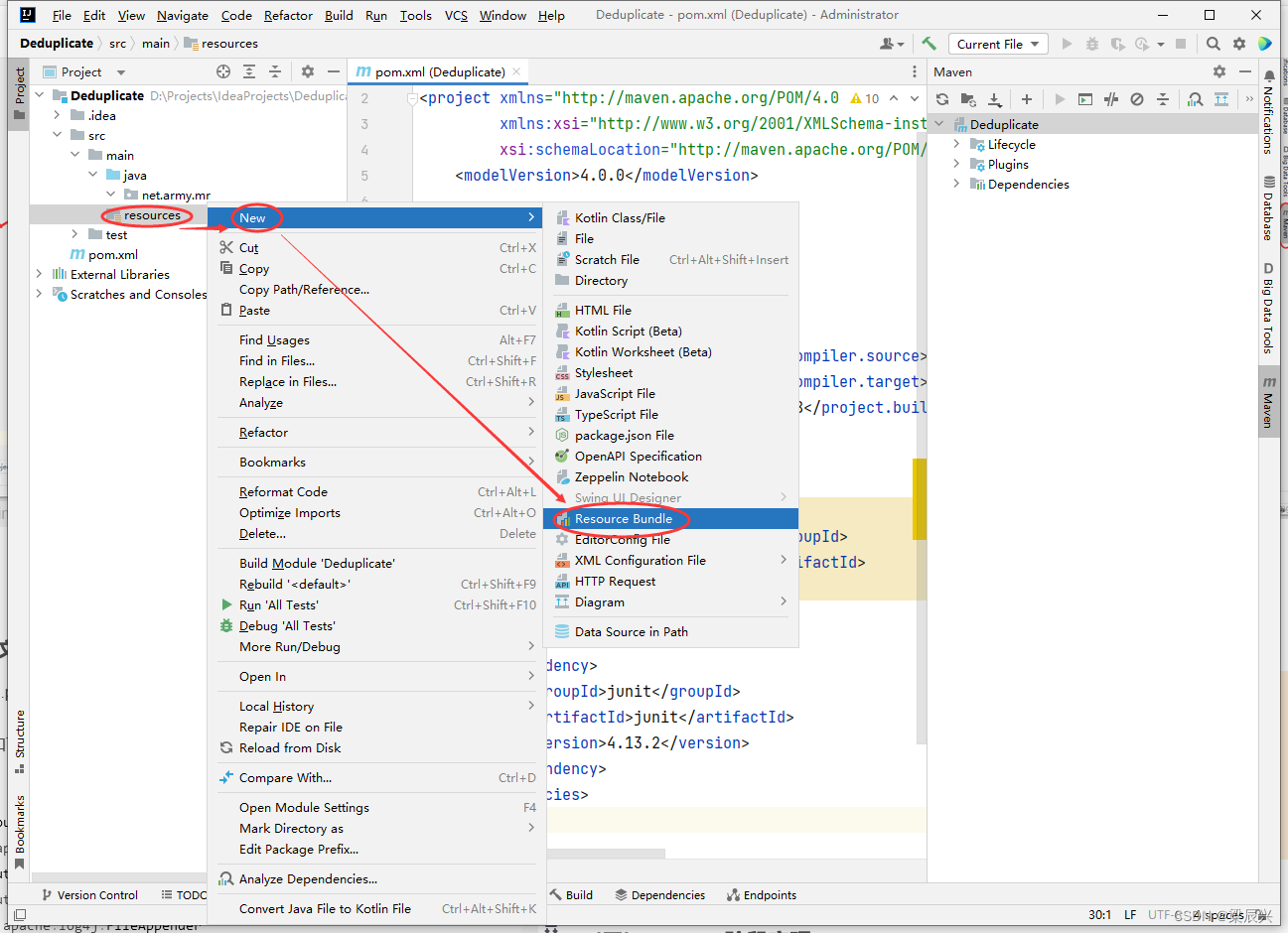

1.在resources目录里创建log4j.properties文件,右击【resources】,选择【New】,单击【Resource Bundle】

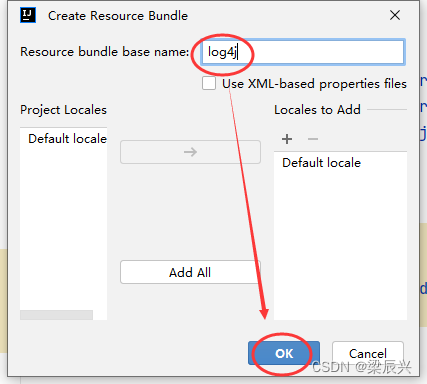

2.在弹出的对话框中输入:log4j,单击【OK】按钮

2.在弹出的对话框中输入:log4j,单击【OK】按钮

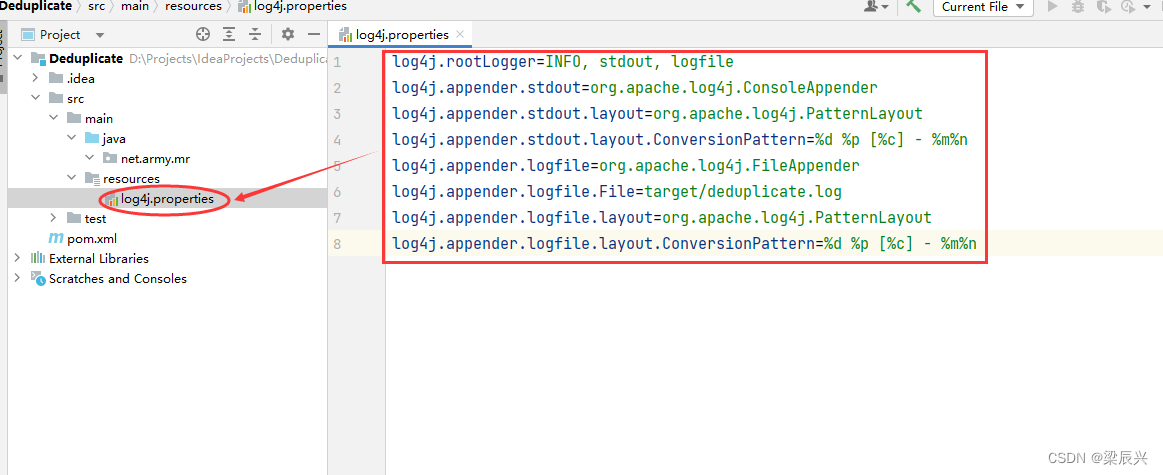

3.向log4j.properties文件添加如下内容:

log4j.rootLogger=INFO, stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/deduplicate.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

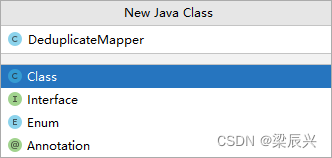

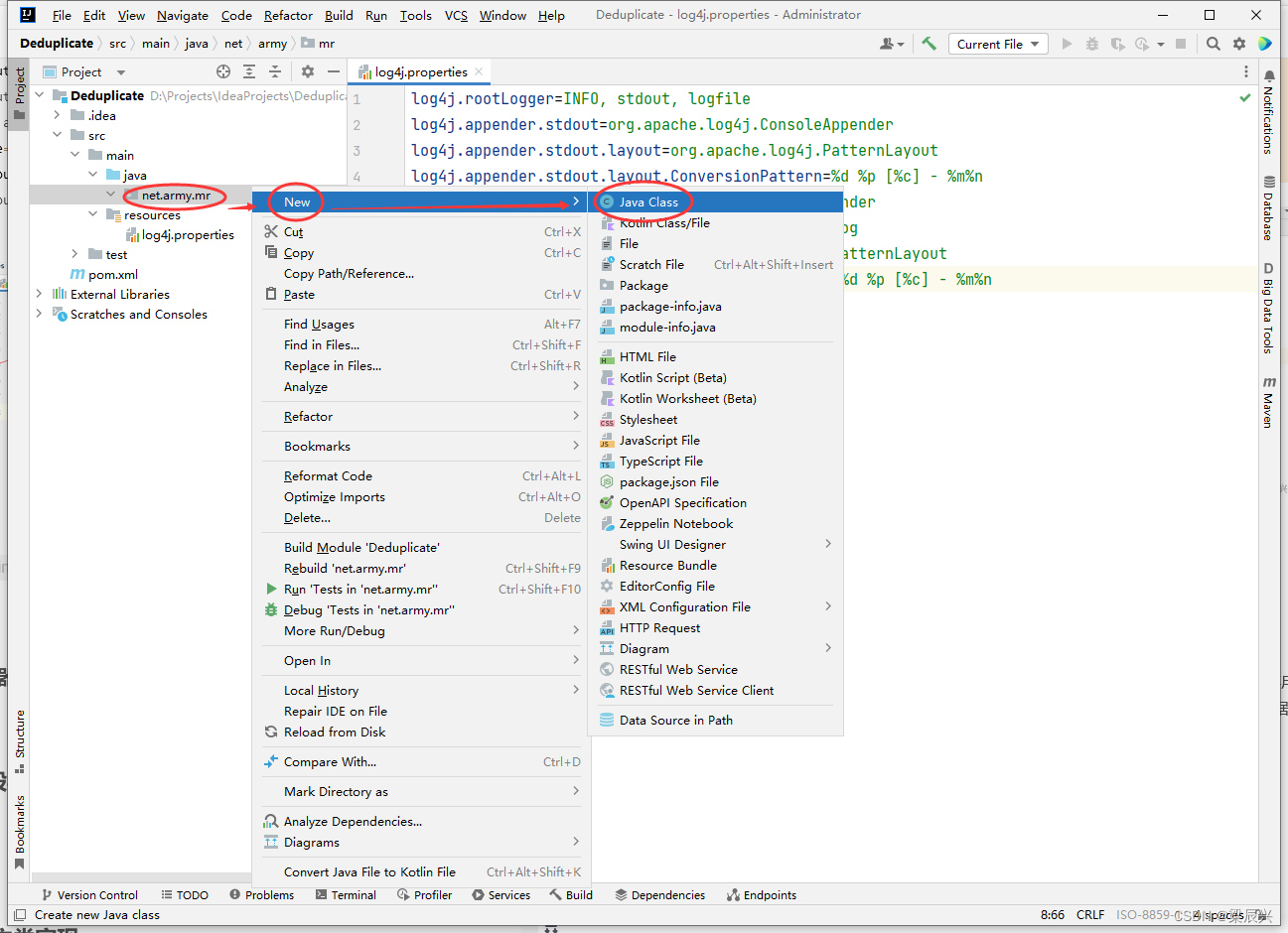

(4)创建去重映射器类:DeduplicateMapper

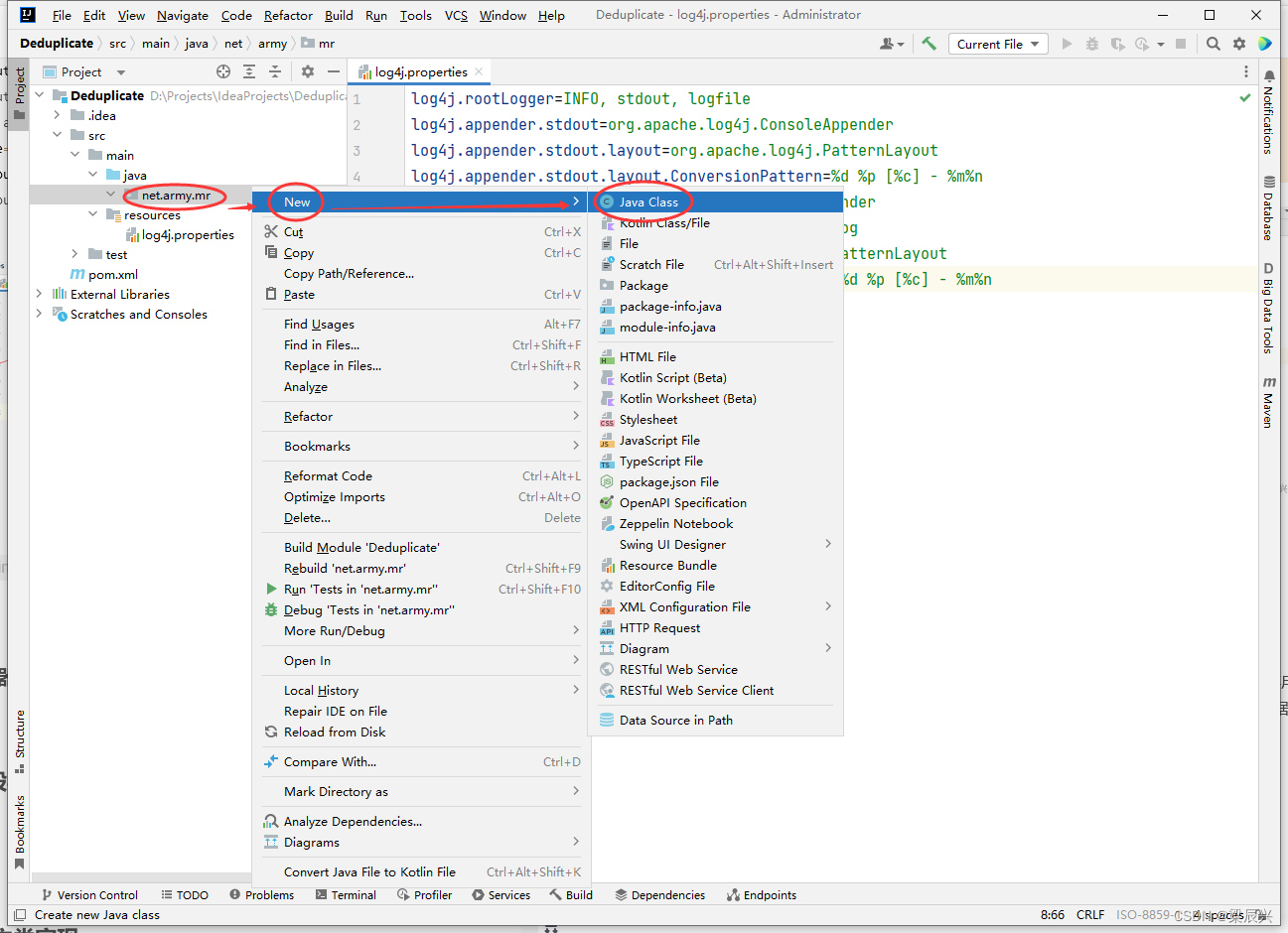

1.右击【net.army.mr】包,选择【New】,单击【Java Class】

2.在弹出的对话框中输入:DeduplicateMapper,按下回车键,创建成功

3.编写代码

package net.army.mr;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

/**

* 作者:梁辰兴

* 日期:2022/12/14

* 功能:去重映射器类

*/

public class DeduplicateMapper extends Mapper<LongWritable, Text, Text, NullWritable> {

private static Text field = new Text();

// <0,2022-12-3 c> --> <2022-12-3 c,null>

@Override

protected void map(LongWritable key, Text value, Context context)

throws IOException, InterruptedException {

field = value;

context.write(field, NullWritable.get());

}

}

(三)Reduce阶段实现

根据Map阶段的输出结果形式,同样在net.army.mr包下,自定义Reducer类DeduplicateReducer,主要用于接受Map阶段传递来的数据,根据Shuffle工作原理,键值key相同的数据就会被合并,因此输出数据就不会出现重复数据了。

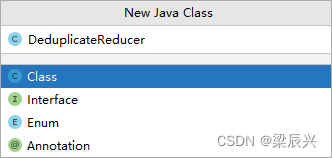

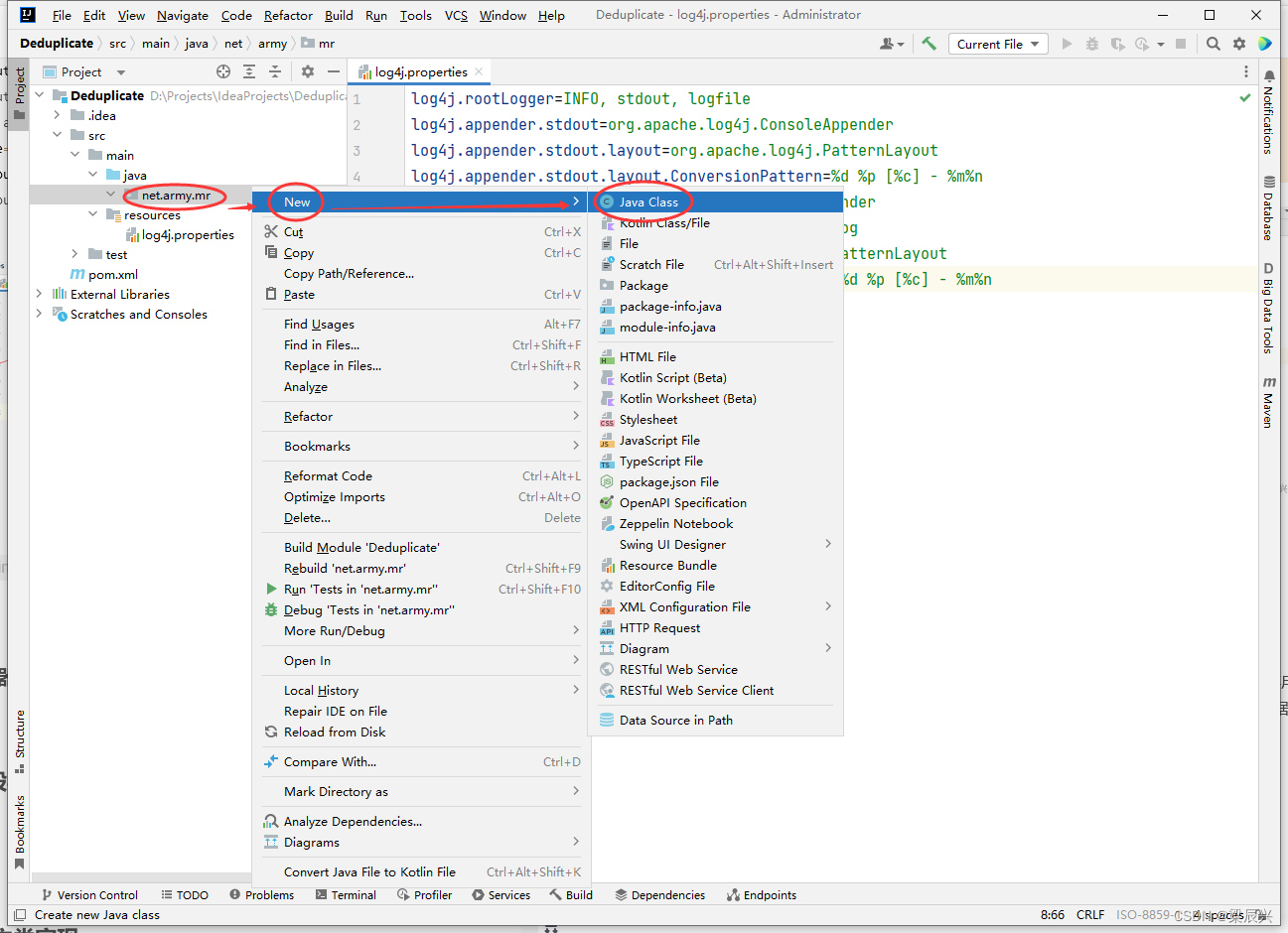

(1)创建去重归并器类:DeduplicateReducer

1.右击【net.army.mr】包,选择【New】,单击【Java Class】

2.在弹出的对话框中输入:DeduplicateReducer,按下回车键,创建成功

3.编写代码

package net.army.mr;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

/**

* 作者:梁辰兴

* 日期:2022/12/14

* 功能:去重归并器类

*/

public class DeduplicateReducer extends Reducer<Text, NullWritable, Text, NullWritable> {

// <2022-12-3 c,null> <2022-12-4 d,null><2022-12-4 d,null>

@Override

protected void reduce(Text key, Iterable<NullWritable> values, Context context)

throws IOException, InterruptedException {

context.write(key, NullWritable.get());

}

}

(四)Driver程序主类实现

编写MapReduce程序运行主类DeduplicateDriver,主要用于设置MapReduce工作任务的相关参数,对HDFS上/dedup/input目录下的源文件实现去重,并将结果输入到HDFS的/dedup/output目录下。

(1)创建去重驱动器类:DeduplicateDriver

1.右击【net.army.mr】包,选择【New】,单击【Java Class】

2.在弹出的对话框中输入:DeduplicateDriver,按下回车键,创建成功

3.编写代码

package net.army.mr;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.net.URI;

/**

* 作者:梁辰兴

* 日期:2022/12/14

* 功能:去重驱动器类

*/

public class DeduplicateDriver {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 获取作业实例

Job job = Job.getInstance(conf);

// 设置作业启动类

job.setJarByClass(DeduplicateDriver.class);

// 设置Mapper类

job.setMapperClass(DeduplicateMapper.class);

// 设置map任务输出键类型

job.setMapOutputKeyClass(Text.class);

// 设置map任务输出值类型

job.setMapOutputValueClass(NullWritable.class);

// 设置Reducer类

job.setReducerClass(DeduplicateReducer.class);

// 设置reduce任务输出键类型

job.setOutputKeyClass(Text.class);

// 设置reduce任务输出值类型

job.setOutputValueClass(NullWritable.class);

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建输入目录

Path inputPath = new Path(uri + "/dedup/input");

// 创建输出目录

Path outputPath = new Path(uri + "/dedup/output");

// 获取文件系统

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 删除输出目录

fs.delete(outputPath, true);

// 给作业添加输入目录

FileInputFormat.addInputPath(job, inputPath);

// 给作业设置输出目录

FileOutputFormat.setOutputPath(job, outputPath);

// 等待作业完成

job.waitForCompletion(true);

// 输出统计结果

System.out.println("======统计结果======");

FileStatus[] fileStatuses = fs.listStatus(outputPath);

for (int i = 1; i < fileStatuses.length; i++) {

// 输出结果文件路径

System.out.println(fileStatuses[i].getPath());

// 获取文件输入流

FSDataInputStream in = fs.open(fileStatuses[i].getPath());

// 将结果文件显示在控制台

IOUtils.copyBytes(in, System.out, 4096, false);

}

}

}

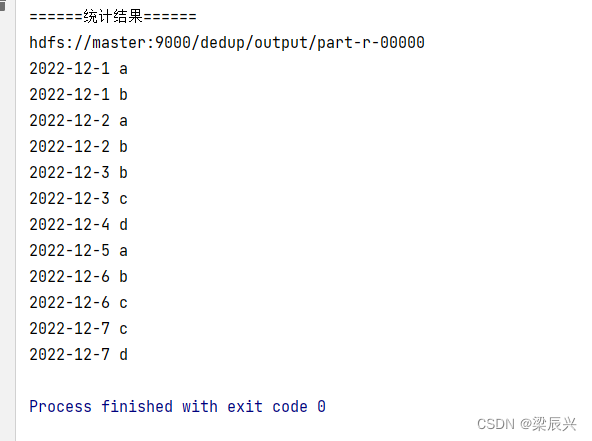

(五)运行去重驱动器类,查看结果

(1)运行DeduplicateDriver类

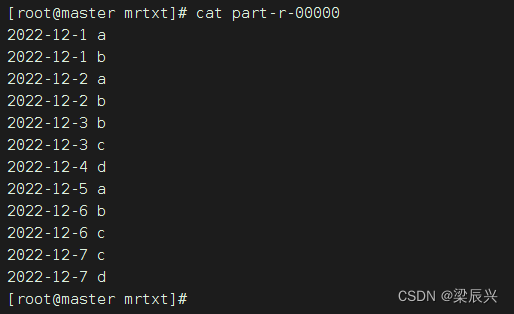

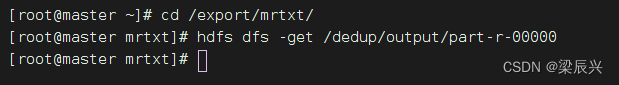

(2)下载并查看文件

1.下载文件

进入mrtxt目录,输入命令:cd /export/mrtxt

下载文件,再输入命令:hdfs dfs -get /dedup/output/part-r-00000

2.查看文件,输入命令:cat part-r-00000