Visual Attention Network

2022 大核注意力机制LKA

在本文中,提出了一种新的大核注意力large kernal attention(LKA)模型, LKA吸收了卷积和自注意的优点,包括局部结构信息、长程依赖性和适应性。同时,避免了忽略在通道维度上的适应性等缺点。

CNN

因为使用了局部上下文信息和平移不变性,极大地提高了神经网络的效率。

视觉的注意力

视觉的注意力可以被分为四个类别: 通道注意力、空间注意力、时间注意力和分支注意力。每种注意力机制都有不同的效果。Self-attention 是一个特别的注意力,可以捕捉到长程的依赖性和适应性,在视觉任务中越来越重要。但是,self-attention有三个缺点:

- 它把图像变成了1D的序列进行处理,忽略了2D的结构信息。

- 对于高分辨率图片来说,二次计算复杂度太高。

- 它只实现了空间适应性却忽略了通道适应性。

对于视觉任务来说,不同的通道经常表示不同的物体,通道适应性在视觉任务中也是很重要的。为了解决这些问题,我们提出了一个新的视觉注意力机制:LKA。 它包含了self-attention的适应性和长程依赖,而且它还吸收了卷积操作中利用局部上下文信息的优点。

视觉MLP

最近的一些研究成功地把标准的MLP分解为了spatial MLP和channel MLP,显著降低了计算复杂度和参数量,释放了MLP的性能。 与我们最相近的MLP是gMLP, 它分解了标准的MLP并且引入了注意力机制。 但是gMLP有两个缺点:

- gMLP对输入尺寸很敏感,只能处理固定尺寸的图像。

- gMLP只考虑了全局信息而忽略了局部的信息。

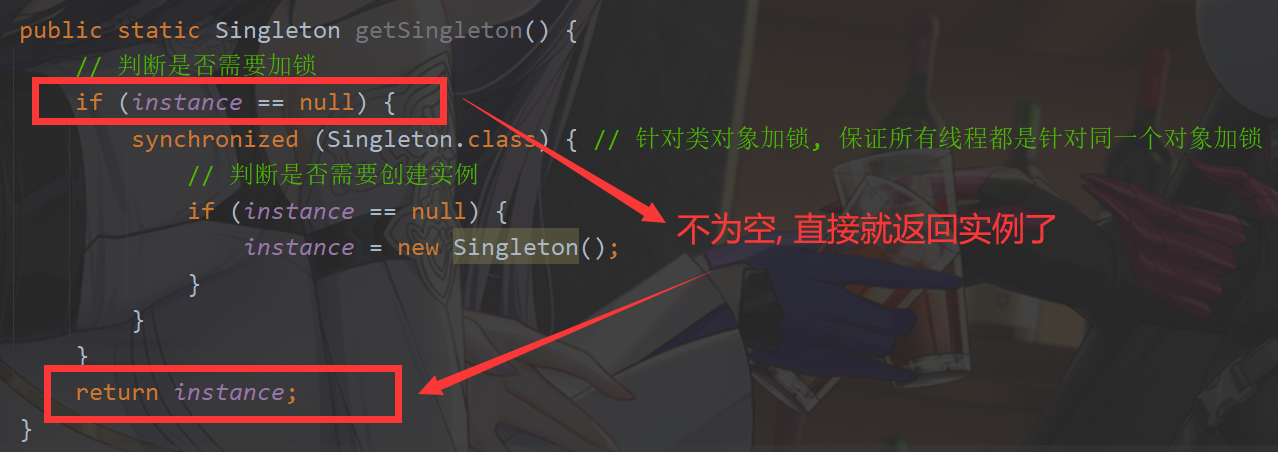

大核注意力机制LKA

注意力机制可以看作是一个自适应选择过程,它可以根据输入特征来选择可鉴别特征,并自动忽略噪声响应。注意力机制的关键步骤是生成表示不同点的重要性的注意力图。要做到这一点应该学习不同点之间的关系。

- MobileNet它将标准卷积解耦为两部分,一个深度卷积和一个点卷积。

- LKA将卷积分解为三部分:深度卷积、深度和扩张卷积、和点卷积。也可以说是一个局部空间卷积(depthwise conv)、一个空间长程卷积(depthwise dilation conv)、一个通道卷积(1 x 1 conv)。

Large Separable Kernel Attention: Rethinking the Large Kernel Attention Design in CNN

LSKA 具有注意力的大可分离卷积核

LKA模块中的深度卷积层随着卷积核大小的增加而导致计算和内存占用呈二次增加。LSKA将深度卷积层的二维卷积核分解为级联的水平和垂直一维卷积核。随着卷积核大小的增加,所提出的LSKA设计更倾向于将VAN偏向物体的形状而不是纹理。

LSKA将深度卷积层的二维卷积核分解为级联的水平和垂直一维卷积核。与标准的LKA设计相比,所提出的分解使得可以在注意力模块中直接使用具有大卷积核的深度卷积层,无需额外的块。