本地部署 Llama2-Code-Interpreter

- 1. Llama2-Code-Interpreter 是什么

- 2. Llama2-Code-Interpreter 主要特点

- 3. 部署 Llama2-Code-Interpreter

- 4. 运行 Llama2-Code-Interpreter

- 5. 访问 Llama2-Code-Interpreter

1. Llama2-Code-Interpreter 是什么

该项目允许 LLM 根据整个流程生成代码、执行代码、接收反馈、调试和回答问题。它的设计直观且通用,能够处理多种语言和框架。

2. Llama2-Code-Interpreter 主要特点

- 🚀代码生成和执行:Llama2 能够生成代码,然后在生成的代码块中自动识别并执行代码。

- 监视并保留先前执行的代码块中使用的 Python 变量。

3. 部署 Llama2-Code-Interpreter

克隆代码库,

git clone https://github.com/SeungyounShin/Llama2-Code-Interpreter.git; cd Llama2-Code-Interpreter

创建虚拟环境,

conda create -n llama2codeinterpreter python==3.10 -y

conda activate llama2codeinterpreter

安装所需的依赖项,

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

pip install -r requirements.txt

pip install protobuf tweepy

4. 运行 Llama2-Code-Interpreter

python chatbot.py --path Seungyoun/codellama-7b-instruct-pad

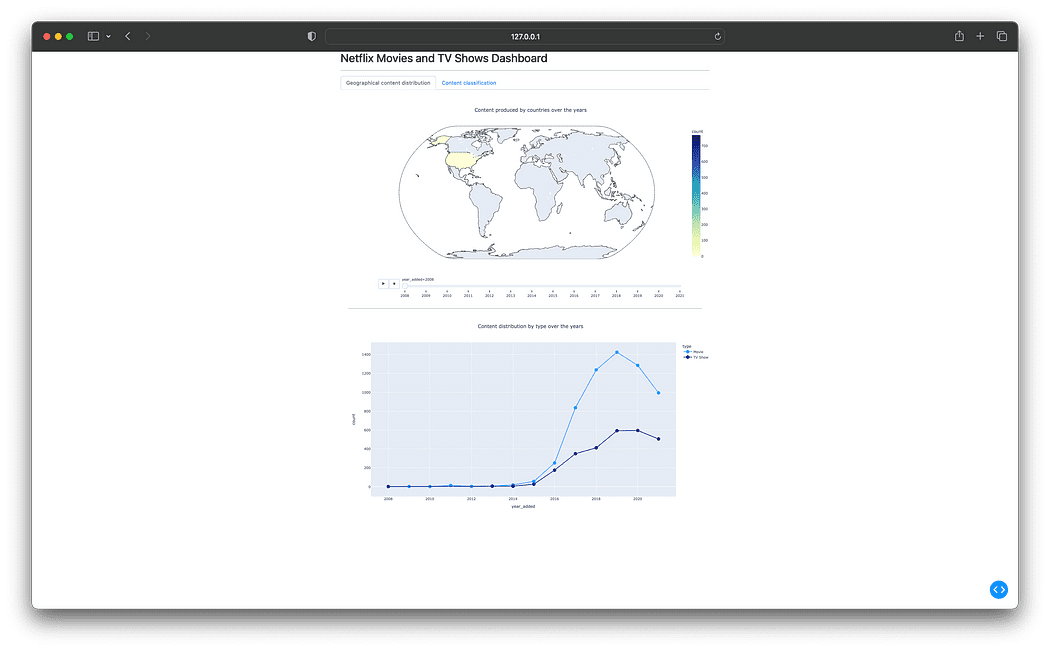

5. 访问 Llama2-Code-Interpreter

使用浏览器打开 http://127.0.0.1:7860,

完结!

![java八股文面试[多线程]——虚假唤醒](https://img-blog.csdnimg.cn/4e7f5d523ec34dd8ac356ce5c530d59d.png)

![[华为云云服务器评测] 华为云耀云服务器 Java、node环境配置](https://img-blog.csdnimg.cn/e78cf7bba4cf4244b80aaca2373f7902.png)