大家好,我是微学AI,今天给大家介绍一下深度学习技巧应用26-CNN中多种注意力机制的嵌入方法,终于搞懂注意力机制了。CNN是一种能够有效处理图像和其他二维数据的深度学习模型。在传统的CNN中,每个卷积核都会对输入的所有位置进行相同的操作,这可能导致网络无法针对特定区域或特征进行更加关注和重点处理。

注意力机制被引入卷积神经网络中,旨在使网络能够自动地学习和聚焦于输入中的重要区域或特征。通过引入注意力机制,可以增强网络对不同区域或特征的关注度,提取更有意义和相关的特征,从而提高模型的性能和表达能力。

一、注意力机制的介绍

我们在CNN中引入注意力机制,使得网络模型能够自适应地学习不同通道之间的关联性和重要性,进而选择性地强调或抑制某些通道上的特征。这种自适应性可以使网络在处理不同类型的图像时更加灵活和准确。

注意力机制的优势:

1.关注重要特征:注意力机制可使网络专注于输入中的重要区域或特征,从而提高模型的感知能力和表达能力。

2.自适应性:注意力机制能够自动学习不同通道之间的关联性和重要性,适应不同任务和数据的特点。

3.提升性能:引入注意力机制可以改善模型在各种计算机视觉任务(如图像分类、目标检测等)中的性能。

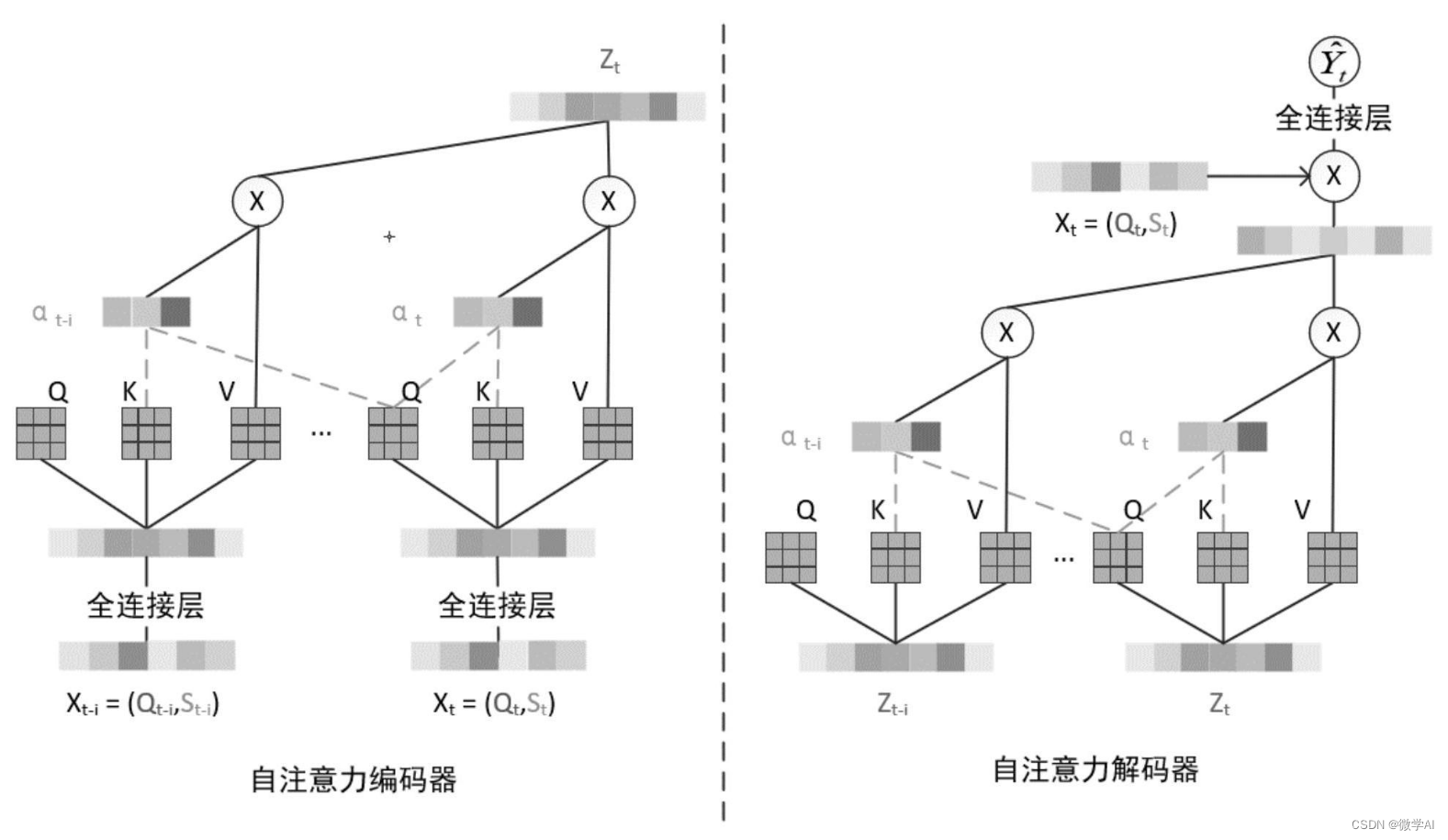

二、线性变换和softmax函数的注意力机制

构建思路:

构建SelfAttention注意力层,接收in_channels作为输入,in_channels表示输入特征的通道数。在该函数中&#