在进行大规模数据抓取时,如何提高效率和稳定性是关键问题。本文将介绍一种可操作的方案——使用HTTP代理来实现并发的网页抓取,并帮助您加速数据抓取过程。

1. 选择合适的HTTP代理服务供应商

- 寻找信誉良好、稳定可靠且具备较快响应时间的HTTP代理服务供应商;

- 确保其支持所需功能(例如高度匿名或隧道转发);

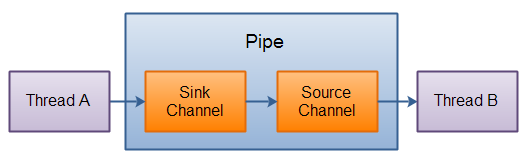

2. 并行请求与连接池管理

- 利用多线程/异步编程技术,在同一时间内发送多个请求以增强并行处理能力;

- 使用连接池管理器对每个线程/任务分配独立而复用性强的TCP/IP连接;

3. 请求重试机制与错误处理

- 设置适当数量及间隔时间之后自动重新尝试失败请求;

- 针对不同类型错误设置相应策略, 如IP被封禁等;

4. 反爬虫措施与轮换User-Agent头部信息

* 在配置中启用反爬虫手段:

限流: 控制访问频率,

验证码识别: 自动化解决图形验证码,

代理轮换: 通过更改User-Agent头部信息来模拟不同客户端;

* 遵守网站的robots.txt规则;

5. 数据处理与存储优化

- 在数据抓取过程中进行实时清洗和筛选,以减少后续处理负荷;

- 合理选择合适的数据库或文件格式,并对其进行性能调优;

6. 监控与日志分析

建立监测系统以追踪HTTP代理状态,并记录请求结果及相关参数。

- 实时监控每个代理服务器响应速度、可用性等指标;

- 分析日志并提取有价值信息, 如异常情况或被封禁IP地址。

标题:加速网页抓取:通过HTTP代理进行并发的数据抓取

![[递归] 自然数分解之方案数](https://img-blog.csdnimg.cn/4f52aef219ee475f82f6b202fc4efd94.png)