大家好!在当今信息爆炸的时代,了解新闻事件的发展进程和舆论反映对于我们保持对时事的敏感度和了解社会动态至关重要。在本文中,我将与你分享使用Python爬虫追踪新闻事件发展进程和舆论反映的方法,帮助你获取及时、全面的新闻信息。

1. 爬取新闻网站

首先,我们需要选择合适的新闻网站作为爬取的目标。选择知名、可靠的新闻网站,以确保获取到权威和可信的新闻信息。

实现方法:

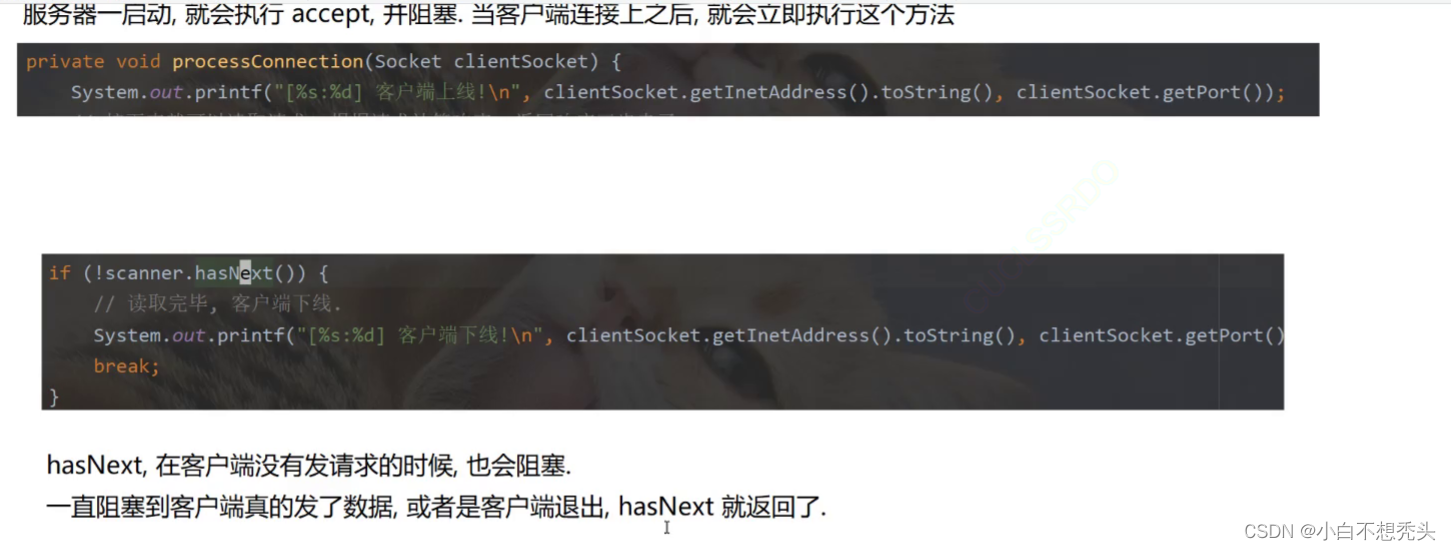

- 发送HTTP请求: 使用Python的requests库发送HTTP请求,获取新闻网页的HTML源代码。

- 解析HTML源代码: 使用Python的BeautifulSoup库解析HTML源代码,提取新闻标题、内容、发布时间等关键信息。

2. 追踪新闻事件发展

一旦我们获取了新闻网站的新闻信息,我们可以使用增量爬虫的方法来追踪新闻事件的发展。通过定期爬取更新的新闻页面,我们可以了解事件的最新进展。

实现方法:

- 记录已爬取的新闻链接: 使用数据库或缓存记录已经爬取的新闻链接,避免重复爬取。

- 定期爬取更新的新闻页面: 使用定时任务或调度器,定期运行爬虫程序,爬取新闻网站上更新的新闻页面。

- 提取新的新闻信息: 对比已有的新闻链接和新爬取的新闻页面,提取新增的新闻信息,包括标题、内容、发布时间等。

3. 分析舆论反映

除了追踪新闻事件的发展,我们还可以通过爬虫来分析舆论反映。通过爬取新闻网站的评论、社交媒体的帖子等,我们可以了解公众对于特定事件的观点和态度。

实现方法:

- 获取评论和社交媒体数据: 爬取新闻网站的评论区、微博、Twitter等社交媒体平台上与新闻事件相关的帖子和评论。

- 情感分析: 使用自然语言处理技术对评论和帖子进行情感分析,了解公众的情绪倾向。

- 关键词提取: 提取评论和帖子中的关键词,帮助我们了解公众关注的焦点和热点问题。

当涉及到具体的网站和数据结构时,爬取代码会因网站的不同而有所差异。在这里,我提供一个基本的示例代码,用于演示如何使用Python爬虫爬取新闻网站的信息。

import requests

from bs4 import BeautifulSoup

# 发送HTTP请求,获取新闻网页的HTML源代码

def get_html(url):

response = requests.get(url)

if response.status_code == 200:

return response.text

else:

print('Failed to retrieve HTML from', url)

return None

# 解析HTML源代码,提取新闻信息

def parse_news(html):

soup = BeautifulSoup(html, 'html.parser')

# 根据实际网页结构,使用选择器提取新闻标题、内容、发布时间等信息

title = soup.select_one('.news-title').text.strip()

content = soup.select_one('.news-content').text.strip()

publish_time = soup.select_one('.publish-time').text.strip()

# 可以根据需要进行数据的进一步处理,例如存储到数据库或进行分析

# 打印新闻信息

print('标题:', title)

print('内容:', content)

print('发布时间:', publish_time)

# 主程序

if __name__ == '__main__':

# 设置要爬取的新闻网站的URL

url = 'https://www.example.com/news/123' # 替换为目标新闻网站的URL

# 获取新闻网页的HTML源代码

html = get_html(url)

if html:

# 解析HTML源代码,提取新闻信息

parse_news(html)

请注意,以上示例代码只提供了一个基本的框架,具体的实现方式需要根据目标网站的结构和数据格式进行调整。同时,在进行网站爬取时,请遵守相关的法律法规和网站的使用条款,确保合法合规地进行数据爬取。