SDXL是目前最强的AI绘画基础模型,直接加载模型,就可以生成不错的效果。但是它有一个致命的问题,就是不支持ControlNet。

在AI绘画中,ControlNet是一个非常重要的工具。有了它,就可以生成更加可控精准的图片。ControlNet的用途非常多,比如,控制人物姿势、线稿上色、动漫变真人、艺术二维码,光影字、ailogo...

好消息是,SDXL终于也支持了Controlnet。虽然只有一个canny模型,但是至少是能用了。

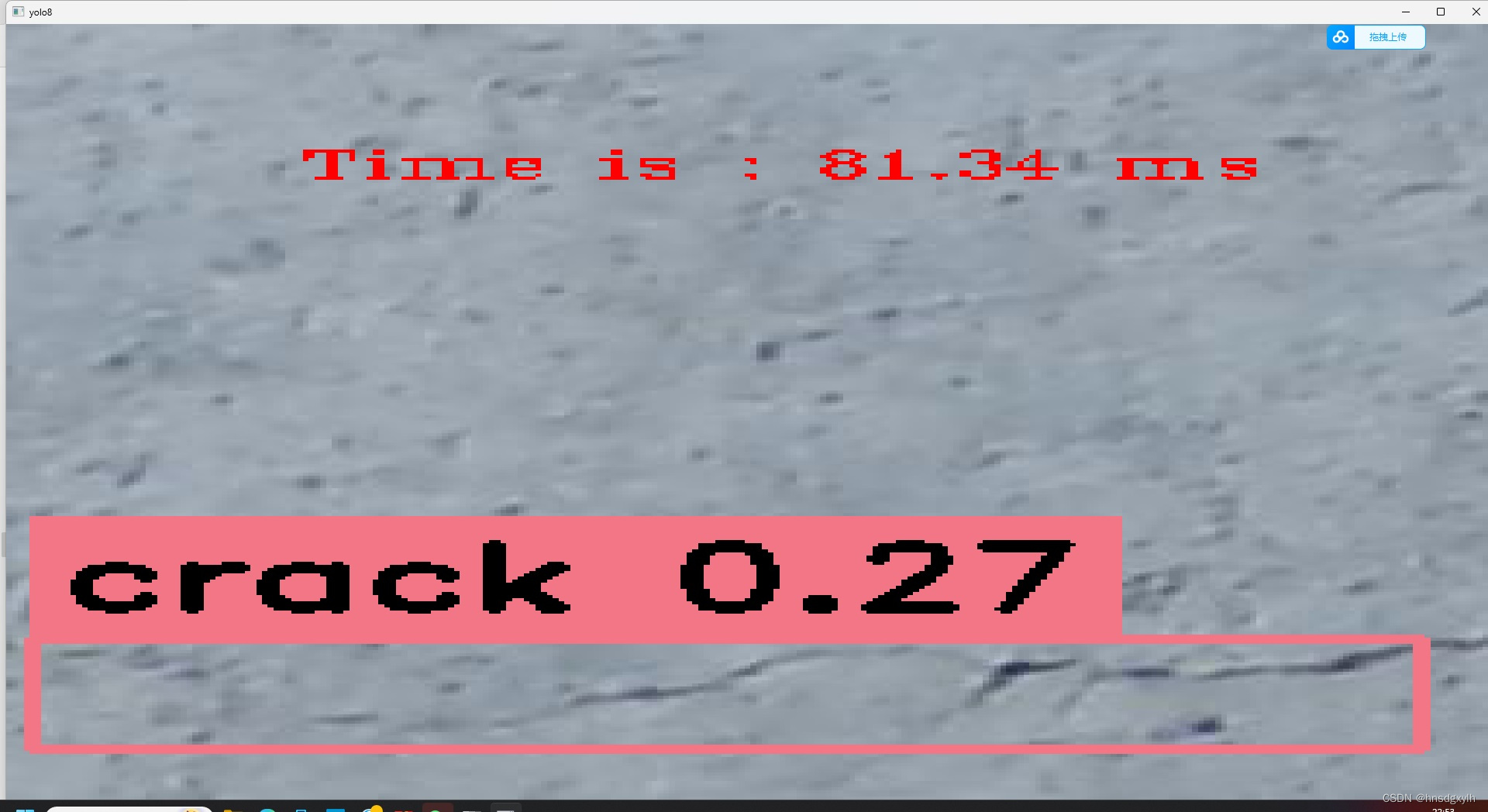

下面来看一下效果:

提示词: ultrarealistic shot of a furry blue bird

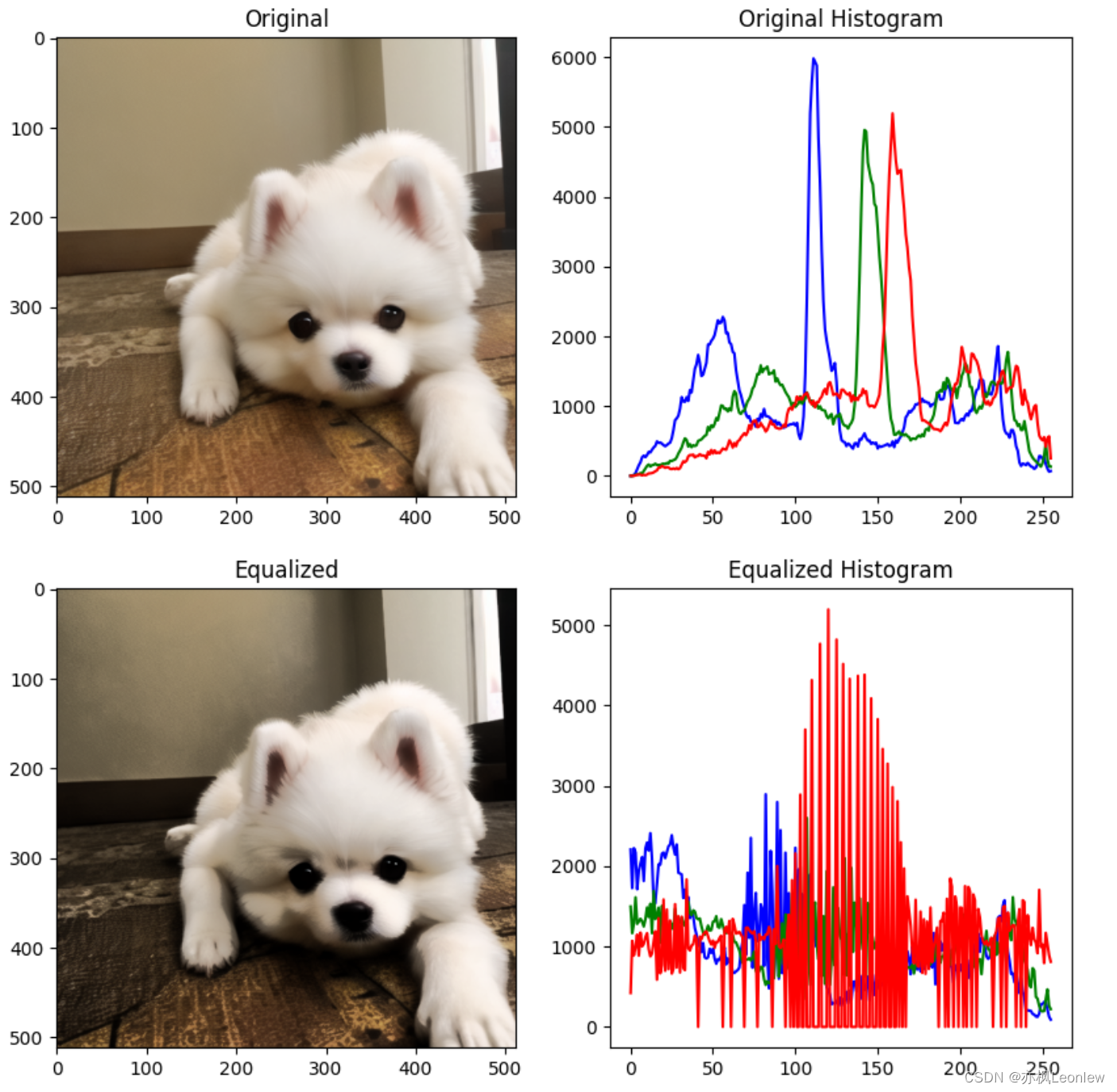

我自己尝试的效果:

随手拿了一张之前生成的图片,然后用Controlnet生成了一下。对比一下,细节控制得挺不错。

下面就具体地说一下,如何在ComfyUI中使用Controlnet。

1.准备工作

首选需要安装好ComfyUI软件,然后确保SDXL基础模型放在指定的路径

这一步不会的可以参考之前的文章。

2. 获取模型

获取ControlNet的Canny模型,并放到指定的路径。

3. 准备图片

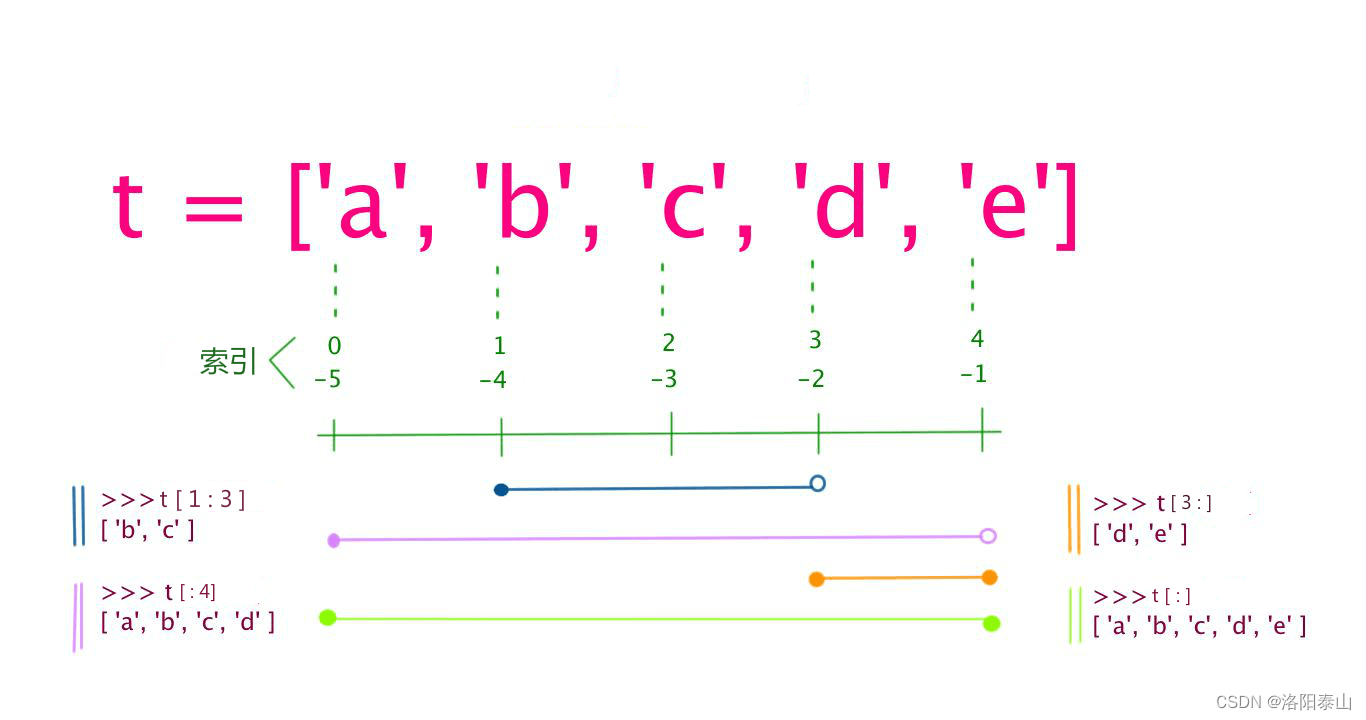

准备一张测试图片

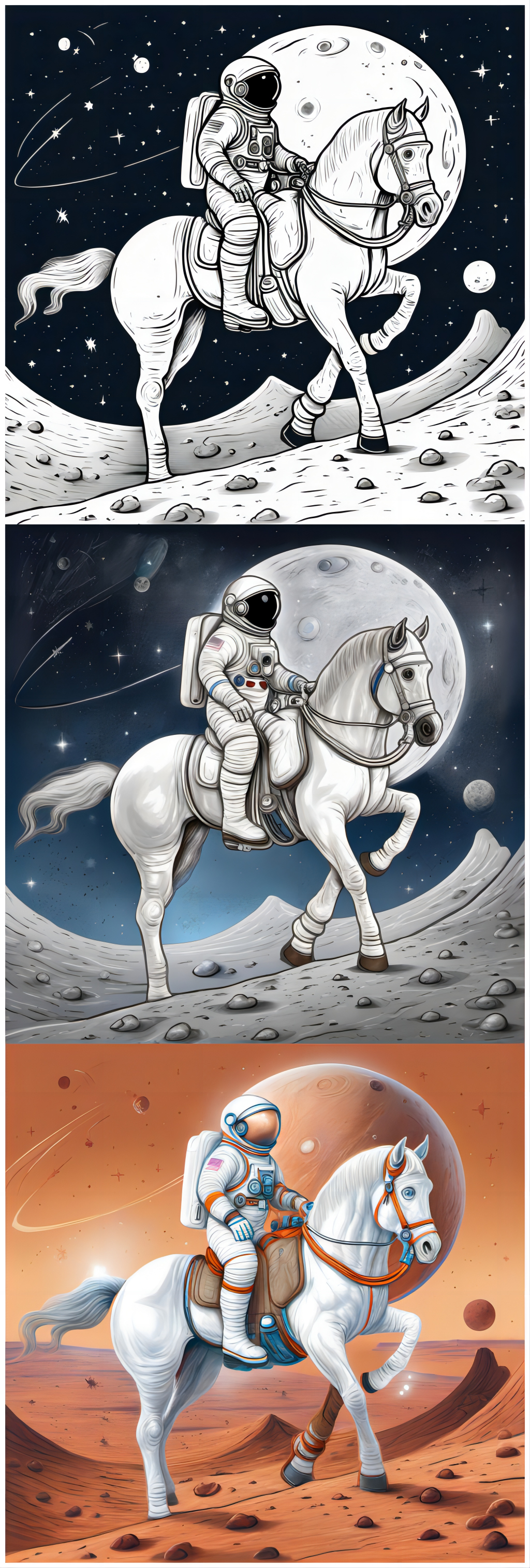

这是我之前用SDXL生成的一张line风格的图片。这次就用这张图片来做演示。

选图片的时候,最好是直接选线稿这样稳定一些,当然用普通图片也是可以滴。

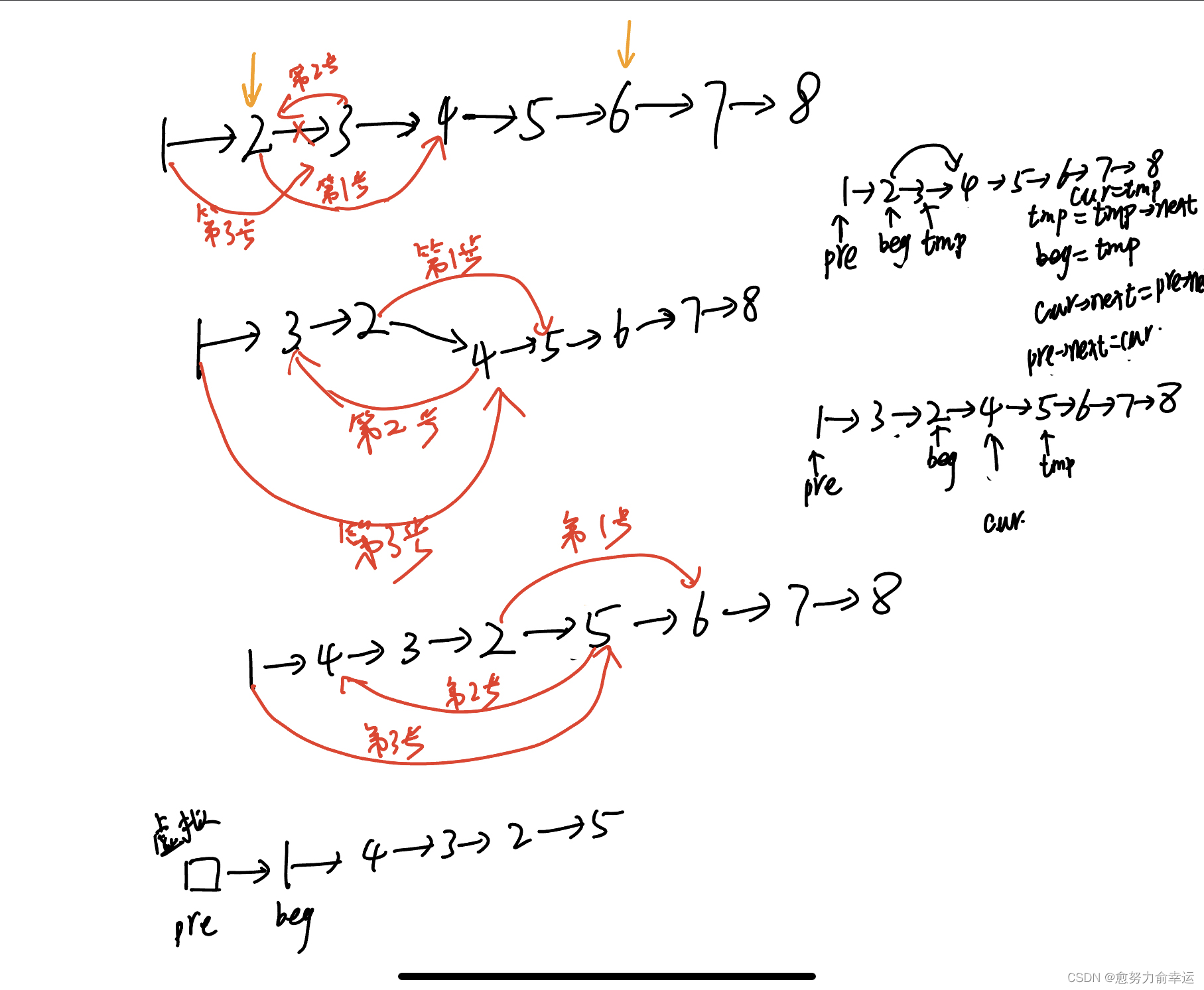

4. 加载工作流

ComfyUI其实挺好用,但是对于不太熟悉的人,自己来创建工作流难度还是比较大。快速体验的最好方式是,直接使用别人创建好的工作流配置文件。

双击run_nvidia_gpu.bat启动软件之后。

只需要把这个叫做sdxl_controlnet_canny.json的文件拖动到浏览器上就可以了。

然后就可以看到这样的流程图了。

5. 运行测试

加载工作流之后,稍微设置一下就可以出图了。

首先是设置一下基础模型,确保是图片中的模型。

然后是设置Controlnet模型和上传参考图片。

然后是改一下提示词。

另外修改一下像素为1024x1024。

万事俱备,最后只要点击一下"Queue Prompt",然后等待图片生成了。

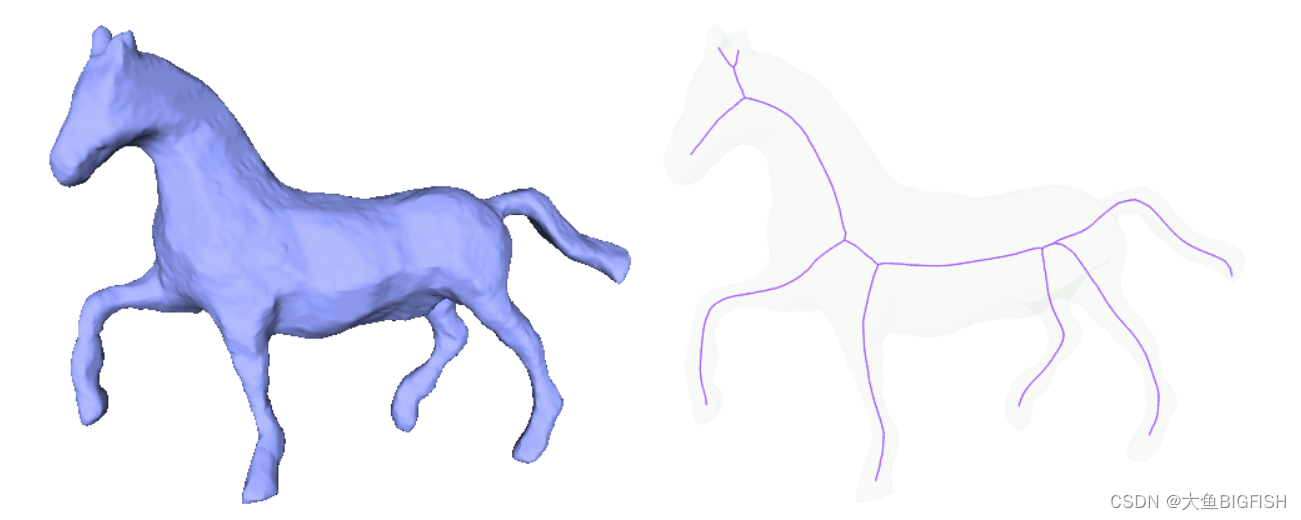

可以对比,原图和生成的图片,是不是完全一张的姿势。具体的效果的话,和提示词以及风格有关。

第一次出图会比较慢,因为需要很长的时间去加载巨大的模型。加上多了一个巨大的Controlnet模型,需要一点耐心。

我以前用SDXL生成过不同的风格图片,但是按以前的方式,每张图片除了风格不同之外,形态也完全不同。现在用了ControlNet就可以生成形态相同,不同风格的图片了。

这匹马,蹄子有点多...哈哈~~

SDXL的ControlNet使用方法大概就是这样,具体的创作就留给大家了!

软件,模型,工作流:见文末