强化学习有关词汇

state:对Environment的完整描述

action: 给定环境中所有有效操作的集合,通常称为动作空间

agent:执行action的模型

Environment:代理之外的所有部分。agent可以直接或间接的与之交互的一切,Agent执行操作时,Environment会发生变化;每一次这样的变化都被认为是一次state转换。Agent执行的每一个动作都会收到环境的reward。

polocoes:策略是agent用来决定采取什么action的规则,可以是确定的,也可以是随机的。目的是根据state来决定action,控制agent进行运动。

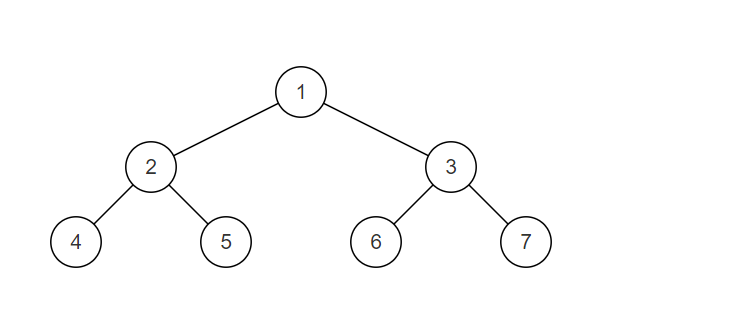

Policy function π:(s,a)——> [0 ,1]:π(a | s)= P(A=a | S = s)

在观察一种S时,根绝策略函数,Agent的A是随机的。一种强化学习的目的就是学习这个policy函数

Reward:agent从环境中接收的数值,作为对agent操作对未来局势影响的判断。也就是agent所采取action的动机。所有动作都会产生奖励。

reward可以大致分为三种:强调期望行为的积极奖励;强调代理应该偏离的行为的消极奖励;以及零奖励,这意味着代理没有做任何特殊或独特的事情

reward一般是人为定义的,reward定义的好坏可以直接影响结果。强化学习的目标就是获得max reward

state transition:状态转移具有随机性

Trajectory:序列是由代理与环境交互过程中的一系列状态和动作所组成。

Return & Discounted return(回报与折扣回报):累计的未来的回报,

retrun: U t = R t + R t + 1 + R t + 2 + R t + 3 + . . . {{\rm{U}}_t} = {{\rm{R}}_t} + {{\rm{R}}_{t + 1}} + {{\rm{R}}_{t + 2}} + {{\rm{R}}_{t + 3}} + ... Ut=Rt+Rt+1+Rt+2+Rt+3+...

Ut只是一个随机变量,在t时刻,并不知道它是什么,它依赖于未来所有的action和state

Discounted return: Υ \Upsilon Υ折扣率

U t = Υ R t + Υ 2 R t + 1 + Υ 3 R t + 2 + Υ 4 R t + 3 + . . . {{\rm{U}}_t} = \Upsilon {{\rm{R}}_t} + {\Upsilon ^2}{{\rm{R}}_{t + 1}} + {\Upsilon ^3}{{\rm{R}}_{t + 2}} + {\Upsilon ^4}{{\rm{R}}_{t + 3}} + ... Ut=ΥRt+Υ2Rt+1+Υ3Rt+2+Υ4Rt+3+...

Action-Value Function:

Definition: Action-value function for policy π:

Q π ( s t , a t ) = E [ U t ∣ S t = s t , A t = a t ] {Q_\pi }({s_t},{a_t}) = {\rm E}\left[ {{U_t}|{S_t} = {s_t},{A_t} = {a_t}} \right] Qπ(st,at)=E[Ut∣St=st,At=at]

Return Ut depends on actions At,At+1,At+2,…… and states St, st+1,St+2,…

Actions are random: P[A = a | S =s] = π(a | s)(Policy function.)

States are random: P[S’ = s’ |s = s,A = a]=p(s’ | s , a)(State transition.)

State-Value Function: