文章目录

- 1、sigmoid

- 2、Tanh

- 3、ReLU

- 4、Leaky ReLU

- 5、Softmax

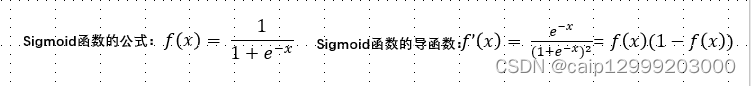

1、sigmoid

优点:将很大范围内的输入特征值压缩到0~1之间,适用于将预测概率作为输出的模型;

缺点:

1)当输入非常大或非常小的时候,容易导致梯度消失问题

2)输出不是0均值,进而导致后一层神经元将得到上一层输出的非0均值的信号作为输入。随着网络的加深,会改变原始数据的分布趋势,一般是放在最后的输出层中使用。

2、Tanh

优点:解决了上述的Sigmoid函数输出不是0均值的问题;

缺点:仍然存在梯度消失问题

3、ReLU

优点:

1)解决了梯度消失问题

2)计算和收敛速度都很快,因为只需要判断是否大于0

缺点:

1)与sigmoid一样,不是0均值的

2)ReLU在小于0的时候梯度为零,这样会导致神经元不能更新参数,即神经元死亡问题

4、Leaky ReLU

优点:Leaky Relu函数在输入为负值时,给予输入值一个很小的斜率,缓解了Dead Relu问题;

缺点:理论上来说,该函数具有比Relu函数更好的效果,但是大量的实践证明,其效果不稳定,故实际中该函数的应用并不多。

5、Softmax

特点:预测结果概率之和等于1,也会存在神经元死亡问题

与sigmoid的比较:

softmax:1)用于单标签的多分类问题,即从多个分类中选取一个正确答案。 Softmax 综合了所有输出值的归一化,因此得到的是不同概率之间的相互关联 。2)各类别概率之和为1 ,也就是说我们加大某一类别的概率必然导致其他类别减小——各类别之间相互关联,是互斥的。

sigmoid:1)用于多标签的多分类问题,可以选取多个标签作为正确答案,它是将任意实数值归一化映射到[0-1]之间,2)各类别概率之和则不一定为1 ,各个输出值依次独立的经过激活函数的映射,某一个类别概率增大可能也伴随另一个类别概率增大——各类别之间相互独立,不互斥。

参考链接:

https://blog.csdn.net/caip12999203000/article/details/127067360