按时间顺序,综述近5年的融合算法。重点分析了最近两年的work,欢迎留言探讨

文章目录

- 前言

- 1.SSR-Laplacian Image Fusion(2017)

- 2、FusionGAN(2019)

- 3、MBNet(2020)

- 4、DIDFuse(2020)

- 5、DDcGAN(2020)

- 6、GAN(2020)

- 7、NestFuse(2020)

- 8、AUFusion(2021)

- 9、AttentionFGAN

- 10、GANMcC

- 11、

- 12、

- 13、

- 14、PIAFusion(2022)

- 15、SeAFusion(2022)

- 16、SwinFusion(2022)

- 17、DIVFusion(2023)

- 18、CDDFuse(CVPR2023)

- 19、

- 总结

前言

提示:以下是本篇文章正文内容,下面案例可供参考

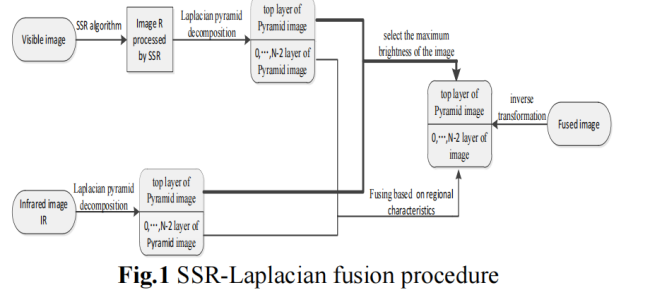

1.SSR-Laplacian Image Fusion(2017)

论文:R. Wu, D. Yu, J. Liu, H. Wu, W. Chen and Q. Gu, “An improved fusion method for infrared and low-light level visible image,” 2017 14th International Computer Conference on Wavelet Active Media Technology and Information Processing (ICCWAMTIP), 2017, pp. 147-151.

本文提出了一种融合低照度可见光图像和红外图像的方法。本文主要是增加了图像的预处理步骤,后续过程是一些传统处理方法的组合和延伸。SSR(Single Scale Retinex)算法,一种基于Retinex的人眼生理特征所发展起来的算法,用于提升可见光图像的对比度。

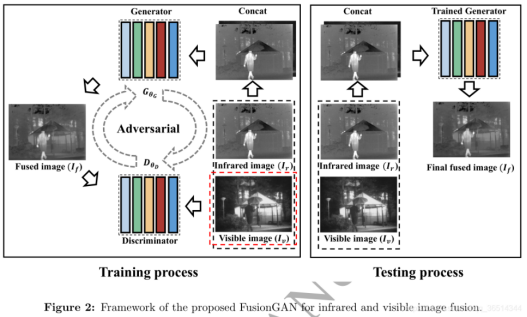

2、FusionGAN(2019)

论文:Jiayi Ma, Wei Yu, Pengwei Liang, Chang Li, and Junjun Jiang. FusionGAN: A generative adversarial network for infrared and visible image fusion. Information Fusion 48, C (Aug 2019), 11–26, 2019.

本文提出FusionGAN,将GAN运用到图像融合的任务中。红外图像Ir和可见光图像Iv按通道连接后输入生成器,输出为融合图像If。考虑可见图像中的纹理细节没有被充分提取,将融合后的图像If和可见图像Iv输入鉴别器中,使得If有更多的纹理细节。生成器旨在生成具有显著红外强度和附加可见梯度的融合图像,鉴别器旨在强制融合图像拥有可见图像的更多细节信息。

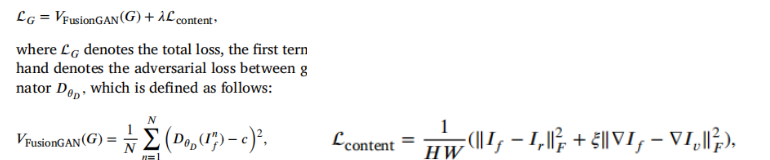

损失函数

生成器:

判别器:

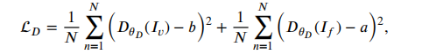

3、MBNet(2020)

Zhou, Kailai et al. “Improving Multispectral Pedestrian Detection by Addressing Modality Imbalance Problems.” European Conference on Computer Vision (2020).

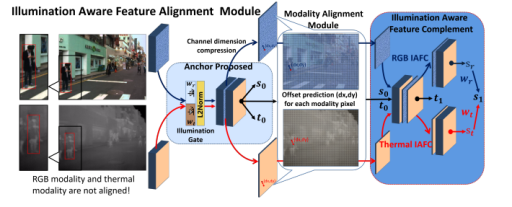

模态不平衡问题主要分为两方面:照明模态不平衡(光照变化)以及特征模态不平衡(红外与可见特征未配准,以及不恰当的融合方式)。本文设计了差分模态感知融合(DMAF,Differential Modality Aware Fusion)模块,使两种模态相互补充。照明感知特征对齐(IAFA,Illumination Aware Feature Alignment Module)模块根据光照条件选择互补特征,并自适应对齐两个模态特征。

DMAF模块中每个模态都包含共同部分和差异部分。

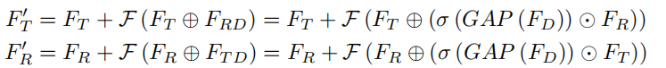

先对两个模态特征直接相减获取差异特征,然后对差异特征做全局平均池化,再进行tanh激活,然后对原始特征进行通道级加权,加权后的特征加到另一模态特征上。

IAFA模块用了一个可以根据可见光图像预测光照条件的小网络,其损失定义如下:

由于红外和可见光相机并不都是同时拍摄的,这就会导致特征无法对齐。故提出了一个模态特征对齐(MA,Modality Alignment)模块来为每种模态的每个像素点(x, y)都预测一个特征偏移(dx, dy),由于特征偏移为浮点数,故采用了双线性插值用邻近点的值进行拟合(x+dx, y+dy)。

IAFA模块先将重赋权的RGB和红外特征拼接,在anchor proposed阶段产生一个大概的anchor位置。在IAFC阶段所预测的回归偏移t0用来产生可变形的anchor来作为位置预测的基本参考。然后可变形的anchors和置信度得分s0进一步通过IAFC阶段进行微调。RGB和红外特征图预测的置信度得分进一步通过光照值进行重新加权。最终的置信度得分和回归偏移值如下:

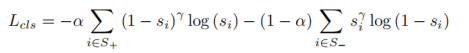

分类损失函数使用了focal loss,来解决样本不平衡问题。

4、DIDFuse(2020)

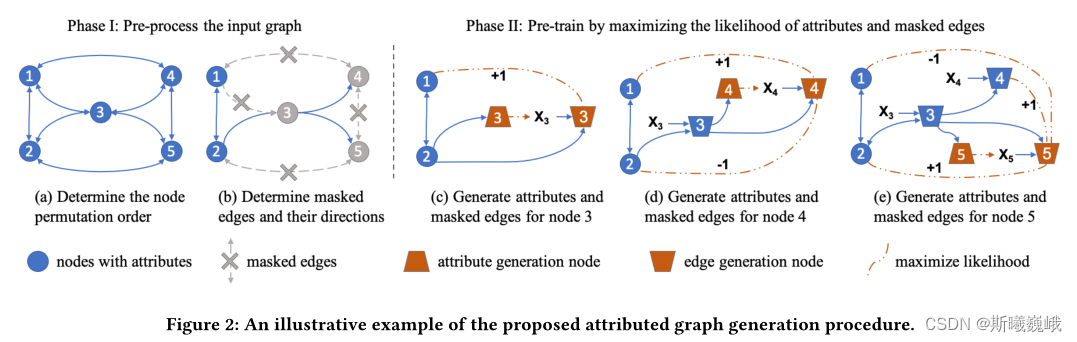

Zixiang Zhao, Shuang Xu, Chunxia Zhang, Junmin Liu, Jiangshe Zhang and Pengfei Li, DIDFuse: Deep Image Decomposition for Infrared and Visible Image Fusion. IJCAI 2020: 970-976.

本模型有效的利用了先验信息,即base信息代表着大尺度的背景信息, detail信息是互异性较明显的信息,即红外和可见的base信息尽可能接近,两者的detail信息尽可能差异较大。经过训练,模型获得了训练好的encoder和decoder,然后进入测试阶段。在测试过程中,添加一个fusion layer,即融合层,实现和的融合,和的融合,然后把其进行拼接,输入decoder实现图像重构。对于融合策略的选择有以下三种策略:直接相加、给定权重相加和L1-norm(把feature map的L1范数看作其activity measurement,然后通过计算不同feature map的L1-norm来给定不同融合权重)。

损失函数

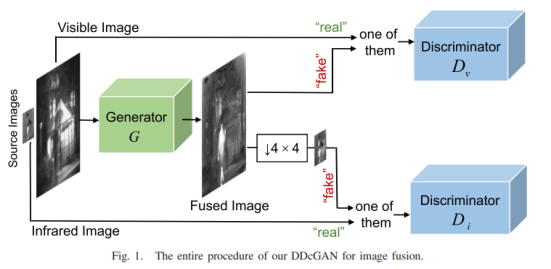

5、DDcGAN(2020)

J. Ma, H. Xu, J. Jiang, X. Mei and X. -P. Zhang, “DDcGAN: A Dual-Discriminator Conditional Generative Adversarial Network for Multi-Resolution Image Fusion,” in IEEE Transactions on Image Processing, vol. 29, pp. 4980-4995, 2020.

本文在FusionGAN的基础上设计了双判别器。为了融合不同分辨率的图像,作者假设可见图像的分辨率是红外图像分辨率的4×4倍,判别器Dv旨在将生成的图像与可见图像区分开,而判别器Di旨在区分原始的低分辨率红外图像和下采样(平均池化)的融合图像。为了在生成器和判别器之间保持平衡,每个判别器的输入层是包含样本数据的单通道,而不是同时包含样本数据和对应的源图像作为条件信息的两通道。

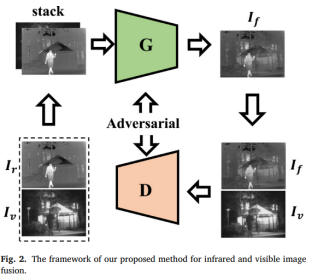

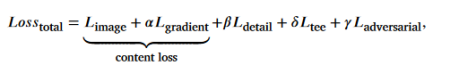

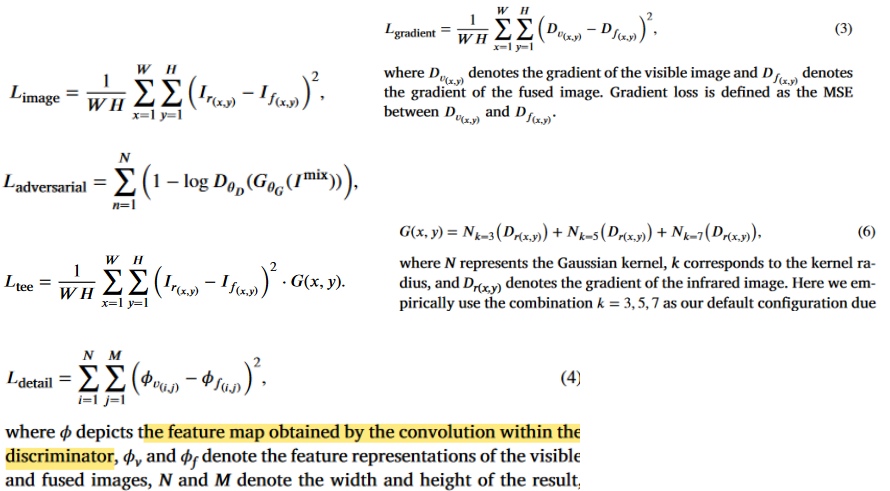

6、GAN(2020)

J. Ma et al.,“Infrared and visible image fusion via detail preserving adversarial learning,” Information Fusion, vol. 54, pp. 85–98, Feb. 2020.

本文的模型用于改善先前GAN模型带来的细节损失问题,并且加入了针对边缘的保护机制。模型的生成器产生融合图像,然后,融合结果与可见光源图像一起送入判别器,判断融合结果是否来自于可见光图像。

损失函数:

7、NestFuse(2020)

H. Li, X. -J. Wu and T. Durrani, “NestFuse: An Infrared and Visible Image Fusion Architecture Based on Nest Connection and Spatial/Channel Attention Models,” in IEEE Transactions on Instrumentation and Measurement, vol. 69, no. 12, pp. 9645-9656, Dec. 2020.

本文是基于nest connection和空间/通道注意力的红外-可见光融合模型,可以在多尺度方面保留重要信息。模型分为编码器、融合策略和解码器三部分。在融合策略中,空间注意力模型和通道注意力模型分别用来描述深度特征在每个空间位置和通道的重要性。首先输入图像送入编码器提取多尺度特征,融合策略在每个尺度上融合这些特征,最后通过基于nest connection的解码器重构图像。

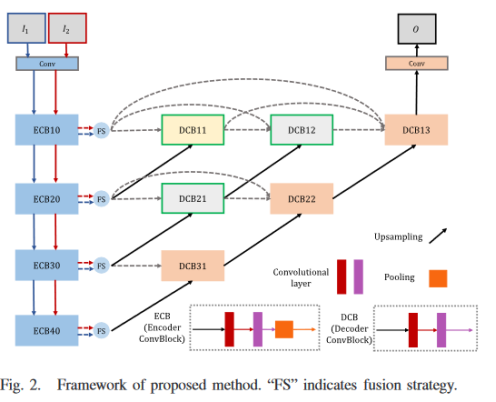

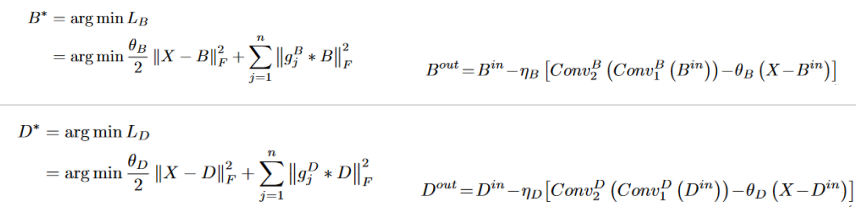

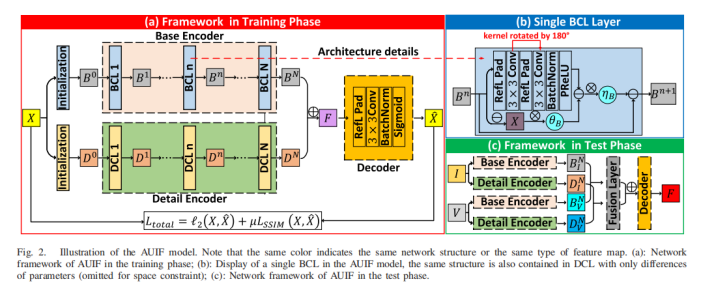

8、AUFusion(2021)

Zixiang Zhao, Shuang Xu, Jiangshe Zhang, Chengyang Liang, Chunxia Zhang and Junmin Liu, “Efficient and Model-Based Infrared and Visible Image Fusion via Algorithm Unrolling,” in IEEE Transactions on Circuits and Systems for Video Technology,2021.

本文利用算法展开的方式构建网络,增加了网络的可解释性。首先预训练一个自编码器用来实现特征提取和图像重建。再采用一些手工设计的融合策略(基于像素的加权平均)来整合从不同源图像中提取的深度特征以实现图像融合。训练时,红外与可见光交替输入网络;测试时,红外与可见成对输入。网络中特征B0和D0分别通过blur和Laplacian滤波器得到。

BCL和DCL模块设计,X表示输入图像,B,D分别表示base feature和detail feature,另外

gBj 表示高通滤波,gDj 表示低通滤波。

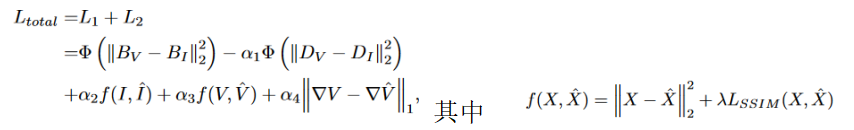

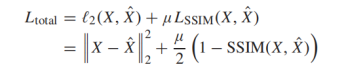

损失函数:

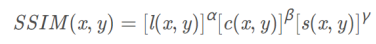

SSIM 衡量两张图片的相似性,该损失使重建图像在亮度、结构和对比度方面接近源图像。

9、AttentionFGAN

J. Li, H. Huo, C. Li, R. Wang and Q. Feng, “AttentionFGAN: Infrared and Visible Image Fusion Using Attention-Based Generative Adversarial Networks,” in IEEE Transactions on Multimedia, vol. 23, pp. 1383-1396, 2021.

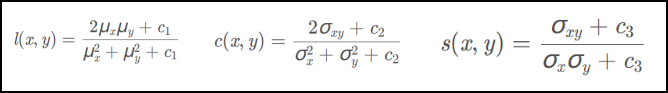

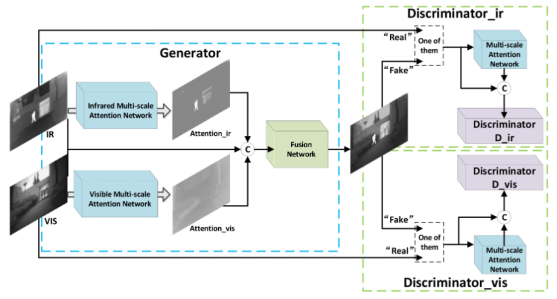

本文将多尺度注意力机制加入GAN来进行红外-可见光图像的融合。多尺度注意力机制旨在捕获全面的空间信息,帮助生成器关注红外图像的前景目标信息和可见光图像的背景细节信息,同时约束判别器更多地关注注意区域而不是整个输入图像。生成器部分是两个多尺度注意力模块首先分别获得红外与可见光图像的注意力图,然后将这两个注意力图和源图像在通道维度拼接后送入融合网络。两个判别器分别用来区分融合图像与红外/可见光图像,结构完全相同,但是参数不共享。

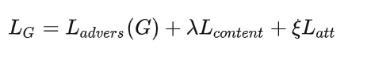

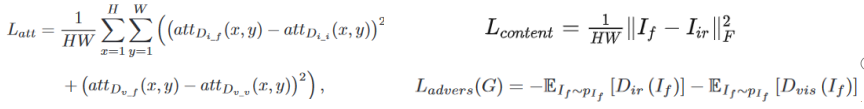

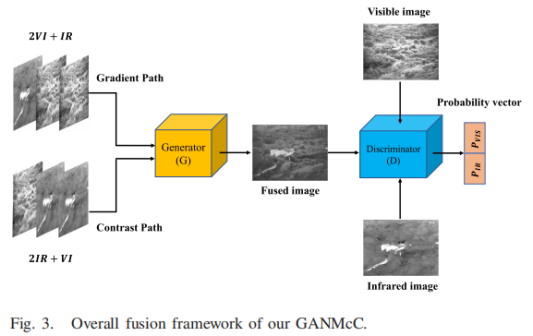

损失函数

生成器:

判别器:前两项表示 Wasserstein distance 估计,最后一项是网络正则化的梯度惩罚

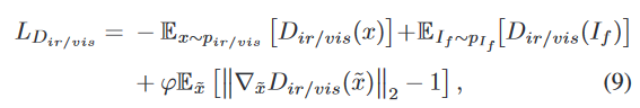

10、GANMcC

J. Ma, H. Zhang, Z. Shao, P. Liang and H. Xu, “GANMcC: A Generative Adversarial Network With Multiclassification Constraints for Infrared and Visible Image Fusion,” in IEEE Transactions on Instrumentation and Measurement, vol. 70, pp. 1-14, 2021.

红外图像的细节信息不一定比可见光差,Rgb图像也有可能对比度优于红外图像。融合图像既有显著的对比度又有丰富的纹理细节,关键是保证源图像的对比度和梯度信息是平衡的,本质上是同时估计两个不同域的分布。GAN可以在无监督情况下更好地估计目标的概率分布,而多分类GAN 可以进一步同时拟合多个分布特征,解决这种不平衡的信息融合。当可见图像过度曝光时,红外图像的相应信息可以弥补,这使得我们的方法能够在保持显著对比度的同时去除高光。

网络架构

对于生成器,输入也是两个模态的混合输入,由生成器得到融合图像。对于判别器,输入图像(红外/可见光/融合图像任选一个输入)进行分类得到输入图像的类别,输出是一个包含两个概率值的向量。对于融合图像,在多分类约束下,generator期望这两个概率都很高,即判别器认为它既是红外图像又是可见图像,而判别器期望这两个概率同时很小 ,即判别器判断融合图像既不是红外图像也不是可见图像。在此过程中,同时约束这两个概率,以确保融合图像在两个类别中的true/false程度相同。经过不断的对抗学习,生成器可以同时拟合红外图像和可见图像的概率分布,从而产生对比度显着和纹理细节丰富的结果。

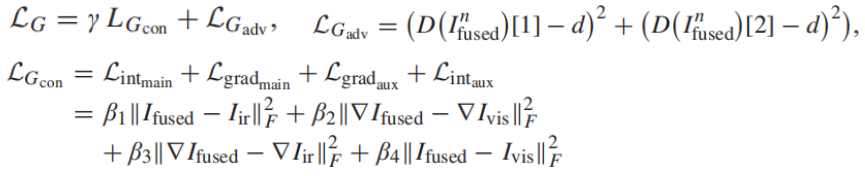

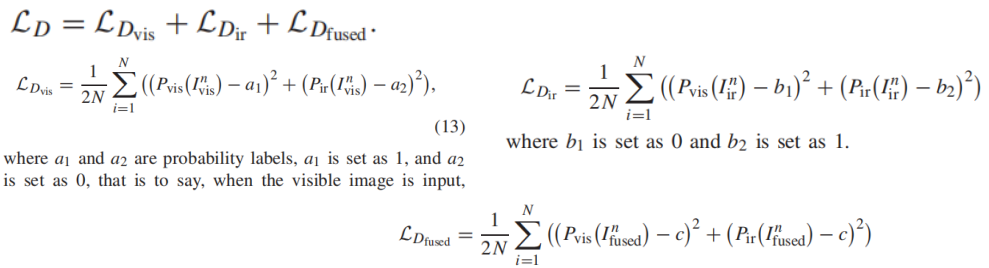

损失函数

生成器:通过调整权重β的大小来决定每种信息的保留程度,d设置为1。

判别器:c设置为0。

11、

12、

13、

14、PIAFusion(2022)

Linfeng Tang, Jiteng Yuan, Hao Zhang, Xingyu Jiang, and Jiayi Ma. “PIAFusion: A progressive infrared and visible image fusion network based on illumination aware”, Information Fusion, 83-84, pp. 79-92, 2022

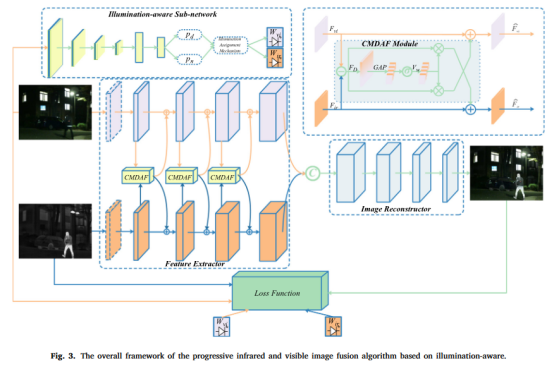

考虑到照明不平衡问题以及融合图像特征不充分的问题,本文提出了一种基于光照感知的渐进式图像融合网络( PIAFusion ),自适应地保持显著目标的强度分布并保留背景中的纹理信息。具体来说,本文设计了一个光照感知子网络来估计光照分布并计算光照概率。此外,利用光照概率构造光照感知损失来指导融合网络的训练,利用跨模态差分感知融合模块来融合红外和可见特征共同信息和互补信息。另外,本文发布了一个用于红外与可见图像融合的大型基准数据集(MSRS,Multi-Spectral Road Scenarios)。

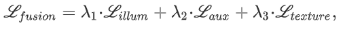

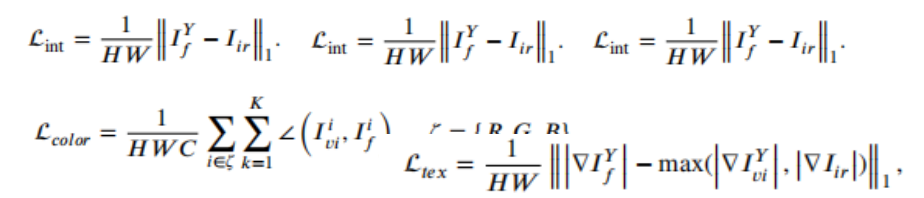

光照感知子网络使用交叉熵损失函数,主干网络损失函数为

15、SeAFusion(2022)

Tang, Linfeng, Jiteng Yuan, and Jiayi Ma. “Image fusion in the loop of high-level vision tasks: A semantic-aware real-time infrared and visible image fusion network.” Information Fusion 82 (2022): 28-42.

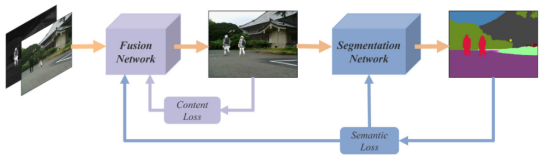

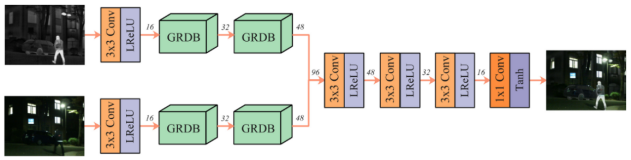

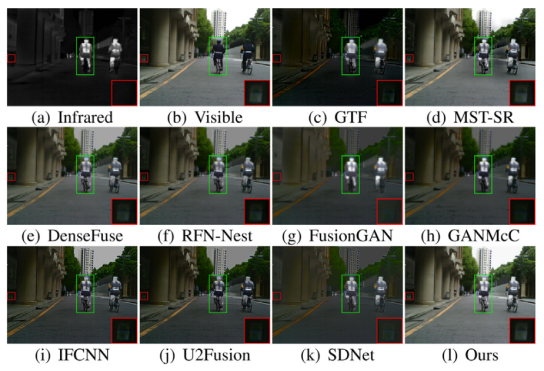

论文提出了一个语义感知的图像融合框架,利用高级视觉任务来驱动图像融合。同时考虑到对实时性的要求,在网络设计方面设计了一个轻量级的网络。而且为了增强网络对细粒度细节特征的描述,设计了一个Gradient Residual Dense Block(GRDB)。最后,考虑到现有的评估指标仅利用EN,MI,SF等统计指标来衡量图像融合的好坏。作者还提出了一种任务驱动的评估方式,即利用融合结果在高级视觉任务上的表现来衡量融合结果的质量。

源图像经过融合网络生成融合图像,而融合网络图像在经过一个分割网络得到分割结果。分割结果与labels构造语义损失,融合图像与源图像之前构造内容损失,其中语义损失只用于约束分割网络,而内容损失与语义损失共同约束融合网络的优化。这样语义损失能够将高级视觉任务(分割)所需的语义信息反传回融合网络从而促使融合网络能够有效地保留源图像中的语义信息.

对于融合网络,SeAFusion采用的是双分支特征提取再Concat融合后重建图像的框架,而在GRDB中利用梯度算子提取的特征作为残差连接能够强化网络对于细节特征的提取。

由于图像融合没有groundtruth,无法利用融合结果预训练一个分割模型来指导融合网络的训练,为此作者通过交替训练融合网络以及分割网络,从而维持图像融合以及语义分割之间的平衡,能在保证高级视觉任务性能的同时不降低融合网络的性能。

结果比较:

16、SwinFusion(2022)

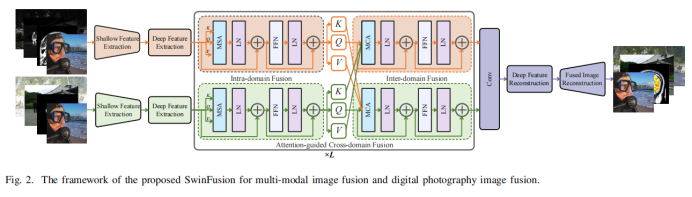

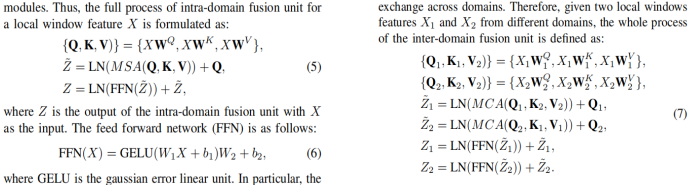

J. Ma, L. Tang, F. Fan, J. Huang, X. Mei and Y. Ma, “SwinFusion: Cross-domain Long-range Learning for General Image Fusion via Swin Transformer,” in IEEE/CAA Journal of Automatica Sinica, vol. 9, no. 7, pp. 1200-1217, July 2022.

一方面,本文设计了一个注意力引导的跨域模块,以实现互补信息和全局交互的充分集成。该方法包括一个基于自注意的域内融合单元和一个基于交叉注意的域间融合单元,它在同一域内和跨域内挖掘和整合长依赖关系。通过远程依赖建模,网络能够充分实现特定领域的信息提取和跨领域互补信息集成,并从全局角度保持适当的表观强度。在自注意和交叉注意中引入了shifted window机制,这允许模型接收任意大小的图像。另一方面,将多模态图像融合和数码摄影图像融合都推广到结构、纹理和强度保持的设计中。定义了一个统一的损失函数形式来约束所有的图像融合问题。SwinFusion模型在多模态图像融合与数码摄影图像融合任务中均表现良好。

SwinFusion模型可分为特征提取、注意引导的跨域融合和重建三个部分。

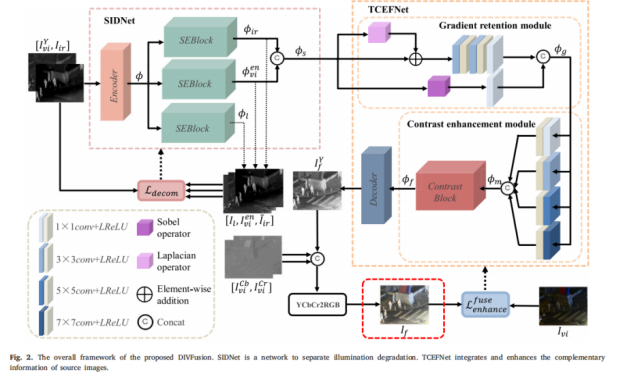

17、DIVFusion(2023)

Linfeng Tang, Xinyu Xiang, Hao Zhang, Meiqi Gong, and Jiayi Ma. “DIVFusion: Darkness-free infrared and visible image fusion”, Information Fusion, 91, pp. 477-493, 2023

(1)论文创新点:

目前的图像融合方法都是针对正常照明下的红外和可见光图像设计的。在夜景中,现有的方法由于可见光图像严重退化,导致纹理细节较弱,视觉感知较差,影响了后续的视觉应用。如果将图像增强和图像融合作为独立的任务处理往往会导致不兼容问题,从而导致图像融合效果不佳。本文将低光图像增强技术和图像融合技术相结合,合理地照亮黑暗,促进互补信息聚合,得到良好的视觉感知的融合图像。

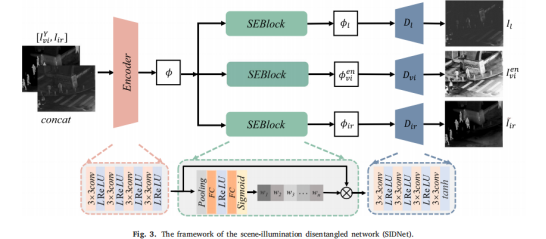

(2)总体架构:

首先设计了一个场景光照解耦网络( SIDNet,scene illumination disentangled network)来去除夜间可见光图像中的光照退化,同时保留源图像的信息特征。为了融合互补信息,增强融合特征的对比度和纹理细节,设计了纹理-对比度增强融合网络( TCEFNet,texture-contrast enhancement fusion network)。所提方法能够以端到端的方式生成具有真实颜色和显著对比度的融合图像。

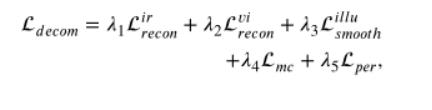

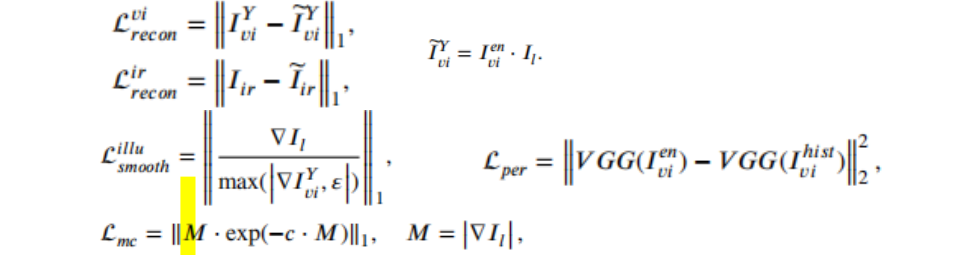

(3)损失函数

主要分为两阶段训练

一阶段:SIDNet用于自监督重构原始图像,由编码器、注意力块和解码器组成。解码器只是训练的时候迫使SIDNet可以生成更好的特征,所以当使用模型融合图像时,不需要生成重建的图像。剥离退化的照明特征,将和作为下一阶段的输入。

其中,Lper 是将使用直方图均衡增强后的图像作为对比,从而使得可以生成增强的可见光图像。

二阶段:固定SIDNet,训练TCEFNet。

除了强度损失,纹理损失之外,还设计了颜色一致性损失来减轻增强和融合带来的颜色失真。

18、CDDFuse(CVPR2023)

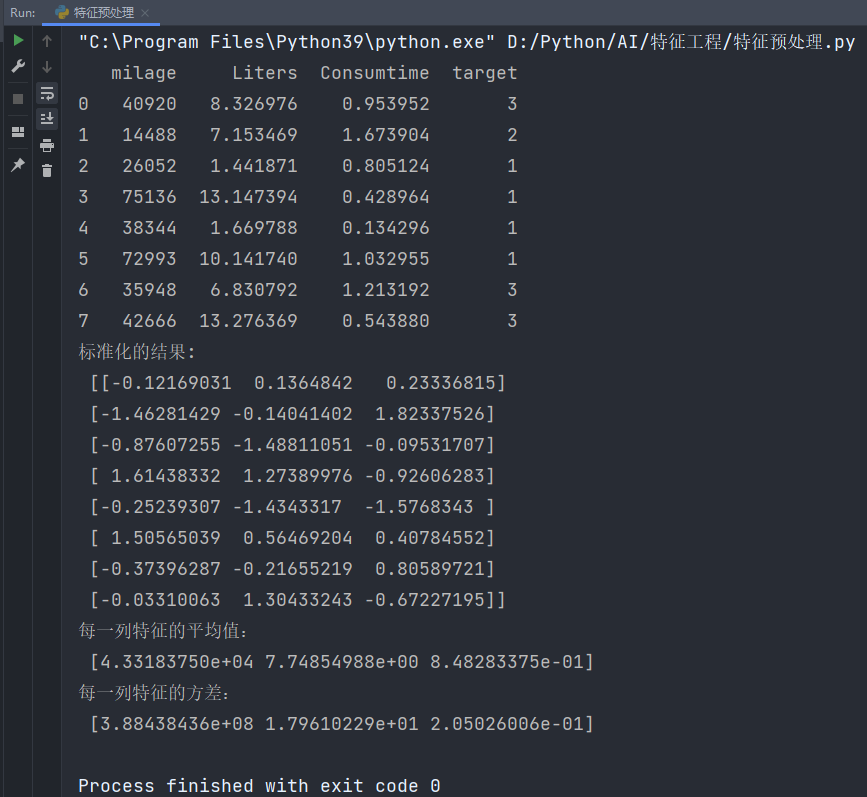

Correlation-Driven Dual-Branch Feature Decomposition for Multi-Modality Image Fusion

多模态图像融合中的相关驱动的双分支特征分解

19、

总结

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。