系列文章链接

论文一:2020 Informer:长时序数据预测

论文二:2021 Autoformer:长序列数据预测

论文三:2022 FEDformer:长序列数据预测

论文四:2022 Non-Stationary Transformers:非平稳性时序预测

论文五:2022 Pyraformer:基于金字塔图结构的时序预测

论文六:2023 Crossformer:多变量时序预测

论文七:2023 LTSF-Linear:质疑transformer能力的线性预测模型

论文链接:https://arxiv.org/abs/2205.13504

github链接:https://github.com/cure-lab/LTSF-Linear

参考解读:https://zhuanlan.zhihu.com/p/569194246

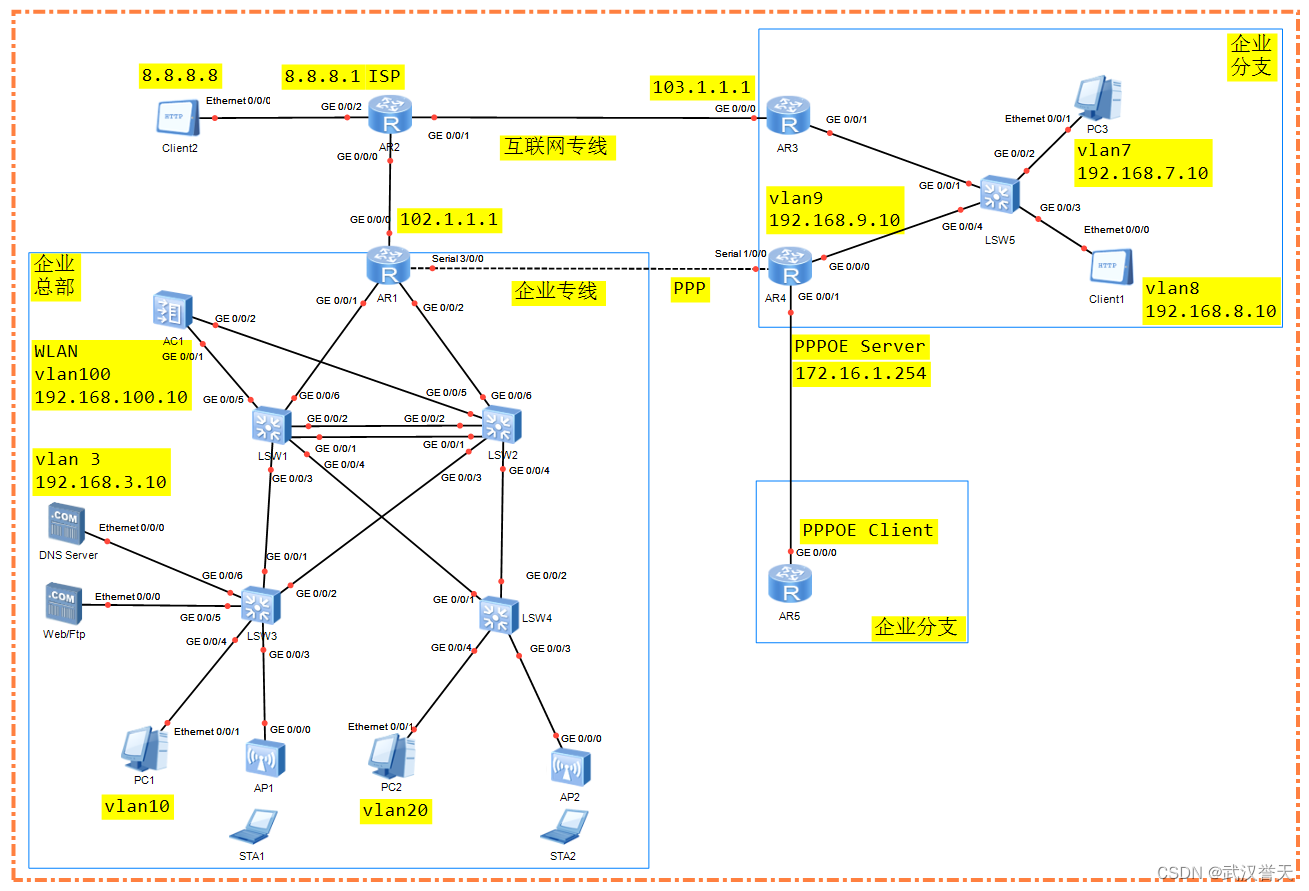

本文是香港中文大学的团队发表的一篇文章,本文主要是针对基于transformer的算法的一种思考,是否transformer在时序任务处理真的能够起到很好的作用?作者认为虽然transformer能够捕捉时序数据间的位置信息,但是能够拿到的信息十分有限,不一定能够充分的表达原始时序特性;而且随着选取的历史窗口长度的增加,误差可能会更大。作者认为这种不完全严格的时序信息对于自然语言处理而言没有那么大的影响,因为稍微打乱顺序对语义的影响没那么大,但是对于时序数据而言,顺序信息起到很关键的作用,所以对基于transformer的方法提出了质疑;

基于此背景,本文作者提出了一个简单的线性结构用于挑战基于transformer的方法,几乎否定了很多transformer结构的有效性;本文提出了两种简单的模型设计去验证他这一猜想:

- D-Linear:该结构的设计是基于Autoformer和FEDformer的时间序列分解思想,采用移动均值将时序数据分解成趋势序列和季节性序列,然后通过简单的线性层进行两种预测结果的的获取,并将两种结果相加以得到最终的预测结果;

- N-Linear:在上述基础上,在预测层之前会把预测值之前的序列拼接到全连接层的输入上,作为预测的前置参考数据;

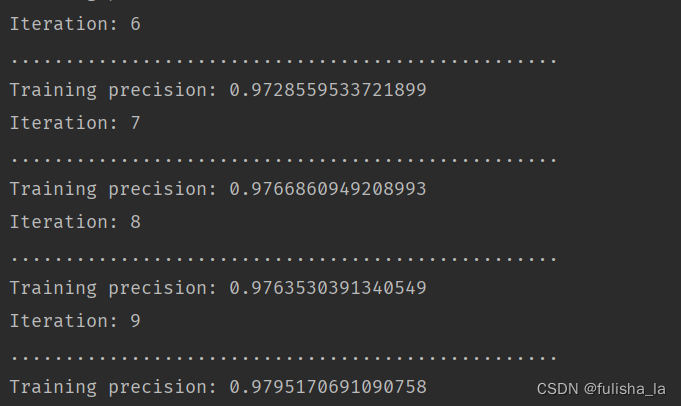

作者的实验表明,前人的很多研究不但没有优化时间复杂度,反而有的效果要差于原始transformer,让大家正视transformer在时序预测领域的作用。

个人理解:对于简单的平稳的时序数据而言,采用transformer肯定是杀鸡用牛刀,容易过拟合且耗时肯定比线性的要多,但是对于复杂的趋势、季节性、非平稳性数据而言,简单的线性模型应该是学习不到更深入的关系的;对于时序order的问题,相邻时间范围内的数据波动范围相似,所以不一定非要完全学习时序关系,而且transfomer会对关联性较大的部分计算出更大的权重,能够更好地自动提取关注区间,简单的线性肯定不能实现这种复杂依赖关系的提取;提出质疑是敢于思考和挑战,但是理性看待;