首先ETL是什么?

ETL代表“Extract, Transform, Load”,是一种用于数据集成和转换的过程。它在数据管理和分析中扮演着重要的角色。下面我们将分解每个步骤:

Extract(抽取): 这一步骤涉及从多个不同的数据源中提取数据,这些源可以是数据库、文件、API、日志文件等等。数据通常以原始的、未经处理的形式抽取出来。

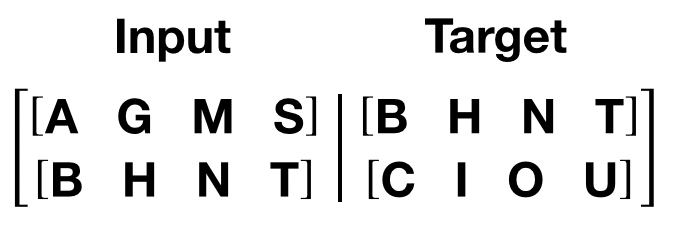

Transform(转换): 在这一阶段,数据被清洗、转换和重新格式化,以使其适合目标数据仓库的结构和需求。这可能包括数据清理、重命名列、数据类型转换、去重、合并数据等操作。

Load(加载): 在此步骤中,经过转换后的数据被加载到目标数据仓库中。这可以是关系型数据库、数据湖、数据仓库或其他存储位置。加载过程应该经过有效的优化,以确保数据的一致性和可查询性。

如何通过ETL采集数据到数仓中?

企业要做数据仓库系统,ETL是最关键的一环,ETL就是把企业的各种数据运到数据仓库中来。

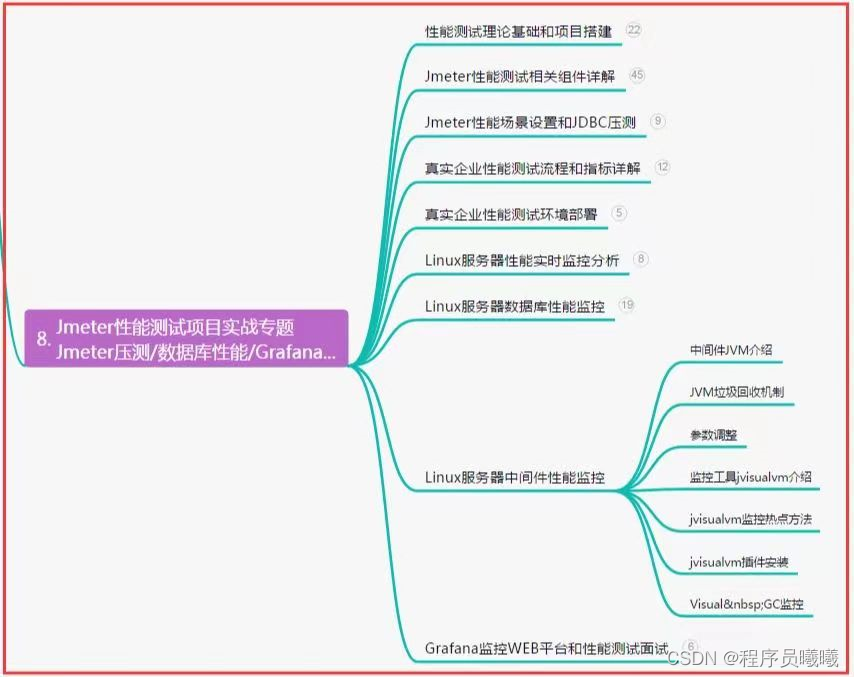

常用ETL工具对比

ETL经常用到的工具有Informatica、Datastage、DataX、Kettle,下面是一个工具的对比。

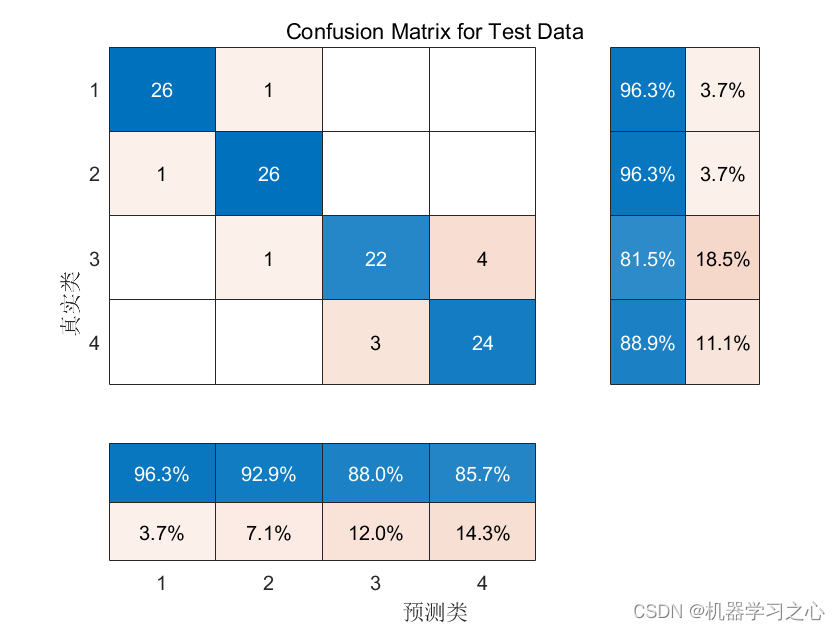

通过上面的对比图可以看到ETLCloud产品优势非常明显,下面我们来一起探索ETLCloud工具的魅力。

ETLCloud数据集成平台安装部署及入门

ETLCloud是一款零代码ETL工具,可以快速对接上百种数据源和应用系统,无需编码即可快速完成数据同步和传输,企业IT人员只需简单几步即可快速完成各种数据抽取同步并配合BI工具实现数据的统计分析。

安装部署:

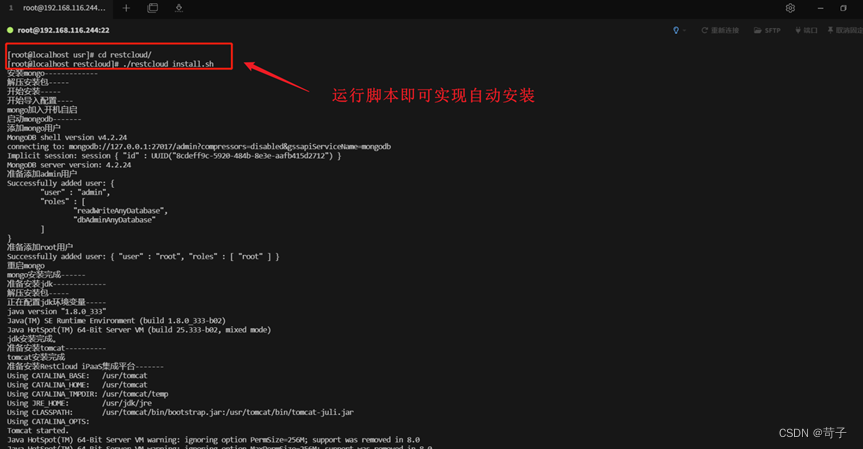

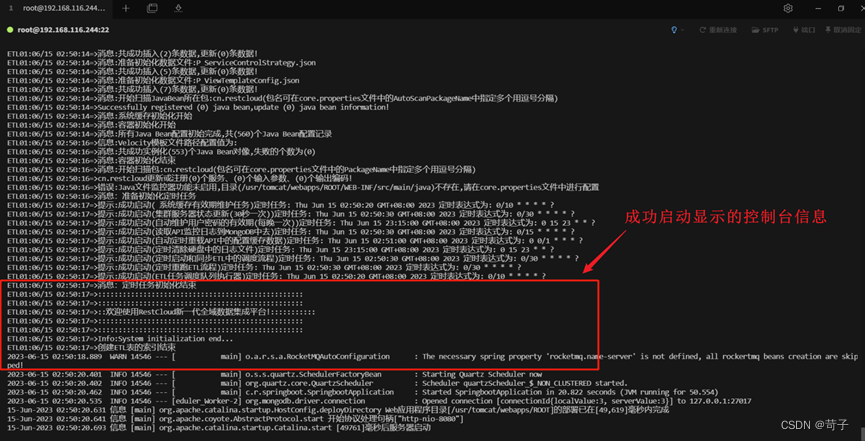

ETLCloud官网提供了linux一键部署包,只需要运行安装包部署脚本即可分钟内完成产品的部署安装。

产品功能:

Web方式访问平台首页,产品功能模块描述清晰简单易用。

数据源管理:

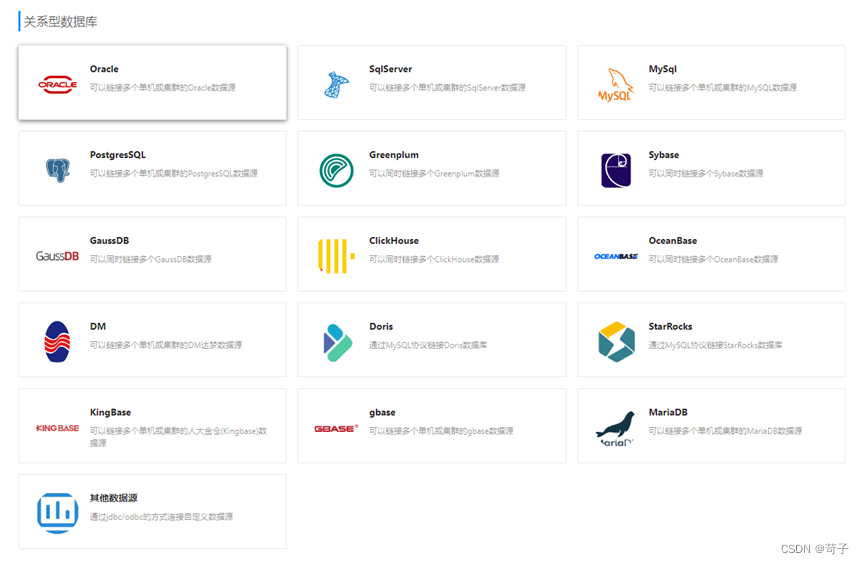

超过40种以上数据库支持,解决企业内部存在多种数据源时对接难度。

离线数据同步:

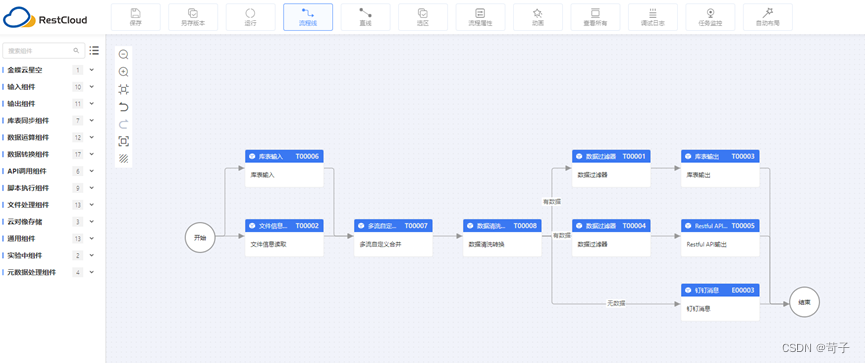

流程设计面板清晰简洁,组件内容丰富,通过不同组件的组合使用,解决当前企业中面临的数据同步过程中的问题。

(ETL流程运行后的效果如上图)

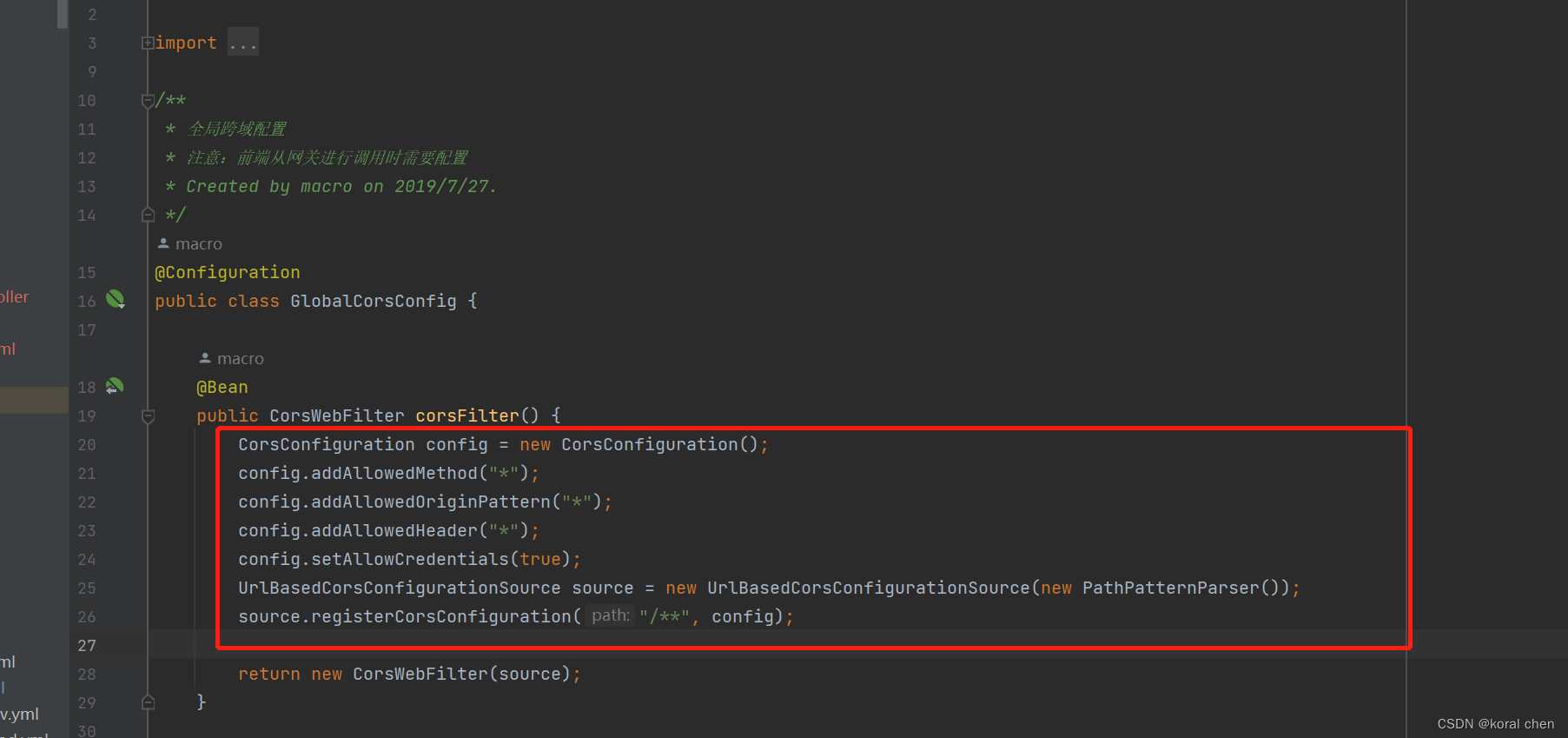

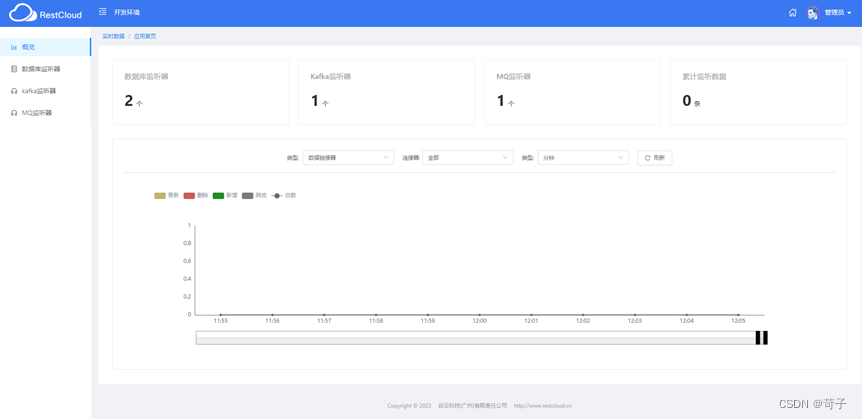

CDC实时数据同步:

通过开启数据库的日志,实现实时数据的监听传输,整个步骤只需要通过简单的配置即可快速完成。另外还支持kafka、各种MQ消息的监听以及推送。

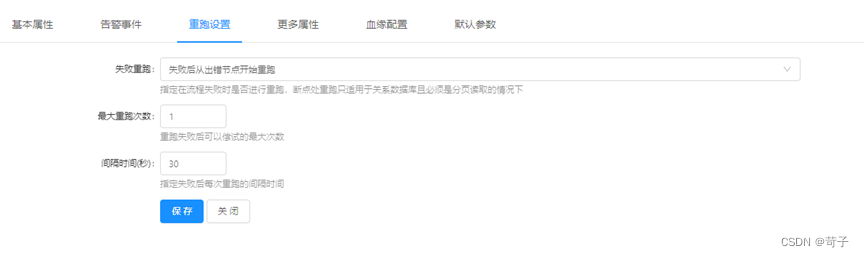

断点续传:

断点续传可以提高传输效率、保证传输可靠性,同时提供更好的用户体验,特别是在网络不稳定或传输大文件时,具有重要的作用,通过ETLCloud界面中可视化配置即可快速实现断点续传能力。

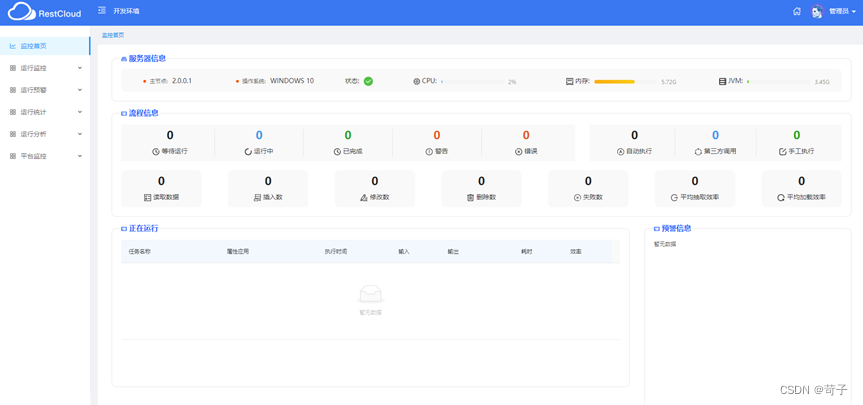

监控预警:

平台本身拥有完善的监控预警体系,通过监控中心快速查到定位出异常流程数据。

在线学习及帮助文档:

ETLCloud官网提供全面的学习视频、帮助文档以及场景示例帮助新人快速上手。

在线帮助文档