原创 | 文 BFT机器人

大语言模型是指基于深度学习技术的大规模预训练模型,它能够通过学习大量的文本数据来生成人类类似的语言表达,机器人可以通过对大量的语言数据进行学习,从中掌握人类的语言表达方式,进而能够更好地与人进行交流和理解。

通过学习举一反三的能力,机器人可以不仅仅是单纯地根据输入做出回应,还能够具备一定的推理和判断能力,从而更好地适应复杂的交流场景。

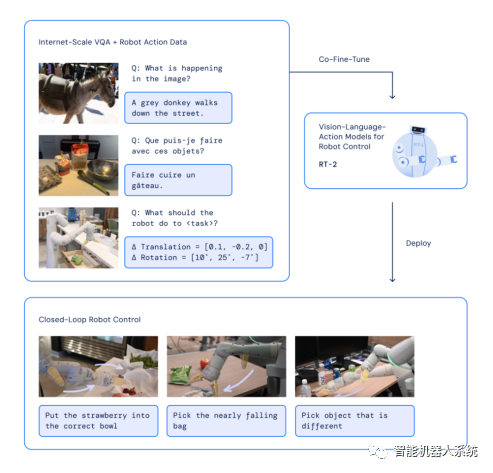

7月28日,谷歌DeepMind推出了一款新的机器人模型Robotics Transformer 2(RT-2),它是全球第一个控制机器人的视觉-语言-动作(VLA)模型,它可以使机器人能够直接通过拍摄或者感知环境的方式获取视觉信息,通过语言理解模块理解人类的语言指令,然后通过动作执行模块进行相应的动作操作。现在不再用复杂指令,机器人也能直接像ChatGPT 一样操纵了。

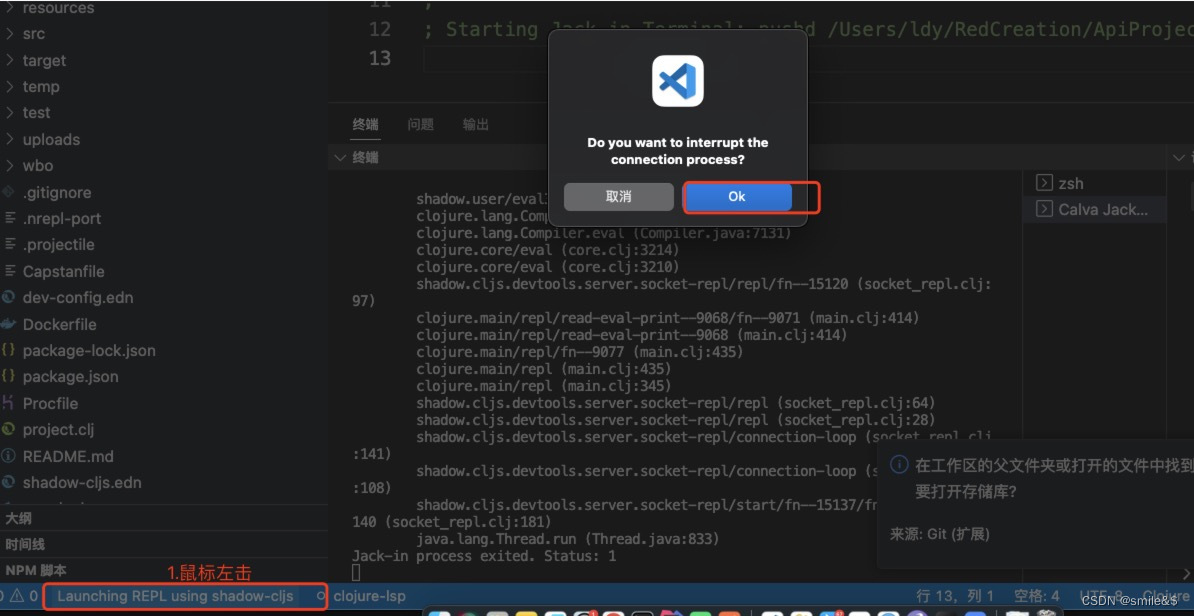

RT-2的架构和训练:对一个预训练的VLM模型在机器人和网络数据上进行共同微调

RT-2的突出之处在于,它可以通过对少量机器人训练数据的处理,不仅使单个模型能够执行基础模型中的复杂推理,还能够输出机器人动作。

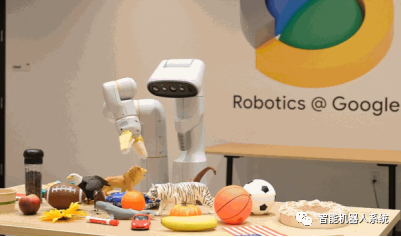

为了展现RT-2的能力,谷歌通过机械臂进行演示,在这次演示中,展示了其卓越的机器学习和人工智能技术,例如,对AI说“捡起已灭绝的动物”,机械臂会在一堆塑料玩具中精准的选择恐龙。

搭载RT-2的机器人能按人类指令行事

在此之前,机器人无法可靠地理解那些它们从未接触过的物品,也不能做到把“灭绝的动物”和“塑料恐龙玩具”联系在一起。

谷歌DeepMind机器人技术主管Vincent表示,以往让机器人丢垃圾必须经过专门的训练,让其理解垃圾的概念,并学会如何捡起和丢掉垃圾。然而,现在有了RT-2,它可以从网络数据中学习识别和处理垃圾的方法,这意味着我们不再需要针对不同场景逐一进行训练了。

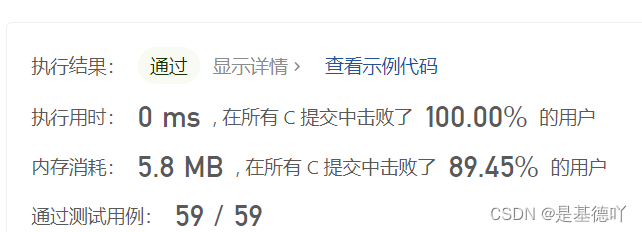

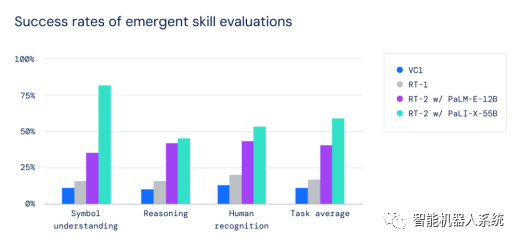

在所有类别中,与之前的基线相比(例如之前在大规模视觉数据集上预训练的RT-1模型和Visual Cortex(VC-1)等模型),RT-2的泛化性能提高到了3倍以上。RT-2在机器人数据中保持了对原始任务的性能,并提高了机器人在之前未曾见过的情景上的性能,从RT-1的32%提高到62%,显示了大规模预训练的显著好处。

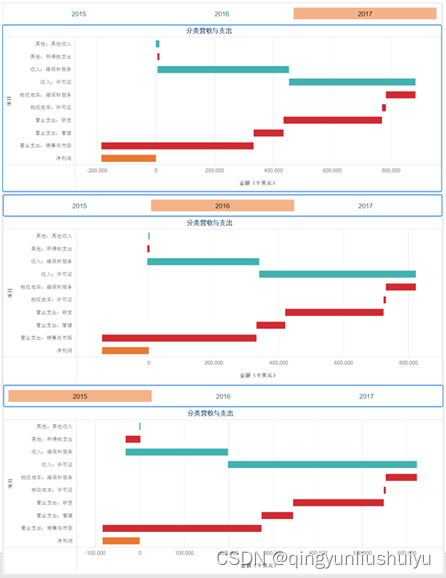

思维链推理可以学习一个独立的模型,既可以规划长期技能序列,又可以预测机器人的动作

真实的世界复杂且没有规律,机器人往往需要通过非常复杂的指令才能做到人类简单的事情,这个过程就像人类婴儿从无知无能逐渐成长为能够独立思考和行动的成年人一样,机器人也需要通过不断的学习和训练来提高自己的能力,而借助 RT-2 的强大功能,机器人可以自己分析更多信息,自行推断下一步该做什么。简而言之,RT-2 的能力在于将信息转化为行动,这显示了其快速适应新环境和情况的潜力。

随着技术的不断发展,RT-2将为我们带来更多的惊喜和改变,让我们期待着机器人技术在未来的发展中发挥更大的作用。

作者 | 音音

排版 | 居居手

更多精彩内容请关注公众号:BFT机器人

(公众号后台回复“优惠活动”查看BFT机器人年终钜惠福利内容)

本文为原创文章,版权归BFT机器人所有,如需转载请与我们联系。若您对该文章内容有任何疑问,请与我们联系,将及时回应。