时序预测 | MATLAB实现BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测

目录

- 时序预测 | MATLAB实现BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测

- 效果一览

- 基本介绍

- 模型搭建

- 程序设计

- 参考资料

效果一览

基本介绍

MATLAB实现BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测。基于贝叶斯(bayes)优化双向长短期记忆神经网络的时间序列预测,BO-BiLSTM/Bayes-BiLSTM时间序列预测模型。

1.优化参数为:学习率,隐含层节点,正则化参数。

2.评价指标包括:R2、MAE、MSE、RMSE和MAPE等。

3.运行环境matlab2018b及以上。

模型搭建

BO-BiLSTM(Bayesian Optimization-Bidirectional Long Short-Term Memory)是一种结合了贝叶斯优化和双向长短期记忆神经网络(BiLSTM)的时间序列预测方法。

时间序列预测是通过分析过去的数据来预测未来的趋势和模式。传统的方法通常基于统计模型或机器学习算法,但选择合适的模型和参数往往是一项挑战。这时,贝叶斯优化可以帮助我们在模型选择和参数调优方面进行更加有效的搜索。

贝叶斯优化是一种用于全局优化的方法,它通过在搜索空间中选择合适的参数进行迭代来找到最优解。它使用贝叶斯推断来建立一个代理模型,该模型估计了目标函数的潜在表达式,并根据观测结果进行更新。通过不断迭代,贝叶斯优化能够在有限的迭代次数内找到最优解。

双向长短期记忆神经网络(BiLSTM)是一种适用于处理序列数据的循环神经网络(RNN)的变体。与传统的LSTM相比,BiLSTM不仅考虑了过去的信息,还同时考虑了未来的信息。它通过在网络中引入反向传播路径来捕捉时间序列中的前后依赖关系,从而提高了预测的准确性。

BO-BiLSTM方法将贝叶斯优化和BiLSTM相结合,以改进时间序列预测的性能。它通过贝叶斯优化方法搜索最佳的BiLSTM模型架构和超参数配置,从而提高模型的泛化能力和预测准确性。BO-BiLSTM方法在每次迭代中使用贝叶斯优化选择新的参数配置,并使用这些配置训练BiLSTM模型。重复这个过程直到达到预定的迭代次数或达到停止条件。

总的来说,BO-BiLSTM方法是一种利用贝叶斯优化和双向长短期记忆神经网络的时间序列预测方法,它能够更好地解决时间序列预测中的模型选择和参数调优问题,并提高预测的准确性和鲁棒性。

- BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测

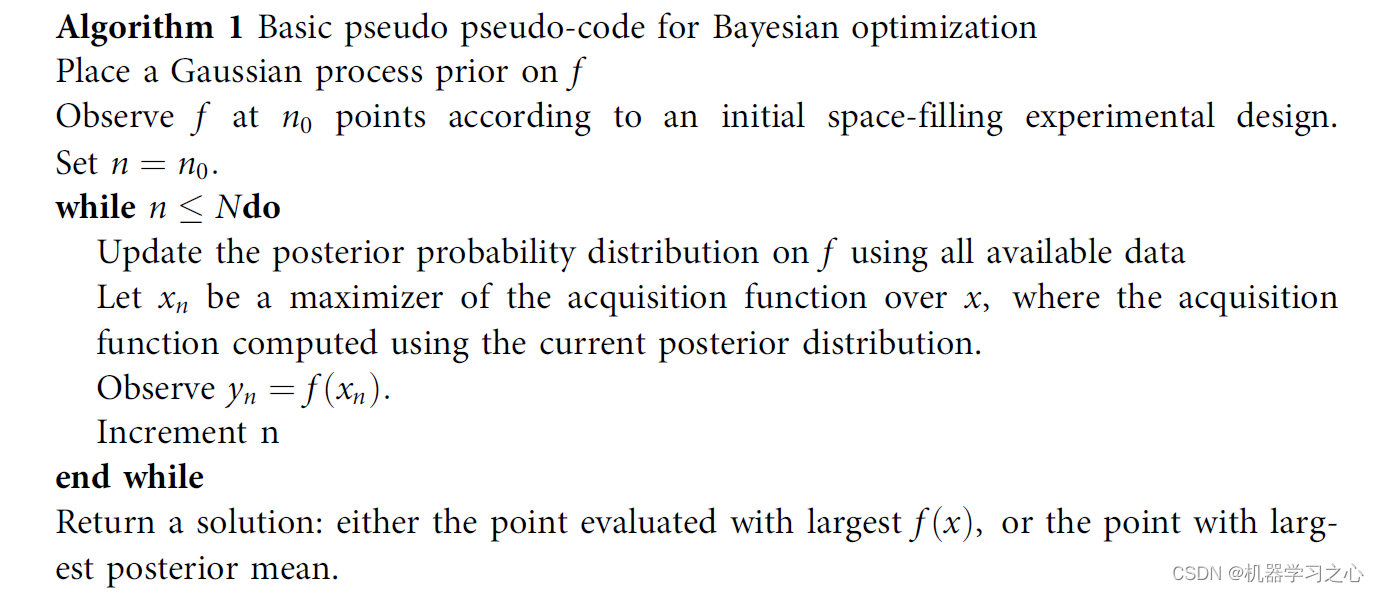

伪代码

- 通过调整优化算法调整模型参数,学习重复率和贝叶斯优化超参数来调整模型参数。

程序设计

- 完整程序和数据获取方式1:私信博主回复MATLAB实现BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测,同等价值程序兑换;

- 完整程序和数据下载方式2(资源处直接下载):MATLAB实现BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测;

- 完整程序和数据下载方式3(订阅《LSTM长短期记忆神经网络》专栏,同时可阅读《LSTM长短期记忆神经网络》专栏内容,数据订阅后私信我获取):MATLAB实现BO-BiLSTM贝叶斯优化双向长短期记忆神经网络时间序列预测,专栏外只能获取该程序。

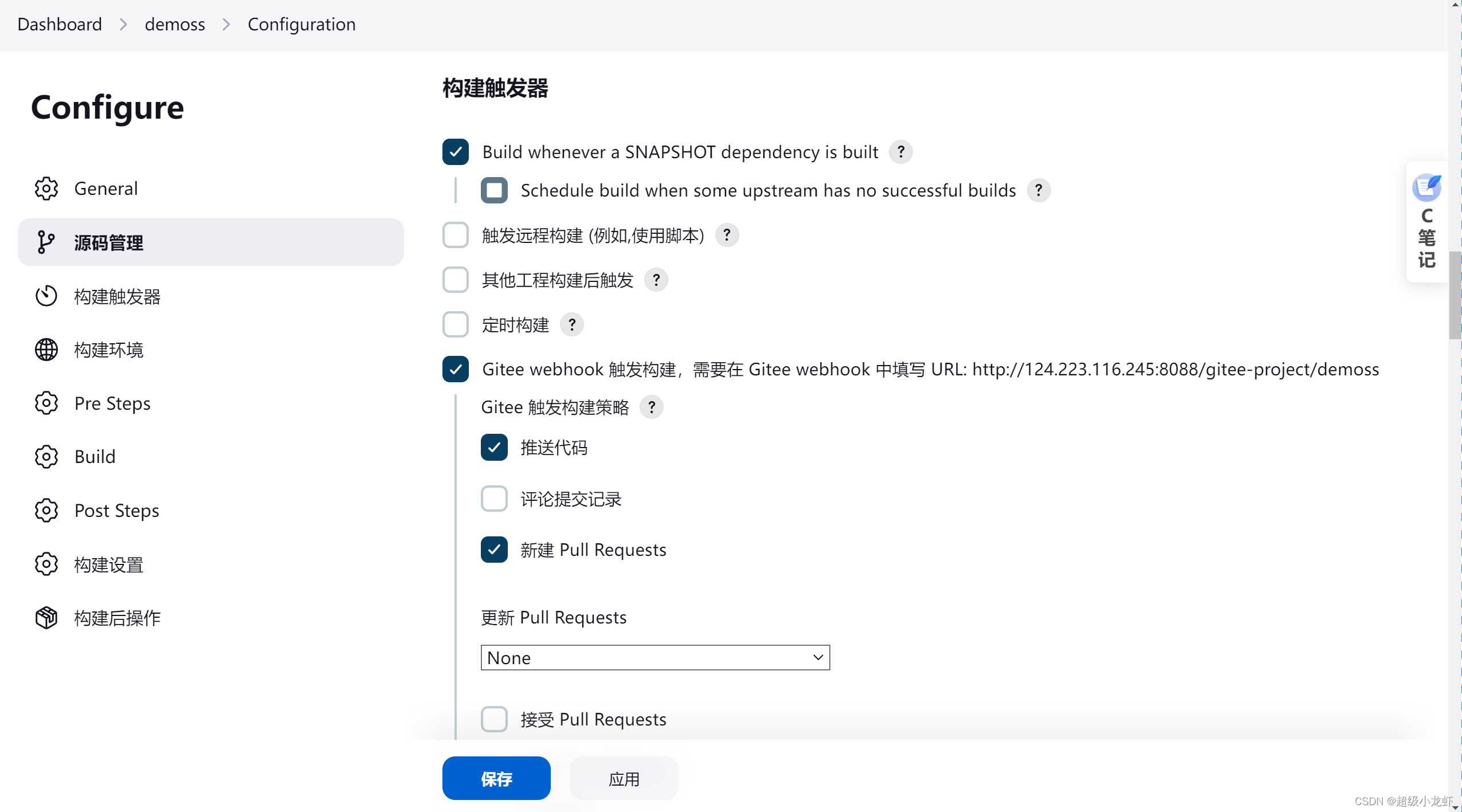

%% 优化算法参数设置

%参数取值上界(学习率,隐藏层节点,正则化系数)

%% 贝叶斯优化参数范围

optimVars = [

optimizableVariable('NumOfUnits', [10, 50], 'Type', 'integer')

optimizableVariable('InitialLearnRate', [1e-3, 1], 'Transform', 'log')

optimizableVariable('L2Regularization', [1e-10, 1e-2], 'Transform', 'log')];

%% 创建网络架构

% 输入特征维度

numFeatures = f_;

% 输出特征维度

numResponses = 1;

FiltZise = 10;

% 创建"LSTM"模型

layers = [...

% 输入特征

sequenceInputLayer([numFeatures 1 1],'Name','input')

sequenceFoldingLayer('Name','fold')

% 特征学习

dropoutLayer(0.25,'Name','drop3')

% 全连接层

fullyConnectedLayer(numResponses,'Name','fc')

regressionLayer('Name','output') ];

layers = layerGraph(layers);

layers = connectLayers(layers,'fold/miniBatchSize','unfold/miniBatchSize');

% 批处理样本

MiniBatchSize =128;

% 最大迭代次数

MaxEpochs = 500;

options = trainingOptions( 'adam', ...

'MaxEpochs',500, ...

'GradientThreshold',1, ...

'InitialLearnRate',optVars.InitialLearnRate, ...

'LearnRateSchedule','piecewise', ...

'LearnRateDropPeriod',400, ...

'LearnRateDropFactor',0.2, ...

'L2Regularization',optVars.L2Regularization,...

'Verbose',false, ...

'Plots','none');

%% 训练混合网络

net = trainNetwork(XrTrain,YrTrain,layers,options);

参考资料

[1] https://blog.csdn.net/kjm13182345320/article/details/129036772?spm=1001.2014.3001.5502

[2] https://blog.csdn.net/kjm13182345320/article/details/128690229

![MyBatis-Plus是什么以及特性[MyBatis-Plus系列] - 第481篇](https://img-blog.csdnimg.cn/img_convert/192e5270eaf41e64aa81bf5018b9b0fa.png)