一、目标

kettle8.2在Linux安装好后,需要与Hive3.1.2数据库建立连接

二、前提

(一)在Linux已经安装好kettle并可以启动kettle

(二)版本:kettle8.2.0 Hive3.1.2 Hadoop3.1.3

(三)在Kettle连接Hive之前,Hadoop和Hive必须安装好

(四)Hive的hiveserver2还可以后台启动远程访问

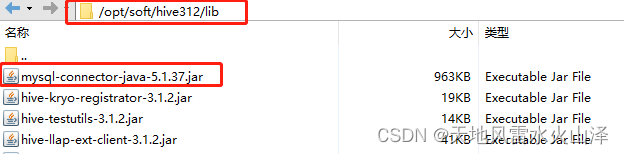

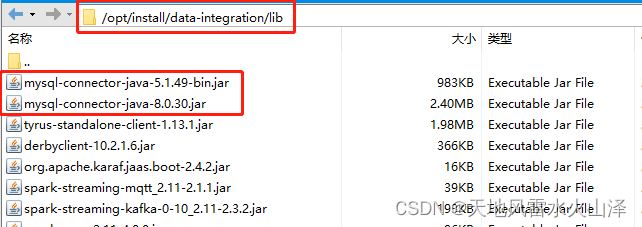

(五)注意kettle8.2里MySQL驱动包的版本以及hive312里MySQL驱动包的版本

1、Hive312的lib里面MySQL驱动包的版本是mysql-connector-java-5.1.37.jar

2、Kettle8.2的lib里面我放了2个MySQL驱动包,一个高版本,一个普通版本,为了防止出现驱动包不匹配

三、实施步骤

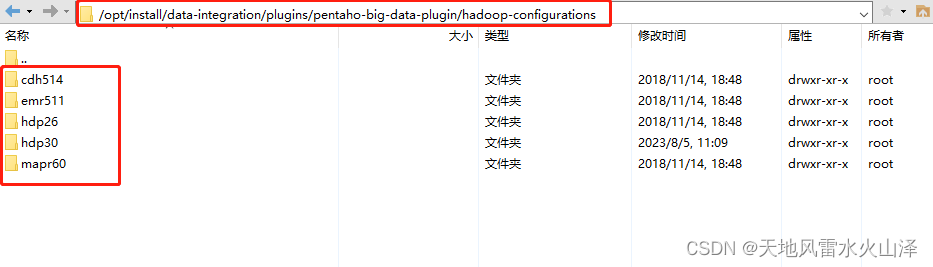

(一)根据你的Hadoop、Hive安装版本,在/opt/install/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations选择相应的文件

注意:Hadoop、Hive安装版本与对应的hadoop-configurations文件夹

| Hadoop、Hive版本 | hadoop-configurations对应文件夹 |

| Hive3.1.2 Hadoop3.1.3 | hdp30 |

| Hadoop260-cdh、hive110-cdh | cdh514 |

由于我安装的版本是Hive3.1.2 Hadoop3.1.3,所以我选的文件是hdp30!

这一步很重要,千万不要随意选!!!一定要版本对应文件!

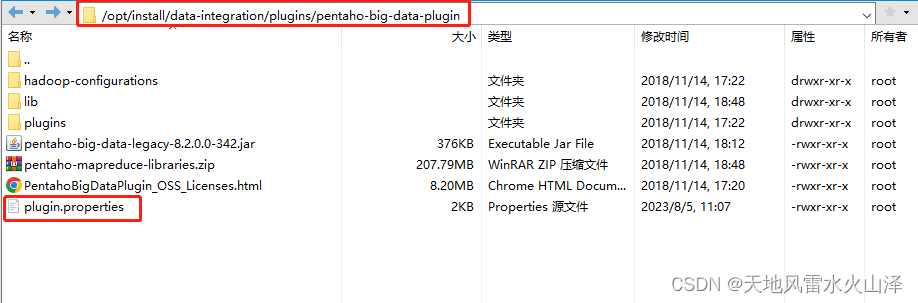

(二)修改kettle里pentaho-big-data-plugin文件夹里的源文件plugin.properties

文件路径:/opt/install/data-integration/plugins/pentaho-big-data-plugin

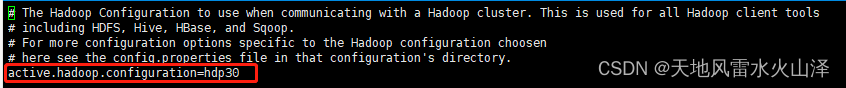

只要设置 active.hadoop.configuration=hdp30

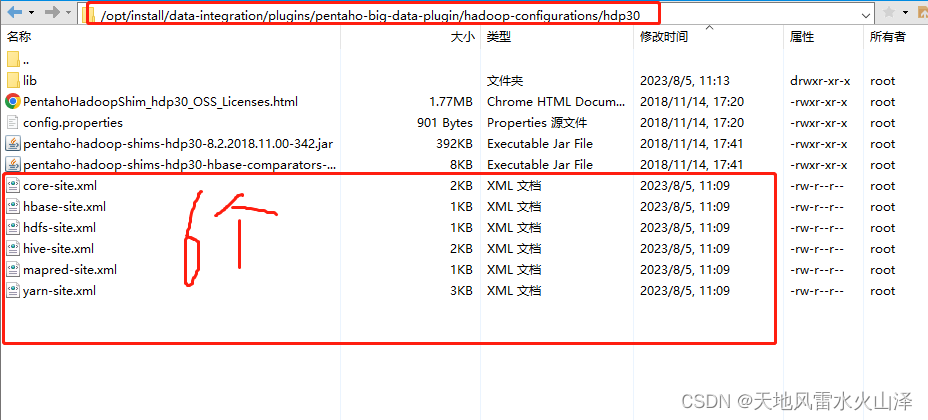

(三)从我们安装的Hadoop、hive、hbase里拉取需要的文件从而替代hdp30文件里的原有文件

主要替换6个文件

Hadoop4个文件: yarn-site.xml、mapred-site.xml、hdfs-site.xml、core-site.xml

Hive1个文件: hive-site.xml

HBase1个文件: hbase-site.xml

结果如下所示

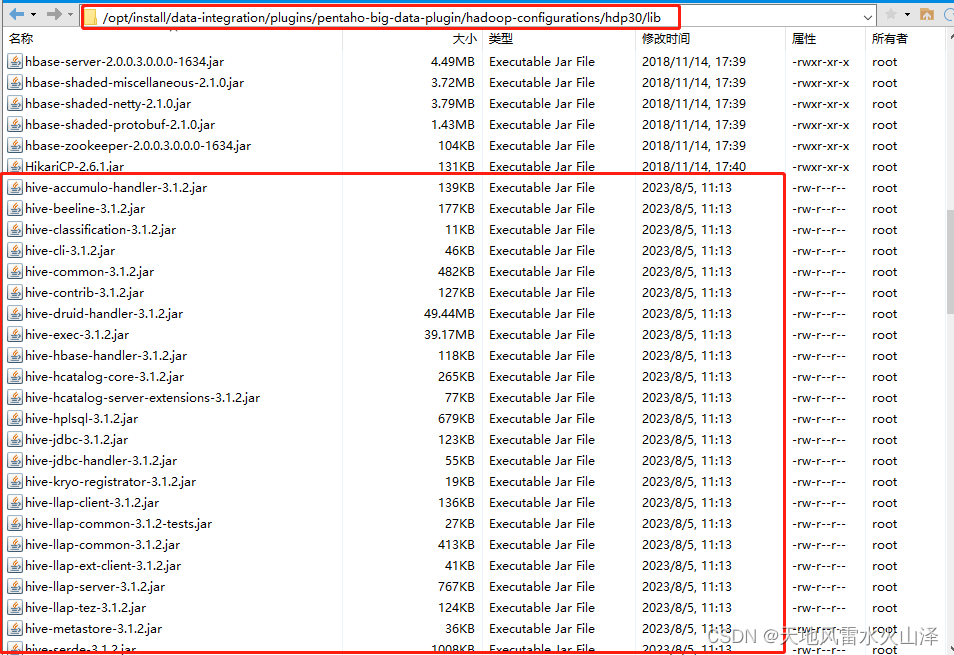

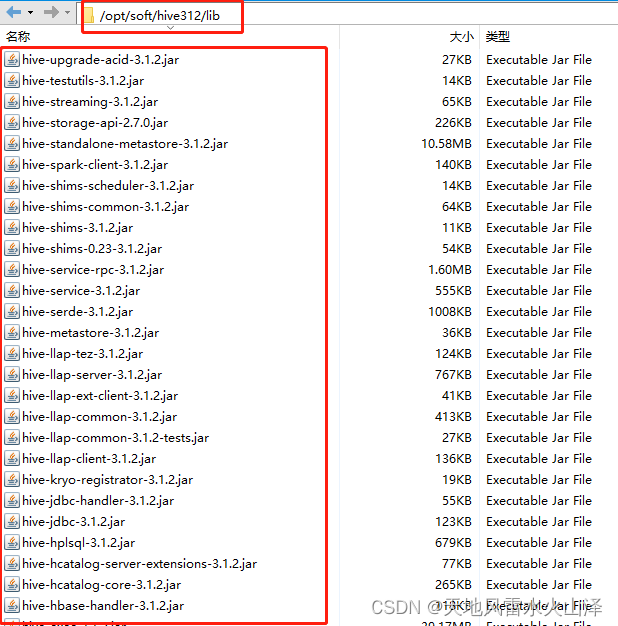

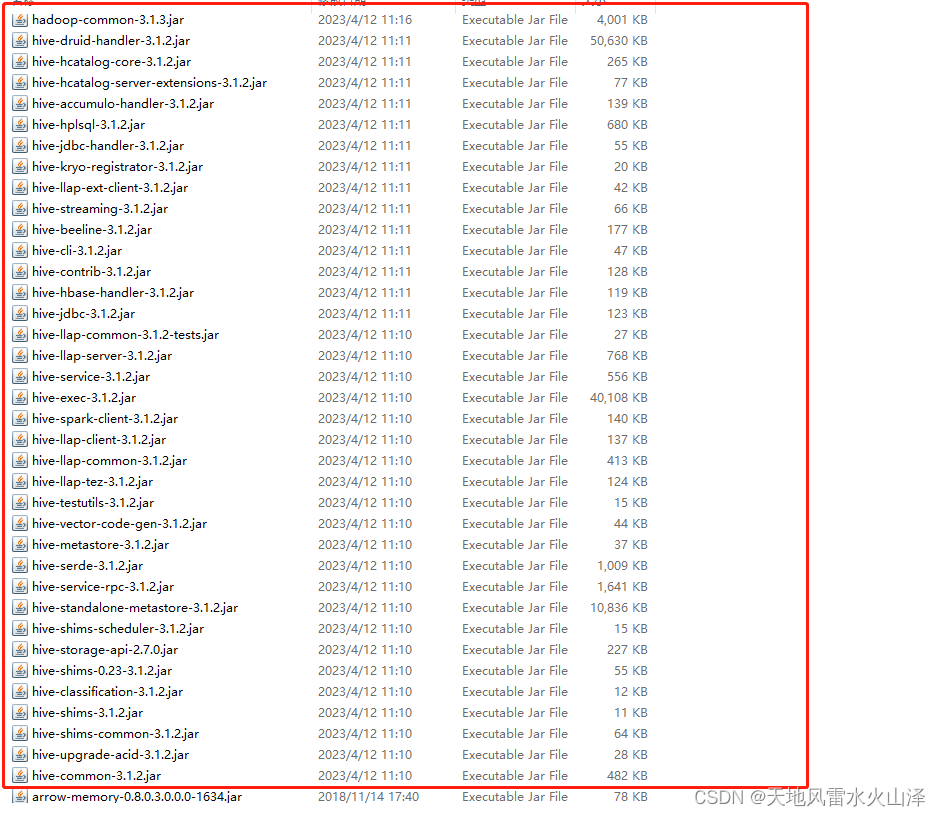

(四)从Hive安装路径的lib目录复制以hive开头的jar包,并替换hdp30\lib里hive开头的jar包

kettle替换jar包文件路径:/opt/install/data-integration/plugins/pentaho-big-data-plugin/hadoop-configurations/hdp30/lib

步骤说明:在hdp30\lib的文件夹下,先删除原本自带的hive开头的jar包,然后把我们Hive312里lib目录下的hive开头的jar包全都复制过去

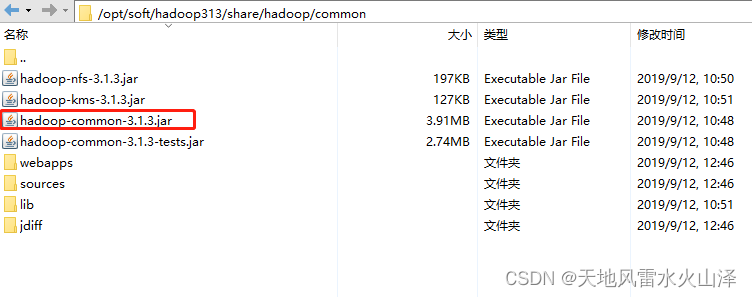

(五)复制Hadoop安装目录下的 hadoop-common-3.1.3.jar到hdp30\lib里

(六)最后在hdp30\lib的文件夹下,需要复制的jar截图如下

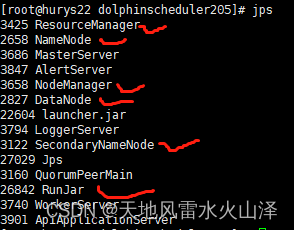

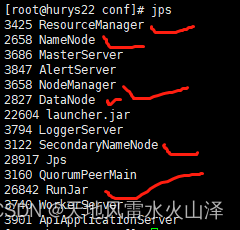

(七)这些准备好后,开启Hadoop服务和hiveserver2服务

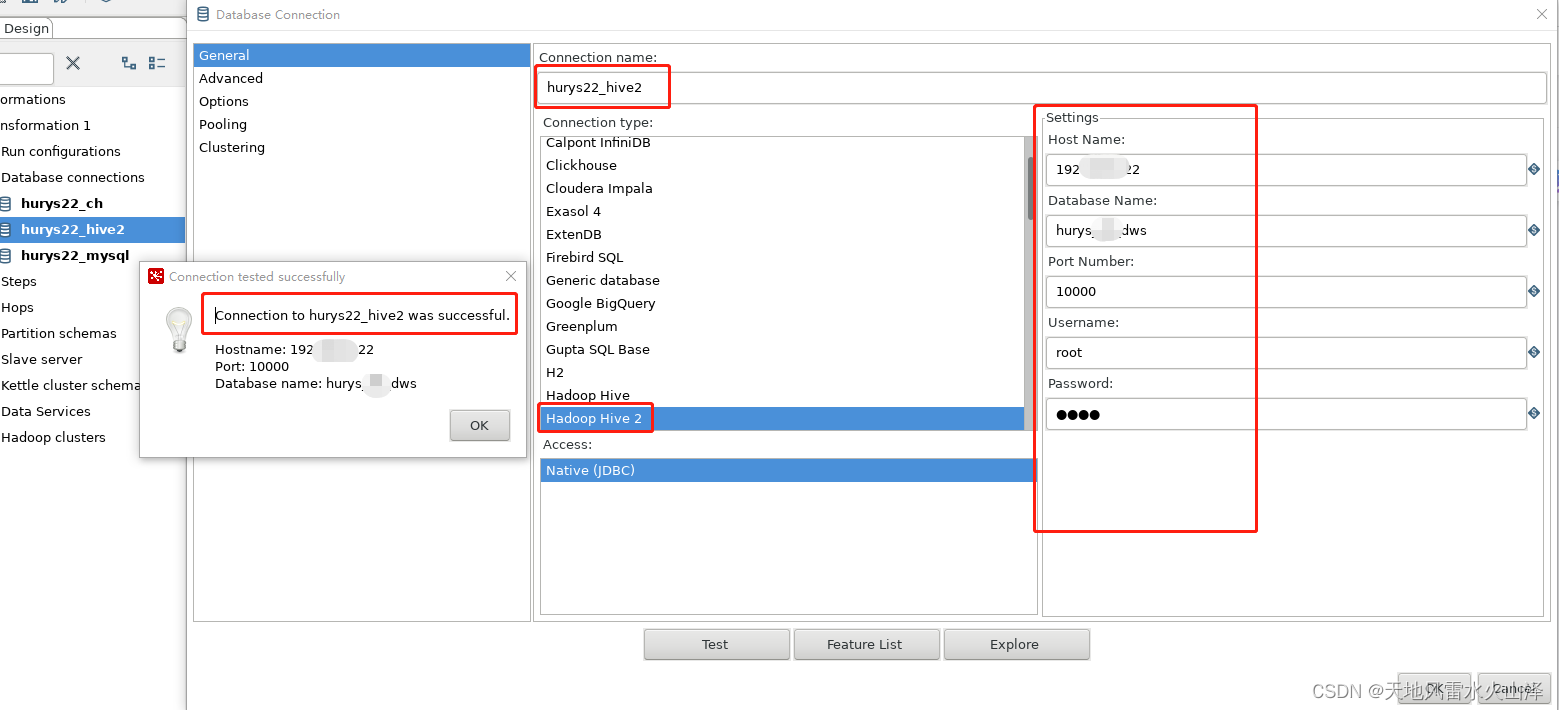

(八)开启kettle,创建hive2数据库连接

到这里,Linux上安装的kettle8.2连接Hive312就成功了!!!

![[Securinets CTF Quals 2023] Admin Service,ret2libc,One is enough](https://img-blog.csdnimg.cn/ae465509aa1943d0b2168c168d6e229a.png)