1.写在前面

很多朋友在做数仓的ETL的动作的时候,还是喜欢比较易上手的kettle

前面章节有介绍过安装kettle,可以参考

ETL工具--安装kettle_老码试途的博客-CSDN博客_spoon.bat 安装

kettle在Windows系统中对数据的转换、表和文件的转换等,都相对简单,而在对大数据平台进行操作的时候,需要先配置相关参数,本节进行kettle整合Hadoop

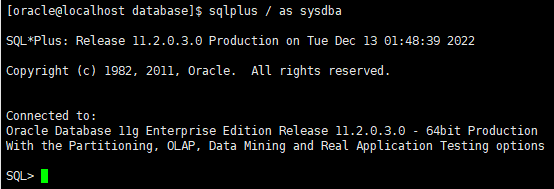

2.设置环境变量

因为涉及到权限问题,所以把每个节点的Hadoop的用户名设置为root,

本次教程有三个节点,分别为node1、node2、node3,依次改一下

##进入配置文件

vim /etc/profile

保存退出,记得三个节点都要操作。

小知识点:

1)先按ESC,然后 shift + : 然后 wp 或者x保存并退出

2)先按Esc 然后shift + zz 也可以

3.核心文件配置

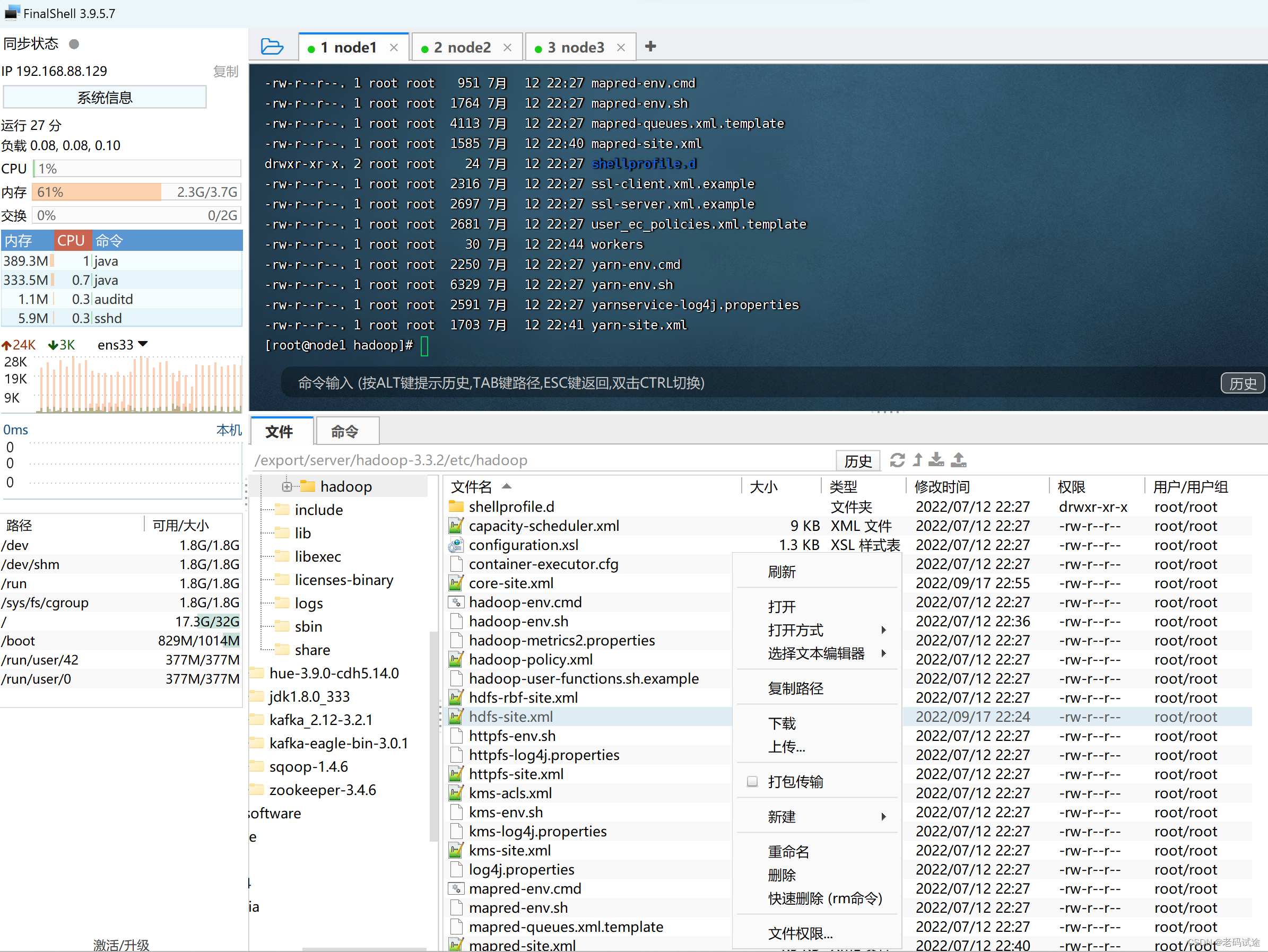

将Hadoop配置文件hdfs-site.xml和core-site.xml下载到Windows的kettle安装目录中

注意:下面是本教程中路径,cdh集成版有所不同

/export/server/hadoop-3.3.2/etc/hadoop/hdfs-site.xml

/export/server/hadoop-3.3.2/etc/hadoop/core-site.xml

用Finalshell下载很方便

##放入kettle的安装目录:

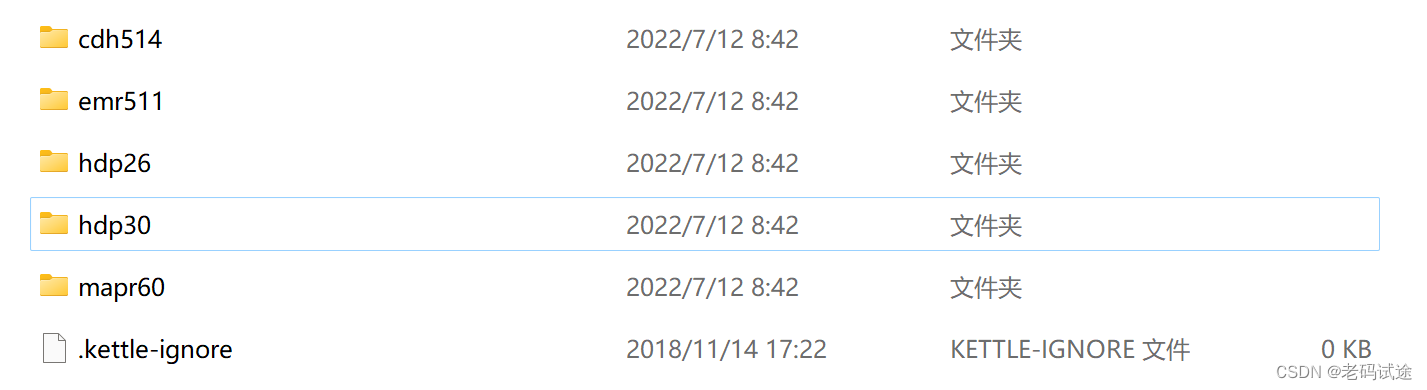

pdi-ce-8.2.0.0-342\data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations

目前试验的Hadoop版本是3.3.2,放入hdp30,替换文件。如果cdh版本的放入cdh514文件夹

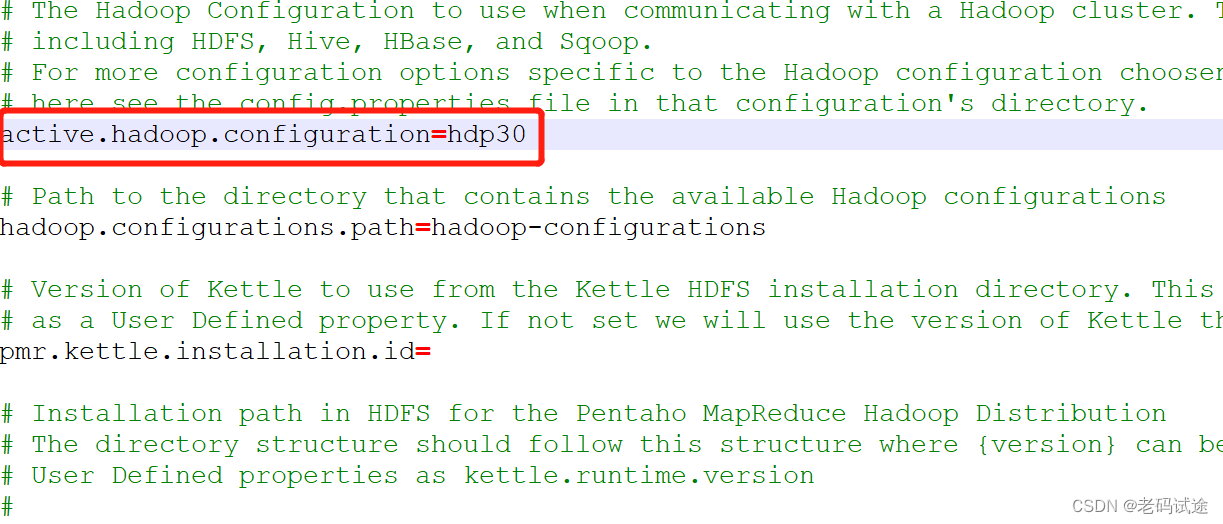

4.修改plugin.properties文件

data-integration\plugins\pentaho-big-data-plugin\plugin.properties

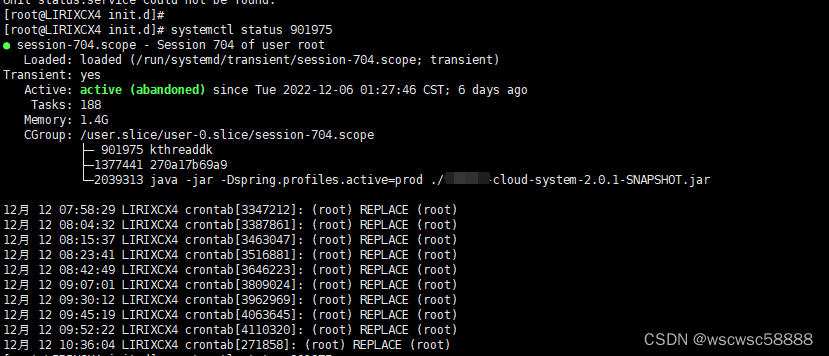

重启Hadoop及kettle,记得启动zookeeper,下面要测试联通

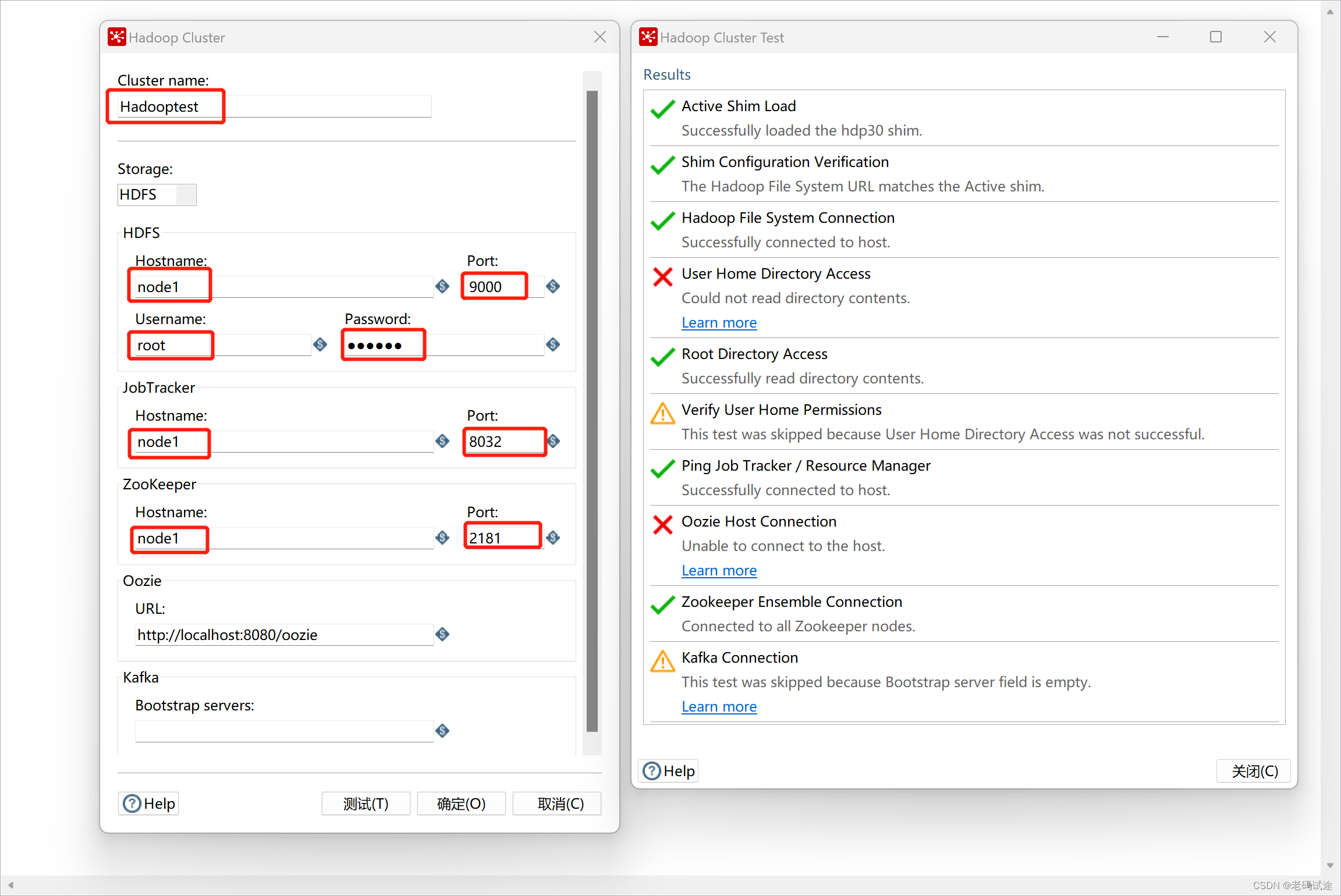

5.配置kettle的Hadoop clusters

左侧主对象树----Hadoop clusters右击----new cluster

关于hdfs的端口号,我最初配置8020,后改为9000了,自己测试连通性,Oozie未配置,不用管

下面可以操作Hadoop组件了