注1:本文系“简要介绍”系列之一,仅从概念上对计算机视觉和机器人导航中的Odometry、Relocalization和SLAM进行非常简要的介绍,不适合用于深入和详细的了解。

航行家的视觉:理解Odometry, Relocalization和SLAM的区别与联系

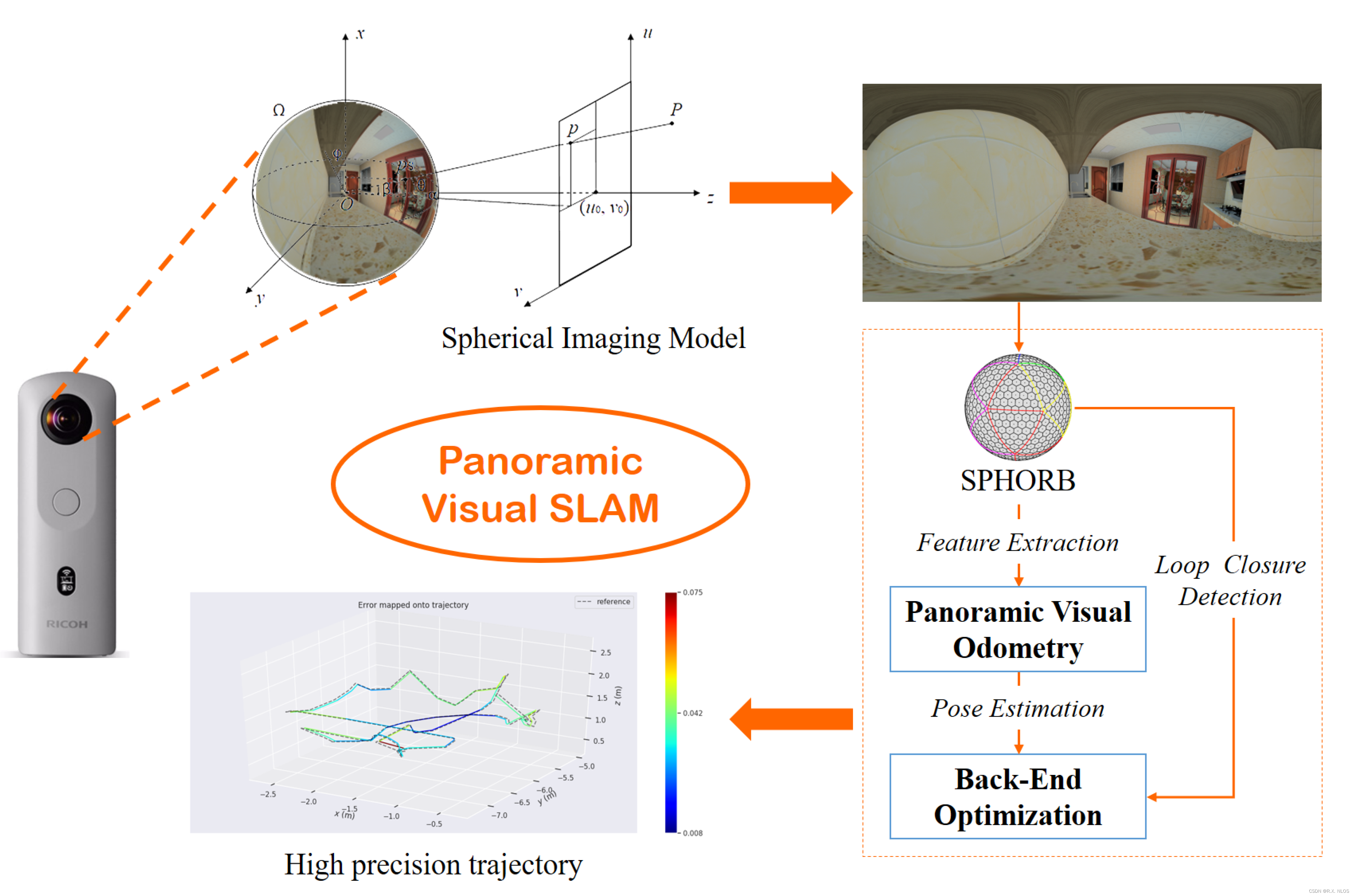

Sensors | Free Full-Text | Panoramic Visual SLAM Technology for Spherical Images

背景介绍

在机器人导航和计算机视觉领域中,有三个核心概念:Odometry,Relocalization和SLAM(Simultaneous Localization and Mapping)。这些技术用于定位和映射,为机器人或增强现实(AR)应用提供了空间感知能力。

原理介绍和推导

Odometry

Odometry是一种使用传感器数据(如轮速计或惯性测量单元(IMU))来估计机器人的相对位置变化的方法。基本公式如下:

Δ position = speed × Δ time \Delta \text{position} = \text{speed} \times \Delta \text{time} Δposition=speed×Δtime

然而,测量误差和环境噪声可能会导致位置估计的累积误差,这是odometry的一大挑战。

Relocalization

Relocalization是一种定位技术,可以在机器人失去定位后重新找到其在地图中的位置。它通常依赖于预先建立的地图和当前观察到的特征,然后使用一种称为匹配的过程来确定当前位置。

SLAM

SLAM是一种同时进行定位和映射的技术。在未知环境中,SLAM能够构建地图,同时跟踪机器人在地图中的位置。

SLAM的基本公式如下:

SLAM ( Map t − 1 , Pos t − 1 , Obs t ) = ( Map t , Pos t ) \text{SLAM}(\text{Map}_{t-1}, \text{Pos}_{t-1}, \text{Obs}_{t}) = (\text{Map}_{t}, \text{Pos}_{t}) SLAM(Mapt−1,Post−1,Obst)=(Mapt,Post)

其中, Map t − 1 \text{Map}_{t-1} Mapt−1是在时间 t − 1 t-1 t−1时的地图, Pos t − 1 \text{Pos}_{t-1} Post−1是在时间 t − 1 t-1 t−1时的位置, Obs t \text{Obs}_{t} Obst是在时间 t t t时的观察。

Odometry和Relocalization为何是SLAM的核心

在机器人导航和计算机视觉中,Odometry和Relocalization被视为Simultaneous Localization and Mapping(SLAM)的核心部分,原因在于它们分别承担了SLAM中的两个主要任务:定位(Localization)和映射(Mapping)。

-

Odometry主要负责定位任务。通过连续的运动估计,Odometry能够跟踪机器人在环境中的位置,即使在没有全局地图信息的情况下也能做到这一点。然而,由于测量误差和环境噪声的影响,Odometry通常会产生累积误差,这可能会导致长期定位的不准确。因此,虽然Odometry能够提供即时的定位信息,但它常常需要配合其他技术(如Relocalization)来提高长期的定位精度。

-

Relocalization主要负责误差修正。当机器人失去定位(例如,由于Odometry的累积误差或者临时的传感器失效)时,Relocalization能够利用预先建立的地图信息,通过识别和匹配环境特征,重新找到机器人在地图中的位置。这种技术对于纠正Odometry的累积误差和提高长期的定位精度非常重要。

-

SLAM结合了Odometry和Relocalization的优点,同时还增加了映射任务。在未知环境中,SLAM不仅能够跟踪机器人的位置(如同Odometry),还能够建立环境的地图(即映射任务)。同时,通过类似Relocalization的技术,SLAM还能够利用已经建立的地图信息来纠正位置的累积误差。

因此,Odometry和Relocalization可以被视为SLAM的核心,因为它们分别实现了SLAM的定位和误差修正功能,而SLAM将这些功能结合起来,实现了在未知环境中同时进行定位和映射。

研究现状

Odometry,Relocalization和SLAM技术已经在许多应用中得到了广泛的使用和发展。例如,在自动驾驶、无人机导航和增强现实等领域都有它们的身影。

挑战

尽管这些技术已经取得了显著的进步,但仍然存在许多挑战,包括:

- 累积误差:由于测量误差和环境噪声,位置估计可能会积累误差。

- 动态环境:在动态变化的环境中,保持精确的定位和映射是非常困难的。

- 计算资源:这些技术通常需要大量的计算资源,这对于嵌入式系统来说可能是一个问题。

未来展望

随着深度学习和人工智能的发展,我们有望解决以上挑战。例如,深度学习可以用于更准确地估计位置和构建地图,而新的优化算法可以减少计算需求。

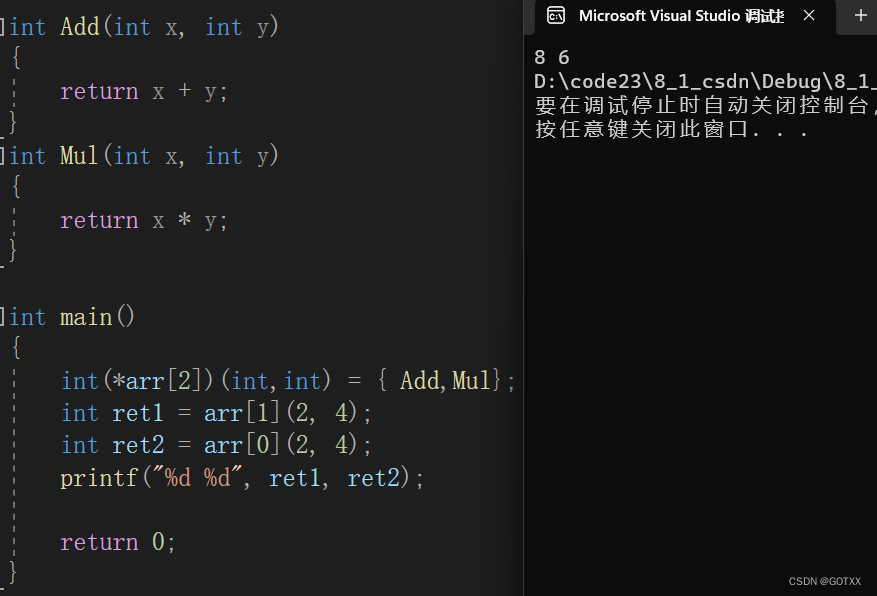

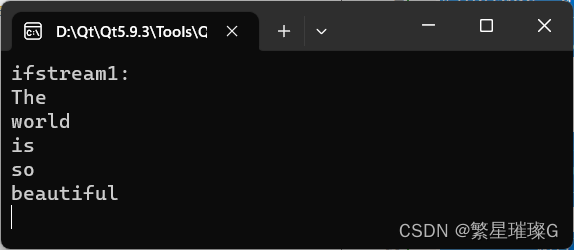

代码示例

这是一个使用Python和OpenCV实现的简单的Odometry示例:

import cv2

import numpy as np

# Load the video

cap = cv2.VideoCapture('video.mp4')

# Parameters for Shi-Tomasi corner detection

feature_params = dict(maxCorners=100, qualityLevel=0.3, minDistance=7)

# Parameters for Lucas-Kanade optical flow

lk_params = dict(winSize=(15,15), maxLevel=2)

# The first frame

_, old_frame = cap.read()

old_gray = cv2.cvtColor(old_frame, cv2.COLOR_BGR2GRAY)

p0 = cv2.goodFeaturesToTrack(old_gray, mask=None, **feature_params)

# Create some random colors

color = np.random.randint(0,255,(100,3))

while(1):

_, frame = cap.read()

frame_gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# calculate optical flow

p1, st, _ = cv2.calcOpticalFlowPyrLK(old_gray, frame_gray, p0, None, **lk_params)

# Select good points

good_new = p1[st==1]

good_old = p0[st==1]

# draw the tracks

for i,(new,old) in enumerate(zip(good_new,good_old)):

a,b = new.ravel()

c,d = old.ravel()

frame = cv2.line(frame, (a,b), (c,d), color[i].tolist(), 2)

frame = cv2.circle(frame, (a,b), 5, color[i].tolist(), -1)

cv2.imshow('frame',frame)

# Now update the previous frame and previous points

old_gray = frame_gray.copy()

p0 = good_new.reshape(-1,1,2)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

cap.release()

总结

Odometry,Relocalization和SLAM都是机器人导航和计算机视觉领域的重要技术,它们对于机器人的空间感知至关重要。尽管这些技术已经取得了显著的进步,但仍然存在许多挑战,期待未来有更多的研究和应用可以帮助我们更好地理解和使用这些技术。