目录

- 部署说明

- MapReduce配置文件

- YARN配置文件

- 分发配置文件

- 集群启动命令

- 开始启动YARN集群

- 查看YARN的WEB UI页面

- 保存快照

- YARN集群的启停命令

- 一键启动脚本

- 单进程启停

- 提交MapReduce任务到YARN执行

- 提交wordcount示例程序

- 查看运行日志

- 提交求圆周率示例程序

p41~43

https://www.bilibili.com/video/BV1WY4y197g7/?p=41

部署说明

- Hadoop HDFS分布式文件系统,我们会启动:

- NameNode进程作为管理节点

- DataNode进程作为工作节点

- SecondaryNamenode作为辅助

- 同理,Hadoop YARN分布式资源调度,会启动:

- ResourceManager进程作为管理节点

- NodeManager进程作为工作节点

- ProxyServer、JobHistoryServer这两个辅助节点

- 那么,MapReduce呢?

MapReduce运行在YARN容器内,无需启动独立进程

所以关于MapReduce和YARN的部署,其实就是2件事情:

- 关于MapReduce: 修改相关配置文件,但是没有进程可以启动

- 关于YARN: 修改相关配置文件, 并启动ResourceManager、NodeManager进程以及辅助进程(代理服务器、历史服务器)

有3台服务器,其中node1配置较高

集群规划如下:

| 主机 | 角色 |

|---|---|

| node1 | ResourceManager、NodeManager、ProxyServer、JobHistoryServer |

| node2 | NodeManager |

| node3 | NodeManager |

MapReduce配置文件

在 $HADOOP_HOME/etc/hadoop 文件夹内,修改:

- mapred-env.sh文件

su - hadoop

cd /export/server/hadoop/etc/hadoop/

vim mapred-env.sh

在顶部添加以下内容

export JAVA_HOME=/export/server/jdk

export HADOOP_JOB_HISTORYSERVER_HEAPSIZE=1000

export HADOOP_MAPRED_ROOT_LOGGER=INFO,RFA

设置JDK路径

设置JobHistoryServer进程内存为1G

设置日志级别为INFO

- mapred-site.xml文件

vim mapred-site.xml

在<configuration></configuration>之间添加以下内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

<discription>MapReduce的运行框架运行为YARN</discription>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node1:10020</value>

<discription>历史服务器通讯端口为node1:10020</discription>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node1:19888</value>

<discription>历史服务器端口为node1的19888</discription>

</property>

<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/data/mr-history/tmp</value>

<discription>历史信息在HDFS的记录临时路径</discription>

</property>

<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/data/mr-history/done</value>

<discription>历史信息在HDFS的记录路径</discription>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<discription>MapRedece HOME设置为HADOOP_HOME</discription>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<discription>MapRedece HOME设置为HADOOP_HOME</discription>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value>

<discription>MapRedece HOME设置为HADOOP_HOME</discription>

</property>

YARN配置文件

vim yarn-env.sh

在顶部添加以下内容

export JAVA_HOME=/export/server/jdk

export HADOOP_HOME=/export/server/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export HADOOP_LOG_DIR=$HADOOP_HOME/logs

设置JDK路径的环境变量

设置HADOOP_HOME的环境变量

设置配置文件路径的环境变量

设置日志文件路径的环境变量

vim yarn-site.xml

在<configuration></configuration>之间添加以下内容

<property>

<name>yarn.resourcemanager.hostname</name>

<value>node1</value>

<discription>ResourceManager设置在node1节点</discription>

</property>

<property>

<name>yarn.nodemanager.local-dirs</name>

<value>/data/nm-local</value>

<discription>NodeManager中间数据本地存储路径</discription>

</property>

<property>

<name>yarn.nodemanager.log-dirs</name>

<value>/data/nm-log</value>

<discription>NodeManager数据日志本地存储路径</discription>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

<discription>为MapReduce程序开启Shuffle服务</discription>

</property>

<property>

<name>yarn.log.server.url</name>

<value>http://node1:19888/jobhistory/logs</value>

<discription>历史服务器URL</discription>

</property>

<property>

<name>yarn.web-proxy.address</name>

<value>node1:8089</value>

<discription>代理服务器主机和端口</discription>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

<discription>开启日志聚合</discription>

</property>

<property>

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/tmp/logs</value>

<discription>程序日志HDFS的存储路径</discription>

</property>

<property>

<name>yarn.resourcemanager.scheduler.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.scheduler.fair.FairScheduler</value>

<discription>选择公平调度器</discription>

</property>

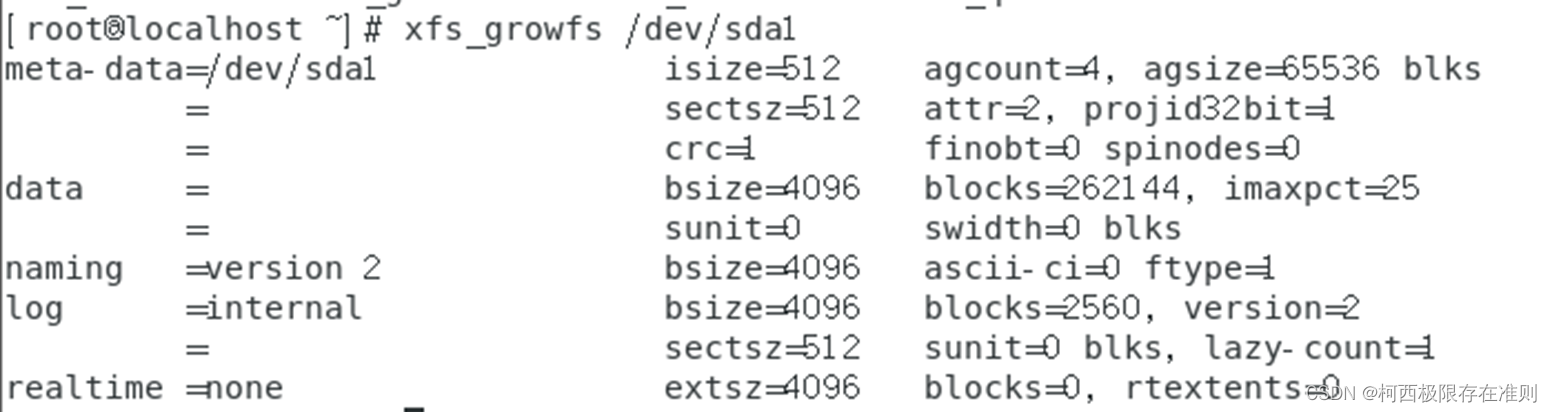

分发配置文件

把配置好的文件分发到其他服务器节点中

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml node2:`pwd`/

scp mapred-env.sh mapred-site.xml yarn-env.sh yarn-site.xml node3:`pwd`/

集群启动命令

常用的进程启动命令如下:

- 一键启动YARN集群: $HADOOP_HOME/sbin/start-yarn.sh

- 会基于yarn-site.xml中配置的yarn.resourcemanager.hostname来决定在哪台机器上启动resourcemanager

- 会基于workers文件配置的主机启动NodeManager

- 一键停止YARN集群: $HADOOP_HOME/sbin/stop-yarn.sh

- 在当前机器,单独启动或停止进程

- $HADOOP_HOME/bin/yarn --daemon start|stop resourcemanager|nodemanager|proxyserver

- start和stop决定启动和停止

- 可控制resourcemanager、nodemanager、proxyserver三种进程

- 历史服务器启动和停止

- $HADOOP_HOME/bin/mapred --daemon start|stop historyserver

开始启动YARN集群

在node1服务器,以hadoop用户执行

start-dfs.sh

start-yarn.sh

jps

mapred --daemon start historyserver

日志文件在/export/server/hadoop/logs,出问题可以查看日志来排查问题。

查看YARN的WEB UI页面

打开 http://node1:8088 即可看到YARN集群的监控页面(ResourceManager的WEB UI)

保存快照

三个服务器都关机退出保存快照

su -

init 0

刚刚部署好YARN集群

YARN集群的启停命令

一键启动脚本

启动:

$HADOOP_HOME/sbin/start-yarn.sh

从yarn-site.xml中读取配置,确定ResourceManager所在机器,并启动它。

读取workers文件,确定机器,启动全部的NodeManager。

在当前机器启动ProxyServer(代理服务器)。

关闭:

$HADOOP_HOME/sbin/stop-yarn.sh

start-yarn.sh

jps

stop-yarn.sh

单进程启停

除了一键启停外,也可以单独控制进程的启停。

$HADOOP_HOME/bin/yarn,此程序也可以用以单独控制所在机器的进程的启停

用法:yarn --daemon (start|stop) (resourcemanager|nodemanager|proxyserver)

yarn --daemon start resourcemanager

yarn --daemon stop resourcemanager

yarn --daemon start nodemanager

yarn --daemon stop nodemanager

yarn --daemon start proxyserver

yarn --daemon stop proxyserver

$HADOOP_HOME/bin/mapred,此程序也可以用以单独控制所在机器的历史服务器的启停

用法:mapred --daemon (start|stop) historyserver

mapred --daemon stop historyserver

mapred --daemon start historyserver

提交MapReduce任务到YARN执行

YARN作为资源调度管控框架,其本身提供资源供许多程序运行,常见的有:MapReduce程序、Spark程序、Flink程序

Hadoop官方内置了一些预置的MapReduce程序代码,我们无需编程,只需要通过命令即可使用。

常用的有2个MapReduce内置程序:

- wordcount:单词计数程序。

统计指定文件内各个单词出现的次数 - pi:求圆周率

通过蒙特卡罗算法(统计模拟法)求圆周率

这些内置的示例MapReduce程序代码,都在:

$HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.1.jar 这个文件内。

cd /export/server/hadoop/share/hadoop/mapreduce/

ll

cd

可以通过 hadoop jar 命令来运行它,提交MapReduce程序到YARN中。

语法: hadoop jar 程序文件 java类名 [程序参数] … [程序参数]

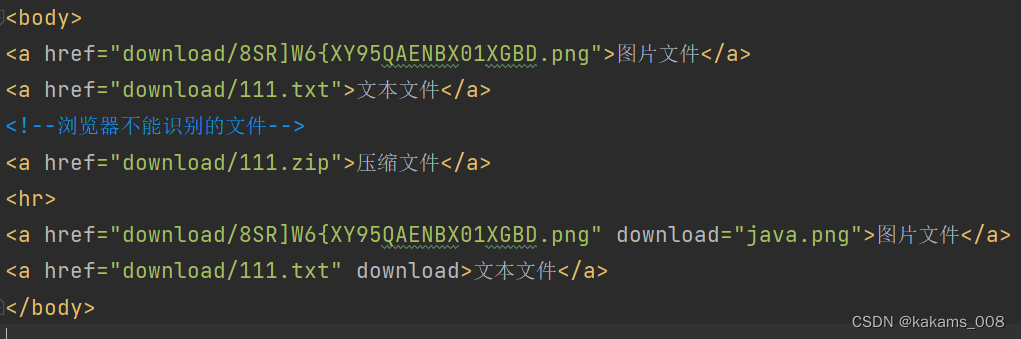

提交wordcount示例程序

单词计数示例程序的功能很简单:

- 给定数据输入的路径(HDFS)、给定结果输出的路径(HDFS)

- 将输入路径内的数据中的单词进行计数,将结果写到输出路径

我们可以准备一份数据文件,并上传到HDFS中。

hadoop it bigdata hello world

hello bigdata hdfs

it is hadoop hdfs

hdfs mapreduce yarn

hadoop yarn

将上面内容保存到Linux中为words.txt文件,并上传到HDFS

start-dfs.sh

vim words.txt

hadoop fs -mkdir -p /input

hadoop fs -mkdir /output

hadoop fs -ls /

hadoop fs -put words.txt /input/

hadoop fs -ls /input/

执行如下命令,提交示例MapReduce程序WordCount到YARN中执行

start-yarn.sh

mapred --daemon start historyserver

hadoop jar /export/server/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.4.jar wordcount hdfs://node1:8020/input hdfs://node1:8020/output/wc

注意:

参数wordcount,表示运行jar包中的单词计数程序(Java Class)

参数1是数据输入路径(hdfs://node1:8020/input/wordcount/)

参数2是结果输出路径(hdfs://node1:8020/output/wc), 需要确保输出的文件夹不存在

提交程序后,可以在YARN的WEB UI页面看到运行中的程序(http://node1:8088/cluster/apps)

执行完成后,可以查看HDFS上的输出结果

hadoop fs -ls /output/wc

hadoop fs -cat /output/wc/*

- _SUCCESS文件是标记文件,表示运行成功,本身是空文件

- part-r-00000,是结果文件,结果存储在以part开头的文件中

执行完成后,可以借助历史服务器查看到程序的历史运行信息

ps:如果没有启动历史服务器和代理服务器,此操作无法完成(页面信息由历史服务器提供,鼠标点击跳转到新网页功能由代理服务器提供)

查看运行日志

点击logs链接,可以查看到详细的运行日志信息。

此功能基于:

- 配置文件中配置了日志聚合功能,并设置了历史服务器

- 启动了代理服务器和历史服务器

- 历史服务器进程会将日志收集整理,形成可以查看的网页内容供我们查看。

所以,如果发现无法查看程序运行历史以及无法查看程序运行日志信息,请检查上述1、2、3是否都正确设置。

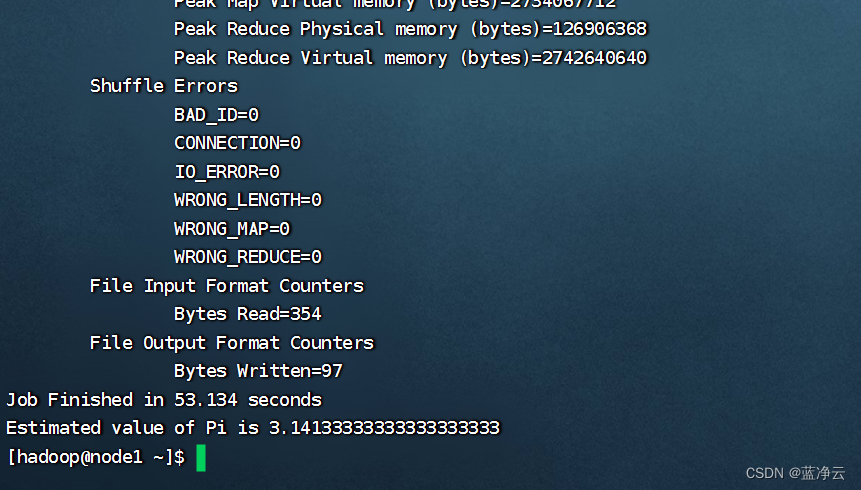

提交求圆周率示例程序

可以执行如下命令,使用蒙特卡罗算法模拟计算求PI(圆周率)

hadoop jar /export/server/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.3.4.jar pi 3 1000

参数pi表示要运行的Java类,这里表示运行jar包中的求pi程序

参数3,表示设置几个map任务

参数1000,表示模拟求PI的样本数(越大求的PI越准确,但是速度越慢)

(样本1000太小,不够精准)