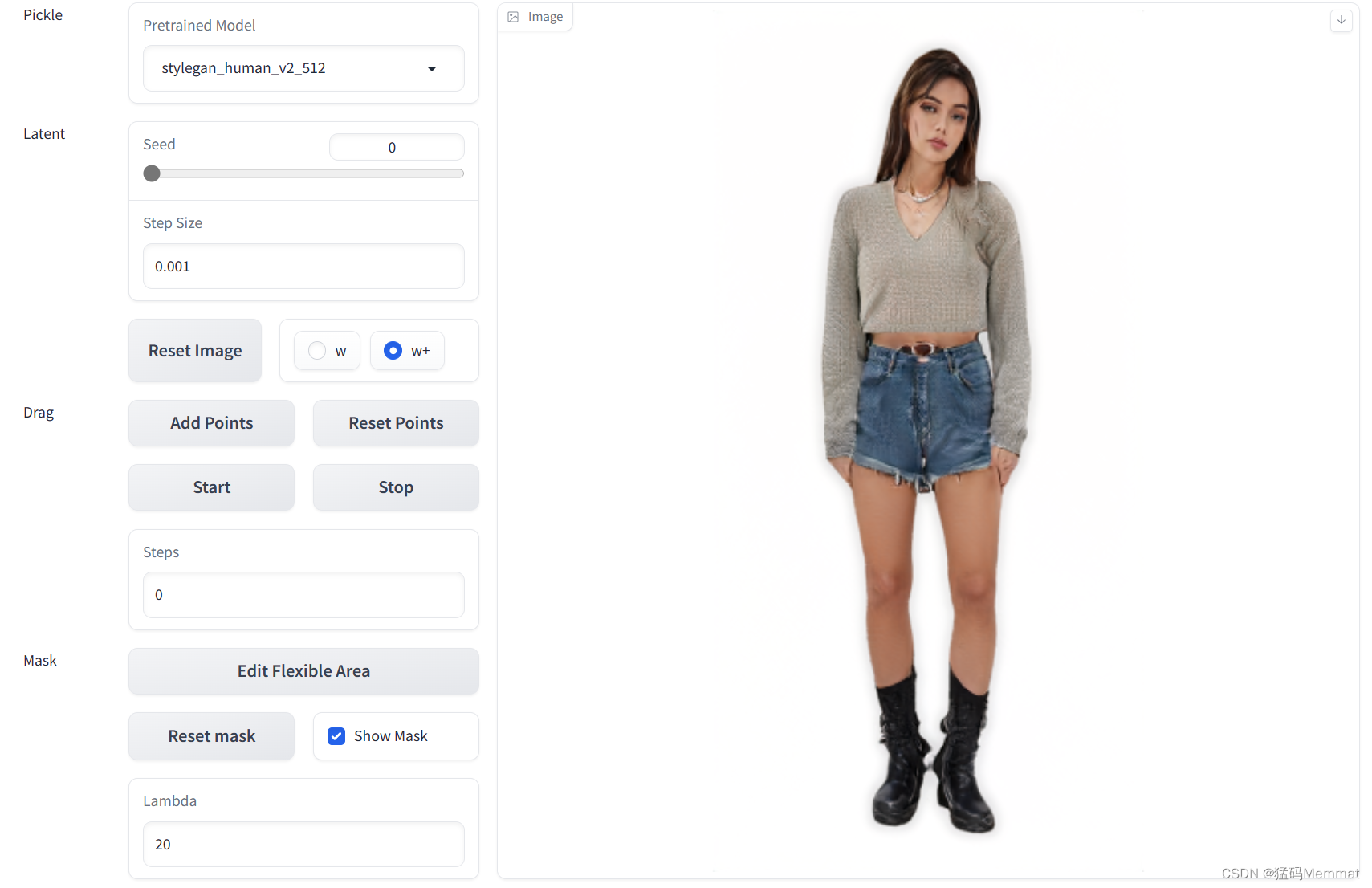

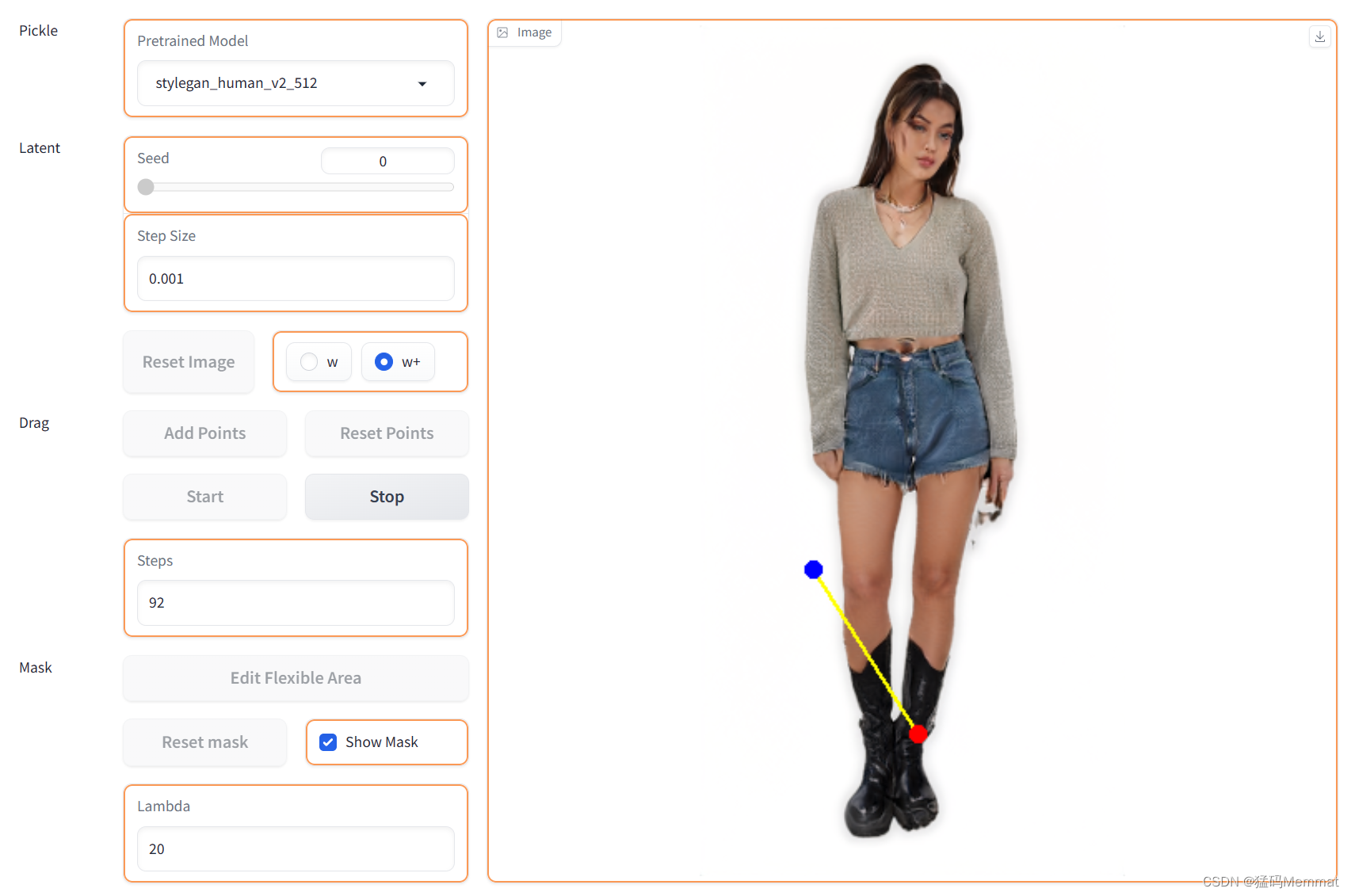

该项目的论文被SIGGRAPH 2023 收录,论文以 StyleGAN2 架构为基础,实现了 “Drag” 关键点就能轻松 P 图的效果。

https://github.com/XingangPan/DragGAN

https://vcai.mpi-inf.mpg.de/projects/DragGAN/

目录

- 原图1

- 测试一

- 测试二

- 测试三

- 原图2

- 测试一

- 测试二

- 原图3

- 测试

- 参考文献

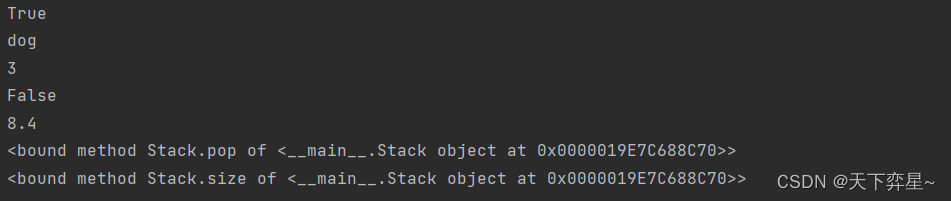

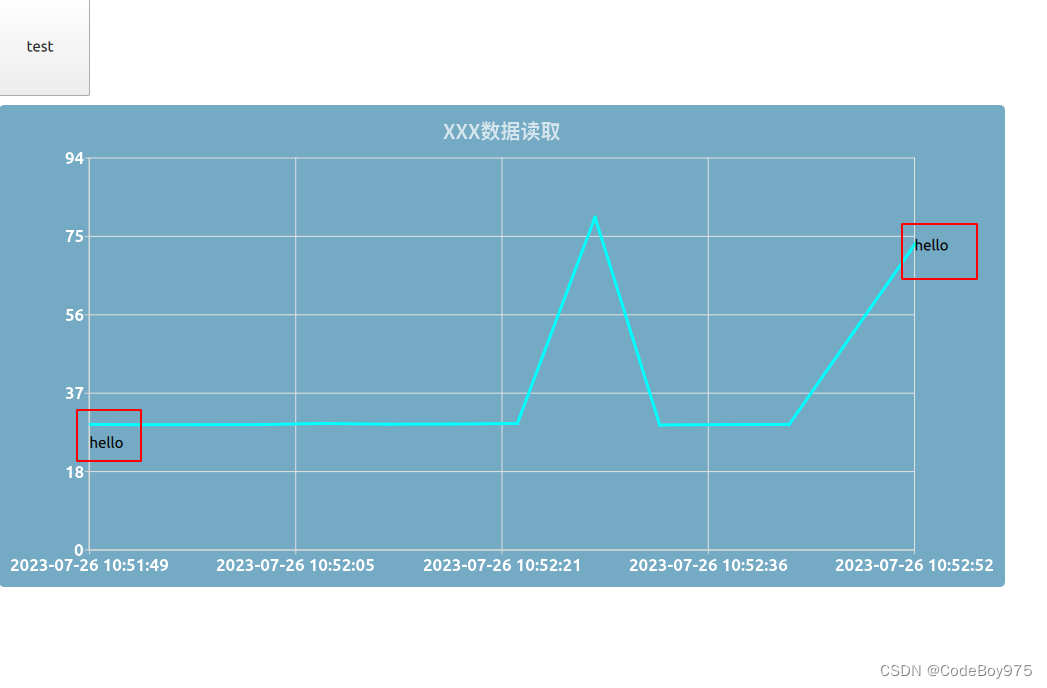

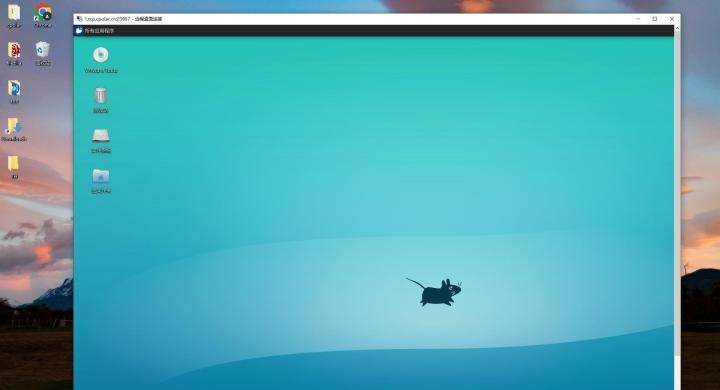

在官方 Demo 中,作者轻触鼠标,一拖一拽,让狗狗微笑、让猫咪"Wink"、让倒影拉长、让太阳升起…完美贴合现实世界的物理结构和物理逻辑。DragGAN 源代码正式放出,目前在 GitHub 上已有超过 20,000 颗星标。

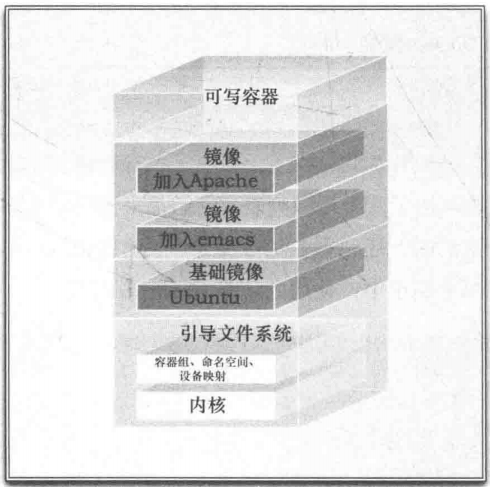

根据论文中的介绍,DragGAN 是一种用于直观基于点的图像编辑的交互方法。利用预先训练的 GAN 来合成不仅精确跟随用户输入的图像,而且停留在真实图像的流形上。与之前的许多方法相比,是一个不依赖于特定领域的建模或辅助网络的通用框架。这是基于两种新方法实现的:一是对隐编码的优化,这些隐编码增量地将多个抓取点移动到它们的目标位置;二是通过点跟踪过程来准确地跟踪抓取点的轨迹。这两个组件利用 GAN 中间特征图的判别质量来进行图像变形,实现交互性能。目前已经证明,此方法在基于 GAN 的操作中优于最先进的方法,并为使用生成先验的强大图像编辑开辟了新的方向。而对于未来的工作,作者计划将基于点的编辑扩展到 3D 生成模型。

原图1

测试一

测试二

测试三

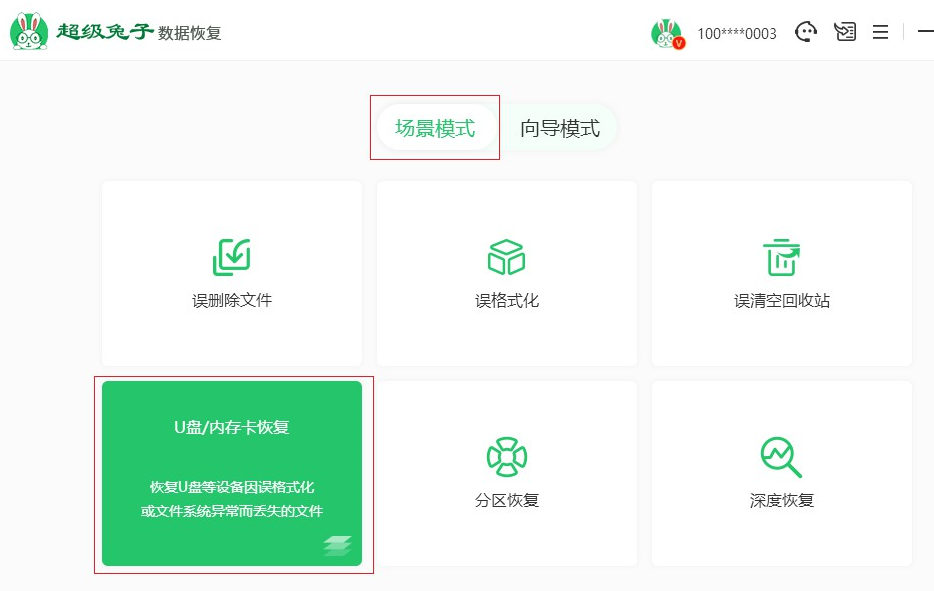

原图2

测试一

测试二

原图3

测试

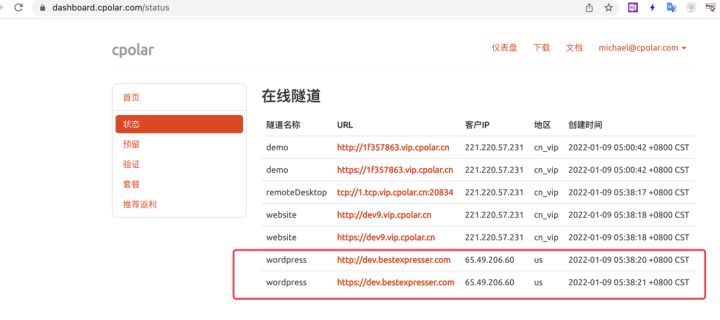

参考文献

https://huggingface.co/spaces/DragGan/DragGan

https://openxlab.org.cn/apps/detail/XingangPan/DragGAN

https://zhuanlan.zhihu.com/p/639963515