首先我们来看OpenAI系列模型:

OpenAI 并不只有一个模型,而是提供了涵盖文本、码、对话、语音、图像领域的一系列模型。

语言类大模型

其中语言类大模型包括: GPT-3、GPT-3.5、GPT-4系列模型。

并且,OpenAI在训练GPT-3的同时训练了参数不同、复杂度各不相同的A、B、C、D四项大模型 (基座模型),用于不同场景的应用;其中,A、B、C、D模型的全称分别是ada(埃达·洛夫莱斯)、babbage(查尔斯·巴贝奇)、curie(居里夫人)和davinci(达芬奇),四个模型并不是GPT-3的微调模型,而是独立训练的四个模型;四个模型的参数规模和复杂程度按照A-B-C-D顺序依次递增:虽不如GPT-3.5和GPT-4那么有名,但A、B、C、D四大模型却是目前OpenAI大模型生态中功能最丰富、API种类最多的四个模型。

为了更好的满足更多的适用场景训练不同规模的模型是目前业内的基本共识。

谷歌PaLM2 Models同时发布了四项大模型:

Gecko (壁虎) 、Otter(水獭) 、Bison (野牛) 、Unicorn(独角兽) ,其中最小的Gecko模型可以在移动端运行,并计划在下一代安卓系统中集成。

图像多模态大模型:

- 最新版为OpanAI的 DALL-E(达利) v2,是DALL-E模型的第二版训练版,能够根据描述生成图像;

- DALL-E模型为基于GPT-3开发的模型,总共包含120亿个参数,不难看出DALL-E对图像的理解能力源于大语言模型;

- 那为啥图像大模型要基于GPT-3来训练呢?OpenAl将大语言模型的理解能力“复制”到视觉领域的核心方法:将图像视作一种一种语言,将其转化为Token,并和文本Token一起进行训练

语音识别模型:

- 最新版为Whisper v2-large model,是Whisper模型的升级版,能够执行多语言语音识别以及语音翻译和语言识别;

- Whisper模型是为数不多的OpenAl的开源模型,该模型通过68万小时的多语言和多任务监督数据进行的训练,目前提供了原始论文进行方法介绍;

- whisper模型可以本地部署,也可以像其他OpenAl大模型一样通过调用API进行在线使用,并且根据官网介绍,Whisper在线模型会有额外运行速度上的优化,通过调用API进行使用,效率更高(当然也需要支付一定的费用)

文本向量化模型:

- Embedding文本嵌入模型,用于将文本转化为词向量,即用一个数组(向量) 来表示一个文本,该文本可以是短语、句子或者文章;

- 最新一代Embedding模型是基于ada模型微调的text-embedding-ada-002模型;

- 通过将文本转化为词向量,就可以让计算机进一步的“读懂文本”,通过词向量的计算和分析和相似度计算,可以对其背后的文本进行搜索、聚类、推荐、异常检测和分类等;

审查模型:

Moderation模型,旨在检查内容是否符合 OpenAl的使用政策。这

些模型提供了 查找以下类别内容的分类功能:仇恨、仇恨/威胁、自残、性、性/未成年人、暴力和暴力/图片等。

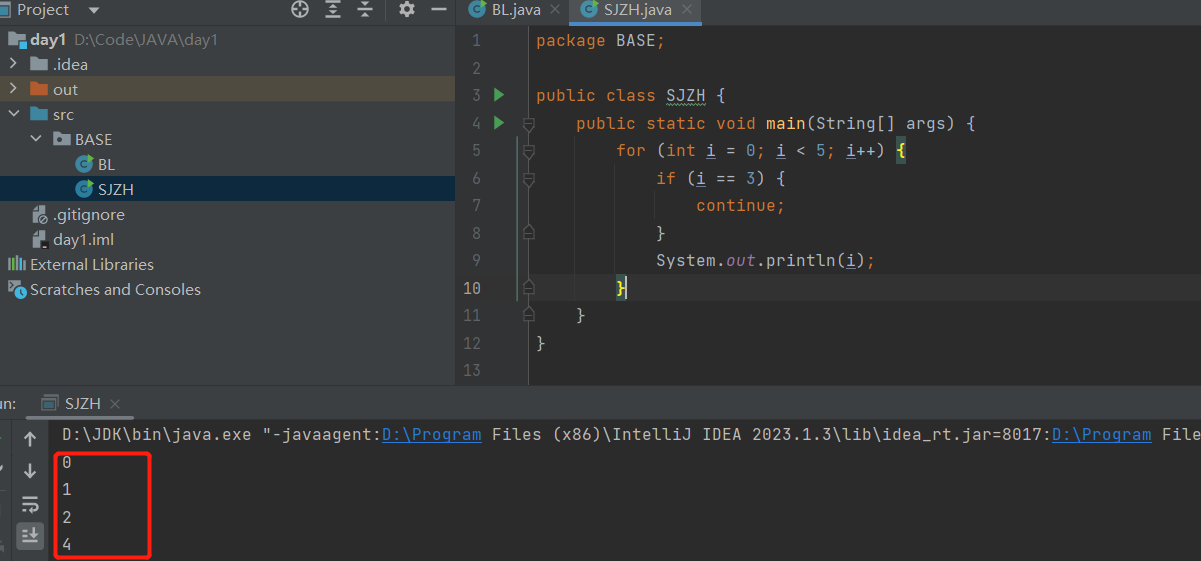

编程大模型:

- Codex大模型,用GitHub数十亿行代码训练而成,能够“读懂”代码,并且能够根据自然语言描述进行代码创建;

- Codex最擅长Python,同时精通JavaScript、Go、Perl、 PHP、Ruby、Swift、TypeScript、SaL,甚至 Shell 等十几种编程语言;

- 该模型发布于2021年8月10日,目前代码编写功能已经合并入GPT-3.5,官网显示该模型为已弃用(deprecated) 状态,意为后续不再单独维护,但并不表示OpenAl巳放弃编程大模型,相反越来越

多的编程功能被集成到语言大模型中; - 目前该模型集成于Visual Studio Code、GitHub Copilot、Azure OpenAl Service等产品中,用于提供自动编程功能支持;

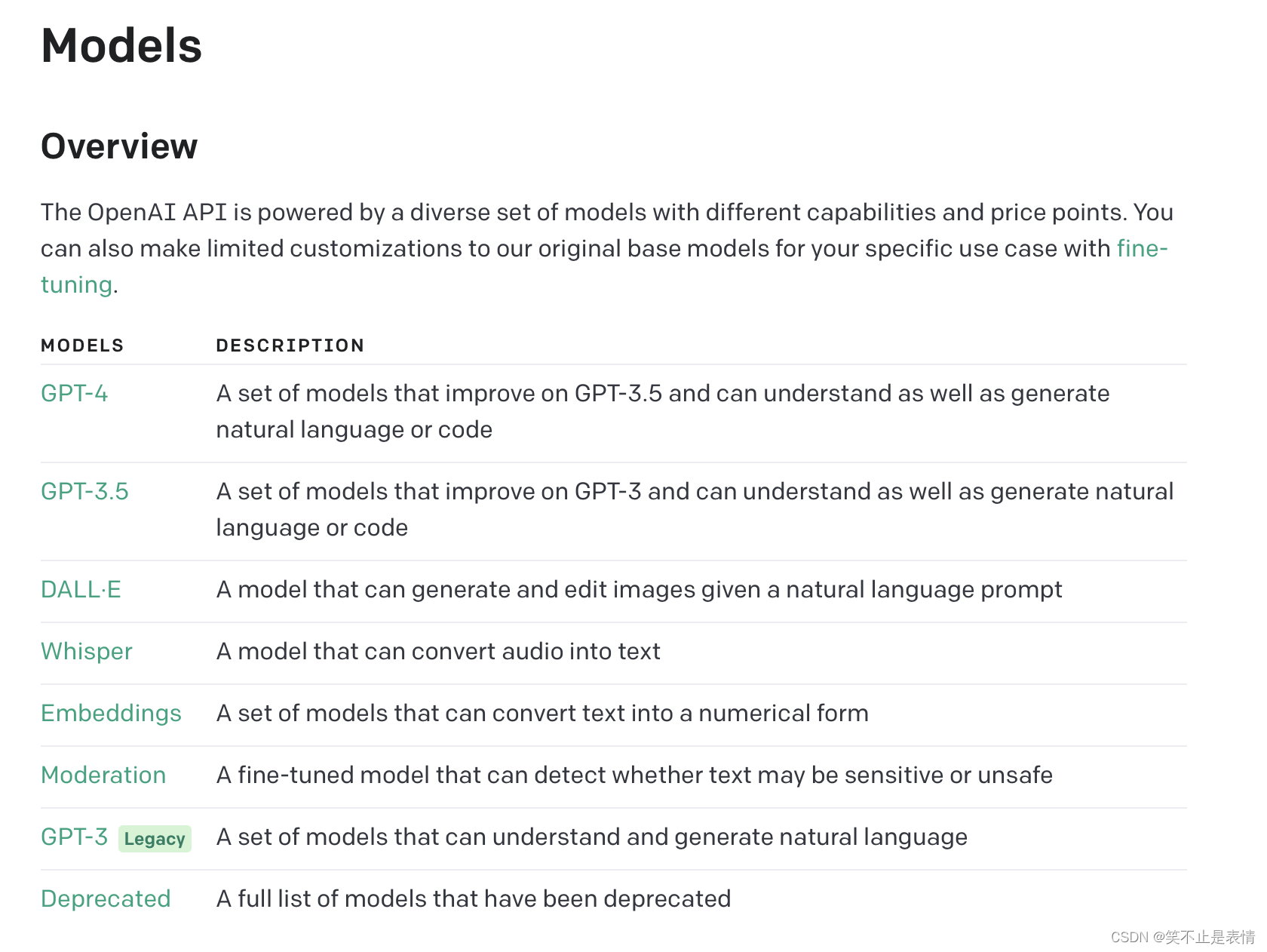

点击地址:https://platform.openai.com/docs/models/overview在models->overiew到OpenAI官网中查看目前的OpenAI模型大类:

点击以下网址:https://platform.openai.com/account/rate-limits可在个人中心一>API速率限制中查看中可以一次性看到目前账户可用的全部API

OpenAl APl命名规则

- 通用模型APl:如GPT-3.5-turbo, GPT-4, ada…

- 停止维护但仍可使用的AP1:如GPT-3.5-turbo-0301 (3月1号停止维护),GPT-4-0314 (3月14号停止维护)

- 面向特定功能的微调模型API:如ada-code-search-code(基于ada微调的编程大模型),babbage-similarity(基于babbage微调的的文本相似度检索模型) …

- 多版本编号模型API:如text-davinci-001(达芬奇文本模型1号)、text-embedding-ada-002(基于ada的Embedding模型2号)

——————————————————————————————————

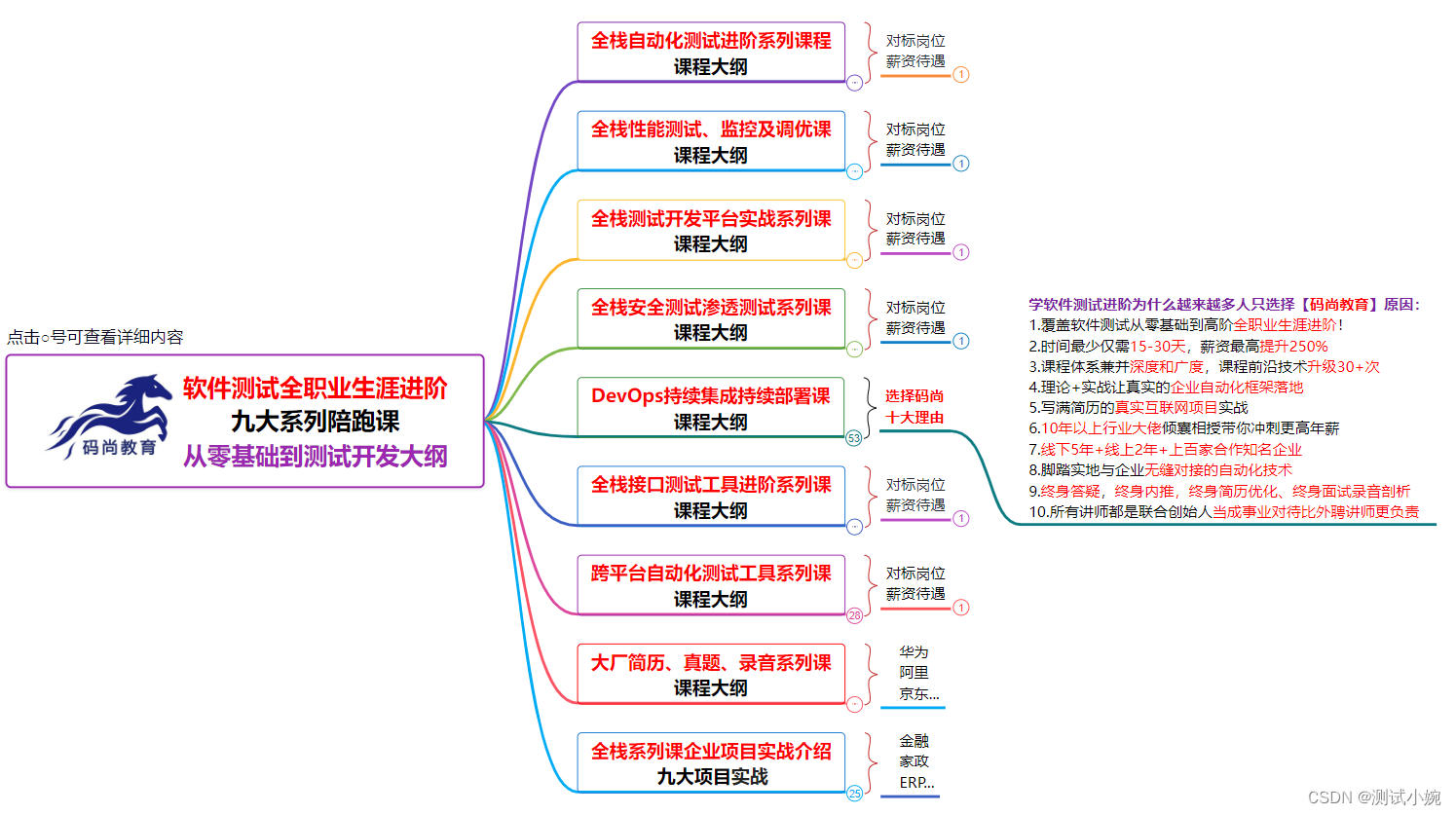

学习大模型需要掌握什么?

第一部分,需要掌握效果最好、生态最丰富、功能最齐全的OpenAl发布的大模型组

第二部分,需要掌握目前中文效果最好、最具潜力、同时具备多模态功能的开源大模型一ChatGLM 6B & visualGLM 6B

为什么要学习开源大模型?

- 更大的微调空问:相比在线大模型,开源大模型可以使用更多微调框架进行模型微调,微调空间更大,更有可能快速完成定制化大模型训练;

- 更加灵活的A应用开发:相比封闭的在线模型,开源模型可以更加灵活便捷的嵌入到AI应用中,同时也可以更加方便的搭配其他开源框架进行使用,从而实现更高效率的Al/应用开发;

- 更低的资费、更安全的数据保障:此外,不同于在线大模型需要根据API调用情况付费,开源大模型开源本地部署,仅需支付相应算力费用即可;此外,数据可以直接本地训练模型,无需在线提交数据进行在线模型微调,数据安全也将更有保障;

全球开源大模型性能评估榜单

榜单一:Hugging Face@: Open LLM Leaderboard

地址:https://huggingface.co/spaces/HuggingFaceH4/open_Ilm_leaderboard

Falcon(鹰眼)大模型:

Falcon模型为阿联酋阿布扎比创新研究所(TII) 开源的大模型,号称“史上最强开源大模型”,总共400亿参数,模型在1万亿个高质量Token上完成训练,叫能超进拥有650亿参数的LLaMA。遗憾的是Falcon并不支持中文。

榜单二:LMSYS组织 (UC伯克利背景): LLM Leaderboard

地址:https://chat.Imsys.org/?arena

通过匿名PK进行模型性能比较,同时纳入开源大模型和在线大模型进行PK,其中GPT-4排名第一,国内清华大学团队ChatGLM-6B 模型位列14。该榜单实时更新较慢,目前Falcon尚末参赛。

目前没有评价大模型能力的太权威的榜单。

——————————————————————————————————

中文最强大语言模型一 ChatGLM 130B

- ChatGLM模型是由清华大学团队开发的大语言模型,该模型借鉴了ChatGPT 的设计思路,在千亿基座模型 GLM-130B 中注入了代码预训练,通过有监督微调 (Supervised Fine-Tuning) 等技术实现人类意图对齐。2022年11月,斯坦福大学大模型中心对全球30个主流大模型进行了全方位的评测,GLM-130B 是亚洲唯一入选的大模型。在与 OpenAl、谷歌大脑、微软、英伟达、脸书的各大模型对比中,评测报告显示 GLM-130B 在准确性和恶意性指标上与 GPT-3 175B(davinci) 接近或持平。

- 论文地址:https://openreview.net/pdf?id=-Aw0rrrPUF

更加精简的低门槛大模型:ChatGLM 6B

清华大学团队同时开源 ChatGLM-6B 模型。ChatGLM-6B 是一个具有62亿参数的中英双语语言模型。通过使用与 ChatGLM (chatglm.cn)相同的技术,ChatGLM-6B 初具中文问答和对话功能,并支持在单张 2060s 上进行推理使用。具体来说,ChatGLM-6B 有如下特点:

- 充分的中英双语预训练:ChatGLM-6B 在 1:1比例的中英语料上训练了1T的token 量,兼具双语能力;

- 较低的部署门槛:FP16 精度下,ChatGLM-6B 需要至少 13GB 的显存进行推理,结合模型量化技术,这一需求可以进一步降低到 10GB (INT8) 和 6GB(INT4),使得 ChatGLM-6B 可以部署在消费级显卡上;

ChatGLM 6B的硬件要求:

- 其中,FP16指的是高精度模式,该模式下推理(即模型运行) 需要至少13G显存,微调需要至少14G显存;

- INT4、INT8则是量化模式,所谓量化模式,指的是模型会限制参数的精度,INT4表示保留4位参数精度,INT8则表示保留8位参数精度,此时相应的推理显存占用和微调显存占用都会明显滅少。最低精度INT4模式下,可以在单卡2060上运行,也是目前硬件要求最低的开源大模型;

- 根据实际测试,在高精度模式下,多轮对话最低显存占用为20G,微调显存占用为22G左右;

ChatGLM 6B丰富的开源生态:

微调框架:ChatGLM 6B + P- Tuning微调,项目地址: https://github.com/ THUDM/ChatGLM-6B/blob/main/ptuning/README.md

微调框架:ChatGLM 6B + LoRA微调,项目地址: https://github.com/ mymusise/ChatGLM-Tuning

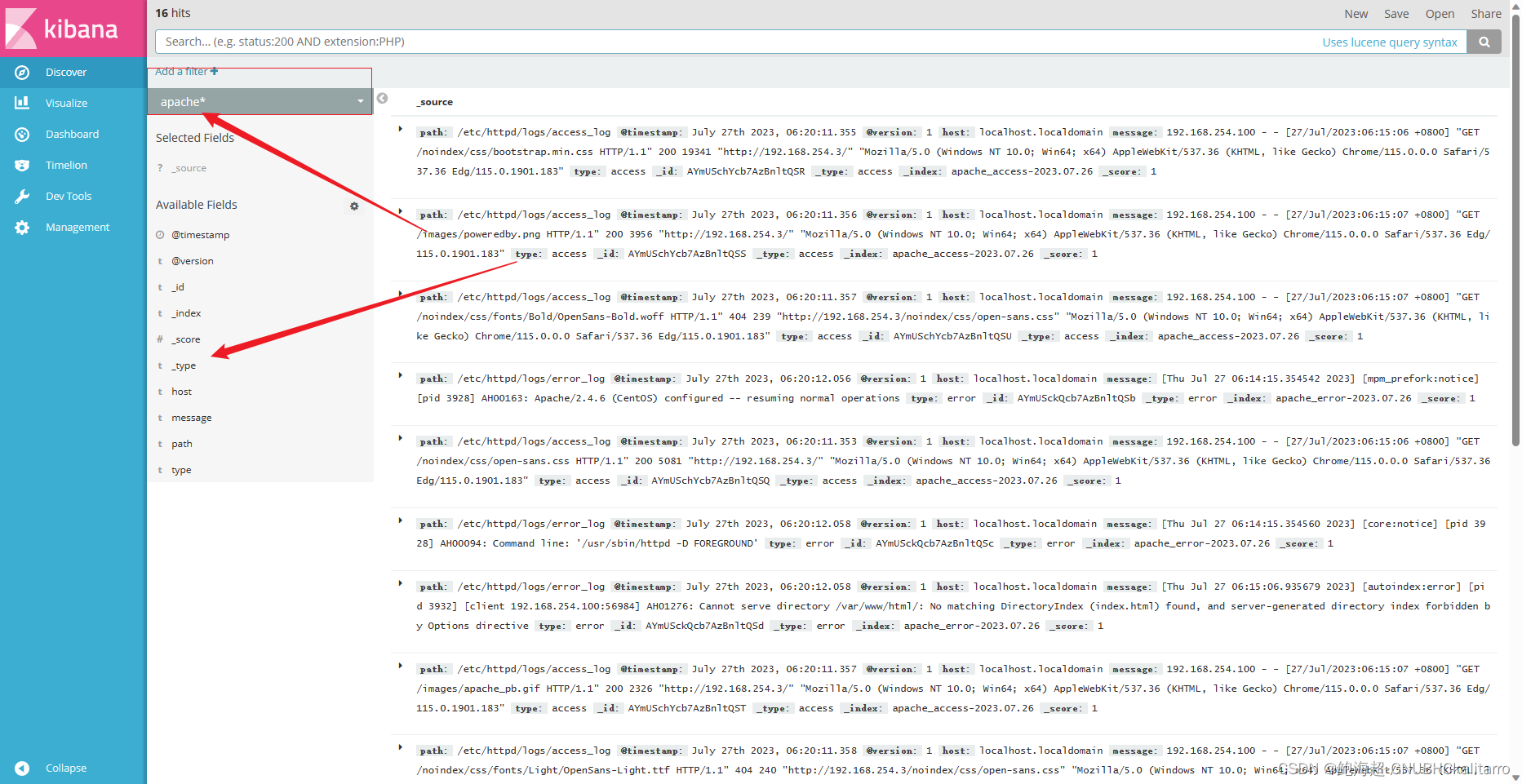

本地知识库:ChatGLM 6B + LangChain,项目地址: https://github.com/ imClumsyPanda/langchain-ChatGLM

多轮对话前端:ChatGLM 6B多轮对话的Web UI展示,项目地址: https:// github.com/Akegarasu/ChatGLM-webui

——————————————————————————————————

基于ChatGLM的多模态大模型 VisualGLM 6B

VisualGLM-6B 是一个开源的,支持图像、中文和英文的多模态对话语言模型, 语言模型基于 ChatGLM-6B,具有 62 亿参数;图像部分通过训练 BLIP2- Qformer 构建起视觉模型与语言模型的桥梁,整体模型共78亿参数。 VisualGLM-6B 依靠来自于 CogView 数据集的30M高质量中文图文对,与300M 经过筛选的英文图文对进行预训练,中英文权重相同。该训练方式较好地将视觉 信息对⻬到ChatGLM的语义空间;之后的微调阶段,模型在⻓视觉问答数据上训 练,以生成符合人类偏好的答案。

VisualGLM 6B部分样例 项目地址:

https://github.com/THUDM/VisualGLM-6B

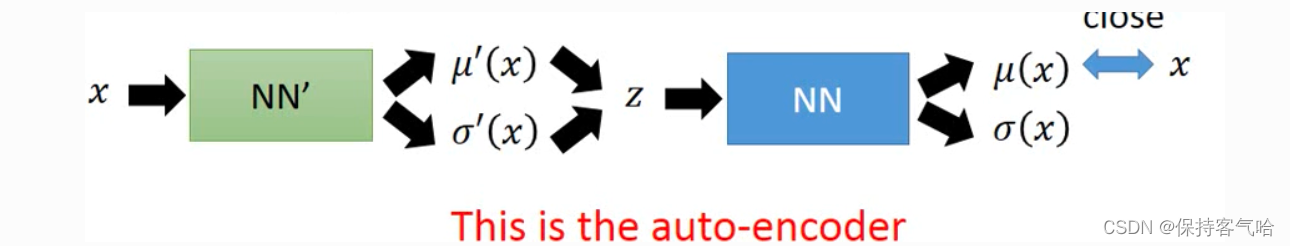

VisualGLM 6B VS Dall·E模型实现思路区别

Dall·E:将图像视作一种语言,将其转化为离散化的Token并进行训练,优势在 于能够非常详细的描述一张图片,但缺点在于图像的Token利用率较低,需要 1000以上的Token才能描述一张256分辨率的图; VisualGLM:考虑到人类在认识图片的时候,往往只对少量视觉语意信息感兴 趣,因此可以不用将整个图片全部离散化为图片,只将图片特征对其到预训练 语言模型即可,这也是BLIP-2的视觉语言与训练方法实现策略。优势在于能够 充分语言模型,缺点在于会缺失图像部分底层信息(细节信息);

医学影像诊断大模型:XrayGLM 6B

项目地址:https://github.com/WangRongsheng/XrayGLM

基于VisualGLM模型,在UI-XRay医学诊断报告数据集上进行微调而来; 报告翻译借助OpenAI GPT模型完成翻译,微调框架为LoRA;

——————————————————————————————————

中文大模型学习首选——ChatGLM 6B

- 低⻔槛上手使用,最低2080Ti即可运行;

- 中英双语大模型,其中中文提示效果更佳;

- 较为丰富的对话UI、微调、AI开发项目生态;

- 大神云集的项目开发和维护团队;

- 率先提出多模态大模型VisualGLM;

- 非常活跃的开源社区,已经越来越多的微调和实践应用场景,未来发展极具潜力;