这个 是摘要的前部分

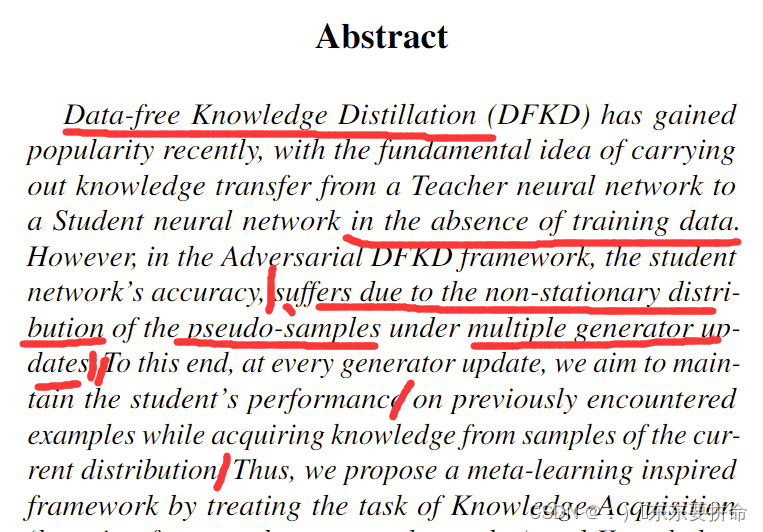

摘要

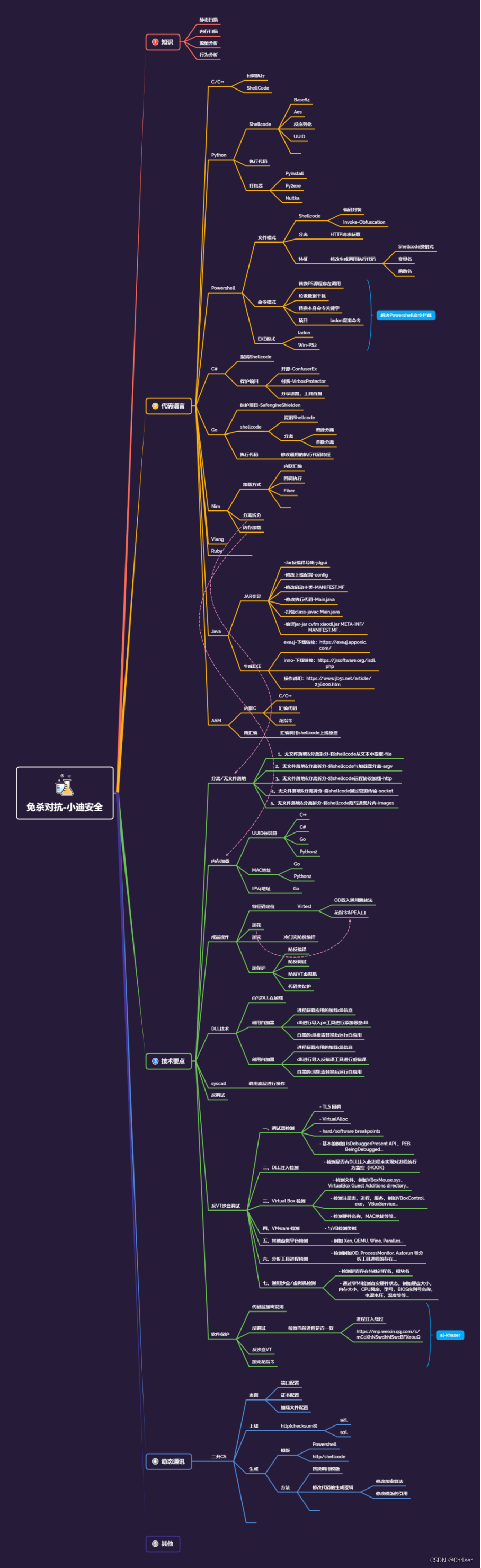

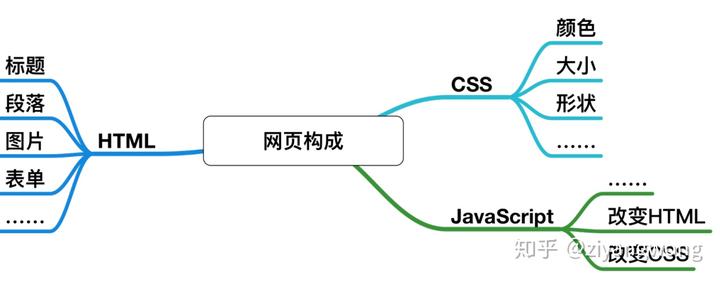

简单的提及 无数据的蒸馏 是怎么样的

和普通的蒸馏有一个本质的区别:没有训练数据

很火啊 最近

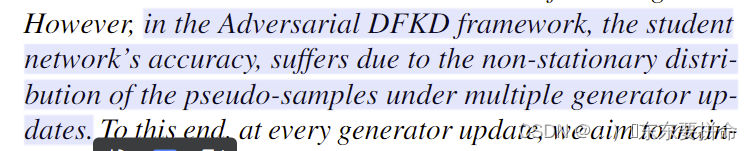

在对抗性的蒸馏框架中呢 存在一个问题

由于多个生成器生成的 非平稳分布的pseudo-samples 导致了学生网络的性能不好

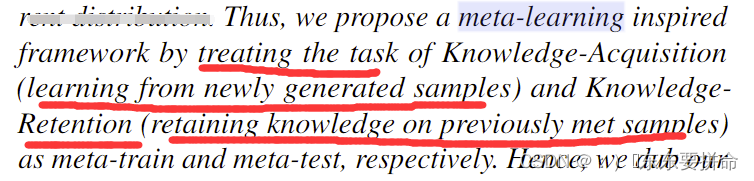

提出一个解决方案的ideal

为此呢 有个ideal 想在每个生成器更新的时候,

学习之前遇到的样本并同时从当前样本分布中获取知识。。。还没太看懂(描述不准确)

来维持学生的性能

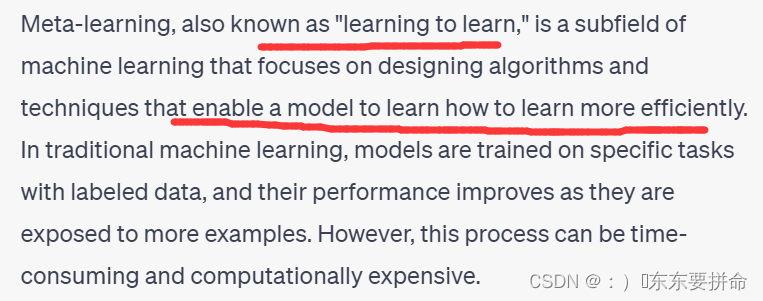

浅浅的看一看meta-learning

其实挺有意义的

我们往下走

然后做了大量的实验 验证了 这篇提出来的假设和方法