GPT-4(Generative Pretrained Transformer 4)是 OpenAI 的最新语言生成模型,其在各类文本生成任务中表现优秀,深受开发者和研究者喜爱。这篇教程将帮助你理解 GPT-4 的基本概念,并向你展示如何使用它来生成文本。

什么是 GPT-4?

GPT-4 是基于 Transformer 架构的语言生成模型。相较于其前代模型,GPT-4 的模型规模更大,训练数据更丰富,因此能够生成更为逼真的人类语言文本。GPT-4,全称为Generative Pre-training Transformer 4,是OpenAI发布的最新的自然语言处理模型。它是GPT-3的后续版本,继续扩大了模型的规模,并引入了一些新的技术来提高性能和效率。

GPT-4继续采用了GPT系列的核心设计理念,即使用大规模的无监督预训练,然后在特定任务上进行微调。这种方法允许模型从大量的文本数据中学习语言的复杂模式,然后将这些知识应用到各种任务中。

GPT-4的工作原理

GPT-4的核心是一个巨大的Transformer模型。Transformer是一种深度学习模型,最初是为了解决机器翻译任务而设计的。它使用了一种称为自注意力(self-attention)的机制,可以捕捉输入序列中的长距离依赖关系。

在GPT-4中,Transformer模型被训练为一个语言模型,即预测给定的一系列词汇后的下一个词汇。这种任务被称为自回归任务,因为模型需要生成的每个新词都依赖于之前生成的词。

GPT-4的一个关键特性是它的规模。与GPT-3相比,GPT-4的模型规模大大增加,这使得它能够学习更复杂的模式,并在各种任务中实现更好的性能。

如何使用 GPT-4?

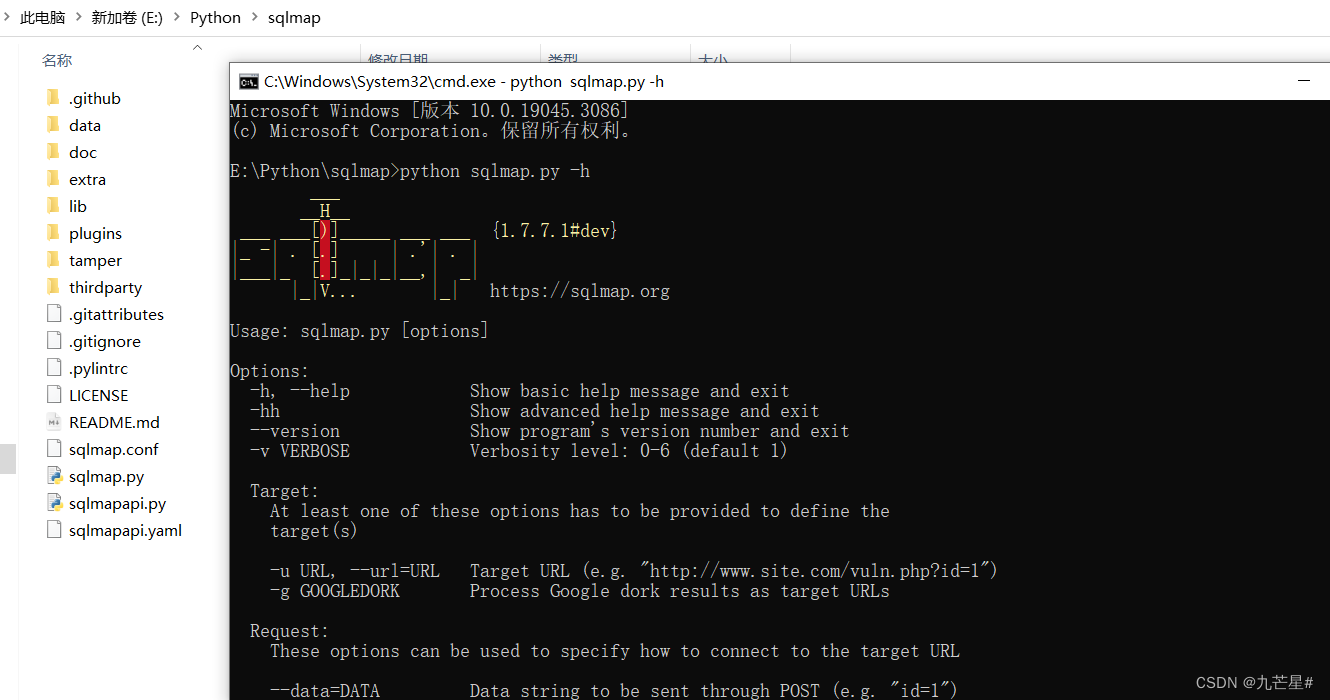

首先,你需要安装必要的 Python 库。使用 pip,你可以轻松安装:

pip install transformers

加载模型

要使用 GPT-4,我们首先需要加载预训练模型和对应的 tokenizer。以下是一个例子:

from transformers import GPT4LMHeadModel, GPT4Tokenizer

tokenizer = GPT4Tokenizer.from_pretrained("gpt4")

model = GPT4LMHeadModel.from_pretrained("gpt4")

生成文本

接下来,我们可以使用加载的模型来生成文本。以下是一个简单的例子:

input_text = "The Earth is the third planet"

input_ids = tokenizer.encode(input_text, return_tensors='pt')

output = model.generate(input_ids, max_length=50, temperature=0.7, num_return_sequences=1)

print(tokenizer.decode(output[0], skip_special_tokens=True))

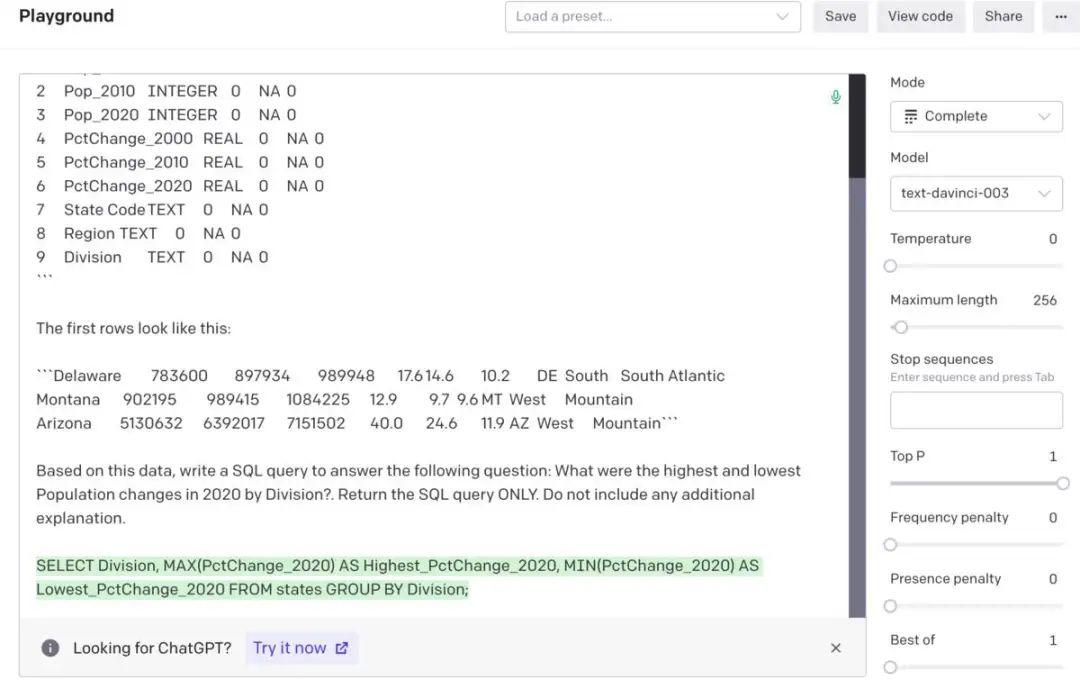

GPT-4的应用

由于GPT-4的强大生成能力,它可以用于各种自然语言处理任务。例如,它可以用于文本生成、机器翻译、问答系统、摘要生成等。此外,由于其大规模的预训练,GPT-4也可以用于一些更复杂的任务,如常识推理和情感分析。

总的来说,GPT-4是一个非常强大的自然语言处理模型,它的工作原理和应用都非常广泛。希望这篇文章能帮助你更好地理解GPT-4的原理和用法。如果你对这个主题有任何问题或想法,欢迎在评论区留言。

![[NLP]Huggingface模型/数据文件下载方法](https://img-blog.csdnimg.cn/bceabd243fac4b2b857d7a770713144c.png)