目录

- 进程启停管理

- 一键启停脚本

- 单进程启停

- 文件系统操作命令

- HDFS文件系统基本信息

- 介绍

- 创建文件夹

- 查看指定目录下内容

- 上传文件到HDFS指定目录

- 查看HDFS文件内容

- 下载HDFS文件

- 拷贝HDFS文件

- 追加数据到HDFS文件

- HDFS数据移动

- HDFS数据删除

- 其他命令

- HDFS WEB浏览

- HDFS权限

- 修改权限

https://www.bilibili.com/video/BV1WY4y197g7?p=26

切换到hadoop用户

su - hadoop

进程启停管理

一键启停脚本

Hadoop HDFS组件内置了HDFS集群的一键启停脚本。

- $HADOOP_HOME/sbin/start-dfs.sh,一键启动HDFS集群

执行原理:- 在执行此脚本的机器上,启动SecondaryNameNode

- 读取core-site.xml内容(fs.defaultFS项),确认NameNode所在机器,启动NameNode

- 读取workers内容,确认DataNode所在机器,启动全部DataNode

start-dfs.sh

- $HADOOP_HOME/sbin/stop-dfs.sh,一键关闭HDFS集群

执行原理:- 在执行此脚本的机器上,关闭SecondaryNameNode

- 读取core-site.xml内容(fs.defaultFS项),确认NameNode所在机器,关闭NameNode

- 读取workers内容,确认DataNode所在机器,关闭全部NameNode

stop-dfs.sh

单进程启停

除了一键启停外,也可以单独控制进程的启停。

- $HADOOP_HOME/sbin/hadoop-daemon.sh,此脚本可以单独控制所在机器的进程的启停

用法:

hadoop-daemon.sh (start|status|stop) (namenode|secondarynamenode|datanode)

start启动、status状态、stop停止

hadoop-daemon.sh start namenode

hadoop-daemon.sh start secondarynamenode

hadoop-daemon.sh start datanode

hadoop-daemon.sh status namenode

hadoop-daemon.sh status secondarynamenode

hadoop-daemon.sh status datanode

hadoop-daemon.sh stop namenode

hadoop-daemon.sh stop secondarynamenode

hadoop-daemon.sh stop datanode

- $HADOOP_HOME/bin/hdfs,此程序也可以用以单独控制所在机器的进程的启停

用法:

hdfs --daemon (start|status|stop) (namenode|secondarynamenode|datanode)

hdfs --daemon start namenode

hdfs --daemon start secondarynamenode

hdfs --daemon start datanode

hdfs --daemon status namenode

hdfs --daemon status secondarynamenode

hdfs --daemon status datanode

hdfs --daemon stop namenode

hdfs --daemon stop secondarynamenode

hdfs --daemon stop datanode

文件系统操作命令

HDFS文件系统基本信息

- 如何区分呢?

Linux:file:///

HDFS:hdfs://namenode:port/ - 如上路径:

Linux:file:///usr/local/hello.txt

HDFS:hdfs://node1:8020/usr/local/hello.txt

协议头file:/// 或 hdfs://node1:8020/可以省略

需要提供Linux路径的参数,会自动识别为file://

需要提供HDFS路径的参数,会自动识别为hdfs://

除非你明确需要写或不写会有BUG,否则一般不用写协议头

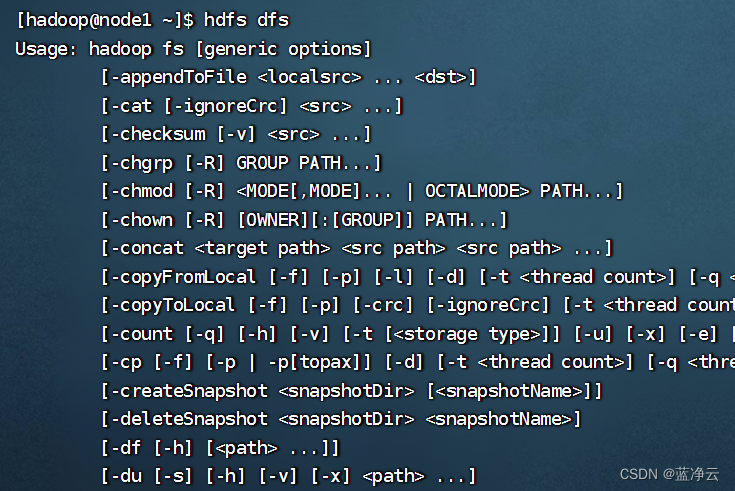

介绍

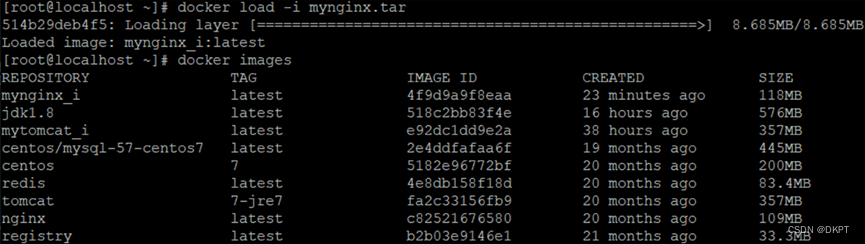

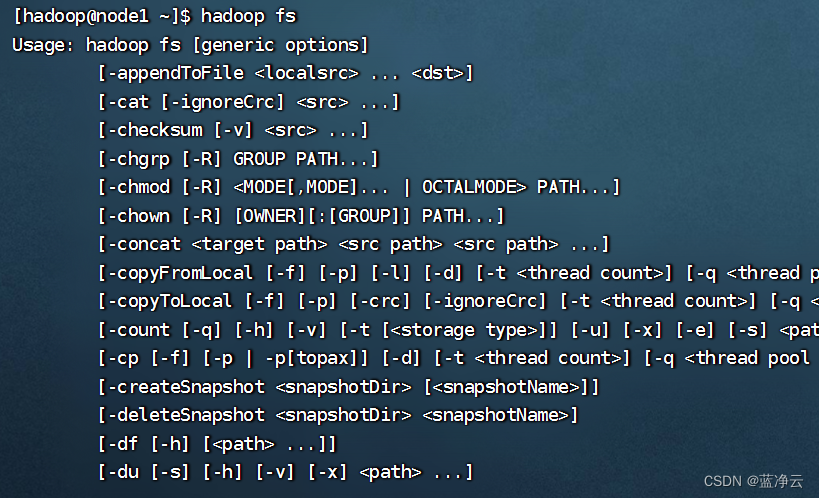

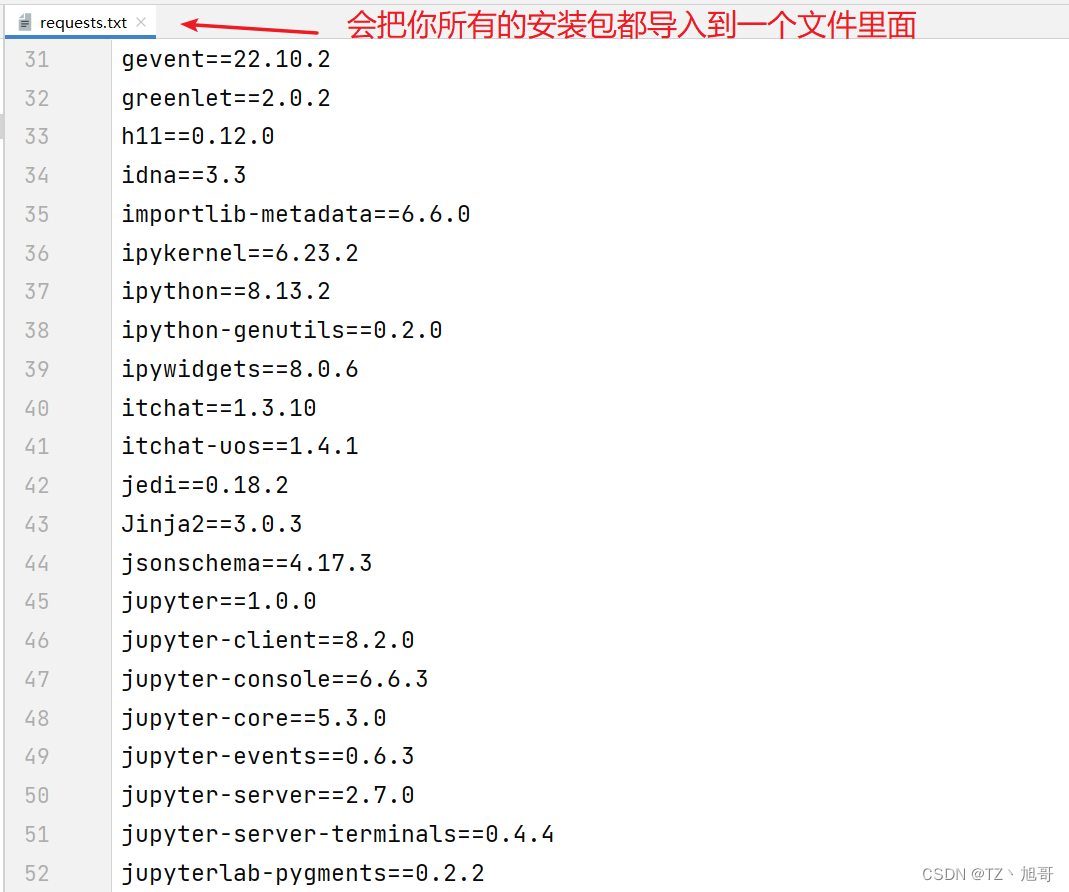

关于HDFS文件系统的操作命令,Hadoop提供了2套命令体系

hadoop命令(老版本用法),用法:hadoop fs [generic options]

hadoop fs

hdfs命令(新版本用法),用法:hdfs dfs [generic options]

hdfs dfs

创建文件夹

用法:

hadoop fs -mkdir [-p] <path> ...

hdfs dfs -mkdir [-p] <path> ...

path 为待创建的目录

-p选项的行为与Linux mkdir -p一致,它会沿着路径创建父目录。

先启动Hadoop集群

start-dfs.sh

创建Linux系统的文件

hadoop fs -mkdir -p file:///home/hadoop/test1

ls

创建HDFS文件系统的文件

hadoop fs -mkdir -p hdfs://node1:8020/test/test2

不写协议头自动识别为需要创建的是HDFS文件系统的文件

hadoop fs -mkdir -p /hello/world/test3

查看指定目录下内容

用法:

hadoop fs -ls [-h] [-R] [<path> ...]

hdfs dfs -ls [-h] [-R] [<path> ...]

path 指定目录路径

-h 人性化显示文件size

-R 递归查看指定目录及其子目录

hadoop fs -ls /

hadoop fs -ls /hello

hadoop fs -ls /hello/world

hadoop fs -ls /test

hadoop fs -ls -R /

上传文件到HDFS指定目录

hadoop fs -put [-f] [-p] <localsrc> ... <dst>

hdfs dfs -put [-f] [-p] <localsrc> ... <dst>

-f 覆盖目标文件(已存在下)

-p 保留访问和修改时间,所有权和权限。

localsrc 本地文件系统(客户端所在机器)

dst 目标文件系统(HDFS)

hadoop fs -put file:///home/hadoop/test.txt hdfs://node1:8020/

hadoop fs -put ./test2.txt /

协议头可写可不写,会自动识别。

查看HDFS文件内容

用法:

hadoop fs -cat <src> ...

hdfs dfs -cat <src> ...

读取指定文件全部内容,显示在标准输出控制台。

hadoop fs -cat /test.txt

读取大文件可以使用管道符配合more

hadoop fs -cat <src> | more

hdfs dfs -cat <src> | more

把test2.txt的内容追加到test.txt,多执行几次,test.txt文件变得很大。

cat test2.txt >> test.txt

覆盖原文件上传

hadoop fs -put -f ./test.txt /

翻页查看,按空格键查看下一页

hadoop fs -cat /test.txt | more

下载HDFS文件

hadoop fs -get [-f] [-p] <src> ... <localdst>

hdfs dfs -get [-f] [-p] <src> ... <localdst>

下载文件到本地文件系统指定目录,localdst必须是目录

-f 覆盖目标文件(已存在下)

-p 保留访问和修改时间,所有权和权限。

hadoop fs -get /test2.txt .

拷贝HDFS文件

hadoop fs -cp [-f] <src> ... <dst>

hdfs dfs -cp [-f] <src> ... <dst>

-f 覆盖目标文件(已存在下)

两个路径都是HDFS文件系统的

hadoop fs -cp /test2.txt /hello/

复制过去,同时改名

hadoop fs -cp /test2.txt /hello/a.txt

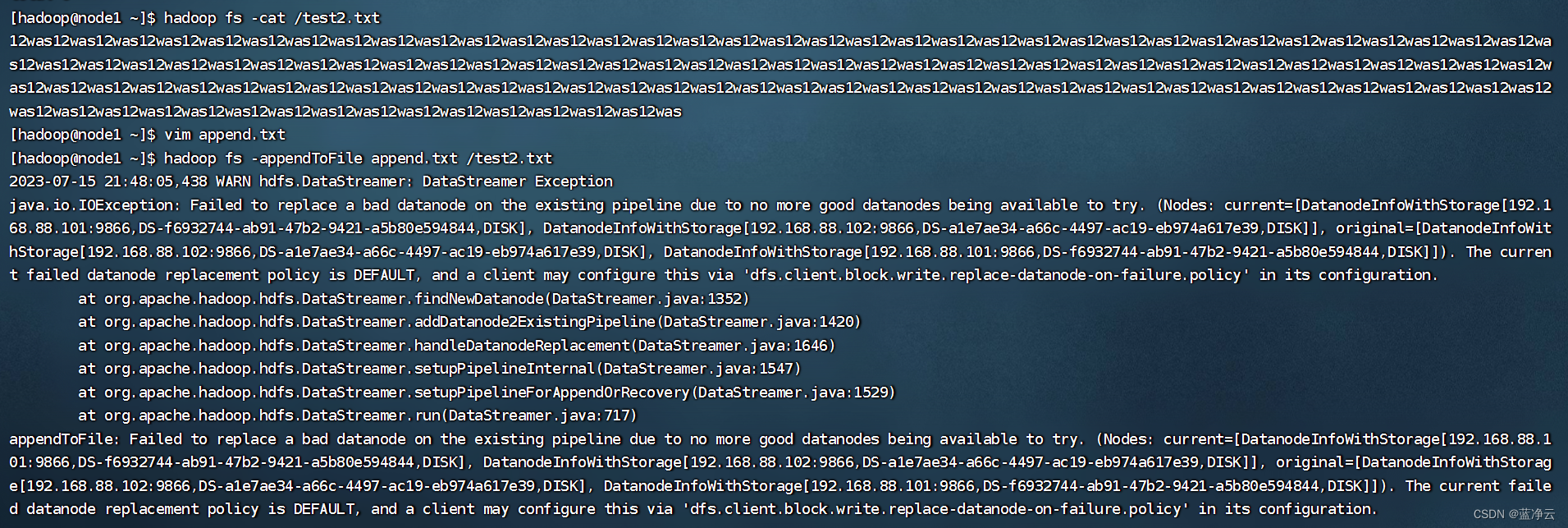

追加数据到HDFS文件

hadoop fs -appendToFile <localsrc> ... <dst>

hdfs dfs -appendToFile <localsrc> ... <dst>

将所有给定本地文件的内容追加到给定dst文件。

dst如果文件不存在,将创建该文件。

如果为-,则输入为从标准输入中读取。

hadoop fs -appendToFile append.txt /test2.txt

报错了,修改配置文件。

cd /export/server/hadoop/etc/hadoop

vim hdfs-site.xml

添加以下内容

<property>

<name>dfs.support.append</name>

<value>true</value>

</property>

<property>

<name>dfs.client.block.write.replace-datanode-on-failure.policy</name>

<value>NEVER</value>

</property>

<property>

<name>dfs.client.block.write.replace-datanode-on-failure.enable</name>

<value>true</value>

</property>

再次执行命令

hadoop fs -appendToFile append.txt /test2.txt

hadoop fs -cat /test2.txt

HDFS数据移动

hadoop fs -mv <src> ... <dst>

hdfs dfs -mv <src> ... <dst>

移动文件到指定文件夹下

可以使用该命令移动数据,重命名文件的名称

hadoop fs -mv /test.txt /test/

移动文件同时改名

hadoop fs -mv /test2.txt /test/a.txt

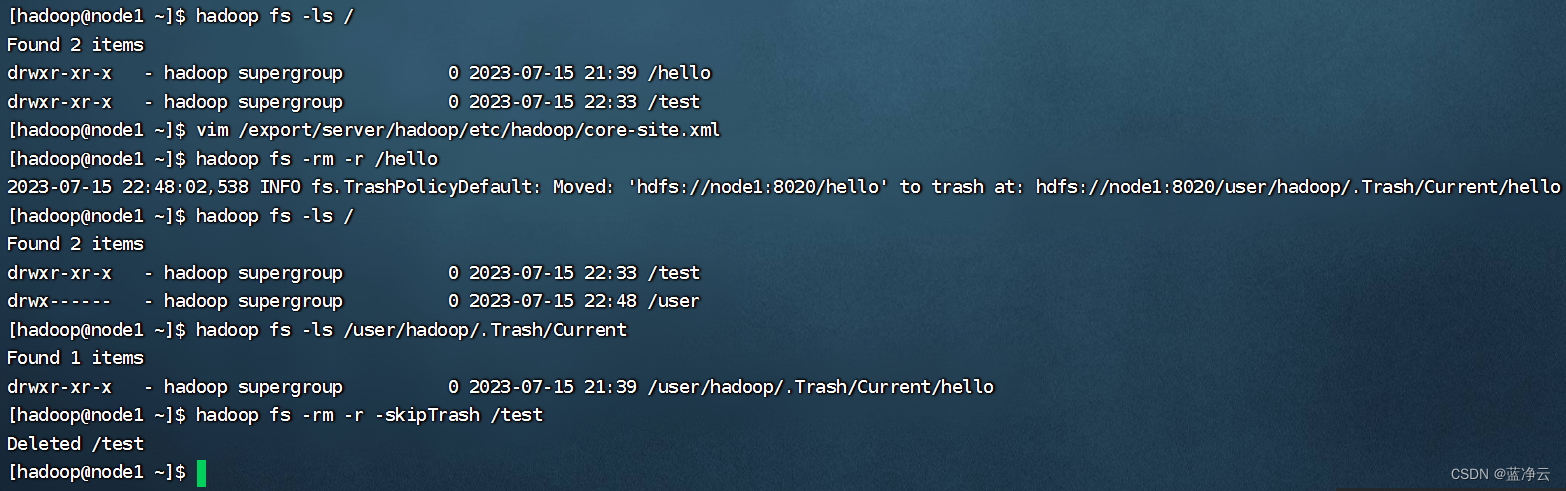

HDFS数据删除

hadoop fs -rm -r [-skipTrash] URI [URI ...]

hdfs dfs -rm -r [-skipTrash] URI [URI ...]

删除指定路径的文件或文件夹

-skipTrash 跳过回收站,直接删除

hadoop fs -rm -r /hello

回收站功能默认关闭,如果要开启需要在core-site.xml内配置:

vim /export/server/hadoop/etc/hadoop/core-site.xml

添加内容

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

<property>

<name>fs.trash.checkpoint.interval</name>

<value>120</value>

</property>

无需重启集群,在哪个机器配置的,在哪个机器执行命令就生效。

回收站默认位置在:/user/用户名(hadoop)/.Trash

其他命令

命令官方指导文档

https://hadoop.apache.org/docs/r3.3.4/hadoop-project-dist/hadoop-common/FileSystemShell.html

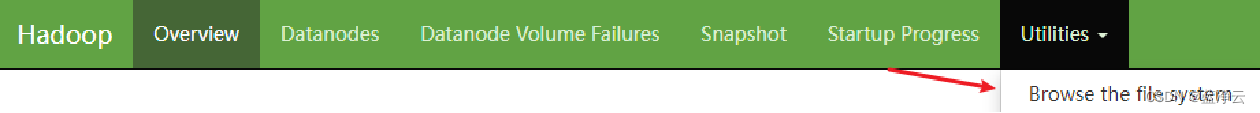

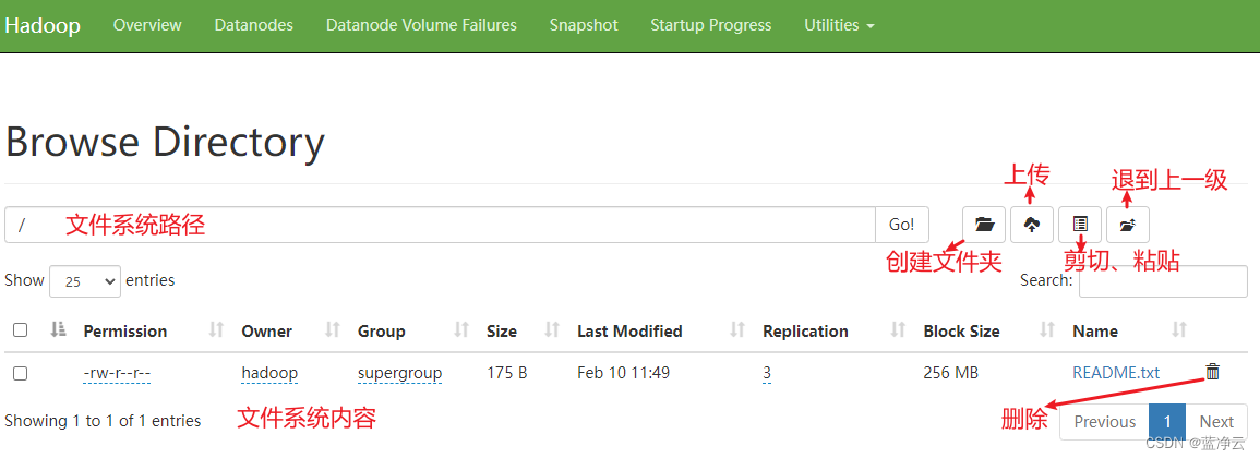

HDFS WEB浏览

http://node1:9870/

除了使用命令操作HDFS文件系统外,在HDFS的WEB UI上也可以查看HDFS文件系统的内容。

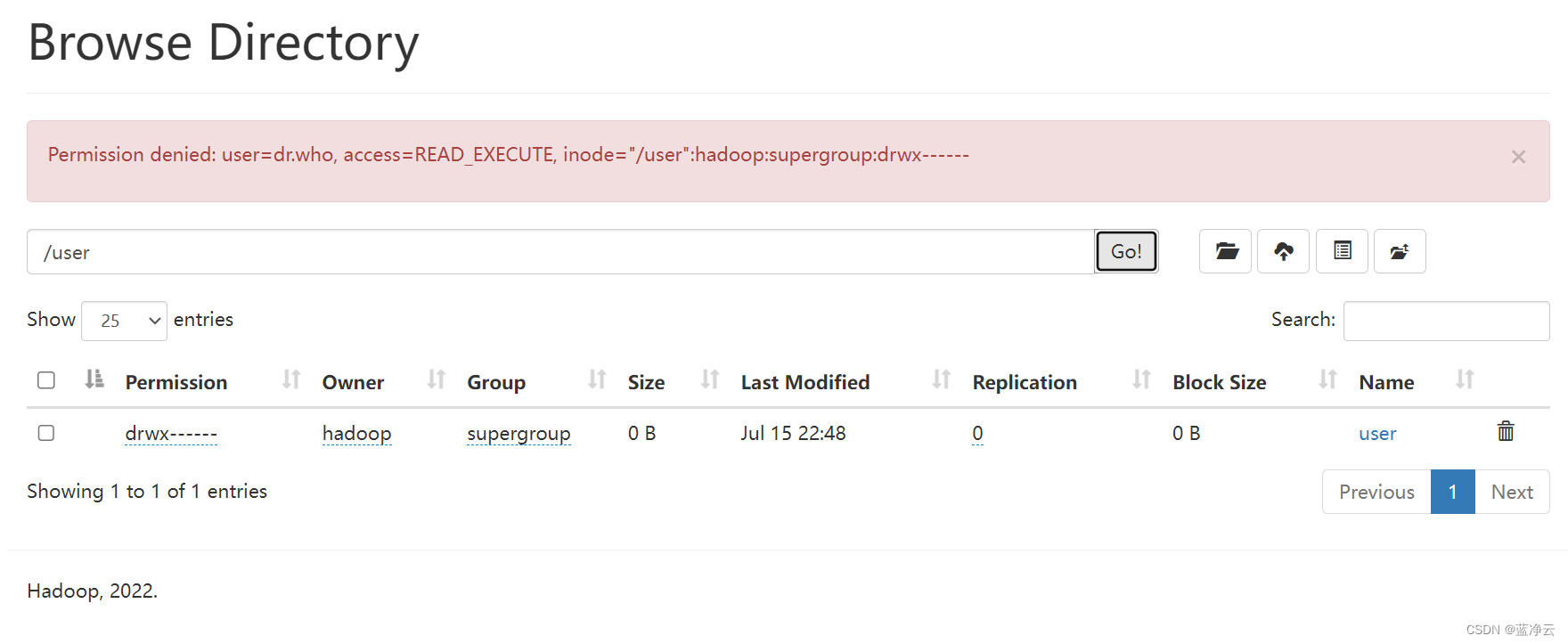

使用WEB浏览操作文件系统,一般会遇到权限问题

这是因为WEB浏览器中是以匿名用户(dr.who)登陆的,其只有只读权限,多数操作是做不了的。

如果需要以特权用户在浏览器中进行操作,需要配置如下内容到core-site.xml并重启集群。

但是,不推荐这样做

HDFS WEBUI,只读权限挺好的,简单浏览即可。

如果给与高权限,会有很大的安全问题,造成数据泄露或丢失。

HDFS权限

修改权限

在HDFS中,可以使用和Linux一样的授权语句,即:chown和chmod

修改所属用户和组:

hadoop fs -chown [-R] root:root /xxx.txt

hdfs dfs -chown [-R] root:root /xxx.txt

修改权限

hadoop fs -chmod [-R] 777 /xxx.txt

hdfs dfs -chmod [-R] 777 /xxx.txt

hadoop fs -chown root:supergroup /test.txt

hadoop fs -chmod 777 /test.txt

![[LINUX]之grep文本过滤](https://img-blog.csdnimg.cn/2d2aa1c719d24763ad74f4840e66c15c.png)