误差分解是将深度学习模型的预测误差拆分为多个组成部分,以便更好地理解模型性能。在深度学习中,我们通常将预测误差分解为三个部分:偏差(Bias)、方差(Variance)和不可避免的误差(Irreducible Error)

用于训练的数据集和你选择的模型一起导致了你的模型的效果,导致的预测误差,也主要是由这两个要素构成的。

偏差(Bias):

偏差衡量了模型预测值与真实值之间的偏离程度。高偏差表示模型的预测结果与真实值相差很大,这通常意味着模型在训练数据上的拟合程度不好**(欠拟合)**。高偏差可能是由于模型过于简单、特征选择不佳或训练时间不足等原因导致的。在深度学习中,简化网络结构(减少层数和神经元数量)可能会导致高偏差。

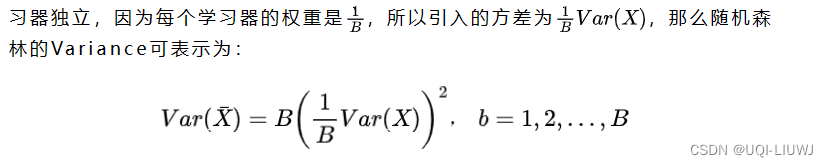

方差(Variance):

方差衡量了模型对训练数据的微小变化的敏感程度。高方差表示模型在不同训练数据集上的预测结果差异较大,这通常意味着模型在训练数据上过度拟合**(过拟合)**。高方差可能是由于模型过于复杂、训练数据噪声太大或样本数量太少等原因导致的。在深度学习中,增加网络结构的复杂度(增加层数和神经元数量)可能会导致高方差。

简而言之,高方差,表示你的模型可能是靠着死记硬背完成了训练,模型并没有真正学会任务。

不可避免的误差(Irreducible Error):

不可避免的误差是由数据本身的噪声引起的,无法通过改进模型来减少。这部分误差与模型的性能无关,而是与数据收集和数据质量有关。

比如我们常说的图像数据集ImageNet,里面有些数据标注,本身就是有问题的,或者说不完美的。

而算法模型以这些不完美的标注数据作为Ground Truth来学习的,所以一定会学习到这种噪声。

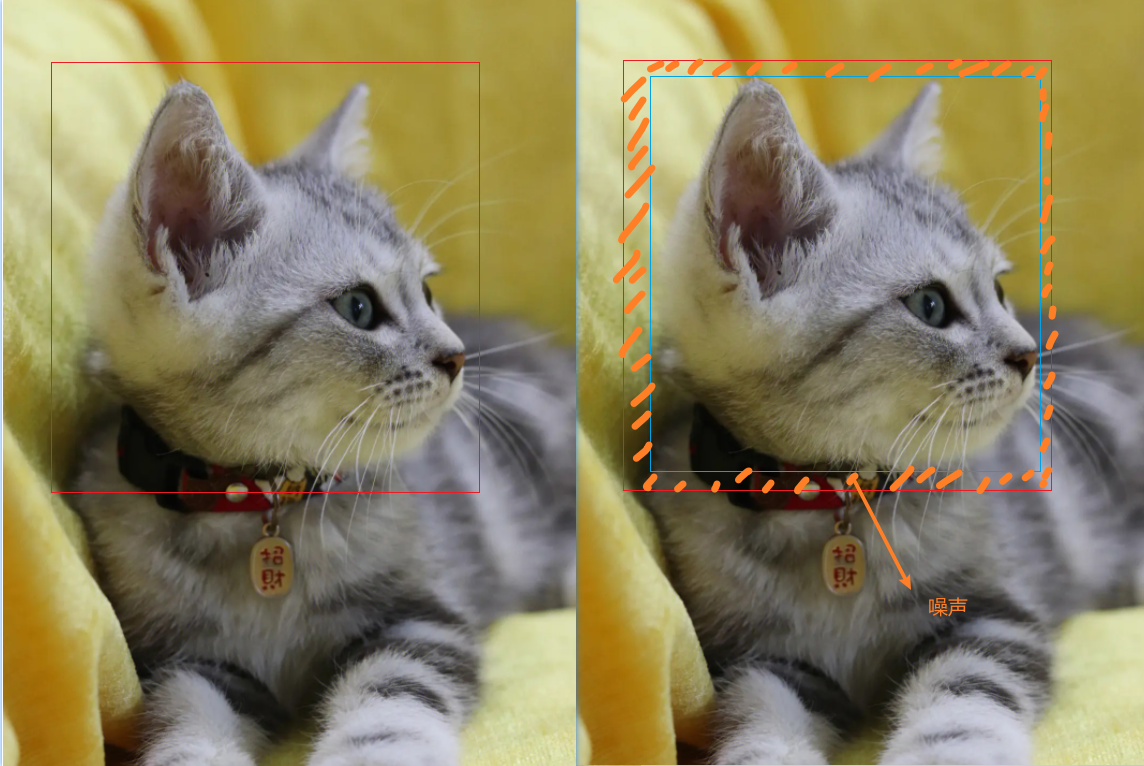

比如在目标检测任务上,我们有一个识别猫的数据集,我们拿到的是左边这种红色标注框,但是我们注意一下,这个标注框其实可以更准确,像右边图片蓝色标注框更准确。不同标注人员提供的这种有个性差异的标注框就是数据集的噪声,它导致了这种irreducible error

在深度学习中,我们通常希望找到一种平衡,既保持较低的偏差(良好的拟合程度),又保持较低的方差(良好的泛化能力)。这称为偏差-方差权衡(Bias-Variance Tradeoff)。

要实现这种权衡,一般可以尝试以下方法:

- 使用更多的数据进行训练,以减少方差。

- 使用数据增强技术,以提高模型对数据变化的鲁棒性。

- 对模型应用正则化(如L1、L2或Dropout),以减轻过拟合。

- 使用交叉验证和早停等技术来选择合适的模型复杂度和超参数。

- 对数据进行降噪和特征选择,以减少不可避免的误差。