目录

0. 相关文章链接

1. 通用的加载和保存方式

1.1. 加载数据

1.2. 保存数据

2. Parquet

2.1. 加载数据

2.2. 保存数据

3. JSON

4. CSV

5. MySQL

5.1. 导入依赖

5.2. 读取数据

5.3. 写入数据

6. Hive

6.1. SparkSQL连接Hive

6.2. 内嵌的 HIVE

6.3. 外部的 HIVE

6.4. 运行 Spark SQL CLI

6.5. 运行 Spark beeline

6.6. 代码操作Hive

0. 相关文章链接

Spark文章汇总

1. 通用的加载和保存方式

SparkSQL 提供了通用的保存数据和数据加载的方式。这里的通用指的是使用相同的API,根据不同的参数读取和保存不同格式的数据, SparkSQL 默认读取和保存的文件格式为 parquet。

1.1. 加载数据

spark.read.load 是加载数据的通用方法

scala> spark.read.

csv format jdbc json load option options orc parquet schema table text textFile如果读取不同格式的数据,可以对不同的数据格式进行设定

scala> spark.read.format("…")[.option("…")].load("…")- format("…"):指定加载的数据类型,包括"csv"、"jdbc"、"json"、"orc"、"parquet"和"textFile"。

- load("…"):在"csv"、"jdbc"、"json"、"orc"、"parquet"和"textFile"格式下需要传入加载数据的路径。

- option("…"):在"jdbc"格式下需要传入 JDBC 相应参数,url、user、password 和 dbtable 。

我们前面都是使用 read API 先把文件加载到 DataFrame 然后再查询,其实,我们也可以直接在文件上进行查询: 文件格式.`文件路径`。

scala>spark.sql("select * from json.`/opt/module/data/user.json`").show1.2. 保存数据

df.write.save 是保存数据的通用方法

scala>df.write.

csv jdbc json orc parquet textFile… …如果保存不同格式的数据,可以对不同的数据格式进行设定

scala>df.write.format("…")[.option("…")].save("…")- format("…"):指定保存的数据类型,包括"csv"、"jdbc"、"json"、"orc"、"parquet"和"textFile"。

- save ("…"):在"csv"、"orc"、"parquet"和"textFile"格式下需要传入保存数据的路径。

- option("…"):在"jdbc"格式下需要传入 JDBC 相应参数,url、user、password 和 dbtable

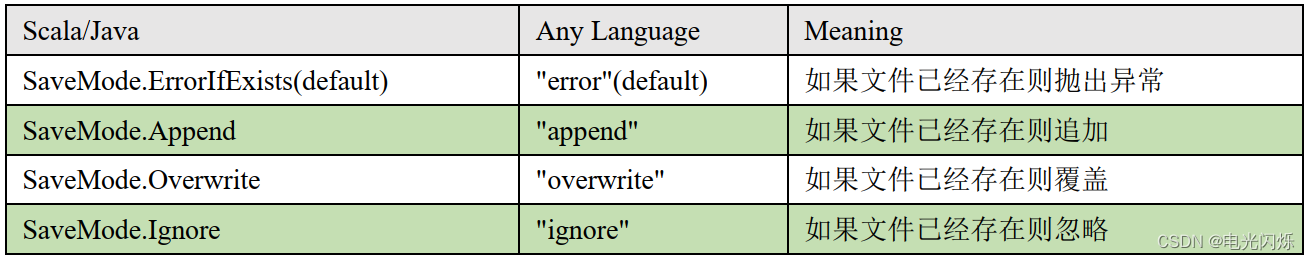

保存操作可以使用 SaveMode, 用来指明如何处理数据,使用 mode()方法来设置。有一点很重要: 这些 SaveMode 都是没有加锁的, 也不是原子操作。

SaveMode 是一个枚举类,其中的常量包括:

df.write.mode("append").json("/opt/module/data/output")2. Parquet

Spark SQL 的默认数据源为 Parquet 格式。 Parquet 是一种能够有效存储嵌套数据的列式存储格式。数据源为 Parquet 文件时, Spark SQL 可以方便的执行所有的操作,不需要使用 format。修改配置项 spark.sql.sources.default,可修改默认数据源格式。

2.1. 加载数据

scala> val df = spark.read.load("examples/src/main/resources/users.parquet")

scala> df.show2.2. 保存数据

scala> var df = spark.read.json("/opt/module/data/input/people.json")

//保存为 parquet 格式

scala> df.write.mode("append").save("/opt/module/data/output")3. JSON

Spark SQL 能够自动推测 JSON 数据集的结构,并将它加载为一个 Dataset[Row]. 可以通过SparkSession.read.json()去加载 JSON 文件。

注意:Spark 读取的 JSON 文件不是传统的 JSON 文件,每一行都应该是一个 JSON 串。格式如下:

{"name":"Michael"}

{"name":"Andy", "age":30}

[{"name":"Justin", "age":19},{"name":"Justin", "age":19}]- 步骤一:导入隐式转换

import spark.implicits._- 步骤二:加载 JSON 文件

val path = "/opt/module/spark-local/people.json"

val peopleDF = spark.read.json(path)- 步骤三:创建临时表

peopleDF.createOrReplaceTempView("people")- 步骤四:数据查询

val teenagerNamesDF = spark.sql("SELECT name FROM people WHERE age BETWEEN 13 AND 19")

teenagerNamesDF.show()

+------+

| name |

+------+

|Justin|

+------+4. CSV

Spark SQL 可以配置 CSV 文件的列表信息,读取 CSV 文件,CSV 文件的第一行设置为数据列,代码如下:

spark

.read

.format("csv")

.option("sep", ";")

.option("inferSchema","true")

.option("header", "true")

.load("data/user.csv")5. MySQL

Spark SQL 可以通过 JDBC 从关系型数据库中读取数据的方式创建 DataFrame,通过对DataFrame 一系列的计算后,还可以将数据再写回关系型数据库中。如果使用 spark-shell 操作,可在启动 shell 时指定相关的数据库驱动路径或者将相关的数据库驱动放到 spark 的类路径下。

bin/spark-shell

--jars mysql-connector-java-5.1.27-bin.jar5.1. 导入依赖

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.27</version>

</dependency>5.2. 读取数据

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.sql.SparkSession

import java.util.Properties

/**

* @ date: 2023/7/4

* @ author: yangshibiao

* @ desc: 项目描述

*/

object BasicModel {

def main(args: Array[String]): Unit = {

// 运行环境

val conf: SparkConf = new SparkConf()

.setAppName("BasicModel")

.setMaster("local[*]")

val spark: SparkSession = SparkSession

.builder()

.config(conf)

.getOrCreate()

val sc: SparkContext = spark.sparkContext

import spark.implicits._

//方式 1:通用的 load 方法读取

spark

.read

.format("jdbc")

.option("url", "jdbc:mysql://linux1:3306/spark-sql")

.option("driver", "com.mysql.jdbc.Driver")

.option("user", "root")

.option("password", "123123")

.option("dbtable", "user")

.load().show

//方式 2:通用的 load 方法读取 参数另一种形式

spark

.read

.format("jdbc")

.options(

Map(

"url" -> "jdbc:mysql://linux1:3306/spark-sql?user=root&password=123123",

"dbtable" -> "user",

"driver" -> "com.mysql.jdbc.Driver"

)

)

.load().show

//方式 3:使用 jdbc 方法读取

val props: Properties = new Properties()

props.setProperty("user", "root")

props.setProperty("password", "123123")

spark

.read

.jdbc("jdbc:mysql://linux1:3306/spark-sql", "user", props)

// 关闭资源

spark.stop()

}

}

5.3. 写入数据

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.sql.{Dataset, SaveMode, SparkSession}

import java.util.Properties

/**

* @ date: 2023/7/4

* @ author: yangshibiao

* @ desc: 项目描述

*/

object BasicModel {

def main(args: Array[String]): Unit = {

// 运行环境

val conf: SparkConf = new SparkConf()

.setAppName("BasicModel")

.setMaster("local[*]")

val spark: SparkSession = SparkSession

.builder()

.config(conf)

.getOrCreate()

val sc: SparkContext = spark.sparkContext

import spark.implicits._

val rdd: RDD[User] = sc.makeRDD(List(User("lisi", 20), User("zs", 30)))

val ds: Dataset[User] = rdd.toDS

//方式 1:通用的方式 format 指定写出类型

ds.write

.format("jdbc")

.option("url", "jdbc:mysql://linux1:3306/spark-sql")

.option("user", "root")

.option("password", "123123")

.option("dbtable", "user")

.mode(SaveMode.Append)

.save()

//方式 2:通过 jdbc 方法

val props: Properties = new Properties()

props.setProperty("user", "root")

props.setProperty("password", "123123")

ds

.write

.mode(SaveMode.Append)

.jdbc("jdbc:mysql://linux1:3306/spark-sql", "user", props)

// 关闭资源

spark.stop()

}

}

case class User(name: String, age: Long)6. Hive

6.1. SparkSQL连接Hive

Apache Hive 是 Hadoop 上的 SQL 引擎,Spark SQL 编译时可以包含 Hive 支持,也可以不包含。包含 Hive 支持的 Spark SQL 可以支持 Hive 表访问、UDF (用户自定义函数) 以及 Hive 查询语言(HiveQL/HQL)等。需要强调的一点是,如果要在 Spark SQL 中包含 Hive 的库,并不需要事先安装 Hive。一般来说,最好还是在编译 Spark SQL 时引入 Hive 支持,这样就可以使用这些特性了。如果你下载的是二进制版本的 Spark,它应该已经在编译时添加了 Hive 支持。

若要把 Spark SQL 连接到一个部署好的 Hive 上,你必须把 hive-site.xml 复制到 Spark 的配置文件目录中($SPARK_HOME/conf)。即使没有部署好 Hive,Spark SQL 也可以运行。 需要注意的是,如果你没有部署好 Hive,Spark SQL 会在当前的工作目录中创建出自己的 Hive 元数据仓库,叫作 metastore_db。此外,如果你尝试使用 HiveQL 中的 CREATE TABLE (并非 CREATE EXTERNAL TABLE)语句来创建表,这些表会被放在你默认的文件系统中的 /user/hive/warehouse 目录中(如果你的 classpath 中有配好的 hdfs-site.xml,默认的文件系统就是 HDFS,否则就是本地文件系统)。 spark-shell 默认是 Hive 支持的;代码中是默认不支持的,需要手动指定(加一个参数即可)。

6.2. 内嵌的 HIVE

如果使用 Spark 内嵌的 Hive, 则什么都不用做, 直接使用即可;但是注意:在实际使用中, 几乎没有任何人会使用内置的 Hive。

Hive 的元数据存储在 derby 中, 默认仓库地址:$SPARK_HOME/spark-warehouse:

scala> spark.sql("show tables").show

+--------+---------+-----------+

|database|tableName|isTemporary|

+--------+---------+-----------+

+--------+---------+-----------+

scala> spark.sql("create table aa(id int)")

scala> spark.sql("show tables").show

+--------+---------+-----------+

|database|tableName|isTemporary|

+--------+---------+-----------+

| default| aa | false |

+--------+---------+-----------+向表加载本地数据:

scala> spark.sql("load data local inpath 'input/ids.txt' into table aa")

scala> spark.sql("select * from aa").show

+---+

| id|

+---+

| 1 |

| 2 |

| 3 |

| 4 |

+---+6.3. 外部的 HIVE

如果想连接外部已经部署好的 Hive,需要通过以下几个步骤:

- Spark 要接管 Hive 需要把 hive-site.xml 拷贝到 conf/目录下

- 把 Mysql 的驱动 copy 到 jars/目录下

- 如果访问不到 hdfs,则需要把 core-site.xml 和 hdfs-site.xml 拷贝到 conf/目录下

- 重启 spark-shell

scala> spark.sql("show tables").show

20/04/25 22:05:14 WARN ObjectStore: Failed to get database global_temp, returning NoSuchObjectException

+--------+--------------------+-----------+

|database| tableName |isTemporary|

+--------+--------------------+-----------+

| default| emp | false |

| default|hive_hbase_emp_table| false |

| default| relevance_hbase_emp| false |

| default| staff_hive | false |

| default| ttt | false |

| default| user_visit_action | false |

+--------+--------------------+-----------+6.4. 运行 Spark SQL CLI

Spark SQL CLI 可以很方便的在本地运行 Hive 元数据服务以及从命令行执行查询任务。在Spark 目录下执行如下命令启动 Spark SQL CLI,直接执行 SQL 语句,类似一 Hive 窗口:

bin/spark-sql6.5. 运行 Spark beeline

Spark Thrift Server 是 Spark 社区基于 HiveServer2 实现的一个 Thrift 服务。旨在无缝兼容HiveServer2。因为 Spark Thrift Server 的接口和协议都和 HiveServer2 完全一致,因此我们部署好 Spark Thrift Server 后,可以直接使用 hive 的 beeline 访问 Spark Thrift Server 执行相关语句。Spark Thrift Server 的目的也只是取代 HiveServer2,因此它依旧可以和 Hive Metastore进行交互,获取到 hive 的元数据。

如果想连接 Thrift Server,需要通过以下几个步骤:

- Spark 要接管 Hive 需要把 hive-site.xml 拷贝到 conf/目录下

- 把 Mysql 的驱动 copy 到 jars/目录下

- 如果访问不到 hdfs,则需要把 core-site.xml 和 hdfs-site.xml 拷贝到 conf/目录下

- 启动 Thrift Server

sbin/start-thriftserver.sh- 使用 beeline 连接 Thrift Server

sbin/start-thriftserver.sh

6.6. 代码操作Hive

- 导入依赖

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_2.12</artifactId>

<version>3.0.0</version>

</dependency>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>1.2.1</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.27</version>

</dependency>- 将 hive-site.xml 文件拷贝到项目的 resources 目录中,代码实现

//创建 SparkSession

val spark: SparkSession = SparkSession

.builder()

.enableHiveSupport()

.master("local[*]")

.appName("sql")

.getOrCreate()- 注意:在开发工具中创建数据库默认是在本地仓库,通过参数修改数据库仓库的地址

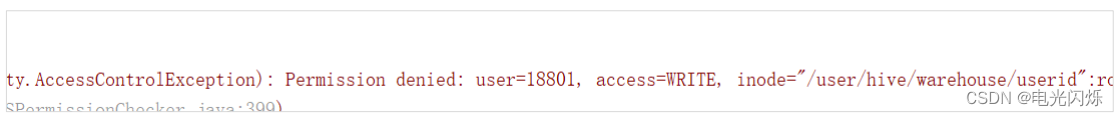

config("spark.sql.warehouse.dir", "hdfs://linux1:8020/user/hive/warehouse")- 如果在执行操作时,出现如下错误,可以代码最前面增加设置用户解决(此处的 root 改为你们自己的 hadoop 用户名称即可,如果使用的是CDH安装,一般设置为hdfs为root用户,针对hive的目录,一般是为hive用户):

System.setProperty("HADOOP_USER_NAME", "root")注:其他Spark相关系列文章链接由此进 -> Spark文章汇总

![[工业互联-22]:常见EtherCAT主站方案:Acontis公司的商用Windows 解决方案](https://img-blog.csdnimg.cn/a9626e0ca11a4f6ab8927d306e415816.png)