深度卷积网络的实际应用

1、三种经典的深度卷积网络

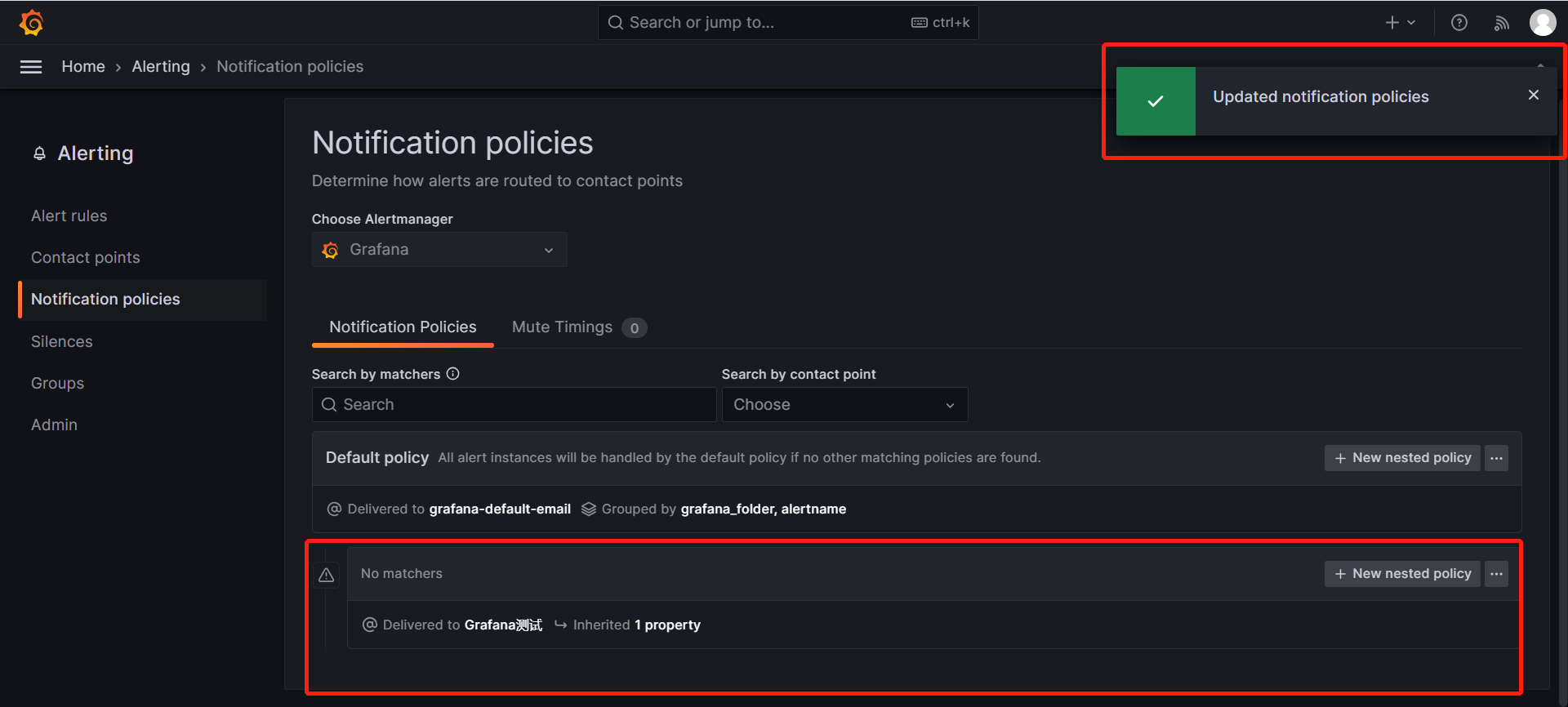

1.1、LeNet-5

使用 sigmoid 函数和 tanh 函数,而不是ReLu 函数,这篇论文中使用的正是 sigmoid 函数和 tanh 函数 LeNet-5 是针对灰度图片训练的,所以图片的大小只有 32×32×1

6

个

5×5 的过滤器,步幅为 1

。由于使用了

6

个过滤器,步幅为

1

,

padding 为

0

,输出结果为

28×28×6

, 图像尺寸从 32×32

缩小到

28×28

。然后进行池化操作

接下来是卷积层,用一组

16

个

5×5

的过滤器,新的输出结果有

16

个通道

池化层,高度和宽度再缩小一半,输出一个

5×5×16

的图像。将所有数字相 乘,乘积是 400

全连接层,在全连接层中,有

400

个节点,每个节点有

120

个神经元,这里已 经有了一个全连接层。但有时还会从这 400

个节点中抽取一部分节点构建另一个全连接层, 就像这样,有 2

个全连接层

最后一步就是利用这

84

个特征得到最后的输出,我们还可以在这里再加一个节点用来 预测𝑦^

的值,

𝑦^

有

10

个可能的值,对应识别

0-9

这

10

个数字

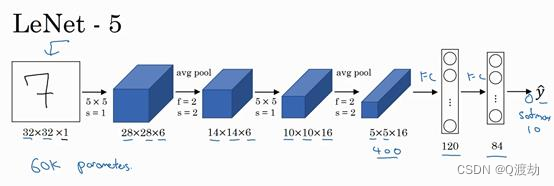

1.2、AlexNet

实际上,这种神经网络与

LeNet 有很多相似之处,不过

AlexNet 要大得多。正如前面讲

到的

LeNet 或

LeNet-5 大约有

6

万个参数,而

AlexNet 包含约

6000

万个参数。当用于训练图 像和数据集时,AlexNet 能够处理非常相似的基本构造模块,这些模块往往包含着大量的隐 藏单元或数据,这一点

AlexNet 表现出色。

AlexNet 比

LeNet 表现更为出色的另一个原因是它使用了

ReLu 激活函数。

GPU 的处理速度还比较慢,所以

AlexNet 采用了非常复杂的 方法在两个

GPU 上进行训练。大致原理是,这些层分别拆分到两个不同的

GPU 上,同时还 专门有一个方法用于两个

GPU 进行交流

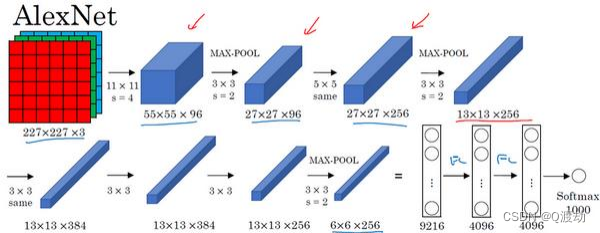

1.3、VGG

2、残差网络

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.coloradmin.cn/o/737610.html

如若内容造成侵权/违法违规/事实不符,请联系多彩编程网进行投诉反馈,一经查实,立即删除!

![[MMDetection]测试模型](https://img-blog.csdnimg.cn/4572b274a4b748e38ac3ab1f2ecf7732.png)