公众号:尤而小屋

作者:Peter

编辑:Peter

大家好,我是Peter~

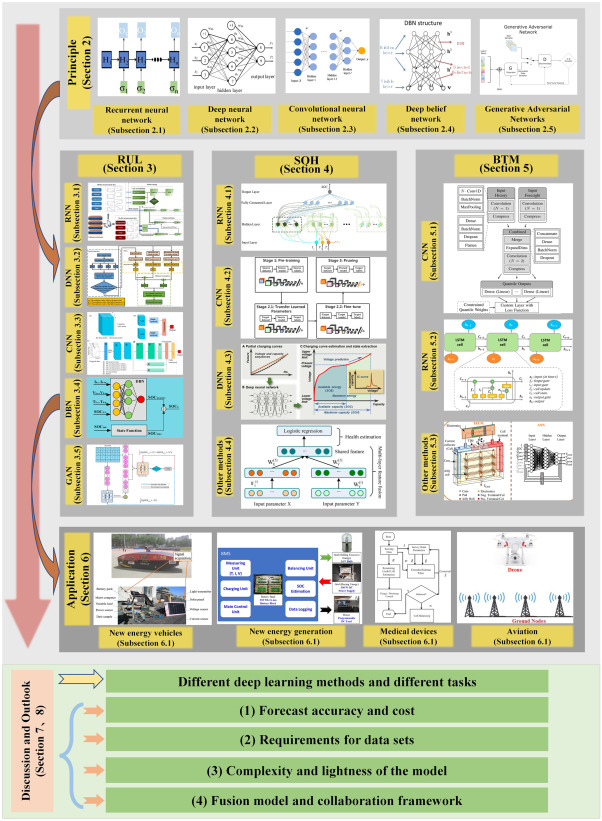

今天给大家分享一篇关于深度学习在Li电池RUL、SOH和电池热管理中的研究进展与应用的文献综述。文献基本信息介绍:

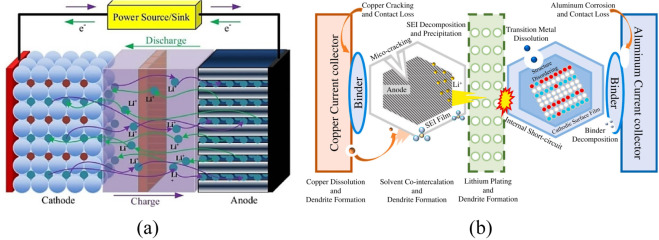

本文系统介绍了Deep Learning深度学习的不同方法在锂电池剩余使用寿命(RUL)、健康状态(SOH)和电池热管理(BTM)预测中的应用。本文综述从预测性能、优点和缺点等方面评估了不同的深度学习方法来进行电池估计和预测。

此外,本文还讨论了上述应用中影响充放电循环、复杂环境、动态条件和不同电池类型的不同算法的特点、成就、局限性和改进方向。

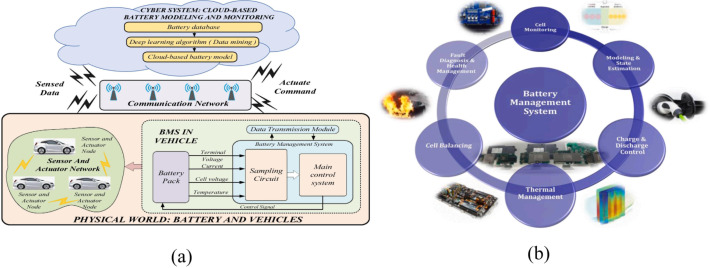

Different methods of DL for BMS(电池管理系统)

BMS:battery management system 电池管理系统。

循环神经网络Recurrent Neural Network-RNN

循环神经网络的基本结构是在处理单元之间既有内部的反馈连接又有前馈连接,这种结构使其具有记忆的能力,类似于人一样。这种能力使得RNN可以解决一些卷积神经网络(CNN)和传统神经网络无法处理的问题.

RNN的主要应用是处理和预测序列数据。它可以借助循环核(cell)从时间维度提取信息,并将提取的特征送入后续网络进行预测等操作。循环核具有记忆力,通过不同时刻的参数共享,实现了对时间序列的信息提取。

在RNN中,隐层的权重是共享的,这意味着同一组权重被多次复用,从而提高了模型的效率和表达能力。

h t = H ( W x h x t + W h h h t − 1 + b h ) y t = W h y h t + b y \begin{aligned} h_{t} & =\mathscr{H}\left(W_{x h} x_{t}+W_{h h} h_{t-1}+b_{h}\right) \\ y_{t} & =W_{h y} h_{t}+b_{y}\end{aligned} htyt=H(Wxhxt+Whhht−1+bh)=Whyht+by

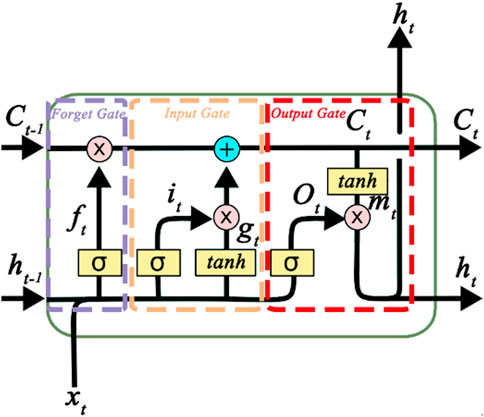

以LSTM为代表:

长短期记忆模型(Long Short-Term Memory,LSTM)是一种改进的循环神经网络结构,旨在解决传统RNN面临的梯度消失和梯度爆炸问题。

LSTM通过引入记忆单元(memory cell)和门控单元(gating unit)来实现在时间维度上的长期依赖。记忆单元用于存储历史信息,而门控单元则控制记忆单元的写入和读取。

LSTM模型的结构包括三个部分:

- 输入门(input gate): 输入门控制当前输入和前一时刻的输出对记忆单元的影响

- 遗忘门(forget gate): 遗忘门控制前一时刻的记忆单元对当前时刻的影响

- 输出门(output gate): 输出门控制当前时刻的记忆单元对输出值的影响

LSTM模型的优点在于:

能够更好地处理长时间序列,避免梯度消失和梯度爆炸问题。

具有较强的记忆能力,能够较好地捕捉历史信息对当前任务的影响。

可以通过不同的参数设置来控制记忆的长度,从而适应不同的任务需求。

i t = σ ( W x i x t + W h i x t − 1 + W c i x t − 1 + b i ) f t = σ ( W x f x t + W h f x t − 1 + W c f x t − 1 + b f ) c t = f t c t − 1 + i t tanh ( W x c x t + W h c x t − 1 + b c ) o t = σ ( W x o x t + W h o h t − 1 + W c o c t + b o ) h t = o t tanh ( c t ) \begin{aligned} i_{t} & =\sigma\left(W_{x i} x_{t}+W_{h i} x_{t-1}+W_{c i} x_{t-1}+b_{i}\right) \\ f_{t} & =\sigma\left(W_{x f} x_{t}+W_{h f} x_{t-1}+W_{c f} x_{t-1}+b_{f}\right) \\ c_{t} & =f_{t} c_{t-1}+i_{t} \tanh \left(W_{x c} x_{t}+W_{h c} x_{t-1}+b_{c}\right) \\ o_{t} & =\sigma\left(W_{x o} x_{t}+W_{h o} h_{t-1}+W_{c o} c_{t}+b_{o}\right) \\ h_{t} & =o_{t} \tanh \left(c_{t}\right)\end{aligned} itftctotht=σ(Wxixt+Whixt−1+Wcixt−1+bi)=σ(Wxfxt+Whfxt−1+Wcfxt−1+bf)=ftct−1+ittanh(Wxcxt+Whcxt−1+bc)=σ(Wxoxt+Whoht−1+Wcoct+bo)=ottanh(ct)

门控单元GRU:

门控单元(Gated Recurrent Unit,GRU)是一种结合了LSTM和传统RNN特点的循环神经网络结构,旨在解决传统RNN面临的梯度消失和梯度爆炸问题。

GRU通过引入门控单元来实现在时间维度上的信息交换和选择。门控单元通过sigmoid函数控制信息的写入和读取。

GRU模型的结构包括三个部分:

- 重置门(reset gate):重置门控制前一时刻的状态信息对当前时刻的影响

- 更新门(update gate):更新门控制当前时刻的输入信息对状态的影响

- 输出门(output gate):输出门控制当前时刻的状态信息对输出的影响。

GRU模型的优点在于:

能够更好地处理长时间序列,避免梯度消失和梯度爆炸问题。

能够根据任务需求灵活地调整信息的写入和读取方式,提高模型的适应性和效率。

结构相对简单,参数较少,训练效率较高。

r t = σ ( W t ⋅ [ h t − 1 , x t ] ) z t = σ ( W z ⋅ [ h t − 1 , x t ] ) h t ~ = tanh ( W h ~ ⋅ [ r t ⋅ h t − 1 , x t ] ) \begin{aligned} r_{t} & =\sigma\left(W_{t} \cdot\left[h_{t-1}, x_{t}\right]\right) \\ z_{t} & =\sigma\left(W_{z} \cdot\left[h_{t-1}, x_{t}\right]\right) \\ \widetilde{h_{t}} & =\tanh \left(W_{\tilde{h}} \cdot\left[r_{t} \cdot h_{t-1}, x_{t}\right]\right)\end{aligned} rtztht =σ(Wt⋅[ht−1,xt])=σ(Wz⋅[ht−1,xt])=tanh(Wh~⋅[rt⋅ht−1,xt])

深度神经网络Deep Neural Network-DNN

深度神经网络(Deep Neural Network,DNN)是一种多层神经网络,由多个传统神经网络组成。

DNN的基本结构是堆叠多个神经网络层,每一层负责从输入数据中提取不同层次的特征。每一层网络的输出作为下一层网络的输入,从而实现对数据的逐层特征提取和表示。

在DNN中,每个神经网络层可以由多个神经元组成。每个神经元接收输入数据,并通过激活函数(activation function)对数据进行处理和变换。常见的激活函数有sigmoid、tanh、ReLU等。

DNN的训练过程通常采用反向传播算法(backpropagation algorithm),通过最小化损失函数(loss function)来调整网络的参数,以提高网络的预测准确性和泛化能力。

a l = σ ( W l a l − 1 + b l ) a^{l}=\sigma\left(W^{l} a^{l-1}+b^{l}\right) al=σ(Wlal−1+bl)

卷积神经网络Convolutional Neural Network-CNN

CNN是一种由卷积层(convolutional layer)、池化层(pooling layer)、全连接层(fully connected layer)组成的神经网络。其中,卷积层和池化层通常交替堆叠,构成网络的主干部分。

-

卷积层是CNN的核心部分,用于从输入数据中学习局部特征。卷积操作通过共享权值的方式,减小了网络的参数数量,同时能够捕捉到数据的空间结构。

-

池化层则用于降低数据的维度,减少计算量并提高网络的泛化能力。常见的池化操作有最大池化(max pooling)和平均池化(average pooling)等。

-

全连接层则是将网络中的所有节点进行全连接,用于对数据进行分类或回归。

CNN被广泛应用于计算机视觉、图像处理等任务中,如图像分类、目标检测、图像分割等。通过捕捉图像的局部特征和空间结构,CNN可以实现对图像的鲁棒性和高效分类。

z i l = x i l ∗ w l + b l a i l = a ( z i l ) v i , j l = pool ( a m , n l ) , ∨ ( m , n ) ∈ R i j \begin{aligned} z_{i}^{l} & =x_{i}^{l} * w^{l}+b^{l} \\ a_{i}^{l} & =a\left(z_{i}^{l}\right) \\ v_{i, j}^{l} & =\operatorname{pool}\left(a_{m, n}^{l}\right), \vee(m, n) \in R_{i j}\end{aligned} zilailvi,jl=xil∗wl+bl=a(zil)=pool(am,nl),∨(m,n)∈Rij

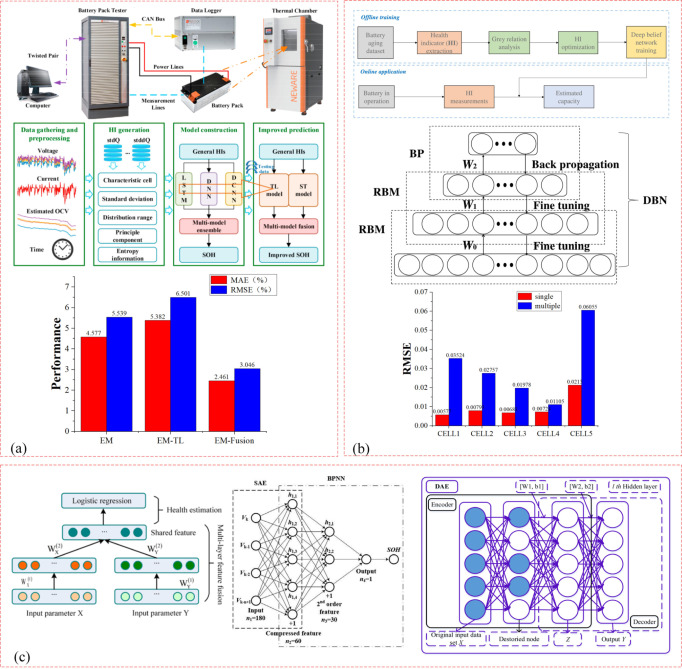

深度置信网络Deep Belief Network-DBN

深度置信网络(Deep Belief Network,DBN)是一种基于深度学习的概率生成模型,通过训练其神经元间的权重,我们可以让整个神经网络按照最大概率来生成训练数据。

DBN是一种多层神经网络,由多个限制玻尔兹曼机(Restricted Boltzmann Machine,RBM)组成。每个RBM包含一个可见层(visible layer)和一个隐层(hidden layer),且每层之间的连接是全连接的。

DBN的学习过程是分层无监督的,即逐层训练每一层的参数,以减小网络的整体误差。在训练过程中,可以通过预训练(pre-training)来优化网络的参数,从而提高网络的表达能力和泛化能力。

除了作为非监督学习模型,DBN还可以作为特征提取器使用。通过对输入数据进行逐层的训练和特征提取,可以得到不同层次的特征表示,从而更好地捕捉数据在不同层次的特征和相关性。

E ( v , h ) = − ∑ i = 1 m v a i v i − ∑ j = 1 m h b j h j − ∑ i = 1 m i ∑ j = 1 m h h j w i , j v i p ( v , h ) = ∑ e e − E ( r , h ) Z p ( v = 1 ∣ h ) = σ ( b j + ∑ j w i , j h j ) p ( h = 1 ∣ v ) = σ ( a i + ∑ i w i , j v i ) \begin{array}{l}E(v, h)=-\sum_{i=1}^{m_{v}} a_{i} v_{i}-\sum_{j=1}^{m_{h}} b_{j} h_{j}-\sum_{i=1}^{m_{i}} \sum_{j=1}^{m_{h}} h_{j} w_{i, j} v_{i} \\ p(v, h)=\frac{\sum_{\mathrm{e}} e^{-E(r, h)}}{Z} \\ p(v=1 \mid h)=\sigma\left(b_{j}+\sum_{j} w_{i, j} h_{j}\right) \\ p(h=1 \mid v)=\sigma\left(a_{i}+\sum_{i} w_{i, j} v_{i}\right)\end{array} E(v,h)=−∑i=1mvaivi−∑j=1mhbjhj−∑i=1mi∑j=1mhhjwi,jvip(v,h)=Z∑ee−E(r,h)p(v=1∣h)=σ(bj+∑jwi,jhj)p(h=1∣v)=σ(ai+∑iwi,jvi)

生成对抗网络Generative Adversarial Networks-GAN

生成对抗网络(Generative Adversarial Network,GAN)是一种深度学习模型,主要用于生成式模型的建模和训练。

GAN由两个部分组成:

- 生成器(generator):生成器用于生成与真实数据相似的新数据

- 判别器(discriminator):判别器则用于判断生成器生成的数据是否与真实数据相似。

在GAN的训练过程中,生成器和判别器通过对抗的方式进行优化。生成器的目标是生成更加真实的数据,而判别器的目标则是提高对生成器生成的数据的鉴别能力。

GAN的优点在于其可以生成与真实数据相似的新数据,并且具有很强的鲁棒性和表现力

G ∗ = arg min G max D V ( G , D ) min G max D V ( G , D ) = E x ∼ U u c r ( x ) [ log D ( X ) ] + E x ∼ U z ( z ) [ log ( 1 − D ( G ( z ) ) ) ] \begin{array}{l}G^{*}=\arg \min _{G} \max _{D} V(G, D) \\ \min _{G} \max _{D} V(G, D)=E_{x \sim U_{\mathrm{ucr}}(x)}[\log D(X)]+E_{x \sim U_{z}(z)}[\log (1-D(G(z)))]\end{array} G∗=argminGmaxDV(G,D)minGmaxDV(G,D)=Ex∼Uucr(x)[logD(X)]+Ex∼Uz(z)[log(1−D(G(z)))]

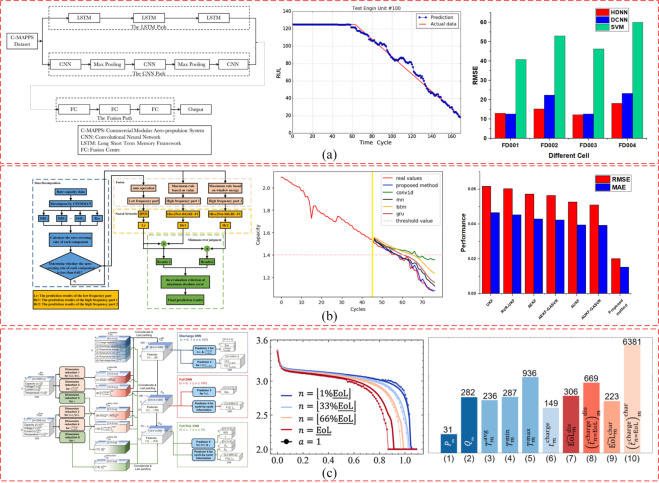

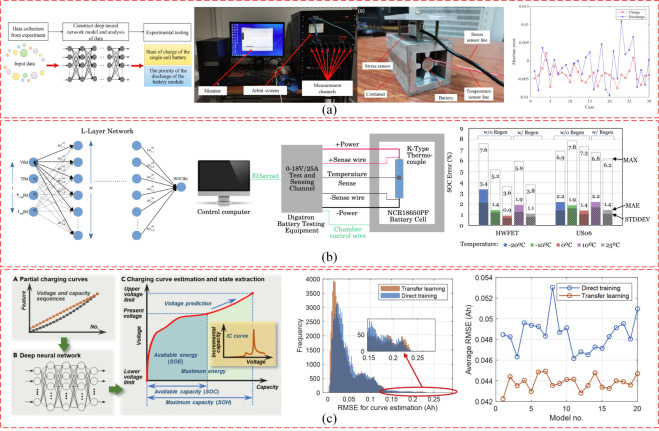

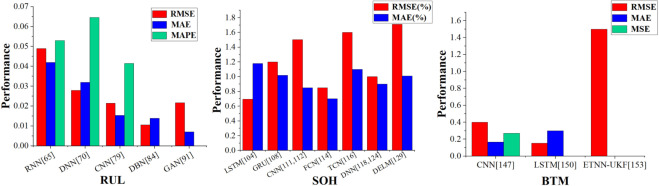

剩余使用寿命Remaining Useful Life-RUL

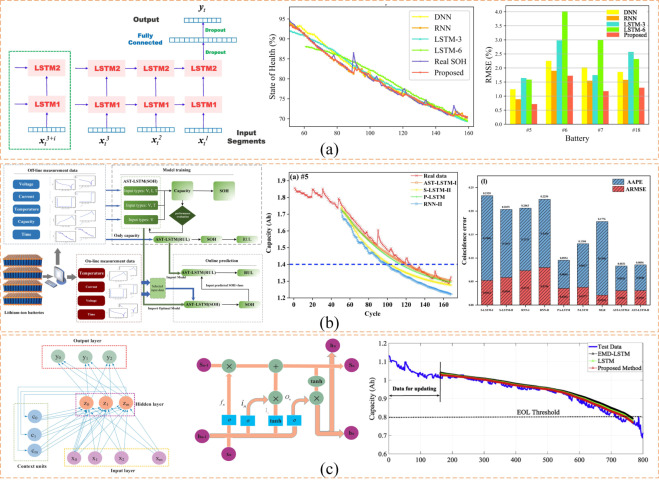

RNN methods

不同的循环神经网络在RUL的应用

DNN methods

不同的DNN网络在RUL的应用

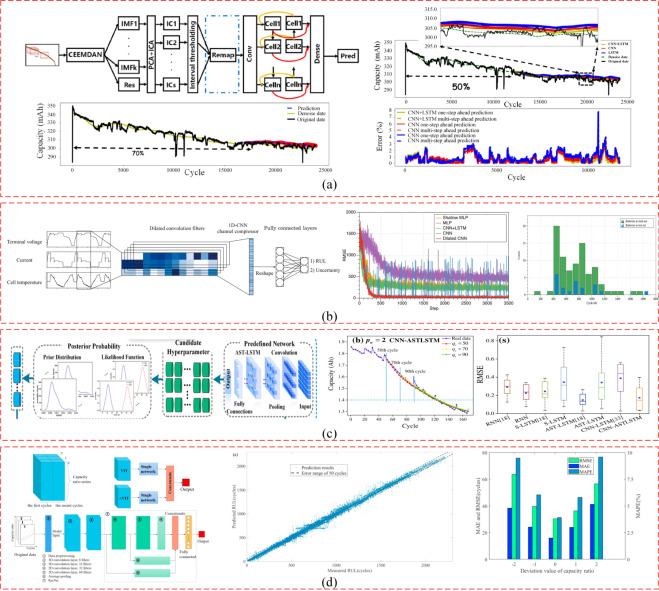

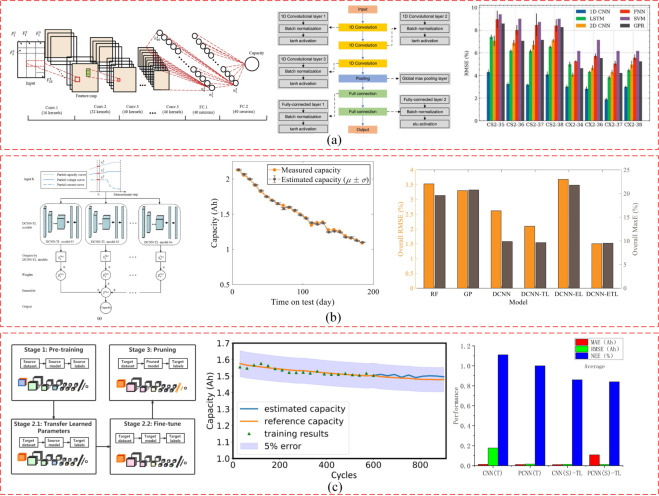

CNN methods

不同的CNN网络在RUL的应用

DBN methods

不同DBN网络在RUL的应用

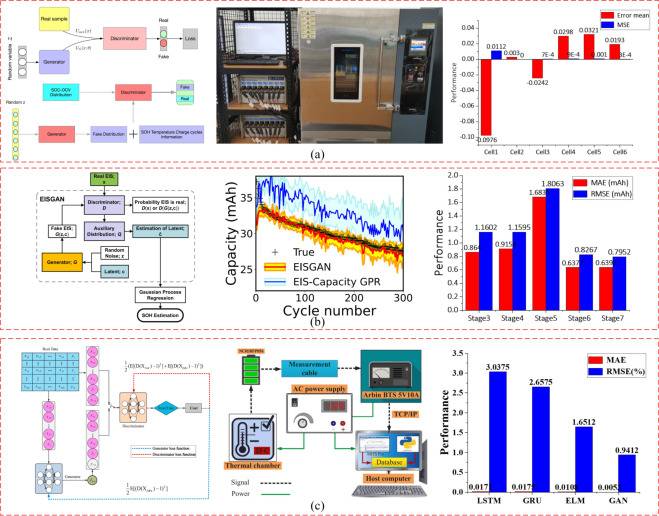

GAN methods

不同GAN网络在RUL的应用

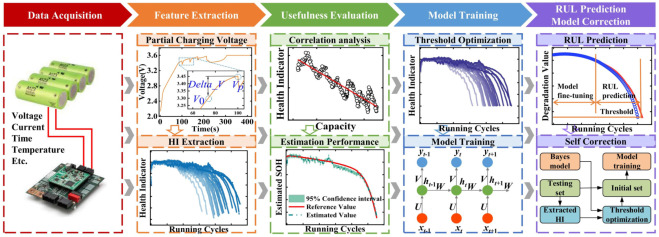

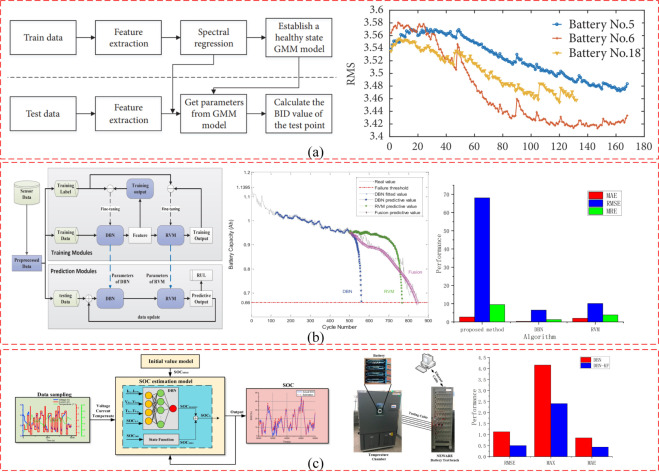

健康状态 State of Health-SOH

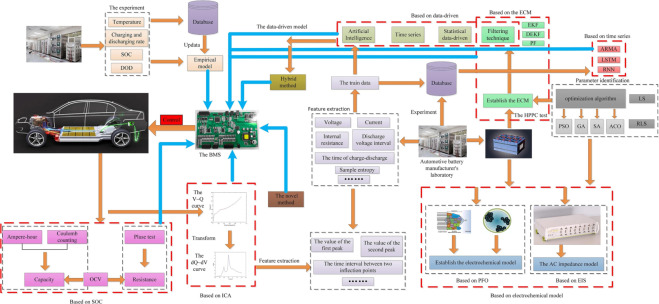

基于深度学习的Li电池SOH预测流程:

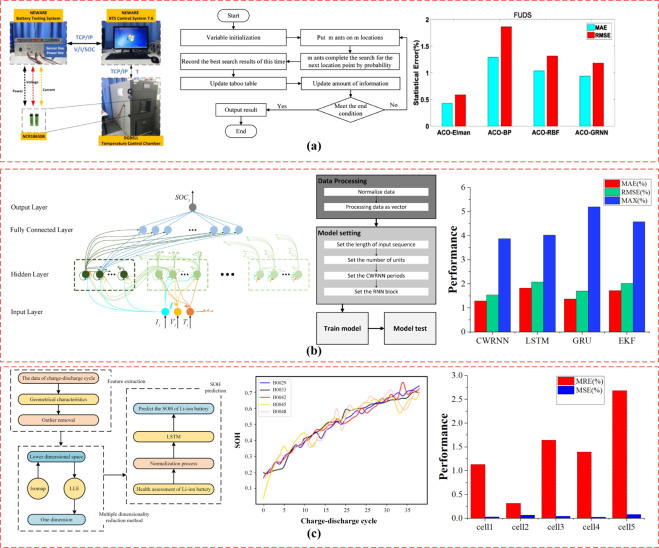

RNN methods

CNN methods

DNN methods

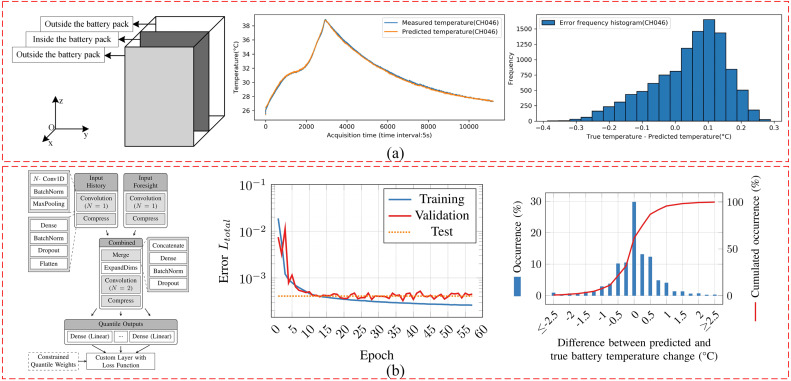

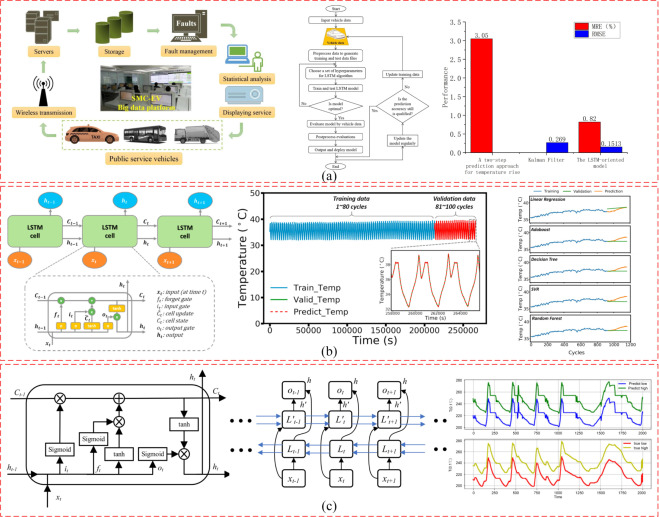

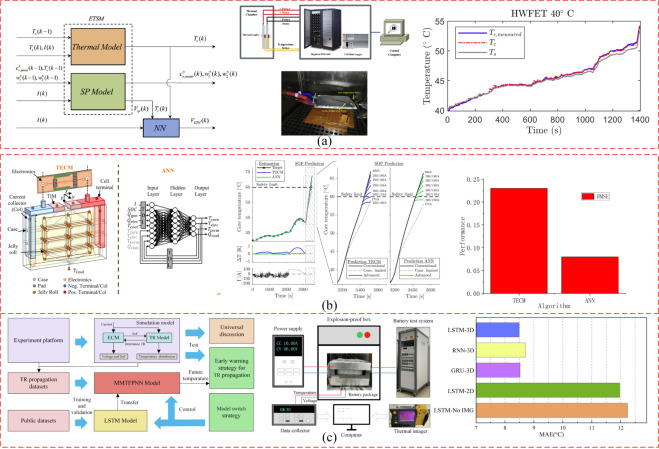

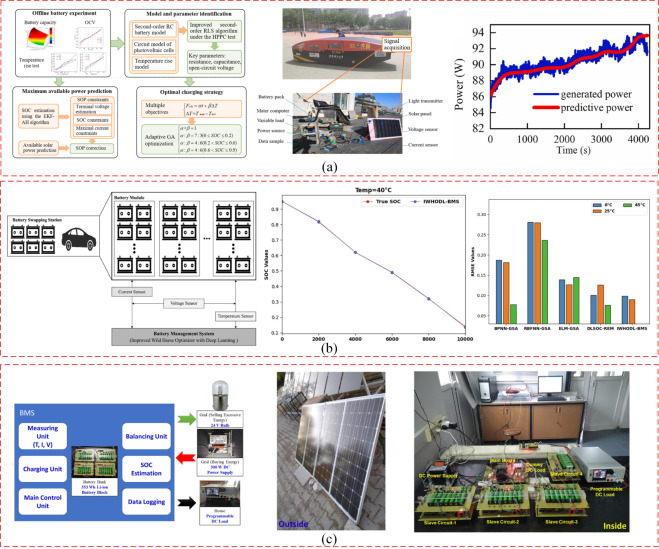

电池热管理battery thermal management-BTM

CNN methods

RNN methods

other methods

DL在RUL-SOH-BTM中的应用文献、方法对比:

Application

电池管理对于确保产品可靠、安全运行至关重要。因此,高效的BMS在保护电池及其相关系统免受损害或过充,以及提高电池性能方面扮演着至关重要的角色,主要包括精确监测、充电和放电控制、热管理、电池安全和保护。

资料获取

最后给大家提供下论文:

1、原论文地址:https://www.sciencedirect.com/science/article/pii/S2352152X23012653#sec1

2、论文获取方式,公众号【尤而小屋】,后台回复:锂电池与深度学习

![Windows | [出现错误 2147942402 (0x80070002) (启动“ubuntu2004.exe”时)]](https://img-blog.csdnimg.cn/910a2375d2f24ab6949025de2d53e625.png)