循环神经网络(Recurrent Neural Network, RNN)是一种处理时间序列数据和自然语言等具有顺序信息的数据的神经网络模型。与普通的前馈神经网络(Feedforward Neural Network)不同,RNN具有循环连接,使得网络能够在处理当前输入信息的同时保留之前输入的信息。

举一个简单的例子:我们要构建一个模型来预测一句话中的下一个单词。假设我们有这样一个句子:“我爱吃苹果,因为苹果很好吃。”,我们希望模型能够预测出在“我爱吃”之后,下一个单词是“苹果”。

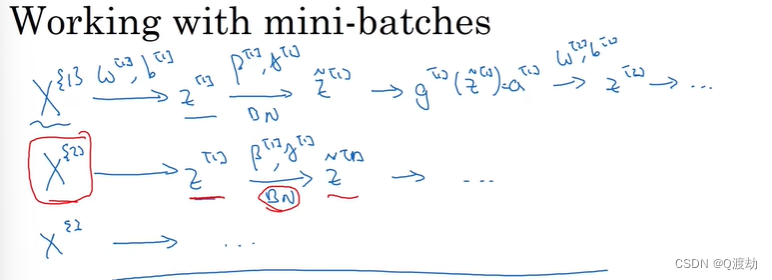

在这个例子中,我们可以使用RNN来处理这个问题。首先,我们将句子切分成单词序列,如["我", "爱", "吃", "苹果"]。接下来,我们将每个单词转换成可以输入到神经网络的向量表示(例如,使用Word Embedding)。然后,我们将这些向量依次输入到RNN中。

RNN的核心是一个隐藏层,它具有一个隐藏状态向量(hidden state vector)。在每个时间步,RNN会接收当前单词的输入向量,以及上一个时间步的隐藏状态向量。通过对这两个向量进行计算(例如,加权求和后通过激活函数),RNN会更新隐藏状态向量,并输出一个表示预测结果的向量。在这个例子中,输出向量可以通过一个全连接层(Fully-connected Layer)和softmax分类器转换为每个可能的下一个单词的概率分布。

在模型训练过程中,我们将实际的下一个单词作为目标值,计算模型输出的概率分布与目标值之间的损失(例如,交叉熵损失),然后通过梯度下降等优化算法来更新网络参数,使模型能够更准确地预测下一个单词。

通过这样的循环结构,RNN能够捕捉到序列中的长程依赖关系,从而在处理时间序列数据和自然语言等问题时具有较好的性能。然而,RNN也存在一些问题,如梯度消失和梯度爆炸,这导致RNN在处理长序列时可能难以捕捉到远距离的依赖关系。为了解决这些问题,研究人员提出了一些改进的RNN结构,如长短时记忆网络(Long Short-Term Memory, LSTM)和门控循环单元(Gated Recurrent Unit, GRU)。

![BUUCTF [GXYCTF2019] CheckIn 1](https://img-blog.csdnimg.cn/b8b178517f694f23a483076c3721ad4d.png#pic_center)