提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 前言

- 一、

- 来源

前言

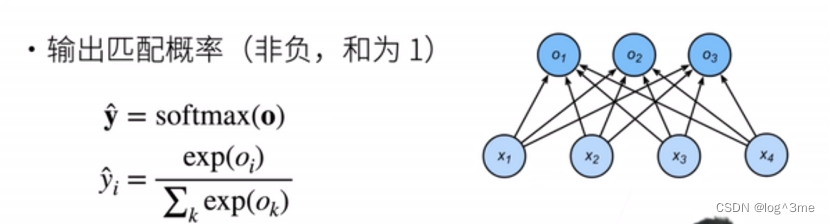

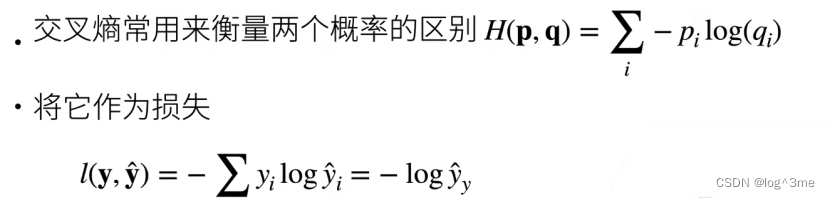

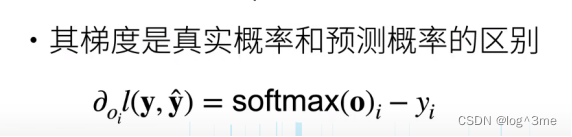

softmax和cross-entorpy

一、

# softmax

import torch

from torch import nn

from d2l import torch as d2l

batch_size=64

train_iter,test_iter=d2l.load_data_fashion_mnist(batch_size) # 把数据读入迭代器

# PyTorch不会隐式地调整输入的形状。在线性层前定义了展平层(flatten),来调整网络输入的形状

# softmax回归的输出层是一个全连接层。 在Sequential中添加一个带有10个输出的全连接层。

net = nn.Sequential(nn.Flatten(), nn.Linear(784, 10)) #flatten:把任何维度的tensor变为2d tensor,保留第0维度,剩下维度展成向量

# 以均值0和标准差0.01随机初始化权

def init_weights(m):

if type(m) == nn.Linear:

nn.init.normal_(m.weight, std=0.01)

net.apply(init_weights)

# cross entropy

loss = nn.CrossEntropyLoss()

# 优化算法

trainer = torch.optim.SGD(net.parameters(), lr=0.1)

# 定义的训练函数来训练模型

num_epochs = 10

d2l.train_ch3(net, train_iter, test_iter, loss, num_epochs, trainer)

来源

b站 跟李沐学AI 动手学深度学习v2 09