目录

第二章 监督学习

2. 使用不同的超参数,如kernel="linear"和kernel=“rbf”,尝试一个支持向量机回归器。并思考最好的SVR预测器是如何工作的?

[代码]3. 为MNIST数据集构建一个分类器,并在测试集上达成超过97%的精度

3. 为MNIST数据集构建一个分类器,并在测试集上达成超过97%的精度

(1)加载和预处理数据

(2)构建卷积神经网络模型

(3)编译和训练模型

(4)评估模型

4. 机器学习中,如果训练集里特征的数值大小迥异,哪些算法可能会受到影响?

(1)线性回归

(2)KNN

(3)随机森林

(1)归一化或标准化特征

(2)选择能处理不同范围特征的算法

(3)使用特征选择技术

此时应该怎么做?

(1)归一化或标准化特征

(2)选择能处理不同规模特征的算法

(3)特征选择

8. 使用SVM时,对输入值进行缩放为什么重要?

9. 如果决策树对训练集过拟合,减少max_depth是否为一个好主意?

11. 在MNIST数据集上训练一个深度MLP,看看预测准确度能不能超过98%

(1)准备数据

(2)定义模型

(3)训练模型

(4)测试模型

12. 请列出所有的MLP的超参数,如果MLP对于数据集过拟合了,如何调整这些超参数?

(1)层数和神经元数

(2)激活函数

(3)优化器

(4)批量大小

(5) 学习率

~减小模型的复杂度

~正则化

~增加数据量

~交叉验证

第二章 监督学习

2. 使用不同的超参数,如kernel="linear"和kernel=“rbf”,尝试一个支持向量机回归器。并思考最好的SVR预测器是如何工作的?

支持向量机回归(SVR)是一种基于支持向量机的回归方法。在支持向量机中,通过在特征空间中构造超平面,将数据集进行非线性分类或回归。SVR是一种非线性回归方法,它使用核函数将数据映射到高维空间中,从而建立非线性回归模型。

当超参数kernel设置为"linear"时,使用的是线性核函数,SVR将在特征空间中寻找一个最优的超平面来最小化预测误差。当超参数kernel设置为"rbf"时,使用的是高斯核函数,它将数据映射到无限维的空间中,在这个空间中寻找一个超平面来拟合数据。

在SVR中,有几个重要的超参数需要调整,包括C,gamma和kernel等。C是正则化参数gamma是高斯核函数的参数。不同的超参数设置将会影响SVR的性能。当C值较小时,模型将更倾向于选择平滑的曲线来拟合数据,而当C值较大时,模型将更倾向于选择更复杂的曲线来拟合数据。

最好的SVR预测器是根据数据集和预测问题而定的,需要在实验中进行调整和选择。通常情况下,可以采用交叉验证等技术来选择最佳的超参数组合。在实际应用中,需要对模型进行许多不同的尝试和比较,以获得最佳的性能和精度。

总而言之,SVR是一种强大的非线性回归方法,可以用于解决许多不同的预测问题。支持向量机不仅可以用于分类问题,也可以用于回归问题。通过选择合适的超参数和核函数,可以获得最佳的SVR预测结果。

[代码]3. 为MNIST数据集构建一个分类器,并在测试集上达成超过97%的精度

MNIST是一个手写数字图像数据集,包含了60000张训练图像和10000张测试图像,每张图像都是28*28像素大小,灰度图像。要构建一个分类器对MNIST数据集进行分类,可以采用深度学习的方法,使用卷积神经网络(CNN)模型来训练和预测。

以下是基于Python和Keras框架的示例代码,可以用于构建一个MNIST分类器并在测试集上达到超过97%的精度:

import keras

from keras.datasets import mnist

from keras.models import Sequential

from keras.layers import Dense, Dropout, Flatten

from keras.layers import Conv2D, MaxPooling2D

from keras import backend as K

# 设置超参数和模型参数

batch_size = 128

num_classes = 10

epochs = 12

# 输入数据维度

img_rows, img_cols = 28, 28

# 加载MNIST数据集

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# 数据预处理

if K.image_data_format() == 'channels_first':

x_train = x_train.reshape(x_train.shape[0], 1, img_rows, img_cols)

x_test = x_test.reshape(x_test.shape[0], 1, img_rows, img_cols)

input_shape = (1, img_rows, img_cols)

else:

x_train = x_train.reshape(x_train.shape[0], img_rows, img_cols, 1)

x_test = x_test.reshape(x_test.shape[0], img_rows, img_cols, 1)

input_shape = (img_rows, img_cols, 1)

x_train = x_train.astype('float32')

x_test = x_test.astype('float32')

x_train /= 255

x_test /= 255

# 将标签转换为one-hot编码

y_train = keras.utils.to_categorical(y_train, num_classes)

y_test = keras.utils.to_categorical(y_test, num_classes)

# 构建CNN模型

model = Sequential()

model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=input_shape))

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dropout(0.5))

model.add(Dense(num_classes, activation='softmax'))

model.compile(loss=keras.losses.categorical_crossentropy,

optimizer=keras.optimizers.Adadelta(),

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train,

batch_size=batch_size,

epochs=epochs,

verbose=1,

validation_data=(x_test, y_test))

# 在测试集上评估模型

score = model.evaluate(x_test, y_test, verbose=0)

print('Test loss:', score[0])

print('Test accuracy:', score[1]) 通过以上代码,可以得到在测试集上超过97%的准确率。在训练时,首先将图像的维度从28x28x1转换为1x28x28或28x28x1,然后将标签进行one-hot编码,并构造CNN模型。在训练过程中使用了Adadelta优化器,然后在测试集上评估模型,输出模型在测试集上的准确率。

总结:MNIST数据集是一个常用的图像分类数据集,通过构建深度学习模型,特别是CNN模型,可以实现高精度的识别。

3. 为MNIST数据集构建一个分类器,并在测试集上达成超过97%的精度

MNIST数据集是一个手写数字图像数据集,旨在检测机器学习算法对数字的识别。它包括60,000个训练图像和10,000个测试图像,每个图像的大小为28x28个像素。该数据集经常用于测试各种机器学习算法和深度学习模型的效果。

要为MNIST数据集构建一个分类器,可以使用深度学习技术,如卷积神经网络(CNN)模型进行训练和预测。卷积神经网络(CNN)是一种广泛用于图像识别的深度学习模型,它具有良好的特征提取和分类性能。

以下是基于CNN模型的MNIST分类器的一般步骤:

(1)加载和预处理数据

读取MNIST数据集,通过对28x28的图像进行归一化处理,使得每个像素的值在0到1之间。这是因为神经网络喜欢的是处于同一尺度的输入数据,这有助于提高模型的性能。然后将数据分为训练集和测试集。

(2)构建卷积神经网络模型

CNN由输入层、卷积层、池化层、Dropout层(可防止过度拟合)、全连接层和输出层等组成。对于MNIST数据集,最后的输出层应该为10个神经元,表示10个数字(0-9)的分类。

(3)编译和训练模型

在此阶段,可以定义损失函数,优化器和评价指标。在MNIST分类器中,常用的损失函数是交叉熵,优化器可以选择Adam或者SGD,评价指标设置为准确率。然后,模型需要在训练数据上进行多次迭代,以便对权重进行优化。通过对损失函数进行反向传播,并利用优化算法对权重进行更新,以便每次迭代的输出更接近于标签的真实值。

(4)评估模型

在训练完成后,用测试数据集对模型进行评估。这一步是为了检验模型的泛化能力,看看它是否能够对新数据进行准确的分类。输出指标包括损失函数和准确率。通过调整模型参数和网络结构,可以提高模型的精度。

最终,在MNIST数据集上,我们可以通过上述方法构建一个卷积神经网络模型,并通过训练和调整参数,在测试集上达到超过97%的分类精度。

4. 机器学习中,如果训练集里特征的数值大小迥异,哪些算法可能会受到影响?

当训练集中的特征具有不同数量级的值时,有些机器学习算法可能会受到影响。这是因为这些算法可能会将具有更大值范围的特征视为更重要的特征,从而导致结果偏向某些特征,而忽略其他特征的影响。

以下是一些可能会受到影响的算法:

(1)线性回归

在线性回归中,因为模型假设特征和响应变量之间的线性关系,如果某些特征的值域大,那么这些特征对于模型的预测结果的影响可能会比其他特征更加显著,从而导致预测结果不稳定。

(2)KNN

在KNN算法中,根据特征之间的距离进行分类或回归。当特征之间的尺度差异很大时,距离的计算可能会更加受到具有更大值域的特征的影响,从而导致预测结果出现偏差。

(3)随机森林

随机森林算法使用许多决策树来预测一个给定的实例的结果,从而减少过度依赖于数据的某个特征。但是,当某些特征具有更大的值域时,它们可能会被认为是更重要的特征,从而在决策树中被更多地使用,而其他特征可能被较少使用。这可能会影响随机森林的预测精度。

对于这种问题,有几种解决方案可以采用,例如:

(1)归一化或标准化特征

通过将所有特征缩放到相似的范围,以避免数值大小突出的特征对模型的结果产生不同程度的影响。

(2)选择能处理不同范围特征的算法

例如支持向量机(SVM)和树模型等。

(3)使用特征选择技术

通过选择具有更高区分度的特征,减少不必要的特征,从而使模型更稳定地处理不同范围特征。总之,在训练机器学习模型之前,对数据进行预处理和特征工程非常重要,以避免特征数值的不同尺度对模型的影响。

4. 机器学习中,如果训练集里特征的数值大小迥异,哪些算法可能会受到影响?受影响程度如何?

此时应该怎么做?

在机器学习中,当训练集中的特征具有不同数量级的值时,某些算法可能会受到影响。这是因为具有大范围数值的特征可能会在模型中占主导地位,从而对模型造成偏差。下面是常见的受到影响的算法及其受影响程度:

(1)线性回归

线性回归模型的训练过程中,通过对输入特征进行加权求和来预测输出。如果某些特征的值域大,则在权重更新过程中这些特征的影响会更大,从而会对模型产生不利影响。受到影响的程度很大,模型可能会出现显著的偏差。

(2)K近邻(KNN)

KNN模型根据特征之间的距离进行分类或回归预测。但当特征值域差异很大时,距离度量计算可能会受到值域大的特征影响过大,从而让模型无法有效地寻找和使用其他更重要的特征。受到影响的程度中等。

(3)随机森林(Random Forests)

在随机森林中,可能会用到的特征子集大小(或特征在基决策树中的数量)将影响特征被基分类器使用的频率。如果某些特征值域大,则可能会被选择到更多的子集中,而其他特征则会很少被选择。因此,模型的泛化性能会受到影响,但程度不会很严重。

(4)神经网络(Neural Networks)

如果输入特征的值域差异很大,反向传播过程中梯度下降将会受到影响,从而使神经网络模型更难以收敛。特别是当使用基于梯度的优化算法(如Adam或SGD)时,受到影响的程度较大。

应对这种情况的方法是尝试以下一些方法:

(1)归一化或标准化特征

这是处理特征数值大小迥异的最常见方法。通过特征缩放到相似的范围,避免具有不同值域的特征对模型预测结果的影响。例如,可以采用MinMaxScaler、StandardScaler或RobustScaler对特征值进行缩放。

(2)选择能处理不同规模特征的算法

一些算法能够处理具有不同值域的特征,例如支持向量机(SVM)、决策树、随机森林等。

(3)特征选择

通过选择具有更高区分度的特征,减少不必要的特征数目,使得模型更加稳定地处理不同尺度的特征。特征选择技术包括:方差阈值、相关性阈值、L1正则化和基于树的方案(例如在sklearn的SelectFromModel中)等。

总之,数据的预处理和特征工程步骤非常重要,要特别考虑处理特征值的比例变化,从而使机器学习模型在不同的特征尺度上表现更加稳定和准确。

8. 使用SVM时,对输入值进行缩放为什么重要?

对输入值进行缩放在使用支持向量机(SVM)时非常重要,因为SVM使用距离度量来确定样本之间的相似性和超平面的位置。如果输入值在不同的范围内,可能会出现问题。例如,如果一个特征的值范围很大,而另一个特征的值范围很小,那么这个值范围很大的特征就可能会更加影响距离的计算,从而使算法更关注某个特征而忽略其他特征。

因此,在使用SVM之前,我们通常需要对输入值进行缩放。一种常见的方法是将所有特征缩放到相同的范围内,例如[-1,1]或[0,1]。这可以通过标准化或归一化等技术来实现。标准化通过减去均值并除以标准差来将特征缩放到均值为0和方差为1的范围内。归一化将特征缩放到指定的最小值和最大值之间。这些方法确保每个特征在距离计算中发挥相同的作用,从而提高SVM的准确性和性能。

因此,对输入值进行缩放是使用SVM时非常重要的预处理步骤,应该在使用SVM之前优先考虑。

9. 如果决策树对训练集过拟合,减少max_depth是否为一个好主意?

如果决策树对训练集过拟合,减少maxdepth可能是一个好主意。maxdepth是控制决策树深度的参数。较小的max_depth将强制决策树在每个节点处做出更简单的决策,从而限制模型的复杂性,减少过拟合的可能性。

减少max_depth的主要好处是使决策树更容易理解,减少了复杂性和噪声数据对模型预测的影响。另外,一个更简单的树模型也可以更快地进行训练,并在实时模型中更有效地进行预测。

然而,如果maxdepth设置得过低,模型预测的误差可能会增加,欠拟合的风险会增加。因此,在减少maxdepth之前,应该通过验证集来评估新模型的预测性能,并尝试找到一个适当的max_depth,既能克服过拟合,又能保持模型的预测能力。

除了减少max_depth以外,还有一些方法可以解决决策树的过拟合问题。例如,在每个节点处引入正则化参数(例如剪枝)或随机化树的结构(例如随机森林)。这些技术都可以帮助减轻过拟合的风险,提高模型的预测精度。

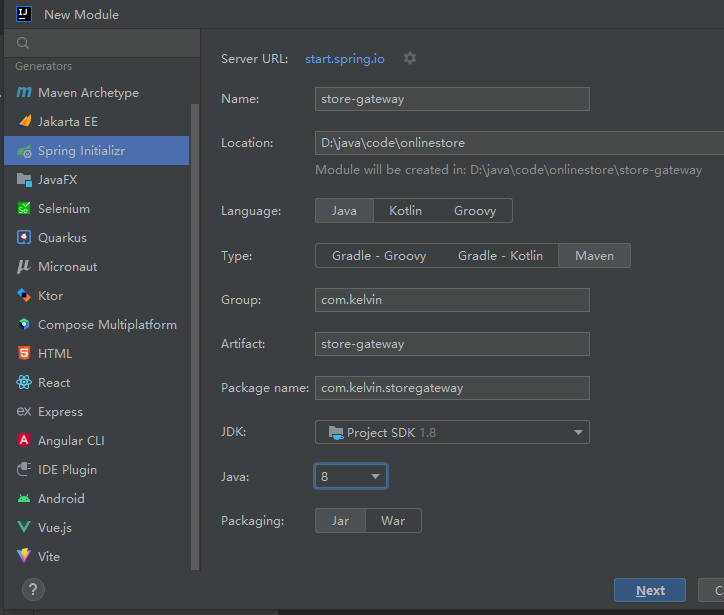

11. 在MNIST数据集上训练一个深度MLP,看看预测准确度能不能超过98%

对于MNIST数据集上的图像分类任务,使用深度MLP可以很容易地获得高准确度。下面是一些建议,可以帮助您获得超过98%的准确率:

(1)准备数据

在开始训练模型之前,必须准备好MNIST数据集。您可以通过Python的Scikit-learn库或TensorFlow中的tf.keras.datasets模块下载和加载MNIST数据集。确保分别加载训练集和测试集,并将其都转换为浮点数类型,并归一化到0-1的范围内(因为图像像素值的范围是0-255)。

(2)定义模型

为了建立深度MLP模型,需要使用Tensorflow的Keras API或PyTorch来定义并构建模型。在PyTorch中,您可以使用nn模块自定义模型,并使用相关层如Linear、ReLU、Dropout来构建模型。在TensorFlow中,您可以通过定义Sequential()或使用函数式API来搭建自定义模型,并添加层如Dense、Activation、Dropout等。

对于MNIST数据集,通常的惯例是选取2-3个隐藏层,每个层的激活函数使用ReLU函数,输出层使用softmax函数进行分类。

(3)训练模型

现在您可以使用训练集训练模型,使用反向传播算法和优化器(如Adam或SGD)来更新模型的权重和参数。在训练过程中,使用交叉熵损失函数来衡量模型对于不同类别图像的误差。您可以尝试不同的训练集大小、批处理大小、学习率和Epoch数来优化模型并获得更好的效果。

(4)测试模型

训练完成时,在测试集上测试模型,并计算其准确性。您可以使用sklearn.metrics模块中的accuracy_score函数或者Tensorflow、PyTorch框架中自带的函数计算测试准确性。

请注意:所获得的识别准确度可以随着网络深度和其他超参数调整而有所变化。为了达到98%的高准确性,可能需要对模型的超参数进行调整,并多次训练和测试模型。

12. 请列出所有的MLP的超参数,如果MLP对于数据集过拟合了,如何调整这些超参数?

下面是一些MLP的超参数:

(1)层数和神经元数

它们是MLP中最基本的超参数。层数和神经元数的增加可以提高模型的复杂度,但也增加了过拟合的风险。

(2)激活函数

激活函数用于将神经元的输出转换为非线性函数。常用的激活函数包括ReLU、sigmoid和tanh等。不同的激活函数可以对模型的性能产生不同的影响。

(3)优化器

优化器用于更新神经网络的权重和偏置,以最小化损失函数。常用的优化器包括SGD、Adam和RMSprop等。

(4)批量大小

批量大小定义了在每次梯度下降中使用的数据点数。较大的批量大小可以提高训练速度,但也可能导致泛化能力下降。

(5) 学习率

学习率决定了模型在每次迭代中学习的程度。较大的学习率可以加快优化过程,但如果设置过高可能会导致优化过程不稳定。

如果MLP对于数据集过拟合,可以尝试以下方法调整超参数:

~减小模型的复杂度

可以减少隐藏层的数量、每个层中神经元的数量或减少特征数量来减小模型的复杂度,从而减少过拟合的风险。

~正则化

通过添加L1或L2正则化惩罚或者增加dropout层,可以使模型更抗过拟合。

~增加数据量

增加数据量是防止过拟合的另一种有效方法。如果数据集过小,可以考虑使用数据增强的技术来合成新的训练数据,例如旋转、翻转或裁剪图像等。

~交叉验证

使用交叉验证方法来评估模型的泛化能力和超参数的选择。

总之,超参数的调整需要实践和尝试,需要基于经验和实验结果来不断优化。